手把手教你如何利用python进行列表数据清洗

文章目录

-

- 一.准备

- 二.利用csv库,读取我们的待处理列表。

- 三.创建一个新的列表list1=[]

- 四.下面贴出完整代码供大家学习

一.准备

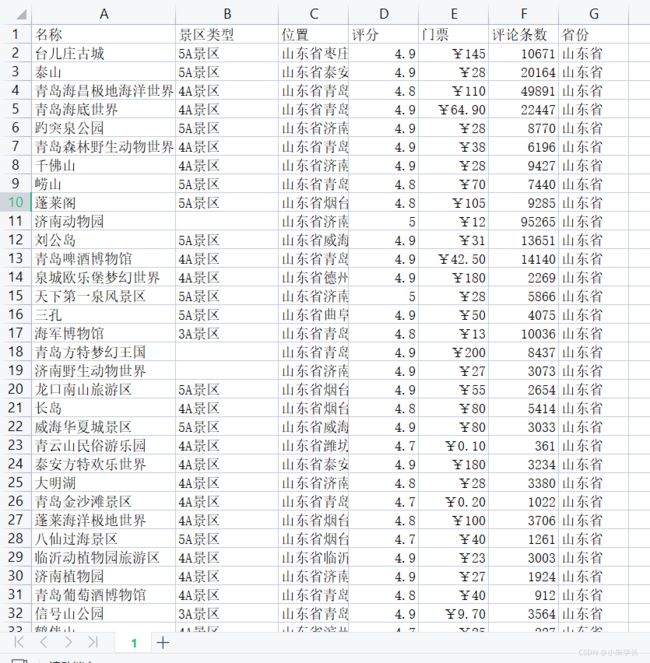

利用scrapy crawl 从某网站爬取到近28000组数据,如下表,观察发现,在景区类型一列,有的是普通景区不是A级景区,那么如果我们需要一个都是A级的景区的表格怎么办,手动对于如此庞大的数据量显然不合适,那么,使用python将会非常简单。

观察上图,发现没有景区的一栏没有任何数据,这显然不利于我们对数据的处理,我们利用wsp的查找替换功能,将None的数据随意替换为一个方便区分的数据。

如图这48155处数据就是我们不需要的垃圾数据,接下来我们使用python对其进行清洗。

二.利用csv库,读取我们的待处理列表。

因为我是直接把列表放入了py文件的目录下,所以不需要写路径,如果不是同目录需要,写明路径。

import csv

with open('1.csv',"r") as a:

reader = csv.reader(a)

list=[]

for row in reader:

list.append(row)

这样,我就成功的把csv里面的数据转换为python对象,并成功的将其存入列表list里面。下面我们输出查看一下list里面是什么内容:

如图,现在我们的list里面是一个二维列表,里面有每一组的数据。

接下来我们观察发现,我们需要区分的景区类别在每一组的第二个位置,也就是类别的第一个下表a[1]。

所以我们写一个循环来遍历这个list,这样就可以在里面的一维列表里面以a[1]来进行筛选我们需要的数据。

三.创建一个新的列表list1=[]

来储存我们筛选之后的数据。

list1=[]

for a in list:

if a[1] !='无':

list1.append(a)

我们来看一下list1是不是成功的筛选出来了;

观察发现,现在每组的第二个数据都是A级景点,说明我们已经筛选成功了,现在我们需要把list1列表里面的数据存入一个新的表格文件就完成了我们需求。

使用pandas库将其转换为DataFrame,之后方便我们存入文件。

name=['名称','景区类型','位置','评分','门票','人气','省份']

test = DataFrame(list1, columns=name)

test.to_csv('e:/testcsv.csv',encoding='gbk')

四.下面贴出完整代码供大家学习

import csv

import numpy as np

from pandas import DataFrame

with open('1.csv',"r") as a:

reader = csv.reader(a)

list=[]

for row in reader:

list.append(row)

list1=[]

for a in list:

if a[1] !='无':

list1.append(a)

print(a)

x = np.array(list1, dtype = str)

name=['名称','景区类型','位置','评分','门票','人气','省份']

test = DataFrame(list1, columns=name)

test.to_csv('e:/testcsv.csv',encoding='gbk')