聚类学习算法对比评估

更多聚类算法

Mini Batch K-Means

实现方法:sklearn.cluster.MiniBatchKMeans

Mini Batch K-Means 整体上和 K-Means 很相似,它是 K-Means 的一个变种形式。与 K-Means 不同的地方在于,其每次从全部数据集中抽样小数据集进行迭代。Mini Batch K-Means 算法在不对聚类效果造成较大影响的前提下,大大缩短了计算时间。

Affinity Propagation

实现方法:sklearn.cluster.MeanShift

MeanShift 又被称为均值漂移聚类。Mean Shift 聚类的目的是找出最密集的区域, 同样也是一个迭代过程。在聚类过程中,首先算出初始中心点的偏移均值,将该点移动到此偏移均值,然后以此为新的起始点,继续移动,直到满足最终的条件。Mean Shift 也引入了核函数,用于改善聚类效果。除此之外,Mean Shift 在图像分割,视频跟踪等领域也有较好的应用。

Spectral Clustering

实现方法:sklearn.cluster.SpectralClustering

Spectral Clustering 又被称为谱聚类。谱聚类同样也是一种比较常见的聚类方法,它是从图论中演化而来的。谱聚类一开始将特征空间中的点用边连接起来。其中,两个点距离越远,那么边所对应的权值越低。同样,距离越近,那么边对应的权值越高。最后,通过对所有特征点组成的网络进行切分,让切分后的子图互相连接的边权重之和尽可能的低,而各子图内部边组成的权值和尽可能高,从而达到聚类的效果。谱聚类的好处是能够识别任意形状的样本空间,并且可以得到全局最优解。

Agglomerative Clustering

实现方法:sklearn.cluster.AgglomerativeClustering

Agglomerative Clustering 又被称为层次聚类。层次聚类算法是将所有的样本点自下而上合并组成一棵树的过程,它不再产生单一聚类,而是产生一个聚类层次。层次聚类通过计算各样本数据之间的距离来确定它们的相似性关系,一般情况下,距离越小就代表相似度越高。最后,将相似度越高的样本归为一类,依次迭代,直到生成一棵树。由于层次聚类涉及到循环计算,所以时间复杂度比较高,运行速度较慢。

Birch 聚类

实现方法:sklearn.cluster.Birch

Birch 是英文 Balanced Iterative Reducing and Clustering Using Hierarchies 的简称,它的中文译名为「基于层次方法的平衡迭代规约和聚类」,名字实在太长。

Birch 引入了聚类特征树(CF 树),先通过其他的聚类方法将其聚类成小的簇,然后再在簇间采用 CF 树对簇聚类。Birch 的优点是,只需要单次扫描数据集即可完成聚类,运行速度较快,特别适合大数据集。

DBSCAN

实现方法:sklearn.cluster.DBSCAN

DBSCAN 是英文 Density-based spatial clustering of applications with noise 的简称,它的中文译名为「基于空间密度与噪声应用的聚类方法」,名字同样很长。

DBSCAN 基于密度概念,要求聚类空间中的一定区域内所包含的样本数目不小于某一给定阈值。该算法运行速度快,且能够有效处理特征空间中存在的噪声点。但是对于密度分布不均匀的样本集合,DBSCAN 的表现较差。

聚类算法对比

首先,我们从 sklearn.cluster 模块中,导入各聚类估计器。如 K-Means 等估计器需要提前确定类别数量,也就是 K 值。判断的方法很简单,如果聚类方法中包含 n_clusters= 参数,即代表需要提前指定。这里我们统一确定 K=3。

from sklearn import cluster # 导入聚类模块

# 对聚类方法依次命名

cluster_names = ['KMeans', 'MiniBatchKMeans', 'AffinityPropagation', 'MeanShift',

'SpectralClustering', 'AgglomerativeClustering', 'Birch', 'DBSCAN']

# 确定聚类方法相应参数

cluster_estimators = [

cluster.KMeans(n_clusters=3),

cluster.MiniBatchKMeans(n_clusters=3),

cluster.AffinityPropagation(),

cluster.MeanShift(),

cluster.SpectralClustering(n_clusters=3),

cluster.AgglomerativeClustering(n_clusters=3),

cluster.Birch(n_clusters=3),

cluster.DBSCAN()

]

print("定义完成")

接下来,我们对上面提到的 8 种常见的聚类算法做一个对比。这里选择了一个空间分布由三个团状图案组成的示例数据集。

import pandas as pd # 导入数据处理模块

from matplotlib import pyplot as plt # 导入绘图模块

%matplotlib inline

# 读取数据集 csv 文件

data = pd.read_csv(

"https://labfile.oss.aliyuncs.com/courses/880/data_blobs.csv", header=0)

X = data[['x', 'y']]

plt.scatter(data['x'], data['y'])

然后,我们分别应用 8 种聚类方法对数据进行聚类,并将最终的聚类结果绘制出来。

import numpy as np # 导入数值计算模块

from tqdm.notebook import tqdm

plot_num = 1 # 为绘制子图准备

plt.figure(figsize=(20, 10))

# 不同的聚类方法依次运行

for name, algorithm in tqdm(zip(cluster_names, cluster_estimators)):

algorithm.fit(X) # 聚类

# 判断方法中是否有 labels_ 参数,并执行不同的命令

if hasattr(algorithm, 'labels_'):

algorithm.labels_.astype(np.int)

else:

algorithm.predict(X)

# 绘制子图

plt.subplot(2, len(cluster_estimators) / 2, plot_num)

plt.scatter(data['x'], data['y'], c=algorithm.labels_)

# 判断方法中是否有 cluster_centers_ 参数,并执行不同的命令

if hasattr(algorithm, 'cluster_centers_'):

centers = algorithm.cluster_centers_

plt.scatter(centers[:, 0], centers[:, 1], marker="p", edgecolors="red")

# 绘制图标题

plt.title(name)

plot_num += 1

在我们指定 n_clusters=3 的方法中,除了 SpectralClustering 出现了三个样本点漂移,其他几种方法的结果几乎是一致的。除此之外,在没有指定 n_clusters 的聚类估计器中,Mean Shift 对于此数据集的适应性较好,而亲和传播聚类方法在默认参数下表现最差。

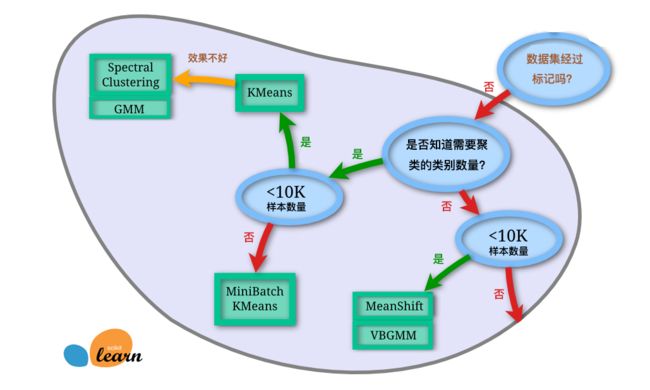

聚类方法这么多,在实际运用中我们该怎样选择呢?其实,scikit-learn 提供了一张选择判断图供大家参考。

在我们指定 n_clusters=3 的方法中,除了 SpectralClustering 出现了三个样本点漂移,其他几种方法的结果几乎是一致的。除此之外,在没有指定 n_clusters 的聚类估计器中,Mean Shift 对于此数据集的适应性较好,而亲和传播聚类方法在默认参数下表现最差。

聚类方法这么多,在实际运用中我们该怎样选择呢?其实,scikit-learn 提供了一张选择判断图供大家参考。