罗列一下Pytorch中的损失函数以及使用场景。在Pytorch中,一共提供了18个损失函数。

Pytorch Loss Function

0、基本用法

criterion = LossCriterion() #构造函数有自己的参数

loss = criterion(x, y) #调用标准时也有参数

....

loss.backward() #反向传播

计算出来的结果默认已经对mini-batch取了平均,不过可以通过参数选择求和还是平均。同时没有特殊的需求,选择默认的参数就可以了。

前几个是比较常用的,之后几个不是特别常用,可以点击链接,官网查看。

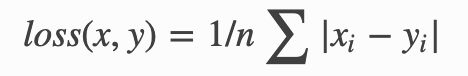

1、L1范数损失 L1Loss

torch.nn.L1Loss(size_average=None, reduce=None, reduction: str = 'mean')

参数:

reduction: "mean" | "sum",选择"sum"时将不会取平均

输入参数:

input: (B, )

target: (B,) 形状一样

输出:常量

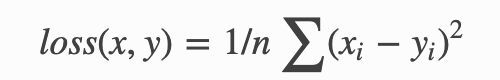

2、均方误差损失 MSELoss

` ``

torch.nn.MSELoss(size_average=None, reduce=None, reduction: str = 'mean')```

输入输出维度和L1Loss相同。

一般回归任务的时候使用。预测房价、股价等等。

3、交叉熵损失函数 CrossEntropyLoss

torch.nn.CrossEntropyLoss(weight=None, size_average=True)

当训练有 C 个类别的分类问题时很有效. 可选参数 weight 必须是一个1维 Tensor, 权重将被分配给各个类别. 对于不平衡的训练集非常有效。

在多分类任务中,经常采用 softmax 激活函数+交叉熵损失函数,因为交叉熵描述了两个概率分布的差异,然而神经网络输出的是向量,并不是概率分布的形式。所以需要 softmax激活函数将一个向量进行“归一化”成概率分布的形式,再采用交叉熵损失函数计算 loss。

使用范围,单标签多类分类问题,比如图片分类、Mnist数字分类等。

注意: CrossEntropyLoss = LogSoftmax+NLLLoss。 这一点可以看解析CrossEntropyLoss和NLLLoss

4、负对数似然损失 NLLLoss

torch.nn.NLLLoss(weight=None, size_average=True)

log likelihood loss损失。用于训练一个n类分类器。

可以通过在最后一层加LogSoftmax来获得类别的log-probabilities

如果不想增加一个额外层的话,您可以使用CrossEntropyLoss。

所以说:CrossEntropyLoss = LogSoftmax+NLLLoss

Input: (N,C) , C是类别的个数

Target: (N) , target中每个值的大小满足 0 <= targets[i] <= C-1

输出:loss

5、NLLLoss2d

torch.nn.NLLLoss2d(weight=None, size_average=True)

对于图片的 negative log likehood loss。计算每个像素的 NLL loss。

Input: (N,C,H,W) C 类的数量

Target: (N,H,W) where each value is 0 <= targets[i] <= C-1

6、KL 散度损失 KLDivLoss

torch.nn.KLDivLoss(weight=None, size_average=True)

计算 KL 散度损失。

KL散度常用来描述两个分布的距离,并在输出分布的空间上执行直接回归是有用的。

input和target的维度相同。与NLLLoss一样,给定的输入应该是log-probabilities。

7、二进制交叉熵损失 BCELoss

torch.nn.BCELoss(weight=None, size_average=True)

二分类任务时的交叉熵计算函数。用于测量重构的误差, 例如自动编码机. 注意目标的值 t[i] 的范围为0到1之间.

使用范围:

- 简单的二分类问题。先通过sigmoid, 然后使用BCELoss。input和target维度都是(N)。

- 多标签二元分类问题。例如同时判断一张图片是不是包含猫、狗、人。inout和target维度就是(N,3)。

注意: BCEWithLogitsLoss = Sigmoid+BCELoss,当网络最后一层使用nn.Sigmoid时,就用BCELoss,当网络最后一层不使用nn.Sigmoid时,就用BCEWithLogitsLoss。 详细可以看: 多标签二元分类

8、BCEWithLogitsLoss

BCEWithLogitsLoss损失函数把 Sigmoid 层集成到了 BCELoss 类中

torch.nn.BCEWithLogitsLoss(weight=None, size_average=True)

BCEWithLogitsLoss损失函数把 Sigmoid 层集成到了 BCELoss 类中。比用一个简单的 Sigmoid 层和 BCELoss 在数值上更稳定, 因为把这两个操作合并为一个层之后, 可以利用 log-sum-exp 的 技巧来实现数值稳定.

9、CTCLoss

10、MarginRankingLoss

11、HingeEmbeddingLoss

12、MultiLabelMarginLoss

13、SmoothL1Loss

14、SoftMarginLoss

15、MultiLabelSoftMarginLoss

16、CosineEmbeddingLoss

17、MultiMarginLoss

18、TripletMarginLoss

19、PoissonNLLLoss

torch.nn.PoissonNLLLoss(log_input=True, full=False, eps=1e-08, reduction='mean')