An End-toEnd Network for Panoptic Segmentation 论文解读

An End-to-End Network for Panoptic Segmentation 论文解读

- 摘要

- 1.概述

- 2.相关工作

-

- 2.1.实例分割

- 2.2.语义分割

- 2.3.全景分割

- 2.4.多任务学习

- 3.提出的端到端框架

-

- 3.1.端到端网络结构

- 3.2.空间排名模块(Spatial Ranking Module)

- 4.实验

-

- 4.1数据集及验证度量标准

- 4.2.实施细节

- 4.3.网络结构的消融研究

- 4.4. 空间排名模块的消融研究

- 5.结论

本篇文章用于自己阅读文献的相关笔记,原文链接: http://openaccess.thecvf.com/content_CVPR_2019/papers/Liu_An_End-To-End_Network_for_Panoptic_Segmentation_CVPR_2019_paper.pdf

摘要

全景分割为图片的每一个像素分配一个类标签同时对每一个对象实例进行分割是一个非常具有挑战性的课题。 传统的现有方法通常使用两种独立的模型,没有进行特征的共享,这使得该课题推广起来效率低下。此外,一种启发式方法通常采用合并结果的方式。但是,这种合并因为缺乏足够的上下文关系,从而很难确定对象实体之间的重叠关系。为了解决这个问题,本文提出了一种新颖的用于全景分割的端到端遮挡感知网络(OANet),能够通过一个单独的网络有效预测实例和语义分割。此外,我们介绍了一种新颖的空间排名模块来处理预测实例之间的遮挡问题。我们进行了广泛的实验来验证我们提出的方法的性能,并在COCO Panoptic基准测试中获得了可喜的成果。

1.概述

全景分割是场景理解的新挑战。目标是为每个像素分配一个类别标签,并分割图像中的每个对象实例。在此任务中,填充分割用于预测无定型区域(记为Stuff),而实例分割解决可数对象(记为Thing)。因此,该任务可以提供更全面的场景信息,并可广泛运用于自动驾驶和场景解析。

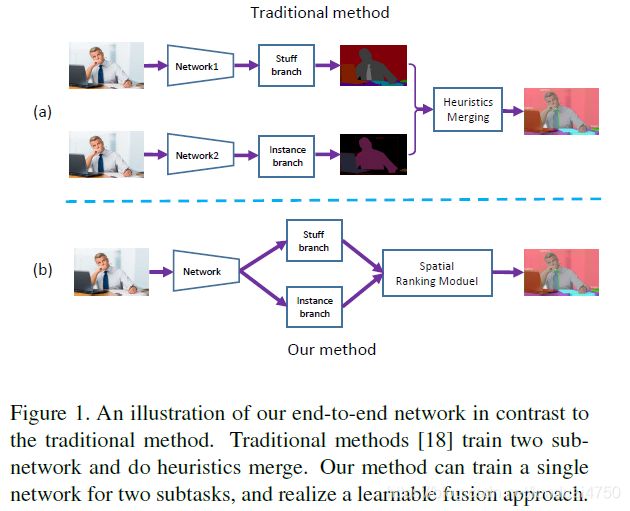

以前的全景分割算法通常包括三个分开的部分:实例分割块,语义分割块和结合块,如图1(a)所示:

这些算法的实例和语义分割模块通常是独立的,没有进行特征分享,造成了明显的计算开销。此外,由于模型的分离,这些算法需要后续处理来结合对应的各自的预测结果。然而,没有stuff和thing之间的上下文关系,结合处理会面临stuff和thing之间的重叠。正如上文所述,利用三个分开部分的模型,很难将这个复杂的途径运用到工业应用中。

在本文中,我们提出了一种新颖的端到端的算法,如图1(b)所示。就目前我们知道的,这是第一个可用于解决该问题的算法。具体来说,我们将实例分割和事物分割合并到了一个网络中,该网络共享主干功能,但这两个任务应用不同的头分支。在训练阶段,主干特征将通过监控stuff和thing的累计损失来优化,而总分支只会对特定任务进行微调。

为了解决对象实例之间的重叠关系,我们还提出了一种新的名叫空间排名模块(Spatial Ranking Module)的算法,这个模块学习排名分数,并提供实例的排序依据。

一般地,我们将我们的算法的贡献总结如下:

• 我们是第一个提出一个端到端遮挡感知网络来解决全景分割任务。

• 我们提出了一个新颖的空间排名模块来解决全景分割中普遍存在的重叠关系的歧义性。

• 我们在全景分割数据集上获得了最先进的性能。

2.相关工作

2.1.实例分割

目前有两种主要的实例分割框架,包括基于提议的方法(proposal-based methods)和基于分割的方法(segmentation-based methods)。基于提议的方法[8,14,24,25,28,29,33]先生成一个对象检测边界框,然后在每个框上执行蒙版预测以进行实例分割。这些方法与目标检测紧密相关,如Fast/Faster R-CNN 以及SPPNet[12,15,36]。在这个框架下,对不同实例进行独立预测产生了重叠问题。就是说,被多种蒙版覆盖的像素可能会被分配到错误的类。基于分割的方法,采用语义分割网络来预测像素类别,并通过解码对象边界[19]或自定义字段[2,9,27]来获得每个实例蒙版。最后,他们使用自下而上的分组机制来生成对象实例。在[35,37,46]中,利用递归神经网络(RNN)方法来一次预测每个实例的蒙版。

2.2.语义分割

语义分割已被广泛研究,并且近年来提出了许多新方法。在强大的深度神经网络[16,21,39,40]的驱动下,FCN[30]通过将图像分类网络的完全连接层替换成卷积层,成功将深度学习应用于逐像素图像语义分割。

诸如UNet[1,38,42,43,47]之类的编解码器结构可以逐渐恢复分辨率并捕获更多对象细节。全局卷积网络(Global Convolutional NetWork)[34]提出了一种大核的方法来缓解分类和定位之间的矛盾。DFN[43]设计了一个频道关注块(channel attention block)来选择特征图。DeepLab[4,6]和PSPNet[48]采用扩张空间金字塔池化或空间金字塔池化来得到多尺度上下文关系。[44]中的方法采用扩张卷积来扩大视野。[5,13,41]中使用多尺度特征来获得足够的接收域。

相关数据集也在不断丰富和扩展。目前有公开的数据集如VOC[11],Cityscapes[7],ADE20K[49],Mapillary Vistas[32]以及COCO Stuff[3]。

2.3.全景分割

全景分割课题在[18]中最先被提出,目前关于这个课题的研究工作还不是很多。[22]提出了一种弱监督模型,该模型联合执行语义和实例分割。该模型对“thing"类使用弱边界框注释,对"stuff"类使用图像级标记。JSIS-Net[10]提出了一个具有实例分割头[14]和金字塔stuff分割头的单一网络,遵循启发式方法将两种输出合并。Li等人[23]提出的AUNet可以利用提案和蒙版等级注意并获得更好的背景结果。

2.4.多任务学习

全景分割也可以被看做多任务学习问题。两个不同的课题可以通过策略[17,31]一起训练。UberNet[20]在单个网络中共同处理低,中,高级视觉任务,包括边缘检测,语义分割和法向量估计。Zamir等人[45]建立了一个名为taskonomy的有向图,它可以有效地测量和利用不同视觉任务之间的相关性。它可以避免重复学习,并可以使用更少的数据进行学习。

3.提出的端到端框架

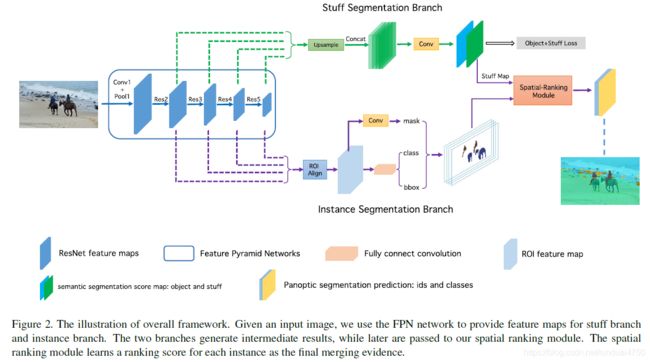

我们的算法概貌如图2所示。我们的算法主要包括三个主要的部分:1)stuff分支用于预测整个输入的stuff分割。2)实例分支提供实例分割预测。3)空间排名模块为每一个实例生成一个排名分数。

3.1.端到端网络结构

我们采用FPN[26]作为端到端网络的骨干架构。对于实例分割,我们采用原始的Mask R-CNN[14]作为我们的网络架构。我们使用自下而上的路径和横向连接来获取特征图。然后附加一个3Χ3的卷积层来获得特征图。在这之后,我们采用ROIAlign[14]层来提取对象提议特征并获得三个预测:提议分类分数,提议边界框坐标以及提议实例蒙版。

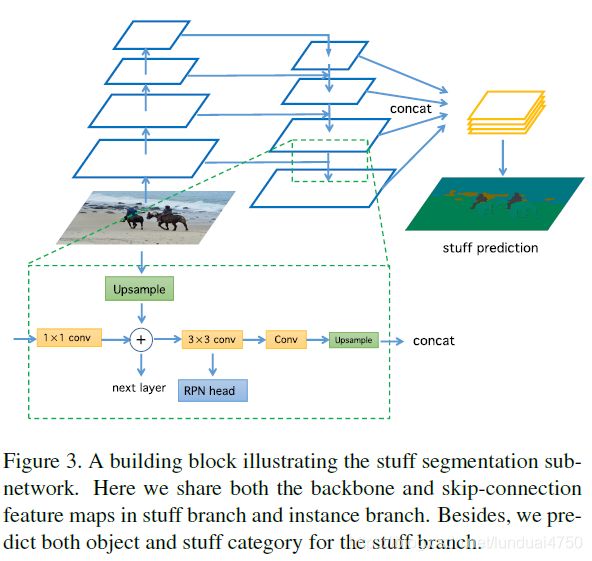

对于stuff分割,将两个3x3卷积层堆叠在RPN特征图上。为了进行多尺度特征提取,我们然后将这些层与后续的一个3x3卷积层和1x1卷积层连接起来。图3展示了stuff分支的细节。在训练期间,我们会同时监督stuff分割和thing分割,因为辅助的对象信息可以为stuff预测提供对象上下文信息。在推理过程中,我们仅提取stuff预测并将其标准化为概率。

为了突破训练过程中的信息流障碍,并使整个管道更高效,我们共享两个分支机构的骨干网的功能。这里提出的问题可以分为两个部分:1)特征图上的共享粒度;2)实例损失和stuff损失之间的平衡。实际上,我们发现,随着更多的特征图被共享,我们可以获得更好的性能。因此,我们共享特征图直接跳过连接层,即RPN头之前的3x3卷积层,如图3所示。

L t o t o a l = L r p n _ c l s + L r p n _ b b o x + L c l s + L b b o x + L m a s k ⏟ i n s t a n c e b r a n c h + λ ⋅ L s e g _ ( s t u f f + o b j e c t ) ⏟ + L s r m s t u f f b r a n c h (1) L_{totoal}=\underbrace{L_{rpn\_cls}+L_{rpn\_bbox}+L_{cls}+L_{bbox}+L_{mask}}\\instance{\space}branch\\+{\underbrace{\lambda{\cdot}L_{seg\_(stuff+object)}}}+L_{srm}\\stuff{\space}branch\tag{1} Ltotoal= Lrpn_cls+Lrpn_bbox+Lcls+Lbbox+Lmaskinstance branch+ λ⋅Lseg_(stuff+object)+Lsrmstuff branch(1)

关于两个监督的平衡,我们首先在等式1中给出多重损失。实例分支包括5种损失: L r p n _ c l s L_{rpn\_cls} Lrpn_cls是RPN objectness loss, L r p n _ b b o s L_{rpn\_bbos} Lrpn_bbos是RPN边界框损失(RPN bounding-boxloss), L c l s L_{cls} Lcls是分类损失(classification loss), L b b o x L_{bbox} Lbbox是对象边界框回归损失(object bounding-box regression loss),以及 L m a s k L_{mask} Lmask是用于蒙版预测的平均二进制交差熵损失(average binary cross-entropy loss)。对于stuff分支只有一个名为 L s e g _ ( s t u f f + o b j e c t ) L_{seg\_(stuff+object)} Lseg_(stuff+object)的语义分割损失。超参数 λ \lambda λ损失平衡,将在后面讨论。 L s r m L_{srm} Lsrm表示空间排名模块的损失函数,将在下一节进行描述。

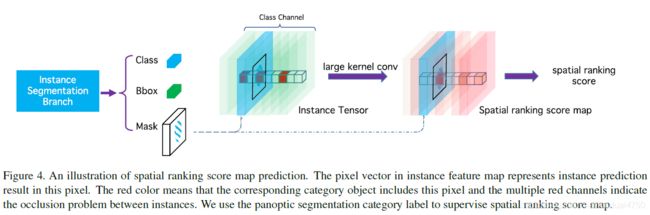

3.2.空间排名模块(Spatial Ranking Module)

现代的实例分割框架通常基于带有附加蒙版预测分支的目标检测网络,例如通常基于FPN[26]的Mask RCNN[14]。一般而言,当前的目标检测框架不考虑不同类别之间的重叠问题,因为流行的度量(例如AP和AR)不受该问题的影响。但是,在全景分割的任务中,由于一幅图像中的像素数量是固定的,因此必须解决重叠问题,或者特别是针对一个像素的多个分配问题。

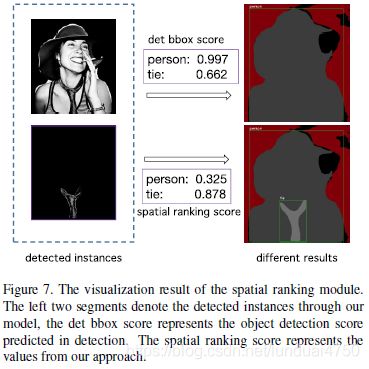

通常,检测分数用于按降序对实例进行排序,然后根据较大分数对象位于较低分数对象之上的规则将其分配给填充画布。但是,这种启发式算法在实践中很容易失败。例如让我们想象一个带着领带的人,如图7所示。由于在COCO数据集中人类别比领带类别出现更频繁,因此其检测分数往往高于领带边框。因此通过上面的简单规则,领带实例被人类实例覆盖,导致性能下降。

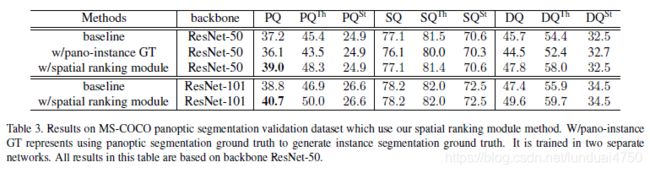

我们是否能够通过全景注释来缓解这一现象?就是说我们强迫网络在领带的地方学习有洞的人注释,我们能避免上述的情况吗?如表3所示,我们使用上述注释进行了实验,但只发现了衰减的性能。因此,该方法当前不适用。

为了解决这个问题,我们诉诸于一种类似语义的方法,并提出了一种简单但非常有效的算法来处理遮挡问题,称为空间排序模块。如图4所示,我们首先将实例分割的结果映射为输入尺寸的张量。特征图的维度是对象类别的数目,而且不同类别的实例被映射到相应的通道。实例张量被初始化为0,对应的映射值被设置为1。然后我们在张量之后追加大卷积核[34],以获得排名得分图。最后,如式2所示,我们使用逐像素交差熵损失函数来优化排名得分图。 S m a p S_{map} Smap代表输出排名得分图, S l a b e l S_{label} Slabel代表相应的非重叠语义标签。

L s r m = C E ( S m a p , S l a b e l ) (2) L_{srm}=CE(S_{map},S_{label})\tag{2} Lsrm=CE(Smap,Slabel)(2)

在获得排名分数图后,我们按公式3计算每个实例对象的排名分数。这里, S i , j , c l s S_{i,j,cls} Si,j,cls表示类别cls的 ( i , j ) (i,j) (i,j)中的排名得分值,注意 S i , j , c l s S_{i,j,cls} Si,j,cls已被归一化为概率分布。 m i , j m_{i,j} mi,j是蒙板指示符,表示像素 ( i , j ) (i,j) (i,j)是否属于该实例。整个实例的排名得分 P o b j s P_{objs} Pobjs是通过蒙板中像素排名得分的平均值计算得到的。

P o b j s = ∑ ( i , j ) ∈ o b j s S i , j , c l s ⋅ m i , j ∑ ( i , j ) ∈ o b j s m i , j (3) P_{objs}=\frac{\sum_{(i,j)\in{objs}}S_{i,j,cls}\cdot{m_{i,j}}}{\sum_{(i,j)\in{objs}}m_{i,j}}\tag{3} Pobjs=∑(i,j)∈objsmi,j∑(i,j)∈objsSi,j,cls⋅mi,j(3)

m i , j = { 0 ( i , j ) ∈ i n s t a n c e 1 ( i , j ) ∉ i n s t a n c e (4) m_{i,j}= \begin{cases} 0& (i,j)\in{instance} \\ 1& (i,j)\notin{instance} \end{cases} \tag{4} mi,j={01(i,j)∈instance(i,j)∈/instance(4)

让我们通过提出的空间排名模块重新考虑上述示例。当将人蒙板和领带蒙板发送进这个模块时,我们使用公式3获得这两个对象的空间排名得分。在排名分数内,前一种方法中的排序规则可以更可靠,并且性能得到改善,就像下一节中介绍的实验一样。

4.实验

4.1数据集及验证度量标准

数据集: 我们所有的实验都是在COCO全景分割数据集[18]上进行的。这个数据集包含118K张图片用于训练,5K张图片用于验证,标注了80类thing以及53类stuff。我们仅将训练图像用于模型训练并在验证集上进行测试。最后我们将测试开发结果提交给COCO 2018全景分割排行榜。

评估指标: 我们采用[18]中定义的标准评估指标,称为全景质量(PQ)。它包含两个因素:1)分割质量(SQ)度量所有类别的质量,2)检测质量(DQ)仅度量实例类。PQ、SQ和DQ的数学形式在等式5中给出,其中p和g是预测值和真实值,TP、FP、FN表示真正例、假正例和假反例。很容易发现SQ是匹配实例的常用平均IOU度量,而DQ可以看作是检测精度的一种形式。匹配阈值设置为0.5,即如果预测值和真实值的像素IOU大于0.5,则认为预测匹配,否则不匹配。对于stuff类,图像中的每个stuff类都被视为一个实例,无论其形状如何。

P Q = ∑ ( p , g ) ∈ T P I O U ( p , g ) ∣ T P ∣ ⏟ × ∣ T P ∣ ∣ T P ∣ + 1 2 ∣ F P ∣ + 1 2 ∣ F N ∣ ⏟ S e g m e n t a t i o n Q u a l i t y ( S Q ) D e t e c t i o n Q u a l i t y ( D Q ) (5) PQ = {\underbrace{{\frac{\sum_{(p,g)\in{TP}}IOU(p,g)}{|TP|}}}}\times{\underbrace{{\frac{|TP|}{|TP|+\frac{1}{2}|FP|+\frac{1}{2}|FN|}}}}\\\tiny{Segmentation\space{Quality(SQ)}\qquad\qquad{Detection\space{Quality(DQ)}}} \tag{5} PQ= ∣TP∣∑(p,g)∈TPIOU(p,g)× ∣TP∣+21∣FP∣+21∣FN∣∣TP∣Segmentation Quality(SQ)Detection Quality(DQ)(5)

4.2.实施细节

我们选择在ImageNet上经过预训练的ResNet-50[16]进行消融研究(类似于控制变量法)。我们采用动量值为0.9和权值衰减为0.0001的SGD(随机梯度下降算法)作为我们的优化算法。采用了具有预热策略[33]的多阶段学习率策略。也就是说,在前2000次迭代中,我们通过将学习率从0.002提高到0.02的线性预热策略。经过60,000次迭代之后,我们将接下来的20,000次迭代的学习率降低至0.002,然后将其余20,000次迭代的学习率设置为0.0002。输入的批处理大小设置为16,这意味着每个GPU一次迭代消费两个图像。对于其他的细节,我们采用Mask-RCNN[14]的经验。

除了对我们网络的两个分支进行训练外,还应该更多的关注空间排名模块。在训练过程中,监督标签是对应的非重叠语义标签,并将其训练为语义分段网络。我们忽略非冲突像素来将网络强制集中在冲突区域上。

在推理过程中,我们将每个图像的最大框数设置为100,并将已连接的stuff区域的最小框数设置为4900。至于空间排名模块,由于我们现在还没有真实值,因此实例分支的输出将通过此模块来解决重叠问题。

4.3.网络结构的消融研究

在本小节中,我们重点介绍端到端网络设计的属性。应该讨论以下三点:损失平衡参数,stuff分支的对象上下文以及两个分支的共享模式。为了避免实验的笛卡尔积,我们仅修改特定参数,并以最佳方式控制其他参数。

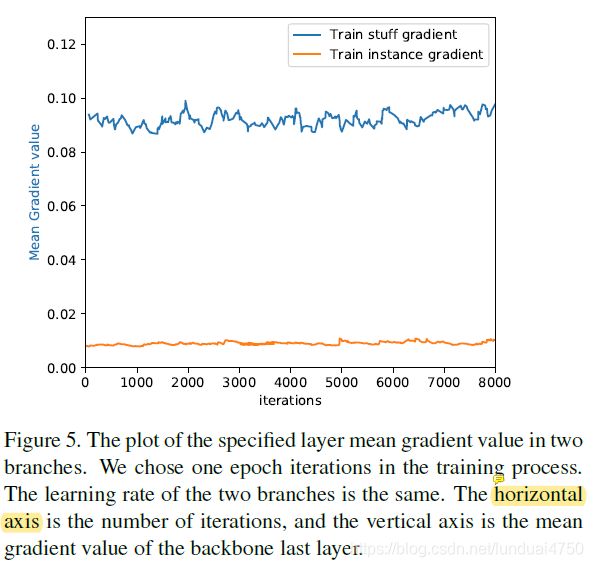

损失平衡问题来自这样一个现实,即stuff分支和instance分支(语义分支和实例分支)的梯度不解近。我们对两个分支相对于主干的最后一个特征图的平均梯度进行统计,在这里,为了公平起见,将超参数 λ \lambda λ设置为1。

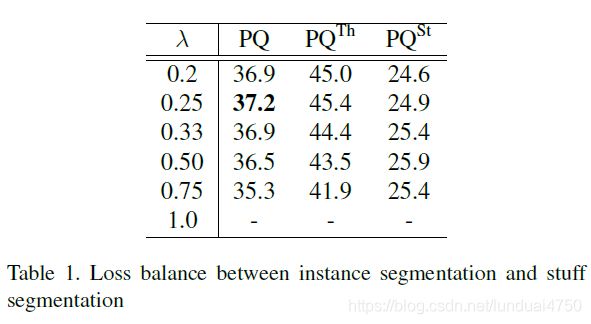

如图5所示,简短明了的是,来自stuff分支的梯度在惩罚信号中占主导地位。因此,我们从等式1中获取一个超参数 λ \lambda λ来平衡梯度。我们用 λ ∈ [ 0.2 , 0.25 , 0.33 , 0.5 , 0.75 , 1.0 ] \lambda\in[0.2,0.25,0.33,0.5,0.75,1.0] λ∈[0.2,0.25,0.33,0.5,0.75,1.0]来进行实验。为了搜索效率,间隔是不均匀的。如表1总结的, λ = 0.25 \lambda=0.25 λ=0.25是最佳选择。注意如果我们设置 λ = 1 \lambda=1 λ=1,这意味着实例分支和stuff分支像单独的模型一样训练,则网络将无法通过我们的默认学习策略进行收敛。

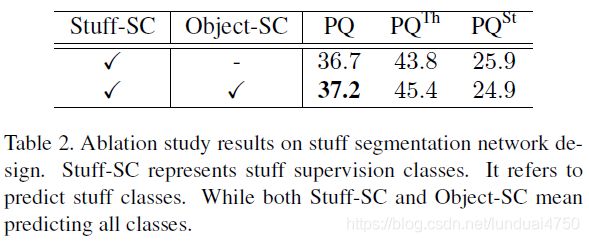

对象上下文是stuff分割中的自然选择。尽管我们只希望从这个分支中进行stuff预测,但缺乏对象监督会在真值中引入空洞,导致对象的上下文不连续。因此,我们进行了一组对比实验,一个对所有133个类别进行了监督,而另一个则在53个stuff类上进行训练。表2的结果显示,在具有对象上下文的情况下,整体PQ值增加了0.5。

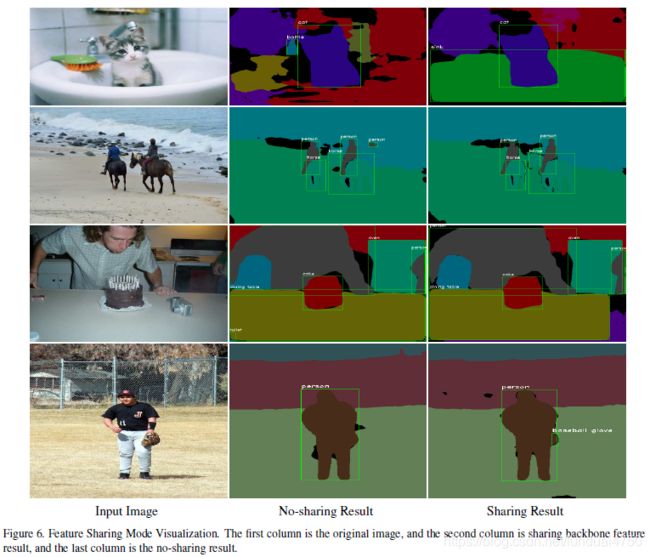

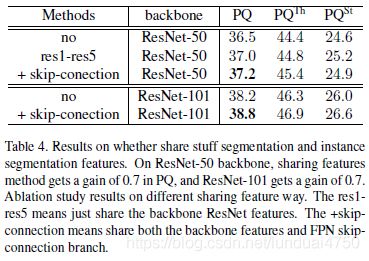

共享特征是我们网络设计的关键。共享有两个好处:1)两个分支可以吸收其他监督信号中的有用信息。2)如果共享网络只计算一次,则可以节省计算资源。为了研究共享特征的粒度,我们进行了两个实验,其中浅共享模型(shallow share model)仅共享主干特征,而深共享模型(deep share model)进一步共享RPN头之前的特征图,如图3所示。表4显示了不同设置之间的比较,深共享模型在PQ值上优于单独的训练基准0.7%。图6展示了共享特征的可视化。

4.4. 空间排名模块的消融研究

用不重叠的注释监督是解决对象排名问题的一个直截了当的方法。这里,我们提炼全景真值,并提取不重叠的注释用于实例分割。表3的第3行给出了这个想法的结果。不幸的是,仅仅替换实例真值不能帮助提升性能,而且可能反过来降低对象的准确率和召回率。这个现象可能来源于COCO中的对象没有遇到重叠问题这一事实,并且迫使网络去学习非重叠会损害整体性能。

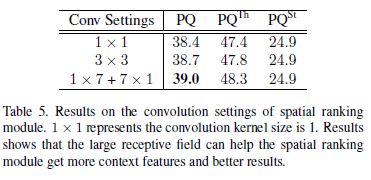

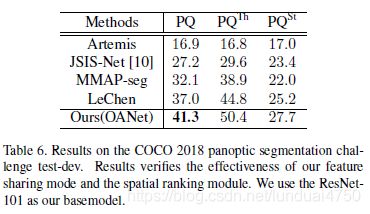

本文提出的空间排名模块旨在解决全景分割中的重叠问题。表5显示更大的接收域能够帮助空间排名模块获取更多的上下文关系和更好的结果。正如我们在表3中关于ResNet-101的第三行和第二行看到的那样,我们的空间排名模块得到的的PQ值在上述提到的端到端基准上提升了1.8%。具体来说, P Q T h PQ^{Th} PQTh提升了2.9%,而 P Q S t PQ^{St} PQSt保持不变。这些事实证明我们的空间排名模块是合理的。如表6所示,我们在COCO test-dev上测试了我们的OANet。与其他结果比较,我们的方法实现了最好的结果。有关详细结果,请参阅http://cocodataset.org/#panoptic-leaderboard。

图7解释了我们的空间排名模块的原理。对于输入示例图片,网络预测一个人带着领带,他们的边界框得分分别为0.997和0.662。如果我们用分数来决定结果,领带将会被人完全覆盖。但是,在我们的方法中,我们可以获得每一个实例的空间排名分数,分别为0.325和0.878。借助新分数,我们可以进行正确的预测。图8总结了更多示例。

5.结论

在本篇文章中,我们提出了一个新颖的端到端遮挡感知算法它将常见的语义分割和实例分割合并为单个模型。为了更好地利用不同的监督,并减少计算资源的消耗,我们研究了不同分支之间的特征共享,发现应该共享尽可能多的特征。此外我们还观察了全景分割中出现的特定排名问题,并且设计了一个简单但高效的空间排名模块来处理这个问题。实验结果表明,我们的方法优于以前的最新模型。

[参考文档]

[1] V. Badrinarayanan, A. Kendall, and R. Cipolla. Segnet: A deep convolutional encoder-decoder architecture for image segmentation. IEEE TPAMI, 2017.

[2] M. Bai and R. Urtasun. Deep watershed transform for instance segmentation. In CVPR, 2017.

[3] H. Caesar, J. Uijlings, and V. Ferrari. Coco-stuff: Thing and stuff classes in context. In CVPR, 2018.

[4] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs. IEEE TPAMI, 2018.

[5] L.-C. Chen, Y. Yang, J. Wang, W. Xu, and A. L. Yuille. Attention to scale: Scale-aware semantic image segmentation. In CVPR, 2016.

[6] L.-C. Chen, Y. Zhu, G. Papandreou, F. Schroff, and H. Adam. Encoder-decoder with atrous separable convolution for semantic image segmentation. In ECCV, 2018.

[7] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele. The cityscapes dataset for semantic urban scene understanding. In CVPR, 2016.

[8] J. Dai, K. He, and J. Sun. Instance-aware semantic segmentation via multi-task network cascades. In CVPR, 2016.

[9] B. De Brabandere, D. Neven, and L. Van Gool. Semantic instance segmentation with a discriminative loss function. arXiv:1708.02551, 2017.

[10] D. de Geus, P. Meletis, and G. Dubbelman. Panoptic segmentation with a joint semantic and instance segmentation network. arXiv:1809.02110, 2018.

[11] M. Everingham, S. A. Eslami, L. Van Gool, C. K. Williams, J. Winn, and A. Zisserman. The pascal visual object classes challenge: A retrospective. In IJCV, 2015.

[12] R. Girshick, J. Donahue, T. Darrell, and J. Malik. Rich feature hierarchies for accurate object detection and semantic segmentation. In CVPR, 2014.

[13] B. Hariharan, P. Arbel´aez, R. Girshick, and J. Malik. Hypercolumns for object segmentation and fine-grained localization. In CVPR, 2015.

[14] K. He, G. Gkioxari, P. Doll´ar, and R. Girshick. Mask r-cnn. In ICCV, 2017.

[15] K. He, X. Zhang, S. Ren, and J. Sun. Spatial pyramid pooling in deep convolutional networks for visual recognition. In ECCV, 2014.

[16] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In CVPR, 2016.

[17] A. Kendall, Y. Gal, and R. Cipolla. Multi-task learning using uncertainty to weigh losses for scene geometry and semantics. In CVPR, 2018.

[18] A. Kirillov, K. He, R. Girshick, C. Rother, and P. Doll´ar. Panoptic segmentation. arXiv:1801.00868, 2018.

[19] A. Kirillov, E. Levinkov, B. Andres, B. Savchynskyy, and C. Rother. Instancecut: from edges to instances with multicut. In CVPR, 2017.

[20] I. Kokkinos. Ubernet: Training a universal convolutional neural network for low-, mid-, and high-level vision using diverse datasets and limited memory. In CVPR, 2017.

[21] A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenet classification with deep convolutional neural networks. In NIPS, 2012.

[22] Q. Li, A. Arnab, and P. H. Torr. Weakly-and semi-supervised panoptic segmentation. In ECCV, 2018.

[23] Y. Li, X. Chen, Z. Zhu, L. Xie, G. Huang, D. Du, and X.Wang. Attention-guided unified network for panoptic segmentation. arXiv:1812.03904, 2018.

[24] Y. Li, H. Qi, J. Dai, X. Ji, and Y. Wei. Fully convolutional instance-aware semantic segmentation. In CVPR, 2017.

[25] Z. Li, C. Peng, G. Yu, X. Zhang, Y. Deng, and J. Sun. Detnet: Design backbone for object detection. In Proceedings of the European Conference on Computer Vision (ECCV), pages 334–350, 2018.

[26] T.-Y. Lin, P. Doll´ar, R. B. Girshick, K. He, B. Hariharan, and S. J. Belongie. Feature pyramid networks for object detection. In CVPR, 2017.

[27] S. Liu, J. Jia, S. Fidler, and R. Urtasun. Sgn: Sequential grouping networks for instance segmentation. In ICCV, 2017.

[28] S. Liu, L. Qi, H. Qin, J. Shi, and J. Jia. Path aggregation network for instance segmentation. In CVPR, 2018.

[29] S. Liu, X. Qi, J. Shi, H. Zhang, and J. Jia. Multi-scale patch aggregation (mpa) for simultaneous detection and segmentation. In CVPR, 2016.

[30] J. Long, E. Shelhamer, and T. Darrell. Fully convolutional networks for semantic segmentation. In CVPR, 2015.

[31] I. Misra, A. Shrivastava, A. Gupta, and M. Hebert. Crossstitch networks for multi-task learning. In CVPR, 2016.

[32] G. Neuhold, T. Ollmann, S. R. Bul`o, and P. Kontschieder. The mapillary vistas dataset for semantic understanding of street scenes. In ICCV, 2017.

[33] C. Peng, T. Xiao, Z. Li, Y. Jiang, X. Zhang, K. Jia, G. Yu, and J. Sun. Megdet: A large mini-batch object detector. In CVPR, 2018.

[34] C. Peng, X. Zhang, G. Yu, G. Luo, and J. Sun. Large kernel matters—improve semantic segmentation by global convolutional network. In CVPR, 2017.

[35] M. Ren and R. S. Zemel. End-to-end instance segmentation with recurrent attention. In CVPR, 2017.

[36] S. Ren, K. He, R. Girshick, and J. Sun. Faster r-cnn: Towards real-time object detection with region proposal networks. In NIPS, 2015.

[37] B. Romera-Paredes and P. H. S. Torr. Recurrent instance segmentation. In ECCV, 2016.

[38] O. Ronneberger, P. Fischer, and T. Brox. U-net: Convolutional networks for biomedical image segmentation. In MICCAI, 2015.

[39] K. Simonyan and A. Zisserman. Very deep convolutional networks for large-scale image recognition. arXiv:1409.1556, 2014.

[40] C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich. Going deeper with convolutions. In CVPR, 2015.

[41] F. Xia, P. Wang, L.-C. Chen, and A. L. Yuille. Zoom better to see clearer: Human and object parsing with hierarchical auto-zoom net. In ECCV, 2016.6180

[42] C. Yu, J. Wang, C. Peng, C. Gao, G. Yu, and N. Sang. Bisenet: Bilateral segmentation network for real-time semantic segmentation. In ECCV, 2018.

[43] C. Yu, J.Wang, C. Peng, C. Gao, G. Yu, and N. Sang. Learning a discriminative feature network for semantic segmentation. In CVPR, 2018.

[44] F. Yu and V. Koltun. Multi-scale context aggregation by dilated convolutions. arXiv:1511.07122, 2015.

[45] A. R. Zamir, A. Sax, W. Shen, L. J. Guibas, J. Malik, and S. Savarese. Taskonomy: Disentangling task transfer learning. In CVPR, 2018.

[46] Z. Zhang, A. G. Schwing, S. Fidler, and R. Urtasun. Monocular object instance segmentation and depth ordering with cnns. In CVPR, 2015.

[47] Z. Zhang, X. Zhang, C. Peng, X. Xue, and J. Sun. Exfuse: Enhancing feature fusion for semantic segmentation. In ECCV, 2018.

[48] H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia. Pyramid scene parsing network. In CVPR, 2017.

[49] B. Zhou, H. Zhao, X. Puig, S. Fidler, A. Barriuso, and A. Torralba. Scene parsing through ade20k dataset. In CVPR, 2017.