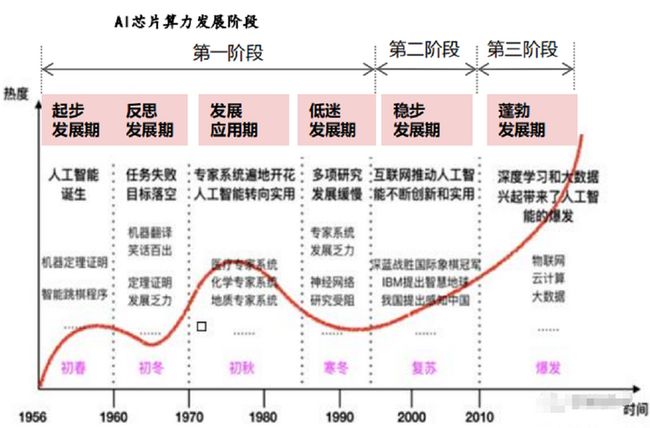

一、人工智能经历过三个阶段,迎来爆发式增长

广义上讲只要能够运行人工智能算法的芯片都叫作AI芯片。但是通常意义上的AI芯片指的是针对人工智能算法做了特殊加速设计的芯片。

AI芯片也被称为AI加速器或计算卡,即专门用于处理人工智能应用中的大量计算任务的模块(其他非计算任务仍由CPU负责)。

第一阶段:因为芯片算力不足,所以神经网络没有受到重视;

第二阶段:通用芯片CPU的算力大幅提升,但仍然无法满足神经网络的需求;

第三阶段:GPU和和新架构的AI芯片推进人工智能落地。

事件1:2014年李天石博士“DianNao”系列论文让科学界看到,在冯诺依曼架构下也可以实现AI专用芯片;

事件2:Google推出的TPU运算架构的AlphaGo,接连打败李世石和柯洁,看到了专用芯片的商业价值。

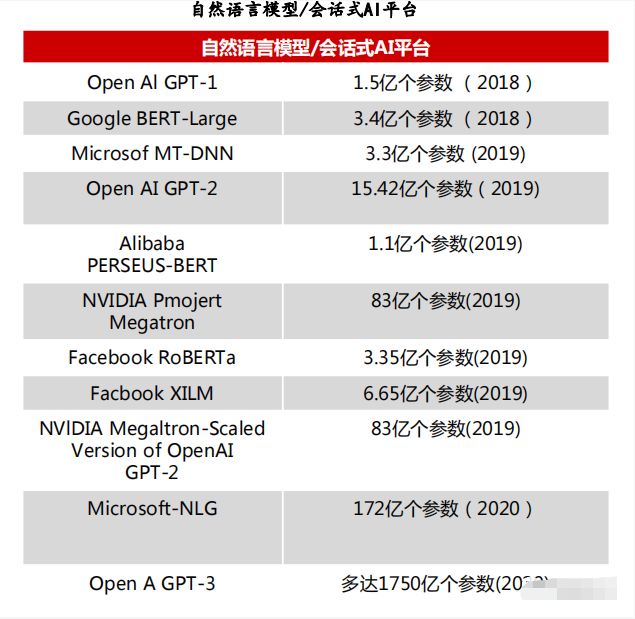

二、推荐式系统模型参数,复杂度大幅增加

GPT-3模型目前已入选了《麻省理工科技评论》2021年“十大突破性技术。

GPT-3的模型使用的最大数据集在处理前容量达到了45TB。根据OpenAI的算力统计单位petaflops/s-days,训练AlphaGoZero需要1800-2000pfs-day,而GPT-3用了3640pfs-day。

算力时代,GPU开拓新场景

三、深度学习模型复杂度对芯片,算力需求激增

AI运算指以“深度学习”为代表的神经网络算法,需要系统能够高效处理大量非结构化数据(文本、视频、图像、语音等)。需要硬件具有高效的线性代数运算能力,计算任务具有:单位计算任务简单,逻辑控制难度要求低,但并行运算量大、参数多的特点。对于芯片的多核并行运算、片上存储、带宽、低延时的访存等提出了较高的需求。

自2012年以来,人工智能训练任务所需求的算力每3.43个月就会翻倍,大大超越了芯片产业长期存在的摩尔定律(每18个月芯片的性能翻一倍)。

针对不同应用场景,AI芯片还应满足:对主流AI算法框架兼容、可编程、可拓展、低功耗、体积及价格等需求。

算力时代,GPU开拓新场景

四、部署位置对AI芯片性能,要求差异

根据机器学习算法步骤,可分为训练芯片和推断芯片。训练芯片主要是指通过大量的数据输入,构建复杂的深度神经网络模型的一种AI芯片,运算能力较强。推断芯片主要是指利用训练出来的模型加载数据,计算“推理”出各种结论的一种AI芯片,侧重考虑单位能耗算力、时延、成本等性能。

从部署的位置来看,AI芯片可分为云端(服务器端)、终端(移动端)两大类。

云端芯片,是指部署在公有云、私有云或混合云上的AI芯片,不仅可用于训练,还可用于推断,算力强劲。

终端芯片,是指应用于手机等嵌入式、移动终端等领域的AI芯片,此类芯片一般体积小、耗电低、性能无需特别强大。

五、GPU是较为成熟的通用型,人工智能芯片

从技术架构来看,AI芯片主要分为图形处理器、现场可编程门阵列、专用集成电路、类脑芯片四大类。

其中,GPU是较为成熟的通用型人工智能芯片,FPGA和ASIC则是针对人工智能需求特征的半定制和全定制芯片,类脑芯片颠覆传统冯诺依曼架构,是一种模拟人脑神经元结构的芯片,类脑芯片的发展尚处于起步阶段。

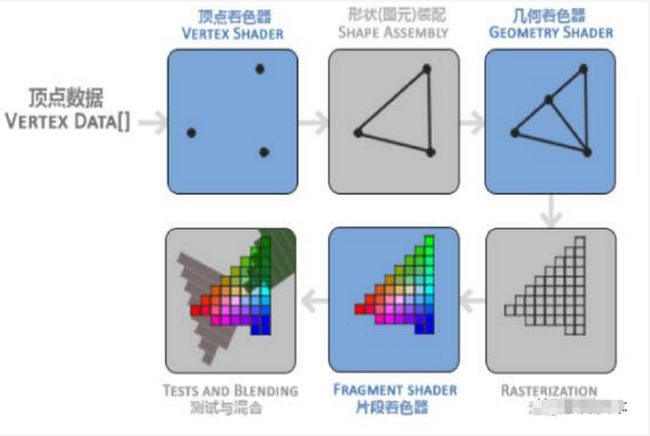

六、GPU设计之初用于显示,图像使用

GPU图形渲染流水线的具体实现可分为六个阶段,如图所示。

顶点着色器(VertexShader);

形状装配(ShapeAssembly),又称图元装配;

几何着色器(GeometryShader);

光栅化(Rasterization);

片段着色器(FragmentShader);

测试与混合(TestsandBlending)。

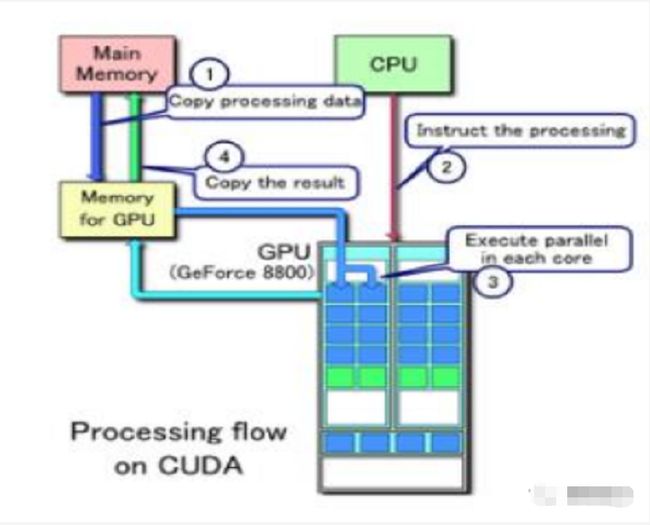

七、GPU适合并行运行,大量计算

GPU(图形处理器)又称显示核心、显卡、视觉处理器、显示芯片或绘图芯片,是一种专门在个人电脑、工作站、游戏机和一些移动设备(如平板电脑、智能手机等)上运行绘图运算工作的微处理器。

GPU使显卡减少对CPU的依赖,并分担部分原本是由CPU所担当的工作,尤其是在进行三维绘图运算时,功效更加明显。图形处理器所采用的核心技术有硬件坐标转换与光源、立体环境材质贴图和顶点混合、纹理压缩和凹凸映射贴图、双重纹理四像素256位渲染引擎等。

GPU是一种特殊类型的处理器,具有数百或数千个内核,经过优化,可并行运行大量计算。虽然GPU在游戏中以3D渲染而闻名,但它们对运行分析、深度学习和机器学习算法尤其有用。

来源:本文整理【驭势资本】