A ConvNet for the 2020s 论文解读

目录

引言

一、Swin-Transform 的介绍

1.1、Swin-transform 背景介绍

1.2 、CNN 网络的反击

1.2.1、Depth-wise conv 反击

1.2.2、ConvNext

二、 ResNet 到 ConVNeXt

2.1、训练策略

2.2、Changing stage compute ratio

2.3、ResNeXt-ify (depth-wise)

2.4、Inverted Bottleneck

2.5、Large Kernel Sizes

2.6、微观设计

2.6.1 ReLU -> GReLU

2.6.2 减少激活层和归一化层

2.7、其它数据

三、知识补充

最大池化缺点

BN 和 LN 对比

Swin transform 结构图

ResNet 结构速览

引言

ViT提出之后(只针对分类任务),Swin Transform 在图像领域(分类下游任务)的全面大幅度超越 CNN 模型, 仿佛印证了 Attetion 论文中 “Attention Is All You Need ”。当读到 Attetion 论文中这句话时,不自觉的回忆起电视剧中,释迦摩尼出生时,一手指天,一手指地,然道:“天上地下 ,唯我独尊”。

ConVNeXt 这篇文章,通过借鉴 swin TransForm 精心构建的 tricks,卷积在图像领域反超 Transform。这些技巧对分类问题下游的问题也有效果。

不由引我们深思,如何深度学习中,如何设计网络,如何使训练神经网络具有更加优异效果,和思考网络设计的物理意义,ConvNext 借鉴以下技巧:

训练技巧、预训练和网络结构比例

减少激活层和归一化层的使用 (Relu 和 norm 会造成特征损失)

其中 7 * 7 的卷积核效果更优(自己的猜想:卷积核大小和任务目标大小存在关系, 卷积核过小会导致感受野受限,无法提取适合目标任务大小的总体特征,陷入局部特征的僵局)

分离的下采样层+ LN(解决下采样发散问题)

论文地址:https://arxiv.org/pdf/2201.03545.pdf

开源地址:https://github.com/facebookrese

一、Swin-Transform 的介绍

1.1、Swin-transform 背景介绍

自从ViT提出之后,在过去的一年里(2021年),基于transformer的模型在计算机视觉各个领域全面超越CNN模型。然而,这很大程度上都归功于Local Vision Transformer模型,Swin Transformer是其中重要代表。

原生的ViT模型其计算量与图像大小的平方成正比,而 Local Vision Transformer模型由于采用local attention(eg. window attention),其计算量大幅度降低,除此之外,Local Vision Transformer模型往往也采用金字塔结构,这使得它更容易应用到密集任务如检测和分割中,因为密集任务往往输入图像分辨率较高,而且也需要多尺度特征(eg. FPN)。总而言之, Swin Transform 将计算量降低,引入 CNN 多尺度结构,使 Transform 能够解决分类下游问题。

Swin Transform 的强大体现在分类下游任务中的屠榜中(几乎所有视觉任务都屠榜了,瑟瑟发抖,相比于 CNN 网络 测试指标提升巨大)。

目前(2022/1/25 年 COCO 目标检测 , swin transform 还是榜首大哥 ,前10 几乎都是 swin transform 的变体)COCO test-dev Benchmark (Object Detection) | Papers With Code。

1.2 、CNN 网络的反击

1.2.1、Depth-wise conv 反击

微软在去年6年份的工作已经讨论了用7x7 depth-wise conv模拟Local Vision Transformer,并且实现了比Swin Transformer更好的效果。

微软在论文Demystifying Local Vision Transformer: Sparse Connectivity, Weight Sharing, and Dynamic Weight上系统地总结了Local Vision Transformer的三大特性:

- Sparse connectivity:每个token的输出只依赖于其所在local window上tokens,而且各个channel之间是无联系的;(这里忽略了attention中query,key和valude的linear projections,那么attention就其实可以看成在计算好的权重下对tokens的特征进行加权求和,而且是channel-wise的)

- Weight sharing:权重对于各个channel是共享的;

- Dynamic weight:权重不是固定的,而是基于各个tokens动态生成的。

这样总结的话,local attention就和depth-wise conv存在很多的相似之处。首先后者也具有Sparse connectivity:计算只在kernel size范围内(或者说是window内),而且各个channel之间无连接。然后depth-wise conv也具有weight sharing特性,但是卷积核是在所有的空间位置上共享的,而且不同channle采用不同的卷积核。对于第三点,depth-wise conv的卷积核是训练参数,一旦完成训练就是固定的,而不像attention那样是动态的。但是local attention丢失了位置信息,需要位置编码,而depth-wise convolution则不需要。

下图是不同操作的区别:

论文中也设计了基于depth-wise convolution的模型,和Swin模型结构类似:

在ImageNet数据集上,DW-Conv模型效果和Swin模型相当(这里D-DW-Conv增加了动态权重的特性,类似SE模块来动态生成kernel weights):

从这项研究来看,设计好的CNN模型在性能上也是可以和local attention模型匹敌的,这样看local attention模型其实也能用CNN模型来近似实现。一点题外话是之前的CNN模型一般常采用3x3和1x1比较小的卷积核,但是这里采用7x7的卷积核反而大幅度提升模型效果(相比ResNet50),这里也值得深思。

下游任务表现:

引用

作者:小小将 链接:https://www.zhihu.com/question/510965760/answer/2306340067 来源:知乎

1.2.2、ConvNext

MetaAI在论文A ConvNet for the 2020s中, 从ResNet出发并借鉴Swin Transformer提出了一种新的 CNN 模型:ConvNeXt,其效果无论在图像分类还是检测分割任务上均能超过Swin Transformer,而且ConvNeXt和vision transformer一样具有类似的scalability(随着数据量和模型大小增加,性能同比提升)。

二、 ResNet 到 ConVNeXt

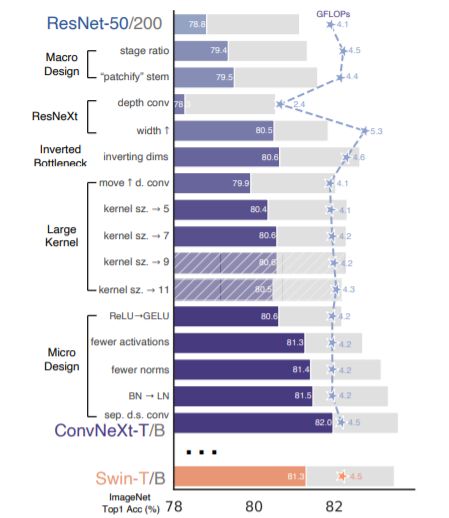

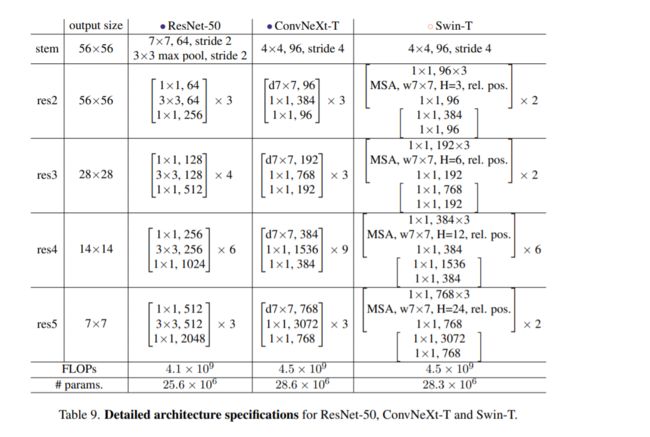

ConvNeXt 从原始的 ResNet 出发,逐步加入swin transform 的 trick,来改进模型。论文中适用 ResNet模型:ResNet50和ResNet200。其中ResNet50和Swin-T有类似的FLOPs(4G vs 4.5G),而ResNet200和Swin-B有类似的FLOPs(15G)。首先做的改进是调整训练策略,然后是模型设计方面的递进优化:宏观设计->ResNeXt化->改用Inverted bottleneck->采用large kernel size->微观设计。由于模型性能和FLOPs强相关,所以在优化过程中尽量保持FLOPs的稳定。

模型效果提升 tricks 总览:

2.1、训练策略

原生的ViT需要大规模数据的预训练,而MetaAI在DeiT论文中提出了一种增强版本的训练策略来解决这个问题,这个训练策略也被随后的vision transformer模型所采用。对于ResNet50,其训练策略比较简单(torchvision版本):batch size是32*8,epochs为90;优化器采用momentum=0.9的SGD,初始学习速率为0.1,然后每30个epoch学习速率衰减为原来的0.1;正则化只有L2,weight decay=1e-4;数据增强采用随机缩放裁剪(RandomResizedCrop)+水平翻转(RandomHorizontalFlip)。而DeiT的训练策略则非常heavy:采用了比较多的数据增强如Mixup,Cutmix和RandAugment;训练的epochs增加至300;训练的optimizer采用AdamW,学习速率schedule采用cosine decay;采用 smooth label 和EMA等优化策略。这里直接将DeiT的训练策略(具体参数设置如下表)应用在ResNet50模型,其性能从原来的76.1%提升至78.8%(+2.7)。这也说明vision transformer模型相比CNN模型的提升很多程度上归功于训练策略的优化,关于这个问题,另外一篇论文Visformer也论证过这一点,而且最近timm库和torchvison库也分别发布了ResNet新的训练策略,并将ResNet50的性能提升至80%+。

我们框架中也可能存在的 adam 优化器的问题:

不查不知道,一查吓一跳,2014年被提出的Adam优化器的收敛性被证明是错误的,之前大部分机器学习框架中对于Adam的权重衰减的实现也都是错误的。关注其收敛性的论文也获得了ICLR 2017的Best Paper,在2017年的论文《Fixing Weight Decay Regularization in Adam》中提出了一种新的方法用于修复Adam的权重衰减错误,命名为AdamW。实际上,L2正则化和权重衰减在大部分情况下并不等价,只在SGD优化的情况下是等价的。而大多数框架中对于Adam+L2正则使用的是权重衰减的方式,两者不能混为一谈。

作者:菜菜鑫

链接:https://www.jianshu.com/p/e17622b7ffee

来源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

在 ConVNeXt 使用模型与训练的方法, 如下:

2.2、Changing stage compute ratio

Swin Transfomer和CNN一样也采用金字塔结构:包含4个stage,每个stage输出不同尺度的特征。这里考虑Swin Transformer和ResNet在宏观设计上的区别,主要有两点:每个stage的计算量占比以及 stem cell结构(即stage1之前的模块)。 首先是各个stage的计算量占比,对比ResNet50,4个stage的blocks数量分别是(3,4,6,3),而Swin-T的设置为(2,2,6,2),4个stage的计算量比约为1:1:3:1。这里调整ResNet50各个stage的blocks数量以和Swin-T一致:从原来的(3,4,6,3)调整至(3,3,9,3)。调整之后模型性能从78.8%提升至79.4%,不过这里要注意的一点是,调整后其实blocks数量增加了,模型的FLOPs从原来的4G增加至4.5G,基本和Swin-T一致了,所以这个性能的提升很大程度上归功于FLOPs的增加。关于各个stage的计算量分配,并没有一个理论上的参考,不过RegNet和EfficientNetV2论文中都指出,后面的stages应该占用更多的计算量。 第二个就是stem的区别。对于Swin-T模型,其stem是一个patch embedding layer,实际上就是一个stride=4的4x4 conv。而 ResNet50的stem相对更复杂一些:首先是一个stride=2的7x7 conv,然后是一个stride=2 的 3x3 max pooling。两种stem最后均是得到1/4大小的特征,所以这里可以直接用Swin的stem来替换ResNet的stem,这个变动对模型效果影响较小:从79.4%提升至79.5%(个人认为:去掉最大池化起到了作用 ,最大池化会造成特征损失)。对于ViT模型,其 patch size一般较大(eg. 16),只采用一个stride较大的conv来做patch embedding往往会存在一定问题,比如Mocov3论文中就指出patch embed可能会导致训练不稳定,而论文Early Convolutions Help Transformers See Better指出将 patch embed 设计成几个堆叠的 stride=2 的3*3 conv,无论是在模型效果上,还是在训练稳定性以及收敛速度都更好;而Swin-T的 patch size相对较小,不会出现ViT的上述问题,不过Swin-T采用的是 non-overlapping conv,后面有论文指出采用overlapping conv(eg stride=4 的7x7 conv)会带来一定的性能提升。

2.3、ResNeXt-ify (depth-wise)

相比 ResNet,ResNeXt通过采用group conv来提升性能,标准的conv其输入是所有的channels,而group conv会对channels进行分组来减少计算量,这样节省下来的计算量用来增加网络的width即特征channels。对于group conv,其最极端的情况就是每个channel一个group,这样就变成了depthwise conv(简称dw conv),dw conv首先在MobileNet中应用,后来也被其它CNN模型广泛采用。对于dw conv,其和 local attention 有很多的相似的地方,local attention其实就是对window里的各个token的特征做加权和,而且操作是per-channel的;而dw conv是对kernel size范围的token的特征求加权和,也是分channel的。这里的最大区别就是:self-attention的权重是动态计算的(data dependent),而dw conv的权重就是学习的kernel,关于这点,微软的论文Demystifying Local Vision Transformer: Sparse Connectivity, Weight Sharing, and Dynamic Weight有深入的分析。

这里将 ResNet50中的 3x3 conv替换成3x3 dw conv,为了弥补 FLOPs 的减少,同时将 ResNet50 的 base width从原来的64增加至96(和Swin-T一致,这里的base width是指stem后的特征大小),此时模型的FLOPs有所增加(5.3G),模型性能提升至80.5%。

2.4、Inverted Bottleneck

如果把self-attention看成一个dw conv的话(这里忽略self-attention的linear projection操作),那么一个transformer block可以近似看成一个inverted bottleneck,因为MLP等效于两个1x1 conv,并且MLP中间隐含层特征是输入特征大小的4倍(expansion ratio=4)。inverted bottleneck最早在MobileNetV2中提出,随后的EfficientNet也采用了这样的结构。ResNet50采用的是正常的residual bottleneck,这里将其改成inverted bottleneck,即从图(a)变成图(b),虽然dw conv的计算量增加了,但是对于包含下采样的residual block中,用于shortcut的1x1 conv计算量却大大降低,最终模型的FLOPs减少为4.6G。这个变动对ResNet50的影响较小(80.5%->80.6%)。

2.5、Large Kernel Sizes

自从VGG之后,主流的CNN往往采用较小的kernel size,如3x3和5x5,其中3x3 conv在GPU上有高效的实现。然而Swin-T采用的 window size为7x7,这比3x3 conv对应的 window size要大得多,所以这里考虑采用更大的kernel size。 在这之前,首先将dw conv移到inverted bottleneck block的最开始,如上图(c)所示。对于transformer block,其实self-attention也是在开始,同时由于采用inverted bottleneck,将dw conv移动到最前面可以减少计算量(4.1G),后续采用较大的kernel size后模型的FLOPs变动更少。由于模型FLOPs的降低,模型性能也出现一定的下降:80.6%->79.9%。 然后调整dw conv的kernel size,这里共实验了5种kernel size:3x3,5x5,7x7,9x9和11x11。实验发现kernel size增加,模型性能有提升,但是在7x7之后采用更大的kernel size性能达到饱和。所以最终选择7x7,这样也和Swin-T的window size一致,由于前面的dw conv位置变动,采用7x7的kernel size基本没带来FLOPs的增加。采用7x7 dw conv之后,模型的性能又回到 80.6%。

2.6、微观设计

2.6.1 ReLU -> GReLU

经过前面的改动,模型的性能已经提升到80%以上,此时改动后的ResNet50也和Swin-T在整体结构上很类似了,下面我们开始关注一些微观设计上的差异,或者说是layer级别的不同。 首先是激活函数,CNN模型一般采用ReLU,而transformer模型常常采用GELU,两者的区别如下图所示。这里把激活函数都从ReLU改成GELU,模型效果没有变化(80.6%)。

2.6.2 减少激活层和归一化层

如下图示,这里只保留中间1x1 conv之后的GELU,就和Swin-T基本保持一致了,这个变动使模型性能从80.6%提升至81.3%。

对于norm层,也存在和激活函数一样的问题,transformer中只在self-attention和MLP的开始采用了LayerNorm,而ResNet每个conv之后采用BatchNorm,比transformer多一个norm层。这里去掉其它的BatchNorm,只保留中间1x1 conv前的BatchNorm,此时模型性能有0.1%的提升。实际上要和 transformer 保持一致,应该在block最开始增加一个BatchNorm,但是这个并没有提升性能,所以最终只留下了一个norm层。另外,transformer的norm层采用 LayerNorm,而CNN常采用BatchNorm,一般情况下BatchNorm要比LayerNorm效果要好,但是BatchNorm受batch size的影响较大。这里将BatchNorm替换成LayerNorm后,模型性能只有微弱的下降(80.5%)。

最后一个差异是下采样,ResNet中的下采样一般放在每个stage的最开始的block中,采用 stride=2 的3x3 conv;

但是ConvNeXt 采用分离的下采样去近似 Swin Transform的 Patch Merging layer(可以看补充知识去理解 Patch Merging),即下采样是放在两个stage之间,通过一个stride=2的 2x2 conv。但是实验发现,如果直接改用Swin-T的下采样,会出现训练发散问题,解决的办法是在添加几个norm层:在stem之后,每个下采样层之前以及global avg pooling之后都增加一个LayerNom(Swin-T也是这样做的)。最终模型的性能提升至82.0%,超过Swin-T(81.3%),对比 1.2.1 节 猜测这里是 LN 起到的效果。

2.7、其它数据

前面我们从ResNet50的Swin-T化,最终得到了ConvNeXt-T模型,对于更大的模型,可以通过调整特征的维度C和各个stage的blocks数量。论文共设计5个ConvNeXt模型,其中前4个模型分别对标Swin,而最后ConvNeXt-XL是一个更大的模型,用来验证模型的scalability。

- ConvNeXt-T: C = (96, 192, 384, 768), B = (3, 3, 9, 3)

- ConvNeXt-S: C = (96, 192, 384, 768), B = (3, 3, 27, 3)

- ConvNeXt-B: C = (128, 256, 512, 1024), B = (3, 3, 27, 3)

- ConvNeXt-L: C = (192, 384, 768, 1536), B = (3, 3, 27, 3)

- ConvNeXt-XL: C = (256, 512, 1024, 2048), B = (3, 3, 27, 3)

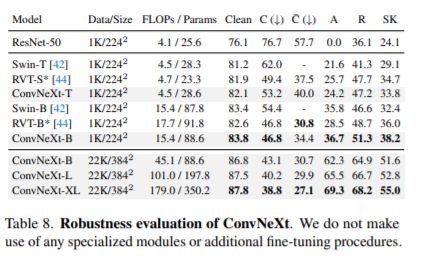

ConvNeXt在ImageNet1K数据集上的分类效果如下所示,可以看到,ConvNeXt在不同的FLOPs均可以超过Swin,如果采用ImageNet22K预训练后,模型性能有进一步的提升,其中ConvNeXt-XL可以达到87.8%,仅略低于目前的SOTA一点(MViT-H, 512^2,88.8%,只有ImageNet21K)。

在下游任务检测和分割上,ConvNeXt也可以超过Swin,如下表所示:

由于FLOPs往往不能准确地反映实际的推理速度,所以上面的对比结果也包括模型速度(分类上用throughout,检测上用FPS),可以看到在实际推理速度上,ConvNeXt也略好于Swin。在显存使用上,两者也相当,比如基于ConvNeXt-B的Cascade Mask-RCNN需要17.4GB peak memory,而Swin-B 需要18.5GB。另外,如果在A100上(支持TF32),采用channel last,ConvNeXt相比Swin有明显的速度优势:

Robustness Evaluation , ConVNeXt 也优于 swin-Transform

三、知识补充

最大池化缺点

根据最大池化的操作,取每个块中的最大值,而其他元素将不会进入下一层。众所周知,CNN卷积核可以理解为在提取特征,对于最大池化取最大值,可以理解为提取特征图中响应最强烈的部分进入下一层,而其他特征进入待定状态(之所以说待定,是因为当回传梯度更新一次参数和权重后,最大元素可能就不是在原来的位置取到了)。

一般而言,前景的亮度会高于背景,因此,正如前面提到最大池化具有提取主要特征、突出前景的作用。但在个别场合,前景暗于背景时,最大池化就不具备突出前景的作用了。

因此,当特征中只有部分信息比较有用时,使用最大池化。如网络前面的层,图像存在噪声和很多无用的背景信息,常使用最大池化。

同理,平均池化取每个块的平均值,提取特征图中所有特征的信息进入下一层。因此当特征中所有信息都比较有用时,使用平均池化。如网络最后几层,最常见的是进入分类部分的全连接层前,常常都使用平均池化。这是因为最后几层都包含了比较丰富的语义信息,使用最大池化会丢失很多重要信息。

BN 和 LN 对比

BN 在图像领域一般优于 LN, LN 更适合 RNN

BN 比较适用的场景是:每个 mini-batch 比较大,数据分布比较接近。在进行训练之前,要做好充分的 shuffle. 否则效果会差很多。

LN 针对单个训练样本进行,不依赖于其他数据,因此可以避免 BN 中受 mini-batch 数据分布影响的问题,可以用于 小mini-batch场景、动态网络场景和 RNN,特别是自然语言处理领域。此外,LN 不需要保存 mini-batch 的均值和方差,节省了额外的存储空间。

Swin transform 结构图

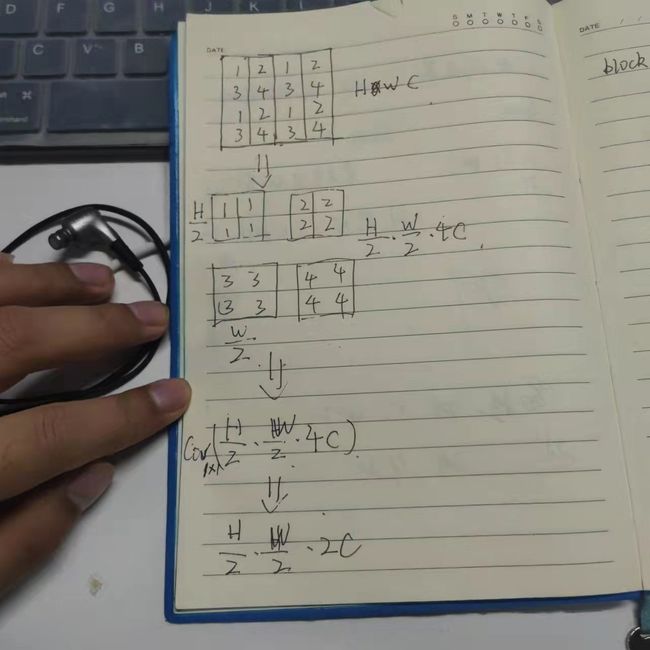

Patch Merging 可以对比下采样(tranform 输入和输出长度相同,对于 transform 是必须的,对于 Conv 来仅起到降维的作用)

Patch Merge 主要用来对齐 CNN 网络中多尺度的特征提取过程,使到达下一个 swin block时, 达到 CNN 中 H W大小减半,channel 加倍。

Patch Merge 首先将 HW 维度上的特征变换成 C 上的特征(由 HWC -> H/2 W/2 4C),然后用 1*1 的 conv 改变 channel 维度,由 H/2 W/2 4C -> H/2 W/2 2C

ResNet 结构速览

aqrose 阿丘科技 内推 算法,图像 高性能 ,框架,嵌入式等岗位

内推码: NTAHmCz

内推码:NTAHmCz

内推码:NTAHmCz

官网 : https://www.aqrose.com/