为什么 AI 犯的错有时会很“瘆人”?

本文转载自程序员不高兴

科技社会的演进史,其实是场战争。

数十万年前,智人艰难跑赢自然界所有生物,站上食物链顶端,由此,引发了一场旷日持久的技术战:解放肉身。

文字,解放了嘴;汽车,解放了腿;键盘,解放了脑。

冷静,我说的是代码和人工智能。

这场技术的空前胜利,引发的不止有人类对 AI 的迷狂,还有巨大的危险:人工智能的间歇性失控,近看,是智商和情商不足;远看,危机四伏。

你可以在智能音箱脑残时,拍腿笑骂它是个十足的智障,却无法在自动驾驶系统脑残时,同样一笑了之。

细细想来,人类可以给 AI 解释清楚很多事,比如跳棋、围棋、五子棋;道路千万条、安全第一条。

可还有更多解释不清的事。

比如为什么拨动气压计刻度盘却不下雨,如果当初尼奥选择了蓝色药丸,接下来可能会发生什么?

对人工智能来说,拥有回答这些「为什么」的能力,至关重要。

(一) 光头的诱惑

去年年底,人工智能出了个大糗。

2020 年 10 月,苏格兰足球冠军联赛即将举行。然而,受新冠疫情影响,苏格兰正处于严格的隔离政策下,球迷无法到场观看。

为了解决这个问题,比赛前一周,因弗内斯俱乐部引入了一套全新的 AI 智能转播系统,内置带有 AI 追踪技术的摄像头,可以自动追踪足球,解放了以往需要在赛场里来回狂奔的摄像师。

这样一来,球迷坐在家里,只要花点小钱就能乐享实时赛况,不必因为疫情而被迫失去一个成年人难得的快乐。

只是没想到,直播第一天,就出了意外。

比赛刚开始,一切正常,双方球员在中场等待门将开球,AI 缓缓将镜头拉远,静待赛点出现。

可随后,AI 只是多看了一眼站在球场边的“光头”边裁,直播画面就朝着奇怪的方向去了。

AI 将边裁锃亮的脑袋认成了足球,尽职尽责进行着赛事直播:边裁走到哪儿,AI 的镜头就转到哪儿。

哪怕边裁离球万里,AI 也会不顾一切调转镜头,尽职尽责地追踪边裁。。。的光头。

场外的万千球迷,原本都在家聚精会神的观赛,很快,他们就觉察出不对劲:屏幕正中间的最佳位置,永远闪着一颗光头,至于球到了哪儿,又被传给了谁,不知道。

这就尴尬了。

察觉到这一异常,技术人员迅速手动修正,试图纠正人工智能的错误认知:小子,你看清楚了,这个不是球,是裁判的光头,那个又白又圆、飞来飞去的才是,别再搞错了啊。

很快,直播恢复正常,直到...边裁再次入镜,一切回到最初的起点:AI 又将边裁的头当成了足球,持续追踪...

这下可好,人工干预也无法阻止这场“光头的诱惑”,即使多次手动修正,奈何 AI 偏有自己的想法,固执认为边裁的头,就是足球。

原来当年传唱的惊悚校园歌谣,是有现实依据的:XX 的头,像皮球…

这下,直播变得有趣了:90 分钟的比赛,其中绝大部分时间,手握啤酒在家观看的球迷们,只能看到边裁的光头停在屏幕中央,至于球在哪儿、有没有进?看不见。

好在,这场比赛最终停在了 1:1,不至于让球迷太过心塞。

比赛终于结束了,我们一起近距离看看这位全程尊享 C 位的光头边裁:嗯,是个迷人的靓仔。

欣赏完边裁英俊的外貌,我们回到这起直播事故,思考一下,为什么人工智能的小眼睛,非得把头当成足球?

好歹是业界知名培训班“深度学习”毕业的,怎么一副学废了的样子?

(二) 机器学习出了什么问题?

传统的计算机程序,所有参数都是透明的,可到了人工智能时代,变化来了。

神经网络是个黑盒子,数据从这头进去,那头出来,至于参数该如何设置,中间会发生什么,执行了哪些操作,很难说出个子丑寅卯。

网传一种说法,哈士奇和狼的相似度高达 99%,剩余的 1%,在于智商。

为了精准区分二者,华盛顿大学用深度神经网络训练了一个模型,经过测试,效果相当不错,识别准确率高达 90%。

但团队在进一步研究后,竟有了令人吃惊的发现:模型之所以能区分哈士奇和狼,并不是靠特征,而是背景。

原来,在用于训练的数据集中,绝大部分图片里的狼,要么站在雪地上,要么头顶的天空正在下雪,模型仅靠背景是否有雪而做出的判断,就达到了令人满意的准确率。

没有一丝丝防备,高大上的哈士奇识别模型,竟是一台雪花识别器。

我们都知道,机器学习的三要素是数据、算力、算法,所以整个行业都铆足了劲,拼命从这三个方面下手:

1、给数据集扩容;

2、安排超高性能的计算设备;(用于训练 GPT-3 的计算机,拥有 285000 个 CPU 内核、10000 个 GPU 和 400Gbps 的网络连接,位列全球超级计算机榜第 5 位。)

3、钻研复杂精深的算法。

看起来,努力的方向没毛病,可为什么人工智能还不能拥有真正的智慧?

一个基础却又不易察觉的原因,在于数据:在机器学习中,常常要求数据是独立同分布(iid,independently identically distribution)。

我们先来看看啥叫独立同分布。

1)独立:数据间不会相互影响

比如摇骰子,抛到几就是几,第一次的结果,完全不会影响第二次的结果。

2)同分布:所有数据都服从同一个分布

还拿摇骰子为例,每一次抛骰子的动作,得到任意点数的概率都是六分之一,这就是同分布。

3)独立同分布:数据既独立,又同分布

除了摇骰子,掷硬币也满足独立同分布。

那么问题来了,机器学习为什么常常需要独立同分布数据?因为容易出效果。

机器学习是一个找规律的过程。模型通过学习已有数据,总结出内在规律,就能拟合未来数据,达到模拟和预测的目的。

如果训练数据具有总体代表性,模型总结规律的表现就好,反之,总结规律的表现就差,很容易被误导。

比如模型可能识别不出站在海滩上的牛,因为没几头牛有机会站在海滩上晒日光浴。

《牛与风筝》(Cows and Kites)

摄影师 Andrew Lever

正因为模型过度依赖训练数据,所以人工智能不仅显得蠢笨,而且极易受到攻击。

曾有一个来自日本的团队,他们只给图片加了一个像素,就成功让人工智能的识别出错,指鹿为马,比如把狗识别成猫,把马识别成智能手机。

一个微小像素就能骗过人工智能,离谱。

来自加州大学伯克利分校的著名人工智能专家 Dawn Song,稍动手脚,也轻松骗过了自动驾驶。

你瞧下面这张图,明明指示牌上写着“STOP”,可 Down Song 仅仅贴了几个黑白胶带条,就让自动驾驶把它看成了时速 45 公里的限速牌。

细思极恐。

所以说,基于规则的人工智能系统非常脆弱,不但容易被数据误导,而且一旦神经网络失效,技术人员也很难找出原因,进行有效修复。

鉴于机器学习“黑盒子”的缺陷,朱迪亚·珀尔提出了基于概率的贝叶斯网络,让“黑盒子”透进了一丝光,也因此获得了图灵奖。

贝叶斯网络的基础,是贝叶斯定理,而贝叶斯定理的本质,是从结果倒推原因。

如果用一句话来概括贝叶斯定理,那就是:当事实在变,看法也要跟着变。

这非常像警察破案。当凶案发生后,警察虽没有实质性证据,但从初步排查的结果来看,高度怀疑张三、李四和王五是凶手。

在接下来的勘查中,警察先发现张三和受害者在案发当晚吵过架,于是张三的嫌疑陡然上升,可随后又发现,两人吵完架后,张三去找朋友打牌,有不在场证明,故而嫌疑解除。

接着,警察发现李四在案发后立即去外地打工了,一追查,发现李四真的只是单纯去打工了,嫌疑也被解除。

最后,警察从王五朋友处得知,王五曾在一次酒醉后提起过与案件相关的细节,立刻查证,终于找到直接证据,成功锁定真凶。

看法随事实改变,这就是贝叶斯定理的精髓,这一招,福尔摩斯也常用。

1985 年,朱迪亚·珀尔将贝叶斯定理运用到人工智能模型中,推出了“贝叶斯网络”,成为「机器学习」这门技术的开山鼻祖。

贝叶斯网络,是让计算机能够在“灰色地带”进行思考的第一个工具,它提出先验概率和后验概率,成为人工智能领域的一个重要工具,直到今天都在被广泛使用。

什么是先验概率和后验概率呢?

假如你是个微生物学家,就必须用显微镜来进行观察,然后记录下数据,最后得出推论。

在这个过程中,你选择的显微镜就是“先验”,记录数据就是“后验”,二者共同决定你的结论质量:如果你选用放大镜观察,或者委托实验室保洁大妈帮你记录数据,都会对实际结果造成影响。

利用贝叶斯网络进行推理时,同样要选好先验和后验,才能保证最佳的训练效果。

尽管贝叶斯网络让机器学习这个黑盒子透明了一些,可它依旧没能弥合人工智能与人类之间的差距:因果。

也就是说,人工智能回答不了为什么。

因此,贝叶斯网络之父朱迪亚·珀尔,决定成为一个“叛教者”。

(三) 机器学习中的小机灵

朱迪亚·珀尔 (Judea Pearl) 所谓的“反叛”,是指从概率关联,到因果推理。

来看下面这个动图,人类在观看时,不用额外思考,也能轻松推论出不同元素间的因果关系。比如当你看到球棒和运动员的手臂同时运动,就知道是运动员的手臂带动了球棒的运动,进而影响了球的运动轨迹。

同时,人类还能进行更高级的反事实思考:如果这个球飞的再高一点,球棒没有击中它,会发生什么?

不管是推论因果联系,还是反事实思考,对人类来说都不难,因为从出生开始,我们就一直在做这样的事情。

可就是这样简单的事情,放在机器学习身上,就成了挑战。

人工智能可以在围棋等赛事中赢过人类,可以在医学影像中预测癌变,可以在海量数据中发现微妙的规律,却无法做到简单的因果判断,例如利用球员腿部动作和足球轨迹间的联系,实现球赛追踪直播,而不是忽略场上的运动员,平白无故将一个又大又白的脑袋当成足球,令人哭笑不得。

尽管现有的机器学习模型已经取得巨大进步,但真相却是,所有的模型,依然是在对数据进行精确的曲线拟合。

也就是说,现有的模型,只是在上一代的基础上提升了性能,但在基本的思想方面,没有任何进步。

在朱迪亚·珀尔看来,要想改变“有多少人工,就有多少智能”的困境,急需一场「因果革命」。

这里说的因果,不是指一个新的研究课题,朱迪亚·珀尔把它称作“新科学”,这是一道新的大门,对人工智能的进步,将会产生巨大的推动作用。

既然如此,那还等什么,赶紧把它写进代码里呀!但事实却是,根本不存在这样的代码。

在长达数十年的时间里,科学界广泛认为,因果关系根本不存在,所以压根儿就没把它划进科学家族中,更别说用科学的语言来描述它了。

当然,这种局面可不是科学家们拍拍脑袋达成的共识,而是实验后得出的结论。

1877 年 2 月 9 日,英国著名的生物统计学家高尔顿,在由英国皇家学院举办的著名“周五晚间演讲”上,做了一个题为“典型遗传规律”的演讲,演讲的重头戏,是场实验演示。

台下身着礼服的观众,全都是英国社会的上层精英,高尔顿当着所有人的面,用一种奇怪的装置,展示了一个实验。

高尔顿立起一块木板,上半部分是很多排交错呈三角形的小格挡 ,下半部分则是几个垂直的竖槽。小球从上部正中央的入口处掉落,经过一排排小格挡的碰撞,就会落到下面的竖槽中。

高尔顿钉板

他把这个板叫做梅花机,后来更多被称为高尔顿钉板 (Galton knocked boards)。

在小球掉落的过程中,碰撞随机发生,落到哪个槽里无法预测,可随着小球的数量增加,你就会发现,小球的分布是有规律的。

越靠近中间的竖槽,小球越多,越到两边,小球就越少,整体分布呈现平滑的中型曲线,非常像单峰驼的驼峰,统计学把这种现象叫做正态分布。

高尔顿用这个实验来模拟人的遗传。

人的身高会受到很多遗传因素的影响,就像高尔顿钉板的小格挡一样,但不管有多少种因素,最终都会呈现出正态分布。

也就是说,大部分人都将处在平均身高区间,特别高和特别矮都是少数。

以我们的生活经验来判断,高尔顿的实验结论没毛病,但高潮还在后面。

高尔顿继续思考:如果在钉板下面,再接一个钉板,结果会发生变化吗?

答案是:会。

这次实验结果表明,第一代中,特别高和特别矮的人都是少数,到了第二代,特别高和特别矮的人增多了,平均身高区间的人数有所减少。

当然,你肯定意识到了,现实世界并不是这样,不管经历多少代,特别高和特别矮的人,始终都是少数。

此外,高尔顿还观察了 600 多位英国名人, 最后发现,正所谓“富不过三代”,这些名人的儿子们,普遍没有父辈有名。

图片仅供一笑

高尔顿将这种现象叫做回归平庸,并用了 12 年时间,采用各种研究方式,企图找出原因。

最后,他得出结论:也许没有什么原因,这个世界,并非是因果能解释的,用“相关性”理解更为合适。

再往后,高尔顿的学生皮尔逊同样认为:世界上只有相关性,没有因果。

只是,有的相关性是有意义的,比如父辈的身高和后代的身高;有的相关性是没有意义的,比如公鸡打鸣和太阳升起。

这一观点,逐渐成为不少科学家的共识。

但这里,其实有个问题。

什么是没有意义?举个栗子,公鸡打鸣不会导致太阳升起。各位注意看这个词,“导致”。

“导致”用来解释的,就是因果联系。

皮尔逊虽然不承认因果,可他在判断相关性的时候,依然用到了因果。

这下,局面变得有些尴尬了:科学上,不能证明因果联系,但在思考上,又离不开因果联系。

贝叶斯网络之父朱迪亚·珀尔,运用哲学的方式,对这一难题给出了自己的看法。

他认为,要把主观和客观这两个维度分开来看。

因果是一种主观的思维方式,人类看到客观现象,就会主观建立起因果联系,但客观世界,也许并非是按照因果规律运转的。

因果联系是人类建立认知的一种基本方式,即使是一次再简单不过的思考,我们也在调用因果思维。更进一步说,不管客观世界存不存在因果,作为人类,主观上都无法离开因果这个思考方式。

只是,以当下的科学研究,还无法给因果联系一个精准的定论。

当然,我们可以慢慢纠结,等能够用科学语言来描述因果关系那一天的到来,可人工智能等不了。

真要等研究明白这个问题,再把它变成代码,输入人工智能,那在此之前,人工智能将长期处于“有多少人工、就有多少智能”的时代。

在这个效率至上的时代,这个方案显然不可取。

在现实世界,不是非要搞明白牛顿力学,才能造出一把锤子,很多实践进步,都出现在理论形成之前。

所以,面对人工智能,当前最重要的工作,不是搞清楚因果联系,而是完善因果思维。

我们来看两个故事。

第一个是后羿射日。远古时期,天上有十个太阳,直接导致温度太高,不适宜人类生存。这时,一个叫后羿的暖男,举起一把大弓,追着射下九个太阳,让地球成为适宜人类居住的蓝色星球。

第二个来源于三体。遥远的外星系,挂着三个太阳,它们在万有引力的作用下互相吸引,做出了很多没有规律的不规则运动,有时不升起,有时三日凌空,导致温度骤升,有时又突然落下,到处漆黑阴冷,三体人只能用脱水的方式来维持生命的延续。

在第一个故事中,存在的因果模型很简单:十个太阳,导致热,射下九个,不热。

在第二个故事中,同样还是太阳,但因果模型变得复杂,因为关键因素增加了:人们意识到了万有引力的存在,而且,三个太阳不仅热,还多了人类无法预测的不规则运动,超出了人类的数学极限,你根本无法通过计算,预测它们下一步的运动轨迹。

其实,第二个故事中的因果模型,也并不一定完全准确,也许你明天早上一睁眼,打开热搜就发现,有科学大神找到了一个除万有引力之外的新规则。

这意味着:世界同时存在不同维度的各种规则,你能察觉的规则越多、越关键,你的因果模型才会越准确。

都有哪些完善因果思维的方法呢?一起来看两个高频使用方法。

(四) 辛普森悖论

关于自动驾驶,出现频率最高的日常迷惑是:机器和人类相比,到底谁开车更安全?

在一次人工智能论坛上,特斯拉公司的董事会主席德霍姆摆出了数据:自动驾驶每 400 万英里发生一次事故,而人类司机呢?每 50 万英里就会有一次事故。

显而易见:自动驾驶胜。

不过,同样是摆数据、讲道理,有人却给出了相反的结论。

来自伊利诺伊大学的一个研究团队,研发出了一种针对自动驾驶的故障评估技术,他们分析了 Uber 和 Waymo 在 2014-2017 年间提交的所有安全报告 (涵盖 144 辆车,累计行驶里程 1116605 英里) 。

最后,结果显示:在同样的行驶里程数下,人类驾驶汽车发生事故的可能性,比自动驾驶汽车低 4000 倍。

如此看来:人类司机胜。

怪了,两方都是以客观数据为依据,却论证了两个截然相反的观点,这就显得有些玄学了。

这种看似违背常理的诡异现象,其实是个非常经典的统计学问题:辛普森悖论。

1951 年,辛普森在论文中阐述了一种奇怪的现象:当人们尝试探究两种变量是否具有相关性的时候,会分别对之进行分组研究。但是,在分组比较中都占优势的一方,在总评中,反而成了失势的一方。

举个栗子,假设你是某大学校长,正坐在办公室里。

突然,秘书眉头紧锁推门进来,对你说:大事不好了,校门口有很多男生举着横幅抗议,说咱们的录取环节存在性别歧视,女生的录取率是 42%,男生的录取率却只有一半,仅为 21%。

听完秘书的汇报,你觉得很疑惑,反问秘书:之前咱们不是专门开会说,今年要提高男性的录取率嘛,怎么还搞成这样?

秘书哭丧着脸回答说:我确实是严格按照计划行事的呀,您看,我还做了个表呢。

从秘书制作的统计表中,你清楚地看到:商学院的录取率中,男生是 75%,女生是 49%;法学院的录取率中,男生是 10%,女生是 5%。

不管看哪个学院,都是男生的录取率高,可不知为什么,合在一起看,男生的录取率反而低了。

同样的数据,却得出相反的结论,这就是辛普森悖论。

就这个例子看,究其原因,是因为秘书只从表面统计了数据,却没有考虑数据间的因果性。

1) 忽略了申请者的性别权重。

申请商学院的女生人数是男生的 5 倍,表示女生更偏爱商学院。在 53.3% 的录取率中,男生申请人数少,所以不被录取的人数也相对少,女生刚好相反,导致男生录取率反而高于女生。

相反,申请法学院的男生人数是女生的 5 倍,显示男生更愿意申请法学院。同理,在 9.2% 的录取率下,尽管最终录取了 10 名男生,1 名女生,但由于女生申请人数本来就少,被淘汰的人数自然也少,导致男生录取率再次高于女生。

可是,一旦将两组录取率进行简单平均,忽视两个学院录取率的巨大差异 (53.3% 和 9.2%),女生录取率自然就反超了。

2) 忽略了其他的潜在影响因素。

在录取率面前,申请者出现比较大的性别差异,只是一种随机事件,往大看,性别甚至可能对录取率毫无影响,仅是这届学生的入学成绩恰好出现这种比例,容易让人误认为是性别因素导致。

虽说上面这个故事纯属虚构,但在现实生活中,确实存在很多辛普森悖论,在政治领域,政客们更是经常利用辛普森悖论来拉拢人心。

福特总统在 1974~1978 年的任期中,对各个收入人群实施减税,从下图中就能看出,每个纳税区间的税率都有所下降,但事实是,在此期间,整体税率出现上升,税收额明显上涨。

辛普森悖论揭示了一个很容易被忽略的真相:数据是个强有力的武器,但它是会骗人的。

想要破解“辛普森悖论”迷局,一个非常好用的方法就是:区分混杂因子。

回想你刚刚当校长时遇到的难题,就能很容易理解这个方法:找到造成“双面数据”的混杂因子,也就是能够同时影响原因和结果的那个因素,把与它相关的因素分开计算 (性别),就能得出正确结论(男生录取率确实高于女生,与原有招收目标一致)。

(五) 酸橙和柠檬

另一个完善因果推理的常用方法,叫做寻找正确的中介物。

在数百年前的大航海时代,坏血病是一种可怕的疾病,仅 1500 年到 1800 年,就有约 200 万名船员因此丧命。

有人开始怀疑,坏血病之所以高发,很可能是因为船上缺少新鲜蔬菜和水果。

1747 年,苏格兰海军终于有了发现:柑橘类水果可以预防这种可怕的疾病。

自此,英国海军开始规定:所有出海的船只,必须携带充足的柑橘类水果。对比下来,他们选择了西班牙柠檬。

当船员们人手捧着这种黄黄的水果后,果真,坏血病很少出现了。对整个英国海军来说,坏血病已经成为历史。

可没想到,一个世纪后,当英国探险队开始极地探险时,坏血病卷土重来。

随后,在 1903 年和 1911 年,又有两支极地考察队遭遇了坏血病。

奇怪,明明已经可以写进历史的坏血病,怎么就又出现了呢?

原来,这几支极地考察队在出发前,只备足了没有腐坏迹象的干肉,以及其他食物和茶饮,完全没有储备柑橘类水果。

极地探险队成员每天的口粮:

巧克力、干肉饼、糖、饼干、黄油、茶

至于为什么不带,因为当时的医生,根本不知道柑橘类水果是怎么预防坏血病的,误以为是柑橘类水果中的酸性物质在起作用。

这样一来,只要含有酸性物质,肯定也能预防坏血病。于是,出于经济方面的考虑,海军高层选择了更便宜的西印度酸橙,替换掉了之前的西班牙柠檬。

反正二者都一样酸,效果肯定差不多。

更绝的是,海军高层不仅换了品种,而且为了防止腐坏,还把酸橙榨汁煮熟后带上船,直接导致坏血病大面积爆发,严重程度超过以往任何时期。

在这个悲惨的案例里,起初,医生以为柑橘类水果可以预防坏血病,是因为它含有酸性物质。那么,酸性物质就是中介因素,它能够直接导致坏血病爆发这个结果。

用因果图表示就是:柑橘类水果——酸性物质——坏血病。

按照这个因果关系,所有的酸性物质都能预防坏血病,比如醋、巧克力都行。可事实上,起预防作用的不是酸性物质,而是维生素 C。

西印度酸橙虽然便宜,可它的维生素 C 含量,只有西班牙柠檬的四分之一,而本来就不多的维生素 C,再经过榨汁煮熟,几乎全军覆没,这才导致坏血病的突然爆发。

所以正确的因果图应该是:柑橘类水果——维生素 C——坏血病。

维生素 C 才是那个正确的中介因素。

所以说,找到正确的中介因素,才是建立有效因果模型、最终解决问题的关键。

历史总在重演,科技永远向前。

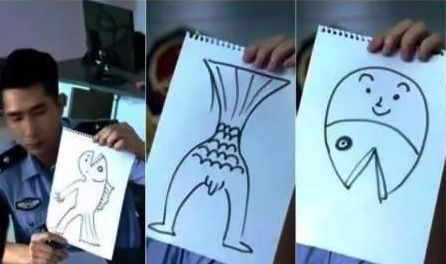

运用因果推理,让人工智能“更聪明”,正在成为行业内的新发力点。前两天,我刚好看到一个新闻,说阿里巴巴达摩院将因果推理引入计算机视觉,试图让 AI 想象从未见过的事物,比如学过人类照片和鱼类照片后,再给 AI 看一张美人鱼的照片。

至于 AI 能将美人鱼认成什么,我还没去探索,但我希望技术人员给 AI 看的美人鱼照片,不是长下面这样。