计算机视觉,卷积神经网络,经典及变革案例分析

本文主要介绍一些重要的的卷积神经网络模型。截图来源为吴恩达老师在Coursera课程Convolutional Neural Networks 第二节的 slides

经典网络:

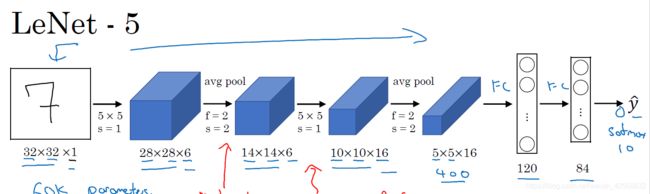

LeNet-5 是最早的经典卷积神经网络, 具体见论文 [LeCun et al., 1998. Gradient-based learning applied to document recognition]

AlexNet 模型可以说是掀起了本轮机器学习的热潮,具体见论文[Krizhevsky et al., 2012. ImageNet classification with deep convolutional neural networks]

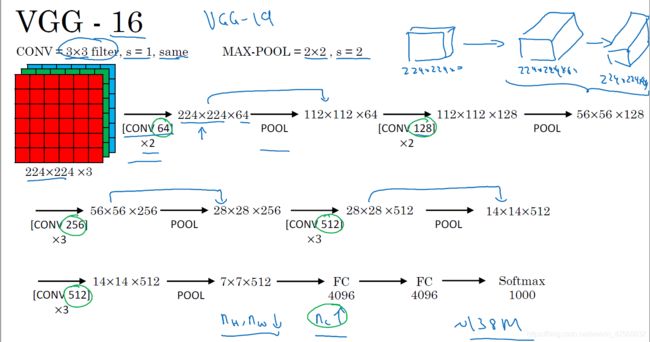

VGG-16 可以说是将卷积神经网络单元标准化,流水线化,具体见论文[Simonyan & Zisserman 2015. Very deep convolutional networks for large-scale image recognition]

下面是一些对经典模型进行变革的模型:

Inception network

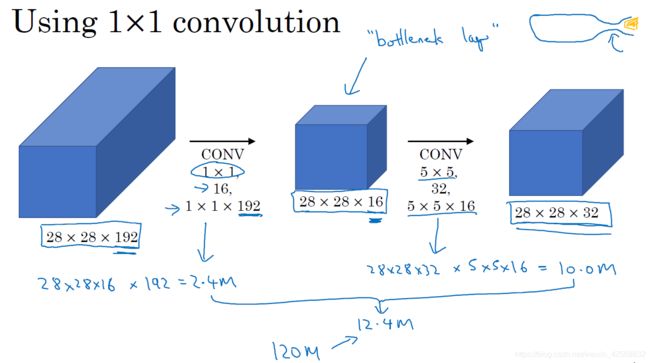

Inception network 的想法是既然我们有的时候要用3*3的filter,有的时候要用5*5的filter,有的时候要用max pool,为什么不设计一个包括所有这些的单元呢?

但这带来了一个问题,那就是巨大的计算量

为了解决计算量大的问题,在中间加入了一层bottleneck layer(1*1*channel_数 卷积网络),这样计算量就大幅减少。

Inception network 的单元结构如下:

Inception network的全局图如下:

Inception network 更多信息参见论文 [Szegedy et al., 2014, Going Deeper with Convolutions]

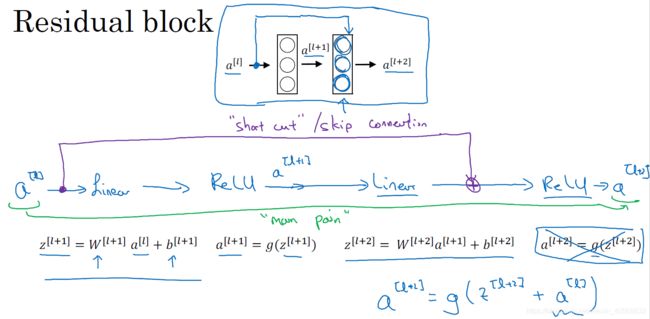

残差网络 ResNets

深层的神经网络面临着梯度消失的问题,残差网络较好的解决了这一问题。ResNets 的主要思想是增加了short cut,有利于目标值的传导,参见论文 [He et al., 2015. Deep residual networks for image recognition]

残差网络使得随着网络层数的增加,训练集误差一直在下降的目标得以实现

残差网络使得随着网络层数的增加,训练集误差一直在下降的目标得以实现

MobileNets

MobileNets顾名思义,就是在手机上可以跑的神经网络。由于CPU和内存的限制,参数量较大的深度神经网络在移动终端或者嵌入式终端运行识别时有一定的困难,MobileNets就是为了解决这一问题。

MobileNets的核心是 Depthwise Separable Convolution,如下图,将一个正常的卷积替换为一个Depthwise和一个Pointwise。注意Depthwise卷积每个filter都是2维的,即每个Depthwise filter只对一个channel的数据起作用。Pointwise卷积的维度是1*1*channel数量,每个Pointwise filter对所有channel的数据起作用。

在下面这个例子中,正常卷积的计算量是2160

Depthwise 卷积的计算量是432

Pointwise 卷积的计算量是240

在这个例子中,使用Depthwise和Pointwise将使计算量减少到原来的31%,当最终的channel 数值很大,比如下图中512时,计算量可以减少到大概原来的10%

MobileNets 更为详细的描述参见论文 [Howard et al. 2017, MobileNets : Efficient Convolutional Neural Networks for Mobile Vision

MobileNet v2 结合了残差网络,效果更好,具体参见论文 [Sandler et al. 2019, MobileNetV2: Inverted Residuals and Linear Bottlenecks]

EfficientNet

EfficientNet 是为了应对这样的应用场景,现在有一个baseline的深度神经网络模型,为了适应不同的终端,需要对这个baseline的神经网络进行缩放,缩放可以在下面三个维度进行,channel 的大小,网络的深度,初始input image的分辨率,三者以怎样的比例缩放是最efficient的,EfficientNet的作者在论文 [Tan and Le, 2019, EfficientNet : Rethinking Model Scaling for Convolutional Neural] 中给出了答案,下面的截图来自该论文,描述了深度神经网络模型的三个伸缩维度。

更为详细的内容建议学习吴恩达老师在Coursera 上的课程 Convolutional Neural Networks ,以及阅读文章中提到的论文。

欢迎留言讨论!

祖国翔,于上海

https://www.linkedin.com/in/guoxiang-zu/