【VIIF:端到端:Resnet】

RFN-Nest: An end-to-end residual fusion network for infrared and visible images

(RFN-Nest: 用于红外和可见光图像的端到端残差融合网络)

RFN提出了一种新颖的细节保留损失函数和特征增强损失函数来训练RFN。

介绍

现有的融合方法可以分为两类: 传统算法和基于深度学习的方法。在传统的算法范畴中,多尺度变换方法被广泛应用于从源图像中提取多尺度特征。通过适当的融合策略将特征通道组合在一起。最后,通过反多尺度变换重建融合图像。显然,这些算法的融合性能高度依赖于所使用的特征提取方法。

遵循此方向,已应用稀疏表示 (SR)和低秩表示 (LRR)从源图像中提取显着特征。在基于SR和LRR的融合方中,使用滑动窗口技术将源图像分解为图像块。使用这些图像补丁构建矩阵,其中每一列都是一个重塑的图像补丁。该矩阵被馈送到SR (或LRR) 中,以计算被视为图像特征的SR (或LRR) 系数。通过此操作,将图像融合问题转换为系数融合问题。融合系数由适当的融合策略生成,并用于在SR (或LRR) 框架中重建融合图像。

尽管传统的融合方法取得了良好的融合性能,但它们存在缺陷 1) 融合性能高度依赖于手工制作的特征,因为很难针对不同的融合任务找到通用的特征提取方法;(2) 可能需要不同的融合策略来处理不同的特征; (3) 对于基于SR和LRR的方法,字典学习非常耗时; (4) 复杂的源图像对基于SR (或LRR) 的融合方法提出了挑战。

我们提出了一种新颖的端到端融合框架 (RFN-Nest)。我们的网络包含三个部分: 编码器网络,旨在提取融合的多尺度深度特征的残余融合网络 (RFN) 以及基于nest连接的解码器网络。尽管所提出的网络的编码器和解码器体系结构与NestFuse相似,但融合策略,训练策略和损失函数完全不同。

为了训练所提出的RFN网络,我们设计了一种新的损失函数 (),以保留可见图像中的细节信息并同时保留红外图像中的显着特征。

贡献

(1) 提出了一种新颖的残差融合网络 (RFN) 来取代手工融合策略。尽管现在许多方法使用深层特征来实现良好的性能,但是选择合适的融合策略的启发式( heuristic)方法是它们的弱点。拟议的RFN是一个可学习的融合网络,可以克服这一弱点。

(2) 制定了两阶段培训策略来设计我们的网络。特征提取和特征重建能力是编码器和解码器网络的关键。仅使用一个阶段的训练策略来同时训练整个网络 (编码器,解码器和RFN网络) 是不够的。受启发,首先,将编码器和解码器网络训练为自动编码器。使用固定的编码器和解码器,使用适当的损失函数对RFN网络进行训练。

(3) 设计了能够保留图像细节的损失函数以及特征增强损失函数来训练我们的RFN网络。我们证明,使用这些损失函数,在融合图像中保留了更多的详细信息和图像显着特征。

相关工作

Non end-to-end methods(非端到端方法)

在早期,深度学习神经网络被用来提取深度特征作为一组「decision」地图。Li等人提出了基于预训练网络的融合框架 (VGG-19)。首先,将源图像分解为显着部分 (纹理和边缘) 和基础部分 (轮廓和亮度)。然后,使用VGG-19从显着部分中提取多级深度特征。在每个级别上,根据深层特征计算决策图,并生成候选融合的显着部分。通过使用适当的融合策略组合融合的基础部分和融合的显着部分来重建融合图像。也可以利用预先训练的ResNet-50直接从源图像中提取深度特征。通过零相分量分析 (ZCA) 和 1范数获得决策图。基于PCANet的融合方法也遵循此框架来生成融合图像,其中使用PCANet代替VGG-19或ResNet-50来提取特征。

除了纯特征提取之外,两个关键过程 (特征提取和融合策略) 也可以由单个网络实现。其中生成决策图是关键,由在输入图像的多个模糊版本的图像补丁上训练的CNN生成决策图。,利用卷积稀疏表示代替CNN来提取特征并生成决策图。根据生成的决策图,可以轻松地重建融合图像。

除上述方法外,还提出了一种基于深度自动编码器网络的融合框架。受DeepFuse的启发,提出了一种新颖的网络体系结构,其中包含编码器,融合层和解码器。采用基于密集块的编码器网络,因为它从源图像中提取了更多互补的深层特征。在他们的框架中,融合策略变得非常重要。受DenseFuse中的体系结构的启发,Li等人提出了NestFuse,以保留可见图像中的更多细节背景信息,同时增强红外图像中的显着特征。此外,还设计了一种新颖的空间/通道注意模型来融合多尺度深层特征。尽管这些框架实现了良好的融合性能,但要找到有效的手工制作的图像融合策略非常困难。

End-to-end methods(端到端方法)

FusionGAN:损失函数有两个项:—>内容损失和鉴别器损失。由于内容丢失,尽管有鉴别器网络,但融合后的图像往往会变得与红外图像相似,从而无法保留图像细节。

为了保留可见图像中的更多详细信息,又提出了FusionGANv2,深化了生成器和鉴别器网络,赋予它们更强大的特征表示能力。此外,还提出了两个新的损失函数,即细节损失和目标边缘增强损失,以保留细节信息。通过这些改进,融合的图像重建了更多的场景细节,并清楚地突出显示了边缘锐化的目标。

IFCNN:利用两个卷积层从源图像中提取深层特征。元素方向(Element-wise)融合规则 (elementwise-maximum,elementwise-sum,elementwise-mean) 用于融合深度特征。融合图像由两个卷积层从融合的深层特征生成。尽管IFCNN在多个图像融合任务中获得了令人满意的融合性能,但其体系结构过于简单,无法提取强大的深度特征,并且使用传统方式设计的融合策略也不是最优的。

The proposed fusion framework

The architecture of the fusion network

RFN-Nest是一个端到端的融合网络,其体系结构如下图所示。RFN-Nest包含三个部分: 编码器 (左部分) 、残差融合网络 ( 1 − 4) 和解码器 (右部分)。对于卷积层,「 × ,(,) 」表示内核大小为 × ,输入通道为 ,输出通道为 。

(RFN-Nest的框架、“ 1 − 4”表示残差融合网络、“3 × 3,(16,8)” 表示在卷积层中内核大小为3 × 3,输入通道为16,输出通道为8。)

通过编码器网络中的最大池化操作,可以从源图像中提取多尺度深度特征,RFN用于融合在每个尺度上提取的多模态深度特征。虽然浅层特征保留了更多的细节信息,但深层特征传达了语义信息,这对于重建显着特征很重要。最后,通过基于nest connection的解码器网络重建融合图像,该网络充分利用了特征的多尺度结构。

上图所示, 和 表示源图像 (红外图像和可见光图像)。 表示RFN-Nest的输出,即融合图像。“” 表示一个针对规模为 的深度特征的残差融合网络。我们框架中编码器的体系结构由四个RFN网络组成, ∈ {1,2,3,4}。这些RFN网络共享相同的体系结构,但权重不同。

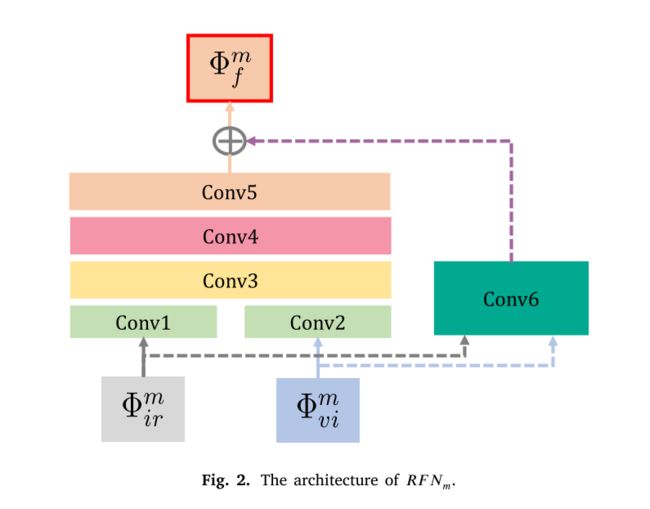

Residual fusion network (RFN)

RFN基于残差块体系结构如下:

和 表示编码器网络提取的第 个尺度深度特征, ∈ {1,2,3,4} 表示RFN网络的索引。“Conv1-6” 表示RFN中的六个卷积层。在此残差体系结构中,“Conv1” 和 “Conv2” 的输出被串联为 “Conv3” 的输入。“Conv6”是第一个生成初始融合特征的融合层。有了这种架构,RFN可以很容易地通过我们的培训策略进行优化。卷积运算产生融合的深度特征 ,这些特征被馈送到解码器网络中。

得益于多尺度深度特征和提出的学习过程,浅层RFN网络和深度RFN网络分别保留了图像细节和显着结构。

Decoder network

基于nest连接体系结构的解码器网络如下图所示。与UNet ++ 相比,关于图像融合任务,我们简化了网络体系结构以使其轻而有效地重建融合图像。( ∈ {1,2,3,4}) 表示通过RFN网络获得的融合的多尺度特征。“DCB” 表示解码器卷积块,它具有两个卷积层。在每一行中,这些块通过类似于密集块架构的短连接连接。跨层链路连接解码器网络中的多尺度深层特征。网络的输出是从融合的多尺度特征重建的融合图像。

Two-stage training strategy

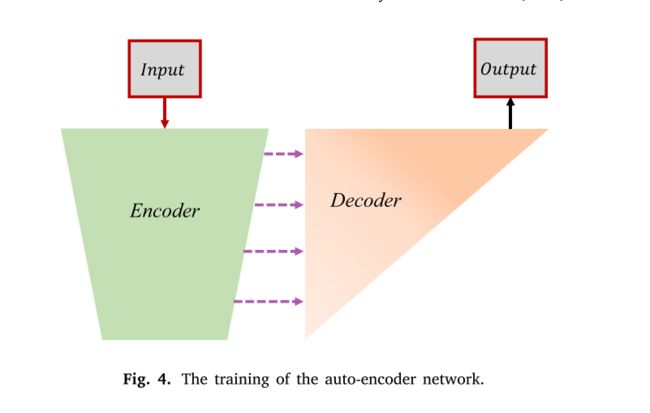

我们制定了两阶段的培训策略,以确保我们网络中的每个部分都能达到预期的性能。首先,将编码器和解码器训练为自动编码器网络以重建输入图像。在学习了编码器和解码器网络之后,在第二个训练阶段,对多个RFN网络进行了训练,以融合多尺度深度特征。

Training of the auto-encoder network

受DenseFuse 的启发,在第一阶段,编码器网络被训练为提取多尺度深度特征。解码器网络经过训练,可以重建具有多尺度深度特征的输入图像。自动编码器网络训练框架如下所示

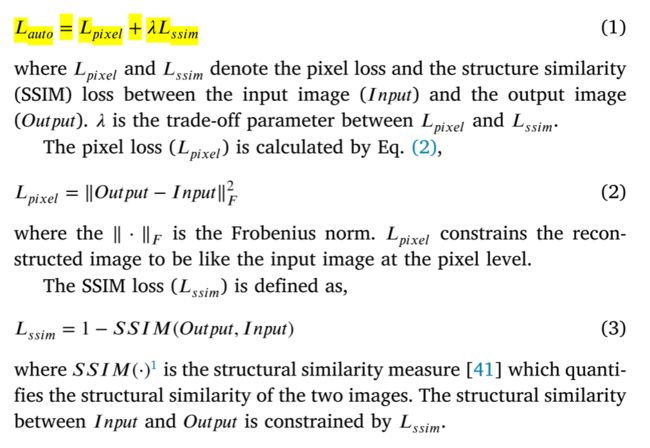

and 代表输入和输出图像,我们的特征提取部分包括一个向下采样操作 (最大池化),它在四个尺度上提取深度特征。这些多尺度深度特征被馈送到解码器网络中以重建输入图像。通过短的跨层连接,可以充分利用多尺度深度特征来重建输入图像。自动编码器网络是使用损失函数进行训练的,o定义如下,

Training of the RFN

提出了RFN来实现完全可学习的融合策略。在第二阶段,在编码器和解码器固定的情况下,用适当的损失函数训练RFN。

利用固定编码器网络从源图像中提取多尺度深度特征 ( 和 )。对于每个尺度,使用RFN来融合这些深层特征。然后,将融合的多尺度特征 ( ) 馈入固定解码器网络。

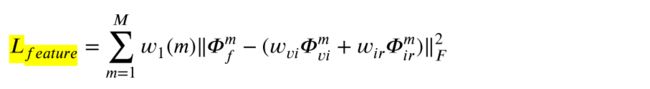

为了训练我们的RFN,我们提出了一个新颖的损失函数 ,它被定义为

其中, 和 分别表示背景细节保存损失函数和目标特征增强损失函数, 是一个权衡参数。

在红外和可见光图像融合的情况下,大多数背景细节信息来自可见光图像。旨在保留可见图像的细节信息和结构特征,定义为

由于红外图像比可见光图像包含更多的显着目标特征,因此设计了损失函数 以约束融合的深度特征,从而保留显着结构。 定义为

是多尺度深度特征的编号,设置为4。由于尺度之间的幅度差异, 1是用于平衡损失幅度的权衡参数向量。它假定四个值 {1,10,100,1000}。 和 r 控制融合特征图 f中可见和红外特征的相对影响。

由于可见信息受的约束,并且的目的是保留红外图像中的显著特征,上述式子中, 通常大于 。