CD2-pFed: Cyclic Distillation-guided Channel Decoupling for ModelPersonalization in Federated Lear论文

背景

知识蒸馏

将同一批数据同时放入两个模型中,将教师模型的预测输出作为软标签,将真实标签作为硬标签,分别计算学生模型的两种损失,最后将两个损失加权求和,作为最终损失更新网络参数。预测的时候,仅使用学生模型。

本文内容

模型个性化的通道解耦

1)给目标模型的每一层分配一个可学习的个性化权重的自适应比例

2)定义了每一层的统一个性化分配率p∈[0,1]。

3)p比例的通道参数在本地进行训练不需要中央服务器聚合。

4)p越大,个性化程度越高。

渐进式的模型个性化

使用线性增长方案:

循环蒸馏

本文首次尝试在PFL中引入循环蒸馏,以改进私有模型权值和共享模型权值之间的交互,从而减少从局部和全局权学习到的表示之间的差距。

针对个性化权重的时间平均移动

为了稳定训练性能,使用EMA进行局部权值更新。

实验部分

数据集

CIFAR-10:包含10类,每类6000张图片,其中5000张为训练集,1000张为测试集

CIFAR-100:包含100类,每类包含600张图片,其中500张训练图片,100张为测试图片

FLICKR-AES:在许多文献中被用于评价个性化美学图像的性能,这些图像被随机分割成80%为 训练集,20%为测试集

HISTO-FED:是一个医学图像数据集,包括公共和私人的苏木精和伊红(H&E)染色的人类结直肠癌(CRC)和正常组织的组织学全载玻片图像。

NCT-CRC-HE-100K:数据集中表示的九种组织类别中每一种的示例图像

实验设置

网络模型:

1)LeNet-5 for CIFAR-10, 具体LeNet-5见经典卷积神经网络--LeNet-5的详解_无尽的沉默的博客-CSDN博客_lenet-5

2)ResNet-34 for CIFAR-100, FLICK-AES, 具体ResNet-34见【学习笔记】【深度学习】ResNet残差网络_小欧尼思密达的博客-CSDN博客_resnet下采样

3)ResNet-32 for HISTO-FED

所有主干网络都是从头开始训练的,不加载任何余弦训练过的权重

超参数

应用随机梯度下降优化器;β = 0.5;T=50;λ = 1;p = 0.5 on CIFAR-10/100 and HISTO-FED;p = 0.8 on FLICK-AES;局部迭代次数 ηi = 1,batch size b = 128 forCIFAR-10;ηi = 4, b = 128 forCIFAR-100;ηi = 4 b = 4 for FLICK-AES and HISTO-FED

比较方法

FedAvg是传统的联邦学习算法,不涉及个性化。

Local training为每个客户训练K个模型的集合,而不需要在客户之间进行通信

LG-Fed在每个设备上共同学习紧凑的局部表示,并在所有客户端上学习顶层的全局模型

FedPer设计了一个基础加顶部个性化层结构,与LG-Fed相反,后者将个性化分配给底层。

评估指标

我们在CIFAR-10和CIFAR-100上使用了两个指标

1)本地测试top-1级分类精度(%)。我们精确地知道数据样本所属的客户端,因此我们可以选择经过特定训练的局部模型进行预测。它评估模型个性化的性能。

2)新测试top-1分类准确率(%)。我们不知道数据样本所属的客户端,因此我们使用所有本地模型的集合来推导出平均预测,其中本地模型将被上传到中央服务器。该索引度量了局部模型表示和全局模型表示之间的兼容性。

对于FLICKR-AES和histo-FED,我们又使用了另一个指标,即外部测试top-1分类准确率

1)具体来说,除了使用本地或新的测试外,我们还使用了外部测试样本。因此,这些图像有可能从不同的分布中采样,旨在验证全局模型表示上的泛化。

值得注意的是,由于没有外部样本,我们没有对CIFAR-10/100进行外部验证。

实验结果

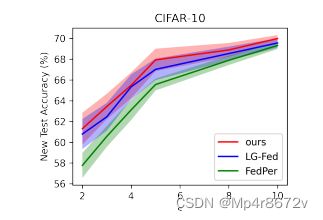

如图5所示,在所有程度的异质性上,即s,CD2-pFed的性能始终优于LG-Fed和FedPer。

如表1所示,我们提出的PFL框架在数据异质性最高的情况上显著提高了31.83%,即s=2。这种经验上的成功显示了我们提出的通道解耦方法的有效性。此外,与最先进的分层个性化方案[2,22]相比,我们的方法获得了最佳的局部和新的分类精度,这表明我们的模型学习了更有能力的局部和全局表示。此外,新的测试精度的优越性表明,我们的方案在个性化中对看不见的数据也实现了更高的泛化。

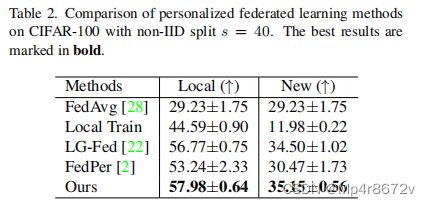

如表2所示,CD2-pFed的局部测试精度提高了28.75%,显示了其对具有更丰富类别的本地数据集的模型个性化的有效性。同时,测试精度提高了5.92,使其对不可见数据的泛化。我们也优于分层的个性化方法,如FedPer,LG-Fed。

FedPer的边际表现优于LGFED,在处理标签分布倾斜方面表现出了顶层个性化的优越性,而LGFed的表现较差。 值得注意的是,LG-Fed的表现仅略优于基线的FedAvg,这是由于在标签分布中存在倾斜,而LG-Fed的个性化底层难以学习

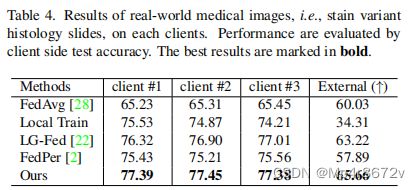

CD2-pFed在4个客户上的内部和外部测试结果始终优于基线,见表4。我们从内部验证比外部验证获得了更高的改进,这表明我们的模型可以很好地个性化全局模型。这些实证结果表明,除了自然图像分类外,CD2-pFed对医学图像的联邦个性化具有稳健性和成功性。

我们还在图6中可视化了非IIDCIFAR-10的训练性能,与现有的分层个性化方法相比,我们的CD2-pFed实现了更快的收敛,而分层个性化方法在联合期间需要更少的通信轮。

所提出的CD2-pFed由三个功能组件组成,以辅助信道解耦,即渐进式个性化比率增量方案(LI)、个性化权值的时间平均移动(TA)和循环蒸馏(CD)。为了测试每种方案的有效性,我们对CIFAR-10进行了消融研究。如表5所示,我们可以观察到1)在所有组件下,CD2-pFed取得了最好的性能,证明了集成LI+TA+CD三种方案的有效性,对原通道解耦的局部测试精度提高了1.51%;2)CD提高最高,TA第二,LI最小;