- 机器学习Pandas_learn3

XW-ABAP

机器学习pandas

frompandasimportDataFrameimportnumpypaints={"车名":["奥迪Q5L","哈弗H6","奔驰GLC"],"最低报价":[numpy.nan,9.80,numpy.nan],"最高报价":[49.80,23.10,58.78]}goods_in=DataFrame(paints,index=[1,2,3])print(goods_in)goods_in_n

- 【技术解密】本地部署 DeepSeek-V3:完整指南

海棠AI实验室

“智元启示录“-AI发展的深度思考与未来展望人工智能深度学习DeepSeek

目录引言运行环境需求下载与安装推理部署总结参考资源引言随着人工智能的快速发展,开源大模型正逐步改变着技术生态。DeepSeek-V3作为最新的开源大模型之一,不仅提供了强大的推理能力,同时也支持本地部署,使开发者可以灵活地进行自定义优化。本文将详细介绍如何在本地部署DeepSeek-V3,涵盖系统要求、安装步骤、模型转换及不同推理框架的应用。1.运行环境需求1.1硬件要求✅NVIDIAGPU(支持

- 人工智能伦理与可持续发展

CarlowZJ

人工智能

前言人工智能(AI)技术正在深刻地改变我们的生活和工作方式。从自动驾驶汽车到智能医疗系统,从个性化推荐到自动化决策,AI的应用无处不在。然而,随着技术的快速发展,其伦理和社会影响也引发了广泛的关注。人工智能伦理不仅涉及技术本身的公平性、透明性和安全性,还涉及到更广泛的社会、经济和环境影响。本文将探讨人工智能伦理的核心问题,并从可持续发展的角度提出应对策略。一、人工智能伦理的核心问题1.1数据隐私与

- 机器学习中输入输出Tokens的概念详解

爱吃土豆的程序员

机器学习基础机器学习人工智能Tokens

随着深度学习技术的快速发展,大语言模型(LargeLanguageModels,LLMs)已经成为自然语言处理(NLP)领域的一个热点研究方向。这些模型不仅能够生成高质量的文本,还能在多种任务中展现出卓越的表现,比如机器翻译、问答系统、文本摘要等。在大语言模型的工作流程中,Tokens的概念扮演着至关重要的角色。本文将详细介绍大语言模型如何使用Tokens,以及如何计算Tokens的数量。什么是T

- 情感分析任务的概述

阿你不是

python开发语言

一、情感分析的概述1、什么是情感分析情感分析,也称为情感分类,是一种自然语言处理的任务,用于分析文本、语音或其他形式的数据中所包含的情感倾向。其目标是判断数据表达的情感是积极的(Positive)、消极的(Negative)还是中立的(Neutral),或者进一步细化为更复杂的情感类别(如愤怒、喜悦、悲伤等)。2、情感分析的主要应用场景1)商业领域:情感分析主要进行产品评价分析,从客户和买家的评价

- 【深度学习基础】第二十四课:softmax函数的导数

x-jeff

深度学习基础深度学习人工智能

【深度学习基础】系列博客为学习Coursera上吴恩达深度学习课程所做的课程笔记。1.softmax函数softmax函数详解。2.softmax函数的导数假设神经网络输出层的激活函数为softmax函数,用以解决多分类问题。在反向传播时,就需要计算softmax函数的导数,这也就是本文着重介绍的内容。我们只需关注输出层即可,其余层和之前介绍的二分类模型一样,不再赘述。我们先考虑只有一个样本的情况

- AI如何创作音乐及其案例

alankuo

人工智能

AI创作音乐主要有以下几种方式:基于深度学习的生成模型深度神经网络:通过大量的音乐数据训练,让AI学习音乐的结构、旋律、和声、节奏等特征。如Transformer架构,其注意力机制可捕捉跨小节的旋律关联性,能生成具有长期依赖性的音乐序列。生成对抗网络(GAN):包含生成器和判别器,生成器负责生成音乐样本,判别器判断生成的音乐是否真实。两者相互对抗、不断优化,使生成器生成更逼真的音乐。变分自编码器(

- AI时代如何引流

alankuo

人工智能

AI时代引流可以从以下几个方面着手:利用AI精准定位与个性化营销精准客户画像:借助AI整合多维度数据,涵盖客户的年龄、性别、地理位置、消费习惯、浏览历史等,深度挖掘后绘制精准的客户画像,明确潜在客户特征与需求,让营销活动更具针对性。个性化内容创作:运用AI的自然语言处理功能,依据客户特点和需求生成个性化的营销内容,如广告文案、产品推荐等。以电商平台为例,可针对不同用户生成符合其喜好的商品推荐文案。

- LLM-PowerHouse: 一站式大型语言模型定制训练与推理指南

Nifc666

语言模型人工智能自然语言处理whisperlangchaingpt开源软件

LLM-PowerHouse:解锁大型语言模型的潜力在人工智能和自然语言处理领域,大型语言模型(LargeLanguageModels,LLMs)正在掀起一场革命。随着GPT、BERT等模型的出现,LLMs展现出了惊人的能力,可以执行各种复杂的语言任务。然而,如何有效地训练和使用这些强大的模型仍然是一个挑战。针对这一需求,GitHub上的LLM-PowerHouse项目应运而生,为开发者、研究人员

- 输入:0.5元/百万tokens(缓存命中)或2元(未命中) 输出:8元/百万tokens

杏花春雨江南

缓存

这句话描述了一种定价模型,通常用于云计算、API服务或数据处理服务中,根据资源使用情况(如缓存命中与否)来收费。以下是对这句话的详细解释:1.关键术语解释Tokens:在自然语言处理(NLP)或数据处理领域,Token通常指文本的最小单位(如一个单词或一个字符)。在这里,Tokens是计费的单位。缓存命中(CacheHit):当请求的数据已经在缓存中时,称为缓存命中。缓存命中通常意味着更快的响应速

- 【sklearn 01】人工智能概述

@金色海岸

人工智能sklearnpython

一、人工智能,机器学习,深度学习人工智能指由人类制造出的具有智能的机器。这是一个非常大的范围,长远目标是让机器实现人工智能,但目前我们仍处在非常初始的阶段,甚至不能称为智能机器学习是指通过数据训练出能完成一定功能的模型,是实现人工智能的手段之一,也是目前最主流的人工智能实现方法深度学习则是机器学习的分支,超过8层的神经网络模型就叫深度学习,深度即层数。深度学习目前在语音、图像等领域取得很好的效果

- 【人工智能】【Python】在Scikit-Learn中使用决策树算法(ID3和CART)

SmallBambooCode

机器学习人工智能python算法scikit-learn决策树机器学习ai

importnumpyasnpimportmatplotlib.pyplotaspltfromsklearn.datasetsimportload_irisfromsklearn.model_selectionimporttrain_test_splitfromsklearn.treeimportDecisionTreeClassifier,plot_tree#加载数据集iris=load_iri

- 差异中寻找共识:浅析中美欧AIGC服务商的标识义务

人工智能

2025年1月7日,西藏日喀则地震中一张被广泛传播的图片“被压在废墟下的小男孩”被证明是AI合成图片,[1]这随即引发了社会对于人工智能生成物(ArtificialIntelligenceGeneratedContent,以下简称“AIGC”)的广泛讨论。随着AI大模型生成逼真图像、音频与视频的能力日益增强,人类作品与AIGC之间的界限愈发模糊。如不加以管控,则会产生“真相侵蚀”(TruthDec

- 迷雾渐开:美国AIGC可版权性剖析及案例梳理

人工智能

当地时间2025年1月29日,美国版权局(U.S.CopyrightOffice,USCO)发布了版权和人工智能相关法律和政策报告的第二部分——《版权和人工智能:可版权性》(以下简称“《USCO可版权性报告》”)[1],旨在探讨人工智能生成内容(AIGC)的可版权性问题。该报告明确指出,美国版权局认为现有的版权法足以解决AIGC问题,因此无需制定新的立法。具体而言,该报告在此前美国版权局于2023

- 智能体平台架构深度剖析:从底层到应用的全链路解析

人工智能

在当今人工智能飞速发展的时代,智能体平台作为承载和驱动智能应用的关键基础设施,其架构设计至关重要。一个优秀的智能体平台架构,能够高效整合各类资源,实现智能体的灵活构建与稳定运行,为多样化的应用场景提供强大支持。稳固根基:基础资源层与并行平台层基础资源层是整个智能体平台的基石。其中,GPU和服务器构成了强大的计算硬件支撑,确保平台能够应对复杂的计算任务。而数据与OSS(对象存储服务)则如同智能体的“

- 美国首例AI训练数据版权案:从汤森路透诉罗斯案看AI训练数据的“合理使用”

人工智能

随着人工智能(AI)技术的快速发展和广泛应用,复杂的版权问题也随之而来。2025年2月11日,美国特拉华州联邦地区法院对汤森路透(ThomsonReuters)诉罗斯(Ross)案作出部分简易判决,认定被告罗斯公司未经授权使用受版权保护的作品训练AI法律检索工具的行为构成版权侵权,且不属于合理使用。[1]这是美国首个就AI训练数据作出实质性判决的案件。本文将重点分析其合理使用论述中对于“转换性目的

- 【人工智能基础2】Tramsformer架构、自然语言处理基础、计算机视觉总结

roman_日积跬步-终至千里

人工智能习题人工智能自然语言处理计算机视觉

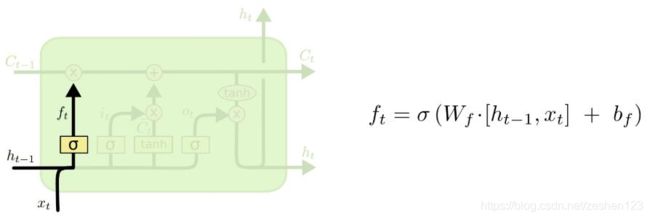

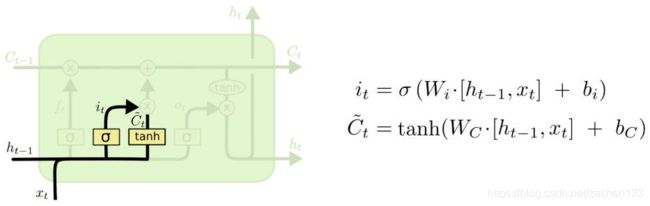

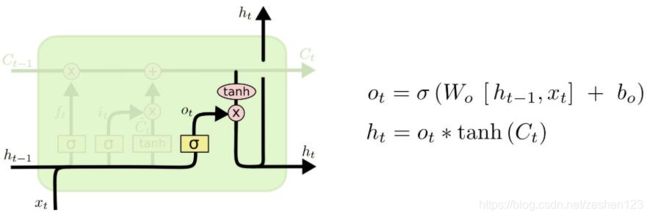

文章目录七、Transformer架构1.替代LSTM的原因2.Transformer架构:编码器-解码器架构3.Transformer架构原理八、自然语言处理基础1.语言模型基本概念2.向量语义3.预训练语言模型的基本原理与方法4.DeepSeek基本原理九、计算机视觉七、Transformer架构1.替代LSTM的原因处理极长序列时,效率下降:虽然LSTM设计的初衷是解决长期依赖问题,即让模型

- 怎么做一个AI产品经理?

AI筑梦师

AI产品经理人工智能产品经理

AI产品经理全面进化:在人工智能迅猛发展的时代,产品经理的角色正经历前所未有的转型。从传统的需求捕捉者到技术与商业紧密结合的创新推动者,AI产品经理肩负着将前沿AI技术转化为解决用户痛点的产品的重要任务。随着大数据、云计算和大模型技术的不断成熟,产品经理不仅需要具备敏锐的市场洞察,还必须深刻理解AI技术本质,跨界整合技术、数据与业务优势,从而推动产品的持续创新与落地。本文将全面解析AI产品经理的角

- 【AI】使用Python实现机器学习小项目教程

丶2136

AI人工智能python机器学习

引言在本教程中,我们将带领您使用Python编程语言实现一个经典的机器学习项目——鸢尾花(Iris)分类。通过这个项目,您将掌握机器学习的基本流程,包括数据加载、预处理、模型训练、评估和优化等步骤。论文AIGC检测,降AIGC检测,AI降重,三连私信免费获取:ReduceAIGC9折券!DetectAIGC立减2元券!AI降重9折券!目录引言一、项目背景与目标二、开发环境准备2.1所需工具2.2环

- 请编写一个Python程序,实现WOA-CNN-BiLSTM鲸鱼算法优化卷积双向长短期记忆神经网络多输入单输出回归预测功能。

2301_81121233

算法神经网络pythonmongodbstormzookeeperspark

实现一个基于鲸鱼优化算法(WOA)优化的卷积双向长短期记忆神经网络(CNN-BiLSTM)的多输入单输出回归预测功能是一个复杂的任务,涉及到多个步骤和组件。由于完整的实现会非常冗长,我将提供一个简化的框架和关键部分的代码示例,帮助你理解如何实现这个功能。请注意,这个示例不会包含所有细节,比如数据集的准备、鲸鱼优化算法的具体实现(WOA是一个元启发式算法,需要单独实现或引用现有库),以及CNN-Bi

- 网络神经架构的概念及其实际应用

2301_81121233

网络爬山算法近邻算法霍夫曼树剪枝哈希算法柔性数组

###网络神经架构的概念**网络神经架构(NeuralNetworkArchitecture)**是指用于构建和组织人工神经网络(ArtificialNeuralNetworks,ANN)的结构和方法。这些架构通常由多个层次的节点(神经元)组成,通过模拟人脑神经元之间的连接和信息传递方式,来处理复杂的数据输入并生成相应的输出。网络神经架构通常由以下几个部分组成:1.**输入层(InputLayer

- LORA 微调大模型:从入门到入土

大模型.

人工智能开发语言gptagi架构大模型

在当今人工智能领域,预训练的大模型已经成为推动技术发展的核心力量。然而,在实际项目中,我们往往会发现这些预训练模型虽然强大,但直接就去应用于一些特定的任务时,往往无法完全满足需求。这时,微调就成为了必不可少的一步。而在众多微调方法中,LORA全名(Low-RankAdaptation)以高效性和实用性,逐渐成为了许多开发者训练模型的首选项。作为一名小有经验的咸鱼开发者,我深知在实际项目中高效的进行

- AI人工智能中的概率论与统计学原理与Python实战:Python实现概率模型

AI天才研究院

AI实战AI大模型企业级应用开发实战大数据人工智能语言模型AILLMJavaPython架构设计AgentRPA

1.背景介绍随着人工智能技术的不断发展,概率论与统计学在人工智能领域的应用越来越广泛。概率论与统计学是人工智能中的基础知识之一,它们在机器学习、深度学习、自然语言处理等领域都有着重要的作用。本文将介绍概率论与统计学的核心概念、算法原理、具体操作步骤以及Python实现方法,并通过具体代码实例进行详细解释。2.核心概念与联系2.1概率论与统计学的区别概率论是一门数学学科,它研究随机事件发生的可能性。

- 如何使用 Python 实现生成对抗网络

NoABug

python生成对抗网络tensorflow

如何使用Python实现生成对抗网络生成对抗网络(GenerativeAdversarialNetwork,GAN)是一种能够生成高质量、逼真图像的深度学习模型。GAN模型由两个神经网络组成:一个生成器和一个判别器。生成器的任务是以噪声为输入,生成看似真实的图像;而判别器则需要根据输入的图像,判断该图像是真实的还是由生成器生成的。下面我们将通过Python代码来实现一个简单的GAN模型。首先,我们

- GAN模型的Python应用——生成对抗网络

代码编织匠人

python生成对抗网络开发语言

GAN模型的Python应用——生成对抗网络生成对抗网络(GenerativeAdversarialNetwork,GAN)是深度学习中的一种重要模型,已经被广泛应用于图像、文本生成等领域。GAN模型由两个神经网络组成:生成器(Generator)和判别器(Discriminator)。生成器用于生成假样本,判别器用于评估真实性。两个神经网络相互博弈,通过一次次迭代训练,最终生成器可以生成足以骗过

- 二值逻辑、三值逻辑到多值逻辑的变迁(含示例)

搏博

人工智能原理算法人工智能机器学习线性代数图像处理数据分析

二值逻辑、三值逻辑到多值逻辑的变迁是一个逻辑体系不断拓展和深化的过程,反映了人们对复杂现象和不确定性问题认识的逐步深入。前文,我们已经探讨过命题逻辑与谓词逻辑,了解了如何用符号语言从浅入深地刻画现实世界。具体可以看我的CSDN文章:人工智能的数学基础之命题逻辑与谓词逻辑(含示例)-CSDN博客人工智能中用到的逻辑可概括地划分为两大类。第一类是经典命题逻辑和一阶谓词逻辑,第二类是泛指除经典逻辑之外的

- ollama下载的DeepSeek的模型(Model)文件在哪里?(C盘下)

神秘泣男子

常见AI大模型部署与应用Ollama部署LLM人工智能ollamallama自然语言处理机器学习

目录一、下载大模型(DeepSeek)2.安装Ollama3.检查安装是否成功二、拉取大模型(DeepSeek)1.打开命令行2.下载模型3.测试下载4.等待下载完成三.模型存放路径这个位置!!在人工智能快速发展的今天,大语言模型已经成为许多人探索和使用的热门技术。而Ollama作为一款轻量级的本地大模型运行工具,让我们能够在个人电脑上体验各种强大的AI模型,如DeepSeek系列。不少用户在安装

- 技术解析麦萌短剧《月光下的你》:从「时间序列的对抗扰动」到「加密身份的收敛证明」

萌萌短剧

重构

《月光下的你》以十六年的时间跨度展开一场关于「数据污染」与「身份验证」的深度博弈,本文将用机器学习视角拆解这场跨越时空的模型纠偏实验。1.数据污染事件:十六年前的对抗攻击许芳菲(Agent_Xu)的遭遇可视为时间序列上的对抗样本注入:标签篡改攻击:许清清(Adversary_XuQing)通过伪造标签(Label_Tampering)将Agent_Xu与傅临州(Node_Fu)强行关联,触发道德约

- AIGC从入门到实战:可能消失的职业和新出现的机会

AGI大模型与大数据研究院

DeepSeekR1&大数据AI人工智能计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

AIGC从入门到实战:可能消失的职业和新出现的机会作者:禅与计算机程序设计艺术1.背景介绍人工智能生成内容(AIGC)正在迅速改变我们的世界。从文本、代码到图像和音乐,AIGC正在各个领域展示其强大的能力,并开始挑战传统的创意产业。本篇文章将深入探讨AIGC的概念、技术原理、应用场景以及其对未来职业的影响,并为读者提供入门AIGC的实用指南。1.1AIGC的兴起AIGC的兴起得益于近年来人工智能技

- 机器学习 [白板推导](三)[线性分类]

神齐的小马

机器学习分类人工智能

4.线性分类4.1.线性分类的典型模型硬分类:输出结果只有0或1这种离散结果;感知机线性判别分析Fisher软分类:会输出0-1之间的值作为各个类别的概率;概率生成模型:高斯判别分析GDA、朴素贝叶斯,主要建模的是p(x⃗,y)p(\vec{x},y)p(x,y)概率判别模型:逻辑回归,主要建模的是p(y∣x⃗)p(y|\vec{x})p(y∣x)4.2.感知机4.2.1.基本模型 模型:f(x

- js动画html标签(持续更新中)

843977358

htmljs动画mediaopacity

1.jQuery 效果 - animate() 方法 改变 "div" 元素的高度: $(".btn1").click(function(){ $("#box").animate({height:"300px

- springMVC学习笔记

caoyong

springMVC

1、搭建开发环境

a>、添加jar文件,在ioc所需jar包的基础上添加spring-web.jar,spring-webmvc.jar

b>、在web.xml中配置前端控制器

<servlet>

&nbs

- POI中设置Excel单元格格式

107x

poistyle列宽合并单元格自动换行

引用:http://apps.hi.baidu.com/share/detail/17249059

POI中可能会用到一些需要设置EXCEL单元格格式的操作小结:

先获取工作薄对象:

HSSFWorkbook wb = new HSSFWorkbook();

HSSFSheet sheet = wb.createSheet();

HSSFCellStyle setBorder = wb.

- jquery 获取A href 触发js方法的this参数 无效的情况

一炮送你回车库

jquery

html如下:

<td class=\"bord-r-n bord-l-n c-333\">

<a class=\"table-icon edit\" onclick=\"editTrValues(this);\">修改</a>

</td>"

j

- md5

3213213333332132

MD5

import java.security.MessageDigest;

import java.security.NoSuchAlgorithmException;

public class MDFive {

public static void main(String[] args) {

String md5Str = "cq

- 完全卸载干净Oracle11g

sophia天雪

orale数据库卸载干净清理注册表

完全卸载干净Oracle11g

A、存在OUI卸载工具的情况下:

第一步:停用所有Oracle相关的已启动的服务;

第二步:找到OUI卸载工具:在“开始”菜单中找到“oracle_OraDb11g_home”文件夹中

&

- apache 的access.log 日志文件太大如何解决

darkranger

apache

CustomLog logs/access.log common 此写法导致日志数据一致自增变大。

直接注释上面的语法

#CustomLog logs/access.log common

增加:

CustomLog "|bin/rotatelogs.exe -l logs/access-%Y-%m-d.log

- Hadoop单机模式环境搭建关键步骤

aijuans

分布式

Hadoop环境需要sshd服务一直开启,故,在服务器上需要按照ssh服务,以Ubuntu Linux为例,按照ssh服务如下:

sudo apt-get install ssh

sudo apt-get install rsync

编辑HADOOP_HOME/conf/hadoop-env.sh文件,将JAVA_HOME设置为Java

- PL/SQL DEVELOPER 使用的一些技巧

atongyeye

javasql

1 记住密码

这是个有争议的功能,因为记住密码会给带来数据安全的问题。 但假如是开发用的库,密码甚至可以和用户名相同,每次输入密码实在没什么意义,可以考虑让PLSQL Developer记住密码。 位置:Tools菜单--Preferences--Oracle--Logon HIstory--Store with password

2 特殊Copy

在SQL Window

- PHP:在对象上动态添加一个新的方法

bardo

方法动态添加闭包

有关在一个对象上动态添加方法,如果你来自Ruby语言或您熟悉这门语言,你已经知道它是什么...... Ruby提供给你一种方式来获得一个instancied对象,并给这个对象添加一个额外的方法。

好!不说Ruby了,让我们来谈谈PHP

PHP未提供一个“标准的方式”做这样的事情,这也是没有核心的一部分...

但无论如何,它并没有说我们不能做这样

- ThreadLocal与线程安全

bijian1013

javajava多线程threadLocal

首先来看一下线程安全问题产生的两个前提条件:

1.数据共享,多个线程访问同样的数据。

2.共享数据是可变的,多个线程对访问的共享数据作出了修改。

实例:

定义一个共享数据:

public static int a = 0;

- Tomcat 架包冲突解决

征客丶

tomcatWeb

环境:

Tomcat 7.0.6

win7 x64

错误表象:【我的冲突的架包是:catalina.jar 与 tomcat-catalina-7.0.61.jar 冲突,不知道其他架包冲突时是不是也报这个错误】

严重: End event threw exception

java.lang.NoSuchMethodException: org.apache.catalina.dep

- 【Scala三】分析Spark源代码总结的Scala语法一

bit1129

scala

Scala语法 1. classOf运算符

Scala中的classOf[T]是一个class对象,等价于Java的T.class,比如classOf[TextInputFormat]等价于TextInputFormat.class

2. 方法默认值

defaultMinPartitions就是一个默认值,类似C++的方法默认值

- java 线程池管理机制

BlueSkator

java线程池管理机制

编辑

Add

Tools

jdk线程池

一、引言

第一:降低资源消耗。通过重复利用已创建的线程降低线程创建和销毁造成的消耗。第二:提高响应速度。当任务到达时,任务可以不需要等到线程创建就能立即执行。第三:提高线程的可管理性。线程是稀缺资源,如果无限制的创建,不仅会消耗系统资源,还会降低系统的稳定性,使用线程池可以进行统一的分配,调优和监控。

- 关于hql中使用本地sql函数的问题(问-答)

BreakingBad

HQL存储函数

转自于:http://www.iteye.com/problems/23775

问:

我在开发过程中,使用hql进行查询(mysql5)使用到了mysql自带的函数find_in_set()这个函数作为匹配字符串的来讲效率非常好,但是我直接把它写在hql语句里面(from ForumMemberInfo fm,ForumArea fa where find_in_set(fm.userId,f

- 读《研磨设计模式》-代码笔记-迭代器模式-Iterator

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.Arrays;

import java.util.List;

/**

* Iterator模式提供一种方法顺序访问一个聚合对象中各个元素,而又不暴露该对象内部表示

*

* 个人觉得,为了不暴露该

- 常用SQL

chenjunt3

oraclesqlC++cC#

--NC建库

CREATE TABLESPACE NNC_DATA01 DATAFILE 'E:\oracle\product\10.2.0\oradata\orcl\nnc_data01.dbf' SIZE 500M AUTOEXTEND ON NEXT 50M EXTENT MANAGEMENT LOCAL UNIFORM SIZE 256K ;

CREATE TABLESPA

- 数学是科学技术的语言

comsci

工作活动领域模型

从小学到大学都在学习数学,从小学开始了解数字的概念和背诵九九表到大学学习复变函数和离散数学,看起来好像掌握了这些数学知识,但是在工作中却很少真正用到这些知识,为什么?

最近在研究一种开源软件-CARROT2的源代码的时候,又一次感觉到数学在计算机技术中的不可动摇的基础作用,CARROT2是一种用于自动语言分类(聚类)的工具性软件,用JAVA语言编写,它

- Linux系统手动安装rzsz 软件包

daizj

linuxszrz

1、下载软件 rzsz-3.34.tar.gz。登录linux,用命令

wget http://freeware.sgi.com/source/rzsz/rzsz-3.48.tar.gz下载。

2、解压 tar zxvf rzsz-3.34.tar.gz

3、安装 cd rzsz-3.34 ; make posix 。注意:这个软件安装与常规的GNU软件不

- 读源码之:ArrayBlockingQueue

dieslrae

java

ArrayBlockingQueue是concurrent包提供的一个线程安全的队列,由一个数组来保存队列元素.通过

takeIndex和

putIndex来分别记录出队列和入队列的下标,以保证在出队列时

不进行元素移动.

//在出队列或者入队列的时候对takeIndex或者putIndex进行累加,如果已经到了数组末尾就又从0开始,保证数

- C语言学习九枚举的定义和应用

dcj3sjt126com

c

枚举的定义

# include <stdio.h>

enum WeekDay

{

MonDay, TuesDay, WednesDay, ThursDay, FriDay, SaturDay, SunDay

};

int main(void)

{

//int day; //day定义成int类型不合适

enum WeekDay day = Wedne

- Vagrant 三种网络配置详解

dcj3sjt126com

vagrant

Forwarded port

Private network

Public network

Vagrant 中一共有三种网络配置,下面我们将会详解三种网络配置各自优缺点。

端口映射(Forwarded port),顾名思义是指把宿主计算机的端口映射到虚拟机的某一个端口上,访问宿主计算机端口时,请求实际是被转发到虚拟机上指定端口的。Vagrantfile中设定语法为:

c

- 16.性能优化-完结

frank1234

性能优化

性能调优是一个宏大的工程,需要从宏观架构(比如拆分,冗余,读写分离,集群,缓存等), 软件设计(比如多线程并行化,选择合适的数据结构), 数据库设计层面(合理的表设计,汇总表,索引,分区,拆分,冗余等) 以及微观(软件的配置,SQL语句的编写,操作系统配置等)根据软件的应用场景做综合的考虑和权衡,并经验实际测试验证才能达到最优。

性能水很深, 笔者经验尚浅 ,赶脚也就了解了点皮毛而已,我觉得

- Word Search

hcx2013

search

Given a 2D board and a word, find if the word exists in the grid.

The word can be constructed from letters of sequentially adjacent cell, where "adjacent" cells are those horizontally or ve

- Spring4新特性——Web开发的增强

jinnianshilongnian

springspring mvcspring4

Spring4新特性——泛型限定式依赖注入

Spring4新特性——核心容器的其他改进

Spring4新特性——Web开发的增强

Spring4新特性——集成Bean Validation 1.1(JSR-349)到SpringMVC

Spring4新特性——Groovy Bean定义DSL

Spring4新特性——更好的Java泛型操作API

Spring4新

- CentOS安装配置tengine并设置开机启动

liuxingguome

centos

yum install gcc-c++

yum install pcre pcre-devel

yum install zlib zlib-devel

yum install openssl openssl-devel

Ubuntu上可以这样安装

sudo aptitude install libdmalloc-dev libcurl4-opens

- 第14章 工具函数(上)

onestopweb

函数

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- Xelsius 2008 and SAP BW at a glance

blueoxygen

BOXelsius

Xelsius提供了丰富多样的数据连接方式,其中为SAP BW专属提供的是BICS。那么Xelsius的各种连接的优缺点比较以及Xelsius是如何直接连接到BEx Query的呢? 以下Wiki文章应该提供了全面的概览。

http://wiki.sdn.sap.com/wiki/display/BOBJ/Xcelsius+2008+and+SAP+NetWeaver+BW+Co

- oracle表空间相关

tongsh6

oracle

在oracle数据库中,一个用户对应一个表空间,当表空间不足时,可以采用增加表空间的数据文件容量,也可以增加数据文件,方法有如下几种:

1.给表空间增加数据文件

ALTER TABLESPACE "表空间的名字" ADD DATAFILE

'表空间的数据文件路径' SIZE 50M;

&nb

- .Net framework4.0安装失败

yangjuanjava

.netwindows

上午的.net framework 4.0,各种失败,查了好多答案,各种不靠谱,最后终于找到答案了

和Windows Update有关系,给目录名重命名一下再次安装,即安装成功了!

下载地址:http://www.microsoft.com/en-us/download/details.aspx?id=17113

方法:

1.运行cmd,输入net stop WuAuServ

2.点击开

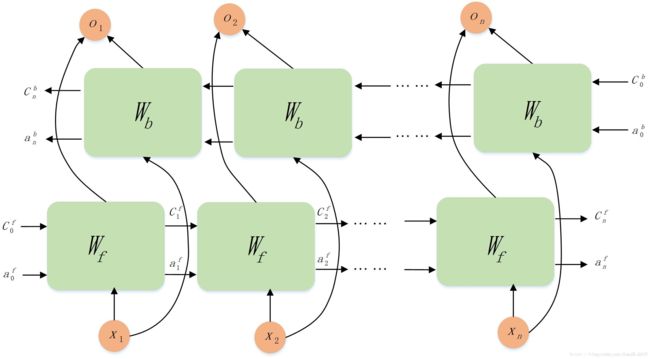

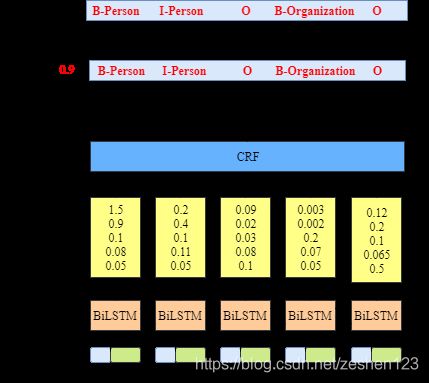

首先输入一段话(按句号再拆分为句子)或者一个句子,将其分割为一个一个单词,然后通过Embedding层进行训练。训练之后传给BiLSTM层,输入是词嵌入向量,输出表示该单词对应各个类别的分数。所有经BiLSTM层输出的分数将作为CRF层的输入,进行学习约束,类别序列中分数最高的类别就是我们预测的最终结果。

首先输入一段话(按句号再拆分为句子)或者一个句子,将其分割为一个一个单词,然后通过Embedding层进行训练。训练之后传给BiLSTM层,输入是词嵌入向量,输出表示该单词对应各个类别的分数。所有经BiLSTM层输出的分数将作为CRF层的输入,进行学习约束,类别序列中分数最高的类别就是我们预测的最终结果。