【对抗攻击论文笔记】对抗迁移性:Delving Into Transferable Adversarial Examples And Black-Box Attacks

文章目录

- 论文概述

-

- idea

- method

- 详细内容

-

- 摘要

- 1.介绍

- 2 对抗深度学习和可迁移性

-

- 2.1 对抗深度学习问题

- 2.2 对抗样本生成的方法

- 2.3 评估方法

- 3. 非定向对抗样本

-

- 3.1 基于优化

- 3.2 基于FGSM

- 4. 定向对抗样本

- 5.集成的方法

- 6.几何特征

论文概述

发表于ICLR2017,论文地址:https://arxiv.org/pdf/1611.02770——深入研究可迁移的对抗样本和黑盒攻击

idea

迁移性是指一个模型生成的一些对抗样本也可能被另一个模型错误分类。

这篇文章其实是基于 Transferability in Machine Learning: from Phenomena to

Black-Box Attacks using Adversarial Samples 的改进和进一步研究,第一次使用不同方法在大规模数据集上生成targeted 和no-targeted对抗样本研究迁移性。迁移性实验的成功,也让作者对为什么能迁移成功进行了探究,不同于以往的理论或者经验分析,作者从模型的几何特性(geometric properties)进行了分析。

method

实验表明,no-targeted对抗样本可以很好的迁移,但是targeted对抗样本迁移性较弱,所以采用了ensemble model(集成模型)的方法,增大了迁移性。

详细内容

摘要

以前的工作主要研究使用小规模数据集的可迁移性。在这项工作中,我们是第一个对大型模型和大规模数据集的可迁移性进行广泛研究的人,我们也是第一个研究targeted对抗样本及其targeted label的可迁移性的人。我们研究了非目标对抗样本和目标对抗样本,并表明虽然可转移的非目标对抗样本很容易找到,但使用现有方法生成的目标对抗样本几乎不会随目标标签一起转移。因此,我们提出了新的基于集成的方法来生成可转移的对抗样本。

(以前的工作其实指的是这篇:Transferability in Machine Learning: from Phenomena to Black-Box Attacks using Adversarial Samples,idea中有链接)

1.介绍

(开始几段就是讲了讲对抗样本的发展过程,以及迁移性的存在;然后介绍了本文的工作内容,包括非定向迁移的有效性,定向的集成攻击迁移等)

主要贡献:

- 对于 ImageNet 模型,我们表明,虽然现有方法可以有效地生成非定向 (no-targeted)可迁移对抗样本(第 3 节),但只有少数由现有方法生成的定向(targeted)对抗样本可以迁移(第 4 节)。

- 我们提出了新颖的基于集成的方法来生成对抗性示例(第 5 节)。我们的方法首次使大部分定向的对抗样本能够在多个模型之间转移。

- 我们是第一个提出为在 ImageNet 上训练的模型生成的 trageted 对抗样本可以转移到黑盒系统,即 Clarifai.com。其模型、训练数据和标签集对我们来说是未知的(第 7 节)。特别是,Clarifai.com 的标签集与 ImageNet 的非常不同。

- 我们对在ImageNet 上训练的大型模型的几何特性进行了首次分析(第6 节),结果揭示了一些有趣的发现,例如不同模型的梯度方向彼此正交。

2 对抗深度学习和可迁移性

2.1 对抗深度学习问题

(主要讲的是对抗攻击问题的定义)

2.2 对抗样本生成的方法

2.2.1 生成非定向对抗样本的方法

f θ ( x ∗ ) ≠ y ( 1 ) ; d ( x , x ∗ ) ≤ B ( 2 ) f_{\theta}(x^*)\neq y (1); d(x,x^*) \leq B (2) fθ(x∗)=y(1);d(x,x∗)≤B(2)

其中 d(·,·) 是量化原始图像与其对抗样本之间距离的度量,B称为失真,是该距离的上限。

-

基于优化

a r g min x ∗ λ d ( x , x ∗ ) − l ( 1 y ∗ , J θ ( x ∗ ) ) arg \min_{x^*} \lambda d(x,x^*)-l(1_{y^*},J_{\theta}(x^*)) argx∗minλd(x,x∗)−l(1y∗,Jθ(x∗))

其中 1 y 1_y 1y是ground trurh标签 y 的 one-hot 编码, l l l是衡量预测与ground truth之间距离的损失函数,λ 是平衡约束 (2) 和 (1) 的常数。这里,损失函数 l l l用于逼近约束(1),它的选择会影响搜索对抗样本的有效性。

损失函数选择的是 l ( u , v ) = l o g ( 1 − u v ) l(u,v)=log(1-uv) l(u,v)=log(1−uv),来源于CW攻击(论文pdf) -

FGS

x ∗ = c l i p ( x + B s g n ( ∇ x l ( 1 y , J θ ( x ) ) ) ) x^*=clip(x+Bsgn(\nabla_x l(1_y,J_{\theta}(x)))) x∗=clip(x+Bsgn(∇xl(1y,Jθ(x))))

其中clip(x) 用于将 x 的每个维度裁剪到像素值的范围内,即本文中的 [0, 255]。 l ( u , v ) = l o g ( 1 − u v ) l(u,v)=log(1-uv) l(u,v)=log(1−uv) -

FG

(与FGS类似,就不多介绍了)

2.3 评估方法

- 模型

5个模型:ResNet-50, ResNet-101, ResNet-152 ,GoogLeNet and VGG-16 - 数据

从 ILSVRC 2012 验证集中,我们随机选择了 100 张图像 - Measuring transferability(衡量迁移性)

在给定两个模型的情况下,我们通过计算一个模型生成的可被正确分类为另一个模型的对抗样本的百分比来衡量 no-targeted 可转移性,我们把这个百分比称为准确率。较低的精确度意味着更好的非定向可转移性。

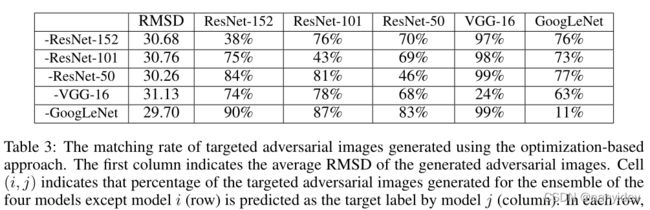

我们通过计算一个模型生成的被另一个模型归类为 targeted 标签的对抗性样本的百分比来衡量目标可转移性。我们将这个百分比称为匹配率。更高的匹配率意味着更好的定向可转移性。

(这个很重要,理解准确率和匹配率,才能看懂下文的实验表格) - Distortion

除了可转移性,另一个重要因素是对抗图像与原始图像之间的失真,采用的是root mean square deviation,RMSD,公式: d ( x , x ∗ ) = ∑ i ( x i ∗ − x i ) 2 / N d(x,x^*)=\sqrt{\sum_i (x_i^*-x_i)^2/N} d(x,x∗)=i∑(xi∗−xi)2/N

N 是 x x x和 x ∗ x^* x∗ 的维数, x i x_i xi 表示 x 的第 i 个维度的像素值,在 [0, 255] 范围内

3. 非定向对抗样本

3.1 基于优化

(主要讲了下实验设置,可以通过调整Adam和λ 的学习率来调整 RMSD。小失真的对抗样本可以攻击成功但不能很好地迁移(附录表15和表16)。增大失真,lr 设置为4,进行实验)

单元格(i,j)表示为模型 i(行)生成的对抗图像在模型 j(列)上评估的准确性。

通过实验分析:

- 对角线包含所有 0 值。这意味着为一个模型生成的所有对抗性图像都可能误导同一个模型。(对角线相当于白盒)

- 使用基于优化的方法为一个模型生成的大部分no-targeted对抗性图像可以转移到另一个模型。

- 尽管三个 ResNet 模型共享相似的架构,仅在超参数上有所不同,但针对 ResNet 模型生成的对抗性示例不一定比其他非 ResNet 模型更好地转移到另一个 ResNet 模型。

3.2 基于FGSM

(基于梯度的快速方法的一个优点是所有生成的对抗样本都位于一维子空间中。通过控制 RMSD 来研究基于梯度的快速方法的有效性)

3.2.1 基于梯度的快速方法的有效性和可迁移性

由于生成的对抗图像的失真 B 和 RMSD 高度相关,我们可以选择这个超参数 B 来生成具有给定 RMSD 的对抗图像。

在表 1 panel B 中,我们使用 FG 生成对抗图像,使得平均 RMSD 与使用基于优化的方法生成的图像几乎相同。我们观察到对角线值都是postive,这意味着FG不能完全误导模型。一个潜在的原因是,FG 可以被视为近似优化,但它是针对速度而不是准确性量身定制的。

另一方面,表中非对角单元格的值对应于为一个模型生成但在另一个模型上评估的对抗性图像的准确性,与基于优化的方法中的对应物相当或更低。这表明 FG 生成的非目标对抗样本也表现出可迁移性。

4. 定向对抗样本

(实验结果如下)

观察发现:

(1)当在用于生成对抗样本的同一模型上进行评估时,targeted对抗图像的预测可以匹配目标标签

(2)但是 targeted 对抗图像很少能被不同的模型预测为目标标签。我们称后者为目标标签不转移(the target labels do not transfer.)。即使增加了失真,仍然没有观察到目标标签转移的改进

5.集成的方法

(在Section 4中已经发现定向攻击的迁移效果很不好,所以采用集成的方法)

给定 k 个 softmax 输出为 J1、…、Jk、原始图像 x 及其ground truth y 的白盒模型,基于集成的方法解决了以下优化问题:

a r g min x ∗ − l o g ( ∑ i = 1 k α i J i ( x ∗ ) ⋅ l y ∗ ) + λ d ( x , x ∗ ) arg \min_{x^*} -log(\sum_{i=1}^k \alpha_i J_i(x^*) \cdot l_{y^*})+\lambda d(x,x^*) argx∗min−log(i=1∑kαiJi(x∗)⋅ly∗)+λd(x,x∗)

其中 y ∗ y^* y∗ 是攻击图片的标签, ∑ i = 1 k α i J i ( x ∗ ) \sum_{i=1}^k \alpha_i J_i(x^*) ∑i=1kαiJi(x∗) 是集成的模型, α i \alpha_i αi 是系数。则我们希望生成的对抗图像对于额外的黑盒模型 Jk+1 保持对抗性。

- 基于优化的方法

(首先说了下实验设置,targeted adversarial,实验结果如下)

targeted攻击匹配率,单元格(i,j)表示为模型 i(行)之外的四个模型的集合生成的目标对抗图像的百分比被模型 j(列)预测为目标标签

(non-targeted adversarial,实验结果如下)

(基于梯度的方法实验结果见附录)

6.几何特征

在本节中,我们展示了模型的一些几何特性,以试图更好地理解可迁移的对抗样本。先前的工作还试图从理论上或经验理解对抗样本的几何特性。在这项工作中,我们检查了在具有 1000 个标签的大型数据集上训练的大型模型,其几何属性以前从未研究过。这使我们能够进行新的观察,以更好地理解模型及其对抗性示例

1.我们评估中不同模型的梯度方向几乎相互正交

不同模型的对抗方向相互正交的

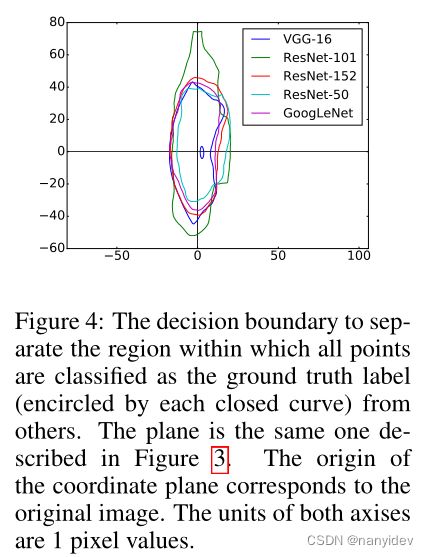

2.使用单个模型的非目标方法的决策边界。

我们研究了不同模型的决策边界,以了解对抗样本迁移的原因。我们选择两个归一化正交方向δ1、δ2,一个是VGG-16的梯度方向,另一个是随机选择的。此二维平面中的每个点 (u, v) 对应于图像 x + uδ1 + vδ2,其中 x 是原始图像的像素值向量

- 对于所有模型,每个模型能够正确预测图像的区域都局限于中心区域。

- 沿着梯度方向,分类器很快就会被误导。

- 对于每个平面,所有平面上最多有 21 个不同的区域。与 ImageNet 中的 1000 个总类别相比,这仅占所有类别的 2.1%。这意味着,对于所有其他 97.9% 的标签,每个平面中都不存在有针对性的对抗样本。这种现象部分解释了为什么基于快速梯度的方法很难找到有targeted的对抗性图像。

此外,我们在同一平面上绘制所有模型的决策边界

我们观察到:

- 边界彼此非常吻合。这就解释了为什么非目标对抗图像可以在模型之间传输。

- 沿梯度方向的边界直径小于沿随机方向的边界直径。一个潜在的原因是沿其梯度方向移动变量可以显着改变损失函数

- 一个有趣的发现是,即使我们沿 x 轴向左移动,这相当于最大化ground truth的预测概率,它也比沿随机方向移动更快地到达边界。我们将此归因于损失函数的非线性:当失真较大时,梯度方向也会发生巨大变化。在这种情况下,沿原始梯度方向移动不再增加预测ground truth标签的概率(参见附录中的图 7)。

- 对于VGG-16 模型,在对应于ground truth 的区域内有一个小洞。这可以部分解释为什么存在具有小失真的非目标对抗性图像,但不能很好地转移。这个漏洞在其他模型的决策平面上是不存在的。在这种情况下,这个洞中的非目标对抗性图像不会转移。