转

如何选择回归损失函数

2018年09月07日 10:21:13 qq_34555202 阅读数 1467

无论在机器学习还是深度领域中,损失函数都是一个非常重要的知识点。损失函数(Loss Function)是用来估量模型的预测值 f(x) 与真实值 y 的不一致程度。我们的目标就是最小化损失函数,让 f(x) 与 y 尽量接近。通常可以使用梯度下降算法寻找函数最小值。

损失函数有许多不同的类型,没有哪种损失函数适合所有的问题,需根据具体模型和问题进行选择。一般来说,损失函数大致可以分成两类:回归(Regression)和分类(Classification)。

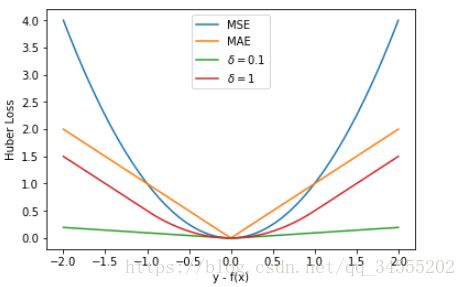

回归模型中的三种损失函数包括:均方误差(Mean Square Error)、平均绝对误差(Mean Absolute Error,MAE)、Huber Loss。

1. 均方误差(Mean Square Error,MSE)

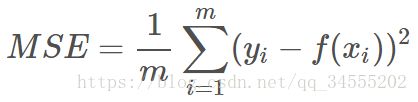

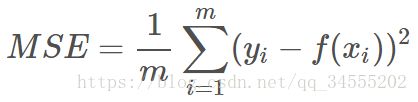

均方误差指的就是模型预测值 f(x) 与样本真实值 y 之间距离平方的平均值。其公式如下所示:

其中,yi 和 f(xi) 分别表示第 i 个样本的真实值和预测值,m 为样本个数。

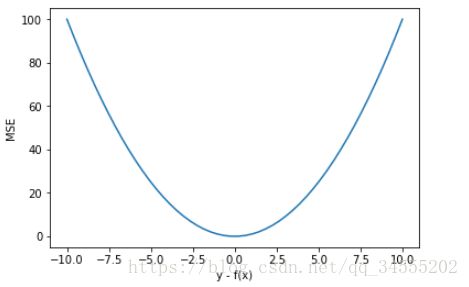

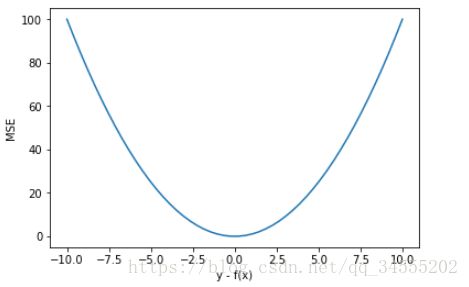

为了简化讨论,忽略下标 i,m = 1,以 y-f(x) 为横坐标,MSE 为纵坐标,绘制其损失函数的图形:

MSE 曲线的特点是光滑连续、可导,便于使用梯度下降算法,是比较常用的一种损失函数。而且,MSE 随着误差的减小,梯度也在减小,这有利于函数的收敛,即使固定学习因子,函数也能较快取得最小值。

平方误差有个特性,就是当 yi 与 f(xi) 的差值大于 1 时,会增大其误差;当 yi 与 f(xi) 的差值小于 1 时,会减小其误差。这是由平方的特性决定的。也就是说, MSE 会对误差较大(>1)的情况给予更大的惩罚,对误差较小(<1)的情况给予更小的惩罚。从训练的角度来看,模型会更加偏向于惩罚较大的点,赋予其更大的权重。

如果样本中存在离群点,MSE 会给离群点赋予更高的权重,但是却是以牺牲其他正常数据点的预测效果为代价,这最终会降低模型的整体性能。我们来看一下使用 MSE 解决含有离群点的回归模型。

-

-

import matplotlib.pyplot

as plt

-

x = np.linspace(

1,

20,

40)

-

y = x + [np.random.choice(

4)

for _

in range(

40)]

-

-

X = np.vstack((np.ones_like(x),x))

-

-

-

-

-

-

-

-

-

for i

in range(num_iter):

-

-

loss =

1/(

2*m) * np.sum((y-y_pred)**

2)

-

-

W = W + lr *

1/m * (y-y_pred).dot(X.T)

-

-

-

y1 = W[

0,

0] + W[

0,

1]*

1

-

y2 = W[

0,

0] + W[

0,

1]*

20

-

-

plt.plot([

1,

20],[y1,y2])

-

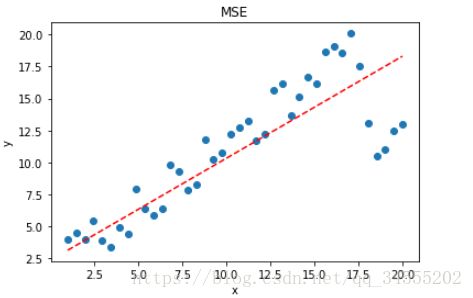

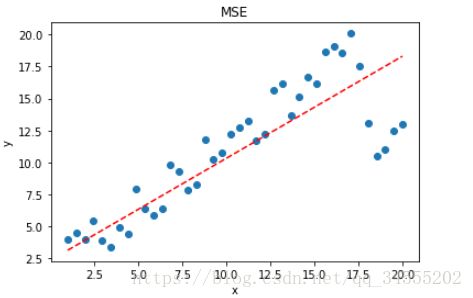

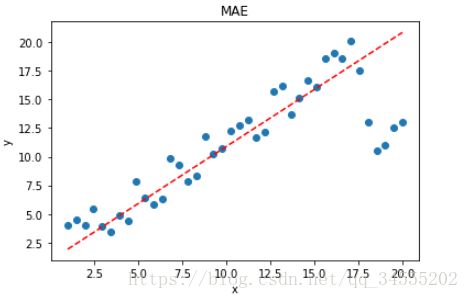

拟合结果如下图所示:

可见,使用 MSE 损失函数,受离群点的影响较大,虽然样本中只有 5 个离群点,但是拟合的直线还是比较偏向于离群点。这往往是我们不希望看到的。

2. 平均绝对误差(Mean Absolute Error,MAE)

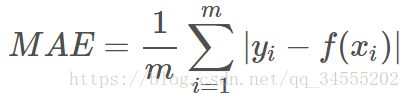

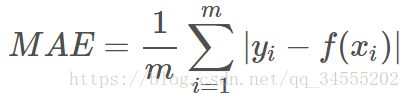

平均绝对误差指的就是模型预测值 f(x) 与样本真实值 y 之间距离的平均值。其公式如下所示:

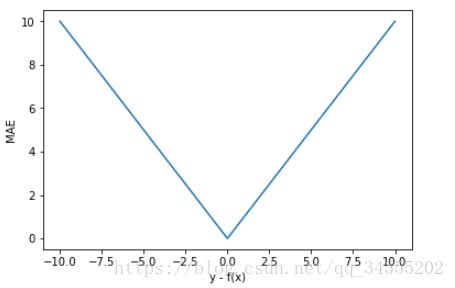

为了简化讨论,忽略下标 i,m = 1,以 y-f(x) 为横坐标,MAE 为纵坐标,绘制其损失函数的图形:

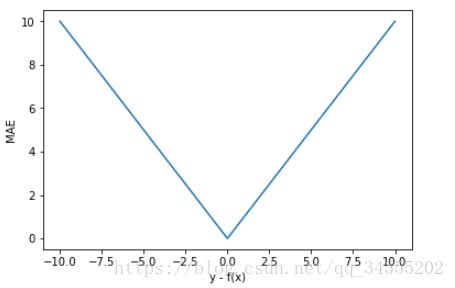

直观上来看,MAE 的曲线呈 V 字型,连续但在 y-f(x)=0 处不可导,计算机求解导数比较困难。而且 MAE 大部分情况下梯度都是相等的,这意味着即使对于小的损失值,其梯度也是大的。这不利于函数的收敛和模型的学习。

值得一提的是,MAE 相比 MSE 有个优点就是 MAE 对离群点不那么敏感,更有包容性。因为 MAE 计算的是误差 y-f(x) 的绝对值,无论是 y-f(x)>1 还是 y-f(x)<1,没有平方项的作用,惩罚力度都是一样的,所占权重一样。针对 MSE 中的例子,我们来使用 MAE 进行求解,看下拟合直线有什么不同。

-

X = np.vstack((np.ones_like(x),x))

# 引入常数项 1

-

-

-

-

-

-

-

-

-

for i in range(num_iter):

-

-

loss =

1/m * np.sum(np.abs(y-y_pred))

-

-

-

-

-

W = W + lr *

1/m * mask.dot(X.T)

-

-

-

y1 = W[

0,

0] + W[

0,

1]*

1

-

y2 = W[

0,

0] + W[

0,

1]*

20

-

-

plt.plot([

1,

20],[y1,y2],

'r--')

-

-

-

-

注意上述代码中对 MAE 计算梯度的部分。

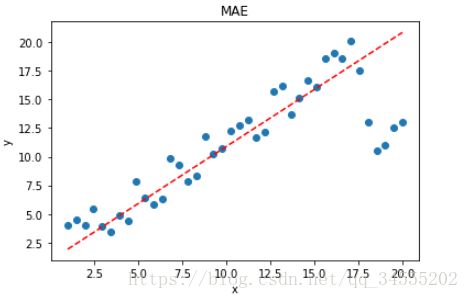

拟合结果如下图所示:

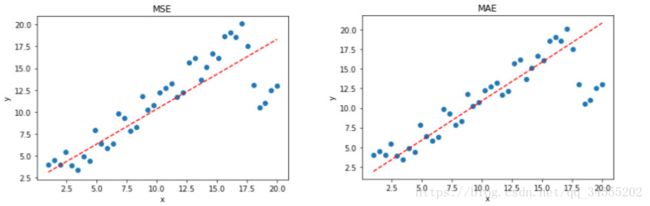

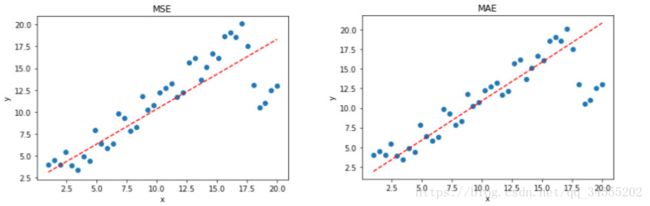

显然,使用 MAE 损失函数,受离群点的影响较小,拟合直线能够较好地表征正常数据的分布情况。这一点,MAE 要优于 MSE。二者的对比图如下:

选择 MSE 还是 MAE 呢?

实际应用中,我们应该选择 MSE 还是 MAE 呢?从计算机求解梯度的复杂度来说,MSE 要优于 MAE,而且梯度也是动态变化的,能较快准确达到收敛。但是从离群点角度来看,如果离群点是实际数据或重要数据,而且是应该被检测到的异常值,那么我们应该使用MSE。另一方面,离群点仅仅代表数据损坏或者错误采样,无须给予过多关注,那么我们应该选择MAE作为损失。

3. Huber Loss

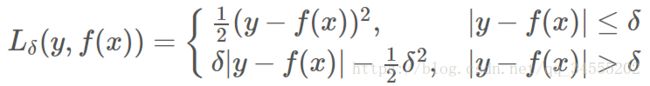

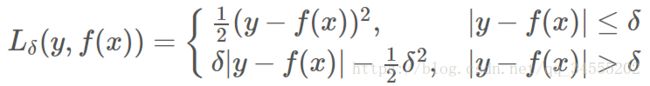

既然 MSE 和 MAE 各有优点和缺点,那么有没有一种激活函数能同时消除二者的缺点,集合二者的优点呢?答案是有的。Huber Loss 就具备这样的优点,其公式如下:

Huber Loss 是对二者的综合,包含了一个超参数 δ。δ 值的大小决定了 Huber Loss 对 MSE 和 MAE 的侧重性,当 |y−f(x)| ≤ δ 时,变为 MSE;当 |y−f(x)| > δ 时,则变成类似于 MAE,因此 Huber Loss 同时具备了 MSE 和 MAE 的优点,减小了对离群点的敏感度问题,实现了处处可导的功能。

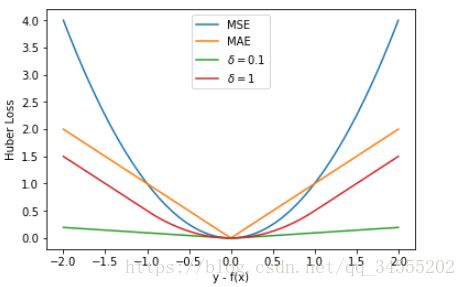

通常来说,超参数 δ 可以通过交叉验证选取最佳值。下面,分别取 δ = 0.1、δ = 10,绘制相应的 Huber Loss,如下图所示:

Huber Loss 在 |y−f(x)| > δ 时,梯度一直近似为 δ,能够保证模型以一个较快的速度更新参数。当 |y−f(x)| ≤ δ 时,梯度逐渐减小,能够保证模型更精确地得到全局最优值。因此,Huber Loss 同时具备了前两种损失函数的优点。

下面,我们用 Huber Loss 来解决同样的例子。

-

X = np.vstack((np.ones_like(x),x))

# 引入常数项 1

-

-

-

-

-

-

-

-

-

-

for i in range(num_iter):

-

-

loss =

1/m * np.sum(np.abs(y-y_pred))

-

-

-

mask[y-y_pred > delta] = delta

-

mask[mask < -delta] = -delta

-

W = W + lr *

1/m * mask.dot(X.T)

-

-

-

y1 = W[

0,

0] + W[

0,

1]*

1

-

y2 = W[

0,

0] + W[

0,

1]*

20

-

-

plt.plot([

1,

20],[y1,y2],

'r--')

-

-

-

-

注意上述代码中对 Huber Loss 计算梯度的部分。

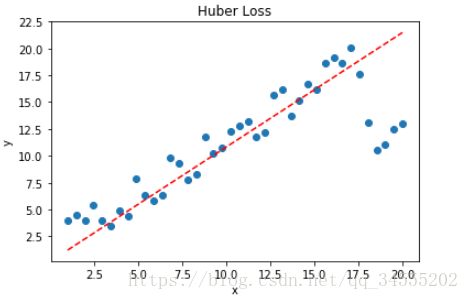

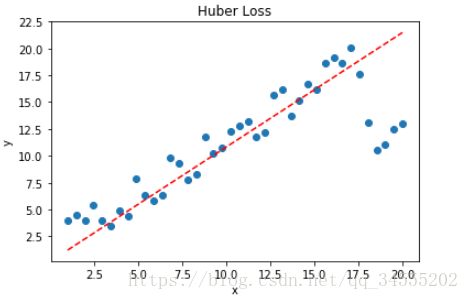

拟合结果如下图所示:

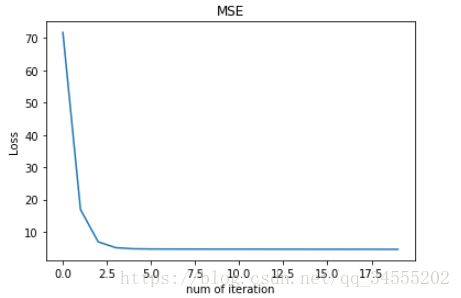

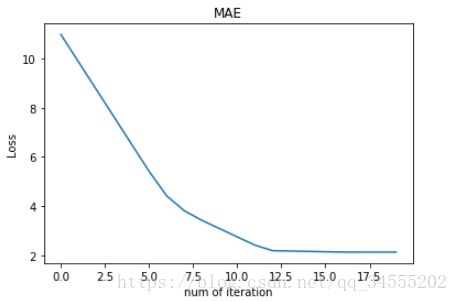

可见,使用 Huber Loss 作为激活函数,对离群点仍然有很好的抗干扰性,这一点比 MSE 强。另外,我们把这三种损失函数对应的 Loss 随着迭代次数变化的趋势绘制出来:

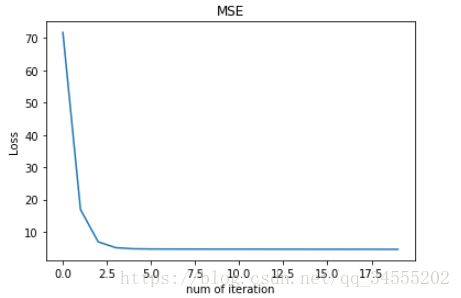

MSE:

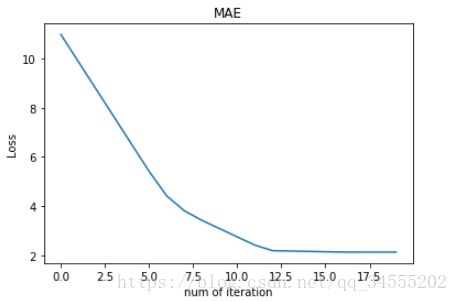

MAE:

Huber Loss:

对比发现,MSE 的 Loss 下降得最快,MAE 的 Loss 下降得最慢,Huber Loss 下降速度介于 MSE 和 MAE 之间。也就是说,Huber Loss 弥补了此例中 MAE 的 Loss 下降速度慢的问题,使得优化速度接近 MSE。

最后,我们把以上介绍的回归问题中的三种损失函数全部绘制在一张图上。

好了,以上就是红色石头对回归问题 3 种常用的损失函数包括:MSE、MAE、Huber Loss 的简单介绍和详细对比。这些简单的知识点你是否已经完全掌握了呢?

【数据应用技巧】选择合适的损失函数(回归篇)

案例来源:@AI科技评论案例地址:https://mp.weixin.qq.com/s/Gt8Q4Wm36DoNBO4xI8SJAw1.MSE(均方误差,L2)1)损失函数是预测与目标之间的误差平方和... 博文 来自: 数据产品笔记

logistic回归详解(二):损失函数(cost function)详解

有监督学习机器学习分为有监督学习,无监督学习,半监督学习,强化学习。对于逻辑回归来说,就是一种典型的有监督学习。既然是有监督学习,训练集自然可以用如下方式表述:{(x1,y1),(x2,y2),⋯,(... 博文 来自: bitcarmanlee的博客

如何选择合适的损失函数,请看......

翻译|张建军编辑|阿司匹林出品|AI科技大本营【AI科技大本营导读】机器学习中的所有算法都依赖于最小化或最大化某一个函数,我们称之为“目标函数”。最小化的这组...... 博文 来自: AI科技大本营

回归模型常见的损失函数

机器学习中的所有算法都依赖于最小化或最大化函数,我们将其称为“目标函数”。最小化的函数组称为“损失函数”。损失函数是衡量预测模型在能够预测预期结果方面的表现有多好的指标。寻找最小值的最常用方法是“梯度... 博文 来自: 陨星落云的博客

5个回归损失函数

大数据文摘出品编译:Apricock、睡不着的iris、JonyKai、钱天培“损失函数”是机器学习优化中至关重要的一部分。L1、L2损失函数相信大多数人都早已不陌生。那你了解Huber损失、Log-... 博文 来自: chduan_10的博客

线性回归和逻辑回归损失函数的区别

首先说什么是凸函数。对区间[a,b]上定义的函数f,若它对区间中任意两点x1和x2,均有f((x1+x2)/2)<=(f(x1)+f(x2))/2,则称f为区间[a,b]上的凸函数。对实... 博文 来自: 一路向北

如何选择 损失函数 Loss Function

欢迎使用Markdown编辑器写博客1.交叉熵CrossEntropy交叉熵与熵相对,如同协方差与方差熵考察的是单个的信息(分布)的期望:H(p)=−∑i=1np(xi)logp(xi)H(p)=-\... 博文 来自: zeng