数据集成领域的相关技术总结

这是大数据技术扫盲系列的第三篇【数据集成领域的相关技术总结】

全文1700字,阅读需要5分钟

《开源大数据热力报告》中,按照数据处理生命周期,将开源大数据技术分为数据集成、数据存储、批处理、流处理、数据查询与分析、数据可视化、数据调度与编排、数据开发与管理8个部分。

我们计划针对每一个部分,梳理下有哪些技术栈,先做一个概念化的整理,后续根据重要的、有发展潜力的技术做深入研究。

一、Airbyte:数据集成领域的新晋领导者

1、整体介绍:

Airbyte是一个开源的数据集成引擎,可以在几分钟内构建一个可靠的数据管道(支持捕获CDC数据),完成从数据源到数据目标端的集成同步,整合数据库、数据仓库、以及数据湖中的数据。

这家位于硅谷的公司,已经成为数据集成领域绝对的领导者,在2021年取得了惊人的成就,完成了3轮融资,总额1.81亿美元,公司估值15亿美元。目前从生态上看,AirByte10000+社区成员、25000+公司、每月600TB的同步,500+贡献者。

2、服务方式:

OpenSource:核心代码和连接器开源

Airbyte Cloud:Saas服务,可以选择在Airbyte托管VPC下部署,或者在自己的VPC下部署

Airbyte Enterprise:在Airbyte Cloud 的基础上,提供一些扩展服务,包括多因素认证、审计、培训和咨询服务等

3、主竞对比较:

Airbyte基于对ETL新的理解,聚焦在解决E、L阶段,转换的操作则交给dbt来实现。强大的开源生态让他支持了200+的连接器,并且按照产品开发计划仍在添加。

官网上给出了与主竞品包括Fivetran、Stitch、Airflow、Matillion、Singer、Meltano、Pipelinewise做出了比较,感兴趣的自己去搜吧。(Airfolw聚焦在工作流管理,和Airbyte不能算为一类)

和主要竞争对手Fivetran的对比,主要体现在以下几点:

Airbyte成立两年扩展了200+的连接器,核心代码是开源的,而Fivetran有大概150+的连接器,且封闭源代码的托管服务。基于Airbyte提供的开发指引,可以低代码化在30分钟内构建自己的连接器。AirByte可以与Kubernetes, Airflow, Prefect, Dagster and dbt做深度集成。

4、思考总结

这种开源商业化的模式,核心代码开源、辅助能力闭源、同时提供云服务的模式,在国外很流行,很多聚焦ToB的科技型公司都是这个套路,产品能成功无外乎两个大的逻辑:

-

产品真的解决用户的实际问题、且在细分领域有很深的沉淀,而非东一榔头西一棒子。

-

外部环境阻力较小,顺势而为。

很明显Airbyte全占了,尤其是后者,国外对云以及Saas服务的拥抱程度较高,愿意为服务买单。反观国内,大部分客户对云的使用是替换IDC服务器,聚焦在Iaas、以及Paas、而对上层的工具类Saas服务尝试较少。

二、dbt:重构数据开发范式

dbt聚焦在ELT中的Transform部分,dbt帮助数据团队像软件工程师一样工作,可以快速的完成数据的转换、处理。

SQL作为数据仓库的母语,dbt将用户代码编译为数仓可执行的SQL,大部分数据分析师只掌握SQL,需要依赖数据工程师完成数据转换,而dbt重构了这一流程。同时让数据团队工作不再割裂,覆盖开发、测试、文档和发布环节,让数据团队可以按照软件工程最佳实践快速协作地部署分析代码。

2021年dbt达成了很多成就,包括Slack用户超过25000,8个国家用用12个meetup团队,9000家员工使用dbt-core(开源)、付费企业1800家。

三、其他数据集成技术

1、Debezium:

Debezium是数据集成的开源分布式工具,可以捕获数据的实时变化,可实现数据的实时同步。通过实时监测数据库变更日志来捕获变更数据,形成数据流输出到下游,同类产品有Canal、DataBus、Maxwell等。

Debezium社区相对活跃。2022年11月刚发布了2.0稳定版。目前支持的连接器包括MongoDB、MySQL、PostgreSQL、SQL Server、Oracle、Db2

2、Seatunnel:

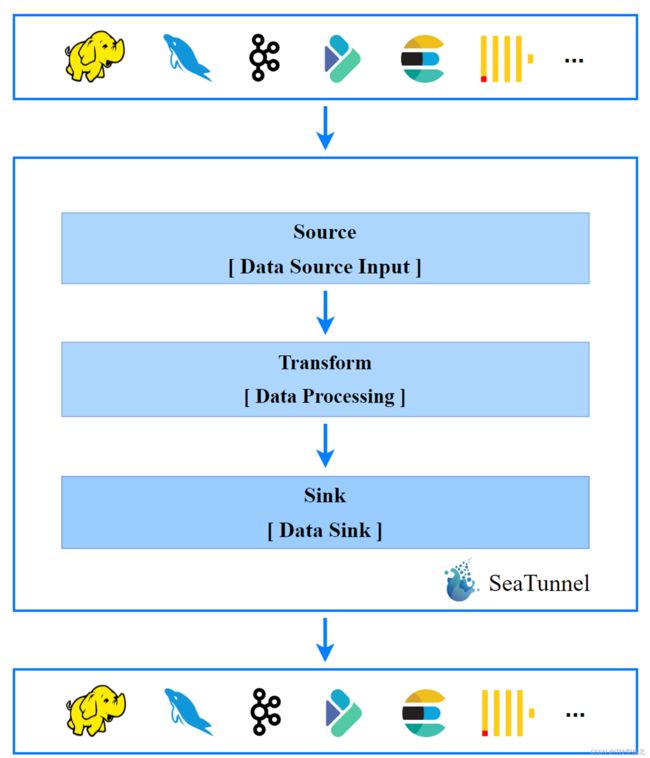

SeaTunnel 原名waterdrop,在21年10月更名为SeaTunnel,是一个支持实时和离线处理的数据集成工具,同时支持Spark和Flink,目前该项目在Apache孵化器之中。

3、InLong

原项目名叫TubeMQ,是腾讯捐献给Apache社区的项目,是一站式海量数据集成平台,服务于数据采集到落地的整个生命周期,主要模块包括:

inlong-agent(采集模块)、inlong-dataproxy(基于Flume-ng的Proxy组件,支持将接收到的数据分发到不同的MQ中)、inlong-sort(对不同MQ消费到的数据进行ETL,并写入sink端)、inlong-manager(数据服务管控能力)、inlong-audit(审计服务)、inlong-dashboard(管控平台的前端模块)

4、FlinkCDC、Chunjun、Datax、Canal、Maxwell

参考https://mp.weixin.qq.com/s?__biz=Mzg4ODc0Njc0NQ==&mid=2247483986&idx=1&sn=b6d62b5217851a629d347e5235da8957&chksm=cff725c4f880acd2c063e2057beb9759cd82f773f9bb9f2b09bd072d8f967f37b9de0f9d0f1b#rd

后续会在公众号中更新关于现代技术栈的总结、思考。