- 自拍上瘾综合症

天秤座的心思

昨天听到新闻里说起了最近流行的自拍上瘾综合症,感觉实在是稀奇。一位服装设计师迷上了自拍镜头下的自己,干脆按照自拍相片里的自己,做了缩鼻,大眼,尖下巴等一系列的整容手术。因为过于迷恋自拍照片里的自己,想要把自己现实生活中的容貌通过医学美容整成和自拍照片里一一模一样,这样的情况已经演变成了一种叫做"自拍上瘾综合症"的心理问题。其实对于一些话题明星来说,整容充其量就是她们/他们人在江湖,身不由己,混“场

- 去做,才有结果!

哺乳指导王梅

美丽老师说:先完成,再完美。给了我很大的启发,其实很多事情,只有做了才有结果。不去迈开第一步,永远都不知道结果怎么样。这周原创7篇朋友圈小文案,购买清大师,成功分销2人购买次卡,第二遍阅读爆款文案,陪儿子看一场电影。图片发自App对于原创文案,一直感觉是道坎,因为文字功底不够好,缺少逻辑性。自从参加了美丽老师21天蜕变,坚持原创,同时又参加了燕飞老师的80分文案,改变了这种想法,没有人天生什么都会

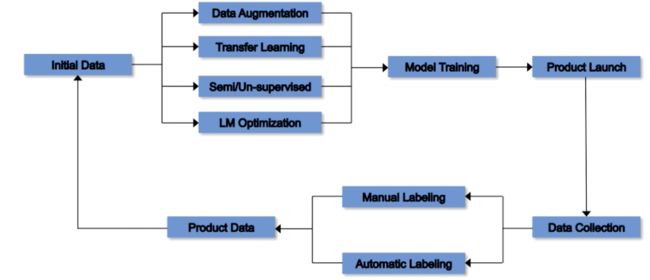

- 消弭大模型幻觉

灰图06

人工智能

这几天,一则关于国产大模型DeepSeek使用率暴跌的传闻引发热议。据称,其用户使用率从54%骤降至3%,主要原因直指一个词:“幻觉”。或许这个数据并未被官方证实,但这场风波却准确地揭开了一个愈发严重的隐忧:我们正在与一类能力极强、却时常“胡说八道”的系统共处。而一旦这种“胡说八道”发生在医疗、法律、金融等关键领域,它所引发的,不是笑话,而是灾难。人们惊觉:这不仅是DeepSeek的危机,也是一场

- 打车

美丽色彩

晚上回家太晚干脆打滴滴车回去。手机显示司机离自己距离1公里远。心想太远了不能马上到,不由得有点气馁。不到一分钟,司机打来电话客套地说稍等正在赶来。心里想,司机也是想快点过来。滴滴车还没来,公交车已经来了。考虑要不要取消滴滴车,改乘公交车,还便宜。心中想着滴滴车司机已赶来,大冷天出来拉活不容易。于是打消取消滴滴车的念头,继续等。一会司机赶来了,上车司机说了不好意思来晚了。其实也算是正常赶到,但是司机

- 这几句话,道尽中国五千年的气度

琴棋书画APP

沧桑数千年,自古至于今,无数圣人先贤、名士豪杰,留下诸多豪言精语和肺腑之言,尤其是这10句话,最能代表中国精神,也是中国人的精神命脉所在。中国气概:人若犯我明犯强汉者,虽远必诛!——《汉书·陈汤传》汉朝强盛之时,“犯强汉者,虽远必诛”的确是被践行的事实。虽远必诛的前提是被犯,属于自卫反击。所以,汉武帝的多数征伐还是师出有名。国力强盛,则是底气。不过,当国家间尚存利益、理念的纠纷,人类还不尽是谦谦君

- 每日一联(7.15)数载风云皆入酒

乔平_

每日一联(7.15)出句:数载风云皆入酒对句:1.千重景色尽浮花(梦梓)2.三年断柳尽成吟(钦建军)3.半生往事尽如烟(王凤捷)4.千秋烟雨付东流(海纳)5.一场梦境枕黄粱(常醒公)6.几行韵律自成诗(雪歌)7.三苏盛誉冠文坛(烛焰松)8.如今涕泪总衔杯(王占君)9.一朝水月映于池(水灵)10.三生岁月尽成诗(綦宗平)11.一帘花月俱成诗(户向发)12.半生功过自从天(乔平)13.半生翰墨既缘情

- 今天有感

0cbcd4301ce0

昏暗的天空笼罩着整个城市,狂风肆虐着整个大地,路上的行人不时用手挡住狂风的吹袭,迅速的跑回家去。因为大地上即将迎来一场大雨,没过多久大雨倾盆而下,哗啦啦,哗啦啦大雨冲洗着整个城市,似乎让疲惫不堪的城市洗个澡重新容颜焕发出新的生命力。人们也许在雨来临的时候,就会停住工作的步伐才会安静下来,听听雨落在地面上,落在屋檐上,玻璃上,树叶上……,甚至听听雨落到心里处来自己灵魂深处的声音。整个世界是忙碌的,整

- 【旅行故事】人际关系@稀土永磁Amy@20220723@上海

稀土永磁Amy

德鲁克谈正确的人际关系:良好的组织精神真正的考验不在于大家能否“和睦相处”;是绩效,而不是一致。“良好的人际关系”如果不是根植于良好的工作绩效所带来的满足感与和谐合理的工作关系,那么其实只是脆弱的人际关系。互相沟通、团队合作、自我发展、培养他人。人和人之间的关系是一场双向奔赴。致敬遇见的那些人和那些事~

- 2018,再见!

二十札记

图片发自App2018年我20岁这一年平凡且精彩走过了两个城市旅行长发剪成短发经历分离与新的开始成为副部,拿到奖学金用所学能力挣钱买口红最重要的是坚持用手账记录2018的点点滴滴n个第一次第一次体验剧组生活第一次和院长,台长同桌吃饭第一次跟朋友出去旅行to青岛第一次去游乐场第一次和妹妹逛街去方特第一次从120斤瘦到112斤第一次独自一人坐了9个小时的火车及返程夜车第一次跟弟弟旅行to南京第一次建立

- 怀念与倾诉

浪尖水花

怀念与倾诉一张白纸上的诗行,被十月的等待打湿北部湾的流萤飞越头顶,星星点点的是你带来的消息么?渐离渐远的秋声,是你远离的脚步么?打开前世今生的行囊,想象你现在如今的样子酝酿了千年的激情,横亘于季节的末梢有醉人的暖风拂过,一粒种子带着南方的体温,蛰伏于心灵的深处沿着诱惑的筑成的栈道随心所欲地爆裂不知道谁的琴弦在今夜拨响婉音在泪水濡湿的梦里演绎着世纪的童话我仿佛听到远寺的钟声你归去的诗章从一个守望到另

- 【说文】读李益《同崔邠登鹳雀楼》

诗酒寒秋

图片发自App鹳雀楼西百尺墙,汀洲云树共茫茫。汉家箫鼓随流水,魏国山河半夕阳。事去千年犹恨速,愁来一日即知长。风烟并在思归处,远目非春亦自伤。《同崔邠登鹳雀楼》,是中唐诗人李益写的一首七律。崔邠,唐代诗人,李益的朋友。这首诗的前四句写登楼观景并抒发历史与现实的感慨;后四句由河山美景而联想到人生苦短,满是惆怅。即景抒情,历史沉思,现实感慨,个人感伤,都融入这56个字,意境浑成厚重,难怪为历代传诵。李

- 中原焦点团队网中29期林丽梅分享第149天。约练第26场。2021.12.26

淡月疏梅

约练分享:第一场(观)注意到咨询师在确认了目标之后,所用的目标好奇问句也是需要循序渐进的。如果直接去问当事人怎么解决问题会有走的过快又拉又拽的感觉。还是从第一问“如果可能的话,你希望有什么改变?”问起,接着第二问“是什么让你希望有这些改变?”第三问“这些改变如果实现了与现在相比会有哪些不同?”第四问“这个改变具体包括那些方面?”第二场(观)咨询师能准确辩识出当事人情绪的点也很重要,因为在这些点上多

- 练笔◎一杯茶的时间

兰子说

谢谢你,赠我天地精华。渐渐的,让时间慢下来,在一杯茶的时间里雀跃,在淡淡的茶香萦绕中豁然开朗。图片发自App喝一杯茶,写一幅字,看一场雨,读一本书,时间也很美。图片发自App茶是霸气的,是不顾一切的,是天地赠阅的安静。茶香袅袅,超然于世,在山水之间找茶,一定懂得茶的骄傲,茶的妥帖,茶的担待,它是对时间和生活的敬畏和体贴,是你自己的体己。守一杯茶,二三知己相依,与寸寸时光缠绕,人生已足够丰盈。一生愿

- 2018-08-01

洪苙婕2009

【0801今日分享】劳动不重要,有效劳动最重要。几种可操作的方式和观念,提升有效性:001明确需求职场也要,生意场也好,上司或者客户的需求,是最重要的。明确需求,是第一要务。正如上述例子,年轻伙计正是因为能明白老板的需求,洞悉店里需求,才能一次性把全部工作做到位。002以终为始一个项目,最终要做成什么样子?周期多长?工作如何拆分?进度如何掌控?以终为始,就是站在终点,安排从开始到结束的一系列工作。

- 培训心得

常奇芳

常奇芳听了叶显发教授的讲座,我内心澎湃,感触良多,受益匪浅!其中让我印象最深刻的就是目前存在的两种教学方法:一种是照本宣科抑郁式的教学,另一种是剑走偏峰表演式的教学!绝大多数老师采用的都是第一种教学方法,此方法闷骚,刻板,生硬,枯燥乏味,致使教学效果大打折扣!以后的教学生涯中,我要积极有效地尝试第二种教学方法,和学生全方位地互动交流,营造自由宽松的教学环境,呈现给学生一场场新颖,有趣,刺激的视觉,

- 文心4.5开源背后的战略棋局:百度为何选择All in开放?

度假的小鱼

AI/大数据创作活动打卡#人工智能基础文心大模型开源GitCode百度

文章目录引言:一场颠覆AI行业格局的孤注国内开源模型的崛起与威胁国际竞争格局的重塑1.技术维度:开源是突破模型性能瓶颈的“加速器”1.1闭源模型的“内卷化”困境1.2文心4.5的开源技术架构:从“黑箱”到“乐高”1.2.1文心4.5的技术创新1.2.2工具链的成熟配套2.商业维度:开源是重构AI市场规则的“核武器”2.1闭源时代的“赢家通吃”逻辑2.2文心4.5的开源商业模型:从“卖API”到“卖

- 2021-11-03 射频消融

快乐的老猫

昨晚做了射频消融术,一切顺利。五点钟进手术室,尹晓盟主任主刀,一个半小时的手术过程一直处清醒的状态。同室的病友说他痛的几乎没坚持下来,我觉得还是可以耐受。相对于以前的治病经历,对猫来说,昨晚顶多就是场小雨。在病床上静卧一夜,今天上午开始下床活动,中午就办理了离院手续。回家的路上,走进一间名为浅草的日料店,准备大吃一顿补补这些日子的亏空,再来一杯扎啤庆祝一下。家人掏出出院医嘱给我看,三个月内以清淡饮

- 别具一格的早春雨景

龙潭1132宋淑萍

图片发自App今天是高端晨读第6课,经过了一场小雪的洗礼,阳光似乎更加明媚,空气如此清新,带着美好的心境来晨读,真是一种享受。让我们跟着张雪梅老师一起走进今天的课程。一,精美的诗配画,匠心独具的思维导图让孩子们耳目一新,大饱眼福。课前展示了吉林龙潭金珠学校孩子们的诗配画,制作精美,可见孩子们有多么用心啊!更让孩子们感到新奇的是思维导图,简直是羡慕极了,既能说明孩子们的巧手描绘,又能说明助学老师教导

- 《恶之花》阮软周司寒小说免费阅读【恶之花TXT】完整版

九月文楼

《恶之花》阮软周司寒小说免费阅读【恶之花TXT】完整版主角:阮软周司寒简介:乔烟害死了我姐姐,于是我准备了一场复仇,也要让她尝一尝痛失所爱的滋味,我将目光放在了乔烟深爱的男人周司寒身上。可以关注微信公众号【放心文楼】去回个书号【2】,即可免费阅读【恶之花】小说全文!第2章乔烟来了!我真的好激动,但是我黑白分明的小鹿眸里盛满了惊慌,两只小手推着周司寒的手臂,“太太来了,先生你把手拿出来……”周司寒这

- 沙拉

颜娘娘的碎碎念

图片发自App今天分享的关键词是:沙拉。一段时间喜欢吃沙拉。那时青春,吃饭都嫌多余。还有一颗娇情的心与莫名其妙的想法。向往杂志女主角一样的生活。主要是因为喜欢甜,喜欢色彩明丽的视觉。更早也是因为偶遇了一套景致到了极点的玻璃餐具。开始时端着透明的盘子,搅着里面小块的水果,只觉终于可以离烟火远一些,离琐碎烦心之事远一点。静坐在阳台,想着心事,吃着心爱的甜品-----偷得片刻过上杂志女主角一样的生活。红

- 晚叶

春三月

红的如霞,黄的若金晚叶轻挥别袖飘坠没有三月春花娇艳绚烂中却尽是成熟之美曾历风雨,又衔露霜春来不惊,秋去从容立于生命之巅告别,没有一丝遗憾翩然,舞出最后心声大地,请与我热情相拥愿在你怀中沉睡酝一场来年美丽的梦图片发自App

- 一体化雨量监测站:感知每一滴雨

柏峰电子

人工智能

一体化雨量监测站:感知每一滴雨的“气象哨兵”柏峰【BF-YL】在气象监测的庞大网络中,有一种设备默默守护着我们与雨水之间的“平衡”——它能精准捕捉每一场雨的强度、时长,为防汛抗旱、农业生产、城市管理提供关键数据。这就是一体化雨量监测站,一个集“感知、传输、分析”于一体的智慧设备,堪称感知雨水的“气象哨兵”。一、构造解析:小巧机身里的“全能系统”与传统分散式雨量监测设备不同,一体化雨量监测站最大的特

- 风雨人生,自己撑伞

昊然说

人生如逆旅,时常经风雨。如果你胆怯,没人替你勇敢;如果你软弱,没人替你坚强。路漫漫其修远兮,路总要一个人走,谁也不能永远伴你左右。喜怒哀乐,自斟自饮,悲欢离合,冷暖自知。既然选择了远方,便为自己撑起一把伞,只顾风雨兼程。古人说:天行健,君子以自强不息。人生在世,总有风雨,求人是一种依赖,可以依赖一时,却无法依赖一世。靠山,山会倒;靠人,人会跑。最靠谱的,唯有自强不息的自己。居士在屋檐下避雨,禅师撑

- 夕霞

云淡忘了汉长安斗城楼阁台原民

云淡的夕阳一场通透的雨水将古城洗去昨日的暴热,24小时前还是42度的高温,现在却可以让我写意地行走。这个夏天在西安我真得不会玩了,也不去探寻天公得随意,忍住和享受都是随机的。本不愿意出来的,就是因为看到窗边的夕照,莫辜负了天公的倦顾,期遇一种美丽的邂逅。看来我的选择是对的,抬手西照将美遇定格,感觉到夕霞的诱惑。庆幸我遇到这种景遇,小区门前奔忙的人啊,谁也没有抬头去看,各自行进着、匆匆中,甚至让我产

- 2023-10-26

栈道村

在守正创新中赓续历史文脉据人民网报导,“心相约,梦闪耀”。10月22日晚,第四届亚洲残疾人运动会开幕式在浙江杭州奥体中心体育场隆重举行。用“金桂花冠”向每一名运动员传递“逐梦折桂、舍我其谁”的美好寓意,以“金石篆刻”的艺术化表现诠释残疾运动员“精诚所至,金石为开”的拼搏精神,运动员入场时不同季节、不同风格的西湖十景借助地屏和网幕惊艶亮相……杭州亚残运会开幕式上,充满东方美学的艺术构思,传递诗情画意

- 【天地诗心】七律·少年游

诗枭李二浪

铭《少年游》柴门溪曲白云渡,沙上蹄痕鸟作诗。正爱蜻蜓伏野树,又摸蝌蚪放清池。霞光晚照湿衣处,月色初深起灶时。美丽流星如雨落,从前年少不曾知。(中华新韵十三支)我年少时无忧无虑,爱在家乡溪水边玩乐,玩到很晚才回家吃饭。我常常觉得,那些逝去的彩色的时光,根本就是我一厢情愿的梦。可事实是我的的确确经历了。我曾机缘之下看过一场美丽的流星雨。那时没有特别在意,以为只要到了晚上都会有。后来发现,人生太多事物需

- 我们的生活在变好?还是变坏?

土衣铀

昨天与儿子说笑间,谈起儿时家乡的一条小河,谈到儿时满天的繁星,等等吧。儿子满脸的羡慕。村庄有条河,从村头流到下边的村庄,儿时水非常清澈,村里人洗衣服,夏天小孩子洗澡水刚刚好,不深不浅,有时捉不少的鱼儿。冬天就成了溜冰场,陀螺场。可是现在由于山上开矿,河里几乎没水,到处是垃圾。小时侯电视里披星戴月的美景,晚上抬头可见,可是在城里长大的儿子觉得那只是电视里的景象。有一次回家,半夜才到,叫醒睡眼朦胧的儿

- 别穿高跟鞋了!“大衣+这11双鞋”正流行,时髦又显高,好看极了!

clgh

大衣向来是冬天的主场!它兼具温度与风度、能包容所有身材、且不拘泥于某种单一的风格。穿上大衣,不但能提升你的品味,整个人的气场和气质都发生了变化,更加自信了。不过,大衣想要穿出时髦精致感,关键在于选对鞋子!说到鞋子,可千万别以为只有高跟鞋才可以hold住大衣的超强气场。“大衣+这4双鞋”的混搭造型,照样能碰撞出惊艳的时尚火花,打造出舒适又有个性的easychic,即便是小个子女生也能完美驾驭。1、大

- 晨间日记(202208120406)

锋听慧言曼语

起床:5:20就寝:23:30天气:晴心情:开心一、任务清单(一)昨日完成的任务,最重要的三件事1.完成早起群班委会的召开;2.完成直播1场,讲团体思维;3.完成;(二)未完成事情及原因(三)计划外事(四)习惯养成:做一个长期主义者1.早起第717天2.坚持晨跑472天。3.坚持亲子绘本伴读1651天;4.坚持写晨间日记407天。5.坚持每天阅读至少1小时227(阅读超过1小时)天:6.家庭读书会

- 有一分钱花一分钱,也是很有面子的事情

爱听故事的依米

有人说世界上最痛苦的事情莫过于你爱的人结婚了,对象却不是你!要我说,最痛苦的事情就是兜里的钱支撑不起心中花钱的欲望。饿死事小,面子事大。现在的人花钱好像陷入了一个误区,感觉好像是钱花的越多,就越有面子。在我们老家判断一场婚礼气不气派,除了结婚前说好的嫁妆彩礼,房车之外,还包括婚礼现场的布置,酒席上用的酒水香烟纸巾,甚至连多少人数都包含在内了,反正用的越好,去参加婚礼的人数越多,你就越有面子。年前的

- SQL的各种连接查询

xieke90

UNION ALLUNION外连接内连接JOIN

一、内连接

概念:内连接就是使用比较运算符根据每个表共有的列的值匹配两个表中的行。

内连接(join 或者inner join )

SQL语法:

select * fron

- java编程思想--复用类

百合不是茶

java继承代理组合final类

复用类看着标题都不知道是什么,再加上java编程思想翻译的比价难懂,所以知道现在才看这本软件界的奇书

一:组合语法:就是将对象的引用放到新类中即可

代码:

package com.wj.reuse;

/**

*

* @author Administrator 组

- [开源与生态系统]国产CPU的生态系统

comsci

cpu

计算机要从娃娃抓起...而孩子最喜欢玩游戏....

要让国产CPU在国内市场形成自己的生态系统和产业链,国家和企业就不能够忘记游戏这个非常关键的环节....

投入一些资金和资源,人力和政策,让游

- JVM内存区域划分Eden Space、Survivor Space、Tenured Gen,Perm Gen解释

商人shang

jvm内存

jvm区域总体分两类,heap区和非heap区。heap区又分:Eden Space(伊甸园)、Survivor Space(幸存者区)、Tenured Gen(老年代-养老区)。 非heap区又分:Code Cache(代码缓存区)、Perm Gen(永久代)、Jvm Stack(java虚拟机栈)、Local Method Statck(本地方法栈)。

HotSpot虚拟机GC算法采用分代收

- 页面上调用 QQ

oloz

qq

<A href="tencent://message/?uin=707321921&Site=有事Q我&Menu=yes">

<img style="border:0px;" src=http://wpa.qq.com/pa?p=1:707321921:1></a>

- 一些问题

文强chu

问题

1.eclipse 导出 doc 出现“The Javadoc command does not exist.” javadoc command 选择 jdk/bin/javadoc.exe 2.tomcate 配置 web 项目 .....

SQL:3.mysql * 必须得放前面 否则 select&nbs

- 生活没有安全感

小桔子

生活孤独安全感

圈子好小,身边朋友没几个,交心的更是少之又少。在深圳,除了男朋友,没几个亲密的人。不知不觉男朋友成了唯一的依靠,毫不夸张的说,业余生活的全部。现在感情好,也很幸福的。但是说不准难免人心会变嘛,不发生什么大家都乐融融,发生什么很难处理。我想说如果不幸被分手(无论原因如何),生活难免变化很大,在深圳,我没交心的朋友。明

- php 基础语法

aichenglong

php 基本语法

1 .1 php变量必须以$开头

<?php

$a=” b”;

echo

?>

1 .2 php基本数据库类型 Integer float/double Boolean string

1 .3 复合数据类型 数组array和对象 object

1 .4 特殊数据类型 null 资源类型(resource) $co

- mybatis tools 配置详解

AILIKES

mybatis

MyBatis Generator中文文档

MyBatis Generator中文文档地址:

http://generator.sturgeon.mopaas.com/

该中文文档由于尽可能和原文内容一致,所以有些地方如果不熟悉,看中文版的文档的也会有一定的障碍,所以本章根据该中文文档以及实际应用,使用通俗的语言来讲解详细的配置。

本文使用Markdown进行编辑,但是博客显示效

- 继承与多态的探讨

百合不是茶

JAVA面向对象 继承 对象

继承 extends 多态

继承是面向对象最经常使用的特征之一:继承语法是通过继承发、基类的域和方法 //继承就是从现有的类中生成一个新的类,这个新类拥有现有类的所有extends是使用继承的关键字:

在A类中定义属性和方法;

class A{

//定义属性

int age;

//定义方法

public void go

- JS的undefined与null的实例

bijian1013

JavaScriptJavaScript

<form name="theform" id="theform">

</form>

<script language="javascript">

var a

alert(typeof(b)); //这里提示undefined

if(theform.datas

- TDD实践(一)

bijian1013

java敏捷TDD

一.TDD概述

TDD:测试驱动开发,它的基本思想就是在开发功能代码之前,先编写测试代码。也就是说在明确要开发某个功能后,首先思考如何对这个功能进行测试,并完成测试代码的编写,然后编写相关的代码满足这些测试用例。然后循环进行添加其他功能,直到完全部功能的开发。

- [Maven学习笔记十]Maven Profile与资源文件过滤器

bit1129

maven

什么是Maven Profile

Maven Profile的含义是针对编译打包环境和编译打包目的配置定制,可以在不同的环境上选择相应的配置,例如DB信息,可以根据是为开发环境编译打包,还是为生产环境编译打包,动态的选择正确的DB配置信息

Profile的激活机制

1.Profile可以手工激活,比如在Intellij Idea的Maven Project视图中可以选择一个P

- 【Hive八】Hive用户自定义生成表函数(UDTF)

bit1129

hive

1. 什么是UDTF

UDTF,是User Defined Table-Generating Functions,一眼看上去,貌似是用户自定义生成表函数,这个生成表不应该理解为生成了一个HQL Table, 貌似更应该理解为生成了类似关系表的二维行数据集

2. 如何实现UDTF

继承org.apache.hadoop.hive.ql.udf.generic

- tfs restful api 加auth 2.0认计

ronin47

目前思考如何给tfs的ngx-tfs api增加安全性。有如下两点:

一是基于客户端的ip设置。这个比较容易实现。

二是基于OAuth2.0认证,这个需要lua,实现起来相对于一来说,有些难度。

现在重点介绍第二种方法实现思路。

前言:我们使用Nginx的Lua中间件建立了OAuth2认证和授权层。如果你也有此打算,阅读下面的文档,实现自动化并获得收益。SeatGe

- jdk环境变量配置

byalias

javajdk

进行java开发,首先要安装jdk,安装了jdk后还要进行环境变量配置:

1、下载jdk(http://java.sun.com/javase/downloads/index.jsp),我下载的版本是:jdk-7u79-windows-x64.exe

2、安装jdk-7u79-windows-x64.exe

3、配置环境变量:右击"计算机"-->&quo

- 《代码大全》表驱动法-Table Driven Approach-2

bylijinnan

java

package com.ljn.base;

import java.io.BufferedReader;

import java.io.FileInputStream;

import java.io.InputStreamReader;

import java.util.ArrayList;

import java.util.Collections;

import java.uti

- SQL 数值四舍五入 小数点后保留2位

chicony

四舍五入

1.round() 函数是四舍五入用,第一个参数是我们要被操作的数据,第二个参数是设置我们四舍五入之后小数点后显示几位。

2.numeric 函数的2个参数,第一个表示数据长度,第二个参数表示小数点后位数。

例如:

select cast(round(12.5,2) as numeric(5,2))

- c++运算符重载

CrazyMizzz

C++

一、加+,减-,乘*,除/ 的运算符重载

Rational operator*(const Rational &x) const{

return Rational(x.a * this->a);

}

在这里只写乘法的,加减除的写法类似

二、<<输出,>>输入的运算符重载

&nb

- hive DDL语法汇总

daizj

hive修改列DDL修改表

hive DDL语法汇总

1、对表重命名

hive> ALTER TABLE table_name RENAME TO new_table_name;

2、修改表备注

hive> ALTER TABLE table_name SET TBLPROPERTIES ('comment' = new_comm

- jbox使用说明

dcj3sjt126com

Web

参考网址:http://www.kudystudio.com/jbox/jbox-demo.html jBox v2.3 beta [

点击下载]

技术交流QQGroup:172543951 100521167

[2011-11-11] jBox v2.3 正式版

- [调整&修复] IE6下有iframe或页面有active、applet控件

- UISegmentedControl 开发笔记

dcj3sjt126com

// typedef NS_ENUM(NSInteger, UISegmentedControlStyle) {

// UISegmentedControlStylePlain, // large plain

&

- Slick生成表映射文件

ekian

scala

Scala添加SLICK进行数据库操作,需在sbt文件上添加slick-codegen包

"com.typesafe.slick" %% "slick-codegen" % slickVersion

因为我是连接SQL Server数据库,还需添加slick-extensions,jtds包

"com.typesa

- ES-TEST

gengzg

test

package com.MarkNum;

import java.io.IOException;

import java.util.Date;

import java.util.HashMap;

import java.util.Map;

import javax.servlet.ServletException;

import javax.servlet.annotation

- 为何外键不再推荐使用

hugh.wang

mysqlDB

表的关联,是一种逻辑关系,并不需要进行物理上的“硬关联”,而且你所期望的关联,其实只是其数据上存在一定的联系而已,而这种联系实际上是在设计之初就定义好的固有逻辑。

在业务代码中实现的时候,只要按照设计之初的这种固有关联逻辑来处理数据即可,并不需要在数据库层面进行“硬关联”,因为在数据库层面通过使用外键的方式进行“硬关联”,会带来很多额外的资源消耗来进行一致性和完整性校验,即使很多时候我们并不

- 领域驱动设计

julyflame

VODAO设计模式DTOpo

概念:

VO(View Object):视图对象,用于展示层,它的作用是把某个指定页面(或组件)的所有数据封装起来。

DTO(Data Transfer Object):数据传输对象,这个概念来源于J2EE的设计模式,原来的目的是为了EJB的分布式应用提供粗粒度的数据实体,以减少分布式调用的次数,从而提高分布式调用的性能和降低网络负载,但在这里,我泛指用于展示层与服务层之间的数据传输对

- 单例设计模式

hm4123660

javaSingleton单例设计模式懒汉式饿汉式

单例模式是一种常用的软件设计模式。在它的核心结构中只包含一个被称为单例类的特殊类。通过单例模式可以保证系统中一个类只有一个实例而且该实例易于外界访问,从而方便对实例个数的控制并节约系统源。如果希望在系统中某个类的对象只能存在一个,单例模式是最好的解决方案。

&nb

- logback

zhb8015

loglogback

一、logback的介绍

Logback是由log4j创始人设计的又一个开源日志组件。logback当前分成三个模块:logback-core,logback- classic和logback-access。logback-core是其它两个模块的基础模块。logback-classic是log4j的一个 改良版本。此外logback-class

- 整合Kafka到Spark Streaming——代码示例和挑战

Stark_Summer

sparkstormzookeeperPARALLELISMprocessing

作者Michael G. Noll是瑞士的一位工程师和研究员,效力于Verisign,是Verisign实验室的大规模数据分析基础设施(基础Hadoop)的技术主管。本文,Michael详细的演示了如何将Kafka整合到Spark Streaming中。 期间, Michael还提到了将Kafka整合到 Spark Streaming中的一些现状,非常值得阅读,虽然有一些信息在Spark 1.2版

- spring-master-slave-commondao

王新春

DAOspringdataSourceslavemaster

互联网的web项目,都有个特点:请求的并发量高,其中请求最耗时的db操作,又是系统优化的重中之重。

为此,往往搭建 db的 一主多从库的 数据库架构。作为web的DAO层,要保证针对主库进行写操作,对多个从库进行读操作。当然在一些请求中,为了避免主从复制的延迟导致的数据不一致性,部分的读操作也要到主库上。(这种需求一般通过业务垂直分开,比如下单业务的代码所部署的机器,读去应该也要从主库读取数