2020-1-25 深度学习笔记3 - 概率与信息论

第三章 概率与信息论

官网

概率论使我们能够提出不确定的声明以及在不确定性存在的情况下进行推理

信息论使我们能够量化概率分布中的不确定性总量

在人工智能领域,概率论主要有两种用途

- 概率法则告诉我们AI系统如何推理,据此我们设计一些算法来计算或者估算由概率论导出的表达式

- 可以用概率和统计从理论上分析我们提出的AI系统的行为

为什么要使用概率

这是因为机器学习通常必须处理不确定量,有时也可能需要处理随机(非确定性的)量。

几乎所有活动都需要一些在不确定性存在的情况下进行推理的能力

不确定性有3种可能的来源

- 被建模系统内在的随机性。例如一个假想的纸牌游戏,在这个游戏中,我们假设纸牌被真正混洗成了随机顺序。

- 不完全观测。例如,在Monty Hall问题中,一个游戏节目的参与者被要求在3个门之间选择,并且会赢得放置在选中门后的奖品。其中两扇门通向山羊,第3扇门通向一辆汽车。选手的每个选择所导致的结果是确定的,但是站在选手的角度,结果是不确定的。

- 不完全建模。例如,假设我们制作了一个机器人,它可以准确地观察周围每一个对象的位置。在对这些对象将来的位置进行预测时,如果机器人采用的是离散化的空间,那么离散化的方法将使得机器人无法确定对象们的精确位置:因为每个对象都可能处于它被观测到的离散单元的任何一个角落。

概率论最初的发展是为了分析事件发生的频率。我们可以很容易地看出概率论。这类事件往往是可以重复的。这种直接与事件发生频率相联系的概率,被称为频率派概率(frequentist probability );

对于不可重复的命题,例如:一个医生诊断了病人,并说该病人患流感的概率为40%,这意味着非常不同的事情——我们既不能让病人有无穷多的副本,也没有任何理由去相信病人的不同副本在具有不同的潜在条件下表现出相同的症状。

在这个例子中,我们用概率来表示一种信任度(degree of belief),其中1表示非常肯定病人患有流感,而0表示非常肯定病人没有患流感。

这种涉及确定性水平的概率,被称为贝叶斯概率(Bay esian probability )。

关于不确定性的常识推理,如果我们已经列出了若干条期望它具有的性质,那么满足这些性质的唯一一种方法就是将贝叶斯概率和频率派概率视为等同的。

概率论提供了一套形式化的规则,可以在给定一些命题的似然后,计算其他命题为真的似然。

随机变量

- 随机变量(random variable)是可以随机地取不同值的变量。我们通常用无格式字体(plain ty peface)中的小写字母来表示随机变量本身,而用手写体中的小写字母来表示随机变量能够取到的值。

- 一个随机变量只是对可能的状态的描述。它必须伴随着一个概率分布来指定每个状态的可能性。

- 随机变量可以是离散的或者连续的

- 离散随机变量拥有有限或者可数无限多的状态,这些状态不一定非要是整数,它们也可能只是一些被命名的状态而没有数值。

- 连续随机变量伴随着实数值。

概率分布

概率分布(probability distribution)用来描述随机变量或一组随机变量在每一个可能取到的状态的可能性大小。我们描述概率分布的方式取决于随机变量是离散的还是连续的。

对离散随机变量用求和得全概率,对连续随机变量用积分得全概率

【离散型变量和概率质量函数】

离散型变量的概率分布可以用概率质量函数(probability mass function,PMF)(1)来描述。通常用大写字母P来表示概率质量函数。

- 通常每一个随机变量都会有一个不同的概率质量函数,读者必须根据随机变量来推断所使用的PMF,而不是根据函数的名称来推断。例如,P(x)通常和P(y )不一样。

- PMF将随机变量能够取得的每个状态映射到随机变量取得该状态的

概率 - 随机变量x=x的概率用P(x)来表示,概率为1表示x=x是确定的,概率为0表示x=x是不可能发生的。

- 为了使得PMF的使用不相互混淆,我们会明确写出随机变量的名称:P(x=x)。

- 有时我们会先定义一个随机变量,然后用∼符号来说明它遵循的分布:x∼P(x)

概率质量函数可以同时作用于多个随机变量。这种多个变量的概率分布被称为联合概率分布(joint probability distribution)。

- P(x=x,y =y )表示x=x和y =y 同时发生的概率。我们也可以简写为P(x,y )。

一个函数P是随机变量x的PMF,必须满足下面这几个条件:

- P的定义域必须是x所有可能状态的集合。

- ∀ x ∈ \forall x \in ∀x∈x, 0 ≤ P ( x ) ≤ 1 0\leq P(x) \leq1 0≤P(x)≤1。

- x x x表示随机变量,x表示随机变量能够取到的值。

- 不可能发生的事件概率为0,并且不存在比这概率更低的状态。

- 能够确保一定发生的事件概率为1,而且不存在比这概率更高的状态。

- ∑x∈XP(x)=1。我们把这条性质称之为

归一化的(normalized)。如果没有这条性质,当我们计算很多事件其中之一发生的概率时可能会得到大于1的概率。

例:离散型变量的PMF

一个离散型随机变量x有k个不同的状态。我们可以假设x是均匀分布(uniform distribution)的(也就是将它的每个状态视为等可能的),它的PMF为 P(x= x i x_i xi)= 1 k \frac{1}{k} k1,对于所有的i都成立。

因为k是一个正整数,所以 1 k \frac{1}{k} k1也是正的。我们也可以看出 ∑ i P ( × = x i ) = ∑ i 1 k = k k = 1 \sum_{i} P( \times =x_i)=\sum_{i}\frac{1}{k}=\frac{k}{k}=1 i∑P(×=xi)=i∑k1=kk=1

显然满足归一化条件。所以P是随机变量x的PMF。

【连续型变量和概率密度函数】

当我们研究的对象是连续型随机变量时,我们用概率密度函数(probability density function, PDF)而不是概率质量函数来描述它的概率分布。

一个函数p是概率密度函数PDF,必须满足下面这几个条件:

- p的定义域必须是x所有可能状态的集合。这个与PMF相同。

- x∈X,p(x)≥0。注意:我们并不要求p(x)≤1。

- ∫p(x)dx=1

概率密度函数p(x)并没有直接对特定的状态给出概率,相对的,它给出了落在面积为δx的无限小的区域内的概率为p(x) δx。

我们可以对PDF求积分来获得点集的真实概率质量。特别地,x落在集合S中的概率可以通过p(x)对这个集合求积分来得到。在单变量的例子中,x落在区间[a, b]的概率是∫[a,b]p(x)dx

例:连续型随机变量的PDF

实数区间上的均匀分布的函数u(x;a,b)

- x作为函数的自变量

- a和b作为定义函数的参数

- 其中a和b是区间的端点且满足b>a。

- 符号“;”表示“以什么为参数”

为了确保区间外没有概率,我们对所有的 x ∉ [ a , b ] x\notin [a,b] x∈/[a,b],令u(x;a,b)=0

在[a,b]内,有 u ( x ; a , b ) = 1 b − a u(x;a,b)=\frac{1}{b-a} u(x;a,b)=b−a1。

可以看出,任何一点都非负。另外,它的积分为1。我们通常用x∼U(a,b)表示x在[a,b]上是均匀分布的。

边缘概率

联合概率:表示两个事件共同发生的概率。A与B的联合概率表示为P(A∩B)或者P(A,B)或者P(AB)。

有时,我们知道了一组变量的联合概率分布,但想要了解其中一个子集的概率分布。这种定义在子集上的概率分布被称为边缘概率分布(marginal probability distribution)。

边缘概率:是某个事件发生的概率。边缘概率是这样得到的:在联合概率中,把最终结果中不需要的那些事件合并成其事件的全概率而消失(对离散随机变量用求和得全概率,对连续随机变量用积分得全概率),这称为边缘化(marginalization)。A的边缘概率表示为P(A),B的边缘概率表示为P(B)。需要注意的是,在这些定义中A与B之间不一定有因果或者时间顺序关系。A可能会先于B发生,也可能相反,也可能二者同时发生。A可能会导致B的发生,也可能相反,也可能二者之间根本就没有因果关系。

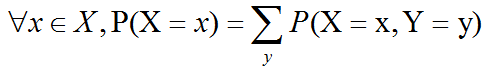

- 离散型变量

例:假设有离散型随机变量x和y,并且我们知道P(x,y )。可以依据下面的求和法则(sum rule)来计算P(x):

边缘概率 的名称来源于手算边缘概率的计算过程。当P(x,y )的每个值被写在由每行表示不同的x值、每列表示不同的y 值形成的网格中时,对网格中的每行求和是很自然的事情,然后将求和的结果P(x)写在每行右边的纸的边缘处。

- 连续型变量

连续型变量,我们需要用积分替代求和:p(x)=∫p(x,y)dy

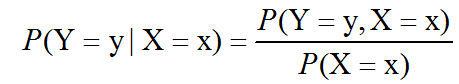

条件概率

在很多情况下,我们感兴趣的是某个事件在给定其他事件发生时出现的概率。这种概率叫作条件概率(conditional probability)。

我们将给定X=x,Y=y发生的条件概率记为P(Y=y |X=x)。这个条件概率可以通过下面的公式计算:

显然,条件概率只在P(x=x)>0时有定义。我们不能计算给定在永远不会发生的事件上的条件概率。

【补充】

条件概率:就是事件Y在另外一个事件X已经发生条件下的发生概率。条件概率表示为P(Y|X),读作”在X条件下Y的概率”。P(Y|X)=P(Y∩X)/P(X)。条件概率有时候也称为后验概率

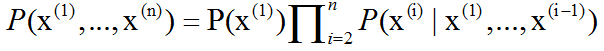

- 条件概率的链式法则

任何多维随机变量的 联合概率 分布,都可以分解成只有一个变量的 条件概率 相乘的形式

这个规则被称为概率的链式法则(chain rule)或者乘法法则(product rule)。它可以直接从条件概率的定义公式中得到。

例:使用两次定义

因为P(a,b,c)=P(a|b,c)P(b,c),P(b,c)=P(b|c)P(c)

所以P(a,b,c)=P(a|b,c)P(b|c)P(c)

独立性和条件独立性

两个随机变量x和y,如果它们的概率分布可以表示成两个因子的乘积形式,并且一个因子只包含x,另一个因子只包含y ,我们就称这两个随机变量是相互独立的(independent)

![]()

如果关于x和y的条件概率分布对于z的每一个值都可以写成乘积的形式,那么这两个随机变量x和y 在给定随机变量z时是条件独立的(conditionally independent)

![]() 我们可以采用一种简化形式来表示独立性和条件独立性:

我们可以采用一种简化形式来表示独立性和条件独立性:x⊥y 表示x和y相互独立,x⊥y|z表示x和y在给定z时条件独立。

期望、方差和协方差

- 期望反映随机变量平均取值的大小

- 方差反映了随机变量离其期望值的距离(离散程度)

- 协方差用于衡量两个变量的总体误差

在概率论和统计学中,数学期望(mean)(或均值,亦简称期望)是试验中每次可能结果的概率乘以其结果的总和,是最基本的数学特征之一。它反映随机变量平均取值的大小。

函数f(x)关于某分布P(x)的期望(expectation)或者期望值(expected value)是指,当x由P产生,f作用于x时,f(x)的平均值。

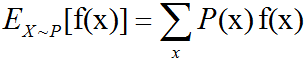

- 对于离散型随机变量,期望可以通过

求和得到

- 对于连续型随机变量可以通过

求积分得到

说明:

1.当概率分布在上下文中指明时,我们可以只写出期望作用的随机变量的名称来进行简化。例如:Ex[f(x)]

2.如果期望作用的随机变量也很明确,我们可以完全不写脚标。例如:E[f(x)]

3.默认地,我们假设E[·]表示对方括号内的所有随机变量的值求平均。类似地,当没有歧义时,我们还可以省略方括号。

【期望值性质】

1.期望是线性的。期望值E是线性函数:E[aX+bY]=aE[X]+bE[Y],X和Y为在同一概率空间的两个随机变量(可以独立或者非独立),a和b为任意实数。

2.一般的说,一个随机变量的函数的期望值并不等于这个随机变量的期望值的函数。

3.在一般情况下,两个随机变量的积的期望值不等于两个随机变量的期望值的积。特殊情况是当这两个随机变量是相互独立的时候E[XY] = E[X]E[Y] (也就是说一个随机变量的输出不会影响另一个随机变量的输出)。

方差(Variance),在概率论和统计学中,一个随机变量的方差描述的是它的离散程度,也就是该变量离其期望值的距离。方差越大,说明随机变量取值越离散。

方差(variance)衡量的是当我们对x依据它的概率分布进行采样时,随机变量x的函数

值会呈现多大的差异 V a r ( f ( x ) ) = E [ ( f ( x ) − E [ f ( x ) ] ) 2 ] Var(f(x))=E[(f(x)-E[f(x)])^2] Var(f(x))=E[(f(x)−E[f(x)])2]

当方差很小时,f(x)的值形成的簇比较接近它们的期望值。

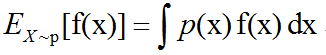

例如:射箭时,一个优秀的选手能保持自己的弓箭集中于目标点附近,而一个经验不足的选手,他弓箭的落点会更容易散落许多地方。

上面的靶上有两套落点。尽管两套落点的平均中心位置都在原点 (即期望相同),但两套落点的离散程度明显有区别。显然蓝色的点离散程度更小(即方差小)。

上面的靶上有两套落点。尽管两套落点的平均中心位置都在原点 (即期望相同),但两套落点的离散程度明显有区别。显然蓝色的点离散程度更小(即方差小)。

方差的平方根被称为标准差(standard deviation)。

我们常用σ表示标准差 σ = V a r ( X ) σ=\sqrt {Var(X)} σ=Var(X)。

标准差也表示分布的离散程度,在概率统计中最常使用作为测量一组数值的离散程度之用。

简单来说,标准差是一组数值自平均值分散开来的程度的一种测量观念。一个较大的标准差,代表大部分的数值和其平均值之间差异较大;一个较小的标准差,代表这些数值较接近平均值。

协方差(Covariance)在概率论和统计学中用于衡量两个变量的总体误差。而方差是协方差的一种特殊情况,即当两个变量是相同的情况。

协方差表示的是两个变量的总体的误差,这与只表示一个变量误差的方差不同。

如果两个变量的变化趋势一致,也就是说如果其中一个大于自身的期望值,另外一个也大于自身的期望值,那么两个变量之间的协方差就是正值。

如果两个变量的变化趋势相反,即其中一个大于自身的期望值,另外一个却小于自身的期望值,那么两个变量之间的协方差就是负值。

协方差(covariance)在某种意义上给出了两个变量线性相关性的强度以及这些变量的尺度

![]()

协方差的绝对值如果很大,则意味着变量值变化很大,并且它们同时距离各自的均值很远。

如果协方差是正的,那么两个变量都倾向于同时取得相对较大的值。

如果协方差是负的,那么其中一个变量倾向于取得相对较大的值的同时,另一个变量倾向于取得相对较小的值,反之亦然。

协方差和相关性是有联系的,但实际上是不同的概念。如果两个变量相互独立,那么它们的协方差为零;如果两个变量的协方差不为零,那么它们一定是相关的。

独立性又是和协方差完全不同的性质。两个变量如果协方差为零,它们之间一定没有线性关系。独立性是比零协方差的要求更强,因为独立性还排除了非线性的关系。

两个变量相互依赖,但是具有零协方差是可能的。

例如,假设我们首先从区间[−1,1]上的均匀分布中采样出一个实数x,然后对一个随机变量s进行采样。s以 1 2 \frac{1}{2} 21的概率值为1,否则为−1。我们可以通过令y =sx来生成一个随机变量y 。显然,x和y 不是相互独立的,因为x完全决定了y的尺度。然而,Cov(x,y )=0。

随机向量 x ∈ R n x \in R^n x∈Rn的协方差矩阵(covariance matrix)是一个n×n的矩阵,并且满足 C o v ( x ) i , j = C o v ( x i , x j ) Cov(x)_{i,j}=Cov(x_i,x_j) Cov(x)i,j=Cov(xi,xj)

协方差矩阵的对角元是方差 C o v ( x i , x i ) = V a r ( x i ) Cov(x_i,x_i)=Var(x_i) Cov(xi,xi)=Var(xi)

常用概率分布

许多简单的概率分布在机器学习的众多领域中都是有用的

【1.伯努利Bernoulli分布-两点分布-离散型随机变量概率分布】

在现实生活中,许多事件的结果往往只有两个。

例如:抛硬币,正面朝上的结果只有两个:国徽或面值;检查某个产品的质量,其结果只有两个:合格或不合格;购买彩票,开奖后,这张彩票的结果只有两个:中奖或没中奖。。。以上这些事件都可被称为伯努利Bernoulli试验。

伯努利试验是单次随机试验,只有"成功(值为1)"或"失败(值为0)"这两种结果,是由瑞士科学家雅各布·伯努利(1654 - 1705)提出来的。

其概率分布称为伯努利分布(Bernoulli distribution),也称为两点分布或者0-1分布,是最简单的离散型概率分布。我们记成功概率为p(0≤p≤1),则失败概率为q=1-p,则

- 其概率质量函数PMF为

P ( x ) = p x ( 1 − p ) 1 − x = { p if x =1 q if x =0 P(x)=p^x(1-p)^{1-x}= \begin{cases} p & \text{if $x$=1} \\ q & \text{if $x$=0} \end{cases} P(x)=px(1−p)1−x={pqif x=1if x=0 - 其期望值为

E ( x ) = ∑ x P ( x ) = 0 × q + 1 × p = p E(x)=\sum xP(x)=0\times q + 1\times p=p E(x)=∑xP(x)=0×q+1×p=p - 其方差为

V a r ( x ) = E [ ( x − E ( x ) ) 2 ] = ∑ ( x − p ) 2 P ( x ) = p q Var(x)=E[(x-E(x))^2]= \sum (x-p)^2P(x) =pq Var(x)=E[(x−E(x))2]=∑(x−p)2P(x)=pq

Bernoulli分布是单个二值随机变量的分布。 它由单个参数 ϕ ∈ [ 0 , 1 ] \phi \in [0, 1] ϕ∈[0,1]控制, ϕ \phi ϕ给出了随机变量等于1的概率。 它具有如下的一些性质:

- P(x=1)=ϕ

- P(x=0)=1−ϕ

- P(x=x)=ϕx(1−ϕ)1−x

- Ex[x]=ϕ

- Varx(x)=ϕ(1−ϕ)

【2.Multinoulli分布-多项分布-离散型随机变量概率分布】

Multinoulli分布(multinoulli distribution)或者范畴分布(categorical distribution)是指在具有k个不同状态的单个离散型随机变量上的分布,其中k是一个有限值。

Multinoulli分布经常用来表示对象分类的分布,所以我们很少假设状态1具有数值1之类的。 因此,我们通常不需要去计算Multinoulli分布的随机变量的期望和方差。

Bernoulli 分布和 Multinoulli 分布足够用来描述在它们领域内的任意分布。它们能够描述这些分布,不是因为它们特别强大,而是因为它们的领域很简单;它们可以对那些,能够将所有的状态进行枚举的离散型随机变量进行建模。当处理的是连续型随机变量时,会有不可数无限多的状态,所以任何通过少量参数描述的概率分布都必须在分布上加以严格的限制。

【3.高斯分布-正态分布-连续型随机变量概率分布】

实数上最常用的分布就是正态分布(normal distribution),也称“常态分布”,又名高斯分布(Gaussian distribution)。最早由A.棣莫弗在求二项分布的渐近公式中得到。C.F.高斯在研究测量误差时从另一个角度导出了它。P.S.拉普拉斯和高斯研究了它的性质。是一个在数学、物理及工程等领域都非常重要的概率分布,在统计学的许多方面有着重大的影响力。

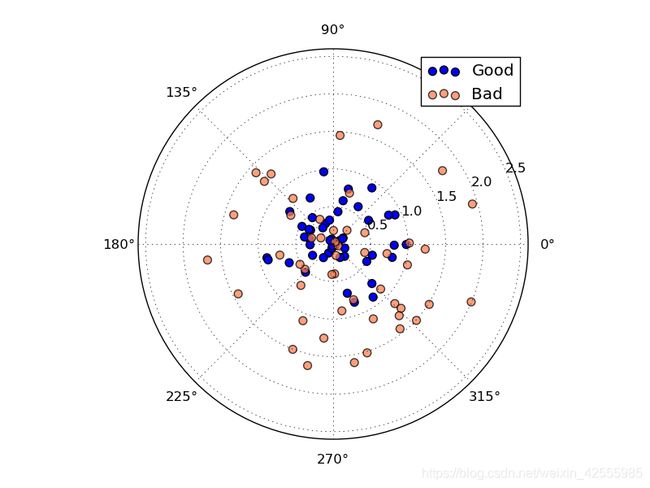

若随机变量X服从一个数学期望为μ、方差为σ2的正态分布,记为N(μ,σ2)。其概率密度函数PDF为正态分布的期望值μ决定了其位置,其标准差σ决定了分布的幅度。

N ( x ; μ , σ 2 ) = 1 2 π σ 2 e x p ( − 1 2 σ 2 ( x − μ ) 2 ) N(x;μ,σ^2)=\sqrt{\frac1{2πσ^2}}exp(−\frac1{2σ^2}(x−μ)^2) N(x;μ,σ2)=2πσ21exp(−2σ21(x−μ)2)符号“;”表示“以什么为参数”

上图是正态分布的概率密度函数N(x;μ,σ2),曲线呈钟型,两头低,中间高,左右对称因其曲线呈钟形,因此人们又经常称之为钟形曲线。

图中中心峰的x坐标由μ给出,峰的宽度受σ控制。在这个示例中,我们展示的是标准正态分布

(standard normal distribution),其中μ=0,σ=1。

正态分布由两个参数控制, μ ∈ R \mu \in R μ∈R 和 σ ∈ ( 0 , ∞ ) \sigma \in (0, \infty) σ∈(0,∞)。

参数μ给出了中心峰值的坐标,这也是分布的均值: E [ E[ E[x ] = μ ] = \mu ]=μ。

分布的标准差用σ表示,方差用σ2表示。

当我们要对概率密度函数求值时,需要对σ平方并且取倒数。

当我们需要经常对不同参数下的概率密度函数求值时,一种更高效的参数化分布的方式是使用参数β∈(0,∞)来控制分布的精度(precision)(或方差的倒数)

N ( x ; μ , β − 1 ) = β 2 π e x p ( − 1 2 β ( x − μ ) 2 ) N(x;μ,β^{−1})=\sqrt{\frac {β}{2π}}exp(−\frac 12β(x−μ)^2) N(x;μ,β−1)=2πβexp(−21β(x−μ)2)

采用正态分布在很多应用中都是一个明智的选择。当我们由于缺乏关于某个实数上分布的先验知识而不知道该选择怎样的形式时,正态分布是默认的比较好的选择,其中有两个原因:

- 我们想要建模的很多分布的真实情况是比较接近正态分布的。

中心极限定理(central limit theorem)说明很多独立随机变量的和近似服从正态分布。这意味着在实际中,很多复杂系统都可以被成功地建模成正态分布的噪声,即使系统可以被分解成一些更结构化的部分。

与高斯分布相关的一个重要定理是

中心极限定理,它的内容为:任何分布的抽样分布当样本足够大时,其渐进分布都是高斯分布。

- 在具有相同方差的所有可能的概率分布中,正态分布在实数上具有最大的不确定性。因此,我们可以认为正态分布是对模型加入的先验知识量最少的分布。

正态分布可以推广到空间,这种情况下被称为多维正态分布(multivariate normal dis-tribution)。

它的参数是一个正定对称矩阵Σ

N ( x ; μ , Σ ) = 1 ( 2 π ) n d e t ( Σ ) e x p ( − 1 2 ( x − μ ) ⊤ Σ − 1 ( x − μ ) ) . N(x;μ,Σ)=\sqrt{\frac {1}{(2π)^ndet(Σ)}}exp(−\frac12(x−μ)^⊤Σ^{−1}(x−μ)). N(x;μ,Σ)=(2π)ndet(Σ)1exp(−21(x−μ)⊤Σ−1(x−μ)).

参数μ仍然表示分布的均值,只不过现在是向量值。参数Σ给出了分布的协方差矩阵

和单变量的情况类似,当我们希望对很多不同参数下的概率密度函数多次求值时,协方差矩阵并不是一个很高效的参数化分布的方式,因为对概率密度函数求值时需要对Σ求逆。我们可以使用一个精度矩阵(precision matrix)β进行替代

N ( x ; μ , β − 1 ) = d e t ( β ) ( 2 π ) n e x p ( − 1 2 ( x − μ ) ⊤ β ( x − μ ) ) N(x;μ,β^{−1})=\sqrt{\frac {det(β)}{(2π)^n}}exp(−\frac12(x−μ)^⊤β(x−μ)) N(x;μ,β−1)=(2π)ndet(β)exp(−21(x−μ)⊤β(x−μ))

我们常常把协方差矩阵固定成一个对角阵。

一个更简单的版本是各向同性(isotropic)高斯分布,它的协方差矩阵是一个标量乘以单位阵。

【高斯分布-补充】

自然科学和社会科学中有极其大量的过程天然遵循高斯分布。即使当它们并不遵循高斯分布的时候,高斯分布也往往提供最佳的逼近。

例如:

- 成人的身高、血压、智商

- 扩散中的微粒位置

- 测量误差

机器学习中很多分布都采用高斯分布的原因是:

1.计算性质好

2.在已知均值和方差的情况下高斯分布的熵是所有分布中最大的,数据分布未知时通常选择熵最大的模型

3.现实中的很多随机变量是由大量相互独立的随机因素的综合影响所形成的,而其中每一个别因素在总的影响中所起的作用都是微小的,这种随机变量往往近似服从高斯分布(中心极限定理的客观背景)

4.对于未知的总体分布,在样本量足够大的情况下,并且知道样本均值和样本方差,可以近似服从高斯分布。

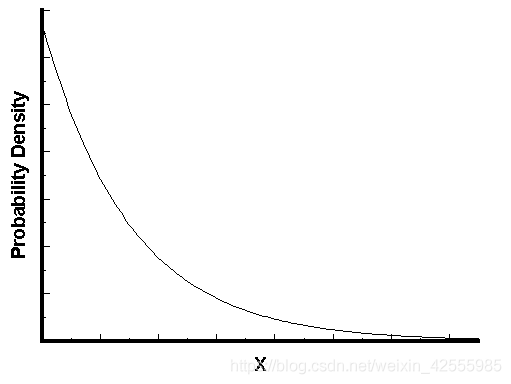

【4.指数分布和拉普拉斯Laplace分布-连续型随机变量概率分布】

指数分布:在概率论和统计学中,指数分布(Exponential distribution)是一种连续概率分布。指数分布可以用来表示独立随机事件发生的时间间隔,比如旅客进入机场的时间间隔、打进客服中心电话的时间间隔、中文维基百科新条目出现的时间间隔等等。

下面这些都属于指数分布

- 婴儿出生的时间间隔

- 来电的时间间隔

- 奶粉销售的时间间隔

- 网站访问的时间间隔

在深度学习中,我们经常会需要一个在x=0点处取得边界点(sharp point)的分布。 为了实现这一目的,我们可以使用指数分布

p ( x ; λ ) = λ l x ≥ 0 e x p ( − λ x ) p(x;λ)=λl_{x≥0}exp(−λx) p(x;λ)=λlx≥0exp(−λx)λ 表示事件的频率

指数分布使用指示函数(indicator function) lx≥0来使得当x取负值时的概率为零。

例:如果下一个婴儿要间隔时间 t ,就等同于 t 之内没有任何婴儿出生

p ( x > t ) = p ( N ( t ) = 0 ) = ( λ t ) 0 e x p ( − λ t ) 0 ! p(x>t)=p(N(t)=0)=\frac {(λt)^0exp(−λt)}{0!} p(x>t)=p(N(t)=0)=0!(λt)0exp(−λt)

p表示概率,N表示某种函数关系,t 表示时间,n 表示数量。1小时内出生3个婴儿的概率,就表示为 P(N(1) = 3) 。λ 表示事件的频率,这里λ =3。

反过来,事件在时间 t 之内发生的概率,就是1减去上面的值。

p ( x ≤ t ) = 1 − p ( x > t ) = 1 − e x p − λ t p(x \leq t)=1 - p(x>t) =1 - exp^{−λt} p(x≤t)=1−p(x>t)=1−exp−λt

由此可以知道接下来15分钟,会有婴儿出生的概率是52.76%

p ( x ≤ 0.25 ) = 1 − e x p − 3 ∗ 0.25 ≈ 52.76 % p(x \leq 0.25)=1 - exp^{−3*0.25} \approx 52.76\% p(x≤0.25)=1−exp−3∗0.25≈52.76%

接下来的15分钟到30分钟,会有婴儿出生的概率是24.92%。

p ( 0.25 ≤ x ≤ 0.5 ) = p ( x ≤ 0.5 ) − p ( x ≤ 0.25 ) = ( 1 − e x p − 3 ∗ 0.5 ) − ( 1 − e x p − 3 ∗ 0.25 ) = e − 0.75 − e − 1.5 ≈ 24.92 % p( 0.25 \leq x \leq 0.5)=p(x \leq 0.5) - p(x \leq 0.25)=(1 - exp^{−3*0.5})-(1 - exp^{−3*0.25})=e^{-0.75}-e^{-1.5} \approx 24.92\% p(0.25≤x≤0.5)=p(x≤0.5)−p(x≤0.25)=(1−exp−3∗0.5)−(1−exp−3∗0.25)=e−0.75−e−1.5≈24.92%

指数分布的图形大概是上面的样子

可以看到,随着间隔时间变长,事件的发生概率急剧下降,呈指数式衰减。想一想,如果每小时平均出生3个婴儿,上面已经算过了,下一个婴儿间隔2小时才出生的概率是0.25%,那么间隔3小时、间隔4小时的概率,是不是更接近于0?

注意:指数分布是独立事件的时间间隔的概率分布,也就是说它的前提是,事件之间不能有关联,否则就不能运用上面的公式。

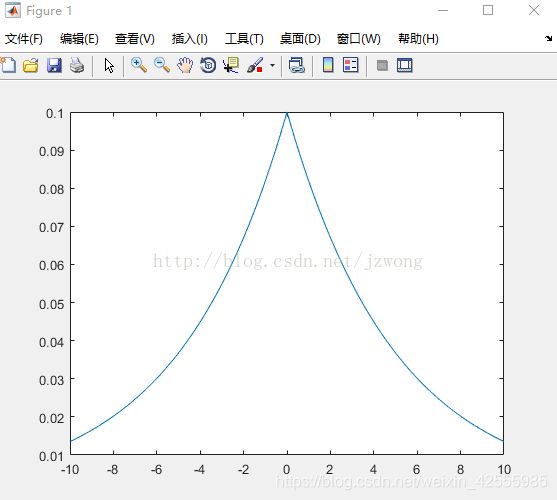

拉普拉斯分布:在概率论与统计学中,拉普拉斯分布是以皮埃尔-西蒙·拉普拉斯的名字命名的一种连续概率分布。由于它可以看作是两个不同位置的指数分布背靠背拼接在一起,所以它也叫做

双指数分布。两个相互独立同概率分布指数随机变量之间的差别是按照指数分布的随机时间布朗运动,所以它遵循拉普拉斯分布。

一个联系紧密的概率分布是Laplace分布(Laplace distribution),它允许我们在任意一点μ处设置概率质量的峰值

L a p l a c e ( x ; μ , γ ) = 1 2 γ e x p ( − ∣ x − μ ∣ γ ) Laplace(x;μ,γ)=\frac {1}{2γ}exp(−\frac {|x−μ|}γ) Laplace(x;μ,γ)=2γ1exp(−γ∣x−μ∣)

μ 是偏移量,γ是尺度参数,若当 μ=0 ,正半部分刚好是尺度为 1 γ \frac1γ γ1 的指数分布的一半 。

拉普拉斯分布图显示如下

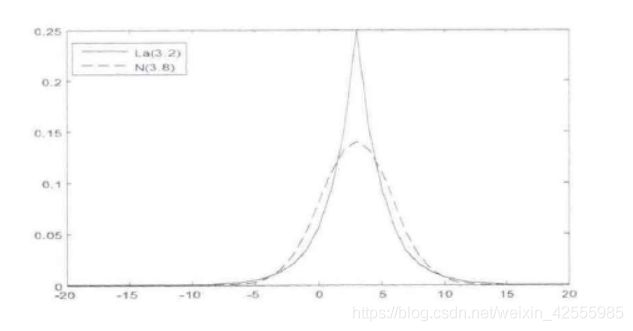

拉普拉斯分布的概率密度函数让我们联想到正态分布,但是,正态分布是用相对于μ平均值的差的平方来表示,而拉普拉斯概率密度函数用相对于平均值的差的绝对值来表示。因此,拉普拉斯分布的尾部比正态分布更加平坦。

拉普拉斯分布与正太分布的比较如下图

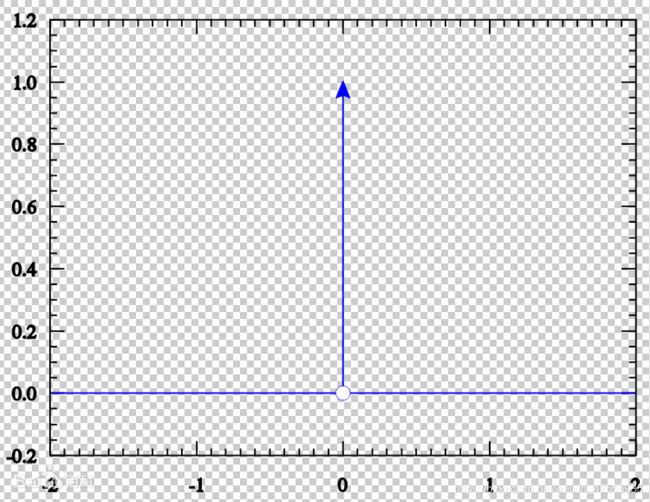

【5.狄拉克δ(Dirac)分布和经验分布-连续型随机变量概率分布】

在一些情况下,我们希望概率分布中的所有质量都集中在一个点上。 这可以通过狄拉克δ Dirac delta函数 δ ( x ) \delta(x) δ(x)定义概率密度函数来实现:

p ( x ) = δ ( x − μ ) p(x)=δ(x−μ) p(x)=δ(x−μ)

Dirac delta函数被定义成在除了0以外的所有点的值都为0,但是积分为1。

Dirac delta函数不像普通函数一样对x的每一个值都有一个实数值的输出,它是一种不同类型的数学对象,被称为广义函数(generalized function),在物理学中常用其表示质点、点电荷等理想模型的密度分布。广义函数是依据积分性质定义的数学对象。 我们可以把 Dirac delta 函数想成一系列函数的极限点,这一系列函数把除0以外的所有点的概率密度越变越小。

通过把P(x)定义成δ函数左移−μ个单位,我们得到了一个在x=μ处具有无限窄也无限高的

峰值的概率质量。

从纯数学的观点来看,狄拉克δ函数并非严格意义上的函数,因为任何在扩展实数线上定义的函数,如果在一个点以外的地方都等于零,其总积分必须为零。

一些函数可以认为是狄拉克δ函数的近似,但是要注意,这些函数都是通过极限构造的,因此严格上都不是狄拉克δ函数本身,不过在一些数学计算中可以作为狄拉克δ函数进行计算。

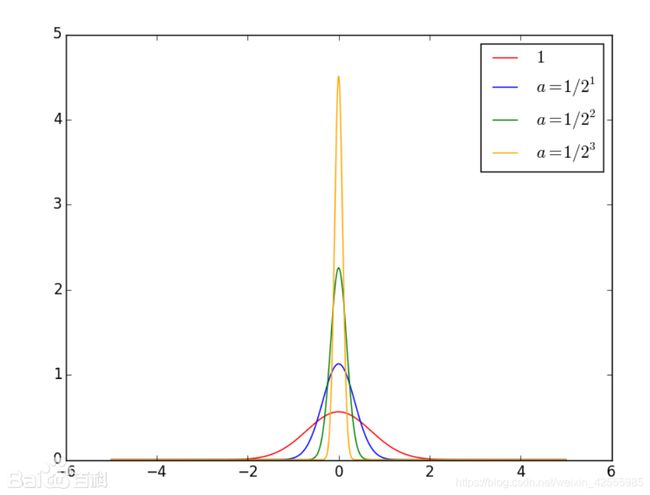

上图是高斯分布函数a趋近于0的序列

上图是高斯分布函数a趋近于0的序列

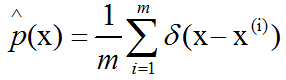

Dirac分布经常作为经验分布(empirical distribution)的一个组成部分出现

经验分布将概率密度 1 m \frac{1}{m} m1赋给 m m m个点 x ( 1 ) , … , x ( m ) x^{(1)}, \ldots, x^{(m)} x(1),…,x(m)中的每一个,这些点是给定的数据集或者采样的集合。 只有在定义连续型随机变量的经验分布时,Dirac delta函数才是必要的。 对于离散型随机变量,情况更加简单:经验分布可以被定义成一个Multinoulli分布,对于每一个可能的输入,其概率可以简单地设为在训练集上那个输入值的经验频率。

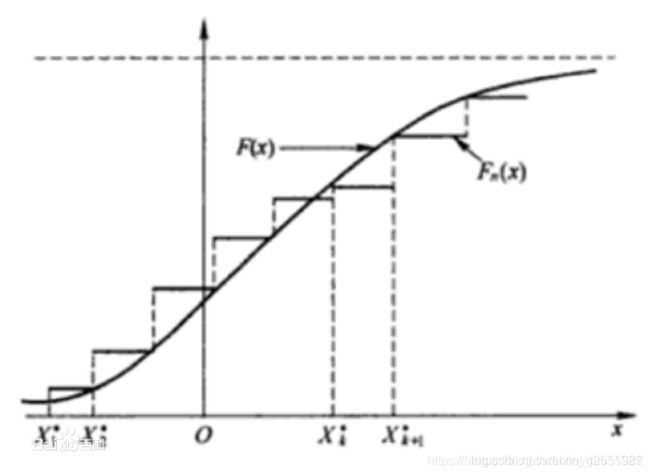

观察上图。可看到分布函数为呈跳跃上升的,每一跳跃为1/n,若有重复L次的值,则按1/n的L倍跳跃上升。图中圆滑曲线是总体X的理论分布函数F(x)的图形。若把经验分布函数的图形连成折线,那么它实际就是累积频率直方图的上边。

观察上图。可看到分布函数为呈跳跃上升的,每一跳跃为1/n,若有重复L次的值,则按1/n的L倍跳跃上升。图中圆滑曲线是总体X的理论分布函数F(x)的图形。若把经验分布函数的图形连成折线,那么它实际就是累积频率直方图的上边。

这和概率分布函数的性质是一致的。

经典统计推断主要的思想就是用样本分布来推断总体分布。

当我们在训练集上训练模型时,我们可以认为从这个训练集上得到的经验分布指明了我们采样来源的分布。 关于经验分布另外一种重要的观点是,它是训练数据的似然最大的那个概率密度函数。

【6.分布的混合】

通过组合一些简单的概率分布来定义新的概率分布也是很常见的。一种通用的组合方法是构造混合分布(mixture distribution)。

混合分布由一些组件(component)分布构成。每次实验,样本是由哪个组件分布产生的取决于从一个Multinoulli分布(多项分布)中采样的结果

这里P(c)是对各组件的一个Multinoulli分布。

我们已经看过一个混合分布的例子了:实值变量的经验分布对于每一个训练实例来说,就是以狄拉克δ Dirac分布为组件的混合分布。

混合模型是组合简单概率分布来生成更丰富的分布的一种简单策略。

混合模型使我们能够一瞥以后会用到的一个非常重要的概念——潜变量(latent variable)。

潜变量,与可观察变量相对,是不直接观察但是通过观察到的其他变量推断(通过数学模型)的变量(直接测量)。旨在用潜在变量解释观察变量的数学模型称为潜变量模型。

潜变量是指不能被直接精确观测或虽能被观测但尚需通过其它方法加以综合的指标,是在记录单元之间变化且其变化影响记录特征的任何未记录到的特征。结果是记录特征之间的联系,这种联系实际上并不是由记录特征本身的任何因果关系产生的。

潜变量是我们不能直接观测到的随机变量。混合模型的组件标识变量c就是其中一个例子。

潜变量在联合分布中可能和x有关,在这种情况下,P(x,c)=P(x|c)P(c)。

潜变量的分布P(c)以及关联潜变量和观测变量的条件分布P(x|c),共同决定了分布P(x)的形状,尽管描述P(x)时可能并不需要潜变量。

一个非常强大且常见的混合模型是高斯混合模型(Gaussian Mixture Model,GMM),它的组件p(x|c=i)是高斯分布。每个组件都有各自的参数,均值μ(i)和协方差矩阵Σ(i)。

有一些混合可以有更多的限制。例如,协方差矩阵可以通过Σ(i)=Σ, ∀ i \forall i ∀i的形式在组件之间共享参数。

和单个高斯分布一样,高斯混合模型有时会限制每个组件的协方差矩阵为对角的或者各向同性的(标量乘以单位矩阵)。

除了均值和协方差以外,高斯混合模型的参数指明了给每个组件i的先验概率(prior probability )αi=P(c=i)。“先验”一词表明了在观测到x之前传递给模型关于c的信念。

作为对比,P(c|x)是后验概率(posterior probability),因为它是在观测到x之后进行计算的。

高斯混合模型是概率密度的万能近似器(universal approximator),在这种意义下,任何平滑的概率密度都可以用具有足够多组件的高斯混合模型以任意精度来逼近。

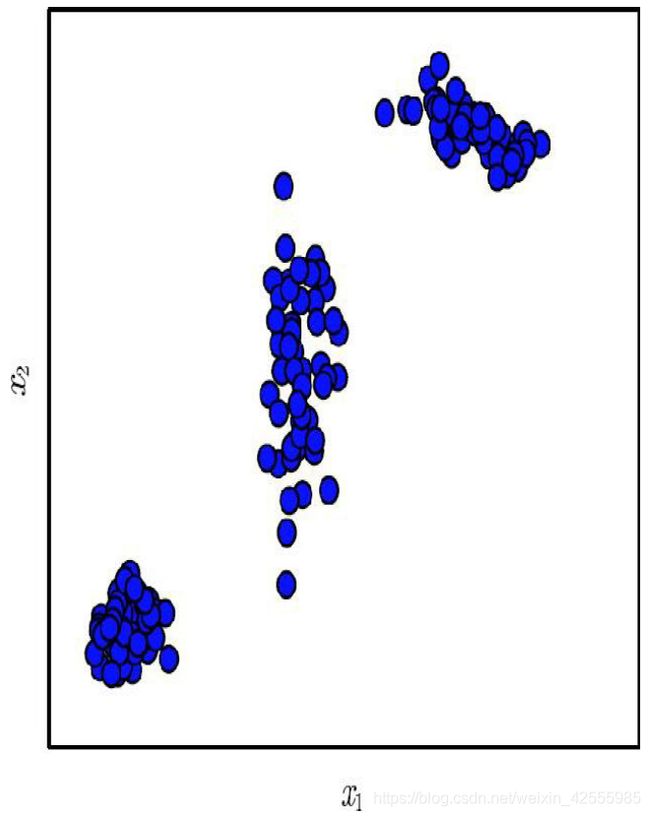

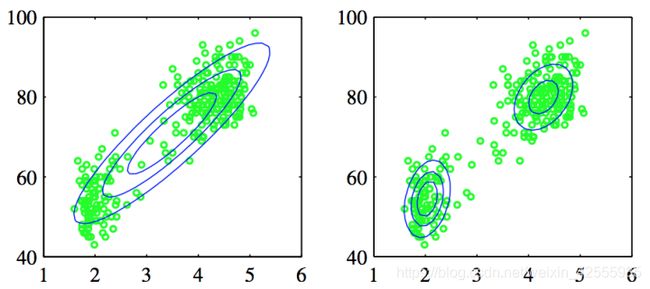

上图是某个高斯混合模型生成的样本

在这个示例中,有三个组件。从左到右,

- 第一个组件具有各向同性的协方差矩阵,这意味着它在每个方向上具有相同的方差。

- 第二个组件具有对角的协方差矩阵,这意味着它可以沿着每个轴的对齐方向单独控制方差。该示例中,沿着 x 2 x_2 x2轴的方差要比沿着 x 1 x_1 x1轴的方差大。

- 第三个组件具有满秩的协方差矩阵,使它能够沿着任意基的方向单独地控制方差。

【补充-GMM高斯混合模型】

为什么使用GMM?

因为有时候单一高斯分布不能很好的描述分布

上图左面用单一高斯分布去描述,显然没有右图用两个高斯分布去描述的效果好。

上图左面用单一高斯分布去描述,显然没有右图用两个高斯分布去描述的效果好。

为什么是“高斯混合模型”,而不是别的混合模型?

因为从中心极限定理知,只要K足够大,模型足够复杂,样本量足够多,每一块小区域就可以用高斯分布描述。而且高斯函数具有良好的计算性能,所以GMM被广泛地应用。

上图中我们用三个高斯分布去描述一个二维的数据。

上图中我们用三个高斯分布去描述一个二维的数据。

【7.常用函数的有用性质】

某些函数在处理概率分布时经常会出现,尤其是深度学习的模型中用到的概率分布。

7-1.logistic sigmoid函数–激活函数

σ ( x ) = 1 1 + e x p ( − x ) σ(x)=\frac {1}{1+exp(−x)} σ(x)=1+exp(−x)1

logistic sigmoid函数通常用来产生Bernoulli分布(伯努利分布-两点分布-离散型随机变量概率分布)中的参数φ,因为它的范围是(0,1),处在φ的有效取值范围内。

上图是sigmoid函数的图示

sigmoid函数在变量取绝对值非常大的正值或负值时会出现饱和(saturate)现象,意味着函数会变得很平,并且对输入的微小改变会变得不敏感。

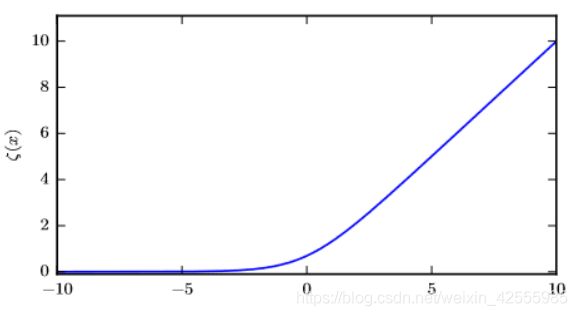

7-2.softplus函数–激活函数

ζ ( x ) = l o g ( 1 + e x p ( x ) ) ζ(x)=log(1+exp(x)) ζ(x)=log(1+exp(x))

softplus函数可以用来产生正态分布的β和σ参数,因为它的范围是(0,∞)。当处理包含sigmoid函数的表达式时,它也经常出现。

softplus函数名来源于它是另外一个函数的平滑(或“软化”)形式,这个函数是

x + = m a x ( 0 , x ) x^+=max(0,x) x+=max(0,x)

这个函数被称为正部函数(positive part function)。与正部函数相对的是负部函数(negative part function),即x−=max{0,−x}。为了获得类似负部函数的一个平滑函数,我们可以使用ζ(−x)。

关于logistic sigmoid函数和softplus函数有一些非常有用的性质

函数σ−1(x)在统计学中被称为分对数(logit),但这个函数在机器学习中很少用到。

logistic sigmoid函数和softplus函数都是激活函数。

所谓激活函数,就是在神经网络的神经元上运行的函数,负责将神经元的输入映射到输出端。

激活函数都是非线性的函数。

为什么要在神经网络中引入非线性的激活函数呢?

因为如果不用非线性的激励函数(其实相当于激励函数是线性的f(x) = x),在这种情况下你每一层输出都是上层输入的线性函数。

很容易验证,无论你神经网络有多少层,输出都是输入的线性组合,与没有隐藏层效果相当,这种情况就是最原始的感知机(Perceptron)了。 正因为上面的原因,所以要引入非线性函数作为激励函数,这样深层神经网络就有意义了(不再是输入的线性组合,可以逼近任意函数)。

举个输入x1,x2 的简单例子来说。

如果没有激活函数,那么无论中间有多少层节点,输出总可以写成 x1,x2 的线性表达式: y = a ∗ x 1 + b ∗ x 2 y=a*x1+b*x2 y=a∗x1+b∗x2 ,这样的网络当然作用有限。所以,引入激活函数就是为了引入非线性因素,以此解决线性模型所不能解决的问题,让神经网络功能更强大。

【8.贝叶斯规则】

我们经常会需要在已知P(y|x)时计算P(x|y )。幸运的是,如果还知道P(x),我们可以用贝叶斯规则(Bay es’ rule)来实现这一目的

P ( x ∣ y ) = P ( x , y ) P ( y ) = P ( x ) P ( y ∣ x ) P ( y ) P(x|y)=\frac {P(x,y)}{P(y)}=\frac {P(x)P(y|x)}{P(y)} P(x∣y)=P(y)P(x,y)=P(y)P(x)P(y∣x)

公式中的P(y)有时是不知道的,我们可以使用公式 P ( y ) = Σ x P ( y ∣ x ) P ( x ) P(y)=Σ_xP(y|x)P(x) P(y)=ΣxP(y∣x)P(x)来计算,所以我们并不需要事先知道P(y )的信息。

贝叶斯规则可以从条件概率的定义【某个事件在给定其他事件发生时出现的概率】直接推导得出,但我们最好记住这个公式的名字,因为很多文献通过名字来引用这个公式。这个公式是以牧师Thomas Bay es的名字来命名的,他是第一个发现这个公式特例的人。这里介绍的一般形式由Pierre-Simon Laplace独立发现。

【9.连续型变量的技术细节】

连续型随机变量和概率密度函数PDF的深入理解需要用到数学分支测度论(measure theory )的相关内容来扩展概率论。测度论超出了《深度学习》一书的范畴,但我们可以简要介绍一些测度论用来解决的问题。

测度论是研究一般集合上的测度和积分的理论。它是勒贝格测度和勒贝格积分理论的进一步抽象和发展,又称为抽象测度论或抽象积分论,是现代分析数学中重要工具之一。 测度理论是实变函数论的基础。

我们已经了解连续型向量值随机变量 x 落在某个集合 S 中的概率是通过 p ( x ) p(x) p(x)对集合S积分得到的。

对于集合S的一些选择可能会 引起悖论。

例如,构造两个集合S1和S2使得 p ( x ∈ S 1 ) + p ( x ∈ S 2 ) > 1 p(x \in S_1) + p( x \in S_2)>1 p(x∈S1)+p(x∈S2)>1并且 S 1 ⋂ S 2 = ∅ S_1 \bigcap S_2 = \emptyset S1⋂S2=∅是可能的。

这些集合通常是大量使用了实数的无限精度来构造的。例如,通过构造分形形状(fractal-shaped)的集合或者是通过有理数相关集合的变换定义的集合。

测度论的一个重要贡献就是提供了一些集合的特征,使得我们在计算概率时不会遇到悖论。

在《深度学习》一书中,我们只对相对简单的集合进行积分,所以测度论的这个方面不会成为一个相关考虑。

对于我们的目的,测度论更多的是用来描述那些适用于 Rn 上的大多数点,却不适用于一些边界情况的定理。 测度论提供了一种严格的方式来描述那些非常微小的点集。 这种集合被称为”零测度”的。 我们不会在《深度学习》一书中给出这个概念的正式定义。 然而,直观地理解这个概念是有用的,我们可以认为零测度集在我们的度量空间中不占有任何的体积。

例如,在R2 空间中,一条直线的测度为零,而填充的多边形具有正的测度。 类似的,一个单独的点的测度为零。 可数多个零测度集的并仍然是零测度的(所以所有有理数构成的集合测度为零)。

另外一个有用的测度论中的术语是”几乎处处(almost every where)”。 某个性质如果是几乎处处都成立的,那么它在整个空间中除了一个测度为零的集合以外都是成立的。 因为这些例外只在空间中占有极其微小的量,它们在多数应用中都可以被放心地忽略。

概率论中的一些重要结果对于离散值成立但对于连续值只能是”几乎处处”成立。

连续型随机变量的另一技术细节,涉及到处理那种相互之间有确定性函数关系的连续型变量。

假设我们有两个随机变量 x 和 y 满足y = g(x) ,其中 g 是可逆的、连续可微的函数。 可能有人会想 p y ( y ) = p x ( g − 1 ( y ) ) p_y(y) = p_x(g^{-1}(y)) py(y)=px(g−1(y))。 但实际上这并不对。

为了看出如何改正这个问题,我们回到标量值的情况。 我们需要保持下面这个性质:

∣ p y ( g ( x ) ) d y ∣ = ∣ p x ( x ) d x ∣ |p_y(g(x))dy|=|p_x(x)dx| ∣py(g(x))dy∣=∣px(x)dx∣

求解上式,我们得到

p y ( y ) = p x ( g − 1 ( y ) ) ∣ ∂ x ∂ y ∣ p_y(y)=p_x(g^{−1}(y)) \mid \frac {∂x}{∂y}\mid py(y)=px(g−1(y))∣∂y∂x∣

或者等价地,

p x ( x ) = p y ( g ( x ) ) ∣ ∂ g ( x ) ∂ x ∣ p_x(x)=p_y(g(x)) \mid \frac {∂g(x)}{∂x}\mid px(x)=py(g(x))∣∂x∂g(x)∣

在高维空间中,微分运算扩展为Jacobian矩阵的行列式——矩阵的每个元素为 J i , j = ∂ x i ∂ y j J_{i, j} = \frac{∂x_i}{∂ y_j} Ji,j=∂yj∂xi。 因此,对于实值向量x和y, p x ( x ) = p y ( g ( x ) ) ∣ d e t ( ∂ g ( x ) ∂ x ) ∣ p_x(x)=p_y(g(x)) \mid det(\frac {∂g(x)}{∂x})\mid px(x)=py(g(x))∣det(∂x∂g(x))∣

【10.信息论】

- 自信息,比特,奈特

- 香农熵

- 微分熵

- 相对熵/KL散度

- 交叉熵

信息论是一门用数理统计方法来研究信息的度量、传递和变换规律的科学。它主要是研究通讯和控制系统中普遍存在着信息传递的共同规律以及研究最佳解决信息的获限、度量、变换、储存和传递等问题的基础理论。

香农被称为是“信息论之父”。人们通常将香农于1948年10月发表于《贝尔系统技术学报》上的论文《A Mathematical Theory of Communication》(通信的数学理论)作为现代信息论研究的开端。这一文章部分基于哈里·奈奎斯特和拉尔夫·哈特利先前的成果。在该文中,香农给出了信息熵的定义。

这一定义可以用来推算传递经二进制编码后的原信息所需的信道带宽。熵度量的是消息中所含的信息量,其中去除了由消息的固有结构所决定的部分,比如,语言结构的冗余性以及语言中字母、词的使用频度等统计特性。

信息论是应用数学的一个分支,主要研究的是对一个信号包含信息的多少进行量化。

它最初被发明是用来研究在一个含有噪声的信道上用离散的字母表来发送消息,例如通过无线电传输来通信。 在这种情况下,信息论告诉我们如何对消息设计最优编码以及计算消息的期望长度,这些消息是使用多种不同编码机制、从特定的概率分布上采样得到的。

在机器学习中,我们也可以把信息论应用于连续型变量,此时某些消息长度的解释不再适用。 信息论是电子工程和计算机科学中许多领域的基础。

在《深度学习》一书中,我们主要使用信息论的一些关键思想来描述概率分布或者量化概率分布之间的相似性。

信息论的基本想法是一个不太可能的事件居然发生了,要比一个非常可能的事件发生,能提供更多的信息。

消息说:”今天早上太阳升起”信息量是如此之少以至于没有必要发送,但一条消息说:”今天早上有日食”信息量就很丰富。

我们想要通过这种基本想法来量化信息。 特别地,

- 非常可能发生的事件信息量要比较少,并且极端情况下,确保能够发生的事件应该没有信息量。

- 较不可能发生的事件具有更高的信息量。

- 独立事件应具有增量的信息。 例如,投掷的硬币两次正面朝上传递的信息量,应该是投掷一次硬币正面朝上的信息量的两倍。

为了满足上述三个性质,我们定义一个事件 x = x x x的自信息(self-information)为

I ( x ) = − l o g P ( x ) I(x)=−logP(x) I(x)=−logP(x)

自信息(self-information),又译为信息本体,由克劳德·香农提出,用来衡量单一事件发生时所包含的信息量多寡。它的单位是bit,或是nats。

说明:

- 在《深度学习》一书书中,我们总是用log来表示自然对数,其底数为e。

- 我们定义的 I ( x ) I(x) I(x) 单位是

奈特(nats)。1奈特是以 1 e \frac 1e e1的概率观测到一个事件时获得的信息量。 - 其他的材料中使用底数为2的对数,单位是比特(bit)或者香农(shannons)。

- 通过比特度量的信息只是通过奈特度量信息的常数倍。

当x是连续的,我们使用类似的关于信息的定义,但有些来源于离散形式的性质就丢失了。

例如,一个具有单位密度的事件信息量仍然为0,但是不能保证它一定发生。

自信息只处理单个的输出。我们可以用香农熵(Shannon entropy )来对整个概率分布中的不确定性总量进行量化【离散型随机变量期望值Ex∼P】:

香 农 熵 : H ( x ) = E x ∼ P [ I ( x ) ] = − E x ∼ P [ l o g P ( x ) ] = − ∑ x p ( x ) l o g P ( x ) 香农熵:H(x)=E_{x∼P}[I(x)]=−E_{x∼P}[logP(x)]=-\sum_{x}p(x)logP(x) 香农熵:H(x)=Ex∼P[I(x)]=−Ex∼P[logP(x)]=−x∑p(x)logP(x)也记作H(P)。

换言之,一个分布的香农熵是指遵循这个分布的事件所产生的期望信息总量。

它给出了对依据概率分布 P 生成的符号进行编码所需的比特数在平均意义上的下界(当对数底数不是2时,单位将有所不同)。

那些接近确定性的分布(输出几乎可以确定)具有较低的熵;那些接近均匀分布的概率分布具有较高的熵。

当x是连续的,香农熵被称为微分熵(differential entropy)。

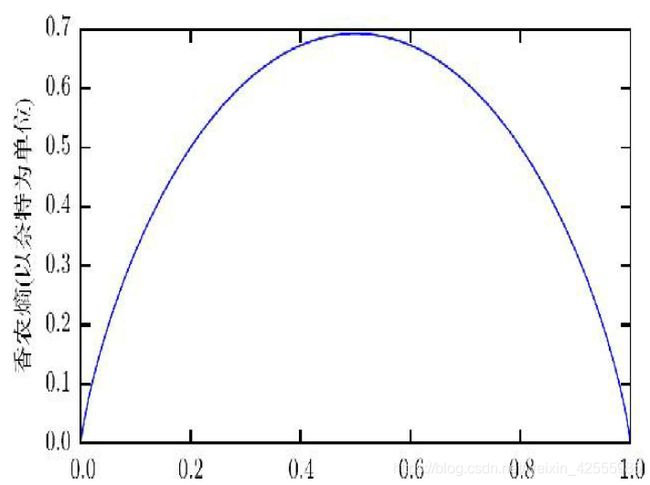

上图是二值随机变量的香农熵

上图是二值随机变量的香农熵

该图说明了更接近确定性的分布是如何具有较低的香农熵,而更接近均匀分布的分布是如何具有较高的香农熵。水平轴是p,表示二值随机变量等于1的概率。熵由(p−1)log(1−p)−p log p给出。

当p接近0时,分布几乎是确定的,因为随机变量几乎总是0。

当p接近1时,分布也几乎是确定的,因为随机变量几乎总是1。

当p=0.5时,熵是最大的,因为分布在两个结果(0和1)上是均匀的。

如果对于同一个随机变量x有两个单独的概率分布P(x)和Q(x),可以使用KL散度(Kullback-Leibler(KL)divergence,又称相对熵(relative entropy))来衡量这两个分布的差。

D K L ( P ∣ ∣ Q ) = E x ∼ P [ l o g P ( x ) Q ( x ) ] = E x ∼ P [ l o g P ( x ) − l o g Q ( x ) ] . D_{KL}(P||Q)=E_{x∼P}[logP(x)Q(x)]=E_{x∼P}[logP(x)−logQ(x)]. DKL(P∣∣Q)=Ex∼P[logP(x)Q(x)]=Ex∼P[logP(x)−logQ(x)].

相对熵可以衡量两个随机分布之间的距离,当两个随机分布相同时,它们的相对熵为零,当两个随机分布的差别增大时,它们的相对熵也会增大。所以相对熵可以用于比较文本的相似度,先统计出词的频率,然后计算相对熵。

在离散型变量的情况下,KL散度衡量的是,当我们使用一种被设计成能够使得概率分布Q产生的消息的长度最小的编码,发送包含由概率分布P产生的符号的消息时,所需要的额外信息量(如果我们使用底数为2的对数时,信息量用比特衡量,但在机器学习中,我们通常用奈特和自然对数。)

KL散度有很多有用的性质,最重要的是它是非负的。

KL散度为0当且仅当P和Q在离散型变量的情况下是相同的分布,或者在连续型变量的情况下是”几乎处处”相同的。

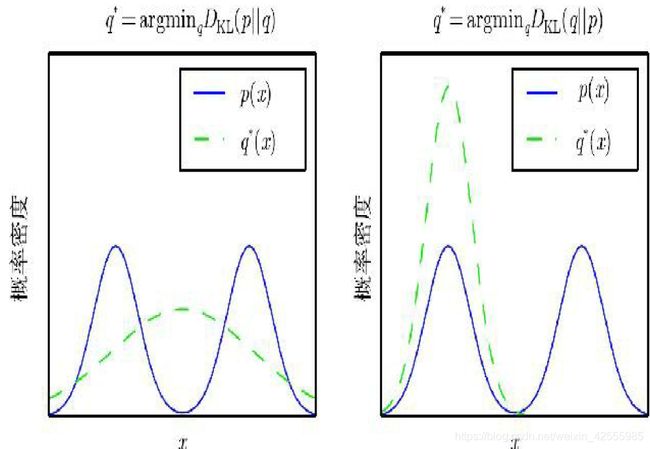

因为KL散度是非负的并且衡量的是两个分布之间的差异,它经常被用作分布之间的某种距离。 然而,它并不是真的距离,因为它不是对称的:对于某些P和Q, D K L ( P ∣ ∣ Q ) ≠ D K L ( Q ∣ ∣ P ) D_{KL}(P||Q) \ne D_{KL}(Q||P) DKL(P∣∣Q)=DKL(Q∣∣P)。这种非对称性意味着选 D K L ( P ∣ ∣ Q ) D_{KL}(P||Q) DKL(P∣∣Q)还是 D K L ( Q ∣ ∣ P ) D_{KL}(Q||P) DKL(Q∣∣P)影响很大。 具体可以参见下图

一个和KL散度密切联系的量是交叉熵(cross-entropy )

交叉熵(Cross Entropy)是Shannon信息论中一个重要概念,主要用于度量两个概率分布间的差异性信息。语言模型的性能通常用交叉熵和复杂度(perplexity)来衡量。

交叉熵可在神经网络(机器学习)中作为损失函数,p表示真实标记的分布,q则为训练后的模型的预测标记分布,交叉熵损失函数可以衡量p与q的相似性。

交叉熵 H ( P , Q ) = H ( P ) + D K L ( P ∣ ∣ Q ) H(P, Q) = H(P) + D_{KL}(P||Q) H(P,Q)=H(P)+DKL(P∣∣Q),它和KL散度很像,但是缺少左边一项

H ( P , Q ) = − E x ∼ P l o g Q ( x ) H(P,Q)=−E_{x∼P}logQ(x) H(P,Q)=−Ex∼PlogQ(x)

针对Q最小化交叉熵等价于最小化KL散度,因为Q并不参与被省略的那一项。

当我们计算这些量时,经常会遇到0 log 0这个表达式。按照惯例,在信息论中,我们将这个表达式处理为limx→0 x log x=0。

【11.结构化概率模型】

机器学习的算法经常会涉及在非常多的随机变量上的概率分布。通常,这些概率分布涉及的直接相互作用都是介于非常少的变量之间的。使用单个函数来描述整个联合概率分布是非常低效的(无论是计算上还是统计上)。

我们可以把概率分布分解成许多因子的乘积形式,而不是使用单一的函数来表示概率分布。

例如,假设我们有3个随机变量a、b和c,并且a影响b的取值,b影响c的取值,但是a和c在给定b时是条件独立的。我们可以把全部3个变量的概率分布重新表示为两个变量的概率分布的连乘形式:

p ( a , b , c ) = p ( b ) p ( a , c ∣ b ) = p ( b ) p ( a ∣ b ) p ( c ∣ b ) p(a,b,c)=p(b)p(a,c|b)=p(b)p(a|b)p(c|b) p(a,b,c)=p(b)p(a,c∣b)=p(b)p(a∣b)p(c∣b)

这种分解可以极大地减少用来描述一个分布的参数数量。

每个因子使用的参数数目是其变量数目的指数倍。这意味着,如果我们能够找到一种使每个因子分布具有更少变量的分解方法,就能极大地降低表示联合分布的成本。

我们还可以使用图论中的图来表示这种分解。

图论中的“图”的概念:由一些可以通过边互相连接的顶点的集合构成。

当用图来表示这种概率分布的分解时,我们把它称为结构化概率模型(structured probabilistic model)或者图模型(graphical model)。

有两种主要的结构化概率模型:有向的和无向的。

两种图模型都使用图 G,其中图的每个节点对应着一个随机变量,连接两个随机变量的边意味着概率分布可以表示成这两个随机变量之间的直接作用。

有向(directed)模型使用带有有向边的图,它们用条件概率分布来表示分解,就像上面的例子。特别地,有向模型对于分布中的每一个随机变量xi都包含着一个影响因子,这个组成xi条件概率的影响因子被称为xi的父节点,记为 P a G ( x i ) PaG(x_i) PaG(xi)。

p ( x ) = ∏ i p ( x i ∣ P a G ( x i ) ) p(x)=\prod_{i}p(x_i∣PaG(x_i)) p(x)=i∏p(xi∣PaG(xi))

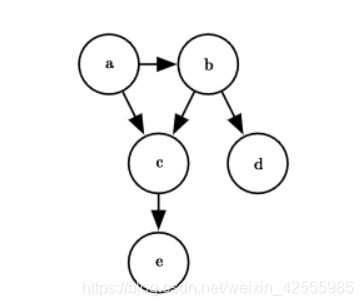

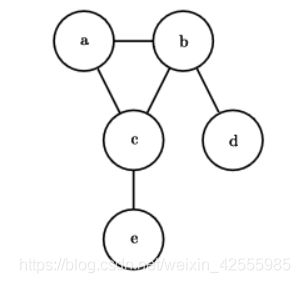

例:有向图的例子以及它表示的概率分布的分解

上图是关于随机变量a、b、c、d和e的有向图模型。

这幅图对应的概率分布可以分解为

p ( a , b , c , d , e ) = p ( a ) p ( b ∣ a ) p ( c ∣ a , b ) p ( d ∣ b ) p ( e ∣ c ) p(a,b,c,d,e)=p(a)p(b|a)p(c|a,b)p(d|b)p(e|c) p(a,b,c,d,e)=p(a)p(b∣a)p(c∣a,b)p(d∣b)p(e∣c)

该图模型使我们能够快速看出此分布的一些性质。例如,a和c直接相互影响,但a和e只有通过c间接相互影响。

无向(undirected)模型使用带有无向边的图,它们将分解表示成一组函数:不像有向模型那样,这些函数通常不是任何类型的概率分布。G中任何满足两两之间有边连接的顶点的集合被称为团,记为C(i)。

无向模型中的每个团C(i)都伴随着一个因子Φ(i)(C(i))。这些因子仅仅是函数,并不是概率分布。每个因子的输出都必须是非负的,但是并没有像概率分布中那样要求因子的和或者积分为1。

随机变量的联合概率与所有这些因子的乘积成比例(proportional)——这意味着因子的值越大,则可能性越大。当然,不能保证这种乘积的求和为1。所以我们需要除以一个归一化常数Z来得到归一化的概率分布,归一化常数Z被定义为φ函数乘积的所有状态的求和或积分。概率分布为

p ( x ) = 1 Z ∏ i ϕ ( i ) ( C ( i ) ) p(x)=\frac 1Z\prod_{i}ϕ^{(i)}(C^{(i)}) p(x)=Z1i∏ϕ(i)(C(i))

例,无向图的例子以及它表示的概率分布的分解

上图是关于随机变量a、b、c、d和e的无向图模型

这幅图对应的概率分布可以分解为

p ( a , b , c , d , e ) = 1 Z ϕ ( 1 ) ( a , b , c ) ϕ ( 2 ) ( b , d ) ϕ ( 3 ) ( c , e ) p(a,b,c,d,e)=\frac 1Zϕ^{(1)}(a,b,c)ϕ^{(2)}(b,d)ϕ^{(3)}(c,e) p(a,b,c,d,e)=Z1ϕ(1)(a,b,c)ϕ(2)(b,d)ϕ(3)(c,e)

该图模型使我们能够快速看出此分布的一些性质。例如,a和c直接相互影响,但a和e只有通过c间接相互影响。

请记住,这些图模型表示的分解仅仅是描述概率分布的一种语言。它们不是互相排斥的概率分布族。有向或者无向不是概率分布的特性;它是概率分布的一种特殊描述(description)所具有的特性,而任何概率分布都可以用这两种方式进行描述。