- 【Python】一文详细介绍 py格式 文件

高斯小哥

Python基础【高质量合集】python新手入门学习

【Python】一文详细介绍py格式文件个人主页:高斯小哥高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程希望得到您的订阅和支持~创作高质量博文(平均质量分92+),分享更多关于深度学习、PyTorch、Python领域的优质内容!(希望得到您的关注~)文章目录一、py格式文件简介二、如何创建和编辑py格式文件三、如何运行py

- 你有想删除的人生吗?(2022-10-10)

燕归来2021

中午遛弯清茶发信息给我:有本书不用看了,建议看作者的另一本。然后聊起她推给我的日剧《人生删除事务所》,我只看了一集,名字觉得很有意思,就问清茶有没有想删除的人生,她回:没有,这么平淡的日子。我:我也没有,这么精彩的人生,哈哈。虽是玩笑说,却也不完全瞎说。闺蜜性情平和佛性,我苦苦挣扎修行半靠子,她生来就有。由人生就聊到最近我追的李子勋,李老师的观点:心理学讲人性多讲道德少,讲究有效性非真实性,很多观

- matlab按行读取txt文件数据集

地上悬河

matlab开发语言

功能:使用Matlab按行读取txt文件,按照特定符号进行分割后加入数组中fid=fopen('coordinate.txt');%首先打开文本文件coordinate.txttemp=[]while~feof(fid)%while循环表示文件指针没到达末尾,则继续%每次读取一行,str是字符串格式str=fgetl(fid);%以','作为分割数据的字符,结果为cell数组s=regexp(st

- C#中的PLINQ和LINQ的效率对比

搬砖的诗人Z

C#c#linq开发语言

PLINQ(ParallelLINQ)和LINQ(LanguageIntegratedQuery)都是.NET框架中的功能,用于对集合进行查询和操作。它们之间的主要区别在于并行处理能力。LINQ:LINQ是一种用于在.NET应用程序中进行数据查询和操作的语言集成功能。它提供了一种统一的方式来查询各种数据源,如集合、数组、XML、数据库等。LINQ是在单线程环境中执行查询操作的,因此对于大型数据集或

- 大创项目推荐 深度学习 opencv python 公式识别(图像识别 机器视觉)

laafeer

python

文章目录0前言1课题说明2效果展示3具体实现4关键代码实现5算法综合效果6最后0前言优质竞赛项目系列,今天要分享的是基于深度学习的数学公式识别算法实现该项目较为新颖,适合作为竞赛课题方向,学长非常推荐!学长这里给一个题目综合评分(每项满分5分)难度系数:3分工作量:4分创新点:4分更多资料,项目分享:https://gitee.com/dancheng-senior/postgraduate1课题

- docker基础(一)

运维搬运工

容器-dockerdocker容器运维

相关概念介绍Docker是一个开源的应用容器引擎,让开发者可以打包他们的应用以及依赖到一个可移植的容器中,然后发布到任何流行的linux机器上,也可以实现虚拟化,容器是完全使用沙箱机制,互相之间不会有任何接口。Docker有几个重要概念:dockerfile,配置文件,用来生成dockerimagedockerimage,交付部署的最小单元docker命令与API,定义命令与接口,支持第三方系统集

- 桃李春风一杯酒

行走的石头521

桃李春风一杯酒,江湖夜雨十年灯。回眸处,雾霭沉沉。跌宕的现世里,与自己和解,不计较,不解释,不纠结,不凑合,读书品茗,赏花听雨,也不失为一种富足与自由。非常喜欢这段话,可能是最近桃花朵朵开的缘故吧!让我不由得想起了那些诗词里的桃花:1、桃花春水生,白石今出没。摇萝枝,半摇青天月。——李白《忆秋浦桃花旧游》2、桃花潭水深千尺,不及汪伦送我情!——李白《赠汪伦》3、黄雀始欲衔花来,君家种桃花未开。长安

- Ai插件脚本合集安装包,免费教程视频网盘分享

全网优惠分享君

随着人工智能技术的不断发展,越来越多的插件脚本涌现出来,为我们的生活和工作带来了便利。然而,如何快速、方便地获取和使用这些插件脚本呢?今天,我将为大家分享一个非常实用的资源——AI插件脚本合集安装包,以及免费教程视频网盘分享。首先,让我们来了解一下这个AI插件脚本合集安装包。它是一个集合了众多AI插件脚本的资源包,涵盖了各种领域,如数据分析、自动化办公、智能客服等等。通过这个安装包,用户可以轻松地

- 地缚少年花子君,一个小小的甜甜圈,源光看见了源辉内心的小秘密

ACGN安乐

大家好我是小安,很高兴又和大家见面了,话不多说我们直接进入正题,不知大家对日本动画《地缚少年花子君》中海鸥学院高等部二年级生,学生会的会长源辉了解多少呢?源辉从第一集中就已经登场,他是源光的哥哥,也是八寻宁宁的理想对象之一,源辉除了有学生这层身份之外和他的弟弟源光一样都是拔除师,也就是我们统称的除妖师,从表面来看源辉是个高颜值帅哥,脾气很好同时也有很多女孩子想做他的女朋友,但金无足赤人无完人大家也

- 过去一年,这16本好书不容错过

m0_54050778

perl

编者按:2023年在动荡与希望中收尾,2023年注定会被载入史册。疫情寒冬结束,ChatGPT横空出世,带动了人工智能技术的飞速发展;淄博烧烤、天津大爷、尔滨之旅等充满感动与幸福。但与此同时,2023年又是动荡与不安的一年,俄乌冲突的延宕,新一轮的巴以冲突,极端天气频发。在这个大环境下,有一些经典的书籍著作诞生。本文将分享2023年最值得一读的16本书籍,文章来自翻译,希望对你有所启示。关于202

- [数据集][图像分类]河道污染分类数据集1923张4类别

FL1623863129

数据集分类数据挖掘人工智能

数据集类型:图像分类用,不可用于目标检测无标注文件数据集格式:仅仅包含jpg图片,每个类别文件夹下面存放着对应图片图片数量(jpg文件个数):1922分类类别数:4类别名称:["lianghao","qingwei","yanzhong","zhongdu"]每个类别图片数:lianghao图片数:435qingwei图片数:423yanzhong图片数:577zhongdu图片数:487重要说明

- 生活中的很多事是既令人生气又令人伤感,但却还无可奈何

城中隐士

今天一打开手机,就看到姨娘家的姐姐兰兰在抖音上发了一则信息,信息内容如下:“我绝对不是我爸妈亲生的,不知他们是从哪儿把我捡回来的”。图源网络,侵则必删今天一大早,天刚蒙蒙亮,姨父就着急莫慌给姨妈家姐姐来一电话,说是家里今天有急事,喊她赶紧回去。还没等姐姐反应过来,姨父就草草地挂断了电话。吓得姐姐立马清醒,以为家里不知出了多大的事?她赶紧从床上爬起来以最快速度第一时间从温江赶到中江。等她顶着烈日,风

- python清华大学出版社答案_Python机器学习及实践

weixin_39805119

python清华大学出版社答案

第1章机器学习的基础知识1.1何谓机器学习1.1.1传感器和海量数据1.1.2机器学习的重要性1.1.3机器学习的表现1.1.4机器学习的主要任务1.1.5选择合适的算法1.1.6机器学习程序的步骤1.2综合分类1.3推荐系统和深度学习1.3.1推荐系统1.3.2深度学习1.4何为Python1.4.1使用Python软件的由来1.4.2为什么使用Python1.4.3Python设计定位1.4.

- 酷开科技依托酷开系统用“平台+产品+场景”塑造全屋智能生活!

京创尤品

科技生活

杰弗里·摩尔的“鸿沟理论”中写道:高科技企业推进产品的早期市场和产品被广泛接受的主流市场之间,存在着一条巨大的“鸿沟”。“鸿沟”,指产品吸引早期接纳者后、赢得更多客户前的那段间歇,以及其中可预知和不可预知的阻碍。多数产品或企业的失败都发生在“鸿沟期”。目前,智慧家居的发展正处在一个“鸿沟期”:势头看似迅猛,但真实用户有限。对于一些企业而言,这条巨大“鸿沟”之所以出现,在于他们对如何推进智慧家居并不

- 自动化测试 —— Pytest fixture及conftest详解

咖啡加剁椒③

软件测试pytest功能测试软件测试自动化测试程序人生职场和发展

前言fixture是在测试函数运行前后,由pytest执行的外壳函数。fixture中的代码可以定制,满足多变的测试需求,包括定义传入测试中的数据集、配置测试前系统的初始状态、为批量测试提供数据源等等。fixture是pytest的精髓所在,类似unittest中setup/teardown,但是比它们要强大、灵活很多,它的优势是可以跨文件共享。一、Pytestfixture1.pytestfix

- 高阶SQL语句(二)

www.mcb.com

数据库mysql

一子查询也被称作内查询或者嵌套查询,是指在一个查询语句里面还嵌套着另一个查询语句。子查询语句是先于主查询语句被执行的,其结果作为外层的条件返回给主查询进行下一步的查询过滤。①子语句可以与主语句所查询的表相同,也可以是不同表②子语句中的sql语句是为了,最后过滤出一个结果集,用于主语句的判断条件③in:将主表和子表关联/连接的语法环境准备:mysql>usekgc_ky35;Readingtable

- 深度学习项目-基于深度学习的股票价格预测研究

雅致教育

计算机毕业设计深度学习人工智能

概要 随着经济的发展,中国股票市场的规模持续扩大,早已成为金融投资的重要部分,掌握股票市场的变化规律无论是对监管者还是投资者都具有极其重要的意义。正因如此,人们不断探索着股票市场的变化规律,其中使用深度学习预测股价是当前国内国际研究与应用的热点。 本文首先从有效市场假说和分形市场假说两个角度讨论了中国股票市场的有效性,说明股票市场具有复杂的非线性特征。其次,结合股票市场特征对比了当前的预测方法

- 史上最详细的测试用例写作规范

心软小念

测试用例

软件测试用例得出软件测试用例的内容,其次,按照软件测试写作方法,落实到文档中,两者是形式和内容的关系,好的测试用例不仅方便自己和别人查看,而且能帮助设计的时候考虑的更周。一个好的测试用例必须包含足够的内容,将这些内容可以拆分为八个要素:用例编号、测试项目、测试标题、重要级别、预置条件、测试输入、操作步骤、预期输出。1、用例编号1)规则:是由字符和数字组成的字符串,具有唯一性、易识别性。2)不同阶段

- DCGAN中的生成器和识别器代码详解

YYLin-AI

DCGAN深度学习celebatensorflow

#DCGAN中的生成器我自己写的有一个封装好的用于生成器和识别器的卷积操作但是在这个代码中我没有使用我自己的代码#原因想绍一下tensorflow自带的函数所以找了一个以前在书上的代码申明一下这个不是原创但是原来代码中有几处不符合DCGAN的要求所以就做了一些修改转载链接没有就直接写成原创建议看代码之前先看看DCGAN的特点,然后再看代码中如何实这些特点的这样会更有帮助DCGAN(深度卷积的对抗生

- ChatGPT技巧大揭秘:AI写代码新境界

2401_83550420

chatgpt4.0chatgptchatgpt人工智能AI写作

ChatGPT无限次数:点击直达ChatGPT技巧大揭秘:AI写代码新境界随着人工智能技术的不断进步,开发人员现在有了更多有趣的工具来提高他们的工作效率。其中,ChatGPT作为一种基于深度学习的自然语言处理模型,已经成为许多开发者的新宠。在本文中,我们将揭秘使用ChatGPT来帮助编写代码的技巧,探索AI在编程领域的新境界。ChatGPT简介ChatGPT是一种基于大型神经网络的对话生成模型,它

- ChatGPT:AI合作伙伴助你成为论文写作高手

2401_83550420

chatgptchatgpt人工智能AI写作

ChatGPT无限次数:点击直达摘要:本文将介绍ChatGPT3.5Turbo(以下简称ChatGPT),一款强大的AI合作伙伴,能够助你成为一名论文写作高手。我们将深入探讨ChatGPT的特点、优势,并提供多个示例,展示ChatGPT在论文写作中的应用。无论是开展研究、撰写论文、还是与ChatGPT进行互动交流,都能够帮助你提升写作效率和质量。引言:随着人工智能的发展,聊天型语言模型在各个领域都

- AI大模型学习:开启智能时代的新篇章

游向大厂的咸鱼

人工智能学习

随着人工智能技术的不断发展,AI大模型已经成为当今领先的技术之一,引领着智能时代的发展。这些大型神经网络模型,如OpenAI的GPT系列、Google的BERT等,在自然语言处理、图像识别、智能推荐等领域展现出了令人瞩目的能力。然而,这些模型的背后是一系列复杂的学习过程,深度学习技术的不断演进推动了AI大模型学习的发展。首先,AI大模型学习的基础是深度学习技术。深度学习是一种模仿人类大脑结构的机器

- 【Python】成功解决ModuleNotFoundError: No module named ‘torchinfo‘

高斯小哥

BUG解决方案合集pythonpytorch新手入门学习debug

【Python】成功解决ModuleNotFoundError:Nomodulenamed‘torchinfo’个人主页:高斯小哥高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程希望得到您的订阅和支持~创作高质量博文(平均质量分92+),分享更多关于深度学习、PyTorch、Python领域的优质内容!(希望得到您的关注~)文

- RNA-seq数据分析_未完成

子诚之

组学数据分析数据分析

目录基础分析1.质控(reads)2.比对3.质控(alignment)4.定量5.样本合并差异表达1.质控(cohort)2.差异分析3.可视化(差异)富集分析肿瘤免疫1.免疫组库2.免疫浸润3.免疫响应4.新抗原预测微生物组参考本文主要覆盖了肿瘤样本bulkRNA-seq数据常见的分析步骤,并从实践角度出发,较为具体地介绍了每一步骤依赖的工具和数据集。另外,尽管本文适用于肿瘤样本,但其中的一些

- 穷人和富人哪个更快乐

骑着蜗牛的大乌龟

有人约我聊一下穷人和富人哪个更快乐?我跟她说,富人快不快乐我不知道,穷人一定不快乐。咱们先来定义一下什么叫穷人。头顶宝字盖,下面八分开,见人弓身行礼,手中沒有钱财”这是繁体字窮的描写,还有一种说法就是一家人住在一个洞穴里,连睡觉都得弓着身子。这种日子我真不知道有什么可快乐的。不知道大家有没有看过蜗居这个电视剧,我印象最深刻的不是海藻海清,也不是宋思明小贝。还记不记得海清的那个邻居上海老太太,最后当

- 【HBZ分享】ES的聚合函数汇总

hbz-

elasticsearchjavalinux

聚合分类指标聚合:对数据集求最大、最小、和、平均值等指标的聚合,称为指标聚合metric格式:GET/index/_search{"size":0,"aggs":{"aggregation_name":{"aggregation_type":{"aggregation_field":"field_name"//可选参数}}//可以添加更多的聚合}}#解析-index:要执行聚合查询的索引名称。-s

- 车牌统计风波

阿哈牧童

在之前的伎俩全部失败以后,房开张贴了即将启动停车场规范管理的告示来打破目前的平衡状态,要求业主去房开办公室登记车牌,就在不久以前,业委会的邓普先就和他们把道道划了出来,停车场的问题由来已久,正是因为扯不清楚,交管部门没收了房开的停车场备案,也正是从那个时候开始,地方政府给出的指导意见也是尽可能的谈,在谈出结果以前,停车场的管理不能为难业主。然而房开可放不下身段,总是想要通过其他形式来解决问题,包括

- OpenCV(一个C++人工智能领域重要开源基础库) 简介

愚梦者

OpenCV人工智能人工智能opencvc++图像处理计算机视觉开源

返回:OpenCV系列文章目录(持续更新中......)上一篇:OpenCV4.9.0配置选项参考下一篇:OpenCV4.9.0开源计算机视觉库安装概述引言:OpenCV(全称OpenSourceComputerVisionLibrary)是一个基于开放源代码发行的跨平台计算机视觉库,可以用来进行图像处理、计算机视觉和机器学习等领域的开发。该库由英特尔公司于1999年开始开发,最初是为了加速处理器

- 【循环神经网络rnn】一篇文章讲透

CX330的烟花

rnn人工智能深度学习算法python机器学习数据结构

目录引言二、RNN的基本原理代码事例三、RNN的优化方法1长短期记忆网络(LSTM)2门控循环单元(GRU)四、更多优化方法1选择合适的RNN结构2使用并行化技术3优化超参数4使用梯度裁剪5使用混合精度训练6利用分布式训练7使用预训练模型五、RNN的应用场景1自然语言处理2语音识别3时间序列预测六、RNN的未来发展七、结论引言众所周知,CNN与循环神经网络(RNN)或生成对抗网络(GAN)等算法结

- 零基础机器学习(5)之线性回归模型的性能评估

一只特立独行猪

机器学习机器学习线性回归人工智能

文章目录线性回归模型的性能评估1.举例1-单一特征2.举例2-多特征线性回归模型的性能评估评估线性回归模型时,首先要建立评估的测试数据集(测试集不能与训练集相同),然后选择合适的评估方法,实现对线性回归模型的评估。回归任务中最常用的评估方法有均方误差、均方根误差和预测准确率(确定系数)。1.举例1-单一特征分别对两个模型进行评估,输入的测试集如表所示。面积/(m2)售价/(万元)面积/(m2)售价

- jQuery 键盘事件keydown ,keypress ,keyup介绍

107x

jsjquerykeydownkeypresskeyup

本文章总结了下些关于jQuery 键盘事件keydown ,keypress ,keyup介绍,有需要了解的朋友可参考。

一、首先需要知道的是: 1、keydown() keydown事件会在键盘按下时触发. 2、keyup() 代码如下 复制代码

$('input').keyup(funciton(){

- AngularJS中的Promise

bijian1013

JavaScriptAngularJSPromise

一.Promise

Promise是一个接口,它用来处理的对象具有这样的特点:在未来某一时刻(主要是异步调用)会从服务端返回或者被填充属性。其核心是,promise是一个带有then()函数的对象。

为了展示它的优点,下面来看一个例子,其中需要获取用户当前的配置文件:

var cu

- c++ 用数组实现栈类

CrazyMizzz

数据结构C++

#include<iostream>

#include<cassert>

using namespace std;

template<class T, int SIZE = 50>

class Stack{

private:

T list[SIZE];//数组存放栈的元素

int top;//栈顶位置

public:

Stack(

- java和c语言的雷同

麦田的设计者

java递归scaner

软件启动时的初始化代码,加载用户信息2015年5月27号

从头学java二

1、语言的三种基本结构:顺序、选择、循环。废话不多说,需要指出一下几点:

a、return语句的功能除了作为函数返回值以外,还起到结束本函数的功能,return后的语句

不会再继续执行。

b、for循环相比于whi

- LINUX环境并发服务器的三种实现模型

被触发

linux

服务器设计技术有很多,按使用的协议来分有TCP服务器和UDP服务器。按处理方式来分有循环服务器和并发服务器。

1 循环服务器与并发服务器模型

在网络程序里面,一般来说都是许多客户对应一个服务器,为了处理客户的请求,对服务端的程序就提出了特殊的要求。

目前最常用的服务器模型有:

·循环服务器:服务器在同一时刻只能响应一个客户端的请求

·并发服务器:服

- Oracle数据库查询指令

肆无忌惮_

oracle数据库

20140920

单表查询

-- 查询************************************************************************************************************

-- 使用scott用户登录

-- 查看emp表

desc emp

- ext右下角浮动窗口

知了ing

JavaScriptext

第一种

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/1999/

- 浅谈REDIS数据库的键值设计

矮蛋蛋

redis

http://www.cnblogs.com/aidandan/

原文地址:http://www.hoterran.info/redis_kv_design

丰富的数据结构使得redis的设计非常的有趣。不像关系型数据库那样,DEV和DBA需要深度沟通,review每行sql语句,也不像memcached那样,不需要DBA的参与。redis的DBA需要熟悉数据结构,并能了解使用场景。

- maven编译可执行jar包

alleni123

maven

http://stackoverflow.com/questions/574594/how-can-i-create-an-executable-jar-with-dependencies-using-maven

<build>

<plugins>

<plugin>

<artifactId>maven-asse

- 人力资源在现代企业中的作用

百合不是茶

HR 企业管理

//人力资源在在企业中的作用人力资源为什么会存在,人力资源究竟是干什么的 人力资源管理是对管理模式一次大的创新,人力资源兴起的原因有以下点: 工业时代的国际化竞争,现代市场的风险管控等等。所以人力资源 在现代经济竞争中的优势明显的存在,人力资源在集团类公司中存在着 明显的优势(鸿海集团),有一次笔者亲自去体验过红海集团的招聘,只 知道人力资源是管理企业招聘的 当时我被招聘上了,当时给我们培训 的人

- Linux自启动设置详解

bijian1013

linux

linux有自己一套完整的启动体系,抓住了linux启动的脉络,linux的启动过程将不再神秘。

阅读之前建议先看一下附图。

本文中假设inittab中设置的init tree为:

/etc/rc.d/rc0.d

/etc/rc.d/rc1.d

/etc/rc.d/rc2.d

/etc/rc.d/rc3.d

/etc/rc.d/rc4.d

/etc/rc.d/rc5.d

/etc

- Spring Aop Schema实现

bijian1013

javaspringAOP

本例使用的是Spring2.5

1.Aop配置文件spring-aop.xml

<?xml version="1.0" encoding="UTF-8"?>

<beans

xmlns="http://www.springframework.org/schema/beans"

xmln

- 【Gson七】Gson预定义类型适配器

bit1129

gson

Gson提供了丰富的预定义类型适配器,在对象和JSON串之间进行序列化和反序列化时,指定对象和字符串之间的转换方式,

DateTypeAdapter

public final class DateTypeAdapter extends TypeAdapter<Date> {

public static final TypeAdapterFacto

- 【Spark八十八】Spark Streaming累加器操作(updateStateByKey)

bit1129

update

在实时计算的实际应用中,有时除了需要关心一个时间间隔内的数据,有时还可能会对整个实时计算的所有时间间隔内产生的相关数据进行统计。

比如: 对Nginx的access.log实时监控请求404时,有时除了需要统计某个时间间隔内出现的次数,有时还需要统计一整天出现了多少次404,也就是说404监控横跨多个时间间隔。

Spark Streaming的解决方案是累加器,工作原理是,定义

- linux系统下通过shell脚本快速找到哪个进程在写文件

ronin47

一个文件正在被进程写 我想查看这个进程 文件一直在增大 找不到谁在写 使用lsof也没找到

这个问题挺有普遍性的,解决方法应该很多,这里我给大家提个比较直观的方法。

linux下每个文件都会在某个块设备上存放,当然也都有相应的inode, 那么透过vfs.write我们就可以知道谁在不停的写入特定的设备上的inode。

幸运的是systemtap的安装包里带了inodewatch.stp,位

- java-两种方法求第一个最长的可重复子串

bylijinnan

java算法

import java.util.Arrays;

import java.util.Collections;

import java.util.List;

public class MaxPrefix {

public static void main(String[] args) {

String str="abbdabcdabcx";

- Netty源码学习-ServerBootstrap启动及事件处理过程

bylijinnan

javanetty

Netty是采用了Reactor模式的多线程版本,建议先看下面这篇文章了解一下Reactor模式:

http://bylijinnan.iteye.com/blog/1992325

Netty的启动及事件处理的流程,基本上是按照上面这篇文章来走的

文章里面提到的操作,每一步都能在Netty里面找到对应的代码

其中Reactor里面的Acceptor就对应Netty的ServerBo

- servelt filter listener 的生命周期

cngolon

filterlistenerservelt生命周期

1. servlet 当第一次请求一个servlet资源时,servlet容器创建这个servlet实例,并调用他的 init(ServletConfig config)做一些初始化的工作,然后调用它的service方法处理请求。当第二次请求这个servlet资源时,servlet容器就不在创建实例,而是直接调用它的service方法处理请求,也就是说

- jmpopups获取input元素值

ctrain

JavaScript

jmpopups 获取弹出层form表单

首先,我有一个div,里面包含了一个表单,默认是隐藏的,使用jmpopups时,会弹出这个隐藏的div,其实jmpopups是将我们的代码生成一份拷贝。

当我直接获取这个form表单中的文本框时,使用方法:$('#form input[name=test1]').val();这样是获取不到的。

我们必须到jmpopups生成的代码中去查找这个值,$(

- vi查找替换命令详解

daizj

linux正则表达式替换查找vim

一、查找

查找命令

/pattern<Enter> :向下查找pattern匹配字符串

?pattern<Enter>:向上查找pattern匹配字符串

使用了查找命令之后,使用如下两个键快速查找:

n:按照同一方向继续查找

N:按照反方向查找

字符串匹配

pattern是需要匹配的字符串,例如:

1: /abc<En

- 对网站中的js,css文件进行打包

dcj3sjt126com

PHP打包

一,为什么要用smarty进行打包

apache中也有给js,css这样的静态文件进行打包压缩的模块,但是本文所说的不是以这种方式进行的打包,而是和smarty结合的方式来把网站中的js,css文件进行打包。

为什么要进行打包呢,主要目的是为了合理的管理自己的代码 。现在有好多网站,你查看一下网站的源码的话,你会发现网站的头部有大量的JS文件和CSS文件,网站的尾部也有可能有大量的J

- php Yii: 出现undefined offset 或者 undefined index解决方案

dcj3sjt126com

undefined

在开发Yii 时,在程序中定义了如下方式:

if($this->menuoption[2] === 'test'),那么在运行程序时会报:undefined offset:2,这样的错误主要是由于php.ini 里的错误等级太高了,在windows下错误等级

- linux 文件格式(1) sed工具

eksliang

linuxlinux sed工具sed工具linux sed详解

转载请出自出处:

http://eksliang.iteye.com/blog/2106082

简介

sed 是一种在线编辑器,它一次处理一行内容。处理时,把当前处理的行存储在临时缓冲区中,称为“模式空间”(pattern space),接着用sed命令处理缓冲区中的内容,处理完成后,把缓冲区的内容送往屏幕。接着处理下一行,这样不断重复,直到文件末尾

- Android应用程序获取系统权限

gqdy365

android

引用

如何使Android应用程序获取系统权限

第一个方法简单点,不过需要在Android系统源码的环境下用make来编译:

1. 在应用程序的AndroidManifest.xml中的manifest节点

- HoverTree开发日志之验证码

hvt

.netC#asp.nethovertreewebform

HoverTree是一个ASP.NET的开源CMS,目前包含文章系统,图库和留言板功能。代码完全开放,文章内容页生成了静态的HTM页面,留言板提供留言审核功能,文章可以发布HTML源代码,图片上传同时生成高品质缩略图。推出之后得到许多网友的支持,再此表示感谢!留言板不断收到许多有益留言,但同时也有不少广告,因此决定在提交留言页面增加验证码功能。ASP.NET验证码在网上找,如果不是很多,就是特别多

- JSON API:用 JSON 构建 API 的标准指南中文版

justjavac

json

译文地址:https://github.com/justjavac/json-api-zh_CN

如果你和你的团队曾经争论过使用什么方式构建合理 JSON 响应格式, 那么 JSON API 就是你的 anti-bikeshedding 武器。

通过遵循共同的约定,可以提高开发效率,利用更普遍的工具,可以是你更加专注于开发重点:你的程序。

基于 JSON API 的客户端还能够充分利用缓存,

- 数据结构随记_2

lx.asymmetric

数据结构笔记

第三章 栈与队列

一.简答题

1. 在一个循环队列中,队首指针指向队首元素的 前一个 位置。

2.在具有n个单元的循环队列中,队满时共有 n-1 个元素。

3. 向栈中压入元素的操作是先 移动栈顶指针&n

- Linux下的监控工具dstat

网络接口

linux

1) 工具说明dstat是一个用来替换 vmstat,iostat netstat,nfsstat和ifstat这些命令的工具, 是一个全能系统信息统计工具. 与sysstat相比, dstat拥有一个彩色的界面, 在手动观察性能状况时, 数据比较显眼容易观察; 而且dstat支持即时刷新, 譬如输入dstat 3, 即每三秒收集一次, 但最新的数据都会每秒刷新显示. 和sysstat相同的是,

- C 语言初级入门--二维数组和指针

1140566087

二维数组c/c++指针

/*

二维数组的定义和二维数组元素的引用

二维数组的定义:

当数组中的每个元素带有两个下标时,称这样的数组为二维数组;

(逻辑上把数组看成一个具有行和列的表格或一个矩阵);

语法:

类型名 数组名[常量表达式1][常量表达式2]

二维数组的引用:

引用二维数组元素时必须带有两个下标,引用形式如下:

例如:

int a[3][4]; 引用:

- 10点睛Spring4.1-Application Event

wiselyman

application

10.1 Application Event

Spring使用Application Event给bean之间的消息通讯提供了手段

应按照如下部分实现bean之间的消息通讯

继承ApplicationEvent类实现自己的事件

实现继承ApplicationListener接口实现监听事件

使用ApplicationContext发布消息

和输入

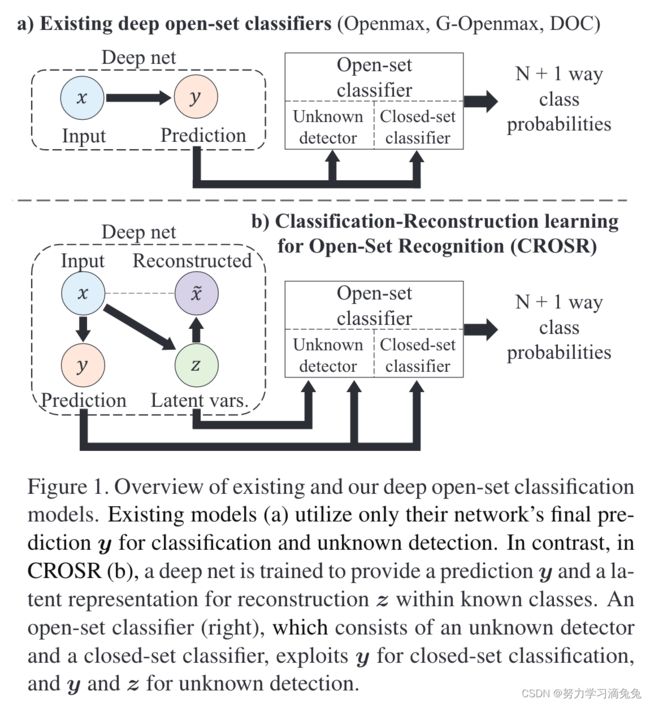

,

![]() 的最佳表示。尽管监督网络中的AV经过优化以给出正确的

的最佳表示。尽管监督网络中的AV经过优化以给出正确的![]() ,但它们没有对

,但它们没有对![]() 的信息进行编码,并且不足以测试

的信息进行编码,并且不足以测试![]() 本身是否在

本身是否在![]() 中。本文通过利用重建潜在表示来缓解这个问题,它对x进行了更多编码。

中。本文通过利用重建潜在表示来缓解这个问题,它对x进行了更多编码。![]()

![]()

![]()

![]()

![]() 表示y和z向量的串联,

表示y和z向量的串联,![]() 表示它们在类

表示它们在类![]() 内的平均值。

内的平均值。![]() 中提取了一系列潜在表示

中提取了一系列潜在表示![]() ,这些潜在表示称为瓶颈。这种体系结构的优点是,它可以检测隐藏在输入数据中但在推理链中间消失的外围因素。由于我们无法假定外围因素最明显的阶段,我们通过简单地将

,这些潜在表示称为瓶颈。这种体系结构的优点是,它可以检测隐藏在输入数据中但在推理链中间消失的外围因素。由于我们无法假定外围因素最明显的阶段,我们通过简单地将![]() 从层中串联起来来构造未知检测器

从层中串联起来来构造未知检测器![]() 的输入向量。这里,

的输入向量。这里,![]() 可以被解释为分解因子来生成

可以被解释为分解因子来生成![]() 。打个比方,使用分解的潜在表示进行未知检测类似于大修机械产品,将

。打个比方,使用分解的潜在表示进行未知检测类似于大修机械产品,将![]() 分解为

分解为![]() 等零件,调查零件是否存在异常,并将其重新组装到

等零件,调查零件是否存在异常,并将其重新组装到![]() 中。

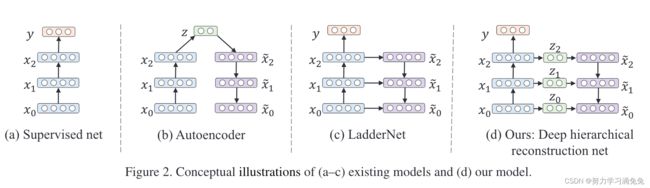

中。![]() 之外,没有用于异常值检测的有用因子,因为

之外,没有用于异常值检测的有用因子,因为![]() 通常具有已知类别分类的高维性。使用自动编码器(b)是一种引入潜在表示进行重建的简单方法,但在使用它们进行开集分类时存在一个问题。深度自动编码器逐渐降低中间层

通常具有已知类别分类的高维性。使用自动编码器(b)是一种引入潜在表示进行重建的简单方法,但在使用它们进行开集分类时存在一个问题。深度自动编码器逐渐降低中间层![]() 的维数用于有效的信息压缩,这不适合大规模闭集分类,因为它需要所有层中相当多的神经元来学习丰富的特征层次。LadderNet(c)可以被视为自动编码器的变体,因为它执行重建。然而,区别在于横向连接,

的维数用于有效的信息压缩,这不适合大规模闭集分类,因为它需要所有层中相当多的神经元来学习丰富的特征层次。LadderNet(c)可以被视为自动编码器的变体,因为它执行重建。然而,区别在于横向连接,![]() 的一部分通过横向连接流向重建流,而无需进一步压缩。它们的作用是进行详细的抽象分解;也就是说,LadderNet在主流中编码抽象信息,在横向路径中编码细节。虽然这对于开放集分类更为可取,因为未知的外围因素可能在细节和摘要中,但LadderNet本身并不提供紧凑的潜在变量。DHRNet(d)通过压缩表示

的一部分通过横向连接流向重建流,而无需进一步压缩。它们的作用是进行详细的抽象分解;也就是说,LadderNet在主流中编码抽象信息,在横向路径中编码细节。虽然这对于开放集分类更为可取,因为未知的外围因素可能在细节和摘要中,但LadderNet本身并不提供紧凑的潜在变量。DHRNet(d)通过压缩表示![]() 中的横向流,进一步增强了分解信息对未知检测的有效性。

中的横向流,进一步增强了分解信息对未知检测的有效性。![]()

![]()

![]()

![]() 表示网络中的特征变换块,

表示网络中的特征变换块,![]() 表示非线性降维操作,包括ReLU和卷积层,而

表示非线性降维操作,包括ReLU和卷积层,而![]() 表示重新投影到

表示重新投影到![]() 的原始维数。

的原始维数。![]() 和

和![]() l对类似于自动编码器。

l对类似于自动编码器。![]() 是自顶向下信息

是自顶向下信息![]() 和横向信息

和横向信息![]() 的组合。图3说明了这些操作,操作堆栈给出了图2(d)所示的整个网络。

的组合。图3说明了这些操作,操作堆栈给出了图2(d)所示的整个网络。