Text-Instance Graph: Exploring the Relational Semantics for Text-based Visual Question Answering

Text-Instance Graph: Exploring the Relational Semantics for Text-based Visual Question Answering

文章目录

- Text-Instance Graph: Exploring the Relational Semantics for Text-based Visual Question Answering

-

- Abstract

- 1. Introduction

- 2. Related works

-

- 2.1. Visual Question Answering

- 2.2. Text-based Visual Question Answering

- 3. Proposed Method

-

- 3.1. Multimodal Features Extraction.

- 3.2. Dynamic OCR-OBJ Graph Network

- 3.3. Transformer Decoder

- 4. Experiments

-

- 4.1. Datasets

- 4.2. Experiment setting

-

- 4.2.1. Evaluation metrics

- 4.2.2. Implementation details

- 4.3. Performance comparison

- 4.4. Ablation study

- 4.5. Qualitative analysis

- 5. Conclusions

Abstract

是时候停止忽视你周围的文字了。在VQA中,周围的文本可以帮助人类有效地理解完整的视觉场景和推理问题语义。在这里,我们讨论了具有挑战性的基于文本的可视化问答(TextVQA)问题,它需要一个模型来回答具有文本阅读能力的VQA问题。现有的TextVQA方法主要关注检测到的对象实例与给定问题的场景文本之间的潜在关系,而忽略了视觉对象实例与OCR文本之间的空间位置关系和复杂的关系语义(例如,C上B的A)。为了应对这些挑战,我们为TextVQA提出了一种新的文本实例图(TIG)网络。TIG构建了一个用于重叠关系建模的OCR-OBJ图,图中的每个节点都通过使用相对对象或OCR文本进行更新。为了解决逻辑复杂的问题,我们提出了一种动态OCR-OBJ图网络来扩展图节点的感知空间,它能够掌握非直接相邻节点的特征信息。考虑到“桌上电脑的品牌”的场景,该模型将使用“电脑”节点作为中间节点,在“品牌”和“桌子”之间建立关联。在三个基准上的大量实验证明了该方法的有效性和优越性。此外,我们的TIG在ST-VQA挑战排行榜上达到了0.505 ANLS,创造了一个新的先进水平。

1. Introduction

基于文本的视觉问答(TextVQA)在先进的视觉和语言学习方法上迈出了一大步[1,2,3,4,5]。作为VQA[6,7,8,9,10]的一个新分支,TextVQA是一个新的挑战,它需要探索图像中呈现的场景文本的语义,并支持VQA在现实世界场景中的应用,例如残疾人或儿童智能助手。与VQA类似,TextVQA的目标是根据给定的图像提供问题的正确答案。然而,关键是将视觉场景和文本内容理解为图像中出现的视觉和语义线索。这就要求该模型能够学习多个领域的知识,如目标检测、文本识别和多模态推理。基本上,TextVQA为计算机系统提供了基本的读取能力,目前这是机器智能的一个开放问题。TextVQA任务被视为视觉问答的一个新分支,因此一些早期研究试图通过引入经典的15 VQA方法来解决这个问题[11]。然而,目前的VQA模型侧重于探索视觉对象之间的关系,只能识别图像中的视觉对象和简单关系。因此,有些方法在遇到基于文本的问题时可能会失败。为了解决这个问题,基于文本的检测方法应该集成到VQA框架中。几种ex-20 isting TextVQA方法[12、13、14]主要采用提取的OCR标记,并构建一个图形来建模OCR文本和视觉对象之间的关系。然而,它们在图形中的许多建模关系都是冗余的,无法对视觉对象和OCR文本之间复杂的逻辑关系进行建模,从而获得区分特征。

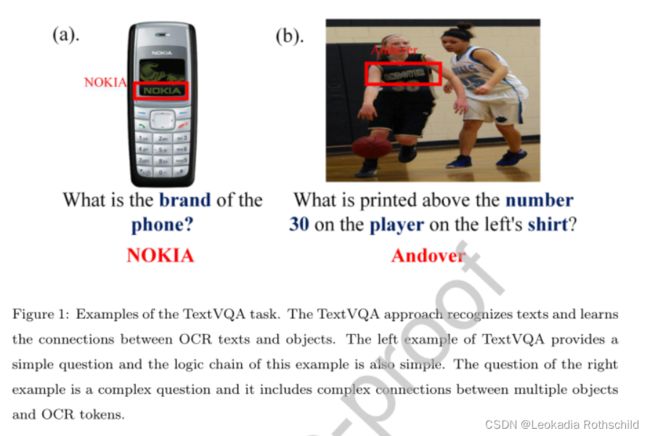

值得注意的是,大多数现有方法忽略了文本和对象之间的基本关系,尤其是OCR标记和视觉对象之间的重叠关系。重叠的OCR文本可能反映对象的某些属性,例如“手机品牌”、“书名”。在现实生活中,重叠关系是稀疏的,这使得模型很容易获得TextVQA任务的更相关的图形节点特征,如图1中的示例(a)。此外,当前的方法通常使用最近的节点来更新其图节点特征,这无法处理示例(b)等组合关系。图1中的“左边球员球衣上数字30上方打印的内容”。扩展35个图形节点的感知空间是处理需要复杂位置逻辑的问题的一种好方法,它使模型能够学习OCR标记和对象之间的逻辑关系。此外,问题信息对于问题回答非常重要,它为模型推理提供了问题线索。TextVQA模型在不同的问题条件下采用不同的关系来帮助推理。40因此,应将问题条件信息添加到图表中,以辅助推理。

图1:TextVQA任务的示例。TextVQA方法识别文本并学习OCR文本和对象之间的连接。TextVQA的左边示例提供了一个简单的问题,这个示例的逻辑链也很简单。正确示例的问题是一个复杂的问题,它包括多个对象和OCR标记之间的复杂连接。

在本文中,我们提出了一种新的结构文本实例图(TIG)网络来应对TextVQA任务的挑战。具体来说,TIG模型提取OCR文本和object45实例之间的重叠关系。如果对象实例与OCR文本重叠,则OCR文本和对象被视为关联。因此,我们基于视觉对象和OCR文本之间的重叠关系构建了一个OCR-OBJ图,使得图节点只与其最近的邻居有关联关系,而不是图像中的所有实例。然后根据OCR-OBJ图和问题信息,提出了一个动态的C50 OCR-OBJ图网络来解析复杂的关系语义。它生成一个方向语义节点特征,并学习多模态图中的长程关联,用于解决复杂问题。最后,采用变压器解码器生成可变长度的答案。

总之,我们强调TIG的贡献如下:

- 我们根据TextVQA的特点,利用对象和文本之间的重叠关系,并构建OCR-OBJ关联图来建模多模态关系,这使得图形的连通性变得稀疏,更新后的图形功能对TextVQA更具代表性

- 我们提出了一种称为文本实例图(TIG)网络的新框架,该网络基于问题线索沿OCR-OBJ图进行推理。它扩展了图节点的感知空间,学习了多步位置逻辑,使生成的图节点具有更强的方向性,并擅长解决复杂问题。

- 定量实验在三个主要基准上进行:TextVQA、ST-VQA和OCR-VQA。实验结果证明了TIG的改进。值得注意的是,我们的TIG在ST-VQA挑战排行榜上达到了0.505 ANLS,并创造了一个新的先进水平。

2. Related works

在本节中,我们首先回顾有关视觉问答(VQA)的相关工作[15,16,17]。然后我们回顾了基于文本的视觉问答(TextVQA)[13,12,18]的最新进展。

2.1. Visual Question Answering

最近,有许多通用的视觉问答方法使用注意机制[11]和图形神经网络。

-

Attention-based VQA methods. 注意机制的基本目的主要是迫使模型关注重要的对象,而忽略不相关的对象。基于注意力的VQA代表性方法包括80[6,3,19]。具体来说,Anderson等人[11]提出了一种自上而下的注意方法,该方法使用问题作为条件信息,并为图像中的对象区域分配权重。然后利用加权视觉区域特征预测答案。然而,当一个复杂的问题需要多步推理时,单步注意过程并没有达到令人满意的结果。为了解决这个问题,模块化协同注意网络(MCAN)[20]设计了一个模块化协同注意层,将有问题的关键词与图像中的关键对象相关联。然后将几个模块化的共同注意层级联在一起,模拟人类的多步骤推理,以获得最终答案。虽然注意机制是捕捉重要信息的好方法,但在图像中构建实例的复杂关系并不是一个好主意。

-

Graph-based VQA methods 图形结构能够很好地建模问题词和视觉对象之间的关系,提供结构化信息,并能更好地显示问题回答的推理过程。许多作品[21,6,22]都依赖于图形结构来解决问题。Teney等人[21]构建了两个图表,以利用图像中出现的单词和对象之间的关系。Li等人[6]将图像编码成图形。然后通过图形注意机制对多类型对象间关系进行建模,学习问题自适应关系表示。Li et100 al.[22]从图像中提取场景图,该图像提供了提供重要线索的结构化信息。然而,上述方法在遇到基于文本的VQA时会严重退化。这是因为这些方法缺乏基于文本的识别建模。

2.2. Text-based Visual Question Answering

现有的TextVQA方法采用了一种级联策略,即首先从图像中提取OCR标记,然后用这些标记应用一个可视化的问答模型。例如,LoRRA[12]首先将OCR令牌引入Pythia模型,并设计了一个OCR注意模块来帮助回答问题。该模型被允许从图像中复制一个OCR标记作为答案。然而,LoRRA忽略了OCR文本和视觉对象之间的关系,这对TextVQA任务很重要。Mishra等人[18]使用文本块提取方法来提取文本信息,包括每个图像的边界框、文本和NER标记。然后将视觉特征、问题信息和文本信息连接到-115 gether,预测最终答案。该模型与LoRRA模型类似,但它利用了额外的NER标签信息来回答基于文本的问题。然而,它仍然不接受任何关系。

多模式多副本网格(M4C)[13]采用了一种转换器结构来学习问题信息、区域视觉表示和OCR标记的联合交互。然后采用120迭代解码器生成可变长度的答案。然而,他们的大部分完全连接的关系都是丰富的关系,并且没有探索关键的关系。为了建立OCR标记和对象之间的关系,多模态图神经网络(MM-GNN)[14]构建了一个图网络,以探索TextVQA的潜在关系。然而,125MM-GNN只进行了一步图推理,每个节点的关联长度为1。因此,它只能解决简单的问题,无法理解复杂的逻辑推理。总之,上述所有方法都通过将OCR令牌集成到其VQA模型中解决了TextVQA问题。但他们忽略了130个检测文本和对象之间的关键关系,并且很难推断图像中的复杂关系。为了解决这个问题,我们提出了一个模型来探索对象和OCR文本之间的关键关系。

3. Proposed Method

在图2中,我们展示了我们提出的被称为文本实例图(TIG)网络的方法的概述。我们提出的TIG模型由三个主要部分组成:

1)多模态特征提取,它提取多模态特征,包括图像对象特征、OCR文本特征和问题信息;

2) 动态OCR-OBJ图形网络,在OCR标记和对象之间建立关联,扩展图形节点的感知空间;

3) Transformer Decoder,在问题功能、OCR文本、视觉对象之间建立交互,并生成最终答案。TIG中每个组件的详细信息见以下章节。

3.1. Multimodal Features Extraction.

问题编码。给定一个问题W=[w1,…,wK],我们用等式1将其编码为语义特征矩阵Q。其中BERT是一名经过预训练的语言模型将单词转换成句子。

![]()

然后采用线性变换层和分层形式层将问题投影到语义空间进行后续计算,并将其表示为等式。2:

式中,Wq表示可学习参数,所有方程式中brevity145的偏差均被忽略。

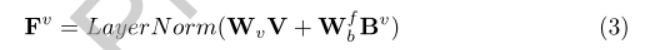

- Visual Object Encoding. 给定图像I,使用预先训练好的FasterRCNN从图像中提取前M个候选对象及其对应的框,它们表示为:V={v1,…,vM}∈ R M × d v R^{M×dv} RM×dv和Bv={bv1,…,bvM}∈ R M × 4 R^{M×4} RM×4。然后,我们使用线性变换将视觉对象特征V和坐标箱特征Bv融合在一起。因此,可以通过等式3生成对象编码Fv。

其中Wv和Wf b是可学习的参数。为了保证训练的稳定性,采用了分层规范化的方法。

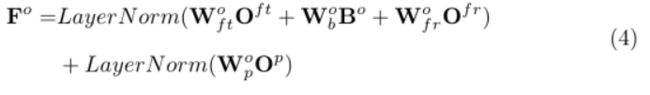

- OCR Text Encoding 预先训练的Rosetta[23]被用作OCR检测器,用于检测N个OCR令牌O={o1,…,oN},以及它们相应的坐标框Bo={Bo 1,…,boN}∈ R N × 4 R^{N×4} RN×4。对于每个OCR标记oi,我们使用FastText[24]模型来提取t={Of T1,…,Of TN}的OCR文本表示∈ R N × d f t R^{N×dft} RN×dft和字符金字塔直方图(PHOC)提取字符级表示Op={op1,…,opn}∈ R N × d p R^{N×dp} RN×dp。此外,采用更快的RCNN模型提取OCR标记的视觉表示,如r={r 1,…,r N}∈ R N × d f r R^{N×dfr} RN×dfr 。最后,通过将文本表示、OCR坐标框、OCR标记视觉表示和字符级表示结合起来,得到最终的OCR文本表示,如下所示:

其中Wof t、Wob和Wof r是可学习的参数。为了保证训练的稳定性,OCR文本特征编码器也采用了层规范化的方法。

3.2. Dynamic OCR-OBJ Graph Network

在本节中,我们将介绍所提出的动态OCR-OBJ图网络。具体来说,它包括两个步骤:

1)OCR-OBJ图构建,在其中构建所有节点(即OCR文本和对象实例)之间的关系;

2) 动态OCR-OBJ图自适应,它将所有可能的关系集成到所有节点的表示中,以进行进一步的答案推理。

-

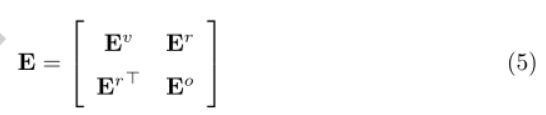

OCR-OBJ Graph Construction为了在OCR文本和图像中的对象之间建立关联,我们构建了一个无向OCR-OBJ图G={X,E}。X=[Fv,Fo]∈ R(M+N)×d表示OCROBJ图的节点,该图包含OCR文本特征和对象外观特征。E∈ R(M+N)×(M+N)表示OCR-OBJ图的边,它包含三种边:OBJ-OBJ边Ev、OCR-OCR边Eo和OCR-OBJ边Er。形式上,边的表示可以用矩阵来表示,并且可以用等式5来表示。

通过观察TextVQA样本,我们发现,如果文本边界框与某个对象重叠,那么该对象和文本很可能是相关的。重叠的文本可能反映了对象的某些属性。受此启发,我们将OCR-OBJ边缘矩阵Er定义为重叠关系。更具体地说,如果第i个节点和第j个节点的IoU分数大于0,则OCR-OBJ边缘矩阵中的对应元素eri,j设置为1.否则对象和OCR标记不关联,对应的边缘为0。

对于OBJ-OBJ边矩阵Ev,它可以用一个矩阵表示,因为任何两个对象都存在关系

对于OCR-OCR边缘矩阵Eo,我们采用相同的策略,并将其设置为矩阵。 -

Dynamic OCR-OBJ Graph Adaption为了推断出准确的答案,需要考虑相关的关系,例如问题与被检测节点之间的关系,以及被检测节点之间的长期关系。为了实现这一点,我们设计了动态OCR-OBJ图自适应,它由一堆问题引导关系编码器(QGR)组成。特别是,问题引导关系编码器在相关问题线索和相关节点的帮助下同时更新每个节点表示。然后,动态OCR-OBJ图形自适应堆叠模型将长程线索(例如,B对C的A,A-C关系)编码到每个节点表示中。接下来,我们将介绍该模块的详细信息,如下所示。

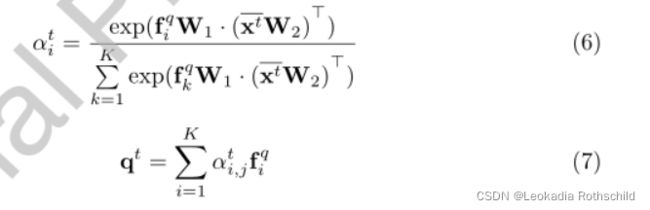

给定节点表示Xt和问题表示Fq,QGRE通过等式6计算每个问题词的权重。其计算过程如下:

其中,fqi指问题表征Fq中的第i个单词特征。xt是通过均值运算从所有节点特征xt聚合而来的全局表示。W∗ 表示可学习的参数。然后,通过Equ生成相关的问题线索。7.接下来,通过组合相关问题线索来更新节点表示,如等式8所示.之后,QGRE编码器通过利用E中定义的节点关系进一步增强节点表示。这可以通过等式10到等式12实现。

其中γti,j表示节点j对节点i贡献的注意权重,[,]表示串联操作。LeakReLU是一个激活函数,是ReLU的变体。除了视觉外观,每个节点还通过问题及其相邻节点同时编码关系,这有助于增强复杂上下文(即问题、OCR文本和视觉内容)理解的表示能力。此外,剩余连接也用于训练稳定性。为了简单起见,我们将上述问题引导关系编码器的过程表述为等式13

为了在节点之间建立远程关联,我们借鉴GRU的思想,通过堆叠多个QGRE编码器来设计动态OCR-OBJ图自适应,其中每个QGRE编码器将上一个编码器中更新的节点特征作为输入。形式上,我们将X表示为初始节点特征X0。J控制感知空间的大小。假设有J个QGRE编码器堆叠在一起,编码所有可能关系(即与问题的关系、短期节点和长期节点)的最终节点表示可以用XJ表示。

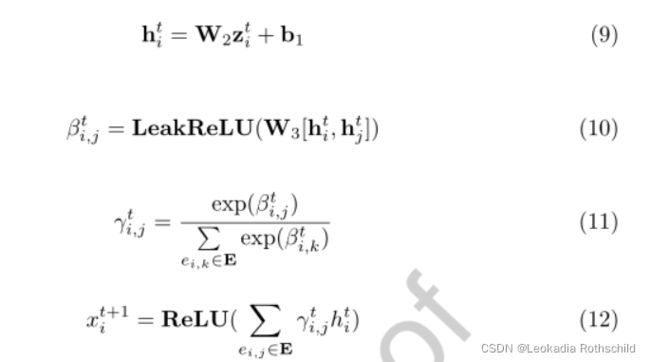

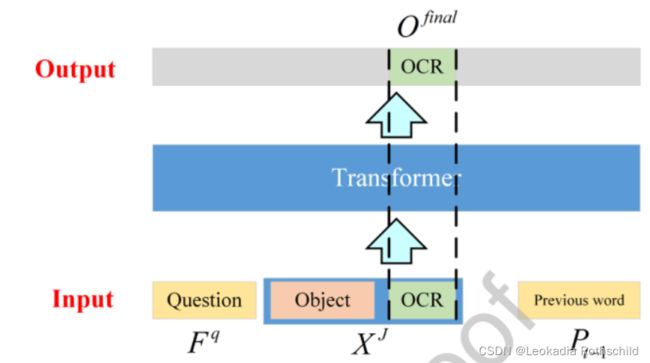

3.3. Transformer Decoder

在这一部分中,我们提出了一个转换器解码器,它由几个转换器层组成[25],并以迭代方式生成应答令牌。具体地说,通过利用问题特征、更新的图节点特征XJ和预先估计的答案标记Pt来推断每个答案标记−1,其中t是答案解析步骤的索引。形式上,我们将P0表示为初始答案标记,并将其设置为“”表示答案的开始。transformer译码的过程可以表示为等式14:

![]()

其中,[,]表示串联操作。使用transformer decoder feature Ffinal t,可以通过解码器feature Ffinal t的最后一个特征向量xdect预测下一个应答令牌,定义如下:

Wdec在哪里∈ Rd×ans len表示答案词汇分类器参数。ans len是答案词汇的长度。

之前的研究[26]表明,除了答案词汇,OCR文本中还会出现一些答案标记。为了解决这个问题,我们借用了[26]中介绍的想法,选择OCR文本的片段作为答案标记。此外,transformer解码器分析OCR文本的内容,并决定是否复制OCR作为应答词。

我们选择的更新OCR特征O final t∈ R N × d R^{N×d} RN×d 根据输入OCR特征的索引,从转换器解码器特征Ff final t得到 R N × d R^{N×d} RN×d,如图3所示。因此,我们定义了复制机制分类器,OCR令牌分布yocrt计算如下:

![]()

其中,W ocr dec和W dec dec是需要学习的参数。最终的应答令牌分布是应答vo-cabulary分布和OCR令牌分布的串联,如下所示:

![]()

在步骤t中,我们对答案令牌分布进行argmax操作,并选择最高分的单词作为答案令牌。此外,在训练阶段,使用二进制交叉熵损失作为损失函数。在推理阶段,当模型生成“”To-ken时,trans-former解码器停止,这意味着答案的结束。

4. Experiments

实验为了评估所提出的方法,我们在三个数据集上进行了实验。此外,还进行了烧蚀研究,以验证TIG模型中各成分的影响。最后,展示一些样本进行定性分析。

4.1. Datasets

TextVQA数据集Singh等人[12]是第一个发布的基于文本的可视化问答数据集。它包含45336个问题和28408个自然图像。该数据集的图像选自Open Image v3,每个问题都附有10个带注释的答案。我们遵循标准的train/valid/测试划分,34602个样本用于培训,50个样本用于验证,5734个样本用于测试。场景文本视觉问答(ST-VQA)Biten等[27]旨在强调文本线索在视觉问答中的重要性。ST-VQA包含23038张图片和相应的31791个问题。其图像来自6个数据集:COCO文本、视觉基因组、VizWiz、ICDAR、ImageNet和IITT-STR。该数据集分为19027个图像和26308个训练问题、2993个图像和4163个测试问题。测试集的基本事实尚未公布,因此我们需要将结果上传到在线服务器以评估性能。OCR-VQA数据集Mishra等人[18]包含207572张封面图片和100万对问答。我们使用OCR-VQA[13]中的前几次分割进行公平比较,将数据集分成80%的图像问题对进行训练,10%用于验证,10%用于测试。与TextVQA和ST-VQA数据集相比,OCR-VQA数据集中的图像更简单,每个图像只包含一个带有一些相关文本的书皮,例如书的“标题”和“作者”。

4.2. Experiment setting

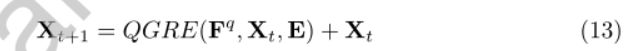

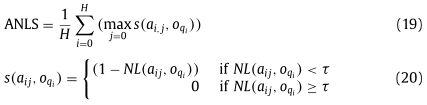

4.2.1. Evaluation metrics

为了评估TextVQA模型生成的答案的质量,我们使用准确度(Acc)作为主要评估指标。在前面的方法[28]之后,我们使用与VQA[28]相同的精度计算过程,如下所示:

![]()

这意味着,当模型预测的答案与人类注释的答案至少一致3次时,评估标准将给出完整的命中分数。否则,只能获得部分分数,并尽可能避免偏差。平均归一化Levenshtein相似度(ANLS)是文本匹配的另一个度量,也是ST-VQA的一个关键评估度量。本文在ST-VQA数据集上计算精度和ANLS,以进行公平比较。ANLS的定义如下:

其中H和G分别表示问题总数和每个问题的基本事实答案总数。ij代表第i个问题的第j个答案,其中i={0,…,H}和j={0,…,G}。o q i是问题的模型预测答案。NL(aij,oqi)是字符串aij和oqi之间的标准化Levenshtein距离。τ在我们的设置中为0.5。即使预测的回答部分与地面真相答案重叠,ANLS仍然会给这个预测答案一定的分数。与精度度量相比,ANLS更灵活、更实用。

4.2.2. Implementation details

对于目标检测,我们采用预先训练的快速RCNN[29],并将其应用于从图像中预测目标(最多100个),得到每个目标2048维的特征向量。为了识别图像中的文本,我们使用预先训练好的Rosetta模型[23]。对于每个OCR标记,我们使用FastText[24]将其文本嵌入300-d特征向量,并使用更快的RCNN提取2048-d视觉特征。对于每个问题,我们将其截断或填充成一个固定长度的序列。然后,我们使用一个三层的BERT模型来提取其语义嵌入,这是预训练的BERT-BASE模型的前三层。我们在训练过程中确定了它的参数,并将其视为更快的RCNN的文本特征提取器。每个问题词都表示为768-d特征向量。QGRE层J的数量,作为感知空间大小,在我们的实现中设置为1。在训练阶段,我们使用Adam[30]作为优化方法,并将学习率设置为5×10−4.为了探索不同的答案模块,我们采用了两种不同的答案生成器:clas-sifier和迭代解码器进行了实验。这部作品的代码已被重新出租。

4.3. Performance comparison

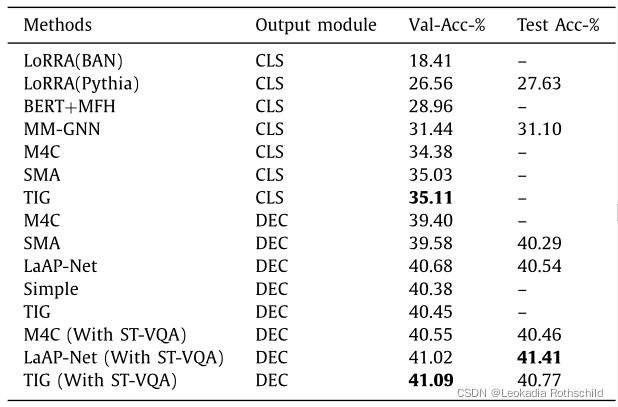

在本节中,我们将介绍三个基准点的比较结果:TextVQA、ST-VQA和OCR-VQA。在TextVQA上的结果我们将TIG与几种最先进的方法进行了比较,包括LoRRA[12]、BERT+MFH[31]、MM-GNN[14]、M4C[13]、SMA[32]、LaAP Net[33]和TextVQA数据集上的Simple[34]。

表1与TextVQA数据集上最新方法的比较。CLS de-notes分类器应答生成器和DEC意味着作为应答生成模块的迭代解码器。“使用ST-VQA”指使用ST-VQA培训数据进行数据论证。

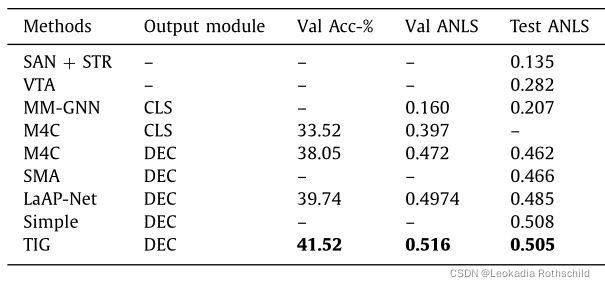

实验结果如表1所示。可以观察到,我们的TIG在使用分类器时达到了最佳性能,在使用迭代解码器作为答案生成器时达到了可比的结果。此外,我们发现使用信息运算解码器的方法优于使用分类器的方法。它表明迭代解码器更适合于解码现实生活问题的答案。具体来说,当TIG模型采用分类器作为应答解码器时,其在验证集上的准确率为35.11%,达到了最佳效果。当使用迭代解码器作为输出模块时,TIG在验证集上也达到了类似的精度40.15%。它的性能优于Simple[34],略微有0.07%的利润,比LaAP Net[33]差0.13%。通过对ST-VQA数据的数据论证,取得了显著的改进。与M4C和LaAP网络相比,TIG的准确度在有效性上比M4C和LaAP网络高0.54%和0.07%。但是,它在测试集上的性能比LaAP网络差,原因可能是LaAP网络使用OCR令牌空间位置作为另一种监督信息。然而,与现有技术相比,提议的TIG取得了可比的结果, 这证明了所提出的动态OCR-OBJ图在TextVQA数据集上的积极有效性。结果在ST-VQA上,我们将TIG模型与SAN+STR[35]、VTA[36]、MM-GNN[14]、M4C[13]、SMA[32]、LaAP-Net[33]和Simple[34]进行了比较。考虑到基于解码器的方法在很大程度上优于基于分类器的方法,不再测试带有分类器的TIG模型。为了与之前的工作进行公平比较[13,27],在ST-VQA数据集上计算精度和ANLS。

表2与ST-VQA数据集上最新方法的比较。CLS de-notes答案分类器和DEC表示迭代解码器。

如表2所示,TIG在精度和ANLS方面都达到了最佳性能。在实验中,TIG、SMA[32]和MM-GNN[14]都利用图形结构来建模关系。然而,MM-GNN和SMA在语义层面上采用图卷积来建模关系,忽略了OCR文本和对象之间的空间关系。因此,与MM-GNN和SMA相比,TIG模型在ANLS上实现了0.298和0.043的改进。它证明了所提出的动态OCR-OBJ图网络的有效性。M4C和TIG采用转换器与多个概念交互并生成可变长度的答案。借助OCR文本和对象之间的关联图,TIG比M4C的准确率高出3.47%,验证集的ANL为0.044,测试集的ANL为0.043。此外,TIG在ST-VQA数据集上的精度和ANLS方面都优于LaAP Net和Simple方法,这表明了所提出的动态OCR-OBJ图在该数据集上的优越性。值得注意的是,TIG在ICDAR挑战2019排行榜的ST-VQA上达到了0.505 ANLS,并在首次上传其结果时创造了一个新的水平。结果在OCR-VQA上,我们还将我们的模型与OCR-VQA数据集上的CNN[37]、BLOCK、M4C[13]和LaAP Net[33]进行了比较,结果如表3所示。总的来说,TIG在验证集和测试集上都达到了最佳性能。具体而言,CNN模型是一种经过预训练的VGG-16卷积神经网络,它可以通过提取视觉外观来直接预测答案。BLOCK只捕获作为答案的文本信息。W2V表示OCR文本的word2vec向量。单一的视觉外观或文本特征无法为TextVQA提供足够的线索。但当CNN、BLOCK和W2V结合在一起时,它的性能会更好。我们提出的TIG模型优于组合方法,因为它们在推理过程中忽略了OCR-OBJ的空间关系。此外,TIG在OCR-VQA验证集和测试集上的表现优于M4C,分别为0.7%和0.3%。此外,在val和测试集上,TIG比LaAP-Net[33]分别提高了0.4%和0.1%,这表明TIG比OCR-VQA数据集上的LaAP-Net更能捕捉书皮和文本之间的关系。

表3在OCR-VQA数据集上与最新方法的比较。CLS表示答案分类器,DEC表示迭代解码器。

4.4. Ablation study

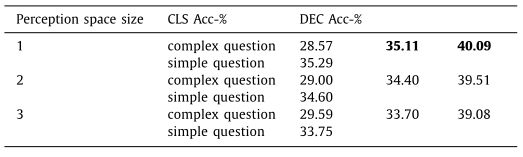

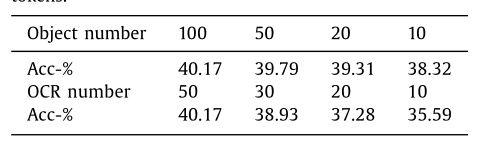

在本节中,我们在TextVQA数据集上进行消融研究,以研究OCR-OBJ图形网络在TIG模型中的作用。感知空间大小的影响:我们评估感知空间大小的影响,感知空间大小通过QGRE层数控制OCR-OBJ图形节点的感知空间。J值越高,模型就能掌握更多的方向性线索,用复杂的逻辑回答问题。TextVQA数据集并没有根据每个问题的复杂性进行划分。为了便于比较,我们根据问题的长度将验证集分为两个子集。很明显,如果问题的长度很长,问题可能会很复杂。受此启发,我们将长度阈值设置为11,即问题长度的中位数。因此,如果问题长度超过阈值,则被视为复杂问题(294个样本),否则为简单问题(4706个样本)。结果如表4所示。显然,我们发现TIG在简单问题上取得了更好的性能。明确地 ,当感知空间J的大小等于1时,TIG在简单问题上的表现最好。当进一步增加到2或3时,TIG对复杂问题的准确度提高,而对简单问题的准确度略有下降。考虑到复杂问题的数量远少于简单问题,复杂问题带来的改进无法弥补简单问题带来的准确性下降。因此,最终精度略有下降。总之,J值越高的TIG模型越适合解决复杂问题,而J值越低的TIG模型越适合解决简单问题。当J等于1时,它在TextVQA数据集上表现最好,我们在TIG模型中将其设置为1。结果表明,我们的动态OCR-OBJ图网络成功地建立了远程关联,而具有更大感知空间的TIG模型在复杂问题上取得了更好的性能。OCR-OBJ子边矩阵的影响如上所述,OCR-OBJ图的边矩阵E包含三个边矩阵:OBJ-OBJ矩阵EV、OCR-OCR矩阵EO和OCR-OBJ矩阵ER。因此,我们设计实验来研究提出的OCR-OBJ相关边缘的影响。表5给出了TextVQA数据集验证集的结果。具体来说,基线模型采用transformer解码器直接生成答案,无需建立图。该算法在分类器上的识别率为31.63%,在解码器上的识别率为39.19%。与基线模型相比,该模型在使用任何类型的关系图(OCR-OBJ、OBJ-OBJ、OCR-OCR)时都取得了改进。其次,结合OBJ-OBJ边缘EV和OCR-OCR E o的模型可以进一步获得更高的精度。此外,我们还将OCR-OBJ边缘E r替换为1个OCR−OBJEdge,所有人的矩阵。与EV+EO相比,使用分类器的识别率为33.85%,使用运算解码器的识别率为39.45%。全TIG模型在分类器上的识别率为35.11%,在解码器上的识别率为41.09%。与具有OCR-OCR边缘和OBJ-OBJ边缘的模型相比,TIG模型在分类器和解码器上分别实现了1.74%和0.16%的显著改进。证明了在TextVQA设置下,OBJ-OBJ、OCR-OCR和OCR-OBJ之间的关系有利于解析正确答案,尤其是OCR-OBJ之间的关系。不同数量的视觉对象和OCR标记的影响从图像中提取的视觉对象和OCR标记被用作回答问题的线索。它们的数量代表了线索的多样性,我们设计实验来验证不同数量的视觉对象和OCR标记的效果。具体来说,我们使用10 0、50、20和10测试不同的视觉对象编号,同时将OCR标记的数量固定为50。我们还将不同的OCR令牌编号设置为50、30、20和10,同时将可视对象的编号固定为10。实验结果如表6所示。显然,当模型选择最大对象数和OCR令牌数时,该模型达到了最佳性能,这表明更多的视觉和文本线索更有利于TextVQA任务。此外,我们发现,当目标数量从10 0减少到50时,TIG模型的精度略有下降。但是,当这个数字从50下降到10时,下降会更加明显 .这意味着TextVQA任务需要足够的视觉对象来支持推理。对于OCR标记号,我们发现OCR标记在TextVQA任务中起着至关重要的作用,甚至比视觉对象更重要。当OCR数字从50减少到10时,它会严重下降,这与TextVQA任务的初始动机一致。

表5图表对TextVQA数据集的影响。lOCR−OBJEdge表示OCR-OBJ边缘被一个矩阵替换。

表6不同数量的视觉对象和OCR标记的效果。

4.5. Qualitative analysis

在本节中,我们将展示几个实验结果的可视化示例,如图4所示。具体而言,将显示六个典型问题及其OCR-OBJ关联图。我们可以观察到,我们的方法成功地预测了前五个例子中的正确答案。作为第一个简单的例子,TIG模型理解视觉信息和相关OCR文本的内容,并预测问题的正确答案。对于第二个例子中形象复杂的问题,TIG模型根据问题线索找到“品牌”。然后,与“品牌”重叠的OCR标记“雅马哈”被视为答案。因此,我们的模型能够找到基本对象,并使用重叠关系来辅助推理。此外,第三个例子是TIG模型在遇到复杂问题时取得了成功。该算法对对象节点“冰箱”的感知进行了预测,正确地找到了推理路径“冰箱-贴纸-警告”。此外,我们发现TIG模型也能很好地解决位置问题,TIG模型主要关注问题的位置词,如第四和第五个例子中的“左”、“下”。根据这些文字,TIG模型将对象“左边的盒子”、“横幅底部”正确定位。然而,提出的模型仍然无法解决“位置字母”问题,即询问单词某些位置的字母或数字。由于当前模型无法理解OCR标记中字符之间的序列关系,TIG模型无法压缩序号。

5. Conclusions

这项工作中,我们提出了一种新的基于文本的可视化问答文本实例图网络。我们的主要想法是利用OCR文本和物体姿态之间的重叠关系。该算法基于视觉对象和OCR文本之间的重叠关系构建OCR-OBJ图,并采用动态OCR-OBJ图网络根据OCR-OBJ图推理长程关联。在TextVQA、ST-VQA和OCR-VQA数据集上的实验结果表明,我们的TIG显著优于最先进的方法。此外,TIG模型也存在一些缺点和局限性。在现实世界中,OCR和OCR之间的关系不是完全相连的关系,它们仍然存在一些位置关系。例如,如果一个品牌由多个OCR字符串组成,根据人类的阅读习惯,通常会有一些顺序关系,例如从左到右或从上到下,这很容易避免错误的顺序关系。我们可以利用人类阅读的这些特点作为先验知识,继续提高TIG模型的效果。