神经网络图像识别技术,神经网络与图像识别

如何通过人工神经网络实现图像识别

。

人工神经网络(ArtificialNeuralNetworks)(简称ANN)系统从20世纪40年代末诞生至今仅短短半个多世纪,但由于他具有信息的分布存储、并行处理以及自学习能力等优点,已经在信息处理、模式识别、智能控制及系统建模等领域得到越来越广泛的应用。

尤其是基于误差反向传播(ErrorBackPropagation)算法的多层前馈网络(Multiple-LayerFeedforwardNetwork)(简称BP网络),可以以任意精度逼近任意的连续函数,所以广泛应用于非线性建模、函数逼近、模式分类等方面。

目标识别是模式识别领域的一项传统的课题,这是因为目标识别不是一个孤立的问题,而是模式识别领域中大多数课题都会遇到的基本问题,并且在不同的课题中,由于具体的条件不同,解决的方法也不尽相同,因而目标识别的研究仍具有理论和实践意义。

这里讨论的是将要识别的目标物体用成像头(红外或可见光等)摄入后形成的图像信号序列送入计算机,用神经网络识别图像的问题。

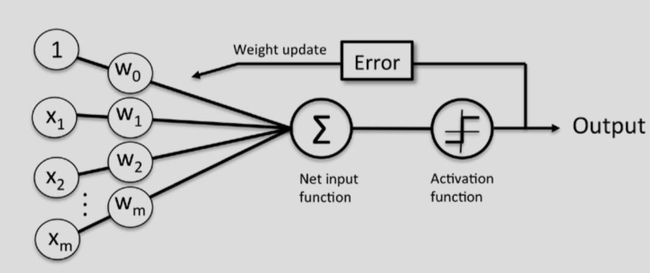

一、BP神经网络BP网络是采用Widrow-Hoff学习算法和非线性可微转移函数的多层网络。一个典型的BP网络采用的是梯度下降算法,也就是Widrow-Hoff算法所规定的。

backpropagation就是指的为非线性多层网络计算梯度的方法。一个典型的BP网络结构如图所示。我们将它用向量图表示如下图所示。

其中:对于第k个模式对,输出层单元的j的加权输入为该单元的实际输出为而隐含层单元i的加权输入为该单元的实际输出为函数f为可微分递减函数其算法描述如下:(1)初始化网络及学习参数,如设置网络初始权矩阵、学习因子等。

(2)提供训练模式,训练网络,直到满足学习要求。(3)前向传播过程:对给定训练模式输入,计算网络的输出模式,并与期望模式比较,若有误差,则执行(4);否则,返回(2)。

(4)后向传播过程:a.计算同一层单元的误差;b.修正权值和阈值;c.返回(2)二、BP网络隐层个数的选择对于含有一个隐层的三层BP网络可以实现输入到输出的任何非线性映射。

增加网络隐层数可以降低误差,提高精度,但同时也使网络复杂化,增加网络的训练时间。误差精度的提高也可以通过增加隐层结点数来实现。一般情况下,应优先考虑增加隐含层的结点数。

三、隐含层神经元个数的选择当用神经网络实现网络映射时,隐含层神经元个数直接影响着神经网络的学习能力和归纳能力。

隐含层神经元数目较少时,网络每次学习的时间较短,但有可能因为学习不足导致网络无法记住全部学习内容;隐含层神经元数目较大时,学习能力增强,网络每次学习的时间较长,网络的存储容量随之变大,导致网络对未知输入的归纳能力下降,因为对隐含层神经元个数的选择尚无理论上的指导,一般凭经验确定。

四、神经网络图像识别系统人工神经网络方法实现模式识别,可处理一些环境信息十分复杂,背景知识不清楚,推理规则不明确的问题,允许样品有较大的缺损、畸变,神经网络方法的缺点是其模型在不断丰富完善中,目前能识别的模式类还不够多,神经网络方法允许样品有较大的缺损和畸变,其运行速度快,自适应性能好,具有较高的分辨率。

神经网络的图像识别系统是神经网络模式识别系统的一种,原理是一致的。一般神经网络图像识别系统由预处理,特征提取和神经网络分类器组成。预处理就是将原始数据中的无用信息删除,平滑,二值化和进行幅度归一化等。

神经网络图像识别系统中的特征提取部分不一定存在,这样就分为两大类:①有特征提取部分的:这一类系统实际上是传统方法与神经网络方法技术的结合,这种方法可以充分利用人的经验来获取模式特征以及神经网络分类能力来识别目标图像。

特征提取必须能反应整个图像的特征。但它的抗干扰能力不如第2类。

②无特征提取部分的:省去特征抽取,整副图像直接作为神经网络的输入,这种方式下,系统的神经网络结构的复杂度大大增加了,输入模式维数的增加导致了网络规模的庞大。

此外,神经网络结构需要完全自己消除模式变形的影响。但是网络的抗干扰性能好,识别率高。当BP网用于分类时,首先要选择各类的样本进行训练,每类样本的个数要近似相等。

其原因在于一方面防止训练后网络对样本多的类别响应过于敏感,而对样本数少的类别不敏感。另一方面可以大幅度提高训练速度,避免网络陷入局部最小点。

由于BP网络不具有不变识别的能力,所以要使网络对模式的平移、旋转、伸缩具有不变性,要尽可能选择各种可能情况的样本。

例如要选择不同姿态、不同方位、不同角度、不同背景等有代表性的样本,这样可以保证网络有较高的识别率。

构造神经网络分类器首先要选择适当的网络结构:神经网络分类器的输入就是图像的特征向量;神经网络分类器的输出节点应该是类别数。隐层数要选好,每层神经元数要合适,目前有很多采用一层隐层的网络结构。

然后要选择适当的学习算法,这样才会有很好的识别效果。

在学习阶段应该用大量的样本进行训练学习,通过样本的大量学习对神经网络的各层网络的连接权值进行修正,使其对样本有正确的识别结果,这就像人记数字一样,网络中的神经元就像是人脑细胞,权值的改变就像是人脑细胞的相互作用的改变,神经网络在样本学习中就像人记数字一样,学习样本时的网络权值调整就相当于人记住各个数字的形象,网络权值就是网络记住的内容,网络学习阶段就像人由不认识数字到认识数字反复学习过程是一样的。

神经网络是按整个特征向量的整体来记忆图像的,只要大多数特征符合曾学习过的样本就可识别为同一类别,所以当样本存在较大噪声时神经网络分类器仍可正确识别。

在图像识别阶段,只要将图像的点阵向量作为神经网络分类器的输入,经过网络的计算,分类器的输出就是识别结果。五、仿真实验1、实验对象本实验用MATLAB完成了对神经网络的训练和图像识别模拟。

从实验数据库中选择0~9这十个数字的BMP格式的目标图像。图像大小为16×8像素,每个目标图像分别加10%、20%、30%、40%、50%大小的随机噪声,共产生60个图像样本。

将样本分为两个部分,一部分用于训练,另一部分用于测试。实验中用于训练的样本为40个,用于测试的样本为20个。随机噪声调用函数randn(m,n)产生。

2、网络结构本试验采用三层的BP网络,输入层神经元个数等于样本图像的象素个数16×8个。隐含层选24个神经元,这是在试验中试出的较理想的隐层结点数。

输出层神经元个数就是要识别的模式数目,此例中有10个模式,所以输出层神经元选择10个,10个神经元与10个模式一一对应。

3、基于MATLAB语言的网络训练与仿真建立并初始化网络% ================S1 = 24;% 隐层神经元数目S1 选为24[R,Q] = size(numdata);[S2,Q] = size(targets);F = numdata;P=double(F);net = newff(minmax(P),[S1 S2],{'logsig''logsig'},'traingda','learngdm')这里numdata为训练样本矩阵,大小为128×40,targets为对应的目标输出矩阵,大小为10×40。

newff(PR,[S1S2…SN],{TF1TF2…TFN},BTF,BLF,PF)为MATLAB函数库中建立一个N层前向BP网络的函数,函数的自变量PR表示网络输入矢量取值范围的矩阵[Pminmax];S1~SN为各层神经元的个数;TF1~TFN用于指定各层神经元的传递函数;BTF用于指定网络的训练函数;BLF用于指定权值和阀值的学习函数;PF用于指定网络的性能函数,缺省值为‘mse’。

设置训练参数net.performFcn = 'sse'; %平方和误差性能函数 = 0.1; %平方和误差目标 = 20; %进程显示频率net.trainParam.epochs = 5000;%最大训练步数 = 0.95; %动量常数网络训练net=init(net);%初始化网络[net,tr] = train(net,P,T);%网络训练对训练好的网络进行仿真D=sim(net,P);A = sim(net,B);B为测试样本向量集,128×20的点阵。

D为网络对训练样本的识别结果,A为测试样本的网络识别结果。实验结果表明:网络对训练样本和对测试样本的识别率均为100%。如图为64579五个数字添加50%随机噪声后网络的识别结果。

六、总结从上述的试验中已经可以看出,采用神经网络识别是切实可行的,给出的例子只是简单的数字识别实验,要想在网络模式下识别复杂的目标图像则需要降低网络规模,增加识别能力,原理是一样的。

谷歌人工智能写作项目:爱发猫

![]()

神经网络控制的书籍目录

文案狗。

第1章神经网络和自动控制的基础知识1.1人工神经网络的发展史1.1.120世纪40年代——神经元模型的诞生1.1.220世纪50年代——从单神经元到单层网络,形成第一次热潮1.1.320世纪60年代——学习多样化和AN2的急剧冷落1.1.420世纪70年代——在低迷中顽强地发展1.1.520世纪80年代——AN2研究热潮再度兴起1.1.620世纪90年代——再现热潮,产生许多边缘交叉学科1.1.7进入21世纪——实现机器智能的道路漫长而又艰难1.2生物神经元和人工神经元1.2.1生物神经元1.2.2人工神经元1.3生物神经网络和人工神经网络1.3.1生物神经网络1.3.2人工神经网络1.4自动控制的发展史1.4.1从传统控制理论到智能控制1.4.2智能控制的产生与基本特征1.4.3智能控制系统1.5模糊集与模糊控制概述1.5.1模糊集1.5.2模糊隶属函数1.5.3模糊控制1.6从生物神经控制到人工神经控制1.6.1生物神经控制的智能特征1.6.2人工神经控制的模拟范围1.7小结习题与思考题第2章神经计算基础2.1线性空间与范数2.1.1矢量空间2.1.2范数2.1.3赋范线性空间2.1.4L1范数和L2范数2.2迭代算法2.2.1迭代算法的终止准则2.2.2梯度下降法2.2.3最优步长选择2.3逼近论2.3.1Banach空间和逼近的定义2.3.2L2逼近和最优一致逼近2.3.3离散点集上的最小二乘逼近2.4神经网络在线迭代学习算法2.5Z变换2.5.1Z变换的定义和求取2.5.2Z变换的性质2.5.3Z反变换2.6李雅普诺夫意义下的稳定性2.6.1非线性时变系统的稳定性问题2.6.2李雅普诺夫意义下的渐进稳定2.6.3李雅普诺夫第二法2.6.4非线性系统的稳定性分析2.7小结习题与思考题第3章神经网络模型3.1人工神经网络建模3.1.1MP模型3.1.2Hebb学习法则3.2感知器3.2.1单层感知器3.2.2多层感知器3.3BP网络与BP算法3.3.1BP网络的基本结构3.3.2BP算法及步长调整3.4自适应线性神经网络3.5自组织竞争型神经网络3.5.1自组织竞争型神经网络的基本结构3.5.2自组织竞争型神经网络的学习算法3.6小脑模型神经网络3.6.1CMAC的基本结构3.6.2CMAC的工作原理3.6.3CMAC的学习算法与训练3.7递归型神经网络3.7.1DTRNN的网络结构3.7.2实时递归学习算法3.8霍普菲尔德(Hopfield)神经网络3.8.1离散型Hopfield神经网络3.8.2连续型Hopfield神经网络3.8.3求解TSP问题3.9小结习题与思考题第4章神经控制中的系统辨识4.1系统辨识基本原理4.1.1辨识系统的基本结构4.1.2辨识模型4.1.3辨识系统的输入和输出4.2系统辨识过程中神经网络的作用4.2.1神经网络辨识原理4.2.2多层前向网络的辨识能力4.2.3辨识系统中的非线性模型4.3非线性动态系统辨识4.3.1非线性动态系统的神经网络辨识4.3.2单输入单输出非线性动态系统的BP网络辨识4.4多层前向网络辨识中的快速算法4.5非线性模型的预报误差神经网络辨识4.5.1非动态模型建模,4.5.2递推预报误差算法4.6非线性系统逆模型的神经网络辨识4.6.1系统分析逆过程的存在性4.6.2非线性系统的逆模型4.6.3基于多层感知器的逆模型辨识4.7线性连续动态系统辨识的参数估计4.7.1Hopfield网络用于辨识4.7.2Hopfield网络辨识原理4.8利用神经网络联想功能的辨识系统4.8.1二阶系统的性能指标4.8.2系统辨识器基本结构4.8.3训练与辨识操作4.9小结习题与思考题第5章人工神经元控制系统5.1人工神经元的PID调节功能5.1.1人工神经元PID动态结构5.1.2人工神经元闭环系统动态结构5.2人工神经元PID调节器5.2.1比例调节元5.2.2积分调节元5.2.3微分调节元5.3人工神经元闭环调节系统5.3.1系统描述5.3.2Lyapunov稳定性分析5.4人工神经元自适应控制系统5.4.1人工神经元自适应控制系统的基本结构5.4.2人工神经元自适应控制系统的学习算法5.5人工神经元控制系统的稳定性5.6小结习题与思考题第6章神经控制系统6.1神经控制系统概述6.1.1神经控制系统的基本结构6.1.2神经网络在神经控制系统中的作用6.2神经控制器的设计方法6.2.1模型参考自适应方法6.2.2自校正方法6.2.3内模方法6.2.4常规控制方法6.2.5神经网络智能方法6.2.6神经网络优化设计方法6.3神经辨识器的设计方法6.4PID神经控制系统6.4.1PID神经控制系统框图6.4.2PID神经调节器的参数整定6.5模型参考自适应神经控制系统6.5.1两种不同的自适应控制方式6.5.2间接设计模型参考自适应神经控制系统6.5.3直接设计模型参考自适应神经控制系统6.6预测神经控制系统6.6.1预测控制的基本特征6.6.2神经网络预测算法6.6.3单神经元预测器6.6.4多层前向网络预测器6.6.5辐射基函数网络预测器6.6.6Hopfield网络预测器6.7自校正神经控制系统6.7.1自校正神经控制系统的基本结构6.7.2神经自校正控制算法6.7.3神经网络逼近6.8内模神经控制系统6.8.1线性内模控制方式6.8.2内模控制系统6.8.3内模神经控制器6.8.4神经网络内部模型6.9小脑模型神经控制系统6.9.1CMAC控制系统的基本结构6.9.2CMAC控制器设计6.9.3CMAC控制系统实例6.10小结习题与思考题第7章模糊神经控制系统7.1模糊控制与神经网络的结合7.1.1模糊控制的时间复杂性7.1.2神经控制的空间复杂性7.1.3模糊神经系统的产生7.2模糊控制和神经网络的异同点7.2.1模糊控制和神经网络的共同点7.2.2模糊控制和神经网络的不同点7.3模糊神经系统的典型结构7.4模糊神经系统的结构分类7.4.1松散结合7.4.2互补结合7.4.3主从结合7.4.4串行结合7.4.5网络学习结合7.4.6模糊等价结合7.5模糊等价结合中的模糊神经控制器7.5.1偏差P和偏差变化率Δe的获取7.5.2隶属函数的神经网络表达7.6几种常见的模糊神经网络7.6.1模糊联想记忆网络7.6.2模糊认知映射网络7.7小结习题与思考题第8章神经控制中的遗传进化训练8.1生物的遗传与进化8.1.1生物进化论的基本观点8.1.2进化计算8.2遗传算法概述8.2.1遗传算法中遇到的基本术语8.2.2遗传算法的运算特征8.2.3遗传算法中的概率计算公式8.3遗传算法中的模式定理8.3.1模式定义和模式的阶8.3.2模式定理(Schema)8.4遗传算法中的编码操作8.4.1遗传算法设计流程8.4.2遗传算法中的编码规则8.4.3一维染色体的编码方法8.4.4二维染色体编码8.5遗传算法中的适应度函数8.5.1将目标函数转换成适应度函数8.5.2标定适应度函数8.6遗传算法与优化解8.6.1适应度函数的确定8.6.2线性分级策略8.6.3算法流程8.7遗传算法与预测控制8.8遗传算法与神经网络8.9神经网络的遗传进化训练8.9.1遗传进化训练的实现方法8.9.2BP网络的遗传进化训练8.10小结习题与思考题附录常用神经控制术语汉英对照参考文献……

本人毕设题目是关于神经网络用于图像识别方面的,但是很没有头续~我很不理解神经网络作用的这一机理

。

我简单说一下,举个例子,比如说我们现在搭建一个识别苹果和橘子的网络模型:我们现在得需要两组数据,一组表示特征值,就是网络的输入(p),另一组是导师信号,告诉网络是橘子还是苹果(网络输出t):我们的样本这样子假设(就是):pt10312142这两组数据是这样子解释的:我们假设通过3个特征来识别一个水果是橘子还是苹果:形状,颜色,味道,第一组形状、颜色、味道分别为:103(当然这些数都是我随便乱编的,这个可以根据实际情况自己定义),有如上特征的水果就是苹果(t为1),而形状、颜色、味道为:214的表示这是一个橘子(t为2)。

好了,我们的网络模型差不多出来了,输入层节点数为3个(形状、颜色,味道),输出层节点为一个(1为苹果2为橘子),隐藏层我们设为一层,节点数先不管,因为这是一个经验值,还有另外的一些参数值可以在matlab里设定,比如训练函数,训练次数之类,我们现在开始训练网络了,首先要初始化权值,输入第一组输入:103,网络会输出一个值,我们假设为4,那么根据导师信号(正确的导师信号为1,表示这是一个苹果)计算误差4-1=3,误差传给bp神经网络,神经网络根据误差调整权值,然后进入第二轮循环,那么我们再次输入一组数据:204(当仍然你可以还输入103,而且如果你一直输入苹果的特征,这样子会让网络只识别苹果而不会识别橘子了,这回明白你的问题所在了吧),同理输出一个值,再次反馈给网络,这就是神经网络训练的基本流程,当然这两组数据肯定不够了,如果数据足够多,我们会让神经网络的权值调整到一个非常理想的状态,是什么状态呢,就是网络再次输出后误差很小,而且小于我们要求的那个误差值。

接下来就要进行仿真预测了t_1=sim(net,p),net就是你建立的那个网络,p是输入数据,由于网络的权值已经确定了,我们这时候就不需要知道t的值了,也就是说不需要知道他是苹果还是橘子了,而t_1就是网络预测的数据,它可能是1或者是2,也有可能是1.3,2.2之类的数(绝大部分都是这种数),那么你就看这个数十接近1还是2了,如果是1.5,我们就认为他是苹果和橘子的杂交,呵呵,开玩笑的,遇到x=2.5,我一般都是舍弃的,表示未知。

总之就是你需要找本资料系统的看下,鉴于我也是做图像处理的,我给你个关键的提醒,用神经网络做图像处理的话必须有好的样本空间,就是你的数据库必须是标准的。

至于网络的机理,训练的方法什么的,找及个例子用matlab仿真下,看看效果,自己琢磨去吧,这里面主要是你隐含层的设置,训练函数选择及其收敛速度以及误差精度就是神经网络的真谛了,想在这么小的空间给你介绍清楚是不可能的,关键是样本,提取的图像特征必须带有相关性,这样设置的各个阈值才有效。

OK,好好学习吧,资料去matlab中文论坛上找,在不行就去baudu文库上,你又不需要都用到,何必看一本书呢!祝你顺利毕业!

液压泵 恒流问题

。

迄今为止,国内外有2种实现泵恒流量调节的方法:一种是在泵的主油路上设置一流量敏感装置,将流量信号转换为压差、位移、力或电压信号,再将其与给定信号比较实现流量反馈调节,达到泵恒流量输出;另一种是采用泄漏电补偿方法,通过检测泵的负载压力、油温等参数由补偿数学模型间接辨识出泵的实际输出流量误差,并对泵的给定信号进行电补偿修正,以达到使泵的输出流量恒定。

这2种方法均能较为满意地实现泵恒流量控制。但是,前者因在主油路上直接检测负载流量,不可避免地带来了附加的节流功率损失;后者由于须先通过实验确定补偿数学模型中的变量系数,建模工作变得繁琐。

同时由于模型是近似线性的,因而精度也受到一定影响。液压泵流量调节系统因受流量—压力特性、滞环特性、死区特性以及粘温特性、质量惯性等的影响,是典型的非线性和时变系统〔1〕。

运用传统的经典控制方法控制液压泵流量调节系统,难以获得满意的控制效果,特别是在工程应用中,当工况发生较大变化使调节系统参数发生较大变化时,会使系统的控制性能明显下降,甚至不能满足工程要求〔2〕。

笔者在分析液压泵恒流量调节方式和特点的基础上,提出一种采用神经网络辨识负载流量原理实现液压泵恒流量调节的新方法。

结合此方法,提出一种基于模糊神经网络的智能学习控制方法,并将其应用于电液比例恒流量调节轴向柱塞泵的控制。

1 基于负载流量神经网络模型的液压恒流泵原理液压泵输出的负载流量实际上是由泵的排量、负载压力、流体介质粘度、泵轴转速等变量决定的复杂的非线性多元函数,很难用精确的数学模型表示。

神经网络因其自身的结构特点,具有逼近任何非线性函数的能力、对复杂不确定系统自学习能力和高度的并行运算能力〔3〕。

因此,可以利用神经网络的特性建立负载流量的神经网络模型并将此模型作为负载流量辨识器引入液压泵流量调节系统中,通过检测各变量间接辨识出泵的实际输出流量,再将其与给定信号比较,实现流量反馈调节,达到恒流量输出。

其原理见图1。这里,用做负载流量辨识器的神经网络须经学习训练得到。我们采用3层前馈神经网络。

由于流体介质粘度主要受温度和压力影响,且泵轴转速变化对负载流量影响相对较小,所以我们从工程应用角度出发,选取泵的负载压力、排量、液体温度作为网络的输入,泵的负载流量作为网络的输出,并采取归一化处理。

隐层和输出层的激励函数取为Sigmoid函数式中,neti为第i个神经元的输入;θi为阈值。训练网络的指标函数定义为式中,Yp为第p个学习样本;Op为相应的网络实际输出;n为训练样本数。

采用最速下降法调整输入层和隐层、隐层和输出层之间的权重、使E达到最小,即第k次迭代的权重修正为式中,l=1,2;β为学习率,β∈(0,1);α为惯性系数。

通过调整、以及θi,可实现对负载流量的建模估计。

从现场采集来的数据通常都会存在各种干扰噪声,为了最大限度地避免这些噪声对网络建模的干扰,我们在利用神经网络学习建模时,采用了一种分组训练检验的方法,即将获得的样本数据分成两组,一组数据用来训练网络,而另一组数据用来评价网络的映射学习结果。

网络误差的评估公式定义为式中,m为测试样本数;Yj为第j个测试样本;Oj为相应的网络实际输出。实验证明该方法对提高建模精度是有效的。

由于负载流量与各变量的非线性函数关系可以通过调整神经网络的权重和阈值得到,因此避免了采用最小二乘多项式拟合方法建立流量补偿数学模型时,必须由实验确定各自变量系数所带来的麻烦。

而且,这种基于负载流量神经网络模型的恒流泵也避免了传统的恒流泵因在主油路上直接检测负载流量所带来的附加的节流功率损失。从理论上讲,以零功率损失实现了液压泵的恒流量调节。

图1 基于负载流量神经网络模型的液压恒流泵原理2 基于模糊神经网络的恒流泵智能学习控制根据液压泵流量调节系统具有时变和非线性的特点,结合上面提出的这种采用神经网络辨识负载流量原理实现液压泵恒流量调节的新方法,我们设计了基于模糊神经网络的恒流泵智能学习控制系统,其结构原理见图2。

控制器由模糊神经网络控制器和定增益线性控制器复合构成。模糊神经网络FNN控制器采取常用的二维输入一维输出结构。

网络的Ⅰ层、Ⅱ层对应于模糊规则的前件,隶属函数取高斯基函数f()=exp〔-(xk-aik)2/〕(i=1,…,7,k=1,2);Ⅲ层、Ⅳ层对应规则后件。

网络的输入端分别对应流量理想设定和负载压力,这样会使模糊神经网络能在理想的流量轨迹附近学习,并能实现系统状态的动态补偿。

定增益线性控制器作为系统反馈控制器可以避免神经网络控制初始误差,并提供神经网络学习信号,起控制器与学习机制双重作用。

这里引入智能调节器的目的是对系统运行状态进行评价,根据偏差及其变化情况在线调整定增益线性控制器(PID控制器)的参数和学习算法中的学习因子。

智能调节器由一系列产生式规则组成,它的建立基于如下几条规则:①若偏差及其变化很小,则比例、积分、微分作用减弱;②偏差为正时,若偏差较小,则比例、积分作用增强,微分作用减弱;③偏差为负时,若偏差较大,则积分、微分作用减弱;④若偏差增加,则学习因子减小,反之,则学习因子增大。

其中,规则①比例、积分、微分作用减弱是为了保持控制提高控制精度;规则②比例、积分作用增强和微分作用减弱是为了减小静差提高控制精度;规则③减弱积分、微分作用是为了兼顾稳定性与调节精度;规则④是为了提高算法的稳定性和收敛速度。

总结以上规则和分析,给出系统的控制算法如下:调节器:if(|e(t)|<e1∩|c(t)|<c1)then(k1=α1,k2=β1,k3=γ1)if(e(t)>0∩e(t)<e2)then(k1=α2,k2=β2,k′3=γ2)if(e(t)<0∩e(t)<-e3)then(k1=α3,k2=β3,k3=γ3)if(e(t)c(t)<0)then(ψ=λ1)if(e(t)c(t)>0)then(ψ=λ2)else(k1=1,k2=1,k3=1,ψ=1)控制器:PID控制器u1(t)=u1(t-1)+k1kp(e(t)-e(t-1))+k2kie(t)+K3kd(e(t)-2e(t-1)-e(t-2))FNN控制器这里e(t)=Q*(t)-Q(t)=Q*(t)-�φ(p(t),q(t),T(t))控制率u(t)=u1(t)+u2(t)权重调整� 以上各式中,e(t)、c(t)分别为当前时刻的偏差和偏差变化率;�φ(*)为负载流量神经网络辨识器的输入输出映射函数;Q*(t)、Q(t)、q(t)、p(t)和T(t)分别为流量理想设定、负载流量、变量泵排量、负载压力和油液温度;e1、e2、e3和c1为偏差和偏差变化率的阈值;kp、ki、kd分别为PID比例、积分、微分项系数;k1、k2、k3和ψ分别为PID参数和学习因子的动态修正因子;α1、β1、β3、γ1、γ2、γ3、λ2(均小于1)和α2、β2、α3、λ1(均大于1)为修正因子取值,这些参数均可现场调整。

图2 基于模糊神经网络的恒流泵智能学习控制系统3 在电液比例恒流量调节轴向柱塞泵中的应用应用上面提出的智能学习控制算法,我们对所研制的电液比例恒流量轴向柱塞泵流量调节系统进行了大量的试验研究。

在建立负载流量神经网络模型时,测取90个试验样本,其中40个样本组成训练样本组,另50个样本组成检验样本组。

取30个隐层节点,学习率取0.6,惯性系数取0.1,经10 000次左右的迭代学习后,误差即可小于0.001。FNN控制器先经在线学习训练后再关闭训练投入使用。

图3和图4为采用流量压差反馈原理的恒流泵在PID控制下的正弦跟踪控制和变轨迹跟踪控制曲线。

图5和图6为采用神经网络辨识负载流量原理的恒流泵在FNN与PID复合控制下的在线学习正弦跟踪控制和停止训练后的变轨迹跟踪控制试验曲线。以上各图中,曲线1为期望轨迹,曲线2为实际轨迹。

从中可以看出,基于新调节原理和控制方法的恒流泵的控制精度和鲁棒性明显提高。

图7和图8为采用新调节原理和控制方法的恒流泵的稳态负载特性和流量阶跃输入响应特性试验曲线,从中可看出,该泵具有良好的稳态特性和动态特性。

图3 图4图5 图6图7 图84 结论本文提出的采用神经网络辨识负载流量原理实现液压泵恒流量调节的新方法,不仅能够解决直接检测负载流量方法带来功率损失的问题,也能够避免泄漏电补偿方法建模时的麻烦。

这为液压泵实现恒流量调节提供了既经济又有效的工程实用方法。结合此方法提出的基于模糊神经网络的恒流泵智能学习控制方法,比传统的控制方法具有更优良的控制品质。

MATLAB编程实现,BP神经网络用于系统辨识的问题?

神经网络怎么辨识对象

神经网络模拟人脑的神经元,神经元之间相互连接,每个神经元接受数据,判断时候产生信号传递给下一个神经元,层层传送,最终达到识别的目的。

神经网络不像其它的模型有理论依据,它很多的像是一种模糊的统计预测模型。正因为这种特性,它的适应能力很强,只要有充足的数据与足够的神经元,便能实现识别,决策,预测等功能。