基于Bert架构的精准知识表征模型

![]()

画像是什么?

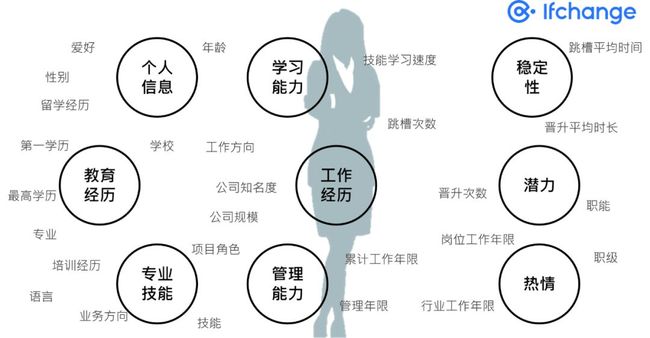

“画像”的出现,得益于大数据、云计算、人工智能等新技术的飞速发展。用户画像(persona)的概念最早由交互设计之父Alan Cooper提出:“Personas are a concrete representation of target users.” 是指真实用户的虚拟代表,是建立在一系列属性数据之上的目标用户模型。

如今,为了提高客户体验和运营效率,画像早已被应用在各行各业。金融企业是最早开始使用用户画像的行业,在人力资本领域,人才/岗位画像的应用大大提升了HR的工作效率和质量,是人力资本数字化的重要入口和核心要素。所谓人才/岗位画像,即是基于企业招聘的显性的职位描述和隐形的内在潜质共同组成的用户画像(以下简称“画像”)。

△一张画像,没有读不懂的人才

构建画像的核心工作,主要是利用存储在服务器上的海量日志和数据库里的大量数据进行分析和挖掘,给用户贴“标签”,而“标签”是能表示用户某一维度特征的标识。

业界有一套较为成熟的画像构建方法,为了让画像成为可普遍使用的基础服务,需要对画像的字段进行数值化处理。其中结构化数据比较容易进行数值编码(例如:性别/年龄/工作年限等),而非结构化数据(例如工作经历/职能/技能等)多数为文本类型处理难度较高。对于非结构化数据,生成具备语义含义的Embedding是业界较为广泛使用的方案。

职能/技能可以统称为用户的知识体系,即使每一个职能/技能生成了具备语义含义的Embedding,如何通过聚合生成用户整个知识体系的数值表达并尽可能保留文本自身的信息,依旧是亟待解决的问题。

在画像构建过程中,对于结构化数据业界已经积累了大量的成熟有效的方案。然而非结构化数据(例如文本类型)包含了更全面和深度的用户潜在信息,目前通过词向量加权平均依旧是主流使用的处理方法。

此类方法存在一些缺陷:

1.生成的Embedding完全基于语义表达,缺失了其内在业务含义;

2.直接加权平均的方法,容易掩盖掉重要的信息,且权重不好定义。

基于此,我们针对人力资本场景,借鉴Bert的思想提出了一个新方法,能够更好地用数学的方法对人才/岗位画像进行表示。

为了让AI+数据驱动的数字化招聘更为精准智能,我们以e成科技独有的HR行业职能/技能知识图谱作为先验的业务知识,并基于海量简历和岗位描述数据(千万级),借鉴Bert的模型架构,专门对画像中的知识体系相关字段(职能/技能)进行了深度优化。该方法提供的知识表征,首先包含了技能/职能的内在关系,其次通过attention的方式聚合能保证重要业务信息的不丢失。

经过优化的人才/岗位画像,在数字化招聘、人岗匹配、人才盘点、薪酬预测等多个下游业务场景中均取得显著的优化提升。

部分场景举例

-

人才选拔:通过人才画像分析,使人才供给与业务发展速度高度匹配,优化人才队伍配置效率,降低人才流失率;

-

人才任用:通过岗位画像和人才画像的分析与匹配度分析,实现人才和岗位最优配置,使优秀人才能充分发挥能力与主观能动性,提高人力资本效率;

-

人才盘点:利用大数据分析及AI技术,全面挖掘人才素质,评估人才潜力,动态校准人才画像,即时展现人才能力、绩效、潜力等分布情况,为人才识别、发展、配置提供价值,激活组织与人才发展;

-

薪酬预测:根据人才画像和岗位画像,结合行业岗位知识,分析人才/候选人技能及发展水平,预测候选人及企业未来薪酬水平;

接下来,院长就将为大家介绍e成科技在有关领域的最新方案以及应用成果。

![]()

ELMoVS Word2Vec,更优的特征提取器

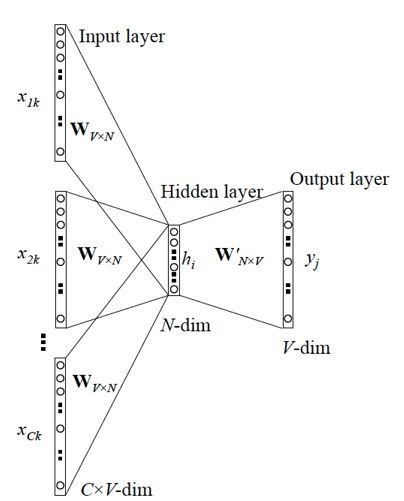

Word2Vec是近几年非常流行的Word Eembedding提取模型。模型通过预先构建的词表将输入语句中某单词前、后所有词语编码为多个one-hot向量传入模型,随后通过一个共享的参数矩阵将这些向量映射到隐藏层,最后使用softmax将隐藏层的输出转化为词表中每个单词的概率作为输出,其中概率最高的单词即为最终预测结果。经过充分训练后,词表中每个单词的语义信息已经充分“嵌入”了用于映射输入层和隐藏层的参数矩阵中。使用时只需用单词的one-hot向量和参数矩阵相乘就可以得到对应的Word Embedding。

这样的网络结构为Word2Vec带来了一个严重的问题,它无法为语言中常见的多义词提取Embedding。由于同一个单词在参数矩阵中只占据一个向量,网络只能将多义词的不同语义信息全部编码到相同的向量中,反而降低了这些词向量的表达能力。此外,Word2Vec只采用了一个线性隐藏层,特征提取能力较弱,对Embedding的表现也有很大的影响。

ELMo(Embedding from Language Models)模型使用与Word2Vec截然不同的方式提取Embedding,并采用更优的特征提取器,很好地解决了多义词问题,同时增强了词向量的表达能力。模型使用两层双向LSTM(Long Short Term Memory)单元作为模型中间层,其中正向LSTM顺序接受输入语句中给定单词的上文,逆向LSTM倒序接受语句中给定单词的下文。训练完成后将输入层Embedding和两层LSTM产生的Embedding加权结合后作为句中每个单词的Embedding使用。与Word2Vec查表式获取静态的Embedding不同,ELMo可以根据上下文信息动态调整词语的Embedding。多层LSTM特征提取器可以从文本中分别提取句法、语义等不同层次的信息,大大提升了词语特征的丰富程度。

Attention机制是近几年提出的新型特征提取器,在NLP领域的表现效果远超以往使用的卷积神经网络和LSTM等技术。Bert的优异表现正是建立在这一机制的基础上,多层Self-Attention单元构成的大型网络和巧妙设计的无监督训练方式使模型可以利用丰富的自由文本进行训练,从中提取多层次的语言特征。

![]()

e成科技的应用:知识表征模型

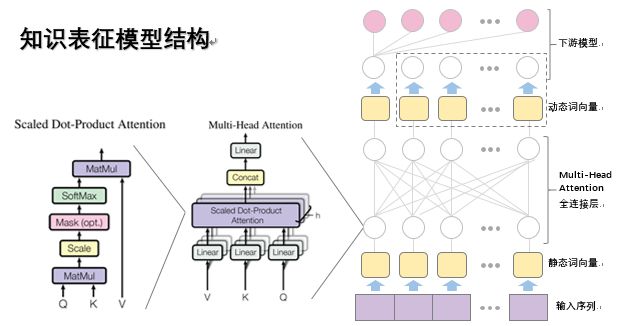

我们的知识表征模型(以下简称“模型”)同样使用了多层Self-Attention单元作为基本的特征提取器,尝试从e成科技丰富的数据中挖掘出可描述职能和技能各自特征及其相关关系的Embedding。

为了训练这样的模型,我们借鉴并调整了Bert的设计思路,建立一套符合我们诉求的模型结构。模型将e成科技知识图谱中职能和技能的实体名称作为Embedding提取粒度,端到端地进行特征提取,避免字粒度模型提取特征后还需将其重新组合成词语的麻烦,也减少了模型的信息损失。

模型训练时,我们使用职能、技能前后拼接的数据结构,其中来自相同CV数据的职能、技能作为正样本,来自相似行业中不同CV数据的职能、技能作为负样本。正负样本数量比例为1:1。为了防止模型仅抽取职能对技能的依赖关系,我们在将职能和技能调换顺序后的数据加入样本中同时训练,以提取双向的依赖关系。

经过充分训练后,模型可以提供多样化的使用方式。模型最后一层输出和输入序列等长的Embedding序列,其中第一个Embedding包含整条数据的特征,之后每个Embedding与输入序列的词语一一对应,分别是每个词语的动态特征。将序列头Embedding接入下游任务网络中可以对模型进行fine-tune,可进一步用于不同的细分领域任务。同时,其余Embedding也可以直接作为词语特征使用。考虑到模型结构复杂,运算时间较长,针对某些性能要求较高的业务场景,可以将模型输入层对应的Embedding作为静态词向量使用,通过查表方式大大简化运算流程。

我们使用内部标注的薪酬预测、人岗匹配数据对不同模型进行了评估,结果如下:

薪酬预测任务中,每个模型需要提取候选人的技能Embedding作为下游任务的参数,辅助判断候选人的薪酬水平。实验中模型之间互不影响,且使用相同的下游薪酬预测模型。结果中可以看到,我们的知识技能表达模型对下游任务各项指标均有5%左右的提升。而人岗匹配任务中,我们将岗位和候选人各自技能Embedding之和作为它们的特征向量,通过特征向量相似度判断候选人和岗位是否匹配。评估结果显示,我们的模型表现非常出众,提升效果明显。

测试过程中,模型可以将大部分被覆盖的词语还原为正确结果,下面是从测试样例中抽取的部分未正确还原的情况。可以看到即使还原失败,模型也能够预测到行业内与正确结果相似的答案。

数字化时代,HR作为推动企业数字化升级的核心力量之一,通过数字化工具助力人才管理和人才引进数字化,已经成为必然趋势。e成科技创新研发的画像+Bot两大引擎,助力人才知己、企业知人、社会知命。利用大数据和人工智能技术构建的画像,将对人才的素质、性格、职业动力都进行全方位描述,帮助人才认识自己,进行自我反思,同时帮助企业和HR更全面、更立体、更准确识别候选人,实现选、融、育、激各个环节高效的人才管理。

作为HR+AI赛道的领跑者,e成科技从创立伊始就将AI基因根植于业务,并开创性地将AI技术与人才战略升级场景深度结合。同时,基于积累多年的AI能力和HR行业经验,e成科技重磅打造了AI开放平台(HR领域首个AI开放平台来了!行业顶级AI你也可以轻松GET!),通过OpenAPI及需求定制等形式将AI能力开放给所有企业和友商。e成科技AI开放平台是HR赛道首个企业自主研发的聚焦人力资本场景的一站式AI能力服务平台,覆盖简历解析、人岗匹配、HR机器人等诸多场景,这些HR+AI的创新应用和智能产品背后,都是e成科技领先的AI能力和默默潜心研发的科学家及算法工程师们作为支撑。未来,e成科技将持续打造更多创新智能产品,全面加速人力资本数字化升级!

作者:e成科技AI算法团队陈嘉钦