CVPR2021目标跟踪汇总(一)

CVPR2021目标跟踪汇总(一)

【1】Learning to Filter: Siamese Relation Network for Robust Tracking

论文地址:https://arxiv.org/abs/2104.00829

代码: https://github.com/hqucv/siamrn

摘要

尽管基于暹罗的跟踪器取得了巨大的成功,但它们在复杂场景下的性能仍然不令人满意,尤其是在有干扰物的情况下。为此,我们提出了一种新的暹罗关系网络,它引入了两个有效的模块,即关系检测器和精化模块。研发以元学习的方式进行,以获得从背景中过滤干扰物的学习能力,而RM旨在将所提出的研发有效地集成到暹罗框架中,以生成准确的跟踪结果。此外,为了进一步提高跟踪器的可辨别性和鲁棒性,我们引入了对比训练策略,该策略不仅试图学习匹配相同的目标,还试图学习如何区分不同的对象。因此,当面对背景杂波、快速运动和遮挡时,我们的跟踪器可以获得准确的跟踪结果。在VOT2018、VOT2019、OTB100、LaSOT和UAV123五个流行基准上的实验结果表明,该方法是有效的,能够获得最先进的结果。

主要工作

【1】介绍了一种新的关系检测器(RD),该检测器通过基于少镜头学习的对比训练策略来获得从背景中过滤干扰物的能力。受益于研发,在跟踪过程中,一旦给定目标的初始状态,我们的跟踪器就可以在杂乱的背景中区分目标,而无需进一步微调。

【2】为了整合研发和分类分支获得的信息来细化跟踪结果,我们设计了一个细化模块(RM),该模块可以联合操作分类和回归来定位目标,减少这两个分支之间的不匹配。

网络结构

暹罗关系网络的跟踪管道。提出了关系检测器和联合精化模块。在跟踪过程中,通过精确的投资回报率池[6]从回归分支生成的提案特征输入研发,以衡量与目标特定特征的关系。然后,我们将研发的输出转换为匹配分数,并在细化模块中利用它来联合操作回归和分类分支,以预测目标位置。

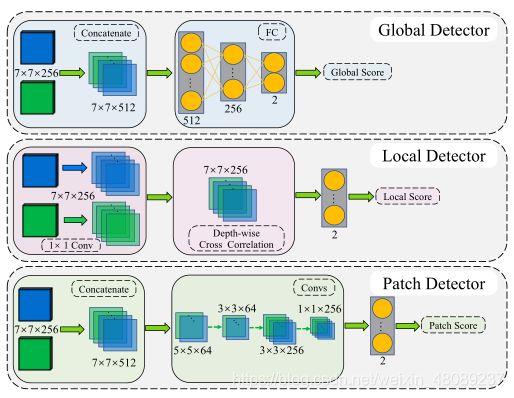

关系检测器的体系结构。它由三个不同的非线性比较器组成,分别命名为Gloabl检测器、局部检测器和Patch检测器。我们通过这些检测器测量目标和感兴趣区域之间的关系,这些检测器被元学习以过滤干扰物。每个检测器最终生成一个分数来测量输入对的关系。

关系检测器的体系结构。它由三个不同的非线性比较器组成,分别命名为Gloabl检测器、局部检测器和Patch检测器。我们通过这些检测器测量目标和感兴趣区域之间的关系,这些检测器被元学习以过滤干扰物。每个检测器最终生成一个分数来测量输入对的关系。

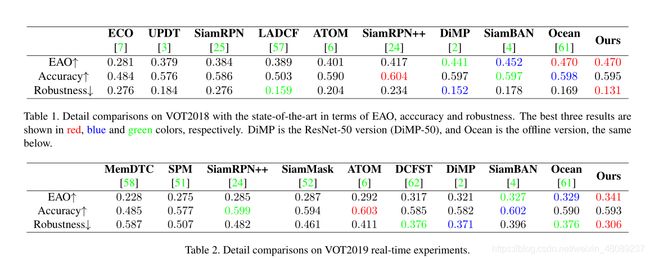

结果

【2】STMTrack: Template-free Visual Tracking with Space-time Memory Networks

论文地址:https://arxiv.org/abs/2104.00324

代码:https://github.com/fzh0917/STMTrack

摘要

如今,提高离线训练的暹罗跟踪器的性能变得越来越困难,因为从第一帧裁剪的模板的固定信息几乎已经被彻底挖掘,但是它们抵抗目标外观变化的能力很差。现有的具有模板更新机制的跟踪器依赖耗时的数值优化和复杂的手工设计策略来实现竞争性能,这阻碍了它们的实时跟踪和实际应用。在本文中,我们提出了一种新的基于时空记忆网络的跟踪框架,该框架能够充分利用与目标相关的历史信息,以更好地适应跟踪过程中的外观变化。具体来说,引入了一种新的存储机制,存储目标的历史信息,引导跟踪器聚焦在当前帧中信息量最大的区域。此外,内存网络的像素级相似度计算使我们的跟踪器能够生成目标的更精确的边界框。在具有挑战性的大规模基准上,与许多竞争对手的追踪器(OTB-2015、TrackingNet、GOT-10k、LaSOT、UAV123和VOT2018)进行了广泛的实验和比较,结果表明,没有花哨的功能,我们的追踪器在以37 FPS运行时,性能优于所有以前最先进的实时方法。

主要工作

【1】提出端到端记忆跟踪框架,具有适应性和模板更新策略。

【2】在视觉跟踪中引入了一种基于像素级相似度计算的新的存储机制,使得我们的跟踪器具有更强的鲁棒性,并且能够生成比以前许多使用特征映射级互相关的高性能方法更精确的目标框。

网络结构

左侧部分是特征提取网络,由内存分支(以浅绿色显示)和查询分支(以浅蓝色显示)组成。内存分支将内存帧和相应的前景-背景标签映射作为输入。" concat "表示沿时间维度的串联操作。中间部分是时空存储网络,它从多个存储帧中检索目标信息,用于查询帧中的目标定位。右侧是查询帧的前景背景分类和目标边界框回归的头部网络。

左侧部分是特征提取网络,由内存分支(以浅绿色显示)和查询分支(以浅蓝色显示)组成。内存分支将内存帧和相应的前景-背景标签映射作为输入。" concat "表示沿时间维度的串联操作。中间部分是时空存储网络,它从多个存储帧中检索目标信息,用于查询帧中的目标定位。右侧是查询帧的前景背景分类和目标边界框回归的头部网络。

结果

【3】Transformer Tracking

论文地址:https://arxiv.org/abs/2103.15436

代码:https://github.com/chenxin-dlut/TransT

摘要

相关性在跟踪领域起着至关重要的作用,尤其是在最近流行的基于暹罗的跟踪器中。相关运算是一种考虑模板和搜索区域相似性的简单融合方式。然而,相关运算本身是一个局部线性匹配过程,导致语义信息丢失,容易陷入局部最优,这可能是设计高精度跟踪算法的瓶颈。有没有比相关性更好的特征融合方法?为了解决这个问题,受Transformer的启发,本文提出了一种新的基于注意力的特征融合网络,该网络仅使用注意力就能有效地将模板和搜索区域特征结合起来。具体而言,所提出的方法包括基于自我注意的自我上下文增强模块和基于交叉注意的交叉特征增强模块。最后,提出了一种基于类暹罗特征提取主干、设计的基于注意力的融合机制以及分类回归头的Transformer跟踪方法。实验表明,我们的TransT在六个具有挑战性的数据集上取得了非常好的结果,尤其是在大规模的LaSOT、TrackingNet和GOT-10k基准上。我们的跟踪器在图形处理器上以大约50华氏度/秒的速度运行。

主要工作

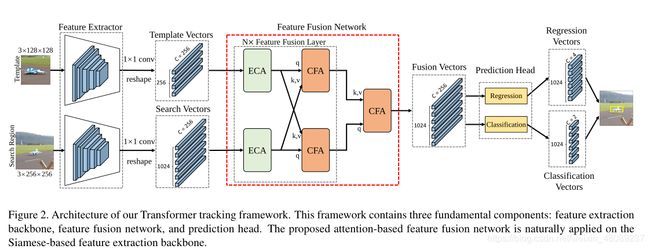

【1】提出新的跟踪框架,包括特征提取模块、融合模块和头部预测模块三部分。融合模块仅使用注意力来组合模板和搜索区域特征,而没有相关性。

【2】开发了基于自注意力机制上下文增强模块和交叉关注的交叉特征增强模块的特征融合网络。与基于相关性的特征融合相比,基于注意力的方法自适应地聚焦有用信息,如边缘和相似目标,并在远处特征之间建立关联,使跟踪器获得更好的分类和回归结果。

网络结构

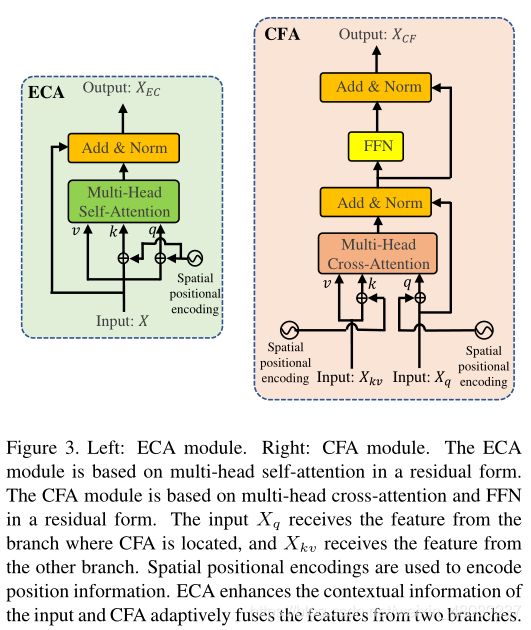

左:ECA模块。右图:CFA模块。ECA模块基于剩余形式的多头自我关注。CFA模块基于多头交叉注意力和剩余形式的FFN。输入Xqreceives来自CFA所在分支的特征,Xkvreceives来自另一个分支的特征。空间位置编码用于编码位置信息。ECA增强输入的上下文信息,CFA自适应地融合来自两个分支的特征。

结果

【4】Transformer Tracking

论文地址:https://arxiv.org/abs/2104.14545

代码:https://github.com/researchmm/LightTrack

摘要

在过去的几年中,目标跟踪取得了显著的进步。然而,最先进的跟踪器变得越来越笨重和昂贵,这限制了它们在资源受限的应用程序中的部署。在这项工作中,我们提出了LightTrack,它使用神经架构搜索(NAS)来设计更轻量级和更高效的对象跟踪器。综合实验表明,我们的LightTrack是有效的。它可以找到与手工制作的SOTA追踪器相比性能更好的追踪器,如SiamRPN++ [30]和Ocean [56],同时使用更少的模型Flops和参数。此外,当部署在资源受限的移动芯片组上时,发现的跟踪器运行得更快。例如,在骁龙845肾上腺素图形处理器上,光线跟踪比海洋快12倍,同时使用的参数少13倍,触发器少38倍。这种改进可能会缩小目标跟踪任务中学术模型和工业部署之间的差距。

主要工作

【1】提出自动化设计神经架构的目标跟踪。

【2】设计了轻量型搜索空间和专用搜索方法。

网络结构

LightTrack包括三个连续的阶段:预处理骨干超网,训练跟踪超网,以及用进化算法对训练好的超网进行搜索。

消融实验

1)大约有50%的主干块使用内核大小为7x7的MBConv。潜在的原因可能是大的感受野可以提高定位精度。

2)搜索到的架构选择倒数第二块作为特征输出层。这可能表明跟踪网络可能不喜欢高级功能。

3)分类分支比回归分支包含更少的层。这可能是由于粗略的对象定位比精确的包围盒回归相对容易。

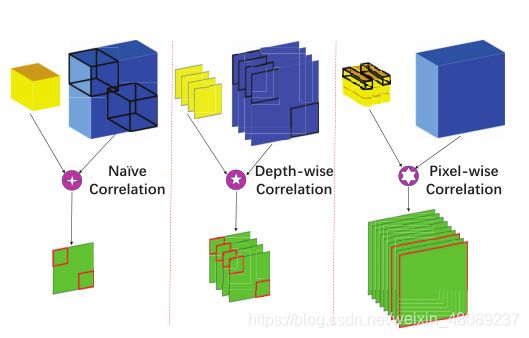

结果

【5】Alpha-Refine: Boosting Tracking Performance by Precise Bounding Box Estimation

论文地址:https://openaccess.thecvf.com/content/CVPR2021/papers/Yan_Alpha-Refine_Boosting_Tracking_Performance_by_Precise_Bounding_Box_Estimation_CVPR_2021_paper.pdf

代码:https://github.com/MasterBin-IIAU/AlphaRefine

摘要

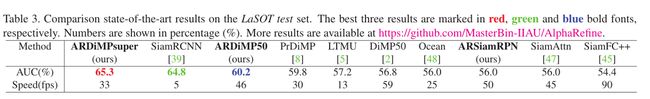

视觉目标跟踪旨在精确估计给定目标的包围盒,由于变形和遮挡等因素,这是一个具有挑战性的问题。许多最近的跟踪器采用多阶段策略来改进包围盒估计。这些方法首先粗略地定位目标,然后在随后的阶段中细化初始预测。然而,现有方法的精度仍然有限,不同阶段的耦合严重限制了方法的可移植性。该工作提出了一种新颖、灵活、精确的细化模块——阿尔法细化(Alpha-Refine,AR),可以显著提高基础跟踪器的盒子估计质量。通过探索一系列设计选项,我们得出结论,成功细化的关键是尽可能提取和维护详细的空间信息。遵循这一原则,Alpha-Refine采用像素相关、角点预测头和辅助蒙版头作为核心组件。在TrackingNet、LaSOT、GOT-10K和VOT2020基准上使用多个基本跟踪器的综合实验表明,我们的方法在几乎没有额外延迟的情况下显著提高了基本跟踪器的性能。所提出的Alpha-Refine方法导致了一系列的增强跟踪程序,其中ARSiamRPN(增强的SiamRPNpp)和ARDiMP50(增强的DiMP50)实现了良好的效率-精度平衡,而ARDiMPsuper(增强的DiMPsuper)在实时速度下实现了非常有竞争力的性能。

主要工作

提出一种精细化模块,通过提取和保持精确的空间信息提高跟踪框精度。

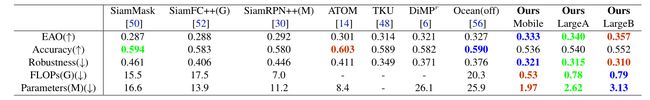

【1】特征融合模块:采用像素级相似度对比方式,保留目标边界和其他详细的空间信息。达到保证每个相关图上的局部信息,同时避免特征模糊的目的。

【2】跟踪框预测方式:1)引入角点检测方式,采用conv-bn-relu四层堆叠的方式对左上角和右下角热力图进行预测。通过soft-argmax方式使模型依据离散热力图预测出连续值,有效避免了RPN中的不一致问题。2)引入辅助掩码,与搜索区域保证相同尺寸,提取更详细的空间信息,同时指导模型更好完成前景、背景的辨别工作。

网络结构

结果

【6】Graph Attention Tracking

论文地址:https://openaccess.thecvf.com/content/CVPR2021/papers/Guo_Graph_Attention_Tracking_CVPR_2021_paper.pdf

代码:https://git.io/SiamGAT

摘要

基于暹罗网络的跟踪器将视觉跟踪任务公式化为相似性匹配问题。几乎所有流行的暹罗跟踪器都是通过目标分支和搜索分支之间的卷积特征互相关来实现相似性学习的。然而,由于目标特征区域的大小需要预先确定,这些基于互相关的方法要么保留了大量不利的背景信息,要么丢失了大量的前景信息。此外,目标和搜索区域之间的全局匹配也在很大程度上忽略了目标结构和部分级信息。为了解决上述问题,我们提出了一种简单的目标感知暹罗图注意力网络用于一般目标跟踪。我们提出用一个完整的二分图建立目标和搜索区域之间的部分-部分对应关系,并应用图关注机制将目标信息从模板特征传播到搜索特征。此外,我们研究了一种目标感知区域选择机制,以适应不同对象的大小和纵横比变化,而不是使用预先固定的区域裁剪进行模板-特征区域选择。在包括GOT-10k、UAV123、OTB-100和LaSOT在内的具有挑战性的基准测试上的实验表明,所提出的SiamGAT优于许多一流的跟踪器并具有领先的性能。

主要工作

【1】提出了一个图关注模块(GAM)来实现信息嵌入的部分对部分匹配。与传统的基于互相关的方法相比,该方法可以大大消除其缺点,有效地将目标信息从模板传递到搜索区域。

【2】与传统固定全局特征进行比对的方式相比,提出可以适应不同目标横纵比的跟踪框架。

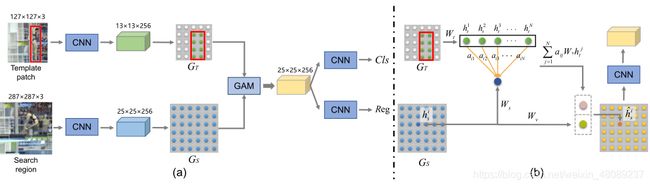

网络结构

网络主要由三部分组成:1)特征提取子网络2)目标感知图注意力模块3)用于目标定位的分类-回归子网络。用一个完全二分图建立了目标模板和搜索区域之间的部分对部分对应关系,针对不同尺寸目标可以更换模板长宽比,实现有效的信息嵌入,使搜索区域的每个部分能够聚合来自目标的信息。

结果

【7】CapsuleRRT: Relationships-aware Regression Tracking via Capsules

论文地址:https://openaccess.thecvf.com/content/CVPR2021/papers/Ma_CapsuleRRT_Relationships-Aware_Regression_Tracking_via_Capsules_CVPR_2021_paper.pdf

代码:

摘要

回归跟踪由于其易于实现的特点而得到了越来越多的关注,而现有的回归跟踪器很少考虑对象部分与完整对象之间的关系。当缺少目标对象的某些部分时,这将最终导致从目标对象漂移。最近,CapsNet由于其部分-对象关系机制,在图像分类方面显示了有希望的结果,而CapsNet即使在执行简单任务时也具有较高的计算要求。因此,CapsNet对回归跟踪的原始适应是没有意义的,因为这将严重影响跟踪器的速度。为了解决这些问题,我们首先探索CapsNet赋予回归跟踪的时空关系。整个回归框架称为CapsularRT,由三部分组成。一种是S-Caps,它捕获零件和对象之间的空间关系。同时,设计了一个T-Caps模块来利用目标内部的时间关系。通过STCaps学习获得目标的响应。此外,提出了一种预先引导的胶囊路由算法,为后续帧生成更精确的胶囊分配。除此之外,CapsNet中繁重的计算负担通过一种知识提取姿势矩阵压缩策略来解决,该策略利用更少样本的更紧密和更具区别性的表示。大量的实验结果表明,CapsularRT在准确性和速度方面优于最先进的方法。

主要工作

【1】提出T-Caps和S-Caps模块学习时空关系。