MICCAI 2022 | mmFormer:Multimodal Medical Transformer for Incomplete Multimodal Learning of BTS

Multimodal Medical Transformer for Incomplete Multimodal Learning of Brain Tumor Segmentation

摘要

从磁共振成像(MRI)中准确地分割脑肿瘤是多模态图像的联合学习所需要的。

然而,在临床实践中,并不总是能够获得一套完整的MRI,缺失模态的问题导致现有多模态分割方法的性能严重下降。

在这项工作中,我们首次尝试利用Transformer进行多模态脑肿瘤分割,该方法对可用模态的任何组合子集都具有鲁棒性。具体而言,我们提出了一种用于不完全多模态学习的新型多模态医学Transformer(mmFormer)。

它具有三个主要组件:

the hybrid modality-specific encoders(混合模态专用编码器),它桥接卷积编码器和模态内Transformer,用于在每个模态内进行局部和全局上下文建模;

an inter-modal Transformer(模态间的Transformer),用于构建和对齐模态间的长程相关性,以获得具有对应于肿瘤区域的全局语义的模态不变特征;

Decoder(解码器),其执行渐进上采样并与模态不变特征融合以生成鲁棒分割。此外,在编码器和解码器中引入了辅助正则化器,以进一步增强模型对不完整模态的鲁棒性。我们在用于脑肿瘤分割的公共BraTS 2018数据集上进行了广泛的实验。结果表明,所提出的mmFormer在几乎所有不完整模态子集上都优于最先进的不完整多模态脑肿瘤分割方法,尤其是在只有一种可用模态的情况下,Dice对肿瘤分割的平均改善率为19.07%。

1. Introduction

1.1 不同模态的重要性:

脑肿瘤在MRI中主要有四个模态 T1-weighted (T1), contrast-enhanced T1-weighted (T1c), T2-weighted (T2), and Fluid Attenuated Inversion Recovery (FLAIR) images。每种成像模式都提供了大脑结构和病理的鲜明对比。多模态图像的联合学习对于脑肿瘤分割至关重要,可以显著提高分割性能。已经广泛探索了许多方法来有效地融合多模态MRI用于脑肿瘤分割,例如,通过将通道维度的多模态图像拼接为输入或融合潜在空间中的特征。

1.2 存在的实际问题:

然而,在临床实践中,由于数据损坏、各种扫描协议和患者的不合适条件,并不总是能够获得一套完整的MRI。在这种情况下,大多数现有的多模态方法可能无法处理不完整的成像模态,并面临分割性能的严重退化。因此,对于具有一个或多个缺失模态的灵活和实际的临床应用,强烈需要鲁棒的多模态方法。

1.3 应对方法:

不完全多模态学习,也称为异模态学习旨在设计对任何可用模态子集都具有鲁棒性的方法。

1.脑肿瘤分割的不完全多模态学习的一种直接策略是通过生成模型合成缺失的模态。

2.另一系列方法探索了从完整模式到不完整模式的知识蒸馏。尽管获得了令人满意的结果,但此类方法必须为缺失模态的每个子集训练和部署特定的模型,这在临床应用中是复杂和繁重的。Zhang等人提出了一种具有自适应融合的单模态模型集成学习,以实现多模态分割。然而,它仅在一种或所有模式可用时才起作用。同时,所有这些方法都需要在训练过程中采用完整的模式。

最近的方法侧重于学习统一的模型,而不是一堆提取的网络,用于不完全多模态分割。例如,HeMIS通过计算任意数量的可用模态的特征的均值和方差来学习多模态信息的嵌入。U-HVED进一步引入了多模态变分自动编码器,以利于生成缺失模态的不完全多模态分割。最近的方法还提出了利用特征分离和注意力机制进行鲁棒的多模态脑肿瘤分割。全卷积网络(FCN)在医学图像分割中取得了巨大成功,并广泛用于上述方法中的特征提取。

尽管FCN具有优异的性能,但卷积的归纳偏差(即局部性)使得FCN难以显式地构建长距离依赖关系。在脑肿瘤分割的不完全多模态学习中,当处理不同的模式时,用有限的感受野提取的特征往往会有偏差。

相比之下,具有跨不同模态的肿瘤区域的全局语义信息的模态不变量嵌入可能有助于更稳健的分割,尤其是当一个或多个模态缺失时更为明显。

Transformer最初被提出用于对序列到序列任务的长期依赖性进行建模,并在各种计算机视觉任务上显示出最先进的性能。很多一致的工作从骨干网络的角度利用Transformer进行脑肿瘤分割。然而,用于脑肿瘤分割的多模态建模的专用Transformer尚未被仔细开发,更不用说不完整的多模态分割了。

本文旨在利用Transformer为脑肿瘤分割的不完全多模态学习建立统一模型。我们提出了多模态医学变换器(mmFormer),它利用混合模态特定编码器和模态相关编码器来构建不同模态内和跨不同模态的长程依赖性。通过显式构建和对齐不同模态之间的全局相关性来提取模态不变表示,所提出的mmFormer显示出优于脑肿瘤分割的不完全多模态学习的鲁棒性。

同时,在mmFormer中引入了辅助正则化器,以鼓励编码器和解码器学习辨别特征,即使缺少一定数量的模态。

2 方法

在本文中,我们提出了用于脑肿瘤分割的不完全多模态学习的mmFormer。我们采用编码器-解码器架构来构建mmFormer,包括用于每个模态的混合模态特定编码器、模态相关编码器和卷积解码器。此外,在编码器和解码器中都引入了辅助正则化器。

mmFormer的概述如图1所示。我们在下面详细介绍了每个组件的细节。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-98Nm5lCZ-1671247939503)(C:\Users\qiaoqiang\AppData\Roaming\marktext\images\2022-11-28-19-23-50-image.png)]

2.1 混合模态特定编码器

混合模态特定编码器旨在通过桥接卷积编码器和模态内Transformer来提取特定模态内的局部和全局上下文信息。我们用M={FLAIR,T1c,T1,T2}表示完整的模态集合。

给定Xm的输入∈ R 1×D×H×W,尺寸为D×H x W,m∈ M、 我们首先利用卷积编码器生成具有局部上下文的紧凑特征图,然后利用模态内Transformer对全局空间中的长程相关性进行建模。

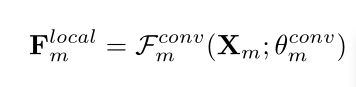

卷积编码器。 卷积编码器通过堆叠卷积块来构建,类似于U-Net的编码器部分。卷积编码器Fconvm产生的具有每个模态内的局部上下文的特征图可以公式化为

其中 F local m ∈R C× D/2的(l-1)次方× H/2的(l-1)次方× W/2的(l-1)次方,C是通道维,并且l是编码器的阶段的数量。具体的说,构建了一个五级编码器,每个块由两个卷积块组成,每个块包含级联的group normalization、Re 和卷积核大小为3的卷积层,但第一阶段的第一个卷积块仅包含卷积层。

在两个连续块之间,采用步长为2的卷积层对特征图进行下采样。编码器每级的滤波器数量分别为16、32、64、128和256。

模态内Transformer 受限于卷积网络的固有局部性,卷积编码器无法有效地在每个模态内建立长距离依赖性。因此,我们利用模态内Transformer进行显式远程上下文建模。模态内Transformer包含一个标记器、一个多头自我关注(MSA)和一个前馈网络(FFN)。

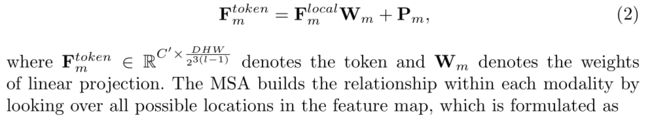

当Transformer以序列到序列的方式处理嵌入时,卷积编码器产生的局部特征图F local m首先被展平成1D序列,并通过线性投影转换成token空间。

然而,平坦化操作不可避免地破坏了空间信息,这对于图像分割至关重要。为了解决这个问题,我们引入了一个可学习的位置嵌入Pm,以通过逐元素求和来补充平坦的特征,其公式化为

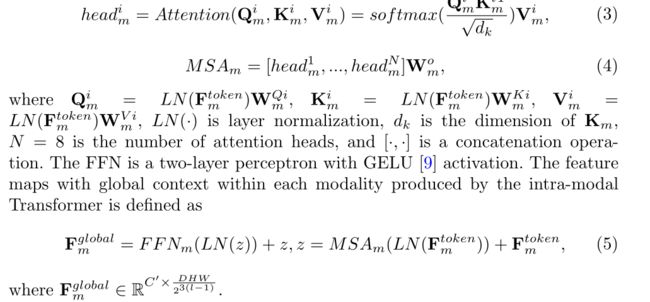

MSA通过查看特征图中的所有可能位置来构建每个模态内的关系

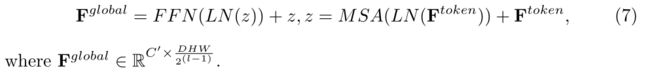

FFN是具有GELU激活的两层感知器。模态内Transformer生成的每个模态内具有全局上下文的特征图定义为

2.2 模态相关编码器

模态相关编码器设计用于为具有与肿瘤区域相对应的全局语义的模态不变特征构建跨模态的长程相关性。它被实现为一个模态间Transformer。

模态间Transformer。与模态内Transformer不同,模态间Transformer通过级联将来自所有模态特定编码器的嵌入合并为输入模态令牌,其定义为

其中δm∈ {0,1}是一个伯努利指标,其目的是在构建不同模态之间的长期依赖关系时,即使某些模态缺失,也能增强鲁棒性。通过将δm设置为0,在训练期间随机进行这种模态级丢失。如果缺少模态,则缺少模态的多模态令牌将由零向量保持。随后,MSD和FFN对其进行处理,以获得跨模态的模态不变特征,其公式如下

2.3 卷积解码器

卷积解码器被设计为将空间分辨率从高级潜在空间逐步恢复到原始mask空间。模态相关变换器的输出序列F global被重塑为与平坦化之前的大小相对应的特征图。卷积解码器具有卷积编码器的对称架构,类似于U-Net。此外,还增加了编码器和解码器之间的跳过连接,以保持更多的低级别细节,从而实现更好的分割。来自特定级别上不同模态的卷积编码器的特征被级联并作为跳过特征转发到卷积解码器。

2.4 辅助正则化器

传统的多模态学习模型倾向于根据辨别模式识别脑肿瘤。当缺少辨别模式时,此类模型可能面临严重退化。因此,即使没有其他模式的辅助,鼓励每个卷积编码器分割脑肿瘤也是至关重要的。为此,卷积编码器的输出由共享权重解码器上采样,以分别从每个模态分割肿瘤。共享权重解码器具有与卷积解码器相同的架构。此外,我们还在卷积解码器中引入辅助正则化器,以迫使解码器即使在缺少某些模态时也生成准确的分割。这是通过在卷积解码器的每个阶段内插特征图来实现的,以通过深度监督来分割肿瘤。

Dice损失被用作正则化器。将网络输出的训练损失与辅助正则化器相结合,总损失函数定义为

其中C是分割类的数量,Nc是类C的体素的数量,如果类标签C是像素i的正确分类,则gci是二进制指示符,pci是相应的预测概率,M={FLAIR,T1c,T1,T2},L是卷积解码器中的级数。

3 实验和结果

数据集和实现。

实验是在BraTS 2018数据集上进行的,该数据集包括285次多对比度MRI扫描,具有四种模式:T1、T1c、T2和FLAIR。

脑肿瘤的不同亚区域被组合成三个嵌套的亚区域:全肿瘤、肿瘤核心和增强肿瘤。组织者已将所有体积共同登记到同一解剖模板上,并将其插值到同一分辨率。采用等式(8)中定义的Dice相似系数(DSC)进行评估。该框架使用PyTorch 1.7 在四个NVIDIA Tesla V100 GPU上实现。

输入大小为128×128×128体素,批量大小为1。随机翻转、裁剪和强度偏移用于数据增强。mmFormer具有106M参数和748G FLOP。使用Adam优化器对网络进行训练,1000个epoch的初始学习率为0.0002。该模型在每个GPU上使用17G内存训练约25小时。

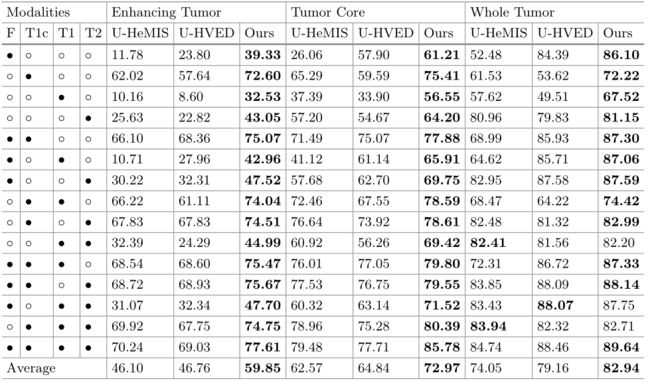

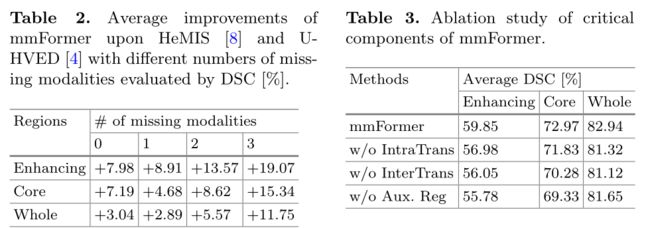

不完全多模式分割的性能。 我们评估了我们的方法对不完全多模态分割的鲁棒性。通过设置δi,i∈ {F L A IR,T 1c,T 1,T 2}为零来实现模态的缺失,用于在推断时丢弃特定模态。我们将我们的方法与使用共享潜在空间的两个代表性模型进行了比较,即HeMIS 和UHVED。为了公平比较,我们使用[21]中的相同数据分割,并直接引用结果。在表1中,我们的方法在所有15种可用模式的可能组合上的增强肿瘤和肿瘤核心的分割以及15种模式中的12种模式的整个肿瘤的分割方面显著优于HeMIS和U-HVED。在表2中,我们表明,随着缺失模式的数量增加,mmFormer获得的平均改善更为显著。同时,观察到当目标更难分割时,mmFormer获得了更多的改进。这些结果证明了mmFormer对脑肿瘤分割的不完全多模态学习的有效性。图2显示,即使有一种模式可用,mmFormer也可以实现脑肿瘤的正确分割。

我们还将mmFormer与ACN进行了比较。ACN依赖于不完全多模态脑肿瘤分割的知识提取。如果总共有N种模态,ACN必须训练 x 4 − 1 x^4 -1 x4−1次蒸馏 x N − 1 x^N -1 xN−1个学生模型用于所有缺失模式的情况,而我们的mmFormer仅通过统一模型学习一次。具体而言,ACN在1名教师和14名学生模型中使用144M参数训练672小时,而mmFormer仅需要25小时,使用106M参数。然而,mmFormer增强肿瘤、肿瘤核心和整个肿瘤的平均DSC(分别为59.85、72.97和82.94)仍然接近ACN(分别为61.21、77.62和85.92)。

完整多模式分割的性能。 我们将我们的方法与最近的基于Transformer的方法(即TransBTS)进行了比较,以实现具有全模态的多模态脑肿瘤分割。我们使用官方存储库复制结果。TransBTS在增强肿瘤、肿瘤核心和整个肿瘤方面分别获得72.66%、72.69%和79.99%的DSC。我们的mmFormer在脑肿瘤的所有分区上都优于TransBTS,DSC分别为77.61%、85.78%和89.64%,证明了mmFormer即使在完整的多模式脑肿瘤分割中的有效性。

消融研究。 我们研究了模态内Transformer、模态间Transformer和辅助正则化器作为我们方法中三个关键组件的有效性。我们通过从mmFormer中排除其中一个组件来分析每个组件的有效性。在表3中,我们将三种变体的性能与具有DSC的mmFormer进行了比较,对15种可能的输入模态组合进行了平均。它表明,模态内变换器、模态间变换器和辅助正则化器在所有肿瘤子区域带来了性能改进。

4 结论

我们提出了一种基于Transformer的脑肿瘤分割不完全多模态学习方法。所提出的mmFormer桥接Transformer和CNN,以在MRI图像的不同模态内和不同模态之间建立长期依赖关系,从而实现模态不变表示。我们在各种缺失模式的组合下验证了我们的脑肿瘤分割方法,并在BraTS基准上优于最先进的方法。当缺少更多模态和/或目标模态更难分割时,我们的方法获得了更多的改进。

ansformer和CNN,以在MRI图像的不同模态内和不同模态之间建立长期依赖关系,从而实现模态不变表示。我们在各种缺失模式的组合下验证了我们的脑肿瘤分割方法,并在BraTS基准上优于最先进的方法。当缺少更多模态和/或目标模态更难分割时,我们的方法获得了更多的改进。