神经网络模型matlab例子,神经网络及其matlab实现

matlab怎么利用神经网络做预测

谷歌人工智能写作项目:小发猫

![]()

如何利用matlab进行神经网络预测

matlab带有神经网络工具箱,可直接调用,建议找本书看看,或者MATLAB论坛找例子常见的神经网络结构。

核心调用语句如下:%数据输入%选连样本输入输出数据归一化[inputn,inputps]=mapminmax(input_train);[outputn,outputps]=mapminmax(output_train);%%BP网络训练%%初始化网络结构net=newff(inputn,outputn,[88]);net.trainParam.epochs=100;=0.01;=0.01;%网络训练net=train(net,inputn,outputn);%%BP网络预测%预测数据归一化inputn_test=mapminmax('apply',input_test,inputps);%网络预测输出an=sim(net,inputn_test);%网络输出反归一化BPoutput=mapminmax('reverse',an,outputps);%%结果分析。

如何利用matlab神经网络工具箱做神经网络分析

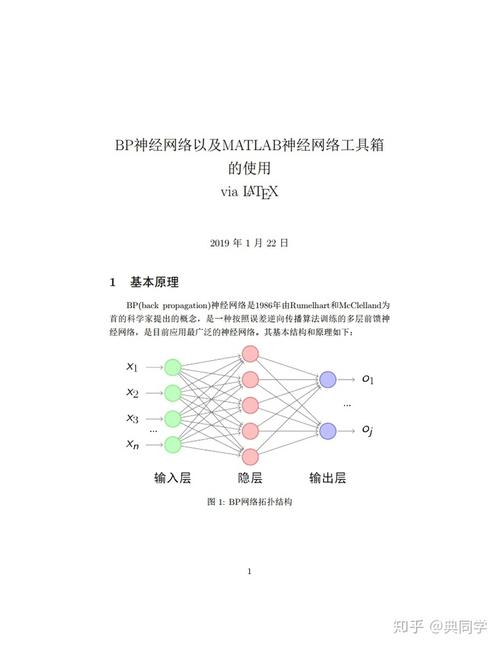

神经网络技术在模式识别与分类、识别滤波、自动控制、预测等方面已展示了其非凡的优越性。神经网络的结构由一个输入层、若干个中间隐含层和一个输出层组成。

神经网络分析法通过不断学习,能够从未知模式的大量的复杂数据中发现其规律。

神经网络方法克服了传统分析过程的复杂性及选择适当模型函数形式的困难,它是一种自然的非线性建模过程,毋需分清存在何种非线性关系,给建模与分析带来极大的方便。

Matlab神经网络原理中可以用于寻找最优解的算法有哪些?

若果对你有帮助,请点赞。神经网络的结构(例如2输入3隐节点1输出)建好后,一般就要求神经网络里的权值和阈值。

现在一般求解权值和阈值,都是采用梯度下降之类的搜索算法(梯度下降法、牛顿法、列文伯格-马跨特法、狗腿法等等),这些算法会先初始化一个解,在这个解的基础上,确定一个搜索方向和一个移动步长(各种法算确定方向和步长的方法不同,也就使各种算法适用于解决不同的问题),使初始解根据这个方向和步长移动后,能使目标函数的输出(在神经网络中就是预测误差)下降。

然后将它更新为新的解,再继续寻找下一步的移动方向的步长,这样不断的迭代下去,目标函数(神经网络中的预测误差)也不断下降,最终就能找到一个解,使得目标函数(预测误差)比较小。

而在寻解过程中,步长太大,就会搜索得不仔细,可能跨过了优秀的解,而步长太小,又会使寻解过程进行得太慢。因此,步长设置适当非常重要。

学习率对原步长(在梯度下降法中就是梯度的长度)作调整,如果学习率lr=0.1,那么梯度下降法中每次调整的步长就是0.1*梯度,而在matlab神经网络工具箱里的lr,代表的是初始学习率。

因为matlab工具箱为了在寻解不同阶段更智能的选择合适的步长,使用的是可变学习率,它会根据上一次解的调整对目标函数带来的效果来对学习率作调整,再根据学习率决定步长。

机制如下:ifnewE2/E2>maxE_inc%若果误差上升大于阈值lr=lr*lr_dec;%则降低学习率elseifnewE2

关于matlab的BP神经网络:

。

比较新的版本,比如说matlab2010以上的,都不需要装神经网络的工具箱建立网络步骤:1、数据归一化:输入的数据通常为P,输出数据通常为T,数据格式为:每列对应一个样本,归一化常用函数:mapminmax[pn,ps]=mapminmax(p);[tn,ts]=mapminmax(t)pn,tn是归一化后的数据,ps,ts是归一化的结构体,在后面反归一化预测值很有用。

2、建立网络并设定参数net=newff(pn,tn,[])中括号里面的是输入层数,隐含神经元数,输出层数,还可以设定节点传递函数等等的参数net.trainparam.epochs=1000训练的次数=0.0001训练的误差目标值=0.1学习速率,通常在0到1之间,过大过小都不好3、预测并分析an=sim(net,pn)ouput=mapminmax('reverse',an,ts)根据之前归一化的标准,对预测结果进行反归一化,得到结果error=output-t这里是对误差进行输出,也可以用error=sum(asb(output-t))当然也可以作图,比如说:plot(p,t,'-o')holdonplot(p,output,'-*')看预测值和真实值能否吻合还可以在神经网络训练完成后的对话框中看MSE和R方还有很多方法提高神经网络的精度,以上程序没有经过MATLAB调试,但大致过程如上纯手打,希望采纳!

谁能教我Matlab 神经网络分析?

自学的话,从基本学起,可以看看下面这本书,看完基本的神经网络都熟悉了。

人工神经网络(ArtificialNeuralNetwork,即ANN),是20世纪80年代以来人工智能领域兴起的研究热点。

它从信息处理角度对人脑神经元网络进行抽象,建立某种简单模型,按不同的连接方式组成不同的网络。在工程与学术界也常直接简称为神经网络或类神经网络。

神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。每个节点代表一种特定的输出函数,称为激励函数(activationfunction)。

每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。

而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

MATLAB中BP神经网络的训练算法具体是怎么样的

BP算法的基本思想是,学习过程由信号的正向传播与误差的反向传播两个过程组成。正向传播时,输入样本从输入层传入,经各隐层逐层处理后,传向输出层。

若输出层的实际输出与期望的输出(教师信号)不符,则转入误差的反向传播阶段。

误差反传是将输出误差以某种形式通过隐层向输入层逐层反传,并将误差分摊给各层的所有单元,从而获得各层单元的误差信号,此误差信号即作为修正各单元权值的依据。

这种信号正向传播与误差反向传播的各层权值调整过程,是周而复始地进行的。权值不断调整的过程,也就是网络的学习训练过程。此过程一直进行到网络输出的误差减少到可接受的程度,或进行到预先设定的学习次数为止。

1)正向传播:输入样本->输入层->各隐层(处理)->输出层注1:若输出层实际输出与期望输出(教师信号)不符,则转入2)(误差反向传播过程)2)误差反向传播:输出误差(某种形式)->隐层(逐层)->输入层其主要目的是通过将输出误差反传,将误差分摊给各层所有单元,从而获得各层单元的误差信号,进而修正各单元的权值(其过程,是一个权值调整的过程)。

注2:权值调整的过程,也就是网络的学习训练过程(学习也就是这么的由来,权值调整)。具体的公式和推导请参阅相关教材,这里很难表述公式。