OM | 论文精读: 深度强化学习与智慧交通(一)

作者:宋绪杰

随着城市化和新兴智能技术的发展,交通运输系统中包含了越来越多的人工智能技 术(AI),被称为智能交通系统(ITS)。本文主要讨论强化学习(RL)在智能交通系统中的应用,下面摘录文中与“交通信号灯 控制”相关的内容。

论文标题:Deep Reinforcement Learning for Intelligent Transportation Systems: A Survey

论文作者:Ammar Haydari, Yasin Yılmaz

随着城市化和新兴智能技术的发展,交通运输系统中包含了越来越多的人工智能技 术(AI),被称为智能交通系统(ITS)。ITS 和 AI 的结合为 21 世纪运输科学研究提供了 有效解决方案,主要应用领域包括“交通信号灯控制”、“自动驾驶”、“交通流控制”等。本文主要讨论强化学习(RL)在智能交通系统中的应用。

在 Reinforcement Learning (RL) 中,智能体在 时刻观测到系统状态 ![]() ,根据当前策略 采取动作

,根据当前策略 采取动作![]() ,并从环境中获得回报

,并从环境中获得回报![]() ,系统转移到下一状态

,系统转移到下一状态![]() 。在每一轮交互中,智能体更新从环境中学到 的知识,下图展示了 RL 的学习过程。

。在每一轮交互中,智能体更新从环境中学到 的知识,下图展示了 RL 的学习过程。

RL 可分为以下两种类型:

-

Model-based RL:智能体知道从状态

转移到

转移到 的概率。

的概率。 -

Model-free RL:智能体不知道转移概率,通过探索环境来学习这个状态转移模型。Model-free RL 又可分为 value-based 和 policy-based 两种。

用 RL 解决交通信号灯控制(TSC)问题需要好好设计如下几个模块:

01 状态(state)

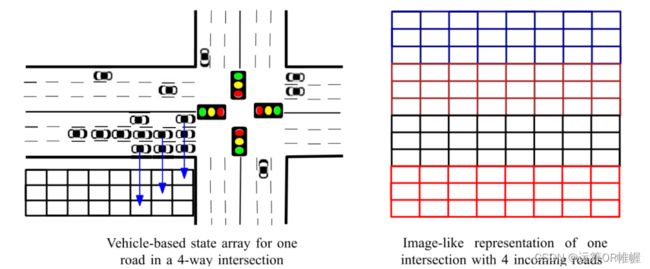

(1) Discrete traffic state encoding (DTSE):这是一种类图像的状态表示形式,将一个车道划分为 个格子,每个格子的长度可容纳一辆汽车,用格子里的值来表示当前路口的 状态。这种状态表示方法较为精细,但数据相对较难收集。

(2) Feature-based value vector:这类方法将某个信息的平均值或总量表示在一个向量中,比如队列长度、等待时间、平均速度、车辆数目等。通常这些信息可以通过路侧 传感器方便地收集。

02 动作(action)

(1) 选择一个相位:在一个交叉路口,通常可以有 4 个绿灯相位,第一种动作可以 选择其中一个相位并执行。

(2) 选择是否改变当前相位:第二种动作可以是一个 01 变量。此种情况下,通常相 位顺序是确定的,通过动作来选择是否改变当前相位并进入下一相位。

(3) 改变当前相位的持续时间:第三种动作可以是连续动作空间下的动作,它表示 当前相位的持续时间。

03 回报(reward)

常用回报包括:等待时间(waiting time),累计延迟(cumulative delay),排队长度 (queue length)以及它们的组合等。

04 神经网络结构(neural network structure)

常用神经网络结构包括:

(1) MLP:即多层感知机,这是标准的全连接神经网络。

(2) CNN:可以看做拥有卷积核的 MLP,有较强的从图像到输出的映射能力。

(3) ResNet:用来解决 CNN 类型网络过拟合问题的网络结构。

(4) GCN:即图卷积神经网络,可在图结构中做卷积操作。

(5) RNN:即循环神经网络,例如 LSTM 网络。经常用于处理序列数据。

05 仿真环境(traffic simulator)

(1)Green Light District (GLD):这是早期一个基于 Java 开发的交通仿真器,有许多 RL 研究使用这个仿真器。

(2) Simulation Urban Mobility (SUMO):这是最受欢迎的开源仿真器之一,用户可以 使用 Python 的 TraCI 接口库实现与环境的交互。

(3) AIMSUN:这是由 Transport Simulation Systems (Spain)设计的一个商用求解器。

(4) Paramics:这是由 Quadstone Paramics (UK)设计的一个商用求解器。(5) VISSIM:是类似于 AIMSUN 的仿真器,拥有 MATLAB 接口。

参考文献:

-

Haydari A, Yilmaz Y. Deep reinforcement learning for intelligent transportation systems: A survey[J]. IEEE Transactions on Intelligent Transportation Systems, 2020.