Incorporating Dynamic Semantics into Pre-Trained Language Model for Aspect-based Sentiment Analysis

论文解读:Incorporating Dynamic Semantics into Pre-Trained Language Model for Aspect-based Sentiment Analysis(将动态语义融入预训练语言模型中,用于面向方面的情感分析)

ACL2022

文章目录

- 论文解读:Incorporating Dynamic Semantics into Pre-Trained Language Model for Aspect-based Sentiment Analysis(将动态语义融入预训练语言模型中,用于面向方面的情感分析)

- 摘要

- 1介绍

- 2 研究情况

-

- 2.1基于方面的情感分析

- 2.2人的语义理解

- 3 Dynamic Re-weighting BERT 介绍

-

- 在这里插入图片描述

- 3.1 Embedding Module嵌入模块

- 3.2 BERT Encoder 编码器

- 3.3 Dynamic Re-weighting Adapter (DRA) 适配器

- 3.4 Sentiment Predicting情绪预测

- 4.1 数据集

- 4.2 参数

- 4.3 Baselines

- 4.4 实验结果

- 4.5 适配器研究

- 4.6 解释能力验证

- 4.7 误差分析

- 5 计算时间比较

- 6 结论

摘要

基于方面的情感分析(ABSA)预测了句子中特定方面的情感极性。虽然BERT等预先训练好的语言模型取得了巨大成功,但将动态语义变化融入ABSA仍然具有挑战性。

在本文中,我们提出通过**动态重加权BERT (DR-BERT)来解决这个问题,这是一种用于学习面向方面的动态ABSA语义的新方法

具体来说,我们首先将Stack-BERT层作为主编码器,以掌握句子的整体语义,然后通过合并轻量级动态重加权适配器(DRA)**对其进行微调。(DRA可以在每一步密切关注句子的一小部分区域,并重新权衡至关重要的单词,以更好地理解方面意识到的情绪)

最后,在三个基准数据集上的实验结果证明了本文提出的模型的有效性和合理性

1介绍

来自transformers的双向编码器表示(BERT) 实现了改进许多语言任务的突破

在ABSA中,Xu等人(2019a)设计了BERT- pt,在BERT模型上探索了一种新的训练后方法。

Song et al.(2019)进一步提出了一种文本对分类模型BERT-SPC,该模型通过将方面附加到上下文句子中来准备输入序列。

尽管上述研究取得了巨大的成功,但在将注意机制直接应用到ABSA任务中或对预先训练的BERT进行微调时仍存在一些关键问题

具体来说,现有的大多数方法都是从上下文句中一次性选择所有重要的词。然而,根据神经科学研究,语义理解过程中的基本词是随着阅读过程而动态变化的,应该反复考虑

同时,简单地用预训练的BERT初始化编码器并不能像我们预期的那样有效地提高ABSA中的性能。模型需要充分考虑给定的方面来理解句子的区域语义

2 研究情况

2.1基于方面的情感分析

Ding和Liu(2007)首先执行依赖解析来确定关于方面的情感极性.

近年来,大多数研究都是利用注意机制来学习词汇的语义关系…….

此外,另一个研究趋势是利用语法知识来学习方面的语法感知特征。例如,Tang等人(2020)开发了依赖图增强双transformer网络来融合平面表示. 最近,预训练方法已被证明在ABSA任务中非常成功。Song等人(2019)设计了一个注意编码器和一个BERT-SPC模型来学习方面和上下文之间的特征。Wang等人(2020)重塑了依赖树,提出了一个关系图注意网络来编码语法关系特征。Tian等人(2021)通过类型感知图网络显式地利用依赖类型来学习感知方面的关系。

然而,这些方法在很大程度上忽略了动态语义理解的过程, 并不能完全揭示方面相关词的动态语义变化。

2.2人的语义理解

为了更好地理解语义,大多数人一次只关注句子的一小部分,需要反复处理重要的部分

在上述研究和语言心理学理论的启发下,本文通过将动态语义理解过程融入到预训练的语言模型中,探索ABSA任务的方面语义变化

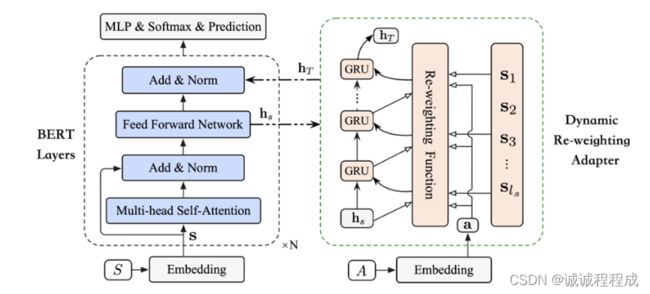

3 Dynamic Re-weighting BERT 介绍

(DR-BERT) 动态重加权bert

图1

问题定义:

在ABSA中,给出了一对句子-方面 (S, A)

本文将句子表示为

它由一系列ls的单词组成

具体方面表示为

la是方面词的长度

ABSA的目标是学习一种能够精确预测特定方面A的句子S的情感极性的情感分类器

本文通过所提出的动态选择和encoder方面感知的语义信息

整体架构:

DR-BERT主要包含两个组件:

(即BERT encoder编码器和Dynamic re - weighted Adapter适配器),

以及两个模块:

(即embedding module嵌入模块和sentiment prediction module情感预测模块)

下面内容解释两个组件、两个模块

3.1 Embedding Module嵌入模块

首先将每个词映射到一个低维向量中。具体来说,DR-BERT的输入是句子序列和方面序列

对于句子序列,我们构造BERT输入为"[CLS]" +句子+“[SEP]”

并且句子S 可以转换为隐藏状态s

对于方面序列,我们采用相同的方法得到每个单词的表示向量

因此,通过嵌入模块,方面序列A映射为

注意,如果方面序列是像“food”这样的单个单词,则方面表示就是嵌入单个词语"food"

而对于方面序列包含多个单词(如“system memory”)的情况,方面表示是每个嵌入单词的平均值

我们可以将方面嵌入过程表示为:

其中 aj 是单词j在方面序列中的嵌入,A表示方面的嵌入。

3.2 BERT Encoder 编码器

多头Self-attention机制

Position-wise Feed-Forward Network网络

3.3 Dynamic Re-weighting Adapter (DRA) 适配器

设计了一个动态重加权适配器(DRA),它可以动态地强调ABSA任务中重要的方面感知词。

如图右侧所示,DRA根据整个句子的整体语义,进一步在每一步选择最重要的单词,并考虑具体的方面表示

DRA的输入是bert encoder的输出和原始embedding的输出

在每一步中,我们首先利用re-weighting attention从输入序列s1 s2 s3…中选择当前输入的单词

然后利用门控循环单元对所选单词进行编码

- The Re-weighting Function 重加权函数

利用注意机制来实现重加权函数F , 目的是在每一步中选择最重要的方面相关词 - The GRU Function.

为了更好地对整个句子的语义进行编码,利用GRU进一步模拟了人类在特定语境下的语义理解过程,这与人们根据理解行为调整对新文本的适应过程是一致的.

给定之前的向量嵌入,将GRU作为输入接收,计算其隐藏向量

3.4 Sentiment Predicting情绪预测

经过N层BERT叠加后,我们得到了句子的最终表示形式

然后,我们将其输入多层感知机(MLP)

并通过一个softmax层将其映射到不同情绪极性的概率

4 实验

4.1 数据集

主要在“Laptop”、“Restaurant” 和“Twitter” 三个ABSA基准数据集上进行实验。每个数据项都有3个情绪极性(positive, negative and neutral)

4.2 参数

在实现中,基于官方的bert-base模型构建框架(nlayers=12, nheads=12, nhidden=768)。gru的隐藏大小和DRA的重加权长度被设置为256和7。学习率在[2e-5, 5e-5和1e-3]之间进行调整,批量大小在[16,32,64,128]中进行手动测试。退出率设置为0.2。超参数l, β和λ经过仔细调整,最终值分别设置为3,0.8和100。该模型使用Adam优化器进行训练,并通过两个广泛使用的指标进行评估。基线模型参数按照原论文的默认配置。

4.3 Baselines

基于注意的模型:……….

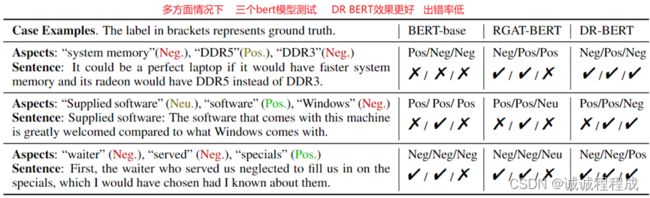

预训练模型: BERT、BERT-PT、BERT-SPC、 AEN-BERT、RGAT-BERT、TGCN

4.4 实验结果

基于bert的方法在两个指标上都优于大多数基于注意力的方法。这一现象表明了预训练语言模型的强大能力。这也是为什么我们采用BERT作为基本编码器来学习整个句子的整体语义表示。

通过比较ABSA的非特定BERT模型(即BERT和BERT-PT)与任务特定模型(如RGAT-BERT),我们发现任务特定BERT模型比非特定模型表现更好。具体而言,我们还可以观察到T-GCN&RGATBERT >AEN-BERT>BERT- pt >BERT的性能趋势,这与之前关于方面相关信息是ABSA模型性能关键影响因素的假设是一致的。

最后,DR-BERT模型仍然优于其他BERT模型(即T-GCN或RGATBERT)。结果证明了基于语义理解过程的动态模型策略的有效性。同时,这也表明我们提出的DRA比之前方法中的其他BERT附加组件能够更好地掌握句的方面感知语义。

4.5 适配器研究

如图,下面研究bert插入不同组件(DRA和mlp)的影响。

我们可以发现,如果不使用adapters适配器和mlp,,DR-BERT将退化为BERT模型,在所有变体中获得最差的性能。这一现象表明了DRA和MLP模块的有效性,且DRA在最终情绪预测中比MLPs发挥更关键的作用。

由于BERT模型通常相当深(例如,12层),我们只将动态重加权适配器插入顶层(例如,第3层、第6层和第9层),以进一步验证DRA模块的有效性。结果如表3的(3)、(4)和(5)所示。

我们观察到,当向DR-BERT的顶层引入适配器时,我们的框架仍然优于BERT模型,这表明DRA在整个句子中编码方面感知的语义是有效的。

下面我们将研究适配器的规模对不同数据集的影响

将适配器的动态重加权长度(T)调到一个较宽的范围内(即2到10)。DR-BERT的性能首先随着重权长度的增加而变好,在7左右达到最佳效果。然后,随着长度的继续增加,性能继续下降。

这一现象与心理学发现相一致,即人类的记忆集中在近7个单词上,这进一步表明了DRA在模拟类人(动态)语义理解方面的有效性。

4.6 解释能力验证

为了评估模型的合理性和可解释性,我们利用眼动仪进行了动态语义理解的研究

当一个人试图理解一个相对较长的句子时,他/她会先阅读整个句子。随后,在给出一个具体的方面后,他会根据之前的记忆状态动态地选择相关词汇,直到他完全理解了所给方面的情感极性。

有趣的是,上述现象与我们的动态重加权适配器的选择结果是一致的,通过重新加权函数F(即方程5和6),我们的模型动态选择了“food, better, while, definitely, not,…”,这对于预测“food”方面的情感非常重要。

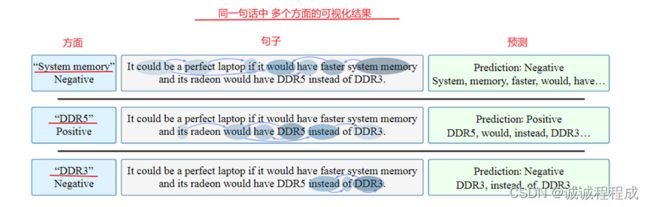

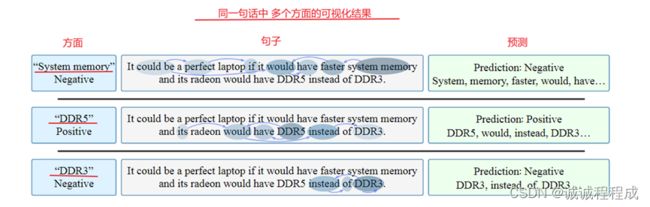

很多文本包含多个方面,模型在复杂场景中的表现很重要。

例如,一个评论句包含多个方面。因此,我们随机选择了一个例子来探讨上下文词的选择在不同的输入下会发生怎样的相应变化。

句子有三个不同的情感极性,即 “系统记忆”-消极、“DDR5”-积极、“DDR3”-消极。

以“DDR5”为例,它与“DDR3”相反,是积极的。读者在接收到整句话的整体语义后,倾向于将“DDR5”与上下文词{“would”、“have”}联系起来,预测正确的情绪“positive”。

总之,所有这些结果表明DR-BERT可以动态提取重要信息,以实现方面感知的语义理解,即使在更复杂的场景中也是如此。

4.7 误差分析

5 计算时间比较

虽然DR-BERT包含了基于GRU的动态重加权适配器,但计算时间远低于基于bert的框架

6 结论

本文介绍了一种新的基于方面的情感分析方法——动态重加权BERT (DR-BERT)。

首先使用BERT层作为基本编码器来学习整个句子的整体语义特征。然后,受人类语义理解的启发,我们设计了一种新的动态重加权适配器(DRA),以增强情感学习过程中方面感知的语义特征。此外,我们将DRA插入到BERT层中,以解决ABSA任务中训练模型的局限性。在三个基准数据集上的大量实验证明了该模型的有效性和可解释性。