解读论文EPSILON: An Efficient Planning System for Automated Vehicles in Highly Interactive Environments

1.算法流程

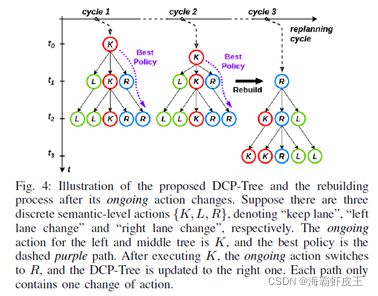

2.DCP-Tree

DCP-Tree是与一定时间持续时间相关的预定义语义动作,树的有向边表示时间上的执行顺序。DCP-Tree从一个正在进行的行动φˆ(上一个计划周期中最优策略的执行行动)开始,每次进入一个新的规划集,通过将φˆ设置为根节点来重建DCP-Tree。可能的策略序列的数量按指数级扩展,为了克服这个问题,根据一个预定义的策略来扩展DCP-Tree,不会在一个决策周期中来回改变驾驶策略。因此,从正在进行的行动来看,每个策略序列在一个规划周期中最多包含一个行动变化,来回的行为则是通过重新规划来实现的。

DCP-Tree确定了智能体的整个决策空间Π。候选策略可以通过遍历DCP-Tree上从根节点到所有叶节点的所有路径来获得。因此,将行为规划简化为从候选策略集中选择效用最大的最佳策略。

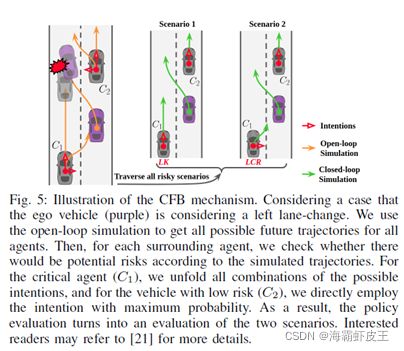

3.CFB流程

CFB的目标是对自我策略的制约,找出附近可能导致风险结果的汽车,尽可能少的分支场景。例如,当驾驶员想要换车道时,会更加关注左车道的情况而不是右车道的情况。因此,通过对自我策略序列的约束,我们可以挑选出一组与自我策略相关的车辆。

4. Multi-agent Forward Simulation

前向仿真实现了一个场景,在多智能体前向运动过程中,生成自车和其他车辆的所有轨迹,假设每个交通参与者在每个时间实例中独立做出决策。

5.Safety Mechanism

如果现实世界的驱动偏离了预定义的模型,该怎么办?

提出了一个两级安全机制:

首先,通过在上下文感知控制器中嵌入安全模块(responsibility-sensitive safety, RSS);

RSS提供了各种驾驶情况下安全横向和纵向距离的数学模型,以及在危险情况下的正确反应(即:当安全距离不满足时)。对于每一个仿真步骤,检查被控车辆的仿真状态是否rss安全。如果没有,则检查上下文感知控制器提供的控制信号是否遵循RSS模型定义的适当响应准则。如果仍然没有,产生一个安全的控制信号服从适当的响应,并覆盖控制输出。

其次,通过在策略选择中设置安全准则(备份计划),增强决策层的鲁棒性;

行为规划器在一个规划周期中评估多个策略,可以将成功完成正向模拟和安全检查的任何其他策略作为备份计划,为备份策略选择手工制定了一个优先级。例如,“变道”策略的备份计划应为“取消变道”。我们可以找到相应的备份策略,检查是否至少有一个可行的计划。如果是,则执行计划中的策略。如果根本没有安全策略,即行为规划失败,则会显示警告信号,触发自动紧急制动(AEB)等低电平主动保护。

6.Semantic-level Actions and DCP-Tree

考虑横向和纵向行动,以获得一个多样化的驾驶政策,由于车辆最常见的横向运动是在可用车道间换道,横向动作的次数Nalat。

对于纵向运动,为了保证运动的连续性和安全性,采用了预先设定的速度控制器,而不是直接施加纵向加速度信号。定义纵向语义动作集Nalon = 3个项目:{积极,温和,保守}。将横向动作和纵向动作相结合,得到Nalon ×Nalat语义级动作。

对于DCP-Tree,设置树的深度为5。为每个语义级动作分配了1 s的时间持续时间,而闭环仿真以0.2 s的分辨率进行,以保持逼真度。因此,所提议的行为规划师的规划期限为5秒。

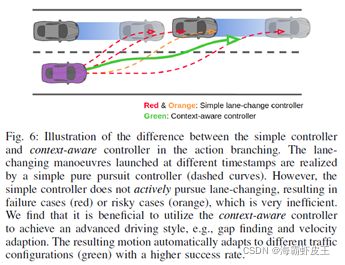

7.Context-aware Forward Simulation Model

闭环仿真的目标是将多智能体系统的状态向前推进,同时考虑潜在的交互作用。

在车道保持方面,横向控制器遵循纯跟踪控制器,纵向运动由IDM控制。

对于变道机动,纵向控制和横向控制是耦合的,将横向控制器扩展为纯追踪控制器,将纵向控制器扩展为速度控制器。

侧向转向控制:

首先检查目标车道是否有足够的归并空间, 以目标车道的中心线γ1 作为纯跟踪控制器的参考路径,否则(图7a),使用备用无碰撞路径γ2 作为参考,横向位置为:

![]()

通过跟踪交替参考路径γ2时,被控车辆可以在不越过车道标记的情况下,在与障碍物保持适当距离的情况下,向目标车道轻微移动。利用纯跟踪控制器可以计算出相应的转向角

![]()

纵向控制:

在目标车道上选择一个间隙,根据新的leader Cf![]() 和追随者Cr

和追随者Cr![]() 的状态生成一个期望的纵向状态,

的状态生成一个期望的纵向状态,

![]()

![]()

Spref 纵向巡航速度由用户和交通规则指定,Str 和Stf 是由最小间距和对应的车头时距导出的阈值位置:

![]()

所提出的期望状态为变道机动时的纵向控制提供了一个目标,使整个过程舒适和安全。即使当保险杠与保险杠之间的距离很小时,期望状态仍然存在,自车纵向状态将逐渐收敛到目标并与间隙对齐。一旦产生期望的纵向状态,应用简单的反馈控制器将自车推向期望状态。控制器的输出为纵向加速度轨迹,形式为

![]()

在换道过程中,考虑当前领先车辆Cl 确保安全,使用普通的IDM来获得另一个加速度aidm![]() 保持自我车道的距离。因此,速度控制器的输出被定义为

保持自我车道的距离。因此,速度控制器的输出被定义为

![]()

为了达到更高的安全要求,使用RSS-safety准则对横向和纵向控制命令进行了双重检查,一旦在当前仿真步骤中自车为RSS- dangerous,给出可行的加速度纵向和横向限制,与控制约束与输出信号(δctrl![]() 和一个actrl

和一个actrl![]() )作比较,并检查输出是否满足适当的响应。如果不是,产生一个安全的控制信号覆盖输出。

)作比较,并检查输出是否满足适当的响应。如果不是,产生一个安全的控制信号覆盖输出。

7.Policy Evaluation

策略的总奖励是由每个CFB选择的场景的奖励的加权总和计算的。每个场景的奖励函数由效率成本F e,安全成本Fs 和航行费用Fn:

效率成本:

![]()

![]()

![]()

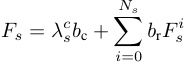

安全成本:

将自车轨迹的所有离散状态与附近的所有其他轨迹进行评估。如果发生碰撞,相应的场景将被直接标记为失败。此外,检查了自车轨迹是否存在Rss危险状态。如果状态为RSS-dangerous时,得到安全速度区间[vrsslb, vrssub]![]() ,并通过与安全速度区间的差值来惩罚状态。

,并通过与安全速度区间的差值来惩罚状态。

bc 和br 分别为表示车辆碰撞和rss安全的违反的布尔值。λcs是碰撞的惩罚。Ns 是轨迹中模拟状态的总数。

导航成本:

![]()

其中bnavi![]() 和bconsist

和bconsist![]() 分别表示匹配导航目标和决策历史一致性。

分别表示匹配导航目标和决策历史一致性。

注意Fs 和Fe 生成每个语义级动作。引入了一个折扣因子γ来调整遥远未来的奖励权重,我们将其设置为γ = 0.7。

(源码链接:git clone https://github.com/HKUST-Aerial-Robotics/EPSILON.git)