论文阅读笔记---Deep HDR Video from Sequences with Alternating Exposures

Kalantari N K, Ramamoorthi R. Deep HDR Video from Sequences with Alternating Exposures[C]//Computer Graphics Forum. 2019, 38(2): 193-205.

摘要:

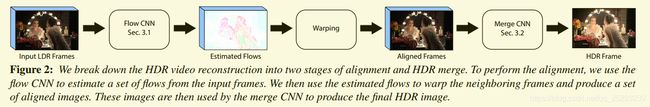

在本文中,提出了一种基于学习的方法来,我们使用两个顺序卷积神经网络(CNN)对整个HDR视频重建过程进行建模。第一步,我们使用网络专门为该应用设计了一个网络,通过估算相邻帧之间的光流,将它们与当前帧对齐。然后,我们使用anotherCNN组合对齐的图像和当前图像,以生成最终的HDR帧。我们通过最小化在一组训练场景上重建的和真实的HDR图像之间的误差来执行端到端训练。我们从现有的HDR视频数据集中综合生成训练数据,并使用一种简单的方法来模拟标准数码相机的缺陷。实验结果表明,我们的方法可以产生高质量的HDR视频,而且对于有两个或三个可选曝光的序列,此方法比现有的SOTA方法快一个数量级.

本文的方法启发来自于[Kalantari and Ramamoorthi], 将视频问题分为两步 对齐和HDR合并, 使用光流法[Liu09]对齐, 使用cnn 合并.

但是由于使用了基于优化的光学流方法进行对准速度慢,而且,现有的光流方法并未针对产生高质量HDR video进行优化,因此, 我们建议通过使用两个顺序的CNN对对准和HDR合并组件进行建模来解决这些问题(提出了两个网络,光流预测网络以及合并网络,从而实现HDR视频的生成。),并通过最小化估计的HDR帧与地面真实HDR帧之间的误差,以端到端的方式训练两个网络.

总结贡献:

•我们提出了第一种深度学习方法,该方法可以通过一系列交替曝光来制作HDRvideo。我们的方法是实用的,可以产生高质量的结果,并且比当前技术快50到110倍(表4)。

•我们提出了一种专门为HDR视频重建应用设计的流网络,并且其性能比现有的非学习和基于学习的光流方法更好。

•本文对KALANTARI的合并网络的输入和结构进行修改,从而极高的提高了质量。

本文的目的是通过交替的曝光度的视频来合成HDR视频,并将两个曝光度扩展为三个曝光度。

要生成HDR帧,![]() ,我们需要使用具有不同曝光量(

,我们需要使用具有不同曝光量(![]() 和

和![]() )的相邻帧在帧i(参考)处重建丢失的内容. 已有的方法慢[KSB∗13, LLM17],

)的相邻帧在帧i(参考)处重建丢失的内容. 已有的方法慢[KSB∗13, LLM17],

3.1 Preprocessing

为了减少处理的复杂性,首先,通过相似变换(旋转、平移、缩放)来使得相邻帧全局对齐到参考帧。通过在参考图像中找到对应的角点特征并使用RANSAC方法从计算的对应关系中找到该相似性模型。此外,我们用伽玛曲线替换了输入图像的原始相机响应函数(CRF). 具体做法: 使用逆CRF()转换所有帧到线性HDR域![]() (ti是帧i的曝光时间), 然后使用gamma曲线将图片从HDR 转换到LDR域:

(ti是帧i的曝光时间), 然后使用gamma曲线将图片从HDR 转换到LDR域: ![]()

![]() , 其中 clip 函数是保证输出在[0, 1]范围,

, 其中 clip 函数是保证输出在[0, 1]范围, ![]()

预处理过程是全局对齐图像 ![]() 使用gamma矫正得到

使用gamma矫正得到![]()

网络结构:

3.2 Flow Network

首先通过全局对齐获得输入图片![]() (全局对齐的),光流网络的目的是解决全局对齐所产生的非刚性移动、视差及潜在的不确定性.

(全局对齐的),光流网络的目的是解决全局对齐所产生的非刚性移动、视差及潜在的不确定性.

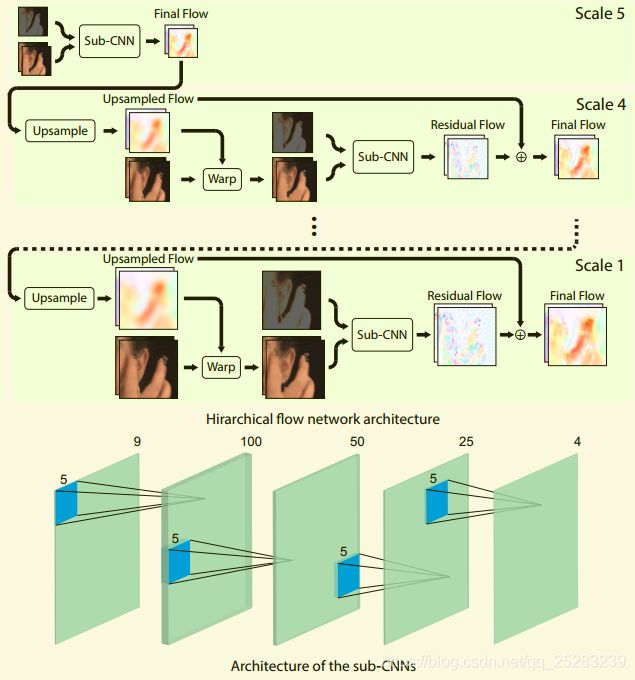

尽管有强大的非学习光流技术[Liu09,XJM12,RWHS15,HLS17],但出于两个原因,使用CNN对光流估算过程进行建模。首先,CNN效率高并且可以在GPU上实现,因此,它们比基于非学习优化的光流方法快得多。其次,光流估算只是我们系统的一个组成部分,其总体目标是产生高质量的HDR视频。通过以端到端的方式训练我们的系统,可以优化光流估算,以最大程度地提高HDR video的质量。因此,与现有的光流估算技术相比,我们的光流估算网络更适合HDR视频重建应用。

由于相邻帧的曝光度不同,需要调整参考图片的曝光度,来匹配相邻帧![]() , 函数h 是将图像Zi从LDR域转换到线性HDR域的函数,

, 函数h 是将图像Zi从LDR域转换到线性HDR域的函数, ![]()

输入{![]() } (9 channel), 产生输出 4 channel ( i-1 , i+1帧 到 参考帧, x和y轴方向的光流估计结果), 通过光流去形变相邻图像得到对齐的图像.

} (9 channel), 产生输出 4 channel ( i-1 , i+1帧 到 参考帧, x和y轴方向的光流估计结果), 通过光流去形变相邻图像得到对齐的图像.

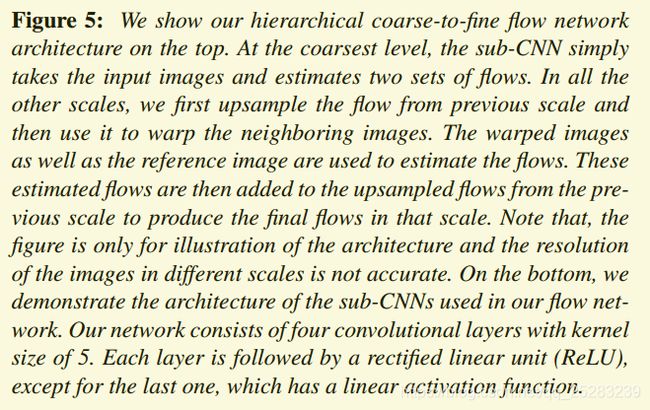

我们的系统由一系列以不同分辨率工作的光流估算器CNN组成。在较大的尺度上估算的流量捕获较大的运动,并用于在较小的尺度上初始化CNN的输入,从而负责估算较小的运动, 最终将光流对齐 ![]() , 得到对齐后的图像

, 得到对齐后的图像 ![]()

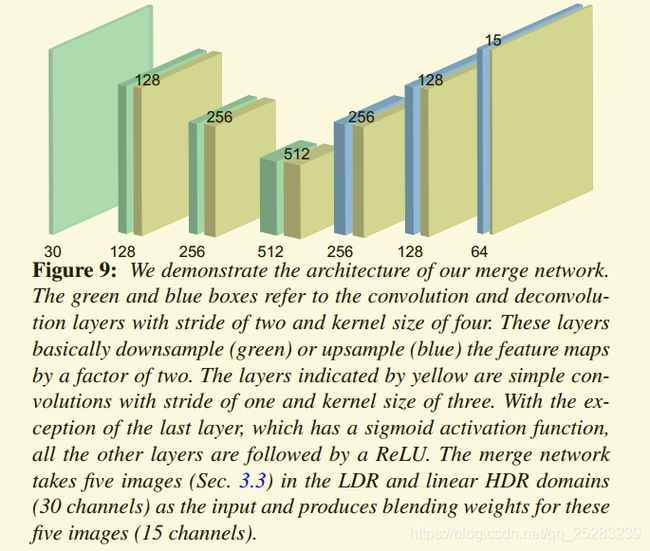

3.3. Merge Network

该网络的目标是从对齐的图像和参考图像中生成高质量的HDR帧。由于已对齐的图像包含残差对齐伪像,因此该网络应从根本上检测出这些伪像并将其从最终的HDR图像中排除。最近,Karantari和Ramamoorthi [KR17]证明了CNN可以有效解决这一具有挑战性的问题。在这里,我们还使用CNN来从一组LDR输入生成HDR图像,但提出两个简单但必要的输入和体系结构更改,以提高结果的质量.

输入: ![]() ( LDR和线性HDR域都作为网络的输入 ,共30 channels)

( LDR和线性HDR域都作为网络的输入 ,共30 channels)

输出: 5个图像的混合权重(15 channels)

最终 HDR image ![]() :

:

Architecture:

4.1 loss function

HDR图像和视频通常在色调映射后显示,该过程通常会提高暗区中的像素值。因此,直接在线性HDR域中定义损耗函数会低估暗区中的误差。为了避免这个问题,我们将HDR图像转移到对数域中,

Hi 是HDR帧范围是[0,1], u设置为5000是控制压缩率

数据集处理:

添加噪声, 0均值,方差在[10^-3, 3*10^-3]范围随机取值的高斯噪声 在低曝光的LDR图像中.

色调扰乱(tone perturbation), 通过将伽马函数独立应用于其不同的颜色通道,从而稍微干扰了参考图像的色调, 具体的![]() , d是随机选取的范围[-0.7, 0.7].

, d是随机选取的范围[-0.7, 0.7].

patch generation: 将图像分解成352×352的小重叠块,步幅为176, 我们的数据集中大多数patch都包含静态背景,这对于训练光流网络没有用。因此,仅当两个相邻图像的超过2000个像素的绝对差大于等于0.1才选择patch.

结果处理:

逆色调映射使用 Reinhard [RSSF02] 方法,

temporal coherency时间一致性使用[kYWS03]方法, 具体如下:

时间色调映射由全局和局部阶段组成:对于全局映射,计算平均和最大亮度,它们控制传递函数以提供良好的初始亮度映射。对数平均亮度由下式给出:

, 其中

, 其中![]() , N是像素个数, Fi 是由时间k − 1和k处的帧组成的因果时间邻域.

, N是像素个数, Fi 是由时间k − 1和k处的帧组成的因果时间邻域.

[KR17] KALANTARI N. K., RAMAMOORTHI R.: Deep high dynamic range imaging of dynamic scenes. ACM TOG 36, 4 (2017).

[Liu09] LIU C.: Beyond Pixels: Exploring New Representations and Applications for Motion Analysis. Doctoral thesis, Massachusetts Institute of Technology, May 2009.

[KSB∗13] KALANTARI N. K., SHECHTMAN E., BARNES C., DARABI S., GOLDMAN D. B., SEN P.: Patch-based high dynamic range video. ACM TOG 32, 6 (Nov. 2013), 202:1–202:8.

[LLM17] LI Y., LEE C., MONGA V.: A maximum a posteriori estimation framework for robust high dynamic range video synthesis. IEEE Transactions on Image Processing 26, 3 (March 2017), 1143–1157.