论文解析(1)——语义分割(求索ljj解读:A Review on Deep learning Techniques Applied to Semantic Segmentation)(更新中))

论文地址:https://arxiv.org/abs/1704.06857

摘要:

社会需求:精确且高效的分割技术。 现需领域:自动驾驶,室内导航,虚拟现实,增强现实等。

技术发展:语义分割,场景理解等。

文章内容:

- 相关术语 背景知识

- 主要数据集 对应挑战

- 现有方法 各自贡献及影响

- 针对所述方法及实验结果的分析

- 未来工作发展方向

1)引言:宏观 :语义分割是场景理解的高层预备任务。 场景理解的重要性越来越突出,因为现实中越来越多的应用场景需要从影像中推理出相关的知识或语义。传统计算机视觉及机器学习分支技术

已相对成熟;虽然深度学习技术还远不成熟,但CNN[7-11]在准确率和效率上都远远超过传统方法。语义分割目前还没有一个统一的工作和最优方法综述,该领域飞速发展使初学者启蒙教育较难

大量工作相继提出,使发展步伐非常耗时。因此追随相关工作,解释其论点,过滤掉低水平工作及验证实验结果非常困难。

2)术语及背景概念

基于深度学习的语义分割不是一个孤立的领域,而是从粗糙推理到精细化推理得自然一步。对于细粒度推理来说,将接下来进行物体的定位与检测,不止提供物体的类别,而且提供关于各类别空间位置

的额外信息,比如中心点或边框。这样很显然,语义分割是实现细粒度推理的很自然的一步,它的目标是:对每个像素点进行密集的预测,这样每个像素点均被标注上对应物体或区域的类别。这还可以

进一步改进,比如实例分割(即对同一类的不同实例标以不同的标签),甚至是基于部分的分割(即对已经分出不同类别的图像进行底层分解,找到每个类对应的组成成分)。在本文中,我们主要关注

一般的场景标注,也就是像素级别的分割,但是我们也会回顾实例分割以及基于部分的分割的较重要方法。

最后,像素级别的标注问题可以松弛为以下公式:对于随机变量集合 中的每个随机变量,找到一种方法为其指派一个来自标签空间 中的一个状态。每个标签 表示唯一的一个类或者物体,比如飞机、汽

车、交通标志或背景等。这个标签空间有 个可能的状态,通常会被扩展为 +1个,即视 为背景或者空的类。通常, 是一个二维的图像,包含W*H=N的像素点x。但是,这个随机变量的集合可以被扩展

到任意维度,比如体数据或者超谱图像。

其他有意义的内容:1. 网络结构,方法及涉及决策。 2. 训练常见技术。 3. 数据预处理,数据增强。

2.1) 常见的深度网络结构

2.1.1)AlexNet

以作者Alex命名,首创了深度卷积网络模型,在2012年ILVSVRC(ImageNet大规模图像识别)竞赛上以top-5准确率84.6%的成绩获胜,与之相近竞争者使用传统模型技术,在相同问题仅取得了73.8%

准确率。由Krizhecsky等人给出的架构相对简单,包括卷积层、max-pooling层及ReLU层各五层作为非线性层,全连接层三层以及dropout层。

2.1.2) VGG

牛津大学Visual Geometry Group命名,提出了深度卷积神经网络的多种模型及配置,提交到2013年ILVSVRC竞赛上。这个模型由16个权重层组成,因此也被称为VGG-16,其在竞赛中取得top-5上

92.7%的准确率。VGG-16与之前的模型主要不同之处在于,其在第一层使用了一堆小感受野的卷积层,而不是少数的大感受野的卷积层,这使得模型参数更少,非线性更强,也使得决策函数更有区分度,

模型更好训练。

2.1.3) GoogLeNet

GoogLeNet是由Szegedy等人提出的在ILSVRC-2014竞赛上取得top-5上93.3%准确率的模型。这个CNN模型以其复杂程度著称,事实上,其具有22个层以及新引入的inception模块。这种新的方法证

实了CNN层可以有更多的堆叠方式,而不仅仅是标准的序列方式。实际上,这些模块由一个网络内部的网络层(NiN),一个池化操作,一个大卷积核的卷积层及一个小核的卷积层组成。所有操作均并

行计算出来,而后进行1x1卷积操作来进行降维。由于这些模块的作用,参数及操作的数量大大减少,网络在存储空间占用及耗时等方面均取得了进步。

2.1.4)ResNet

微软提出的ResNet由于在ILSVRC-2016中取得的96.4%的准确率而广受关注。除了准确率较高之外,ResNet网络还以其高达152层的深度以及对残差模块的引入而闻名。残差模块解决了训练真正深层网

络时存在的问题,通过引入identity skip connections网络各层可以把其输入复制到后面的层上。

本方法的关键想法便是,保证下一层可以从输入中学到与已经学到的信息不同的新东西(因为下一层同时得到了前一层的输出以及原始的输入)。另外,这种连接也协助解决了梯度消失的问题。

2.1.5) ReNet

为了将循环神经网络RNN模型扩展到多维度的任务上,Graves等人提出了一种多纬度的循环神经网络(MDRNN)模型,将每个单一的循环连接替换为带有d个连接的标准RNN,其中d是数据的spatio-

temora(时-空)维度。基于这片工作,Visin等人提出了ReNet模型,而是使用常见序列RNN模型。这样,RNN模型的数量在每一层关于d(输入图像维数2d)线性增长。在ReNet中,每个卷积层(卷积

+池化)被4个同时在水平与竖直方向切分图像的RNN模型所替代。

2.2) 迁移学习

从头训练一个深度神经网络通常是不可行的,有两个原因:需要足量数据集训练且训练至网络收敛需要很长时间。即便得到足够数据而且短时间能够达到收敛,从之前训练结果中的权重开始训练也总比

随机初始化的权重开始训练要好。

Yosinski等人证明即便从较不相关的任务中迁移学习来的特征也要比直接从随机初始化学习的特征要好,这个结论也考虑到了随着提前训练的任务与目标任务之间差异增大,可迁移性将减小的情况。

然而,迁移学习技术并没有如此直接。一方面,使用提前训练的网络必须满足网络架构的约束,不过,因为一般不会新提出一个全新的网络架构来使用,所以使用现有的网络架构或网络组件来进行迁移

学习是常见的;另一方面,迁移学习的训练过程相对于从头开始的训练过程来说区别非常小。合理选择微调的层是很重要的,一般选网络中较高的层因为底层一般倾向于保留更加通用的特征;同时,合

理地确定学习率也是很重要的,一般选取很小的值,因为一般认为提前训练的权重相对比较好,无需过度修改。

由于收集和创建像素级别的分割标注数据集的内在困难性,这些数据集的规模一般不如分类数据集如ImageNet等的大。分割研究中数据集的规模问题在处理RGB-D或3D数据集时更加严重,因为这些数

据集规模更小。也因此,迁移学习,尤其是从提前训练好的分类网络中微调而来的方式,将会成为分割领域的大势所趋,并且已经有办法成功地进行了应用。

2.3)数据预处理与数据增强

数据增强技术被证明有利于通用尤其是深度学习架构训练,无论是加速收敛过程还是作为一个正则项,这也避免了过拟合并增强了模型泛化能力。

数据增强一般包括在数据空间或特征空间上引用一系列迁移技术,在数据空间上应用增强技术较常见:从已有数据应用迁移方法如平移旋转,扭曲,缩放,颜色空间转换,裁剪等得到新的样本,目标是

通过生成更多样本来构建更大的数据集,防止过拟合以及对模型进行正则化,还可以对该数据集的各个类的大小进行平衡,甚至手工地产生对当前任务或应用场景更加具有代表性的新样本。

3)数据集及竞赛

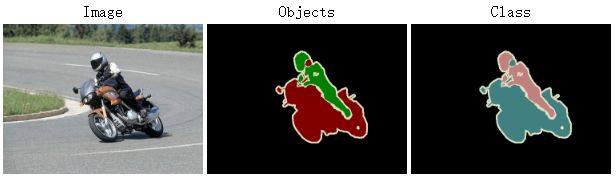

PASCAL视觉物体分类数据集(PASCAL-VOC) (http://host.robots.ox.ac.uk/pascal/VOC/voc2012/) : 包括一个标注了的图像数据集和五个不同的竞赛:分类、检测、分割、动作分类、人物布局。分割的竞赛很有趣:他的目标是为测试集里的每幅图像的每个像素预测其所属的物体类别。有21个类,包括轮子、房子、动物以及其他的:飞机、自行车、船、公共汽车、轿车、摩托车、火车、瓶子、椅子、餐桌、盆栽、沙发、显示器(或电视)、鸟、猫、狗、马、绵羊、人。如果某像素不属于任何类,那么背景也会考虑作为其标签。该数据集被分为两个子集:训练集1464张图像以及验证集1449张图像。测试集在竞赛中是私密的。争议的说,这个数据集是目前最受欢迎的语义分割数据集,因此很多相关领域卓越的工作将其方法提交到该数据集的评估服务器上,在其测试集上测试其方法的性能。方法可以只用该数据集训练,也可以借助其他的信息。另外,其方法排行榜是公开的而且可以在线查询。

PASCAL 部分数据集(PASCAL Part)(http://www.stat.ucla.edu/∼xianjie.chen/pascal part dataset/pascal part.html):对于PASCAL-VOC 2010识别竞赛的扩展,超越了这次竞赛的任务要求而为图像中的每个物体的部分提供了一个像素级别的分割标注(或者当物体没有连续的部分的时候,至少是提供了一个轮廓的标注)。原来的PASCAL-VOC中的类被保留,但被细分了,如自行车被细分为后轮、链轮、前轮、手把、前灯、鞍座等。本数据集包含了PASCAL VOC的所有训练图像、验证图像以及9637张测试图像的标签。

PASCAL 部分数据集(PASCAL Part)(http://www.stat.ucla.edu/∼xianjie.chen/pascal part dataset/pascal part.html):对于PASCAL-VOC 2010识别竞赛的扩展,超越了这次竞赛的任务要求而为图像中的每个物体的部分提供了一个像素级别的分割标注(或者当物体没有连续的部分的时候,至少是提供了一个轮廓的标注)。原来的PASCAL-VOC中的类被保留,但被细分了,如自行车被细分为后轮、链轮、前轮、手把、前灯、鞍座等。本数据集包含了PASCAL VOC的所有训练图像、验证图像以及9637张测试图像的标签。

PASCAL 上下文数据集(PASCAL Context) [28] (http://www.cs.stanford.edu/∼roozbeh/pascal-context/):对于PASCAL-VOC 2010识别竞赛的扩展,包含了对所有训练图像的像素级别的标注。共有540个类,包括原有的20个类及由PASCAL VOC分割数据集得来的图片背景,分为三大类,分别是物体、材料以及混合物。虽然种类繁多,但是只有59个常见类是较有意义的。由于其类别服从一个幂律分布,其中有很多类对于整个数据集来说是非常稀疏的。就这点而言,包含这59类的子集常被选作真实类别来对该数据集进行研究,其他类别一律重标为背景。

PASCAL 上下文数据集(PASCAL Context) [28] (http://www.cs.stanford.edu/∼roozbeh/pascal-context/):对于PASCAL-VOC 2010识别竞赛的扩展,包含了对所有训练图像的像素级别的标注。共有540个类,包括原有的20个类及由PASCAL VOC分割数据集得来的图片背景,分为三大类,分别是物体、材料以及混合物。虽然种类繁多,但是只有59个常见类是较有意义的。由于其类别服从一个幂律分布,其中有很多类对于整个数据集来说是非常稀疏的。就这点而言,包含这59类的子集常被选作真实类别来对该数据集进行研究,其他类别一律重标为背景。

微软常见物体环境数据集(Microsoft COCO) [31]:(http://mscoco.org/) 是另一个大规模的图像识别、分割、标注数据集。它可以用于多种竞赛,与本领域最相关的是检测部分,因为其一部分是致力于解决分割问题的。该竞赛包含了超过80个类别,提供了超过82783张训练图片,40504张验证图片,以及超过80000张测试图片。特别地,其测试集分为4个不同的子集各20000张:test-dev是用于额外的验证及调试,test-standard是默认的测试数据,用来与其他最优的方法进行对比,test-challenge是竞赛专用,提交到评估服务器上得出评估结果,test-reserve用于避免竞赛过程中的过拟合现象(当一个方法有嫌疑提交过多次或者有嫌疑使用测试数据训练时,其在该部分子集上的测试结果将会被拿来作比较)。由于其规模巨大,目前已非常常用,对领域发展很重要。实际上,该竞赛的结果每年都会在ECCV的研讨会上与ImageNet数据集的结果一起公布。

微软常见物体环境数据集(Microsoft COCO) [31]:(http://mscoco.org/) 是另一个大规模的图像识别、分割、标注数据集。它可以用于多种竞赛,与本领域最相关的是检测部分,因为其一部分是致力于解决分割问题的。该竞赛包含了超过80个类别,提供了超过82783张训练图片,40504张验证图片,以及超过80000张测试图片。特别地,其测试集分为4个不同的子集各20000张:test-dev是用于额外的验证及调试,test-standard是默认的测试数据,用来与其他最优的方法进行对比,test-challenge是竞赛专用,提交到评估服务器上得出评估结果,test-reserve用于避免竞赛过程中的过拟合现象(当一个方法有嫌疑提交过多次或者有嫌疑使用测试数据训练时,其在该部分子集上的测试结果将会被拿来作比较)。由于其规模巨大,目前已非常常用,对领域发展很重要。实际上,该竞赛的结果每年都会在ECCV的研讨会上与ImageNet数据集的结果一起公布。

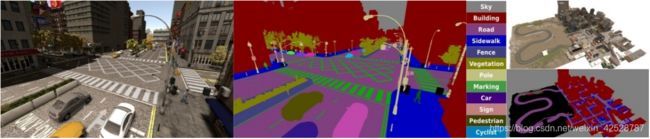

图像与注释合成数据集(SYNTHIA)(http://synthia-dataset.net/)是一个大规模的虚拟城市的真实感渲染图数据集,带有语义分割信息,是为了在自动驾驶或城市场景规划等研究领域中的场景理解而提出的。提供了11个类别物体(分别为空、天空、建筑、道路、人行道、栅栏、植被、杆、车、信号标志、行人、骑自行车的人)细粒度的像素级别的标注。包含从渲染的视频流中提取出的13407张训练图像,该数据集也以其多变性而著称,包括场景(城镇、城市、高速公路等)、物体、季节、天气等。

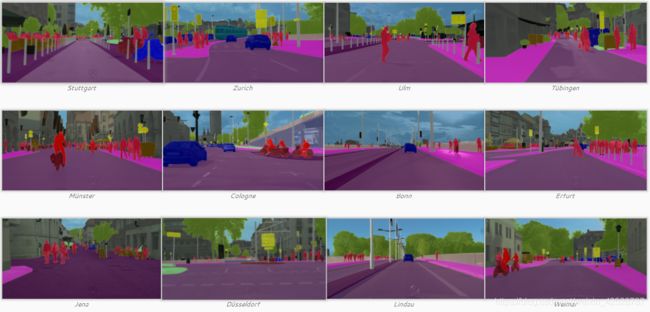

城市风光数据集 [33] (https://www.cityscapes-dataset.com/)是一个大规模的关注于城市街道场景理解的数据集,提供了8种30个类别的语义级别、实例级别以及密集像素标注(包括平坦表面、人、车辆、建筑、物体、自然、天空、空)。该数据集包括约5000张精细标注的图片,20000张粗略标注的图片。数据是从50个城市中持续数月采集而来,涵盖不同的时间以及好的天气情况。开始起以视频形式存储,因此该数据集按照以下特点手动选出视频的帧:大量的动态物体,变化的场景布局以及变化的背景。

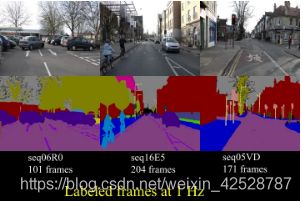

CamVid数据集 [55,34] (http://mi.eng.cam.ac.uk/research/projects/VideoRec/CamVid/)是一个道路、驾驶场景理解数据集,开始是五个视频序列,来自一个安装在汽车仪表盘上的960x720分辨率的摄相机。这些序列中采样出了701个帧(其中4个序列在1fps处,1个序列在15fps处),这些静态图被手工标注上32个类别:空、建筑、墙、树、植被、栅栏、人行道、停车场、柱或杆、锥形交通标志、桥、标志、各种文本、信号灯、天空、……(还有很多)。值得注意的是,Sturgess等人[35]将数据集按照367-100-233的比例分为训练集、验证集、测试集,这种分法使用了部分类标签:建筑、树、天空、车辆、信号、道路、行人、栅栏、杆、人行道、骑行者。

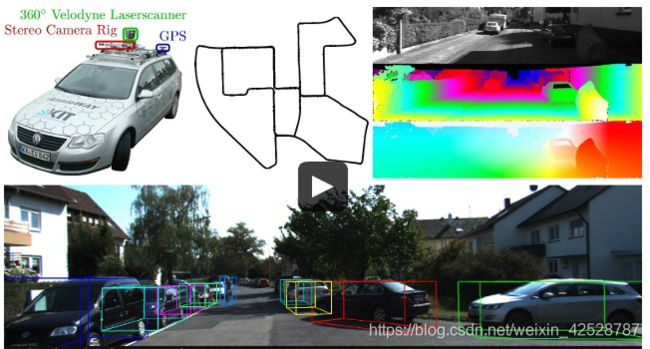

KITTI [56] 是用于移动机器人及自动驾驶研究的最受欢迎的数据集之一,包含了由多种形式的传感器得出的数小时的交通场景数据,包括高分辨率RGB、灰度立体摄像机以及三维激光扫描器。尽管很受欢迎,该数据集本身并没有包含真实语义分割标注,但是,众多的研究者手工地为该数据集的部分数据添加标注以满足其问题的需求。Alvarez等人[36,37]为道路检测竞赛中的323张图片生成了真实标注,包含三个类别:道路、垂直面和天空。Zhang等人[39]标注了252张图片,其中140张训练、112张测试,其选自追踪竞赛中的RGB和Velodyne扫描数据,共十个类。Ros等人[38]在视觉测距数据集中标注了170个训练图片和46个测试图片,共11个类。

后面的数据集先不更了,个人认为不太主流,先种草这些进行调研~

后面的数据集先不更了,个人认为不太主流,先种草这些进行调研~

4)方法

深度学习技术取得巨大成功(官方发言),尤其是监督方法(信号处理专业小白认为CNN是采样方法)如CNN用于图像分类和物体检测,激励着研究者们探索像素级别标注能力,如语义分割。这些深度学习技术区别于传统方法的关键优势在于其强大的针对当前问题学习合适的特征表示的能力,例如,对于一个特定数据集的像素集标注问题,其使用一种端对端的方法而不是手工设计的特征,而手工设计特征需要领域专门知识,耗时耗力而且有时太过精细化以致于只能在某个特定的场景下使用。

最近,最成功用于语义分割的深度学习技术均来自同一个工作,即全卷积网络FCN ,该方法的出色之处在于,其利用了现存的CNN网络作为其模块之一来产生层次化的特征。作者将现存的知名的分类模型包括AlexNet、VGG-16、GoogLeNet和ResNet等转化为全卷积模型:将其全连接层均替换为卷积层,输出空间映射而不是分类分数。这些映射由小步幅卷积上采样(又称反卷积)得到,来产生密集的像素级别的标签。该工作被视为里程碑式的进步,因为它阐释了CNN如何可以在语义分割问题上被端对端的训练,而且高效的学习了如何基于任意大小的输入来为语义分割问题产生像素级别的标签预测。本方法在标准数据集如PASCAL VOC分割准确率上相对于传统方法取得了极大的进步,且同样高效。由于上述及更多显著的贡献,FCN成为了深度学习技术应用于语义分割问题的基石,其处理过程如图7所示。

博主作者注:我个人认为全连接层(也叫FCN)的训练速度可能还不如全卷积层,从信号处理专业底层来看整个深度网络训练过程宏观上相当于图像信号经过了一个基于自适应算法及卷积遍历的滤波器得到的过滤后信号如何被处理成更精准的像素级可训练信号,全卷积层的反卷积无疑更能迎合架构的整体需求;加上传统卷积神经网络后的全连接层可能是一个更加类似于多层感知机的训练网络,其含有的权重和推理机制往往要耗费比卷积层更大的算力和时间(不相信的可以去考古下theano时代的VGG-16),所以该技术可以说是与le-net并肩的一大创举(并不是所有人都敢做的)。

FCN这里指全卷积层仍然存在针对于某些问题应用的局限性:固有的空间不变性导致其没有考虑到有用的全局上下文信息,也没有默认考虑对实例的辨识,在高分辨率场景达不到实时操作,也完全不适合非结构性数据(3D点云)或非结构化模型。

科普(度娘):非结构化数据是数据结构不规则或不完整,没有预定义的数据模型,不方便用数据库二维逻辑表来表现的数据。包括所有格式的办公文档、文本、图片、XML, HTML、各类报表、图像和音频/视频信息等等。(请注意:二维逻辑来表现,不是形象也不是图象,我认为所有非结构化数据都是有可能被转化为结构化的)

4.1) 解码器变体

一开始很难理解,但是你要结合它跟全卷积层的区别来看,就相当于在解码过程中加入了类似于res-net原有信号来恢复信号的东东,这样是不是就可以起到降低算力的结果了呀?(纯个人臆想)

会调研下Seg-net再更。

4.2) 整合上下文知识

4.2.1) 条件随机场

4.2.2) 扩张的(dilated)卷积

4.2.3)多尺度预测

4.2.4)特征融合

4.2.5)循环神经网络RNN

4.3) 实例分割

4.4) RGB-D数据(带有深度)

4.5) 三维数据

4.6) 视频序列