重修-龙珠计划机器学习训练营task2-XGBoost part2学习笔记

一、学习知识点概要

基于天气数据集的XGBoost分类实战:掌握 XGBoost 的Python调用并将其运用到天气数据集预测。

二、学习内容

Part1 基于天气数据集的XGBoost分类实践

导入数据

!wget https://tianchi-media.oss-cn-beijing.aliyuncs.com/DSW/7XGBoost/train.csv

Step1: 库函数导入

基础函数库

import numpy as np

import pandas as pd

绘图函数库

import matplotlib.pyplot as plt

import seaborn as sns

要求:选择天气数据集进行方法的尝试训练,现在有一些由气象站提供的每日降雨数据,我们需要根据历史降雨数据来预测明天会下雨的概率。样例涉及到的测试集数据test.csv与train.csv的格式完全相同,但其RainTomorrow未给出,为预测变量。

特征描述:

Step2: 数据读取/载入

我们利用Pandas自带的read_csv函数读取并转化为DataFrame格式

data = pd.read_csv(‘train.csv’)

Step3: 数据信息简单查看

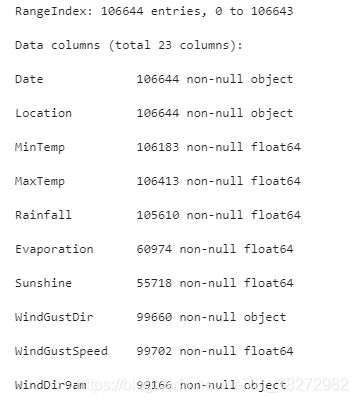

利用.info()查看数据的整体信息

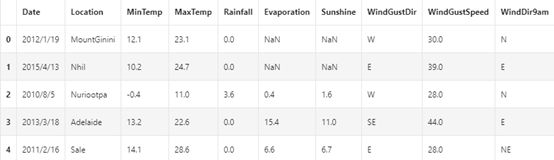

进行简单的数据查看,我们可以利用 .head() 头部.tail()尾部

data.head()

备注:数据集中存在NaN,一般的我们认为NaN在数据集中代表了缺失值,可能是数据采集或处理时产生的一种错误。这里我们采用-1将缺失值进行填补,还有其他例如“中位数填补、平均数填补”的缺失值处理方法

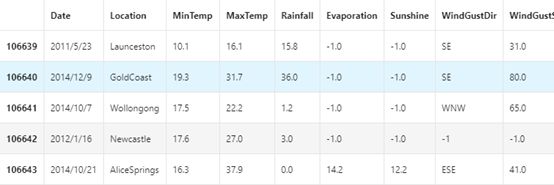

data = data.fillna(-1)

data.tail()

利用value_counts函数查看训练集标签的数量

pd.Series(data[‘RainTomorrow’]).value_counts()

备注:数据集中的负样本数量远大于正样本数量 “数据不平衡”问题。可进行一些特殊处理。

对于特征进行一些统计描述

data.describe()

Step4: 可视化描述

#数字特征与非数字特征

numerical_features = [x for x in data.columns if data[x].dtype == np.float]

category_features = [x for x in data.columns if data[x].dtype != np.float and x != ‘RainTomorrow’]

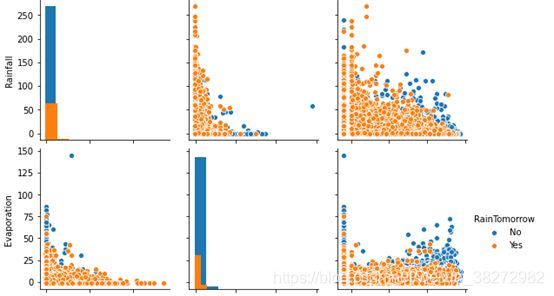

选取三个特征与标签组合的散点可视化

sns.pairplot(data=data[[‘Rainfall’,

‘Evaporation’,

‘Sunshine’] + [‘RainTomorrow’]], diag_kind=‘hist’, hue= ‘RainTomorrow’)

plt.show()

#在2D情况下不同的特征组合对于第二天下雨与不下雨的散点分布,以及大概的区分能力

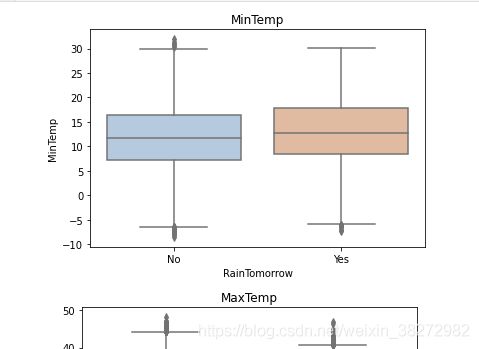

for col in data[numerical_features].columns:

if col != ‘RainTomorrow’:

sns.boxplot(x=‘RainTomorrow’, y=col, saturation=0.5, palette=‘pastel’, data=data)

plt.title(col)

plt.show()

#利用箱型图我们也可以得到不同类别在不同特征上的分布差异情况

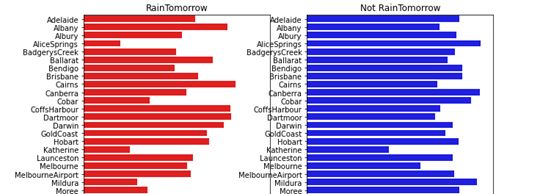

tlog = {}

for i in category_features:

tlog[i] = data[data[‘RainTomorrow’] == ‘Yes’][i].value_counts()

flog = {}

for i in category_features:

flog[i] = data[data[‘RainTomorrow’] == ‘No’][i].value_counts()

plt.figure(figsize=(10,10))

plt.subplot(1,2,1)

plt.title(‘RainTomorrow’)

sns.barplot(x = pd.DataFrame(tlog[‘Location’]).sort_index()[‘Location’], y = pd.DataFrame(tlog[‘Location’]).sort_index().index, color = “red”)

plt.subplot(1,2,2)

plt.title(‘Not RainTomorrow’)

sns.barplot(x = pd.DataFrame(flog[‘Location’]).sort_index()[‘Location’], y = pd.DataFrame(flog[‘Location’]).sort_index().index, color = “blue”)

plt.show()

#不同地区降雨情况差别很大,有些地方明显更容易降雨

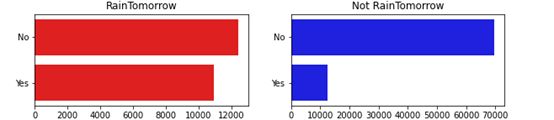

plt.figure(figsize=(10,2))

plt.subplot(1,2,1)

plt.title(‘RainTomorrow’)

sns.barplot(x = pd.DataFrame(tlog[‘RainToday’][:2]).sort_index()[‘RainToday’], y = pd.DataFrame(tlog[‘RainToday’][:2]).sort_index().index, color = “red”)

plt.subplot(1,2,2)

plt.title(‘Not RainTomorrow’)

sns.barplot(x = pd.DataFrame(flog[‘RainToday’][:2]).sort_index()[‘RainToday’], y = pd.DataFrame(flog[‘RainToday’][:2]).sort_index().index, color = “blue”)

plt.show()

分析的结论:天下雨明天不一定下雨,但今天不下雨,第二天大概率也不下雨

Step5: 对离散变量进行编码

XGBoost无法处理字符串类型的数据,我们需要一些方法讲字符串数据转化为数据。一种最简单的方法是把所有的相同类别的特征编码成同一个值,例如女=0,男=1,狗狗=2,所以最后编码的特征值是在[0,特征数量−1] 之间的整数。除此之外,还有独热编码、求和编码、留一法编码等等方法可以获得更好的效果。

把所有的相同类别的特征编码为同一个值

def get_mapfunction(x):

mapp = dict(zip(x.unique().tolist(),

range(len(x.unique().tolist()))))

def mapfunction(y):

if y in mapp:

return mapp[y]

else:

return -1

return mapfunction

for i in category_features:

data[i] = data[i].apply(get_mapfunction(data[i]))

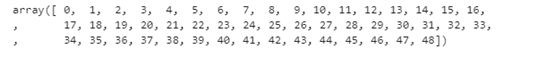

编码后的字符串特征变成了数字

data[‘Location’].unique()

Step6: 利用 XGBoost 进行训练与预测

为了正确评估模型性能,将数据划分为训练集和测试集,并在训练集上训练模型,在测试集上验证模型性能。

from sklearn.model_selection import train_test_split

选择其类别为0和1的样本 (不包括类别为2的样本)

data_target_part = data[‘RainTomorrow’]

data_features_part = data[[x for x in data.columns if x != ‘RainTomorrow’]]

测试集大小为20%, 80%/20%分

x_train, x_test, y_train, y_test = train_test_split(data_features_part, data_target_part, test_size = 0.2, random_state = 2020)

导入XGBoost模型

from xgboost.sklearn import XGBClassifier

定义 XGBoost模型

clf = XGBClassifier()

在训练集上训练XGBoost模型

clf.fit(x_train, y_train)

在训练集和测试集上分布利用训练好的模型进行预测

train_predict = clf.predict(x_train)

test_predict = clf.predict(x_test)

from sklearn import metrics

利用accuracy(准确度)【预测正确的样本数目占总预测样本数目的比例】评估模型效果

print(‘The accuracy of the Logistic Regression is:’,metrics.accuracy_score(y_train,train_predict))

print(‘The accuracy of the Logistic Regression is:’,metrics.accuracy_score(y_test,test_predict))

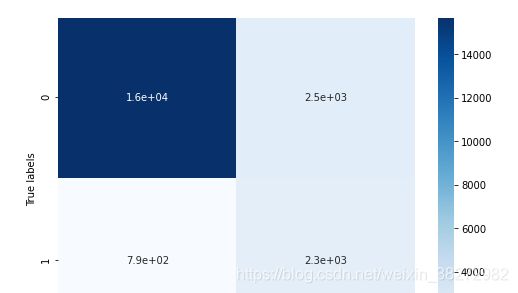

查看混淆矩阵 (预测值和真实值的各类情况统计矩阵)

confusion_matrix_result = metrics.confusion_matrix(test_predict,y_test)

print(‘The confusion matrix result:\n’,confusion_matrix_result)

利用热力图对于结果进行可视化

plt.figure(figsize=(8, 6))

sns.heatmap(confusion_matrix_result, annot=True, cmap=‘Blues’)

plt.xlabel(‘Predicted labels’)

plt.ylabel(‘True labels’)

plt.show()

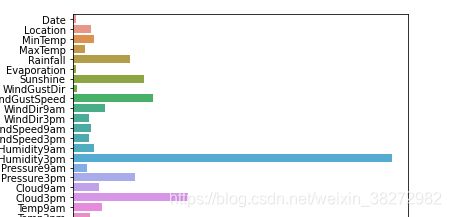

Step7: 利用 XGBoost 进行特征选择

#XGBoost的特征选择属于特征选择中的嵌入式方法,在XGboost中可以用属性feature_importances_去查看特征的重要度

? sns.barplot

sns.barplot(y=data_features_part.columns, x=clf.feature_importances_)

备注:

使用XGBoost中的下列重要属性来评估特征的重要性。

• weight:是以特征用到的次数来评价

• gain:当利用特征做划分的时候的评价基尼指数

• cover:利用一个覆盖样本的指标二阶导数(具体原理不清楚有待探究)平均值来划分。

• total_gain:总基尼指数

• total_cover:总覆盖

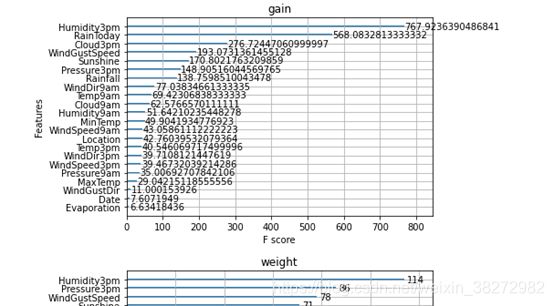

from sklearn.metrics import accuracy_score

from xgboost import plot_importance

def estimate(model,data):

#sns.barplot(data.columns,model.feature_importances_)

ax1=plot_importance(model,importance_type="gain")

ax1.set_title('gain')

ax2=plot_importance(model, importance_type="weight")

ax2.set_title('weight')

ax3 = plot_importance(model, importance_type="cover")

ax3.set_title('cover')

plt.show()

def classes(data,label,test):

model=XGBClassifier()

model.fit(data,label)

ans=model.predict(test)

estimate(model, data)

return ans

ans=classes(x_train,y_train,x_test)

pre=accuracy_score(y_test, ans)

print(‘acc=’,accuracy_score(y_test,ans))

Step8: 通过调整参数获得更好的效果

从sklearn库中导入网格调参函数

from sklearn.model_selection import GridSearchCV

定义参数取值范围

learning_rate = [0.1, 0.3, 0.6]

subsample = [0.8, 0.9]

colsample_bytree = [0.6, 0.8]

max_depth = [3,5,8]

parameters = { ‘learning_rate’: learning_rate,

‘subsample’: subsample,

‘colsample_bytree’:colsample_bytree,

‘max_depth’: max_depth}

model = XGBClassifier(n_estimators = 50)

进行网格搜索

clf = GridSearchCV(model, parameters, cv=3, scoring=‘accuracy’,verbose=1,n_jobs=-1)

clf = clf.fit(x_train, y_train)

网格搜索后的最好参数为

clf.best_params_

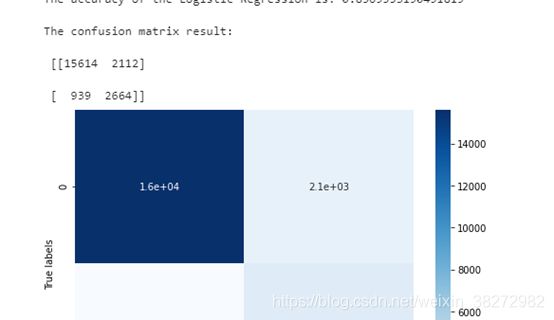

在训练集和测试集上分布利用最好的模型参数进行预测

定义带参数的 XGBoost模型

clf = XGBClassifier(colsample_bytree = 0.6, learning_rate = 0.3, max_depth= 8, subsample = 0.9)

在训练集上训练XGBoost模型

clf.fit(x_train, y_train)

train_predict = clf.predict(x_train)

test_predict = clf.predict(x_test)

利用accuracy(准确度)【预测正确的样本数目占总预测样本数目的比例】评估模型效果

print(‘The accuracy of the Logistic Regression is:’,metrics.accuracy_score(y_train,train_predict))

print(‘The accuracy of the Logistic Regression is:’,metrics.accuracy_score(y_test,test_predict))

查看混淆矩阵 (预测值和真实值的各类情况统计矩阵)

confusion_matrix_result = metrics.confusion_matrix(test_predict,y_test)

print(‘The confusion matrix result:\n’,confusion_matrix_result)

利用热力图对于结果进行可视化

plt.figure(figsize=(8, 6))

sns.heatmap(confusion_matrix_result, annot=True, cmap=‘Blues’)

plt.xlabel(‘Predicted labels’)

plt.ylabel(‘True labels’)

plt.show()

三、学习问题与解答

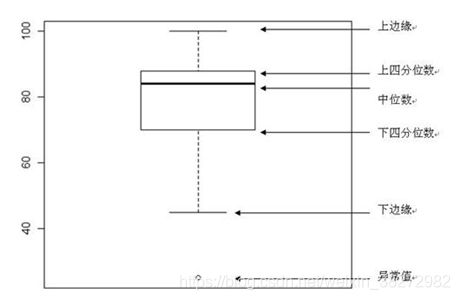

箱图看的不太明白:

箱盒图(也称盒图,箱线图等)是在1977年由美国统计学家John Tukey发明,分析数据需要为定量数据。通过箱盒图,可以直观的探索数据特征。

箱盒图共由五个数值点构成,分别是最小观察值(下边缘),25%分位数(Q1),中位数,75%分位数(Q3),最大观察值(上边缘)。中横线:中位数IQR:75%分位数(Q3)-25%分位数(Q1)最小观察值(下边缘) = Q1 – 1.5 IQR最大观察值 (上边缘)= Q3 + 1.5 IQR特别说明:箱盒图里面的极大值(上边缘值)并非最大值,极小值(下边缘值)也不是最小值。如果数据有存在离群点即异常值,他们超出最大或者最小观察值,此时将离群点以“圆点”形式进行展示。

四、学习思考与总结

XGBoost的重要参数:

1.eta[默认0.3]

通过为每一颗树增加权重,提高模型的鲁棒性。

典型值为0.01-0.2。

2.min_child_weight[默认1]

决定最小叶子节点样本权重和。

这个参数可以避免过拟合。当它的值较大时,可以避免模型学习到局部的特殊样本。

但是如果这个值过高,则会导致模型拟合不充分。

3.max_depth[默认6]

这个值也是用来避免过拟合的。max_depth越大,模型会学到更具体更局部的样本。

典型值:3-10

4.max_leaf_nodes

树上最大的节点或叶子的数量。

可以替代max_depth的作用。

这个参数的定义会导致忽略max_depth参数。

5.gamma[默认0]

在节点分裂时,只有分裂后损失函数的值下降了,才会分裂这个节点。Gamma指定了节点分裂所需的最小损失函数下降值。 这个参数的值越大,算法越保守。这个参数的值和损失函数息息相关。

6.max_delta_step[默认0]

这参数限制每棵树权重改变的最大步长。如果这个参数的值为0,那就意味着没有约束。如果它被赋予了某个正值,那么它会让这个算法更加保守。

但是当各类别的样本十分不平衡时,它对分类问题是很有帮助的。

7.subsample[默认1]

这个参数控制对于每棵树,随机采样的比例。

减小这个参数的值,算法会更加保守,避免过拟合。但是,如果这个值设置得过小,它可能会导致欠拟合。

典型值:0.5-1

8.colsample_bytree[默认1]

用来控制每棵随机采样的列数的占比(每一列是一个特征)。

典型值:0.5-1

9.colsample_bylevel[默认1]

用来控制树的每一级的每一次分裂,对列数的采样的占比。

subsample参数和colsample_bytree参数可以起到相同的作用,一般用不到。

10.lambda[默认1]

权重的L2正则化项。(和Ridge regression类似)。

这个参数是用来控制XGBoost的正则化部分的。虽然大部分数据科学家很少用到这个参数,但是这个参数在减少过拟合上还是可以挖掘出更多用处的。

11.alpha[默认1]

权重的L1正则化项。(和Lasso regression类似)。

可以应用在很高维度的情况下,使得算法的速度更快。

12.scale_pos_weight[默认1]

在各类别样本十分不平衡时,把这个参数设定为一个正值,可以使算法更快收敛。

13.learning_rate: 有时也叫作eta,系统默认值为0.3。每一步迭代的步长,很重要。太大了运行准确率不高,太小了运行速度慢。

调节模型参数的方法有贪心算法、网格调参、贝叶斯调参等。这里我们采用网格调参,它的基本思想是穷举搜索:在所有候选的参数选择中,通过循环遍历,尝试每一种可能性,表现最好的参数就是最终的结果。