论文笔记:Adversarial Cross-Modal Retrivieval

对抗式跨模态检索

- 0.Pre-work

-

- Feature Projector

0.Pre-work

- 要解决什么问题:

现有的基于DNN的跨模态检索仅仅关注于保持配对的跨模态数据集的成对相似性,这些数据共享语义标签并且在模型学习的过程中充当输入,然而一个模态的一项数据可能存在多个语义不同的项,所以仅仅关注成对样本是远远不够的 - 用什么方法解决?

提出了一种基于对抗训练的跨模态搜索ACMR( Adversarial Cross-Modal Retriviel), Adversarial learning 是两个阶段相互作用的结果,首先,特征提取,试图在公共子空间中生成一个模态不变的表示,并模糊另一个阶段,模态分类——依据生成表示区分不同的模态;

论文进一步对特征提取施加三重约束,以最大限度地缩小来自具有相同语义标签的不同模态的所有项目的表示之间的差距,同时最大限度地扩大不同语义的图像和文本之间的距离。以此保留了底层的跨模态语义结构,确保所学习的表示在模态内是有区别的,在模态之间是不变的 - 达到了什么样的效果?

提出的ACMR方法在4个基准数据集上(3个小规模和一个相对大规模)进行了评估,并使用许多现有方法作为参考。实验结果表明,该算法在多模态检索方面的性能明显优于现有的多模态检索算法 - 存在什么问题?

现有的基于dnn的跨媒体检索模型通常只关注保持耦合的跨模式项(如图像和文本片段)的成对相似性,它们共享语义标签并作为模型学习过程的输入。然而,对于一个模态的一个项,可能存在多个语义上不同的相同模态的项,因此只关注成对耦合的项是远远不够的。(就是一个视频片段,对应两个文本)因此,通过这种方法学习到的通用表示不能完全保留数据中潜在的跨模态语义结构。(其他相似的)。要保持这种结构,就需要最小化具有相同语义标签的不同模态的所有项表示之间的差距(例如,将同一主题上的任何文本和任何图像链接在一起),同时最大化相同模态的语义不同项之间的距离(例如,如果两个图像或两个文本不相关,则将它们彼此分离)。

为了解决现有基于dnn的跨媒体检索方法的这一缺陷,我们提出了一个新的框架,即基于对抗性学习[8]概念的对抗性交叉模型检索(ACMR)。

引用这个

HAIYOUZHEGE

如图1所示,该框架的核心是两个过程之间的相互作用,一个是Feature Projector,另一个是amodality Classififjer,作为一个极大极小的游戏进行。

1.第一个过程是一个特征映射器,执行表征学习的主要任务,尝试在共享子空间中产生模型不变的表示来混淆另一个过程。再对特征投影施加三元组约束,以最小化具有相同语义标签的不同模态的所有项目的特征向量之间的距离,同时最大化相同语义上不同的图像和文本特征向量之间的距离。

2.后者是一个模态分类器,主要基于第一个过程中产生的特征表示信息对不同模态进行区分。论文在四个公开的数据集上进行了有效性实验,其性能明显优于其他跨模态检索方法。

文章要做的事情(cross-media retrieval):

输入:image(sentence)+dataset 输出:sentence(image)rank list

二、Contributions:

1.框架的核心是两个过程之间的相互作用,一个特征映射器和一个模态分类器,特征映射器为公共子空间中的不同模态的项目生成模态不变表示。其目的是混淆充当对手的模态分类器。模态分类器试图根据其模态区分项目,并以这种方式控制特征映射器的学习。通过将模态分类器置于对手角色中。当模态分类器无法分辨时结束。

2.训练特征投影仪,使得它共同执行标签预测并在数据中保留底层的跨模态语义结构。通过这种方式,它可以确保学习的特征既可以在模态中进行区分,也可以在模态之间进行不变。

由于图像特征和文本特征通常具有不同的统计特性,并遵循未知(复杂)分布,因此无法在跨模态检索中直接相互比较。为了使图像和文本具有直接的可比性,我们的目标是划分一个公共子空间。然后映射过去。

1.左侧输入是Image和Text

Image:VGG-fc7的输出作为特征v_i

Text:利用简单的BoW(TF-IDF)作为特征t_i

2.接下来ACMR需要做一个Feature Projection,也就是将v_i与t_i映射到SubspaceS

假设Projection Function是f(·),那么Image v_i的Projection Features就是S_v=f(v_i;\theta_v),Text t_i的是S_t=f(t_i;\theta_t)。

ACMR Model的目的就是为了学习出有效的S_v与S_t。

ACMR学习出的的S_v与S_t应该有这样三个性质:

Modality-invariant

Cross-Modal similarity

Semantically-discriminative

文章全篇就是对这三个性质进行探讨,从直觉出发解决了检索问题。

Modality Classifier

ACMR希望学习出的S_v与S_t是在Common Subspace,也就是说两者有identical distribution,即让Modality Classifier(MC)无法分辨出输入是Image还是Text。

MC与Feature Projector之间形成了一个Adversary的关系,MC需要尽可能的分辨出Input是Image还是Text,如果最后MC分辨不出来了,那么就证明FP将Image和Text学习到了同一空间(当然中间还有其他的约束)。

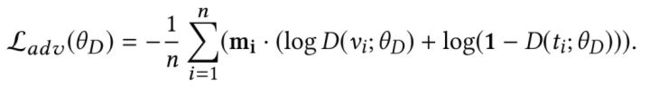

文中MC的Loss定义如下(对于v_i和t_i分别要计算出Cross-entropy)

应该为:

Feature Projector

在先前的交叉熵损失的计算中,目的仅仅是为了保证在一个子空间内各个语义配对的跨模态项的成对相关性,这还远远不够,因为正如前述,语义匹配的可能不止两项。

此外这个相关性损失不能很好的区别相同模态语义上不同的项,论文提出了一种新的FP模型,可以展现文本和图像madal-invariant映射到共同子空间的过程,分为两个部分,分别解决上面所说的两个问题:

- Label Prediction::Semantically-discriminative

- Structure Preservation: Cross-modal Similarity

Label prediction的目的在于使映射出的不同语义(Semantic)的Subspace特征可以彼此区分;Structure preservation使要确保相同语义的跨模态的Subspace特征要保持一致(modal-invariant),从下图可以体会出两者的作用和区别(每一个圆圈代表一个图像;每一个矩形代表一个文本项目;相同颜色的圆形和矩形属于相同的语义类别):

鉴于此,我们提出对feature投影仪进行建模,将标签预测和结构保存两个步骤结合起来,体现文本和图像的模态不变嵌入到一个公共子空间的过程。标签预测过程使公共子空间中每个模态的投影特征表示在给定语义标签的情况下具有鉴别性。结构保存过程确保属于同一语义标签的特征表示在不同形式中是不变的。这两个过程的联合效应如图2(a)所示。

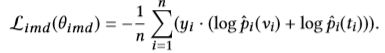

Label prediction为了解决intra-madal discriminative的问题,其损失为:

为了保证特征投影后数据的内模态判别(模式内区分)保留,在公共子空间中部署了一个分类器来预测投影项的语义标签。

该分类将耦合图像和文本实例的投影特征作为训练数据,并生成每个项目语义类别的概率分布作为输出。

Structure Preservation:为了保证模态间不变性的保持,我们的目标是最小化来自不同模态的所有语义相似项的表示之间的差距,同时最大化相同模态的语义不同项之间的距离。受基于排名的跨媒体检索方法[33,39]的启发,我们通过为此目的制定的三重态损失项,在嵌入过程中实施三重态约束。

我们没有应用在整个实例空间中采样三元组的昂贵计算方案,而是从每个小批量中的标记实例执行三元组采样。首先,从图像和文本样本的角度,将来自不同模式但具有相同标签的所有样本构建为耦合样本。换句话说,我们构建了形式 ( v i , t i ) i {(vi,ti)}i (vi,ti)i的对,以image作为anchor,同时将具有相同标签的文本指定为正匹配,以及形式{(ti,vi)}i的对,其中文本项作为锚点,图像作为正匹配。