第1章 云计算基础概念

第1章 云计算基础概念

1.1 什么是云计算?它能做什么?

概念?非成熟型新型技术?有前途。

[1]:什么是云计算?举个例子:云笔记,云硬盘,云音乐(酷狗有猜你喜欢)等服务模式。所以云计算就在我们身边,涵盖我们的衣食住行(ppt-云计算就在我们身边)

[2]:而且,当前云计算目前格局百家争鸣?(各种云,阿里云/腾讯云/华为云/百度云/金山云/UCloud/京东云/华三云/网易云/浪潮云等等。。很多公司业务基于云平台来实现)

(云计算之前,个人PC时代及基本应用),移动互联网物联网时代,对算力要求越来越高。

如何理解算力?举个例子:1+1等于几?2的200次方呢?比特币原理(比特币算力对于云计算来说无用,SHA256bit,“SHA256是安全散列算法SHA系列算法之一,其摘要长度为256bits,即32个字节,故称SHA256。对于任意长度(按bit计算)的消息,SHA256都会产生一个32个字节长度数据,称作消息摘要,SHA256算法使用的哈希值长度是256位)

既然要求算力,我直接公司自建机房提升算力不可以吗?不需要云。

[3]:未来需要大数据人工智能分析(框架和模型是现成的),可以请工程师吗?大企业有钱,请得起。

我也请得起!那也要考虑业务上线周期。(讲讲业务上线流程?)

[4]:敏捷开发,快速上线,提升竞争力,抢占市场。

强调快速反应、快速迭代、价值驱动

[5]:云计算可以直接在线购买,租用相关业务,无需自己开发,快速方便。

再去对比下传统上线流程?云计算的优势是不是立刻显现出来?

1.2 云计算4类部署模式

私有云、公有云、混合云、社区/行业云

1)阿里云提供云主机,面向所有的用户提供服务,就是公有云的例子。 2)中国电科自己搭建一个数据中心,企业内部的业务系统部署在这个数据中心,以云的方式提供内部的IT服务,就是私有云。 3)12306一方面利用自有的数据中心提供购票查询等等业务,在用户量巨大时,把部分查询功能利用阿里云来提供服务,这个模式就是混合云的架构。

有些有钱的公司就是要自己搭建–私有云

租用厂商提供的资源-公有云

一部分云,一部分机房,混合云(IBM是世界上最大混合云供应商)

针对医疗、健康、教育、新零售等特定行业的一些云方案,整套解决方案。行业社区云。

云计算老大:AWS 亚马逊,第二微软,第三阿里云(国内第一),但是国内私有云华为第一

大家是否发现,云计算领头羊的,为什么基本都是电商/互联网公司?是因为第一业务规模庞大(双11高峰期,秒杀,数据流太大,采购服务器,很多服务器在非节假日闲置,如何实现利益最大化?对外租用?在高峰期也可以进行回收,来接收顶级流量),业务驱动技术,技术更新非常快,牛人非常多,为云计算商业模式的推动打下坚实的基础。

可是当年,2010年大佬们还不看好云计算,腾讯说是个好东西,但很遥远,再看看;百度说新瓶装旧酒(于是ALL in AI人工智能领域,智能汽车);阿里说当下就应该做(纯自研),阿里业务有需求,百度没有需求。百度有啊店铺,2007年开始,2011年关闭;腾讯拍拍,2014年被京东收购。现在看来,阿里很有眼光。

阿里云国内第一,可为什么学华为?因为华为私有云第一,且学私有云,很快适应公有云,底层架构都是一样的,阿里云主打公有云,界面操作,不懂底层原理。

1.3 云计算优势(5特征)

按需自助服务(水电燃,基础设施,国家建设,用多少,给多少)–华为云操作:测试环境很方便(维护成本、损耗、人力物力成本,电费等等)

广泛的网络接入(手机、三方终端设备、电脑等)

资源池化(屏蔽底层不同厂商的物理硬件差异)

快速弹性伸缩(根据需求自动扩充)

可计量服务

MB/s的含义是兆字节每秒,Mbit/s的含义是兆比特每秒,前者是指每秒传输的字节数量,后者是指每秒传输的比特位数。MB/s中的B字母是Byte的含义,虽然与Mbit/s中的bit翻译一样,都是比特,也都是数据量度单位,但二者是完全不同的。Byte是字节数,bit是位数,在计算机中每八位为一字节,也就是1Byte=8bit,是1:8的对应关系。因此1MB/s等于8Mbit/s。2000Mbit/s=250MB/s

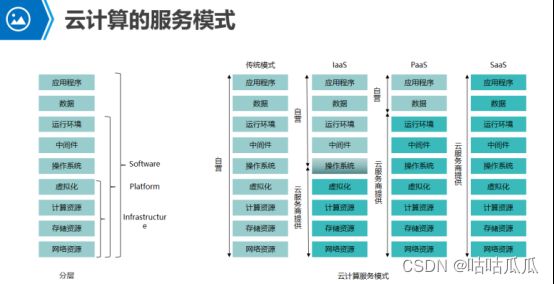

1.4 云计算3种服务模式

信息时代数据量不断的暴涨,对算力需求也愈发强烈。

企业需求的算力,云计算公司可以提供,其实就是租算力。

不仅你可以租算力,也可以租存储、租网络、租应用程序、租软件等等。

于是按照租用的情况,提供3种租用服务模式。Iaas/Paas/Saas(EPR/CRM直接用app store/安卓/Lumia撸妹儿)

第2章 虚拟化基础

2.1 云计算用到的技术-虚拟化

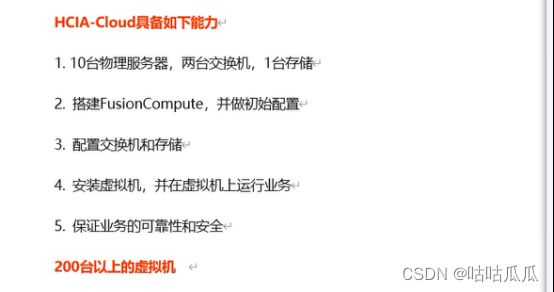

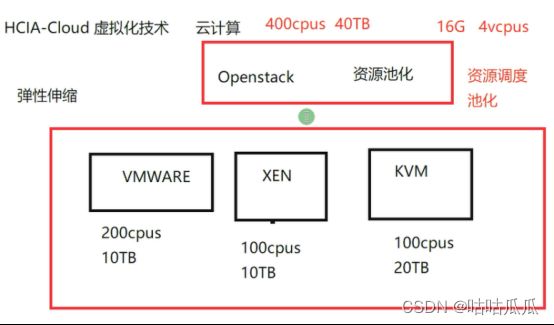

HCIA-Cloud 虚拟化技术

学云计算,为什么学虚拟化?因为云计算底层采用的就是虚拟化技术。

上层为什么可以弹性拓展和伸缩?实质是操作的底层虚拟机。

云计算和虚拟化又有什么区别?

云计算操作系统使用 OpenStack

底层使用虚拟化 vmware/xen/kvm

每个虚拟化有自己的资源,最终由openstack将这些资源进行池话,

将资源聚合成大的资源池。

租个云主机,申请主机时,请求会在底层开启一个虚拟机。那不是虚拟化才牛x吗?云不怎样啊?

云是做资源池化,集中管控的,资源调度整合,租户隔离。就像老板一样,老板接到任务,下放给具体的部门去完成啊。谁牛啊?老板?干活的?

云计算底层只能是虚拟机吗?能否为物理机???Openstack可以接管虚拟机,也可以接管物理机,称作裸金属BMS(裸机)。为什么存在这个?因为某些应用不支持虚拟机,比如oracle RAC 共享磁盘,失去了云弹性的优势。业务上云,数据库rac本地。

规划和排错,是在虚拟化这一层,而不是云计算这一层。这就是云计算和虚拟化的区别。

2.2 虚拟机是什么

2009年第一次接触vmware虚拟化软件,感觉很神奇。操作系统中可以跑操作系统,学习实验的好帮手。

Vmware虚拟化软件

为什么要使用虚拟机?

比如测试linux,windows

安装两个操作系统不行吗?需要来回切换,且万一操作系统中毒导致无法开启,或者需要两个网卡呢等等,使得物理机灵活性变的非常差。

只要物理机资源足够,虚拟机数量、不同版本os、硬盘、网卡随意添加。

中毒?破坏性测试?快照来帮忙。这些都是虚拟化的优点。

虚拟化只能用来做实验吗?能否用来跑业务呢?

Vmware workstation 工作站,oracle virtualBox,你可以把核心业务,web、erp、财务系统,部署在里面吗?

VMware workstation player 是免费的,为避免法律纠纷,可以使用它,不侵权。没有高级特性。

传统公司业务服务器,物理机的世界,成本高,不节能,机柜多,服务器多

如果一台高配服务器,把所有的业务系统部署在一台服务器上,然后做高可用。

不建议,一旦某个业务出问题,可能会影响到其他业务系统。

所以,一台服务器运行一个业务,不是性能,而是出于安全考虑。

这样一来,成本比较高,就可以使用虚拟化。

虚拟化优势:节省资源,资源隔离。

用workstation可以吗?所有鸡蛋都放在一个篮子里,不可取。

所以不可以使用单机版虚拟化,工作站级别,必须使用企业级虚拟化软件,高级特性。

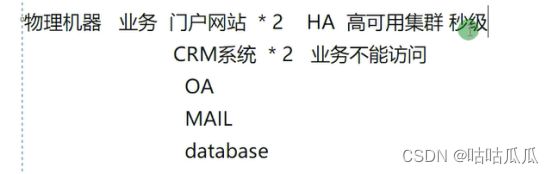

补充(测试环境/生产环境)

测试环境:测试、开发

生产环境:运行的业务

生产环境可用性

比如 游戏公司招聘 运维,保证 5个9

哪怕5个9 也要考虑行业,微信、支付宝、股票实时交易等等。

365241%=87.6 365240.001%*60分钟=5.256分钟

2.3 企业级虚拟化介绍

虚拟化中的老大:VMWare

云计算世界:AWS亚马逊/Microsoft微软/阿里云

云计算世界的虚拟化几乎是开源虚拟化,如果不采用开源,那么每卖出一套云计算软件,都需要给vmware付费,成本高,没有源代码,代码不可控,受制于别人。(去IOE)

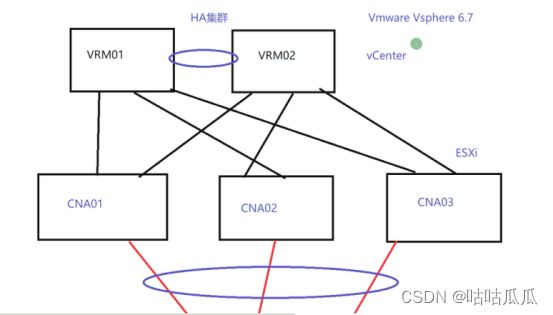

Vmware企业级虚拟化:vSphere

微软企业级虚拟化:Hyper-V

华为企业级虚拟化:FusionCompute

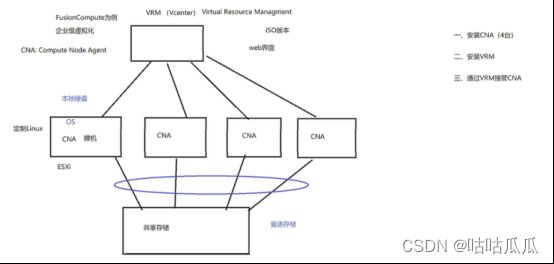

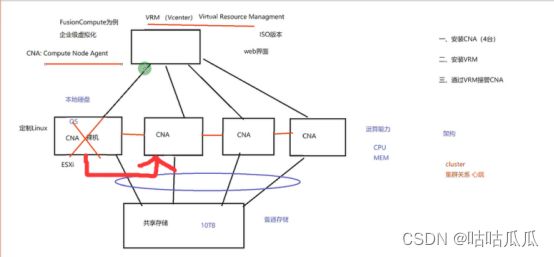

企业级虚拟化有哪些特性?我们以华为FusionCompute为例来介绍。

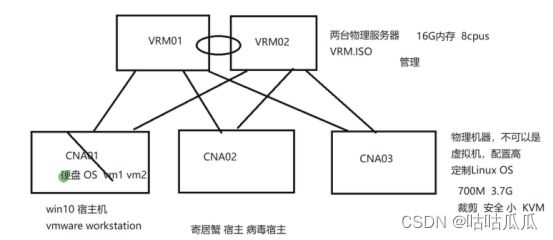

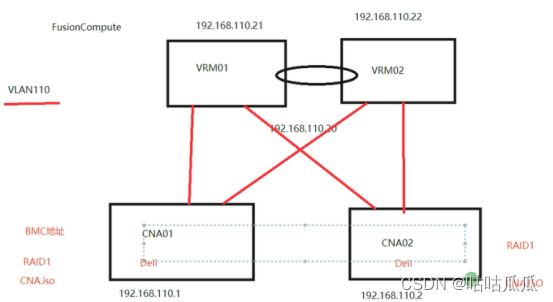

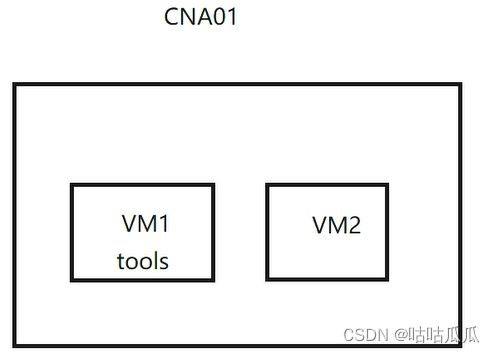

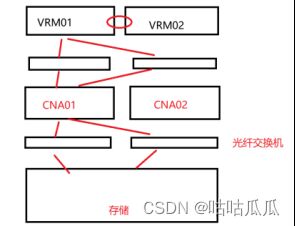

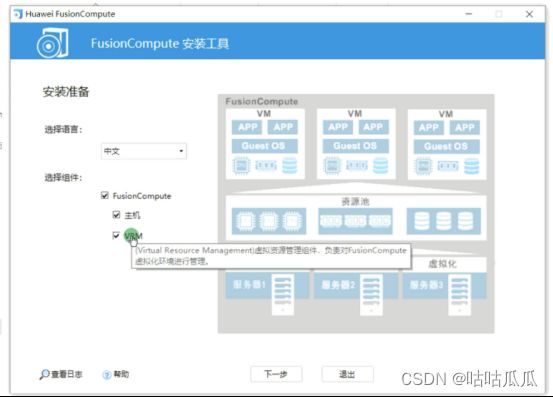

VRM(Virtual Resource Management)虚拟资源管理

VRM也是一个iso,是web界面,负责资源调度

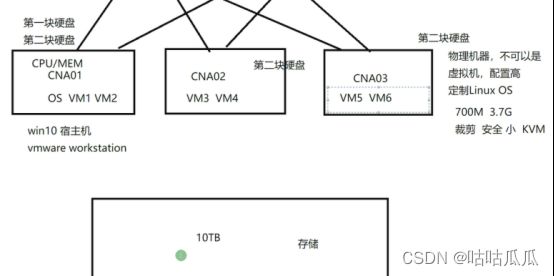

CNA Computing Node Agent 计算节点代理

CNA是一个装在裸机上的操作系统,被阉割过的Linux,可以在官网下载到的iso文件,大概700M左右,是定制的一个Linux操作系统。

演示打开FC界面

注意:CNA本身提供本地硬盘,这个硬盘主要安装操作系统的,而里面的虚拟机磁盘,是由底层存储划给它的。CNA只有操作系统盘,CNA提供运算能力,共享存储提供存储空间。

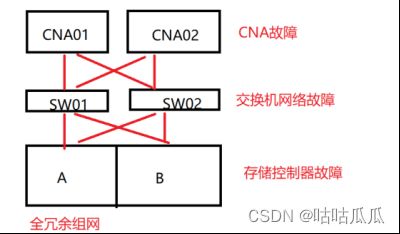

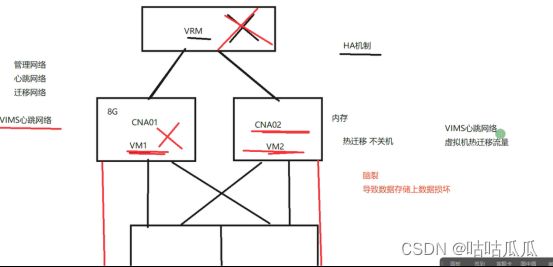

为什么要使用这种架构?因为可实现高可用,VRM监控各个CNA的心跳

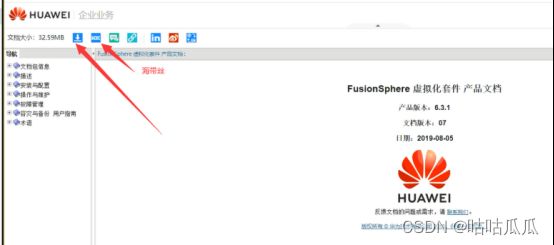

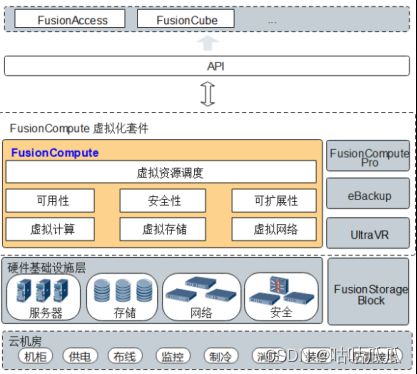

2.4 华为FusionSphere虚拟化套件

目的让学员知道目前学习的FusionCompute属于哪一块。有全景图。(8.0.1官方文档中已经没有fusionmanager了,换成了FusionCompute Pro)

FusionCompute里面包含VRM和CNA,围绕关系进行讲解。

2.5 华为FusionCompute介绍

CNA本身具有硬盘,但不推荐使用,因为一旦CNA出现故障,所有虚拟机都出问题。所以建议虚拟机不要安装在本地硬盘,而是安装在共享存储中。

问题:如果vm1 对性能的要求,已经超过了各个节点CNA单台性能,怎么办?

答:单台虚拟机性能不能超过单台CNA性能。假如CNA64cpus,单虚拟机不得超过64cpus

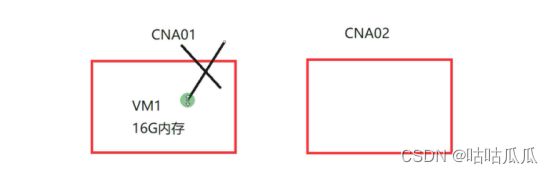

问题:CNA挂了,虚拟机怎么接管?

答:由其他CNA接管,VRM会去检测,集群HA,会自动进行接管。不可手动。

问题:CNA1剩余配置不足以创建一台新的vm,那么剩余怎么处理?

答:VRM统一调度指定CNA,控制虚拟机在哪里创建,不需要执行CNA主机。在集群上创建虚拟机,会根据负载均衡选择合适的CNA主机。不可以把CNA主机的内存和CPU拼在一起。

问题:CNA挂了,其他CNA接管,需要重启虚拟机,如何保证业务连续性?

答:影子虚拟机(影子虚拟机是精确的副本)、HA高可用等可以保证。

第3章 FusionCompute架构及安装

3.1 华为FusionCompute组件

结合上图,画出华为FC和VMWare的对应关系,然后介绍FC组件。

3.2 华为产品手册及软件下载

账号绑定代理商,是经过华为认证的,不然某些产品手册和软件无法下载。

3.3 物理服务器介绍

6颗CPU是免费的,超过6CPU就要付费

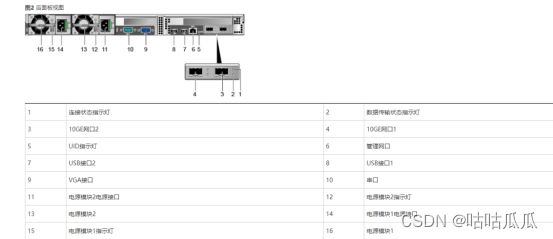

CNA是基于物理服务器的,看下物理服务器长什么样。

塔式服务器/刀片式服务器/机架式服务器(很多)

塔式服务器像主机

E9000机箱采用12U/16刀片结构(全宽和半宽),密度大,在有限的空间可以放更多服务器。

![]()

机架式服务器(用的最多的)。

机柜标准42U—导轨

规定的尺寸是服务器的宽(48.26cm=19英寸)与高(4.445cm的倍数)。由于宽为19英寸,所以有时也将满足这一规定的机架称为“19英寸机架”。厚度以4.445cm为基本单位。

1U就是4.445cm,2U则是1U的2倍为8.89cm。所谓“1U的PC服务器”,就是外形满足EIA规格、厚度为4.445cm的产品。设计为能放置到19英寸机柜的产品一般被称为机架服务器。

问:服务器怎么放?

答:卡在导轨上,推进去

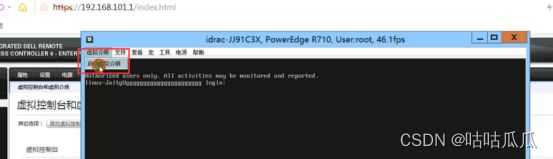

服务器来了,如何安装操作系统?跑机房?接显示器?

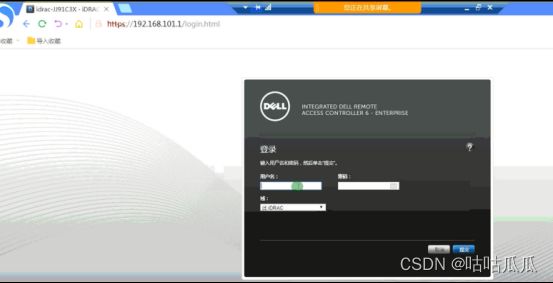

3.4 智能平台管理接口

远程管理服务器,通过IPMI接口可实现。

智能平台管理接口Intelligent Platform Management Interface,简称IMPI。

使用该标准实现对服务器的开机、关机、重启等操作

原本是一种Intel架构的企业系统的周边设备所采用的一种工业标准。IPMI亦是一个开放的免费标准,用户无需支付额外的费用即可使用此标准。

各个厂商远程管理卡名字不一样,但协议一样。

IBM:RSA(Remote Supervisor Adapter II) 远程管理适配器/远程管理卡

HP:iLO iLO(Integrated Lights-Out)是 HP 独有的服务器远程管理技术

DELL:iDRAC(Integrated Dell Remote Access Controller,)

HUAWEI:V1和V2早期的叫iMANA,V3开始叫iBMC 基板管理控制

baseboard management controler

(泰山服务器 iBMC 192.168.2.100 Administrator Adminaite9000)

云计算可以对接哪些类型发服务器(都是基于IPMI标准来发送指令的)

iBMC和iMana有什么区别呢,是一回事吗

功能是一样的,不同版本的名称不同。

V1、V2服务器叫iMana,V3及以后版本叫iBMC。iBMC在处理芯片和软件上都做了升级,iBMC开始采用华为自研管理芯片。软件也做了重大修改,比以前的版本更加稳定。

客户端(跳板机)如何连接到BMC的??如图,最右是跳板机。

长什么样?服务器什么样?存储什么样?

和网口长的一样,

接口集成独立的操作系统,嵌入式操作系统,真正的网卡,是没有os的。远程管理卡,只要通电就行,出厂默认带ip,bios里面默认设置,输入ip账号密码即可。

演示登陆

对于老服务器,BMC 是 扳手

对于新服务器,BMC 是 Mgmt management

对于存储,维护口 是 扳手

(存储:扳手–维护口 小电脑–管理口)

版本说明:可以远程管理修改bmc地址

SmartKit为存储、服务器、云计算三大领域的产品提供了统一的服务工具平台,同时也支持原OceanStor Toolkit的所有功能。

3.5 手工安装CNA及注意事项

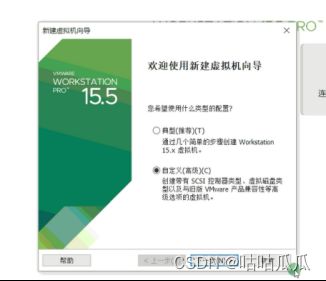

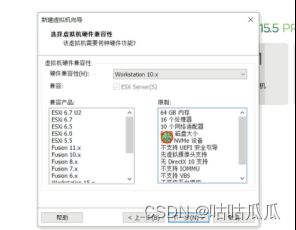

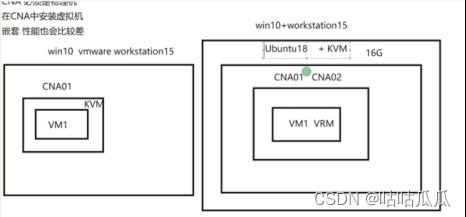

CNA必须是物理机,在CNA中安装虚拟机

能不能在虚拟机上安装CNA?可以,但不支持嵌套,也就是不支持CNA上的虚拟机。

有没有办法?有

要么虚拟机安装

云主机本身就是虚拟机,也是不可以嵌套。

要么物理主机安装

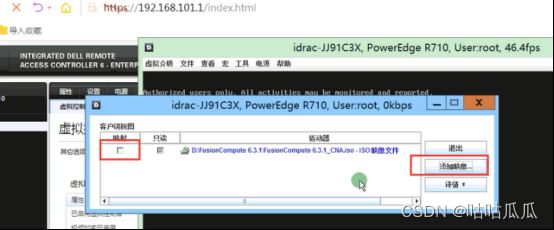

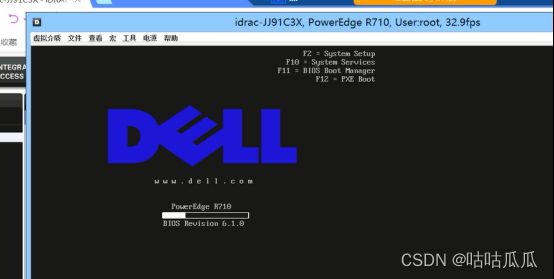

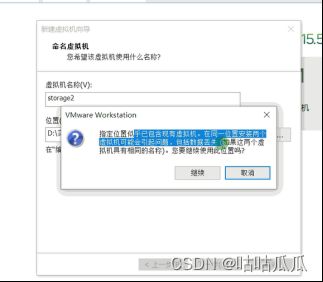

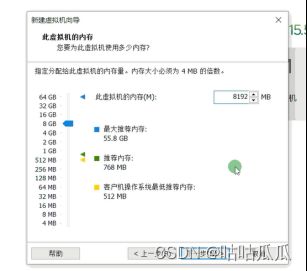

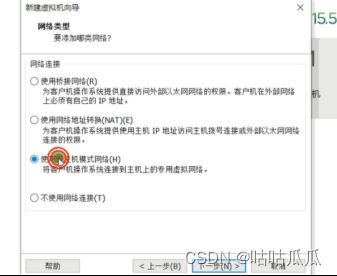

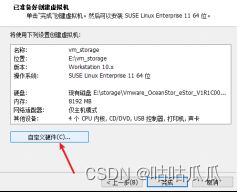

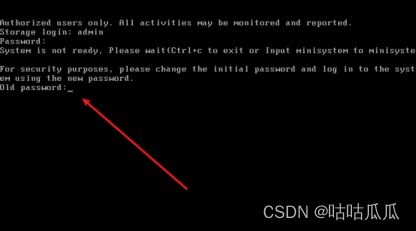

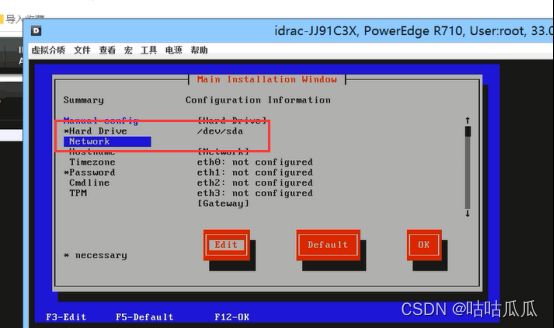

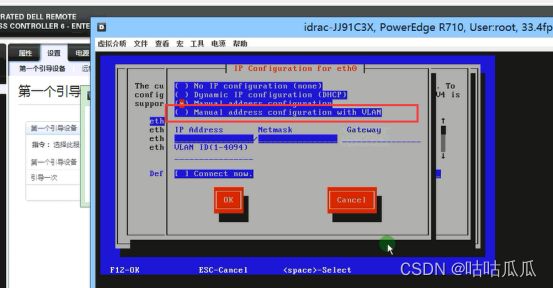

课上演示如何在虚拟机中安装CNA(内存必须大于8G),主要讲解操作步骤,实验用真机。除了配置RAID,一切的步骤和虚拟机一模一样。

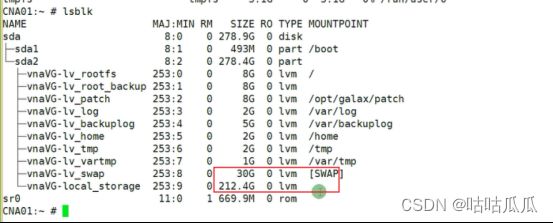

1.硬盘:raid1 swap分区

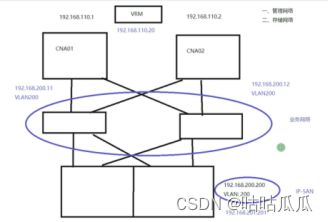

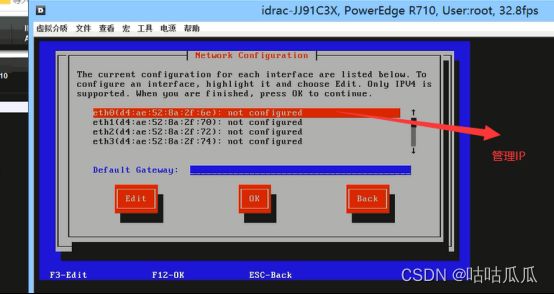

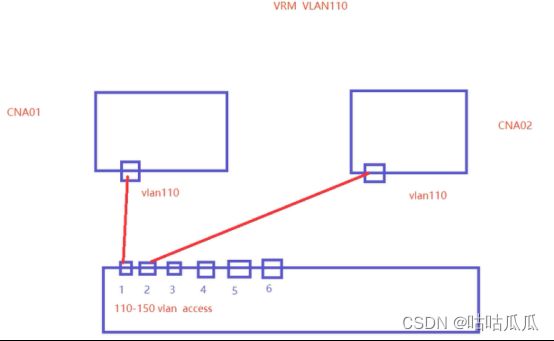

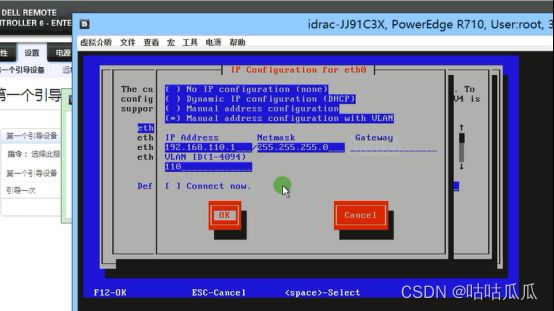

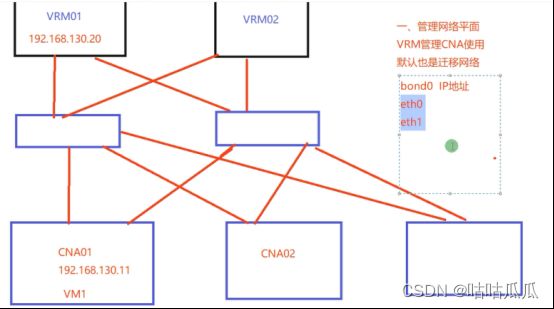

2.网络规划:VRM和CNA必须在同一个子网内,同一个vlan

配置路由可以吗?可以,但是有延迟,50毫秒。

网络规划按照之前文档来

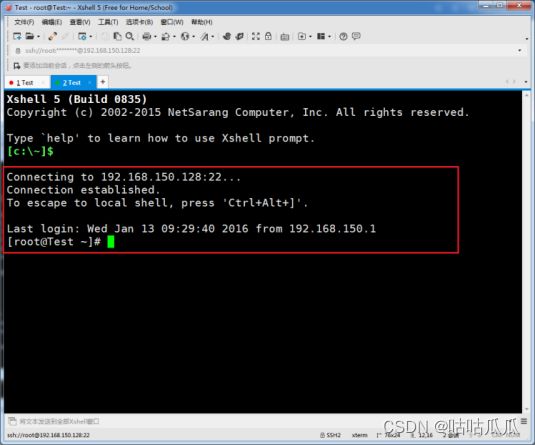

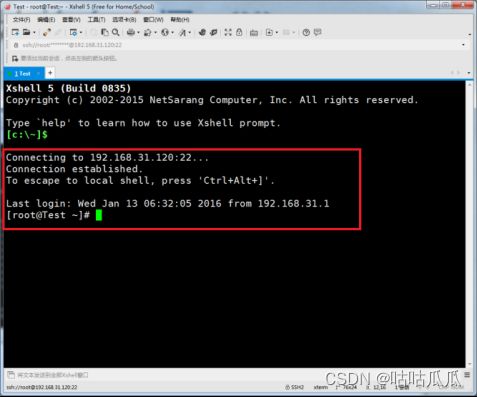

第一个远程链接:

远程连接:lab.yutianedu.com:1000

用户名:tianhairui

密码:YTedu@123

CNA01 192.168.130.11 网关 192.168.130.254

CNA02 192.168.130.12 网关 192.168.130.254

VRM01 192.168.130.21

VRM02 192.168.130.22

VRM VIP: 192.168.130.20

VIP是什么?浮动IP,对客户端透明,不管谁宕机,都可以漂移到另一台VRM节点上,实现高可用。

注意默认网关,设置默认的ip,192.168.130.254 ,创建虚拟机的时候选择的时仅主机,所以针对vmnet1 来设置一个ip。不然无法检测。

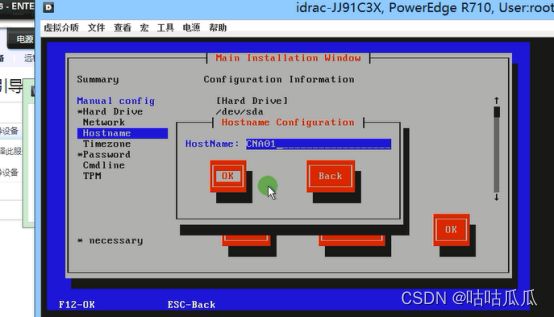

3.主机名 CNA01

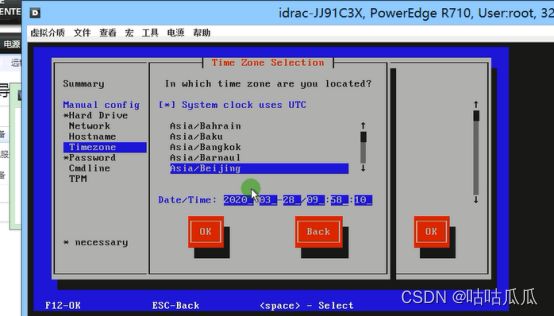

4.时区 默认beijing

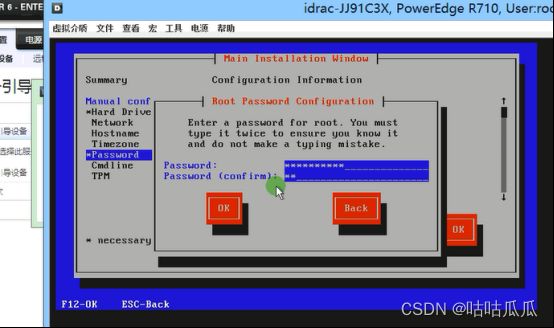

5.密码 必须复杂性要求,大小写,大于8位

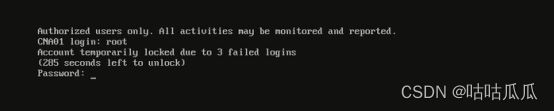

密码不知道,破解可以吗?

6.命令行 调优调整linux内核参数 磁盘调度算法 保持默认

7.TPM 安全等保 加固

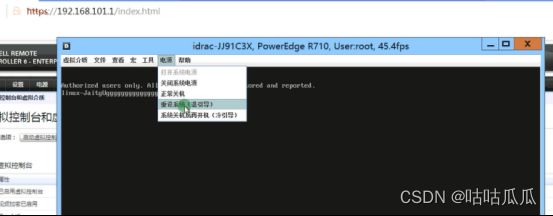

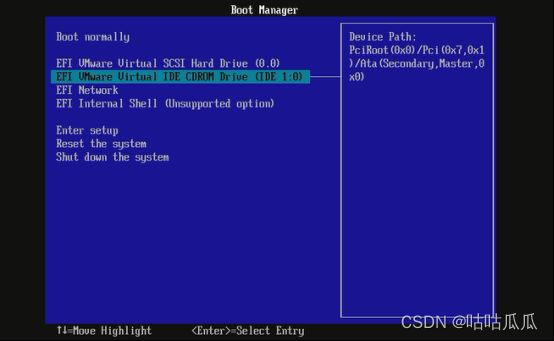

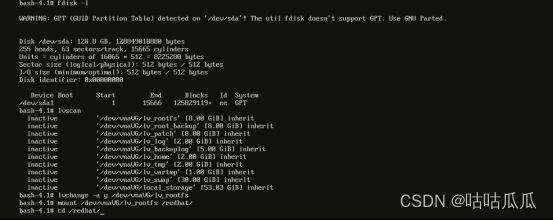

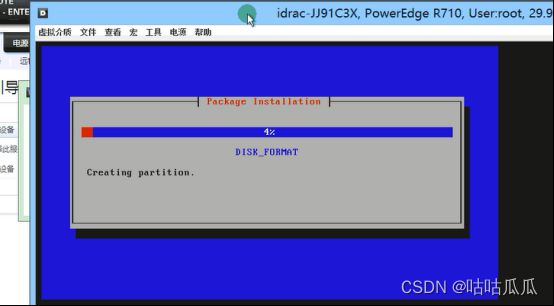

关机,加载红帽6.4(可尝试其他版本)。启动,按ESC键,用光盘启动

![]()

![]()

重启

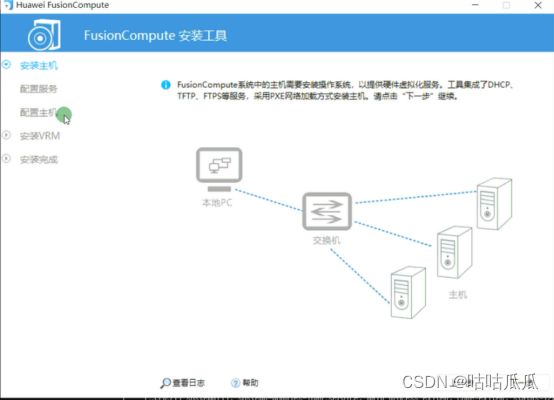

3.6 工具批量安装CNA

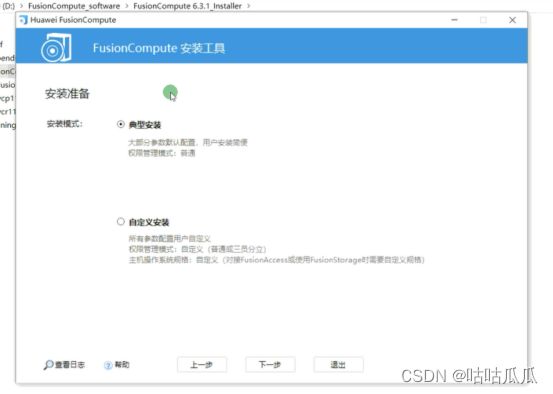

批量进行CNA安装。华为提供的installer工具,可同时安装CNA和VRM

第4章 虚拟化XEN与KVM

4.1 虚拟化的历史

云计算底层,用的都是开源虚拟化,源代码开源可用,方便二次开发;虚拟化免费,源码可用,如果用vmware,需要付费给vmware。所以云计算厂商不会使用商用虚拟化,而选择开源虚拟化。

两大阵营 XEN 和 KVM

早些年使用XEN,现在基本都是KVM

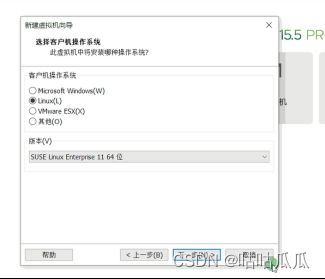

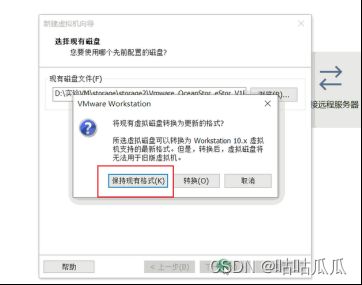

FusionCompute 6.1 之前使用 SUSE Enterprise Linux 11 64bit

FusionCompute 6.1 之后 Euler OS 欧拉Linux

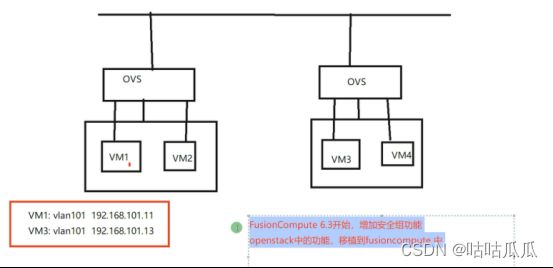

FusionCompute 6.3 之前使用Xen

FusionCompute 6.3 (6.3)KVM

Linux扩展

RedHat 开源 付费补丁 rhn_register

CentOS 编译 community Enterprise Operation System CentOS

大企业选择付费红帽,互联网选择CentOS免费

Oracle Enterprise Linux OEL和欧拉都是基于redhat

AWS最早使用XEN,当年没有KVM,国内云计算厂商基本用的都是KVM虚拟化

1964年 IBM开始尝试在大型机上实现虚拟化

1972年 IBM推出运行在大型机上的虚拟机

1999年 VMware推出了x86架构的虚拟化产品

2002年 Xen正式被开源

2006年 Qumranet宣布KVM诞生

2007年 惠普发布了针对HP-UX的Integrity虚拟机

2007年 红帽5.0版本中提供XEN虚拟化机制

2008年 微软放在Windows Server 2008 R2中加入了Hyper-V

2010年 红帽6.0版本中默认仅提供KVM虚拟化机制

2011年 IBM、红帽、惠普和英特尔成立开放虚拟化联盟,加速KVM推广

2013年 Docker推出

4.2 计算虚拟化术语

Guest OS:

虚拟机操作系统

Guest Machine:

虚拟出来的虚拟机

Hypervisor:

虚拟化软件层/虚拟机监控机

(Virtual Machine Monitor,VMM)

Host OS:

运行在物理机之上的OS

Host Machine:

物理机

4.3 XEN与KVM的区别

由于处理器架构的不同,在大型机上已经成熟的虚拟化技术却并不能为小型机及x86所用。直到2001年,VMware发布了第一个针对x86服务器的虚拟化产品。之后的几年间,英国剑桥大学的一位讲师发布了同样针对x86虚拟化的开源虚拟化项目Xen,并成立XenSource公司(07年Citrix思杰将其收购);微软在2008年发布的Windows Server 2008 R2中加入了Hyper-V。期间,VMware被EMC收购,XenSource则被思杰收购。

不过几个月后,到了RHEL 5.0发布的时候,红帽决定也将Xen加入到自己的默认特性当中——那是2006年。一时之间,在Linux服务器领域,Xen似乎成为了 VMware之外的最佳虚拟化选择(事实上也没多少其他可选的)。

但是,作为一项Linux平台上的虚拟化技术,Xen在很长一段时间内一直没有被接受到Linux内核的代码当中,这对于Xen的维护者而言,不仅意味着要多做很多工作,还意味着用户在废了半天劲装好Xen之后可能遇到意想不到的问题(注:2011年6月发布的Linux内核3.0中已经加入了对Xen的支持——Xen的工程师们表示这是清理了7年遗留代码、提交了600多个补丁的成果)。

而红帽方面,也许是因为当时对这种脱离内核的维护方式很不爽,也许是因为采用Xen的RHEL在企业级虚拟化方面没有赢得太多的市场,也许是因为思杰跟微软走的太近了,种种原因,导致其萌生了放弃Xen的心思。2008年9月,红帽收购了一家名叫Qumranet的以色列小公司,由此入手了一个叫做KVM的虚拟化技术(KVM,全称Kernel-based Virtual Machine,意为基于内核的虚拟机)。

总之红帽决定选择了一个新兴的基于内核的虚拟化技术:KVM。而在正式采用KVM一年后,就宣布在新的产品线中彻底放弃Xen,集中资源和精力进行KVM的工作。至此各大虚拟化技术VMware,Xen,KVM等均出现,并找到自己位置。

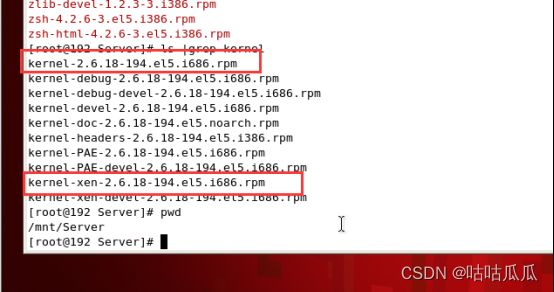

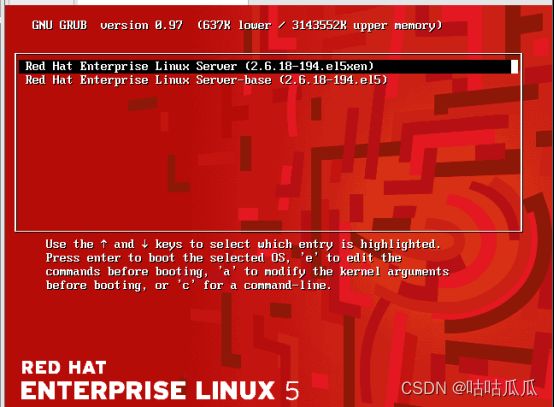

Xen

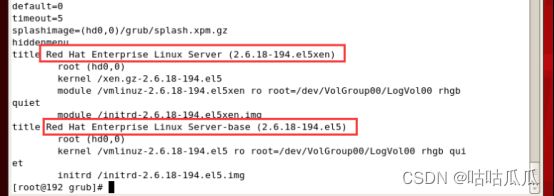

Xen特点:必须升级内核才能使用。

如果想要使用Xen虚拟化,内核必须运行在XEN上,才能跑虚拟机。

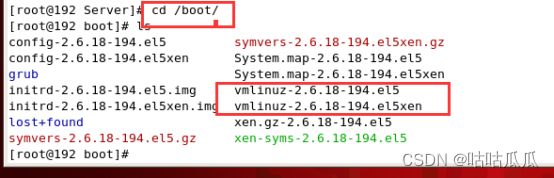

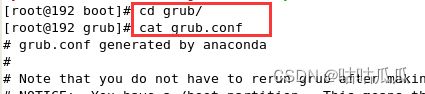

查看下现在使用的默认内核

Reboot重启,切换标准内核。Xen虚拟化跑不起来。

维护庞大的内核,所有内核模块,驱动程序都需要重新编译,重新安装,工作量及其大。

一旦升级内核,和内核相关的所有的内核模块,驱动都需要重新编译。意味着要经常维护一套庞大的内核,这就是XEN问题所在。

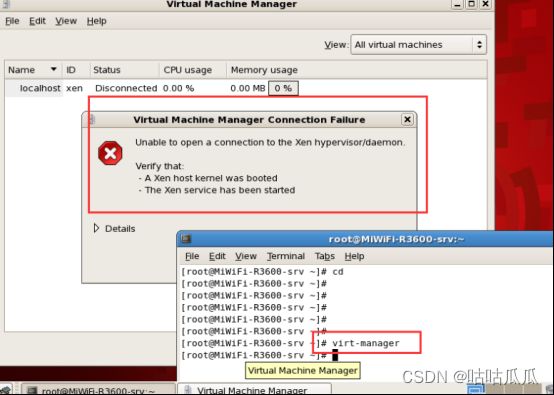

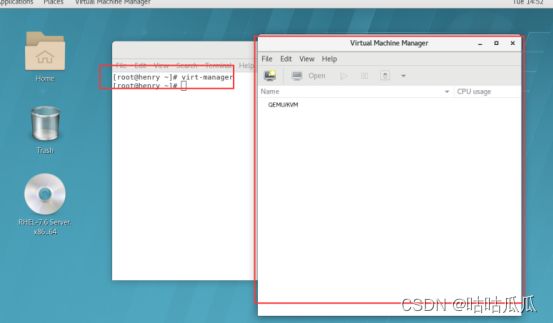

再来看看红帽7,直接安装相关包 yum install -y virt*

就可以打开虚拟机 virt-manager

KVM:Kernel-based virtual machine 基于内核的虚拟机,不需要维护庞大的内核。

如何知道底层是否跑的KVM?

在CNA上,也可以差。就是个内核模块,轻量级,非常方便。

每运行一个虚拟机,都会作为系统的进程

Ps aux |grep kvm

XEN和KVM谁输谁赢?现在看来,KVM赢了。

Citrix思杰赞助了一个开源社区CloudStack

红帽也赞助了一个开源社区OpenStack

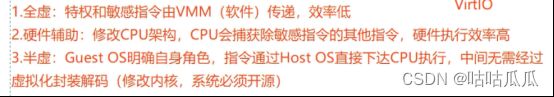

4.4 半虚拟化、完全虚拟化、硬件辅助虚拟化

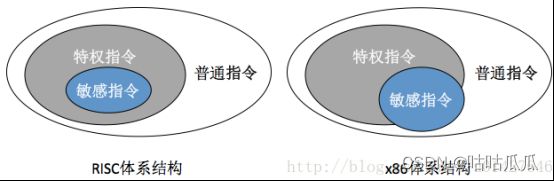

CPU指令环知识/直到虚拟化技术出现,传统x86架构存在缺陷:部分敏感指令不是特权指令。所以各大厂商开始着手处理这个问题/VMWare软件完全虚拟化/Xen半虚拟化/CPU厂商硬件辅助虚拟化。

早期XEN支持半虚拟化

KVM不支持半虚拟化

半虚拟化开始于XEN,半虚拟化技术,以Xen为先例,主要解决的就是这个问题——如何捕获非特权指令的敏感指令。

注意:并不是半虚拟化就是XEN,XEN就是半虚拟化,不要去绑定思维。

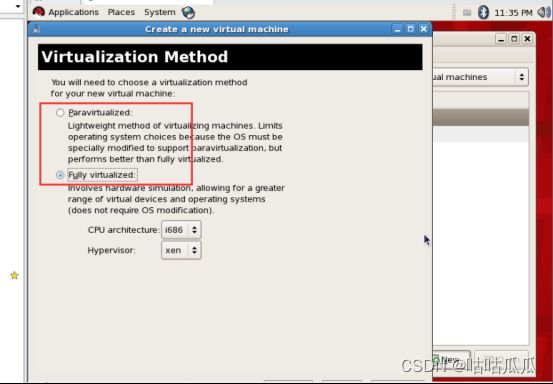

半虚拟化只是在早期为了解决x86架构问题,提出的,刚好当年XEN采用的就是。XEN同时也支持硬件辅助的完全虚拟化。看图

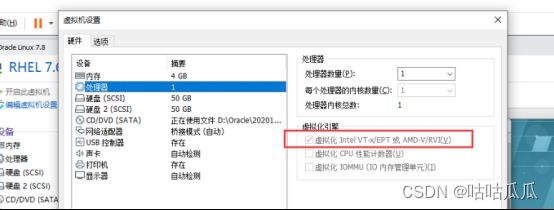

是否支持硬件辅助的完全虚拟化,要看BIOS主板是否支持虚拟化,是否开启。虚拟机设置是否也开启了硬件辅助。

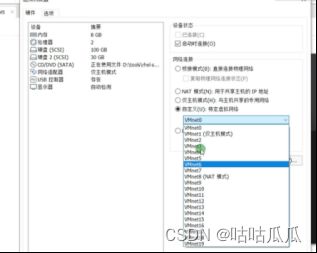

在BIOS里面,是否支持虚拟化。虚拟机里面要开启硬件辅助虚拟化

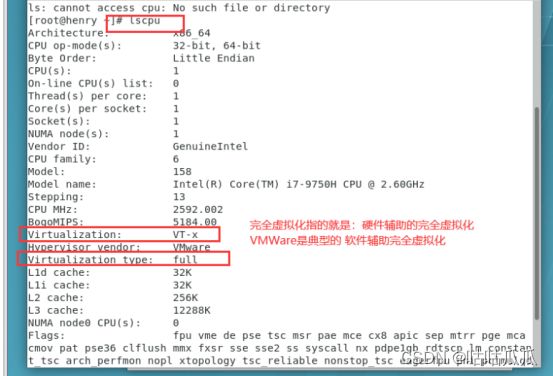

完全虚拟化

VMWare

硬件辅助虚拟化

INter:VT-X

AMD: AMD-V

注意:半虚拟化只能是Linux,因为要需改内核。而windows不开源,无法修改。

4.5 理解virtio

Linux硬盘,网卡,可以选择virtio类型。

Linux因为自带驱动,所以支持virtio

Windows系统盘,没有驱动,所以无法识别,不建议使用virtio

但是windows数据盘可以。

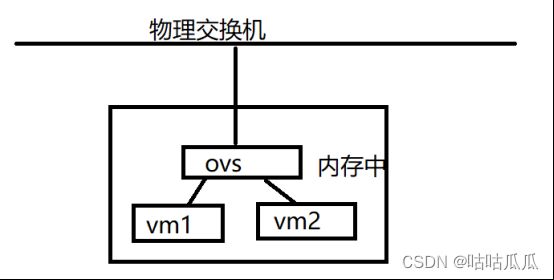

在完全虚拟化里面,虚拟机不知道自己是虚拟机,所以访问的时候,流量是:

Vm1-ovs-到物理交换机-ovs-vm2 非常麻烦,因为vm1vm2不知道自己是虚拟机。所以可以为网卡安装半虚拟化驱动PV Driver 硬盘半虚拟化驱动PV Drive,就知道自己是个虚拟机,直接在内存ovs中进行数据的传输,不再经过物理交换机,这就是在完全虚拟化中安装半虚拟化驱动。

第5章 计算虚拟化

5.1 FusionCompute 6.3.1安装

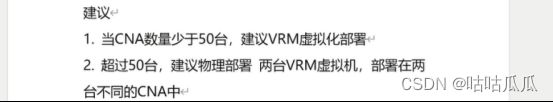

VRM作为虚拟机安装在CNA里面,节省两台物理机。

网络规划按照之前文档来

第一个远程链接:

远程连接:lab.yutianedu.com:1000

CNA01 192.168.130.11 网关 192.168.130.254

CNA02 192.168.130.12 网关 192.168.130.254

VRM01 192.168.130.21

VRM02 192.168.130.22

VRM VIP: 192.168.130.20

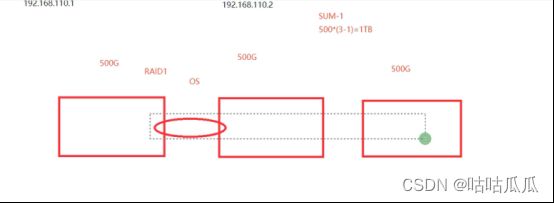

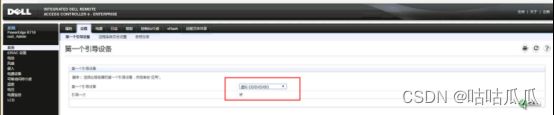

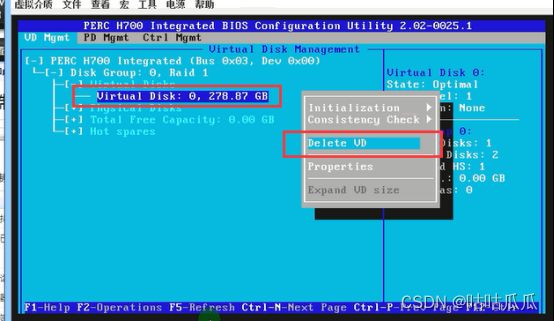

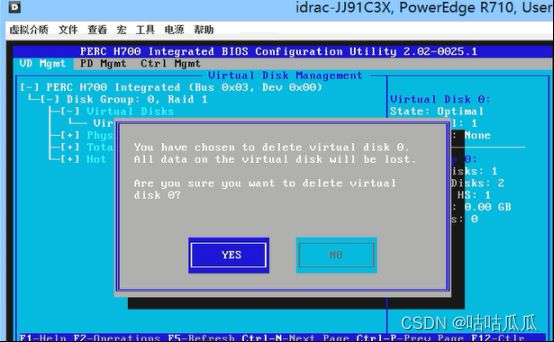

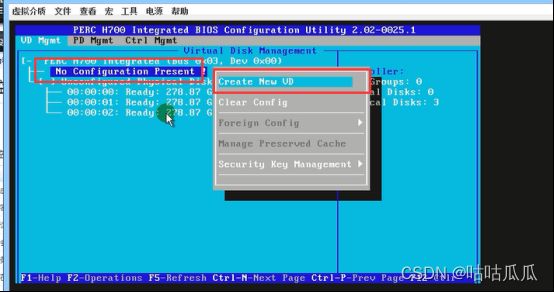

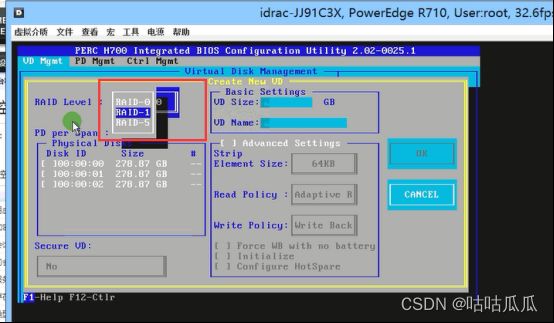

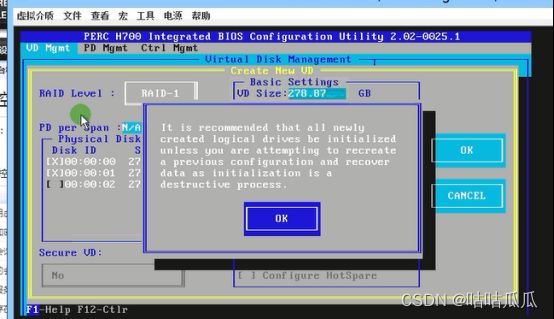

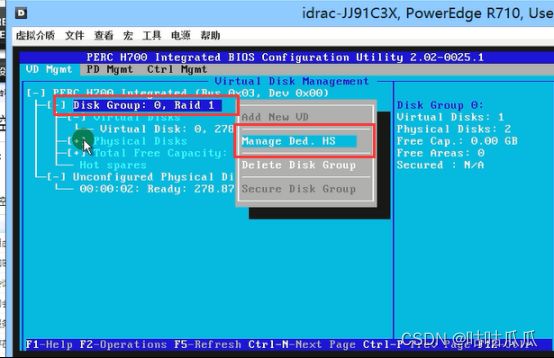

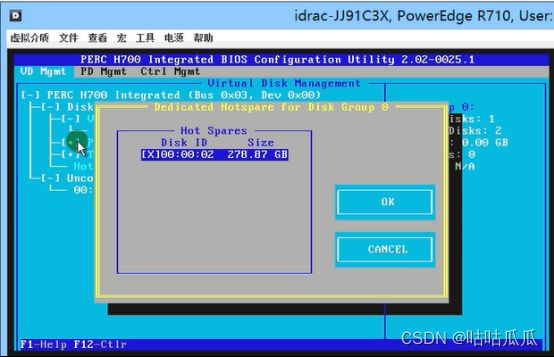

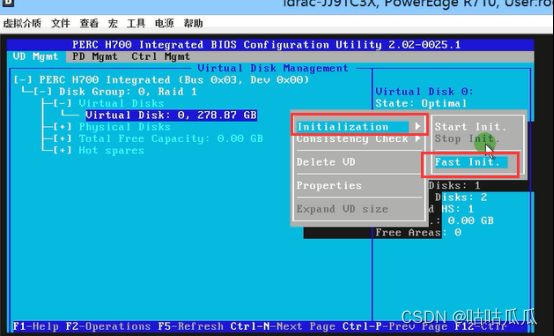

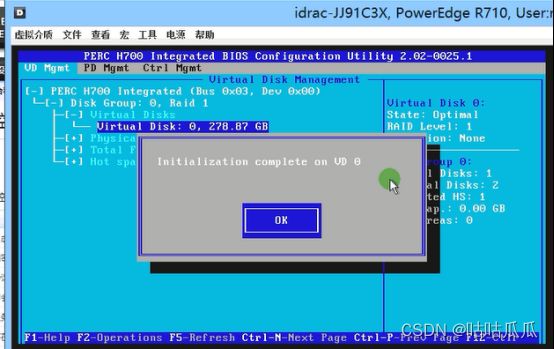

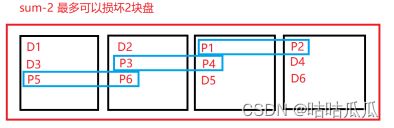

5.1.1 DELL服务器RAID原理及配置

RAID 1 双盘镜像

RAID 5

总容量为=总盘数-1

做raid,品牌大小建议一致,如果非要不一致,也行,性能问题

木桶原理,快慢,慢为主;大小,小为主。

![]()

三块盘,两块raid1,一块热备盘。备胎

数据位和校验位重新分布

关于RAID的更多信息,到讲存储的时候再讲。

5.1.2 CNA安装

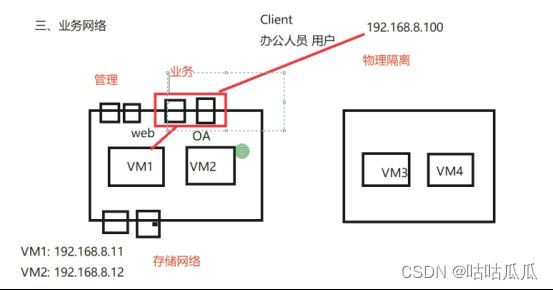

业务网络,管理网络,存储网络,希望网络隔离,用到vlan

为什么要设置vlan??交换机上是怎么规划的?引入7.1 ,然后画图。

数据包进来后,会打上tag标签。交换机上做trunk。并放行110-150

安装完两台CNA

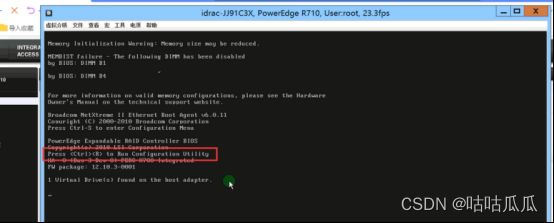

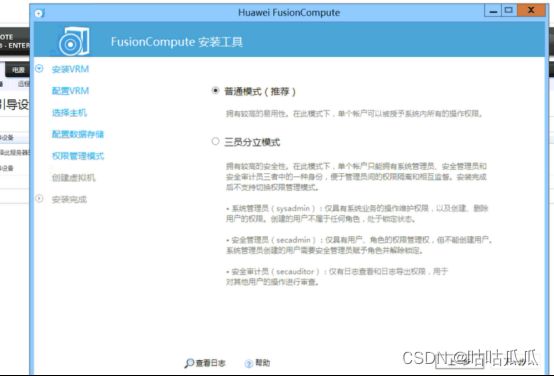

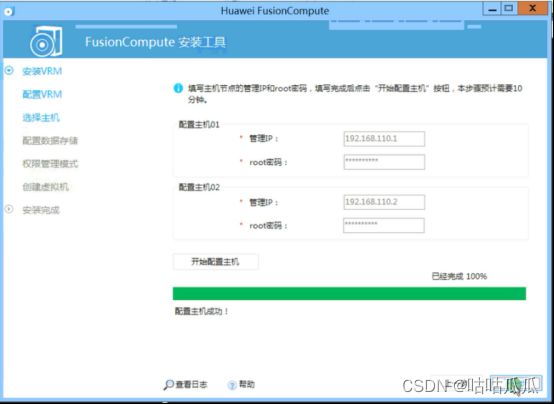

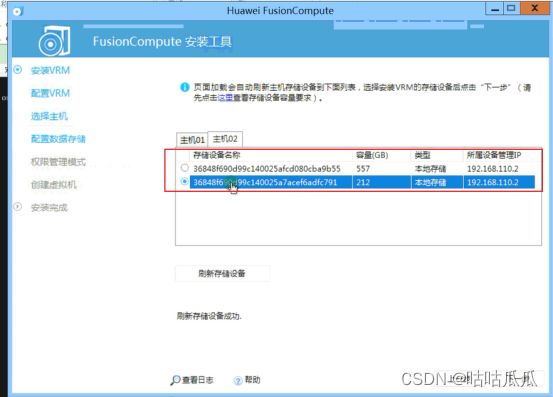

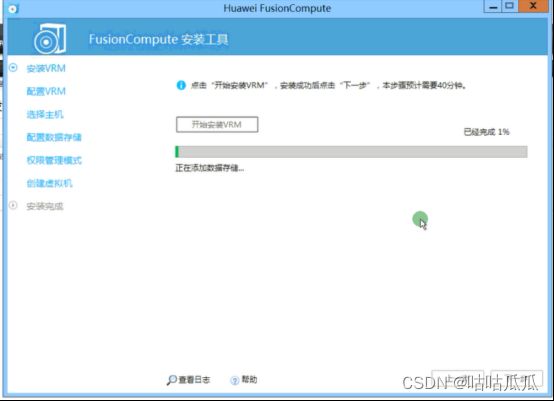

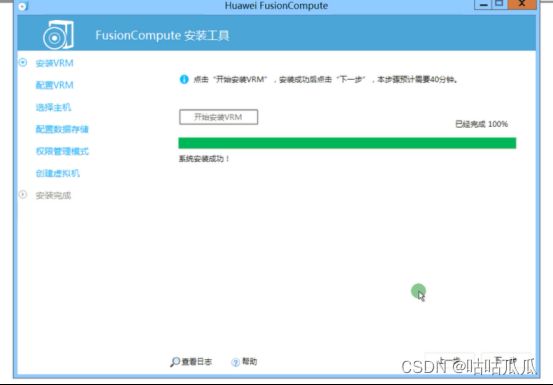

5.1.3 VRM安装

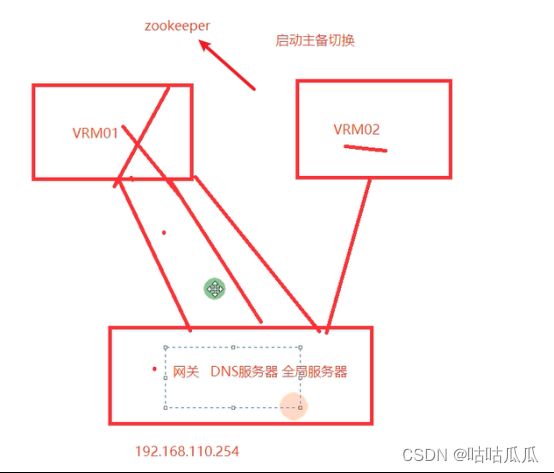

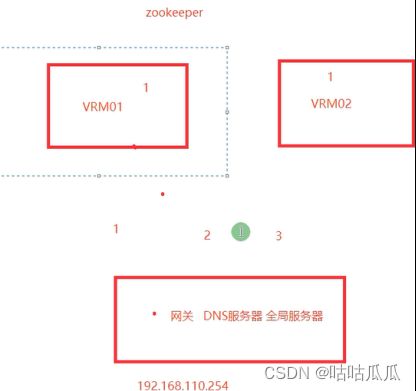

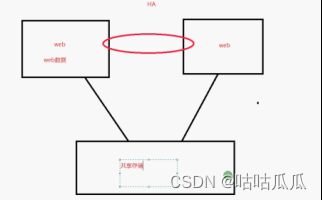

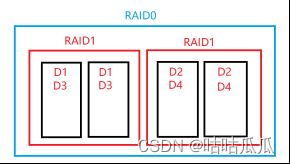

什么是仲裁IP??防止脑裂。不需要专门的仲裁服务器,可以ping通即可。是一个三方仲裁机制。

要是仲裁服务器挂了。。。就会产生脑裂。

而且,zookeeper有过半存活和投票选举机制。

![]()

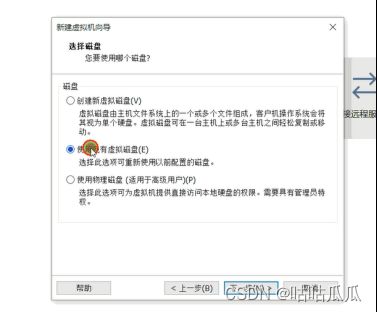

把VRM安装在CNA里面的本地硬盘中,那这样是不是就不能迁移和HA呢???

是否有问题?商业环境是这么做的吗?

在业务层 VRM 做HA,使用zookeeper,底层数据库(高斯)gaussdb数据是同步的。

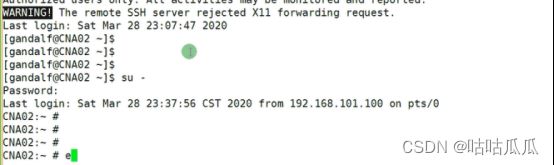

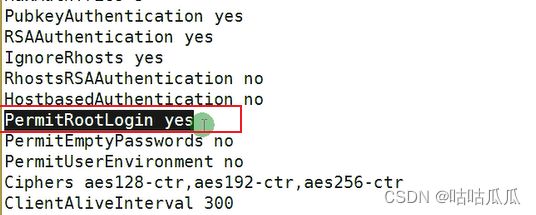

发飙~~~CNA是可以进入命令行维护的。但是实际工作过程中,总不能每次登陆BMC啊。。。

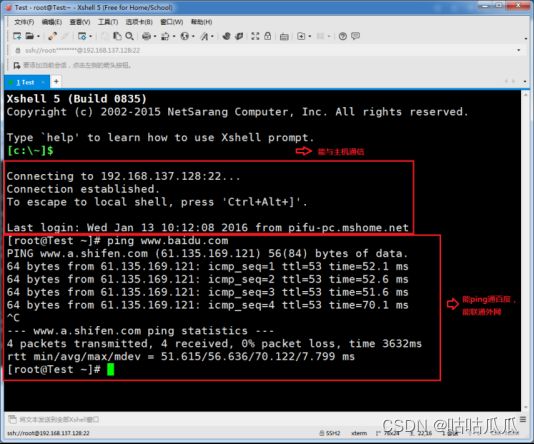

所以,要通过三方工具。Putty,secureCRT,xshell

但是,为了安全,不允许使用ssh远程 root 进行登陆。但可以进行设置(新版可以直接登陆)

Vim /etc/ssh/sshd_config

所以为了安全,在CNA中建立了一个普通用户 gandalf

华为虚拟化(魔戒三部曲,华为研发leader,可能比较痴迷指环王)

进来后 TMOUT=0变量,默认300秒。=0会话不过期。

疯了。。。。现在可以直接登陆root

三员分立,中国特色客户。分开。安全审计,安全等保用户的(过等保-等级保护)。

公检法:公安、检察院、法院

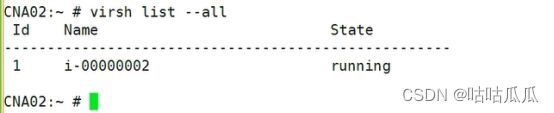

安装完CNA后,KVM的虚拟化就安装好了,所需要的套件安装好了。

Kvm的命令就可以运行了。等一会安装好虚拟机后,就可以通过命令查看了。

Virsh list --all

KVM 命令如何使用?在IP级别都会给大家讲到。

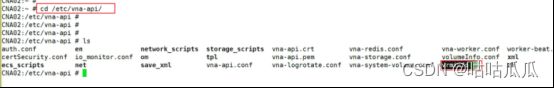

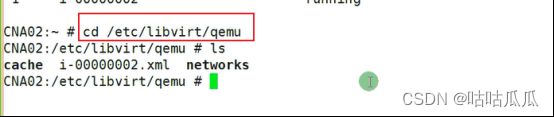

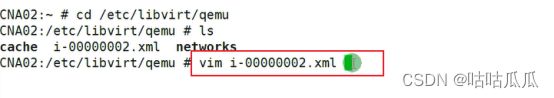

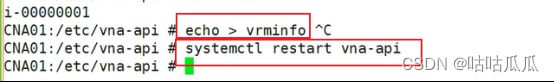

CNA接管失败-重要

VRM一旦故障,重建VRM,它的UUID不一样,接管的时候会提示:已经有其他VRM接管了。

这种情况怎么办???

真正的UUID在这里!!

CNA02 是被 i-00000002 这个VRM接管的。

解决方法:官方手册,ppt都没有

5.1.4 VRM如何接管CNA

这时候CNA03会被其中一个VRM接管,如果想换接管的VRM,就按照上面的方式进行信息清除。一个CNA,只能被一个VRM接管。

问题???刚才接管的时候,怎么没让我们输入用户名和密码呢?

因为,默认使用的是gandalf 来接管的。改了gandalf密码后,无法接管。。。内置好的。

下面的BMC,是做电源管理用的。DRS DPM

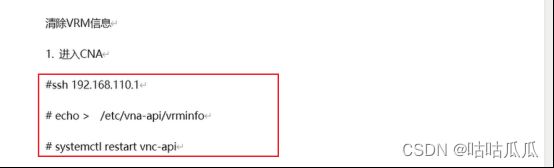

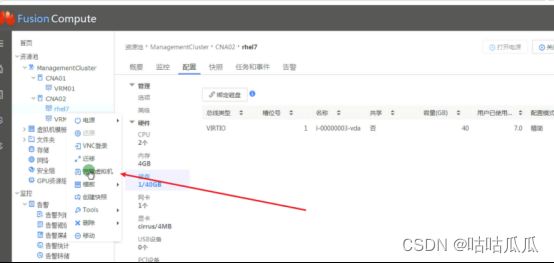

5.1.5 如何创建虚拟机

如果系统选择错误,(virtio可以提高性能)PV 驱动就会安装错误。

Virtio驱动,linux自带,windows不自带,怎么安装,挂载一个软驱。

选择windows需要手工选择,选linux自动,不需要手工选择。(结合4.5 virtio)

VNC登陆进行操作系统安装

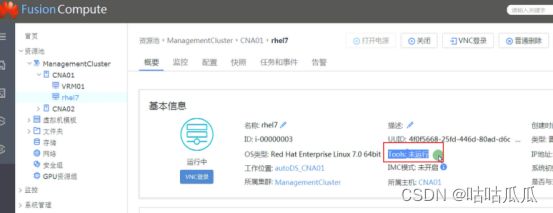

5.1.6 安装tools

之后安装tools

安装完成重启

如果是windows,直接挂在光盘,双击安装。

因为有个vip

5.2 FusionCompute集群讲解

计算虚拟化,把计算资源进行虚拟化。cpu,内存,io资源。

能否超额?能否复用?等等

登陆VRM,输入VRM VIP地址

回顾架构图

通过FusionCompute tools会自动创建一个管理集群

默认密码

描述-运维管理

用户名:admin

密码:IaaS@PORTAL-CLOUD8!

5.2.1 集群概念

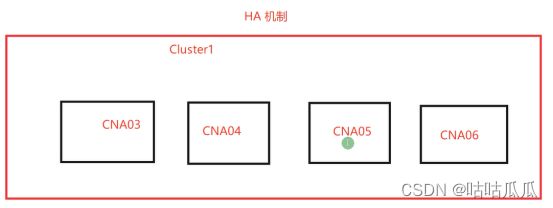

CNA01和CNA02,因为不在同一个集群里,所以,无法HA(Highly Available)

需要注意:

CNA硬件架构要一致(Inter和AMD) 热迁移,指令集不一样,导致失败

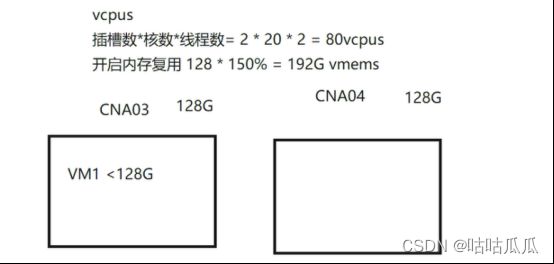

5.2.2 主机内存复用

为什么128G内存可以使用192G?因为在创建虚拟机的时候,分配4G,不一定完全使用4G。

建议最高150%,超过120%会有紧急报告

开启内存复用好处:提高虚拟机开机密度

关闭内存复用好处:提高虚拟机性能

什么开机密度?开启前,只能开10台,开启内存复用后,开启15台。

作为公有云开不开?多卖钱,当然开。

5.2.3 虚拟机启动策略

负载均衡、自动分配

负载均衡:虚拟机启动的时候,集群会根据内部算法,在负载相对较轻的主机上开启。

自动分配:集群繁忙,虚拟机启动的时候直接轮询启动。

谁来算?VRM,如果瓶颈是CNA,负载均衡;如果瓶颈是VRM,自动分配。

调度如何实现的?基于Zookeeper

如何知道VM瓶颈?在监控里面可以查看

集群-单击右键

主机-单击右键

注意:虚拟机可以和主机进行绑定

为什么要绑定啊?

因为有些财务软件需要用到加密狗或者U盾。只能和物理机绑定。

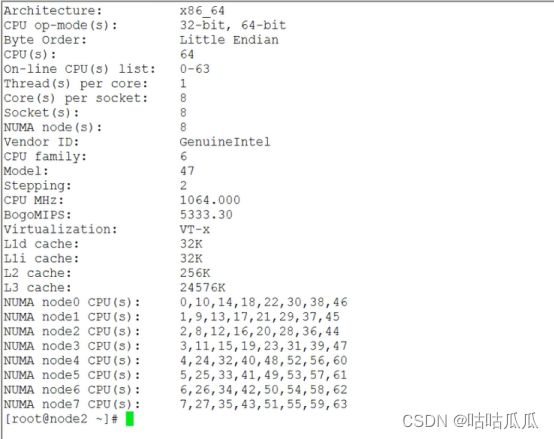

5.2.4 NUMA非一致性内存访问

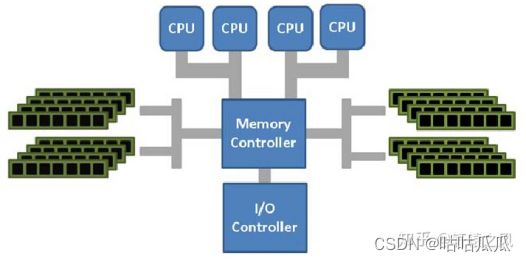

理解UMA架构,这样的架构称为UMA(Uniform Memory Access),直译为“统一内存访问,

在NUMA出现之前,CPU朝着高频率的方向发展遇到了天花板,转而向着多核心的方向发展。

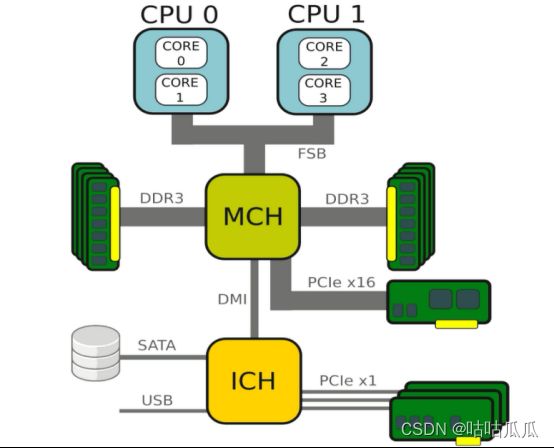

在一开始,内存控制器还在北桥中,所有CPU对内存的访问都要通过北桥来完成。此时所有CPU访问内存都是“一致的”。

但随着CPU核心数的增加,这样的架构难免遇到问题,比如对总线的带宽带来挑战、访问同一块内存的冲突问题。为了解决这些问题,有人搞出了NUMA(Non-Uniform Memory Access)

随着cpu和内存不断增多,资源竞争成为了瓶颈。因为所有的数据都要经过FSB,占用带宽资源。可FSB前端总线带宽是有限的。于是问题就出来了。如何解决??

Cpu和内存放在同一个numa node里面,建立很多节点。叫NUMA节点。

Core(s) per socket 指每个物理CPU内Core的数量。 Thread(s) per core 就是每个core中的Thread 数量

Cpu访问内存直接访问本地内存,如果不够,可以通过QPI快速通道去使用其他内存。

访问自己的叫 local access ,访问其他的叫做 remote access。

这时候觉得NUMA好牛啊,但是,操作系统这边忙的不可开交。

频繁的通过QPI会让建立的缓存失效,一个线程一会在这里,一会在那里,很随意。

NUMA的内存亲和性问题,为了得到更好的访问速度,线程在哪个NUMA节点上开启,就在哪个节点上来运行,避免跨节点内存访问。

Numa和内存复用互斥。

不可以跨主机CNA去分配cpu和内存资源。

5.2.5 开启HA-故障响应

源主机恢复虚拟机

必须等CNA01恢复好之后,再去启动虚拟机

HA虚拟机

直接在CNA02上启动

为什么会存在源主机恢复???

因为加入CNA01上面跑了10个vm,一旦故障,这时候其他主机资源又不够,就有可能影响到CNA02,与其这样,还不如等着。

5.2.6 开启HA-接入控制

HA资源预留

集群允许主机故障设置

5.2.7 开启HA-群体性故障

如果在两个小时内,出现了很多虚拟机故障,只处理前面2个虚拟机。

5.2.8 开启计算资源调度

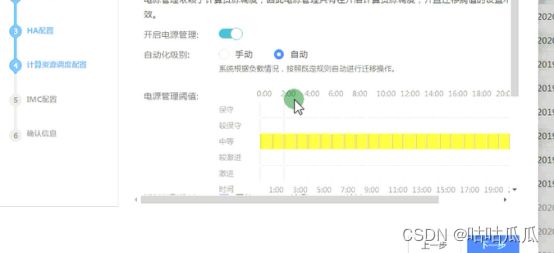

5.2.8.1 计算资源调度自动化(调度均衡)DRS

我们在管理CNA的时候,如何判定机器负载很高,或者不均衡?可以根据CPU,或者内存,或者CPU和内存。一旦超过规定的值,就会触发调度(自动),如果选择手动,会有告警,手工进行迁移。

迁移阈值敏感度设置(5个级别)

当某台CNA内存或CPU超过了规定的值,然后持续了30秒,突然又降下来了,这时候要不要动态平衡呢?

也可以根据不同时段来设置不懂的敏感度

动态走的是热迁移,在线迁移,不会影响业务,非常小。

5.2.8.2 电源管理DPM

为了绿色环保

在非业务高峰期,关闭其他的CNA主机,

第二天再开机,负载均衡将虚拟机分布到开机的主机上。

集群可以检测到

如何实现开机关机??

集群中添加主机的时候,可以维护BMC地址,通过底层IPMI标准指令来实现开机关机。如果要电源管理,需要维护BMC地址账号和密码。一般情况下不用。

如果是保守派:我选择开机,能不关机就不关机

如果是激进派:我选择关机,能不开机就不开机

5.2.9 IMC模式(Incompatable Migration Cluster)

建议同一批次的型号的主机,放在同一个集群内。

不同批次放在不同集群。

但是cpu版本不一样,有可能在同一个集群里面。

IMC的原理说明

1、原理说明

设置集群的IMC策略,使虚拟机可以在不同CPU类型的主机之间进行迁移。其基本思想是集群内所有CPU指令和功能取交集,这样就可以保证虚拟机在所有主机间热迁移的时候CPU寄存器状态、CPU相关指令状态等在对端节点上可以继续调度起来。

2、使用说明

打开IMC虽然可以保证异构CPU节点之间可热迁移虚拟机,但是是以牺牲性能为代价的,因为高级别的CPU指令往往代表着更快的CPU指令处理效率和速度,而为了满足异构CPU之间的虚拟机在线热迁移,而高级CPU指令可能只存在与个别CPU上。

当站点下存在异构服务器的时候,建议把CPU型号相同的CPU尽量规划到同一个集群下,以保证同一集群下各节点CPU型号一致,这样可避免打开IMC开关。当然,最好是没有异构服务器最好。

英特尔的tick-tock 钟摆模式。

Tick-Tock:Tick年(工艺年)更新制作工艺,Tock年(架构年)更新微架构。

两年一代,不仅保证工艺的跟新,也保证的兼容和安全,避免风险。

最终,集群创建完成,也可以修改

一个集群,多个集群有什么区别?自动化调度,资源调度,HA只能针对一个集群实现。

两个集群不可以HA(不可超出集群边界)

同一个集群下的两个主机可以HA

#

如果虚拟机使用本地磁盘,那么无法实现热迁移,高可用等集群高级特性。

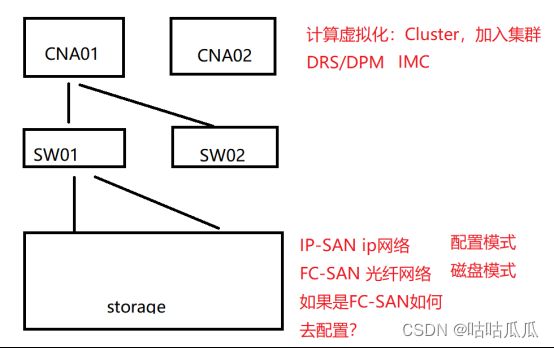

所以要用到 共享存储(存储-指的就是共享)。

这就是为什么要有存储。

存储长什么样子?要学一些什么?存储自己故障怎么办?等等。

先看看存储长什么样,图片,对照官方3D图。

结合第5章,FC的安装,最终的目的是为了安装在共享存储上面。

Openfiler,华为oceanstor dorado 模拟真实存储,如何对接 fusioncompute。

虚拟机如果安装在本地硬盘上,迁移就实现不了,所以我们要把虚拟机安装在共享存储上,需要硬件存储技术。现在我们说的是传统存储,不讲分布式存储(IE)。

只要高可用,就需要用到共享存储,所谓共享存储,就是大家都可以去访问。

把虚拟机装在共享存储中,而不是本地硬盘。

存储涉及哪些技术和知识点呢?如果存储故障呢?

先来看一下存储(以华为官网3D模型 OceanStore 5300 V3为例,官方手册2000V3系列-2100V3-2U控制框-控制器)

6.1 电源

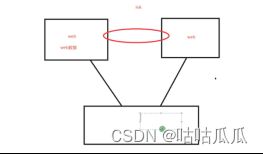

6.2 板载SmartIO

GE有光有电,ETH口是网线口-电口。

gigabit ethernet

英[ˈɡɪɡəbɪt ˈiːθənet]

美[ˈɡɪɡəbɪt ˈiːθərnet]

GE接口,指的是 Gigabit Ethernet 千兆以太网接口,带有GE标记的接口,说明是 1000M 以太网网络接口。

GE接口有光纤接口,也有电接口两种方式。

应用方面:

在跨城市互联中将主要用到GE及以上的接口,以及运营商的核心网络设备互联。但随着科技的发展,网络应用的升级,一些重点单位的上联端口也开始出现GE以上的速率。

6.3 SmartIO模块

6.4 级联硬盘框

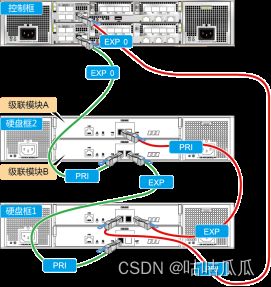

EXP0和EXP1 两个口是 12Gb的SAS口,干什么用的?扩展硬盘框用的,叫级联硬盘框

硬盘框默认带了0-24 一共25个硬盘。1TB*25=25TB

同一级联环路中的其他硬盘框应形成两个相互独立、互为冗余的链路,即采用正反向冗余连接的方式,以达到最佳的组网可靠性。

6.5 管理、维护、串口

所有的接口都是有冗余的

万一机房坏了。。。。就要做双活,两地三中心,IE课程里面会涉及。

那个串口,其实就是console口

6.6 组网-理解什么是SAN

买一台低端存储,但是维护,用的时候,需要购买license激活,扩容,快照,远程复制,双活等,都需要买license,比较贵

全球存储品牌:

Dell:高端EMC 去IOE

Netapp

IBM

HP

Huawei

浪潮、联想、华三、红衫等。

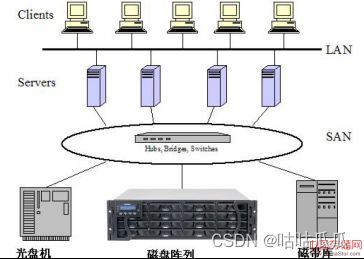

通过架构图,画出存储区域网,引出SAN网络,什么是SAN网络

蓝色的,就是存储网络:用于主机到存储的连接。我们称之为 SAN (storage area(attach) network)存储附加网络/存储区域网络

6.7 FC到底是什么

SAN一般指存储区域网络。存储区域网络(Storage Area Network,简称SAN)采用网状通道(Fibre Channel ,简称FC,区别与Fiber Channel光纤通道)技术,通过FC交换机连接存储阵列和服务器主机,建立专用于数据存储的区域网络

FC:Fibre Channel网状通道;Fibre/Fiber都有纤维之意,与光纤无关

已经被大多数人误解为Fiber Channel光纤通道。

FC只是适用于SAN(存储区域网络)中的一种传输协议;可以将其看作SAN中的TCP/IP

IBM对Fibre Channel接口定义:“The Fibre Channel (FC) interface is a serial interface (usually implemented with fiber-optic cable).”

FC只是usually使用光纤,还有高速铜线缆;使用光纤做介质需要GBIC转换光电信号

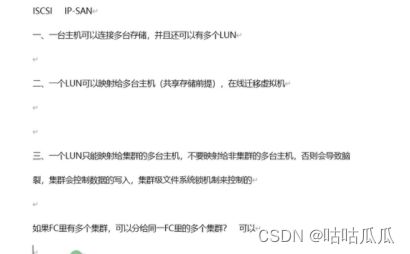

6.8 IP-SAN和FC-SAN

走ip网络以太网口Eth(如果走的是ip网络)-IP-SAN

走fc网络光口FC口(如果是光纤或高速铜缆)-FC-SAN

IP-SAN也称为iSCSI,它是把scsi协议封装在ip网络里面进行远程传输。

这个是什么意思呢?

了解Scsi线缆和硬盘接口

超过100公里,用ip-san

SCSI一般指小型计算机系统接口。小型计算机系统接口(SCSI,Small Computer System Interface)是一种用于计算机及其周边设备之间(硬盘、软驱、光驱、打印机、扫描仪等)系统级接口的独立处理器标准。

一般情况下,都是本机线连接本机硬盘。但是如果要远程传输呢?就需要把scsi协议封装在ip网络里面进行传输,这就叫iSCSI协议,在存储区域网里面也叫IP-SAN。(IP-SAN使用的是普通以太网交换机)

场景:ip-san,以太网交换机、网卡、网线

Fc-san,光纤交换机、光纤、高速铜缆

融合一起

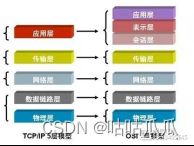

FCoE:FC over Ethernet 把FC协议封装在以太网里面传输,FC协议0-5层,上三层为FC协议,下两层为以太网协议。需要用到FCoE交换机和专用网卡。把两者结合到一起,保证传输距离和稳定行。

协议层说明:

FC-0:物理层,定制了不同介质,传输距离,信号机制标准,也定义了光纤和铜线接口

以及电缆指标

FC-1:定义编码和解码的标准

FC-2:定义了帧、流控制、和服务质量等

FC-3:定义了常用服务,如数据加密和压缩

FC-4:协议映射层,定义了光纤通道和上层应用之间的接口,上层应用比如:串行SCSI 协 议,HBA 的驱动提供了FC-4 的接口函数,FC-4 支持多协议,如:FCP-SCSI, FC-IP,FC-VI

OSI 7层模型

6.9 RAID技术

Raid到底是什么,为什么需要raid技术?

磁盘阵列(Redundant Arrays of Independent Disks,RAID),有“独立磁盘构成的具有冗余能力的阵列”之意。

1.计算机里面 CPU、内存非常快,但是磁盘很慢,导致I/O瓶颈。磁盘性能差。为了提高性能

2.提供冗余

Cpu、内存 坏了可以更换,但是硬盘坏了,有时候是无法恢复的,所以磁盘数据是最重要的。为了解决这个问题,才诞生了 RAID 技术。

那到底是提高性能?还是提供冗余呢?引申出RAID级别。

RAID 0/1/3/5/6/10/50(没有raid 十,raid 五十)

各种RAID技术及优缺点。

6.9.1 RAID 0

条带化的磁盘阵列,必须有大于等于2个硬盘组成,能不能1个硬盘呢?可以,但没有意义。在分布式存储里面,raid卡不支持直通,那么会将每一块硬盘都做成raid0,目的是为了让raid卡来识别。如果raid卡本身支持直通,就不需要做成raid0。(有些RAID卡是不支持直通模式的)

什么叫条带化?如果没有raid,写数据,一个人工作,两个人加油。做了raid就是团队力量。

条带化,会设置分片,设置为2的n次方k,2k,4k,8k。。。。

设置为分片之后。读写速度很快。

但是,缺点:没有冗余。一个磁盘损坏,数据丢失。所以RAID 0很少会单独拿来使用。对安全性没有要求可以使用。

6.9.2 RAID 1

必须是由2倍的磁盘数组成。比如2,4,6,8等,raid 1 可以单独设置热备盘。

请问raid 0 能不能设置热备盘?不可以,坏一块盘,数据就丢了,备胎也没用。

如果不小心把D1分片给删除了,第二个盘里面的D1会不会删除?会的。

只能解决物理错误,不能解决逻辑错误。

所以,即便做了raid,也依然要使用备份软件来备份数据。

(赛门铁克NBU 安全软件公司赛门铁克宣布,该公司分拆后的第二家公司的名字已经确定,即Veritas Technologies,来自于赛门铁克2005年收购的数据存储公司Veritas Software)

所以,raid0 和raid 1 都有自己的缺陷。

Raid 0 提供性能,没有冗余,raid 1 提供冗余,读写性能下降。

Raid 2 没有商业使用价值,被raid3取代,raid3 被raid 5取代,raid 4 被raid 6 取代。

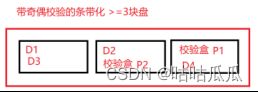

6.9.3 RAID 3

有提升性能吗?读写性能都有提升,而且有冗余,最多可以损坏一块盘。

那是怎么做冗余的呢?

存储里面通过校验位来做的,有两种算法:1.复制 2.异或

Raid 1 属于复制算法,完全复制一份。

其他的属于异或运算,相同为假0,相异为真1

比如:损坏了中间一块盘。换一个新盘,通过其他盘可以算出该盘数据。在raid里面叫“重构”,但是数据很慢。因为每个数据都要倒推算出来。

RAID 3 磁盘使用率n-1/n,10块盘,最多可以坏1块。

But,RAID 3有天然的缺陷。因为单独拿了一个盘来当 专用校验盘。

校验盘说:你们一帮坑货!就我自己累,你们倒挺轻松的。

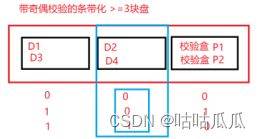

6.9.4 RAID 5

比起RAID 3 他们的区别在哪里?

因为raid3 是单独来出来一块盘当校验盘。磁盘数越多,校验盘越慢,精神上支持校验。不公平,raid 5 公平,每个盘都可以成为校验盘。重构速度更快,压力分摊各个节点。

缺陷:不管是raid3和raid5,只能同时坏1块盘。

6.9.5 RAID 6

Q+P(q代表同一条带运算的结果),DP(double parity) 两种算法

6.9.6 组合RAID 10

两种raid的结合(raid 1+raid 0),先做镜像,再做条带。

至少4块盘,且必须是2的倍数。

如果是 6 块盘怎么办?那就做 3 组raid 1,然后再做 raid 0

空间利用率 50%

优势:raid 10情况下,最多可以损坏几块硬盘?不可以随机故障2块。

Raid 6 ,可以随机故障2个硬盘吗?可以

都是10块盘,是raid 6 磁盘利用率高,还是raid 10 高?Raid 6 高。

一分析,发现raid 6 性能、冗余、空间利用率都比raid 10 要来的好。

在业务场景下,raid 5 和 raid 10 用的最多。

客户配置raid,选择哪个?我个人工作过程中,采用的是raid 5.

到底哪个性能好?

看实际业务需求。

随机小io的写、修改,都会导致很多这种开销。而RAID 10就解决的这个问题,频繁更新不会重新校验。

历史数据不动的,RAID5

经常更新变动的,RAID10(数据库固态盘)

如果是顺序IO,建议RAID 5,数据库业务、银行交易、死翘翘,开销非常大,raid5要校验。

如果是随机小IO,建议RAID10,视频监控、备份死是死不了的

6.9.7 组合RAID 50

Raid 50 至少几块盘?至少6块盘。因为raid 5 至少3块。RAID 60 至少需要8块盘。

每个盘1TB,可以用多大?4T=6*2/3

6.9.8 LUN

LUN:logic unit number 同大小、同型号、同批次。

如果不一样,按照小的算。

有点像大磁盘的分区,一个分区给a用,一个给b用。双方看不到对方的空间。

先做raid,再做lun。

类似于磁盘分区,或者逻辑卷。

6.10 VMWare部署存储环境

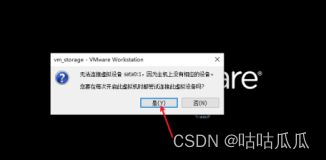

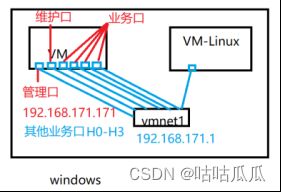

注意:有6个仅主机的网卡。一个管理口,一个维护口,4个业务口

IP地址设定,和vmnet1 为同一个网段就可以了。

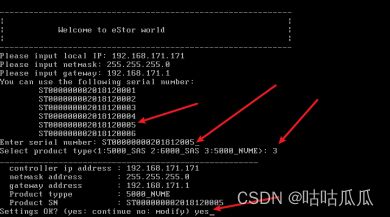

192.168.171.171

开始初始化。

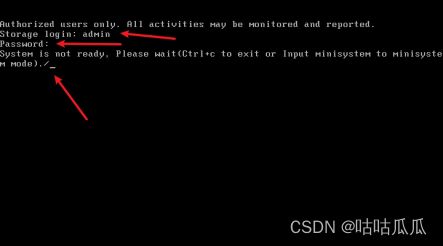

用户名:admin

密码:Admin@storage

登陆后先导入License

6.10.1 导入License

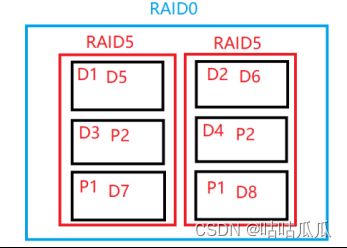

6.10.3 创建硬盘域

![]()

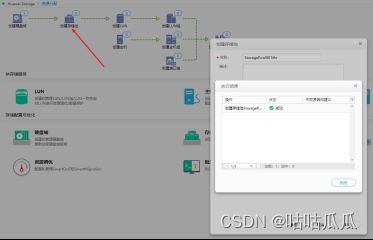

6.10.10 LUN组和主机组映射逻辑

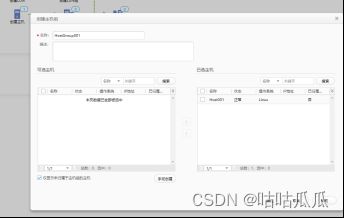

创建主机和主机组,把主机添加到主机组里面

把Lun组映射给主机组

LUN是要映射给主机的,直接映射就行,干什么要搞LUN组的概念?

是因为,下次如果不够了,再创建一个LUN,再一次映射,比较麻烦。

为什么要搞主机组?

是因为同一个LUN,要被多个主机组访问到,加入LUN组,做好映射,主机组内的所有主机就可以访问到了。

现在的问题是?

LUN组映射的是主机组,而主机组仅仅是个标识名称,不具备现实意义。主机组里面包含了多台主机,那么这个LUN是对应哪一台主机呢?

如何实现逻辑主机组和 物理主机进行关联?

如果都在同一个子网内,那么源地址一个,目标存储地址有两个,还是无法实现冗余。所以,建议,存储网络接口,AB控分布在不同子网里面。

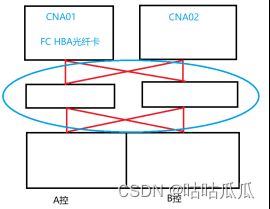

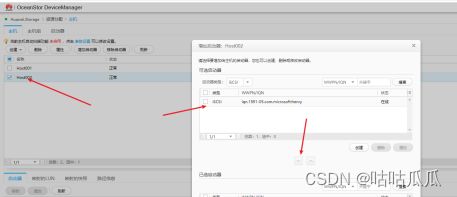

6.10.10.1 如果是FC-SAN

每一块光纤卡,都会有一个WWNN 和多个WWPN号

就像网卡,有一个MAC地址。

WWNN:world wide NOde name 全球唯一节点名

WWPN:world wide port name 全球唯一端口名(主要关注,16进制数字,全球唯一)

有时候你会看到标识WWNs,指的就是他俩。

查看WWNN:cat /sys/class/fc_host/host*/node_name

查看WWPN:cat /sys/class/fc_host/host*/port_name

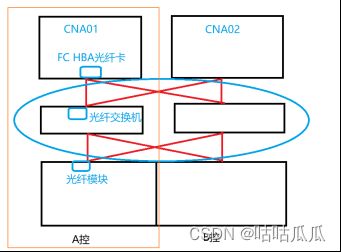

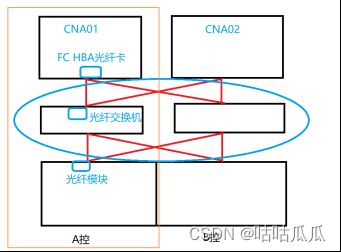

于是,整个架构图是:主机有光纤卡、连接光纤交换、连接光纤模块,主要通电。WWPN号就可以在存储上看到。

于是,我们在 主机 里面 添加启动器,选择FC,把WWPN和主机关联起来。于是,我们就可以通过WWPN知道,具体哪一台主机。就是通过光纤卡来识别的。

如果是FC-SAN 很简单。

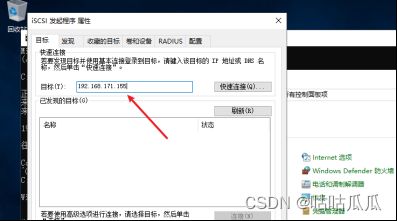

6.10.10.2 如果是IP-SAN

我们没有光纤,就使用这个环境来。

走iSCSI协议。用以太网。

我们针对H0-H3业务口设置IP地址(光纤不需要)

管理网络,和存储网络,建议分开,不要在一个子网里面,最好分开。

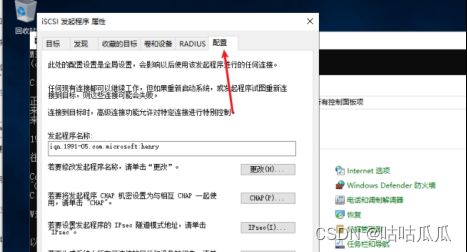

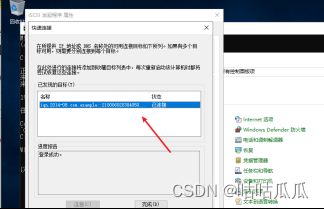

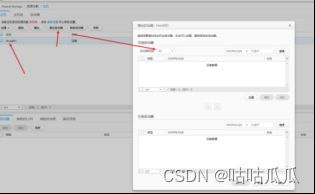

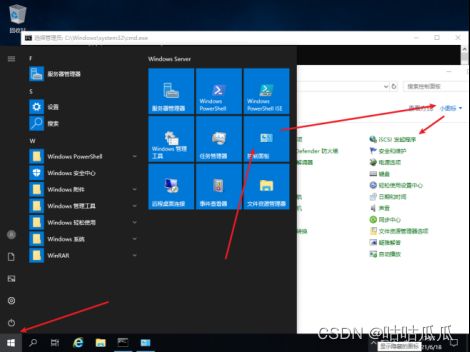

6.10.11 Windows 映射

Windows 2019 里面自带iSCSI客户端

控制面板-管理工具-iSCSI发起程序

相当于主机安装客户端,要去向存储发起连接。

默认不管是windows 和 Linux 都是安装了的。

注意:

标识光纤卡的唯一名称为:WWPN号

标识iSCSI的唯一名称为:iqn号(iSCSI Qualified Name)adj. 有资格的;具备…的学历/资历;有条件的(iSCSI合格名称)默认会加载计算机名,只要不重复,也可以手工修改。

6.10.12 Linux 映射

启动Linux 7.6

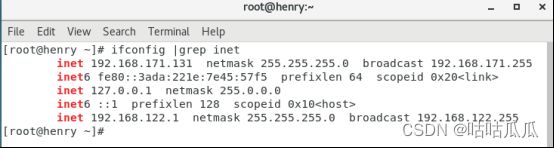

配置临时ip

Ifconfig ens33 x.x.x.x netmask 255.255.255.0

查看ip地址ifconfig

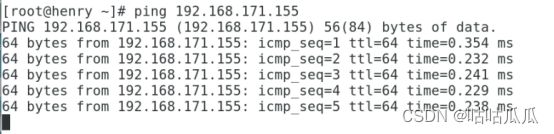

是否ping通存储H0口(配置的存储ip地址)

发起连接:

[root@henry ~]# iscsiadm -m discovery -t st -p 192.168.171.155

192.168.171.155:3260,8196 iqn.2014-08.com.example::2100060203040506::22003:192.168.171.155

进行登陆:

fdisk -l

[root@henry ~]# iscsiadm -m node -l

-l --login #登入节点(服务器)

-t --type=type #这里可以使用的类型为sendtargets(可简写为st)、slp、fw和 isns,此选项仅用于discovery模式,且目前仅支持st、fw和isns;其中st表示允许每个iSCSItarget发送一个可用target列表给initiator;

-p --portal=ip[:port] #指定target服务的IP和端口;

-m --mode op #可用的mode有discovery, node, fw, host iface 和 session

登陆成功后,返回存储,增加启动器

![]()

驱动器号

[root@henry ~]# cat /etc/iscsi/initiatorname.iscsi 启动器名称

InitiatorName=iqn.1994-05.com.redhat:cec1c93a5442

第7章 存储多路径及高级技术

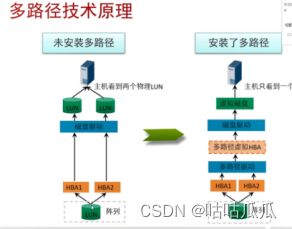

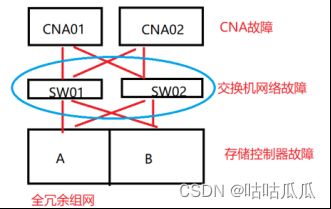

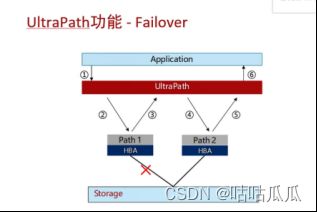

7.1 存储可靠性技术-多路径

什么是多路径,为什么要用到多路径。会存在哪些问题?

提升存储的可靠性,存在多路径映射问题。

然后演示,windows,映射两条链路。(实验,都在同一网段)

最少队列:一条链路1000请求,另一条500请求。

然后,引出多路径软件。华为存储有自己的ultrapath,各个版本。我们以windows版来给大家演示一下。双击安装。

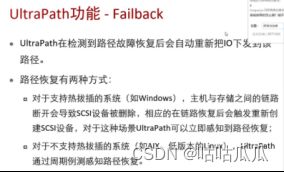

Failback 故障恢复。

7.2 FC里面存储的对接

FC对接过程中,CNA主机里面安装的有多路径软件。

用的是系统默认的。

Rpm -qa |grep multip

Systemctl status multipathd

多路径可以先安装。

FC 配置流程

1.给CNA添加存储接口,配置IP地址

2.存储-添加存储资源

3.扫描存储设备

4.创建数据存储,添加数据存储-格式化(VIMS),VRM发送指令给CNA,CNA执行格式化和挂载任务,格式化速度取决于磁盘的性能和容量

默认格式文件系统化格式为VIMS(virtual image manage system)

微软的NTFS,VMWare的为VMFS。

ocfs2 是 Oracle cluster file system 2 ,VIMS是基于ocfs来的。

存储资源–物理存储

存储设备–Lun

数据存储–文件系统

一台CNA主机操作,另外一边是否可以看到?可以的。

两台主机访问同一个地方,如果两边同时修改呢?

当一个文件打开后,另一个只能只读(用的是ocfs2文件系统)

因为有锁。什么是锁机制?

ATM机的故事。

数据库级别的表级锁,和行级锁。

文件系统级别是文件为单位。

扫盘命令

[root@henry03 scsi_host]# for i in /sys/class/scsi_host/host*/scan;do echo “- - -” > $i;done

[root@henry03 scsi_host]# fdisk -l

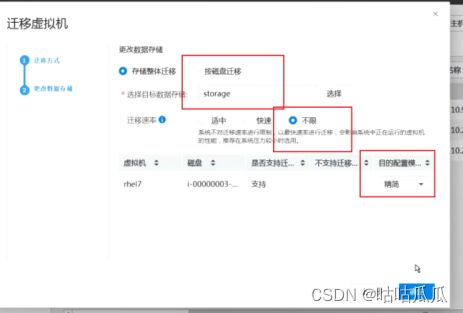

7.3 虚拟机迁移(本地-共享存储)

7.3.1 更改数据存储

存储热迁移,迁移的过程中,不影响业务。

7.3.2 更改主机

卸载光驱和tools

umount /dev/sr0

两台主机的误差不可以超过5分钟。data 03291136

Cmd 去ping看过程。

![]()

7.3.3 添加数据存储-虚拟化和裸设备

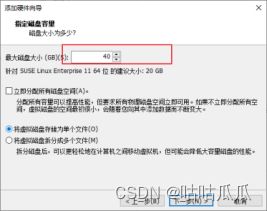

虚拟化存储:快照、精简配置,链接克隆等高级特性

裸设备,是没有格式化的,高性能,满足某些特殊场景。

裸设备有什么用?

创建虚拟机的时候是看不到这个裸设备的,因为不是虚拟化。

虚拟机-配置-硬盘-绑定磁盘

![]()

虚拟机独占使用,裸设备映射,透传scsis指令,。Oracle 裸设备(11gR2就不支持了)

7.3.4 簇大小

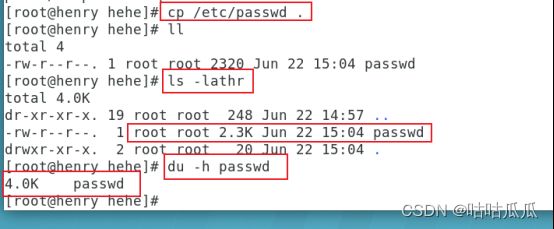

Block size 文件系统的最小存储单元

Windows 簇大小,linux 块大小

一个文件至少要占用一个bocksize的大小(1k,2k,4k)

大的好?还是小的好?

一个实际2.3k小,一个占用磁盘大小4k。

如果是小文件4k,如果 20k,占用5个block

如果是大文件16k,如果20k,占用2个block,浪费0.2k

那是不是越小越好呢?读文件,读5个block,下面读2个。

建议,blocksize稍微大些。

7.4 高级特性-硬盘

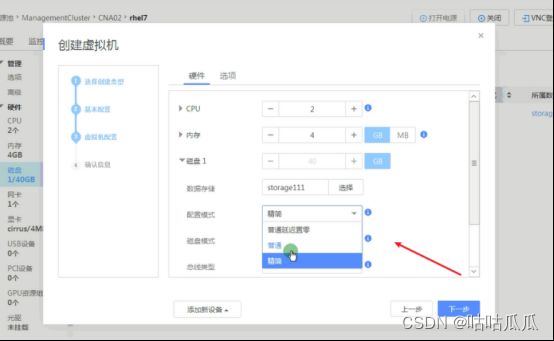

7.4.1 配置模式

一般做实验,选择精简模式。

普通模式:创建后,0填充一遍。第一次非常慢。后期性能高。

根据磁盘容量为磁盘分配空间,在创建过程中会将物理设备上保留的数据置零。这种格式的磁盘性能要优于其他两种磁盘格式,但创建这种格式的磁盘所需的时间可能会比其他类型创建磁盘长。建议系统盘使用。

精简模式:按需分配,不做初始化,不填0。懒。后期性能差。

系统首次仅分配磁盘容量配置值的部分容量,后续根据使用情况,逐步进行分配,知道分配总额达到磁盘容量配置值为止。(会根据需求胖,但不会瘦下来)

普通延迟置零:创建时,不会擦除物理设备上保留的任何数据。后续从虚拟机首次执行写操作时会按需将其置零。创建速度比普通 块;IO性能位于普通和精简两种模式之间。

公有云一般都是精简模式。

Vmware企业级虚拟化

精简模式可以转为普通模式,普通无法更改为精简模式。

在华为企业级虚拟化有两种方法:1.克隆,2.迁移数据存储

三种模式可以互转。

克隆不影响业务,建议停机,克隆。

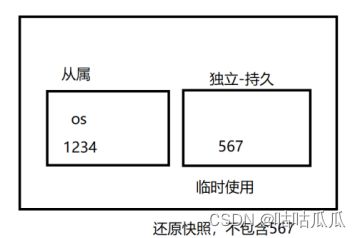

7.4.2 磁盘模式

从属:默认。快照包含磁盘,更改永久写入。

独立-持久:

快照中不包含该磁盘数据。

独立持久,就是给应用临时使用的空间。测试空间。

独立-非持久:关闭电源或恢复快照后,丢弃磁盘更改。

疑问:数据在哪里保存的?

差分盘技术。

关机,直接删除差分盘,用母盘。

1.安装好OS

2.安装app,配置好,正常使用

3.关机,设置独立非持久

4.开机写数据

5.关机,再开机(重启不丢失,关闭电源丢失)

怎么看差分盘?

7.4.3 快照

开机拍快照,vmware,保存内存快照,很慢。

一致性快照,tools通知内存刷盘,然后保存快照。

在linux中 sync 把内存数据刷入磁盘

Oracle alter system checkpoint;

第8章网络虚拟化

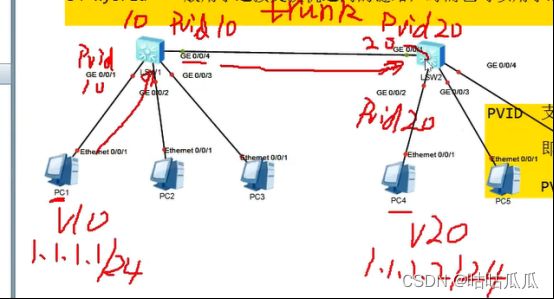

8.0 VLNA实验

Host and Vlan

IPADDR NETMASK GATEWAY VLAN

PC1: 192.168.100.1 255.255.255.0 192.168.100.0 3

PC2: 192.168.100.2 255.255.255.0 192.168.100.0 2

PC3: 192.168.100.3 255.255.255.0 192.168.100.0 2

PC4: 192.168.100.4 255.255.255.0 192.168.100.0 3

PC1/PC2/PC3/PC4: ping 192.168.100.1/2/3/4

SW-1

system-view 用户试图,进入系统试图

防止弹出干扰信息

《》undo terminal moniter

[] undo info-center enable

[Huawei]display vlan

[Huawei]vlan 2

[Huawei-vlan2]quit

[Huawei]vlan 3

[Huawei-vlan3]quit

[Huawei]display vlan

The total number of vlans is : 3

ACCESS

Ethernet 0/0/1

Ethernet 0/0/2

[Huawei]interface Ethernet 0/0/1

[Huawei-Ethernet0/0/1]port link-type access

[Huawei-Ethernet0/0/1]port default vlan 2

[Huawei-Ethernet0/0/1]quit

[Huawei]interface Ethernet 0/0/2

[Huawei-Ethernet0/0/2]port link-type access

[Huawei-Ethernet0/0/2]port default vlan 3

[Huawei-Ethernet0/0/2]quit

TRUNK

Ethernet 0/0/3

[Huawei]interface Ethernet 0/0/3

[Huawei-Ethernet0/0/3]port link-type trunk

[Huawei-Ethernet0/0/3]port trunk allow-pass vlan 2

[Huawei-Ethernet0/0/3]port trunk allow-pass vlan 3

[Huawei-Ethernet0/0/3]quit

SW-2 第二个交换机,和第一个操作一样

SW-1

DVS、端口组、网络平面、桥接(上行链路)、host-only 没有上行链路。

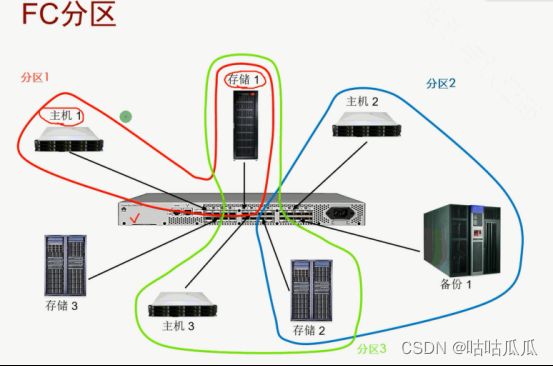

IP-SAN是通过划分VLAN来隔离的。

FC-SAN是通过ZONE来隔离的。

看下光纤交换机

8个口可以用,其他口需要买license激活;

两台交换机级联,也需要license激活;

超过一定的距离,也需要license激活。

博科300 光纤交换机默认: 10.77.77.77 admin/password

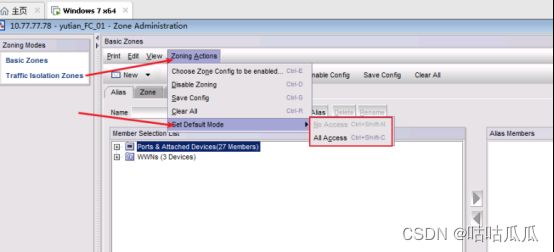

8.1 光纤交换机配置

以太网交换机,光纤交换机

博科-比如16口交换机,只能用8口,另外8口需要license激活。

两台光纤交换机如果要做级联,需要再次购买license。

距离超过一定长度,需要购买长距离的license。

光纤交换机技术垄断。

管理口IP: 10.77.77.77(可以改)

Admin

Password

如果是上面这个,基本都是贴牌,都是博科的光纤交换机。

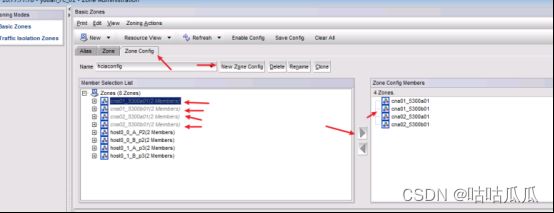

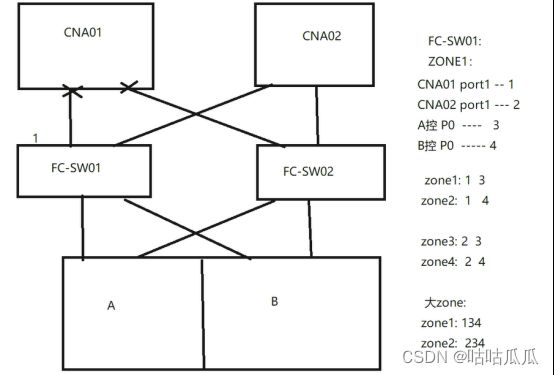

全景图及交换机配置规划

交换机所有的口有个默认值:NO access 和 All access

不在一个zone里面就不通。

那如果有10台CNA,有20台CNA,这样划分,就会非常麻烦。所以,引出 :

大zone:更方便

小zone:更安全,划分麻烦

有些客户要求小zone,提前要规划好。

如果 两台CNA的口子和存储划在同一个zone里面,两台CNA会通信吗?它俩即使要通信走的也不会是这个网络,因为我们划分zone目的是为了连存储,连存储是要有发起端和接收端的,两个发起端怎么能通呢?即使通,也是走的业务管理网络。

光纤交换机怎么划分ZONE

方法有三种

1.根据端口来配置,万一接错端口就比较麻烦

2.根据WWPN来配置(防止捋线的过程中,光纤插错地方,有WWPN,随便插)但是如果hba卡坏掉了就需要更换。

3.别名来配置,维护起来相对比较简单明了。

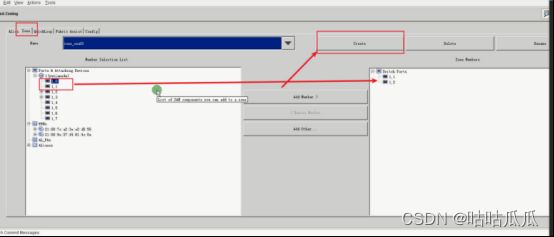

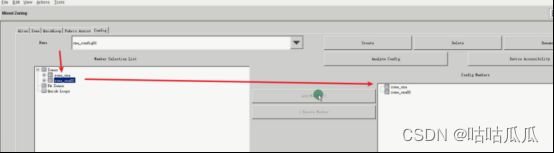

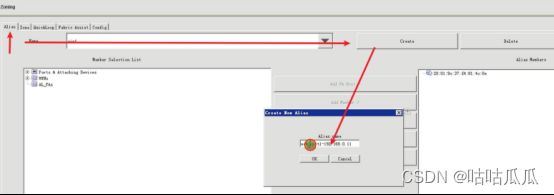

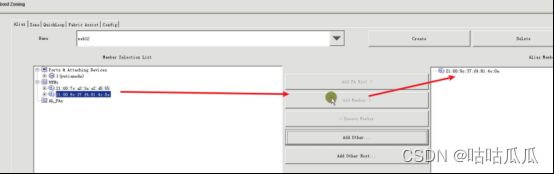

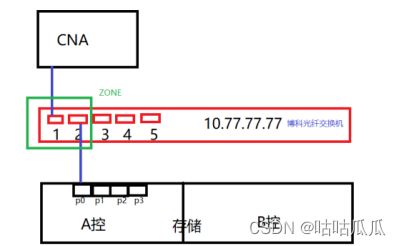

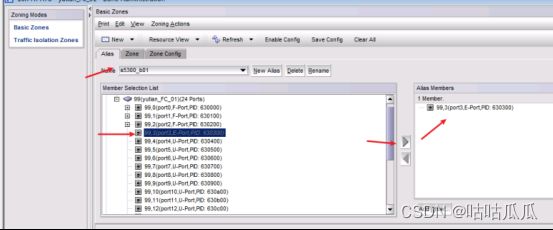

8.1.1 别名规划

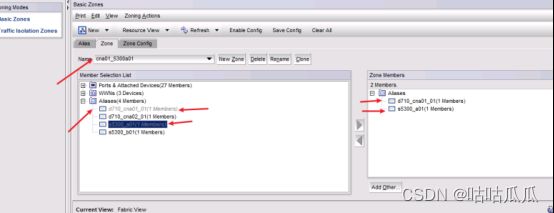

D710_cna01_01 99,0 CNA01主机HBA卡01口

D710_cna02_01 99,1 CNA02 主机HBA卡01 口

S5300_a01 99,2 存储A控01口

S5300_b01 99,3 存储B控01口

8.1.2 划分ZONE规划

Zone名称 组成端口

Cna01_5300a01 99,0 and 99,2

cna01_5300b01 99,0 and 99,3

Cna02_5300a01 99,1 and 99,2

Cna02_5300b01 99,1 and 99,3

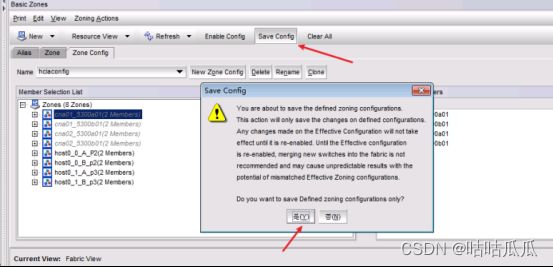

8.1.3 zone配置生效

可以规划多个config,但同一时间,只能有一个config生效。

可以提前规划好。

Zone进行隔离,不划分zone,有可能从这个,那个接口走,端口之间串联,划分zone,是必须从这个zone接口走存储流量的,所以,划分zone就是为了进行隔离。

主机能不能访问lun,取决于主机和lun在不在同一个zone里面,和lun映射没有关系。

如果不在同一个zone里面,即使把lun映射给主机,主机也无法访问到。

8.2 网络连接类型

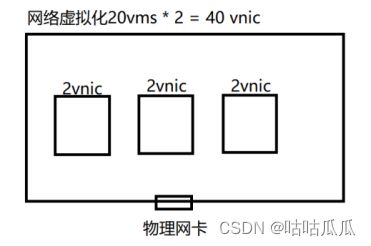

物理机世界,一个网卡,连一个网络

一台物理机里面有20台虚拟机,每个虚拟机2快vnic虚拟网卡,那么一共40个vinc,但只有1个物理网卡。

一个数据包进来后,丢给哪个虚拟机?如何进行虚拟机隔离呢?如何支撑业务访问呢?

单机虚拟化

Vmware,里面网络模式的区别及场景

桥接、NAT和仅主机

8.2.0 详解

https://blog.csdn.net/agonie201218/article/details/119921628

由于Linux目前很热门,越来越多的人在学习linux,但是买一台服务放家里来学习,实在是很浪费。那么如何解决这个问题?虚拟机软件是很好的选择,常用的虚拟机软件有vmware workstations和virtual box等。在使用虚拟机软件的时候,很多初学者都会遇到很多问题,而vmware的网络连接问题是大家遇到最多问题之一。在学习交流群里面,几乎每天都会有同学问到这些问题,写这篇详解也是因为群里童鞋网络出故障,然后在帮他解决的过程中,对自己的理解也做一个总结。接下来,我们就一起来探讨一下关于vmware workstations网络连接的三种模式。

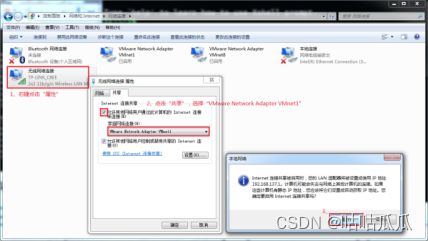

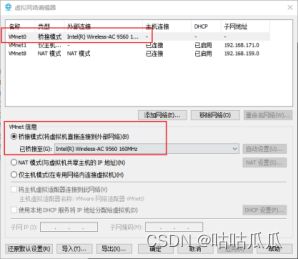

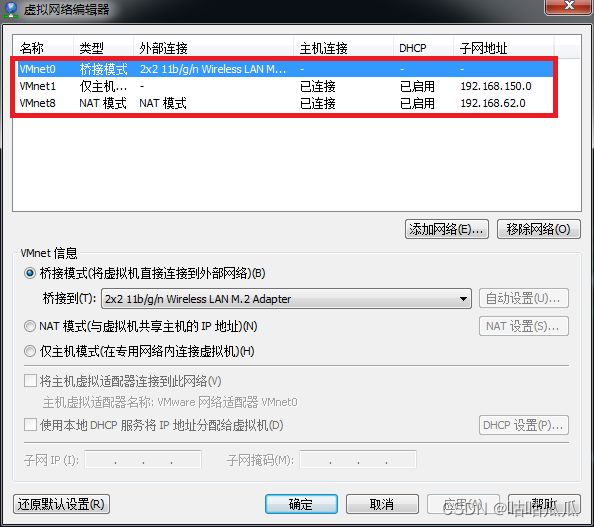

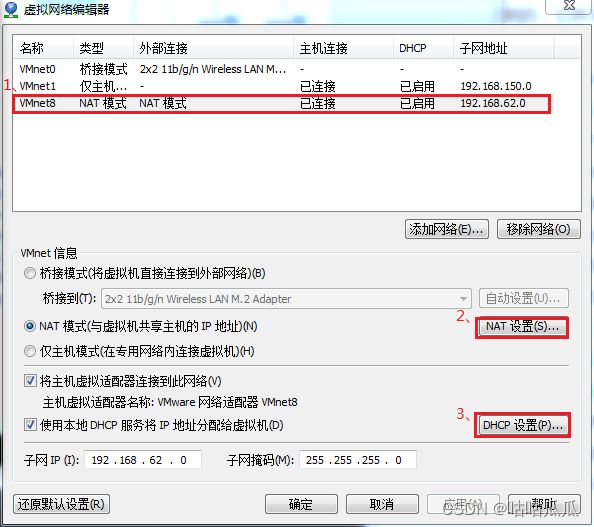

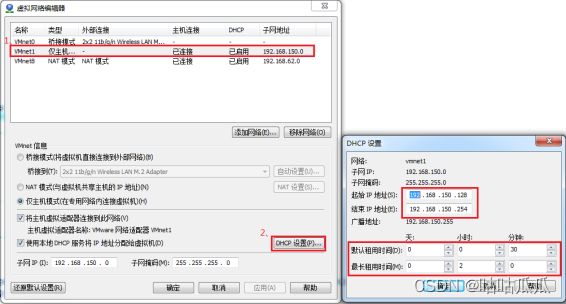

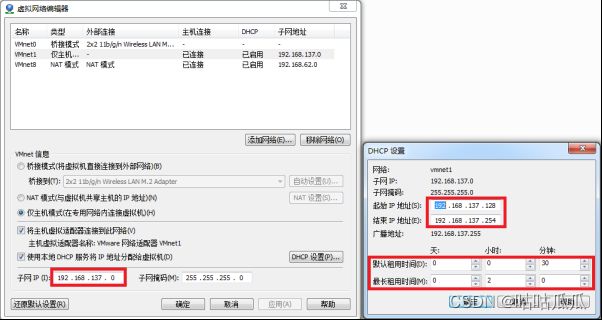

vmware为我们提供了三种网络工作模式,它们分别是:Bridged(桥接模式)、NAT(网络地址转换模式)、Host-Only(仅主机模式)。

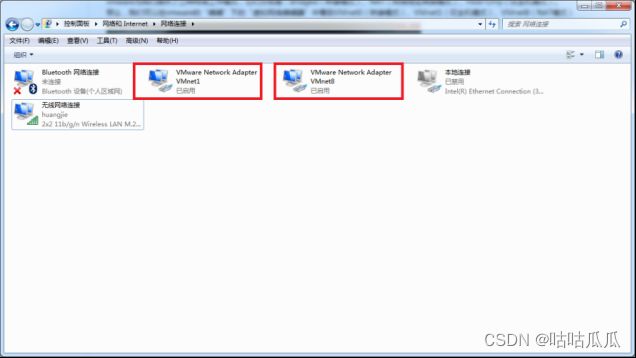

打开vmware虚拟机,我们可以在选项栏的“编辑”下的“虚拟网络编辑器”中看到VMnet0(桥接模式)、VMnet1(仅主机模式)、VMnet8(NAT模式),那么这些都是有什么作用呢?其实,我们现在看到的VMnet0表示的是用于桥接模式下的虚拟交换机;VMnet1表示的是用于仅主机模式下的虚拟交换机;VMnet8表示的是用于NAT模式下的虚拟交换机。

同时,在主机上对应的有VMware Network Adapter VMnet1和VMware Network Adapter VMnet8两块虚拟网卡,它们分别作用于仅主机模式与NAT模式下。在“网络连接”中我们可以看到这两块虚拟网卡,如果将这两块卸载了,可以在vmware的“编辑”下的“虚拟网络编辑器”中点击“还原默认设置”,可重新将虚拟网卡还原。

小伙伴看到这里,肯定有疑问,为什么在真机上没有VMware Network Adapter VMnet0虚拟网卡呢?那么接下来,我们就一起来看一下这是为什么。

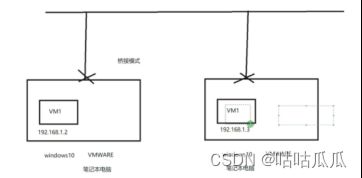

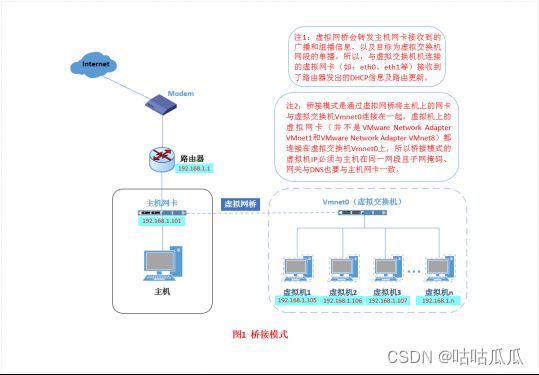

一、Bridged(桥接模式)

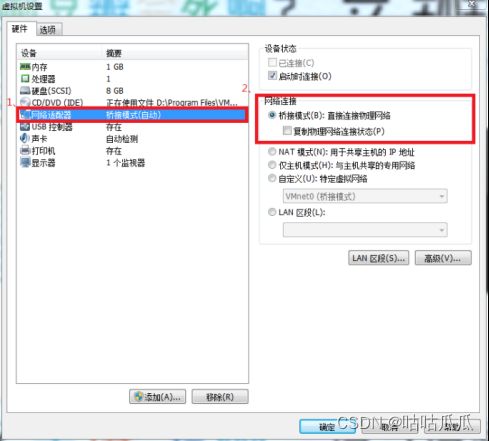

什么是桥接模式?桥接模式就是将主机网卡与虚拟机虚拟的网卡利用虚拟网桥进行通信。在桥接的作用下,类似于把物理主机虚拟为一个交换机,所有桥接设置的虚拟机连接到这个交换机的一个接口上,物理主机也同样插在这个交换机当中,所以所有桥接下的网卡与网卡都是交换模式的,相互可以访问而不干扰。在桥接模式下,虚拟机ip地址需要与主机在同一个网段,如果需要联网,则网关与DNS需要与主机网卡一致。其网络结构如下图所示:

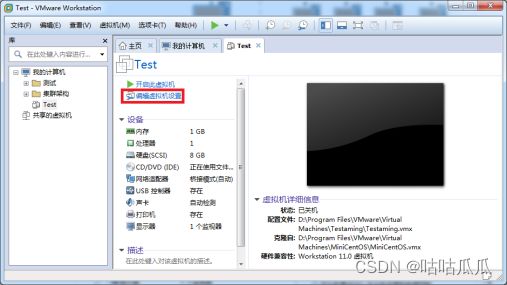

接下来,我们就来实际操作,如何设置桥接模式。

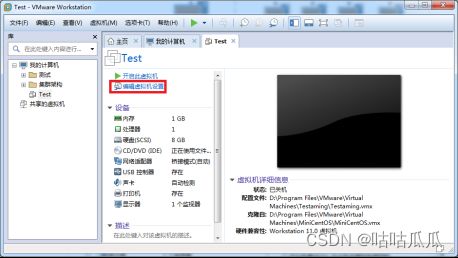

首先,安装完系统之后,在开启系统之前,点击“编辑虚拟机设置”来设置网卡模式。

在进入系统之前,我们先确认一下主机的ip地址、网关、DNS等信息。

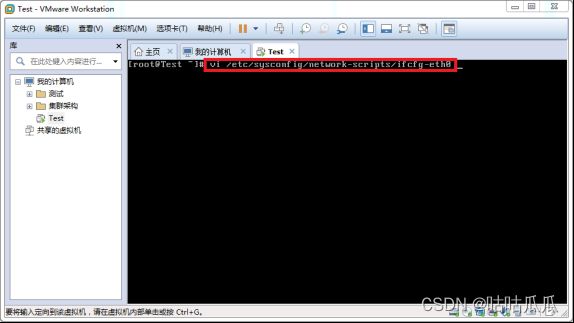

然后,进入系统编辑网卡配置文件,命令为vi /etc/sysconfig/network-scripts/ifcfg-eth0

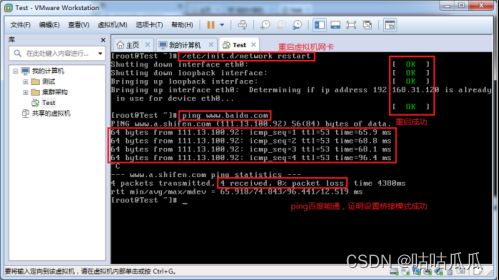

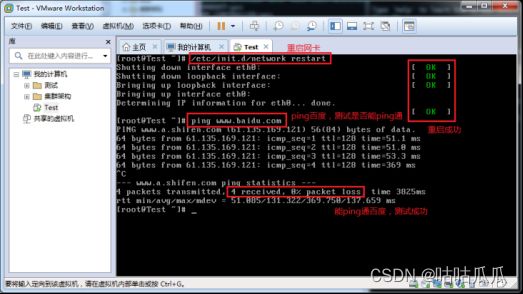

编辑完成,保存退出,然后重启虚拟机网卡,使用ping命令ping外网ip,测试能否联网。

能ping通外网ip,证明桥接模式设置成功。

那主机与虚拟机之间的通信是否正常呢?我们就用远程工具来测试一下。

主机与虚拟机通信正常。

这就是桥接模式的设置步骤,相信大家应该学会了如何去设置桥接模式了。桥接模式配置简单,但如果你的网络环境是ip资源很缺少或对ip管理比较严格的话,那桥接模式就不太适用了。如果真是这种情况的话,我们该如何解决呢?接下来,我们就来认识vmware的另一种网络模式:NAT模式。

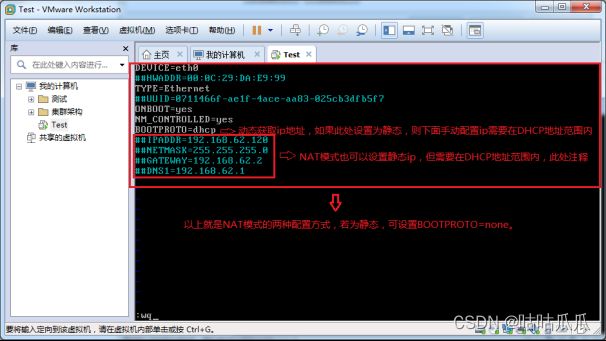

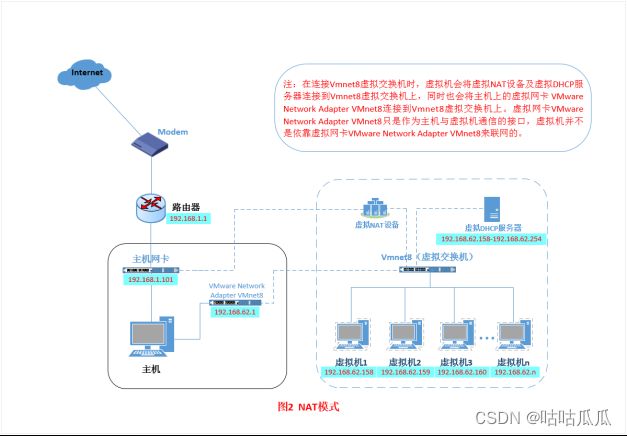

二、NAT(地址转换模式)

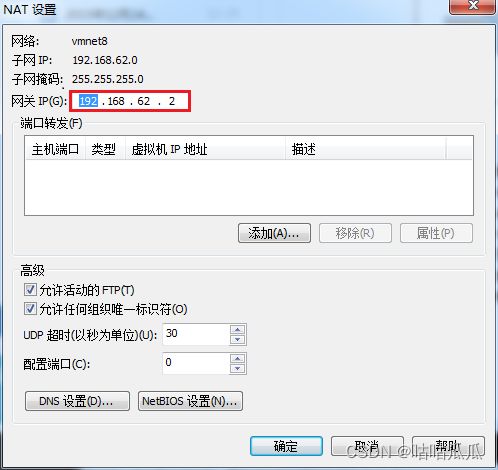

刚刚我们说到,如果你的网络ip资源紧缺,但是你又希望你的虚拟机能够联网,这时候NAT模式是最好的选择。NAT模式借助虚拟NAT设备和虚拟DHCP服务器,使得虚拟机可以联网。其网络结构如下图所示:

在NAT模式中,主机网卡直接与虚拟NAT设备相连,然后虚拟NAT设备与虚拟DHCP服务器一起连接在虚拟交换机VMnet8上,这样就实现了虚拟机联网。那么我们会觉得很奇怪,为什么需要虚拟网卡VMware Network Adapter VMnet8呢?原来我们的VMware Network Adapter VMnet8虚拟网卡主要是为了实现主机与虚拟机之间的通信。在之后的设置步骤中,我们可以加以验证。

首先,设置虚拟机中NAT模式的选项,打开vmware,点击“编辑”下的“虚拟网络编辑器”,设置NAT参数及DHCP参数。

![]()

将虚拟机的网络连接模式修改成NAT模式,点击“编辑虚拟机设置”。

点击“网络适配器”,选择“NAT模式”

![]()

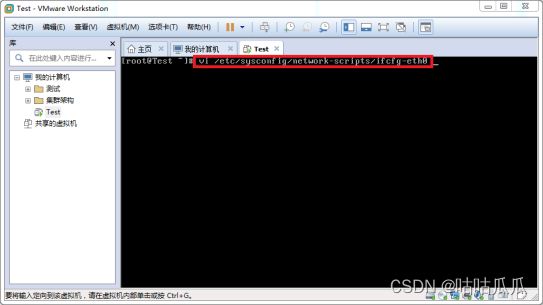

然后开机启动系统,编辑网卡配置文件,命令为vi /etc/sysconfig/network-scripts/ifcfg-eth0

编辑完成,保存退出,然后重启虚拟机网卡,动态获取ip地址,使用ping命令ping外网ip,测试能否联网。

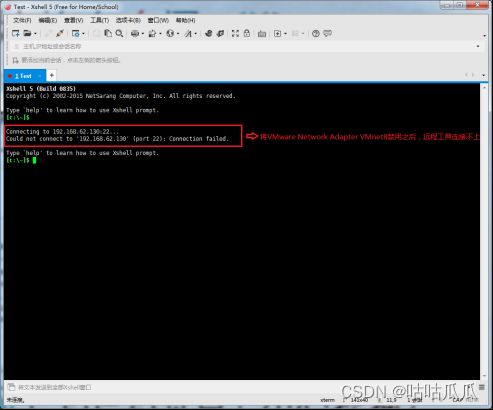

之前,我们说过VMware Network Adapter VMnet8虚拟网卡的作用,那我们现在就来测试一下。

如此看来,虚拟机能联通外网,确实不是通过VMware Network Adapter VMnet8虚拟网卡,那么为什么要有这块虚拟网卡呢?

之前我们就说VMware Network Adapter VMnet8的作用是主机与虚拟机之间的通信,接下来,我们就用远程连接工具来测试一下。

然后,将VMware Network Adapter VMnet8启用之后,发现远程工具可以连接上虚拟机了。

那么,这就是NAT模式,利用虚拟的NAT设备以及虚拟DHCP服务器来使虚拟机连接外网,而VMware Network Adapter VMnet8虚拟网卡是用来与虚拟机通信的。

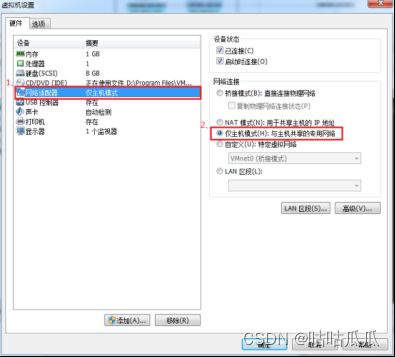

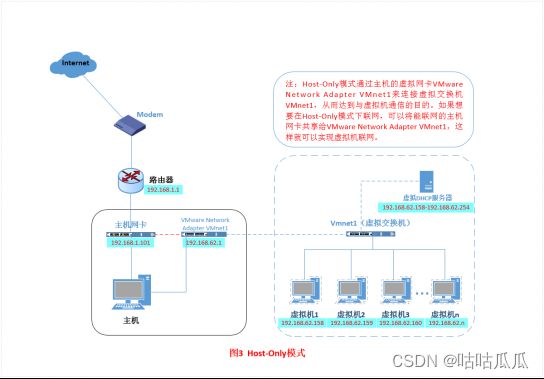

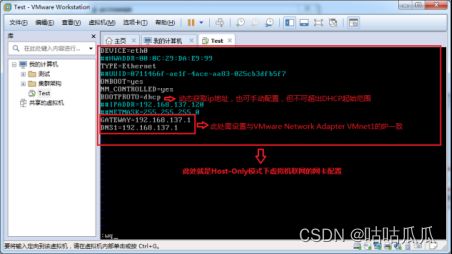

三、Host-Only(仅主机模式)

Host-Only模式其实就是NAT模式去除了虚拟NAT设备,然后使用VMware Network Adapter VMnet1虚拟网卡连接VMnet1虚拟交换机来与虚拟机通信的,Host-Only模式将虚拟机与外网隔开,使得虚拟机成为一个独立的系统,只与主机相互通讯。其网络结构如下图所示:

通过上图,我们可以发现,如果要使得虚拟机能联网,我们可以将主机网卡共享给VMware Network Adapter VMnet1网卡,从而达到虚拟机联网的目的。接下来,我们就来测试一下。

首先设置“虚拟网络编辑器”,可以设置DHCP的起始范围。

我们可以看到上图有一个提示,强制将VMware Network Adapter VMnet1的ip设置成192.168.137.1,那么接下来,我们就要将虚拟机的DHCP的子网和起始地址进行修改,点击“虚拟网络编辑器”

重新配置网卡,将VMware Network Adapter VMnet1虚拟网卡作为虚拟机的路由。

重启网卡,然后通过 远程工具测试能否联通外网以及与主机通信。

测试结果证明可以使得虚拟机连接外网。

以上就是关于vmware三种网络模式的工作原理及配置详解。

8.2.1 桥接模式

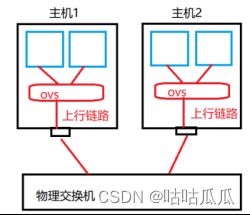

桥接模式:把所有虚拟机都桥接到虚拟交换机上。

在桥接的作用下,类似于把物理主机虚拟为一个交换机(内存里面),所有桥接设置的虚拟机连接到这个交换机的一个接口上,物理主机也同样插在这个交换机当中,所以所有桥接下的网卡与网卡都是交换模式的,相互可以访问而不干扰。

每个物理网卡都会对应一个上行链路;

每个上行链路都会对应一个虚拟交换机。OVS开源软件实现虚拟交换机。

在VMWare里面,这个ovs虚拟交换机叫:vmnet0。Ovs是在内存中的。所以vmnet0你在电脑上是看不到的。

流量走向,两台虚拟机交互,直接走ovs虚拟交换机,而不需要走物理交换机。

回顾下pvdrive,半虚拟化驱动virtio。

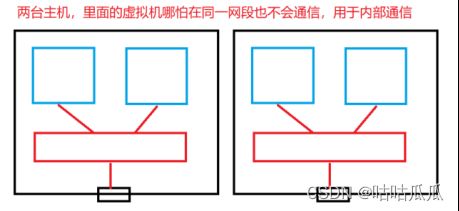

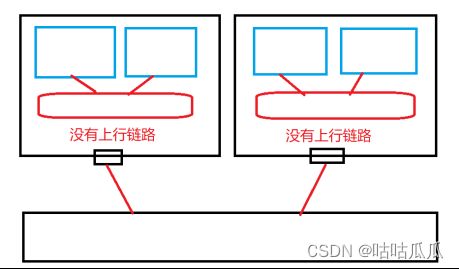

8.2.2 仅主机模式host-only

只做虚拟机的内部通信,Host-Only模式是出于安全考虑,Host-Only模式将虚拟机与外网隔开,使得虚拟机成为一个独立的系统,只与主机相互通讯。

应用场景

![]()

8.2.3 NAT模式

一般虚拟机上网,使用桥接模式配置简单,但如果你的网络环境是ip资源很缺少或对ip管理比较严格的话,那桥接模式就不太适用了,而我们又需要联网。

我们该如何解决呢?

我们需要用到vmware的另一种网络模式:NAT模式。

能出去,但是想回来,也需要配置nat转换。

使用wireshark抓包

如果不是DHCP分发网络,那么网络就不是vmnet8的子网,就不会通过该子网的网关出去。所以无法上网。

8.2.4 自定义网络

如果虚拟机很多,那么固定的虚拟交换机压力比较大,所以可以自定义

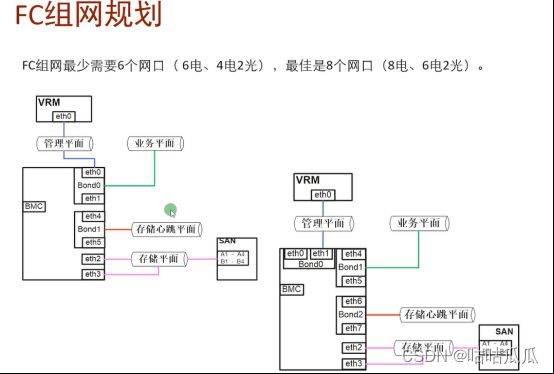

8.3 FC的网络平面

Fusioncompute 5个网络平面8块网卡

一个物理机CNA,8张网卡(全部电口,也可6电2光)

BMC接口(不会作为主要网络平面来),带上BMC一共5个网络平面。

8.3.1 管理网络平面

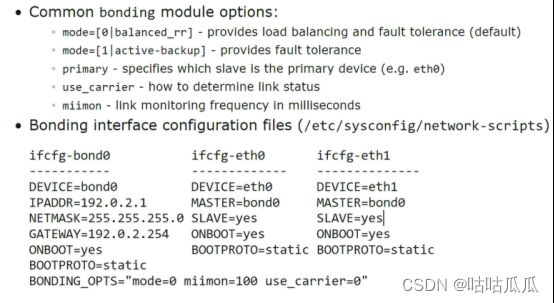

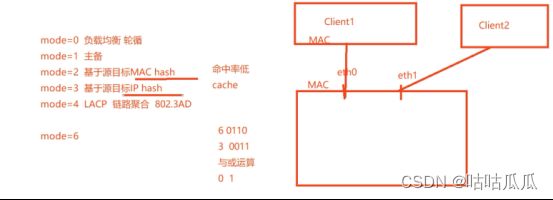

1.VRM管理CNA的网络平面,每个平面两个网卡,为了冗余和负载均衡。

0 和 6 的区别:都是负载均衡,0是轮询,6是负载均衡。

1是主备,4 是链路聚合协议。

VRM和CNA管理网络,VRM监控CNA之间心跳,实现HA迁移。

那么两个集群能否共享同一个存储,可以的。为什么可以?不怕脑裂?

存储-在关联主机的时候,多个集群也可以共享一个存储。因为在同一套VRM里面。

CNA修改ip地址和主机名: hostconfig

8.3.2 存储网络平面

添加逻辑接口,以及主机添加多个网口。

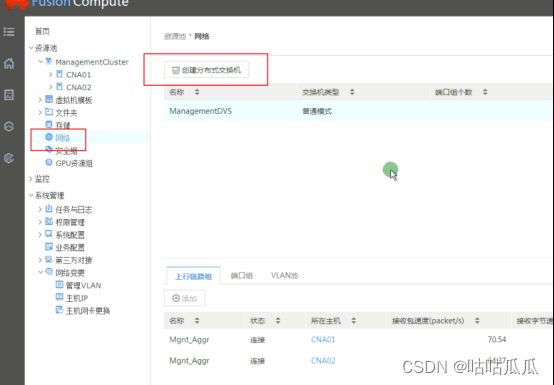

8.3.3 业务网络平面(重点)

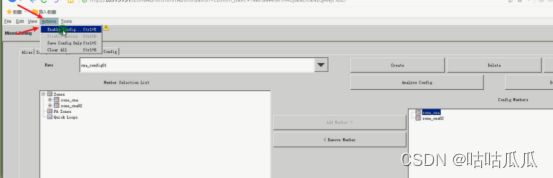

原理:

1.创建分布式交换机,普通模式,上行链路,vlan池

2.在DVS中添加端口组,指定vlan

3.创建虚拟机,选择对应的端口组

还可以对端口组进行限速

分布式交换机

CNA配置一个ovs,10台CNA,每台都需要配置ovs,端口组

分布式,一次性帮你把10台CNA都创建完成,可以共用。比如虚拟机之前绑定的是product端口组,万一迁移到另外一台CNA主机,而恰好这台CNA主机上没有这个端口组。

那么就会迁移失败。(为了避免这个问题,就开发出了分布式交换机,统一配置)

那么虚拟交换机可以这样创建,为什么主机网络不可以呢?

是因为,管理网络,和存储网络逻辑接口是绑定好的ip地址,唯一固定的,没有办法批量。

那分布式虚拟交换机为什么不用配置ip?

是因为,管理网络和存储网络,都是针对CNA主机的。

而业务网络,是针对虚拟机的,ip由单个虚拟机自己来配置的。

存储网络和管理网络 是给CNA用的

业务网络是给 VM用的。

两台虚拟机是否可以通??可以,因为直连。业务网络默认走桥接。

能不能走hostonly,仅主机?不勾选 添加上行链路即可。

8.3.4 VIMS心跳网络、迁移网络

默认情况下,vm1从CNA01迁移到CNA02,使用的是VRM的管理网络。也是心跳网络、也是迁移网络。

这时候迁移的是什么?迁移的是内存,而且是热迁移,不关机,内存通过网络来迁移。

VRM假如断开了。。。故障了。

虚拟机是否可以正常访问。开机的是可以的。

如果vrm故障,CNA也故障,这时候无法实现HA。

这里的添加业务管理接口,不是业务网络的意思。业务网络在下面的“网络”里面。

VIMS心跳网络主要是保护存储的。因为万一VRM故障,没有人负责监控,没有心跳,就会导致脑裂,导致数据损坏。

(1)VIMS分布式锁

一个VIMS卷同时被多个CNA节点挂载,因此每个CNA节点都可以访问VIMS卷上的文件。为保证多节点读写同一文件的数据一致性,VIMS需要实现分布式文件锁。VIMS的DLM(Distribute lock manager)模块负责实现分布式文件锁,它提供集群概念上的锁服务,调用者通过DLM保证集群间的同步要求。

VIMS采用分布式全对称锁机制。在VIMS中有多个资源管理者(master),每个master只对应一个锁资源。不同的master并不会集中在同一个节点上,无管理中心节点。

正常情况下成为某个锁资源的master方式有两种:

第一个申请访问某资源的节点

如果多节点同时访问某资源,以VIMS节点号较小的节点作为master

当节点发生故障时,此节点负责管理的资源会重新选举出master。

(2)VIMS心跳

VIMS存在两种心跳,磁盘心跳用于检测主机是否可以正常读写共享存储,网络心跳用于检测主机间网络通信是否正常。作为集群文件系统,挂载了VIMS卷的CNA节点从来都不是单独的个体,作为集群节点成员之一,通过网络心跳确保与其它节点进行正常的网络通信。

6个口,管理平面和业务平面可以放在一起。

因为管理平面流量比较小。可以复用。

8.3.5 BMC网络平面

Bmc平面一定是独立的。

有人问:能够把管理网络和bmc网络放在一起?不可以,bmc一定是独立的。

所有网络都可以连接到同一台交换机上(建议把存储的单独分离出来)

8.3.6 安全组概念(防火墙)

添加绑定安全组即可。

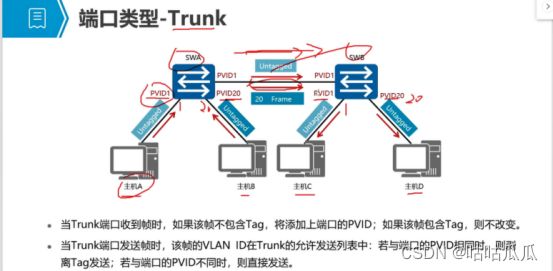

8.3.7 交换机类型-高级特性

![]()

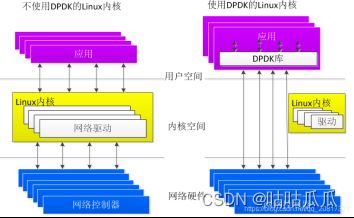

DPDK:用户态交换模式,只有特定的几款英特尔的交换机支持,提升性能。

如图:DPDK绕过了Linux内核的网络驱动模块,直接从网络硬件到达用户空间,不需要进行频繁的内存拷贝和系统调用。

SR-IOV:Single Root I/O Virtualization 网卡必须支持这个模式。

正常网卡,要经过VMM的,类似于网卡的硬件辅助虚拟化。

绕过VMM层,硬件直通给虚拟机使用,不需要经过vmm的开销,性能提升。

也有缺点:就是虚拟机无法进行热迁移。

支持大帧:MTU最大传输单元(Maximum Transmission Unit,MTU)用来通知对方所能接受数据服务单元的最大尺寸,说明发送方能够接受的有效载荷大小。 [1]

以太网和802.3对数据帧的长度都有一个限制,其最大值分别是1500字节和1492字节。

支持最大提升到 9000字节,也叫巨帧。当然,也需要对应的交换机支持。

添加端口组中:中继 是干啥的?虚拟机中创建虚拟机。。。。把外面虚拟机打上trunk,放行里面虚拟机的vlan端口。一般不用。

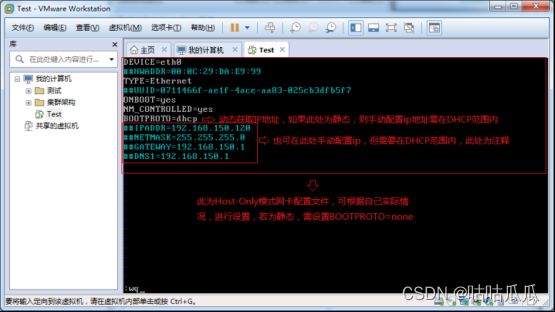

DHCP隔离:

了解下DHCP原理

1.当客户端获取ip,DHCP的discovery 255.255.255.255 全网广播:谁是dhcp

2.DHCPoffer 只要是dhcp就会回应:我就是dhcp,我有地址池

3.客户端DHCPrequest请求一个ip地址呢

4.Dhcpack 确认

如果一个局域网配置了两个dhcp服务器,这时候可能会冲突了。所以可以进行隔离。

![]()

打上勾,哪怕端口组做了dhcp,也不会响应。

IP与MAC绑定:为了安全,防止ARP网络欺骗攻击

TCP校验:安全

越低的越大。

广播抑制:有人中毒后,不停广播,瘫痪网络,可以进行限制。

这些是在虚拟交换机上设置的。一般是在物理交换机上设置。

—以下为旧版笔记—

7.0.1 旧(根据端口)光纤交换机划分ZONE

Admin

Password

添加过来的zone才生效

Zone可以有多个,config也可以有多个,但同时只能有一个config生效。

可以提前把ZONE规划好。创建config,创建多套方案。灵活性比较大。

交换机默认配置:全通,全不通。NO access,all access

如何划分ZONE??

大ZONE和小ZONE

小的更安全,但规划起来极其麻烦。

大的规划起来非常简单。

划在一个zone里面,CNA01和CNA02 不会通,因为他们是连接存储SAN网络的。,他们通是通过 管理网络来通的。而不是通过存储网络。

因为主机有 发起端 和 接受端。

缺点:

根据端口划分,万一捋线差错,就会出问题。

7.0.2 旧(根据WWPN)来划分ZONE

Wwpn:全球唯一端口号

WWN: world wide number 是硬件的全球唯一标示

WWPN: world wide port number 是指端口号

WWNN: world wide node number 是指节点号

WWPN

World Wide Port Name, 是对于FC HBA卡上的一个端口的全球唯一标识符,它相当于网卡中的MAC地址,全球只有唯一一个。

WWNN

World Wide Node Name, 是对于每一个节点(终端或者设备)的全球唯一标示符。

根据以上的描述

对于单口的FC HBA来说,它应该只有一个WWNN和一个WWPN

对于双口的FC HBA来说,它应该只有一个WWNN和和两个WWPN

对于FC交换机来说,它应该只有一个WWNN,每一个接口对应一个WWPN。

不管插线如何变更,都没有关系,属于硬件绑定。

缺点:第一次非常麻烦。如果光纤卡更换了,需要重新划分。

7.0.3 旧alias

查看wwpn和别名对应上。

每个光口都有WWPN号:全球唯一端口号

为了方便管理,可以把不同交换机的端口划在同一个zone里面。

另外,如果一个16口不够用,也需要级联。级联需要授权。

配置ip,划分ZONE,调整端口类型等。

快速方法查看wwpn?在操作系统里面就可以看。

在linux里面,查下面文件:

配置zone,也可以通过命令行。

大小zone,职业素养问题,作为工程师尽量去做好。

一块网卡,虚拟出20块网卡

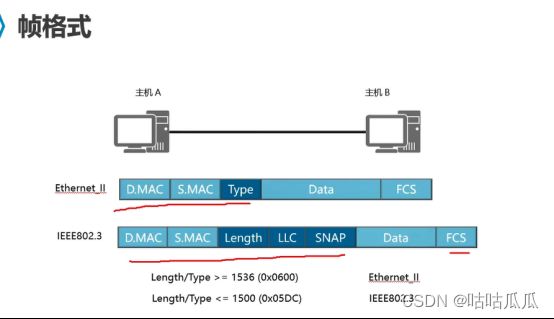

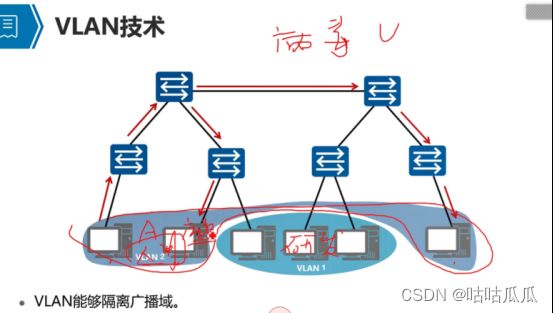

7.1 —VLAN技术-个人学习,适度讲解—

集线器(缺点,引出交换机)-交换机(引出数据包)-数据包(泛洪缺点,引出VLan)-VLan

集线器是半双工模式:必须是单项的。A-B,或者B-A,同一时间 两个端口不能同时收发数据,并且两个端口通信时,其他端口不能工作。

解决什么问题?主机过多,数据泛洪后,消耗很多cpu资源,而且不安全。通过vlan可以进行资源隔离。

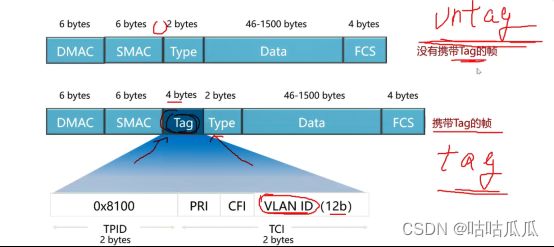

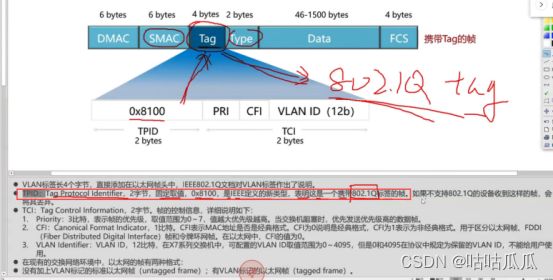

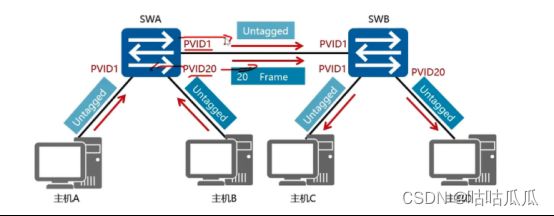

不管是802.3还是以太网II型,都没有携带vlan标签。

数据帧不一定都携带tag,叫untag

在数据帧里面嵌入tag标签。

Tag是4个字节的长度,里面包含12比特长度的vlan id,标识该数据帧属于哪个vlan。

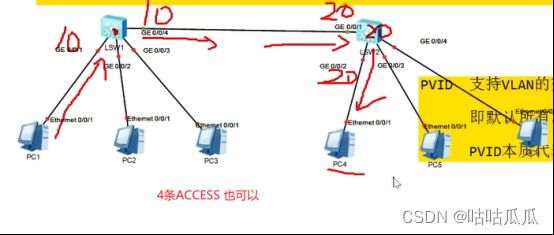

7.2 交换机端口的链路类型

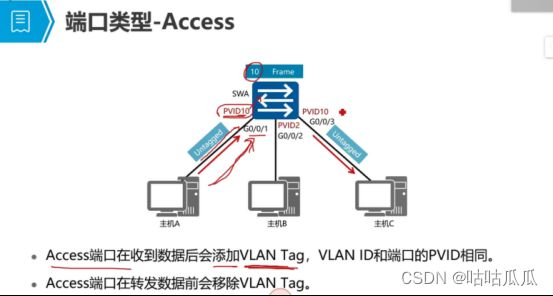

三种类型:ACCESS和Trunk,还有hibrid,如何灵活使用类型,前提对帧的处理方式的理解。

交换机端口的链路类型:决定了交换机对帧处理的方式。

Access:一般用于连接终端设备(PC、打印机)能不能连防火墙?路由器?灵活配置,不是限制死的。

Trunk:一般用于连接交换机之间的链路,时而也可以连接服务器、防火墙、路由器等。

Hybrid:和trunk一样,主要是对帧的处理方式。??

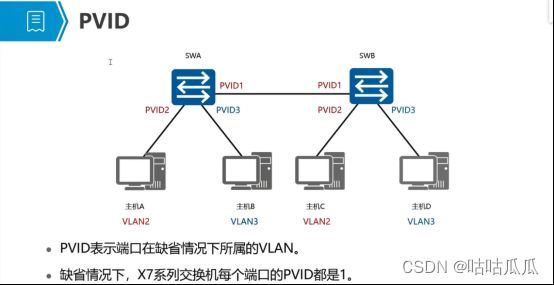

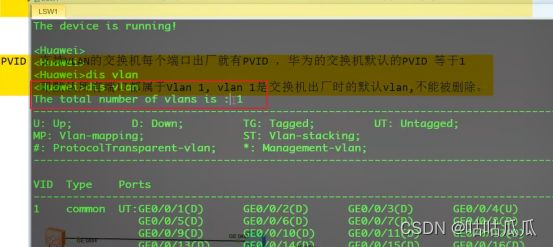

7.3 PVID

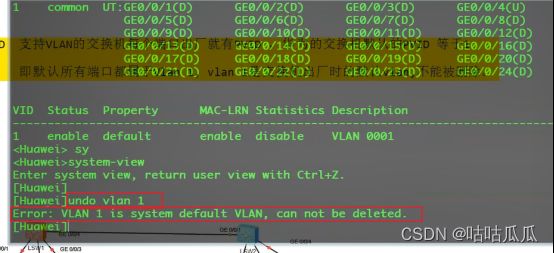

交换机(支持vlan)的每个端口出厂就有PVID,华为交换机默认的PVID=1.所以默认端口都是VLAN1,不能被删除。

(有些可以删,比如D-LINK)

如何查看PVID??Display interface g0/0/1

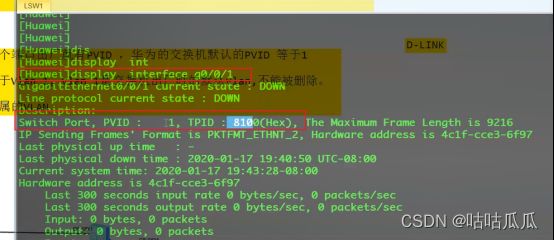

7.4 ACCESS端口类型

原理:数据帧传给 交换机,交换机根据这个端口默认的PVID,打上VLAN标签,然后转发给同样PVID的端口,然后发送给客户端时候,再重新去除VLAN标签。

那,会不会存在,access收到的数据帧本身就包含了tag的标签呢?那如何处理??超纲

如果本身含有tag,判断tag和PVID是否相同,相同则接收,不同则丢弃。

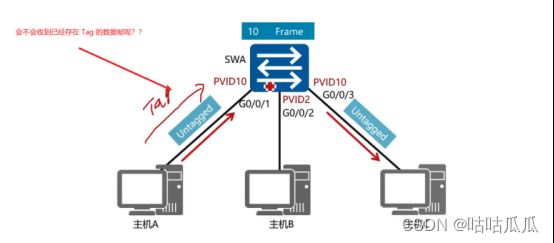

7.5 TRUNK端口类型

干道,用于实现不同交换机上的相同VLAN相互交互。Vlan穿透

二层通信:实现同网段通信。干道不能实现路由功能,只能二层通信。

三层通信:不同网段,路由。

华为交换机默认只放行VLAN1

目的就是可以按照要求能通即可。

7.6 Hibrid端口类型

特殊的TRUNK类型,trunk:如果tag和PVID相同,一定剥离;如果tag和PVID不同,一定保留发出去。

而Hibrid,灵活按需,给管理员自由选择。发送行为由管理员来管理,tag的保留。如果tag和PVID相同,可选择保留,可选择剥离。

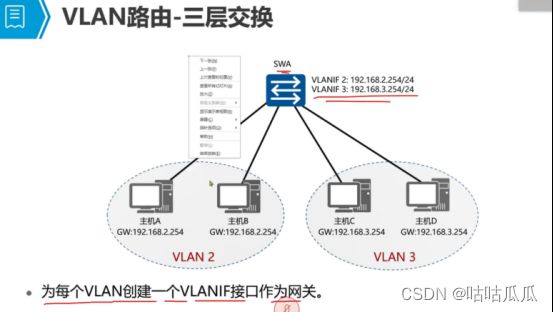

什么是vlanif

VLANIF(Virtual Local Area Network Interface),是华为交换机的一个配置项,应用于三层交换机。这是一种逻辑接口,物理上不存在。

方法/步骤

1

在配置好二层vlan后,三层交换机上使用vlanif命令建立对应vlan的路由,配置完成后,可以实现VLAN之间的通信。

2

interface Vlanif <1-4094> (VLAN interface number)

ip address IP地址 子网掩码

示例:

[SW1]interface vlanif 10

[SW1-vlanif10]ip address 192.168.1.254 24

[SW1-vlanif10]quit

Vlanif

能配vlanif的设备通常是三层交换机。

要理解vlanif的IP地址,在了解TCP/IP协议体系的前提下,还需要理解如下几个概念。

二层,VLAN,交换机,三层,路由器,三层交换机。

二层转发对应的设备是交换机,交换机对广播报文是全域转发,就是所有端口都会转发广播报文,广播报文过多显然会考验交换机的性能,还造成带宽资源的浪费。

为了低成本的解决这个问题,业界提出VLAN概念,在一个交换机上,通过划分不同的VLAN隔离广播域,即一个VLAN的广播只能在该VLAN内转发。这样也不需要增加新的交换机。

那不同VLAN之间的报文怎么转发呢?可以通过三层设备转发,比如路由器。

但路由器有两个问题,一是端口通常没有交换机多,二是成本要高于交换机。

所以业界又搞出了三层交换机的产品,兼具二层转发与三层转发的功能,一举规避了路由器存在的两个问题。同一个VLAN的报文可以通过三层交换机进行二层转发,不同VLAN之间的报文可以通过三层交换机进行三层转发。

三层交换机进行三层转发的关键就是在每个VLAN基础上虚拟出一个vlanif接口,并配上IP,从而实现三层转发。这就是vlanif下配IP地址的用处。

增加部分

1如何解锁FC的admin账号

fusioncompute登录的时候,如果密码输入次数过多会被锁定,导致界面无法登录,下面我就教大家如果在底层去解锁admin账号。

第一步:ssh登录到主VRM,切换到root账号下。

第二步:进入/opt/galax/vrm/tomcat/script/omsconfig/bin 目录下执行命令:sh resetSystemManageUser.sh unlock

第三步:执行完毕后重启一下浏览器重新登录就可以。

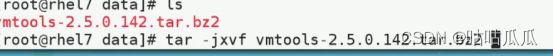

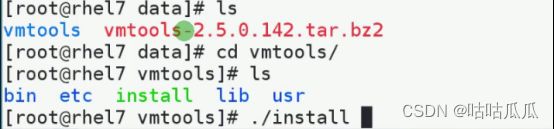

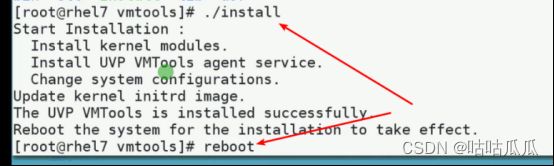

2如何确定虚拟机中是否安装了VMTools

1、 Linux虚拟机如何判断虚拟机中是否安装了VMTools

1.1 登录虚拟机内部,执行如下命令:

cat /etc/.vmtools/version.ini

如果有该文件,并且有类似如下的回显信息,则说明安装了VMTools工具。反之,则未安装。

其中vmtoolsVersion即为VMTools的版本号,kernelVersion为虚拟机对应的内核版本号。

1.2 执行如下命令,来确认vmtools是否运行正常:

ps -ef | grep vm-agent

如果有类似如下的回显信息,说明VMTools运行正常,反之,则说明VMTools未正常运行。

2、Windows虚拟机如何判断虚拟机中是否安装了VMTools

登录虚拟机内部,查看任务栏中,是否存在“M”的黄色图标

如果存在,说明已经安装了VMTools。反之,则未安装。

3什么是S3

Amazon Simple Storage Service (简称 Amazon S3) 是一个公开的云存储服务,Web 应用程序开发人员可以使用它存储数字资产,包括图片、视频、音乐和文档。S3 提供一个 RESTful API 以编程方式实现与该服务的交互。目前市面上主流的存储厂商都支持S3协议接口,比如华为、华三、戴尔、元核云等