- 22、JavaScript学习笔记——ES5严格模式

lvh98

javascript学习前端

ES5严格模式当前使用的ES语法是基于ES3.0的方法加上ES5.0的新增方法。默认情况下,ES3.0和ES5.0冲突的部分,会沿用ES3.0的方法;而在ES5.0严格模式下,冲突部分会使用ES5.0的方法。1.“usestrict”不再兼容ES3.0的一些不规则语法。使用全新的ES5.0规范。1.1ES5.0严格模式的启动要选择使用严格模式,需要使用严格模式编译指示(pragma),即一个不赋值

- 《JS教程》笔记:一、JavaScript编程语言——2.3现代模式use strict(严格模式、旧模式)

Dontla

javascriptjavascript笔记开发语言

现代JavaScript教程中文版现代JavaScript教程文章目录现代模式,"usestrict""usestrict"确保\"usestrict\"出现在最顶部没有办法取消`usestrict`浏览器控制台默认不启动`usestrict`是否应该显式声明"usestrict"?(非必须,有办法自动启用)现代模式,“usestrict”长久以来,JavaScript不断向前发展且并未带来任何兼

- spring mvc java 8 rest idea_springmvc学习笔记---面向移动端支持REST API

射命丸咲

springmvcjava8restidea

前言:springmvc对注解的支持非常灵活和飘逸,也得web编程少了以往很大一坨配置项.另一方面移动互联网的到来,使得RESTAPI变得流行,甚至成为主流.因此我们来关注下springmvc对restapi的支持程度,以及需要做的工作评估.样例设计和准备:springmvc学习笔记系列的文章目录:•idea创建springmvc项目RESTAPI的设计原则遵循之前的博文来实现•移动互联网实战--

- Spark Streaming的背压机制的原理与实现代码及分析

weixin_30777913

spark大数据python

SparkStreaming的背压机制是一种根据JobScheduler反馈的作业执行信息来动态调整Receiver数据接收率的机制。在Spark1.5.0及以上版本中,可以通过设置spark.streaming.backpressure.enabled为true来启用背压机制。当启用背压机制时,SparkStreaming会自动根据系统的处理能力来调整数据的输入速率,从而在流量高峰时保证最大的吞

- HDFS读写流程(全面深入理解)

AnAn-66.

hadoophdfs面试hadoop

1、HDFS写流程 (1)客户端通过对FileSystem.create()对象创建建文件,DistributedFileSystem会创建输出流FSDataOutputStream。 (2)DistributedFileSystem通过RPC远程调用名称节点,在文件系统的命名空间中创建一个新的文件,此时该文件中还没有相应的数据块。 (3)名称节会执行一些检查,比如文件是否已经存在、客户端是

- HDFS的读写流程

熊與猫v

大数据hadoopbigdata

一,HDFS的读写流程1.hdfs的写入流程文上传流程如下:创建文件:①HDFSclient向HDFS写入数据,先调用DistributedFileSystem.create()②RPC调用namenode的create(),会在HDFS目录树中指定的路径,添加新文件;并将操作记录在edits.log中namenode.create()方法执行完后,返回一个FSDataOutputStream,它

- HDFS的读写流程步骤(附图文解析)

m0_67265464

面试学习路线阿里巴巴hdfshadoop大数据面试intellij-idea

1、HDFS的写入流程:详细步骤:client发起文件上传请求,通过RPC与NameNode建立通讯,NameNode检查目标文件是否已存在,父目录是否存在,返回是否可以上传;client请求第一个block该传输到哪些DataNode服务器上;NameNode根据配置文件中指定的备份数量及副本放置策略进行文件分配,返回可用的DataNode的地址,如:A,B,C;client请求3台DataNo

- Spring MVC学习笔记

万般滋味皆生活

后端开发springspringmvc

文章目录SpringMVC什么是MVC设计模式?SpringMVC的核心组件SpringMVC的工作流程如何使用?SpringMVC注解SpringMVC数据绑定SpringMVC模型数据解析SpringMVC自定义数据转换器SpringMVCREST特点如何使用SpringMVC文件上传下载SpringMVC表单标签库常用的表单标签SpringMVC数据校验SpringMVCSpringMVC是

- HDFS安全模式

哒啵Q297

hdfshadoop大数据

当hdfs集群启动的时候,由于要做很多的事情,这期间集群进入了安全模式离开安全模式的条件:NameNode启动后会进入一个称为安全模式的特殊状态。处于安全模式的NameNode对于客户端来说是只读的。NameNode从所有的DataNode接收心跳信号和块状态报告(blockreport)每个数据块都有一个指定的最小副本数(dfs.replication.min),当NameNode检测确认某个数

- spring mvc 创建restapi 笔记

weixin_42277889

springmvc笔记

@RestController@RequestMapping("/spittles")publicclassSpittleController{//示例:使用@RequestBody接收JSON并自动转换为Spittle对象@PostMappingpublicSpittlesaveSpittle(@RequestBodySpittlespittle){//此时Spring已经把请求体中的JSON/

- 使用vue-pdf 给pdf加水印

从此苏州|更江南

vue.jsjavascript前端

上一页下一页{{pageNum}}/{{totalPages}}importpdffrom'vue-pdf'exportdefault{name:"SHOWRESULTS",components:{pdf},data(){return{pageNum:1,//显示第一页loadedRatio:0,//当前页面的加载进度,范围是0-1,等于1的时候代表当前页已经完全加载完成了totalPages:1

- 使用scikit-learn中的KNN包实现对鸢尾花数据集或者自定义数据集的的预测。

Jam-Young

scikit-learnpython信息可视化

使用scikit-learn中的KNN包实现对鸢尾花数据集或者自定义数据集的的预测。#导入鸢尾花数据集fromsklearn.datasetsimportload_iris,fetch_20newsgroups#数据化可视包importseabornassnsimportmatplotlib.pyplotaspltimportpandasaspdfromsklearn.model_selectio

- React应用深度优化与调试实战指南

python算法(魔法师版)

javascript开发语言ecmascriptreact.js前端

一、渲染性能优化进阶1.1精细化渲染控制typescript复制//components/HeavyComponent.tsximportReact,{memo,useMemo}from'react';interfaceItem{id:string;complexData:{//复杂嵌套结构};}constHeavyComponent=memo(({items}:{items:Item[]})=>

- Verilog系统函数实现单精度float、双精度doble浮点类型和整型之间互相转换

whik1194

XilinxFPGAZYNQverilogsystemverilog

标准verilog支持双精度double类型和十六进制64位数据相互转换,使用$realtobits和$bitstoreal系统函数使用示例://test_tb.v`timescale1ns/1psmoduletest_tb;realdata_real;reg[63:0]data_hex;initialbegindata_real=0;data_hex=0;data_real=1234.56789

- 联想开机按f2怎么修复系统图解_联想笔记本开机f2修复电脑步骤 - 卡饭网

非典型工科生

联想开机按f2怎么修复系统图解

Win7系统联想笔记本开机提示pxe-mof:exitingpxerom的原因及解决方法Win7系统联想笔记本开机提示pxe-mof:exitingpxerom的原因及解决方法Win7旗舰版系统的联想笔记本电脑每次开会都要显示:pxe-mof:exitingpxerom,这该怎么办?下面我们的小编给大家分享下解决方法.原因分析:出现该提示是笔记本电脑中开启了网卡启动导致的,Idea系列笔记本设置方

- mysql.sock.lock的作用_不能创建 mysql.sock.lock是怎么回事

0110君

15052003:26:57mysqld_safeStartingmysqlddaemonwithdatabasesfrom/usr/local/mysql/data2015-05-20T03:26:58.070269Z0[Warning]TIMESTAMPwithimplicitDEFAULTvalueisdeprecated.Pleaseuse--explicit_defaults_for_t

- 电脑键盘按键都代表着什么意思?

szkfp

F1F12通常称为功能键,其中F指的是Function功能的意思,说明F1F12是12个功能键。每一个电脑键盘标配都是顶端都有F1~F12一排按键。我估计全部掌握的人还真不算多,今天高手君就给大家普及一下F1~F12键在日常Windows系统中的功能和使用。注意,仅限台式机或者笔记本的外接键盘。(部分笔记本自带键盘F1~F12被赋予了其他功能,不再此文讨论之列)。F1:帮助键。当碰到一个程序或一个

- 备赛蓝桥杯之第十五届职业院校组省赛第三题:产品360度展示

云端·目前学前端

备赛蓝桥杯蓝桥杯职场和发展

提示:本篇文章仅仅是作者自己目前在备赛蓝桥杯中,自己学习与刷题的学习笔记,写的不好,欢迎大家批评与建议由于个别题目代码量与题目量偏大,请大家自己去蓝桥杯官网【连接高校和企业-蓝桥云课】去寻找原题,在这里只提供部分原题代码本题目为:2024年十五届省赛职业院校组真题第三题:产品360度展示题目:需要考生作答的代码段如下:/***@param{*}initialValue初始值*@param{Arra

- GraphQL扩展语言GraphQXL常见问题解决方案

祝晋遥

GraphQL扩展语言GraphQXL常见问题解决方案graphqxlGraphQXLisanewlanguagebuiltontopoftheGraphQLsyntaxthatextendstheoriginallanguagewithsomeadditionalfeaturesusefulforcreatingscalableandbigserversideschemas.Thisreposi

- 正则表达式超全笔记!!这一篇就够了!!

灿灿不会秃头

js正则表达式

欢迎各位大神批评指点!!!!正则表达式1.什么是正则表达式(规则表达式)1.1正则是一种规则1.2正则是一种字符串1.3校验、检索、替换等那些符合某个模式(规则)的文本设想:想要匹配输入是数据是否是一串手机号1.长度2.校验是否是数字3.前三位必须是手机137138152172//----------------传统方法校验----------------------//length===11电话

- skynet

吓人的鸟

编程语言-c/c++编程语言-luaskynetcluagameserver

https://github.com/cloudwu/skynet电商不是有C2BB2CC2C这些个概念么,互动百科的CEO甚至还对抄袭美其名曰:COPYTOCHINA(C2C)。鸟人今天也为C2B赋予新意:COPYTOBLOG。哈哈研究skynet的朋友请移步云风的博客,我这里纯属抄袭下来做标记笔记用的,因为个人阅读习惯如此。http://blog.codingnow.com/2012/08/s

- 【笔记】从华为云看4P理论的卓越践行者

通信_楠木

笔记华为云系统架构用户运营产品运营产品经理

在当今竞争激烈的云计算市场中,华为云犹如一颗明星取得了令人瞩目的成绩。其成功的背后,离不开对4P营销理论——产品(Product)、价格(Price)、渠道(Place)、促销(Promotion)的巧妙运用与深度融合。这一经典的营销理论框架,在华为云的市场战略布局中被赋予了新的活力与内涵,下面就结合最近的学习总结,让我们深入探究华为云是如何运用4P营销理论书写其辉煌篇章的。学习是一种愉悦,一种收

- 【学习笔记总结】华为云:应用上云后的安全规划及设计

通信_楠木

学习笔记华为云架构云计算安全架构

一、背景和问题数字化时代,随着信息技术的飞速发展,企业和各类组织纷纷将自身的应用程序迁移至云端。云计算凭借其诸多优势,如成本效益、可扩展性、灵活性以及便捷的资源共享等,已然成为了现代业务运营的重要支撑。今年,我所在企业也将IT系统全面迁移上XX云,究其原因是为了在激烈的市场竞争中保持敏捷性和创新性,需要快速部署新的应用并实现高效的数据处理,云平台提供的丰富资源和便捷的服务模式使其能够迅速满足这些需

- 802.15.4 LrWpanCsmaCa NS3代码2-入网、状态机切换和数据收发等流程

wenxin-

网络协议信息与通信NS3WPANCSMA/CA

802.15.4LrWpanCsmaCaNS3代码2-入网、状态机切换、时隙/非时隙版CSMACA和数据收发等流程文章目录一、入网流程二、数据收发流程2.1数据传输2.2状态机切换2.3发送和接收流程2.3.1发送处理:2.3.2接收处理:2.3.3数据收发时序图:2.3.4PdDataConfirm处理流程2.3.5PdDataIndication处理流程三、CSMA/CA流程一、入网流程信标使

- 青少年编程与数学 02-008 Pyhon语言编程基础 05课题、数据类型

明月看潮生

编程与数学第02阶段青少年编程开发语言python编程与数学数据类型

青少年编程与数学02-008Pyhon语言编程基础05课题、数据类型一、数据类型1.数字类型(NumericTypes)2.序列类型(SequenceTypes)3.集合类型(SetTypes)4.映射类型(MappingType)5.布尔类型(BooleanType)6.二进制数据类型(BinaryDataTypes)7.None类型类型转换二、Python与Go数据类型比较1.类型系统2.基本

- 1-structedStreaming-基本流程(2.3.1)

github_28583061

javaspark大数据mysqlhadoop

基本流程--spark2.3.1新定义接口--中间使用了一些过度接口为了兼容老版本如:BaseStreamingSourceDataSource为一个类,定义了可插拔的数据源,对应一些列旧的数据源DataSourceV2spark2.3.1新接口,只是一个接口,没有任何方法,需要配合ReadSupport或者WriteSupport接口等一起MicroBatchReadSupport--实现创建M

- 1-structedStreaming-基本流程(2.2.1)

github_28583061

javaspark大数据hadoophive

基本流程spark2.2.1StructuredNetworkWordCount统计来自socket的wordcount创建stream,指定数据源DataStreamReader--从外部存储加载流数据的接口lines=spark.readStream.format("socket").option("host",host).option("port",port).load()加载数据流为Dat

- C# EntityFramework 连接 MySQL

吃不胖的猫o(=^ェ^=)m

c#mysql

安装1.安装MySQL-connector-NET6.9.12.msi2.安装MySQL-for-visualstudio1.2.9.msi3.安装MySQL.Data(版本需要与MySQLConnector/NET相同):在VisualStudio的"程序包管理控制台"执行Install-PackageMySQL.Data6.9.124.安装MySql.Data.Entity(版本需要与MySQ

- 996引擎 - NPC-添加NPC引擎自带形象

笑虾

996引擎996引擎

996引擎-NPC-添加NPC引擎自带形象截图参考添加NPC参考资料截图参考添加NPC编辑NPC表:Envir\DATA\cfg_npclist.xls1.1.需要临时隐藏NPC时可以在id前加//1.2.如果NPC朝向不对,可以调整dir列。(按8方向,上是0顺时针数。我这里给的4)1.3.形象代码:NPC代码、怪物编号(官网好像显示不太正常,直接看:996M2引擎帮助文档.chm也行)1.4.

- Qt 智能指针详细介绍

zhaoyongCNSX

QtQt智能指针

1.Qt智能指针概述Qt提供了一套基于父子对象的内存管理机制,所以我们很少需要去手动delete.但程序中不一定所有类都是QObject的子类,这种情况下仍然需要使用一些智能指针.注意:在Qt中使用智能指针时,一定要避免发生多次析构.2.Qt中的智能指针分类根据不同的使用场景,可分为以下几种:共享数据.隐式或显式的共享数据(不共享指针),也被称为侵入式指针.QSharedDataPointer指向

- rust的指针作为函数返回值是直接传递,还是先销毁后创建?

wudixiaotie

返回值

这是我自己想到的问题,结果去知呼提问,还没等别人回答, 我自己就想到方法实验了。。

fn main() {

let mut a = 34;

println!("a's addr:{:p}", &a);

let p = &mut a;

println!("p's addr:{:p}", &a

- java编程思想 -- 数据的初始化

百合不是茶

java数据的初始化

1.使用构造器确保数据初始化

/*

*在ReckInitDemo类中创建Reck的对象

*/

public class ReckInitDemo {

public static void main(String[] args) {

//创建Reck对象

new Reck();

}

}

- [航天与宇宙]为什么发射和回收航天器有档期

comsci

地球的大气层中有一个时空屏蔽层,这个层次会不定时的出现,如果该时空屏蔽层出现,那么将导致外层空间进入的任何物体被摧毁,而从地面发射到太空的飞船也将被摧毁...

所以,航天发射和飞船回收都需要等待这个时空屏蔽层消失之后,再进行

&

- linux下批量替换文件内容

商人shang

linux替换

1、网络上现成的资料

格式: sed -i "s/查找字段/替换字段/g" `grep 查找字段 -rl 路径`

linux sed 批量替换多个文件中的字符串

sed -i "s/oldstring/newstring/g" `grep oldstring -rl yourdir`

例如:替换/home下所有文件中的www.admi

- 网页在线天气预报

oloz

天气预报

网页在线调用天气预报

<%@ page language="java" contentType="text/html; charset=utf-8"

pageEncoding="utf-8"%>

<!DOCTYPE html PUBLIC "-//W3C//DTD HTML 4.01 Transit

- SpringMVC和Struts2比较

杨白白

springMVC

1. 入口

spring mvc的入口是servlet,而struts2是filter(这里要指出,filter和servlet是不同的。以前认为filter是servlet的一种特殊),这样就导致了二者的机制不同,这里就牵涉到servlet和filter的区别了。

参见:http://blog.csdn.net/zs15932616453/article/details/8832343

2

- refuse copy, lazy girl!

小桔子

copy

妹妹坐船头啊啊啊啊!都打算一点点琢磨呢。文字编辑也写了基本功能了。。今天查资料,结果查到了人家写得完完整整的。我清楚的认识到:

1.那是我自己觉得写不出的高度

2.如果直接拿来用,很快就能解决问题

3.然后就是抄咩~~

4.肿么可以这样子,都不想写了今儿个,留着作参考吧!拒绝大抄特抄,慢慢一点点写!

- apache与php整合

aichenglong

php apache web

一 apache web服务器

1 apeche web服务器的安装

1)下载Apache web服务器

2)配置域名(如果需要使用要在DNS上注册)

3)测试安装访问http://localhost/验证是否安装成功

2 apache管理

1)service.msc进行图形化管理

2)命令管理,配

- Maven常用内置变量

AILIKES

maven

Built-in properties

${basedir} represents the directory containing pom.xml

${version} equivalent to ${project.version} (deprecated: ${pom.version})

Pom/Project properties

Al

- java的类和对象

百合不是茶

JAVA面向对象 类 对象

java中的类:

java是面向对象的语言,解决问题的核心就是将问题看成是一个类,使用类来解决

java使用 class 类名 来创建类 ,在Java中类名要求和构造方法,Java的文件名是一样的

创建一个A类:

class A{

}

java中的类:将某两个事物有联系的属性包装在一个类中,再通

- JS控制页面输入框为只读

bijian1013

JavaScript

在WEB应用开发当中,增、删除、改、查功能必不可少,为了减少以后维护的工作量,我们一般都只做一份页面,通过传入的参数控制其是新增、修改或者查看。而修改时需将待修改的信息从后台取到并显示出来,实际上就是查看的过程,唯一的区别是修改时,页面上所有的信息能修改,而查看页面上的信息不能修改。因此完全可以将其合并,但通过前端JS将查看页面的所有信息控制为只读,在信息量非常大时,就比较麻烦。

- AngularJS与服务器交互

bijian1013

JavaScriptAngularJS$http

对于AJAX应用(使用XMLHttpRequests)来说,向服务器发起请求的传统方式是:获取一个XMLHttpRequest对象的引用、发起请求、读取响应、检查状态码,最后处理服务端的响应。整个过程示例如下:

var xmlhttp = new XMLHttpRequest();

xmlhttp.onreadystatechange

- [Maven学习笔记八]Maven常用插件应用

bit1129

maven

常用插件及其用法位于:http://maven.apache.org/plugins/

1. Jetty server plugin

2. Dependency copy plugin

3. Surefire Test plugin

4. Uber jar plugin

1. Jetty Pl

- 【Hive六】Hive用户自定义函数(UDF)

bit1129

自定义函数

1. 什么是Hive UDF

Hive是基于Hadoop中的MapReduce,提供HQL查询的数据仓库。Hive是一个很开放的系统,很多内容都支持用户定制,包括:

文件格式:Text File,Sequence File

内存中的数据格式: Java Integer/String, Hadoop IntWritable/Text

用户提供的 map/reduce 脚本:不管什么

- 杀掉nginx进程后丢失nginx.pid,如何重新启动nginx

ronin47

nginx 重启 pid丢失

nginx进程被意外关闭,使用nginx -s reload重启时报如下错误:nginx: [error] open() “/var/run/nginx.pid” failed (2: No such file or directory)这是因为nginx进程被杀死后pid丢失了,下一次再开启nginx -s reload时无法启动解决办法:nginx -s reload 只是用来告诉运行中的ng

- UI设计中我们为什么需要设计动效

brotherlamp

UIui教程ui视频ui资料ui自学

随着国际大品牌苹果和谷歌的引领,最近越来越多的国内公司开始关注动效设计了,越来越多的团队已经意识到动效在产品用户体验中的重要性了,更多的UI设计师们也开始投身动效设计领域。

但是说到底,我们到底为什么需要动效设计?或者说我们到底需要什么样的动效?做动效设计也有段时间了,于是尝试用一些案例,从产品本身出发来说说我所思考的动效设计。

一、加强体验舒适度

嗯,就是让用户更加爽更加爽的用你的产品。

- Spring中JdbcDaoSupport的DataSource注入问题

bylijinnan

javaspring

参考以下两篇文章:

http://www.mkyong.com/spring/spring-jdbctemplate-jdbcdaosupport-examples/

http://stackoverflow.com/questions/4762229/spring-ldap-invoking-setter-methods-in-beans-configuration

Sprin

- 数据库连接池的工作原理

chicony

数据库连接池

随着信息技术的高速发展与广泛应用,数据库技术在信息技术领域中的位置越来越重要,尤其是网络应用和电子商务的迅速发展,都需要数据库技术支持动 态Web站点的运行,而传统的开发模式是:首先在主程序(如Servlet、Beans)中建立数据库连接;然后进行SQL操作,对数据库中的对象进行查 询、修改和删除等操作;最后断开数据库连接。使用这种开发模式,对

- java 关键字

CrazyMizzz

java

关键字是事先定义的,有特别意义的标识符,有时又叫保留字。对于保留字,用户只能按照系统规定的方式使用,不能自行定义。

Java中的关键字按功能主要可以分为以下几类:

(1)访问修饰符

public,private,protected

p

- Hive中的排序语法

daizj

排序hiveorder byDISTRIBUTE BYsort by

Hive中的排序语法 2014.06.22 ORDER BY

hive中的ORDER BY语句和关系数据库中的sql语法相似。他会对查询结果做全局排序,这意味着所有的数据会传送到一个Reduce任务上,这样会导致在大数量的情况下,花费大量时间。

与数据库中 ORDER BY 的区别在于在hive.mapred.mode = strict模式下,必须指定 limit 否则执行会报错。

- 单态设计模式

dcj3sjt126com

设计模式

单例模式(Singleton)用于为一个类生成一个唯一的对象。最常用的地方是数据库连接。 使用单例模式生成一个对象后,该对象可以被其它众多对象所使用。

<?phpclass Example{ // 保存类实例在此属性中 private static&

- svn locked

dcj3sjt126com

Lock

post-commit hook failed (exit code 1) with output:

svn: E155004: Working copy 'D:\xx\xxx' locked

svn: E200031: sqlite: attempt to write a readonly database

svn: E200031: sqlite: attempt to write a

- ARM寄存器学习

e200702084

数据结构C++cC#F#

无论是学习哪一种处理器,首先需要明确的就是这种处理器的寄存器以及工作模式。

ARM有37个寄存器,其中31个通用寄存器,6个状态寄存器。

1、不分组寄存器(R0-R7)

不分组也就是说说,在所有的处理器模式下指的都时同一物理寄存器。在异常中断造成处理器模式切换时,由于不同的处理器模式使用一个名字相同的物理寄存器,就是

- 常用编码资料

gengzg

编码

List<UserInfo> list=GetUserS.GetUserList(11);

String json=JSON.toJSONString(list);

HashMap<Object,Object> hs=new HashMap<Object, Object>();

for(int i=0;i<10;i++)

{

- 进程 vs. 线程

hongtoushizi

线程linux进程

我们介绍了多进程和多线程,这是实现多任务最常用的两种方式。现在,我们来讨论一下这两种方式的优缺点。

首先,要实现多任务,通常我们会设计Master-Worker模式,Master负责分配任务,Worker负责执行任务,因此,多任务环境下,通常是一个Master,多个Worker。

如果用多进程实现Master-Worker,主进程就是Master,其他进程就是Worker。

如果用多线程实现

- Linux定时Job:crontab -e 与 /etc/crontab 的区别

Josh_Persistence

linuxcrontab

一、linux中的crotab中的指定的时间只有5个部分:* * * * *

分别表示:分钟,小时,日,月,星期,具体说来:

第一段 代表分钟 0—59

第二段 代表小时 0—23

第三段 代表日期 1—31

第四段 代表月份 1—12

第五段 代表星期几,0代表星期日 0—6

如:

*/1 * * * * 每分钟执行一次。

*

- KMP算法详解

hm4123660

数据结构C++算法字符串KMP

字符串模式匹配我们相信大家都有遇过,然而我们也习惯用简单匹配法(即Brute-Force算法),其基本思路就是一个个逐一对比下去,这也是我们大家熟知的方法,然而这种算法的效率并不高,但利于理解。

假设主串s="ababcabcacbab",模式串为t="

- 枚举类型的单例模式

zhb8015

单例模式

E.编写一个包含单个元素的枚举类型[极推荐]。代码如下:

public enum MaYun {himself; //定义一个枚举的元素,就代表MaYun的一个实例private String anotherField;MaYun() {//MaYun诞生要做的事情//这个方法也可以去掉。将构造时候需要做的事情放在instance赋值的时候:/** himself = MaYun() {*

- Kafka+Storm+HDFS

ssydxa219

storm

cd /myhome/usr/stormbin/storm nimbus &bin/storm supervisor &bin/storm ui &Kafka+Storm+HDFS整合实践kafka_2.9.2-0.8.1.1.tgzapache-storm-0.9.2-incubating.tar.gzKafka安装配置我们使用3台机器搭建Kafk

- Java获取本地服务器的IP

中华好儿孙

javaWeb获取服务器ip地址

System.out.println("getRequestURL:"+request.getRequestURL());

System.out.println("getLocalAddr:"+request.getLocalAddr());

System.out.println("getLocalPort:&quo

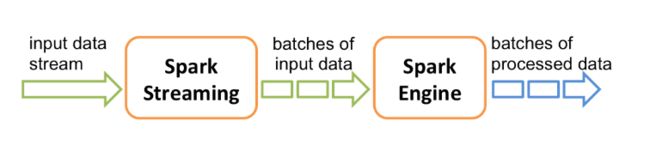

如上图所示,Spark Streaming接收输入数据流,并在内部将数据流分为多个较小的batch(batch 大小取决于batch的间隔)。Spark Streaimg引擎将这些输入数据的batch处理后,生成处理过数据的batch结果集。

如上图所示,Spark Streaming接收输入数据流,并在内部将数据流分为多个较小的batch(batch 大小取决于batch的间隔)。Spark Streaimg引擎将这些输入数据的batch处理后,生成处理过数据的batch结果集。 所以,实际上任何对DStream的操作都转换成了对DStream隐含的一系列对应RDD的操作。入下图所示:

所以,实际上任何对DStream的操作都转换成了对DStream隐含的一系列对应RDD的操作。入下图所示: 上图中对lines DStream的flatMap操作,实际上应用于lines对应每个RDD的操作,并生成了对应的works DStream的RDD。

上图中对lines DStream的flatMap操作,实际上应用于lines对应每个RDD的操作,并生成了对应的works DStream的RDD。 Spark Streaming为每个输入源启动对应的接收器。接收器以任务的形式运行在应用的执行器进程中,从输入源收集数据并转换为RDD。接收器收集到数据后会把数据复制到另一个执行器进程来保障容错性。在驱动器程序中的StreamingContext会周期性地运行Spark作业来处理这些数据,并把当前时间区间中的RDD与之前时间区间中的RDD进行整合。

Spark Streaming为每个输入源启动对应的接收器。接收器以任务的形式运行在应用的执行器进程中,从输入源收集数据并转换为RDD。接收器收集到数据后会把数据复制到另一个执行器进程来保障容错性。在驱动器程序中的StreamingContext会周期性地运行Spark作业来处理这些数据,并把当前时间区间中的RDD与之前时间区间中的RDD进行整合。 对DStream可以用的最简单窗口操作是window(),它返回一个新的DStream来表示所请求的窗口操作的结果数据。换句话说,window()生成的DStream中的每个 RDD 会包含多个批次中的数据,可以对这些数据进行count()、transform()等操作。使用代码如下所示:

对DStream可以用的最简单窗口操作是window(),它返回一个新的DStream来表示所请求的窗口操作的结果数据。换句话说,window()生成的DStream中的每个 RDD 会包含多个批次中的数据,可以对这些数据进行count()、transform()等操作。使用代码如下所示: