Stable-Diffusion和ControlNet插件安装全过程,以及使用心得汇总.

Stable-Diffusion的安装我采用的是YouTuBe视频的

<>

需要魔法上网

12分钟的视频从你的系统是否支持stable diffusion开始到最后安装成功并运行,一气呵成.

国内因为魔法原因,导致很多小伙伴不能直接采用此方法.

所以还有B站的 秋葉aaaki 大神做的整合包,这里就不介绍了.

开始安装SD

先确定你的电脑显卡是否可以运行,基本上1000,2000,3000,还有4000系列都可以.

但是最好是拥有8G及以上显存

(如果想要自己跑模型,则最少需要12G显存,可以利用插件降低至6G但是质量同样也会下降.)

Install Git

首先安装Git版本管理器

打开https://git-scm.com/download/win,就可以直接下载最新版本.

Git版本管理器通常是管理从Git仓库下载的版本,在Stable-Diffusion中他只有一个作用

就是实时更新Stable-Diffusion至最新版本,这也是和国内一键安装包最大的不同.

Install Python

安装python 3.10.6以上版本,但最好不要安装3.11.0以上的版本,具体原因不清楚,只是看到网上有说只能安装3.10.N的版本.

https://www.python.org/downloads/windows/

另外要注意一定要在安装时,勾选Add Python 3.10 to PATH,这能保证你的系统只有一个Python版本.

防止出现错误问题.

Install Stable Diffsuion

完成了上面两个前置软件的安装,就可以开始安装SD了.

首先,在你想要安装SD的盘符里新建一个文件夹,这里注意有SSD硬盘就装SSD,因为每次启动和切换model时,都会重新读取model,如果是机械硬盘会很费时间,导致启动和切换变慢.并且确保有200G的可用空间,SD本身不大,但是以后会不停的往里面加model和生成的照片也会存放在里面.

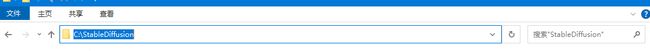

比如放在C盘,在C盘新建一个文件夹,起名叫StableDiffusion即可,不要有中文或者其他符号免得报错.

然后打开此文件夹,并在此处清空文本,然后键入CMD.

来到这里

之后在命令提示行里键入git clong https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

回车以后程序会自动下载github上的代码,如果没有魔法上网的小伙伴可能这一步会卡死,或者下载速度只有几KB/s.

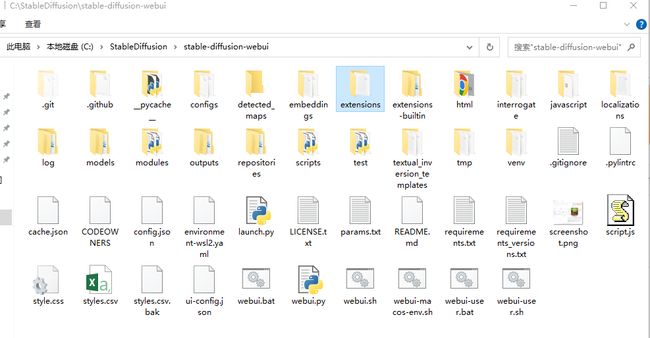

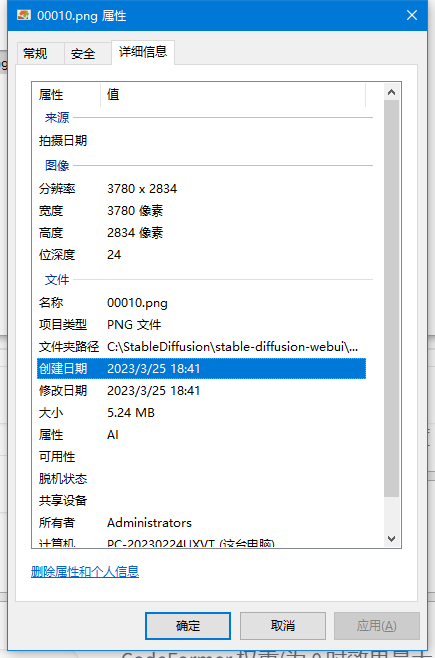

当软件下载完成后,你可以在你新建的文件夹里找到stable-diffusion-webui的文件

这就是SD的全部文件,现在需要一个基础的model,来测试SD是否能正常运行,并且生成图像.

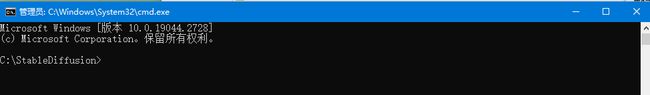

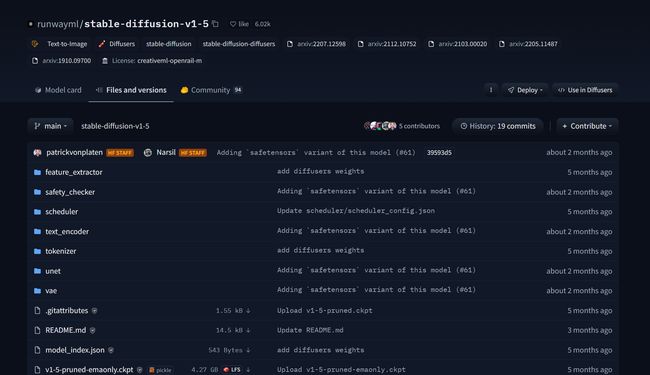

视频里推荐的是SDv1.5的基础模型https://huggingface.co/runwayml/stable-diffusion-v1-5

下载箭头所指的文件即可,其他不用下载.

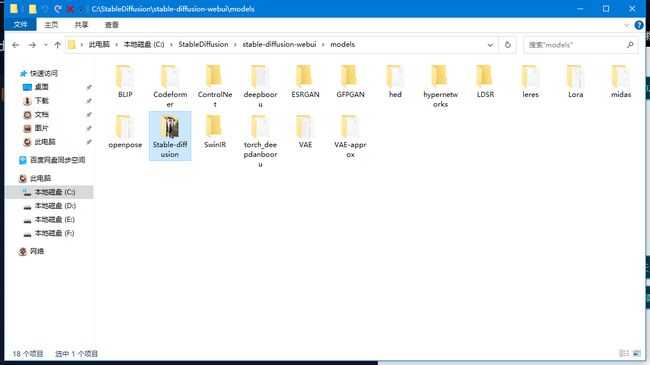

下载完成以后将文件移动到SD文件夹里的models里的Stable-diffusion里.

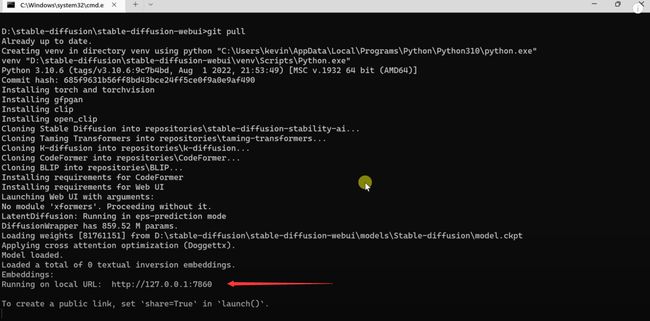

之后在回到stable-diffusion-webui目录,将webui-user.bat用记事本打开,并在里面添加git pull命令,这样就可以再你每次打开SD时自动检测更新.

青色箭头所指的命令为开启xformers,开启后会加速图片生成速度,并且减低爆显存的概率,以及黑图等问题.但牺牲的就是图片的一点点质量,当然如果你是8G显存生成图片时不超过1024*1024分辨率的情况是不需要开启他的.

保存好后就可以双击webui-rser.bat运行程序了

只要出现此地址就代表成功运行了,将地址复制粘贴到网页打开即可.

如何具体使用SD就不在本篇说了.

网上有很多教程,使用SD并不简单,尤其是当你抱有一定期望时,想要让SD生成出和你心中所想一模一样或八九不离十的图片,同时还需要修复图片里的小问题小细节.这都需要不断地摸索和学习.

现在SD的大众主流就是停在此处,B站,油管的视频网站都有很多关于使用SD的教程.

使用好SD就如同二十几年前使用好PS一样,当你真的使用好它,并且能随心所欲的生成你想要的结果时,这场AI红利盛宴,你就站在了前面.

安装中文语言包插件

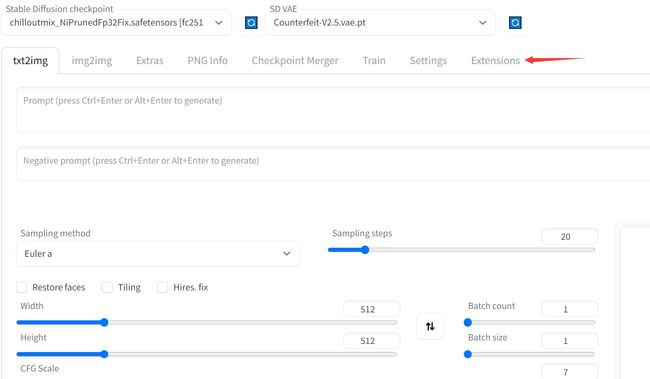

在网页中点击Extensions

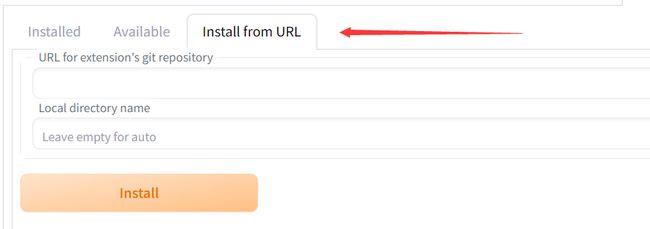

选择Install from URL

在URL for extension's git repository里键入

https://github.com/dtlnor/stable-diffusion-webui-localization-zh_CN.git

点击Install

之后等安装就好了,这一步同样需要用到魔法上网,否则下载速度会非常慢.

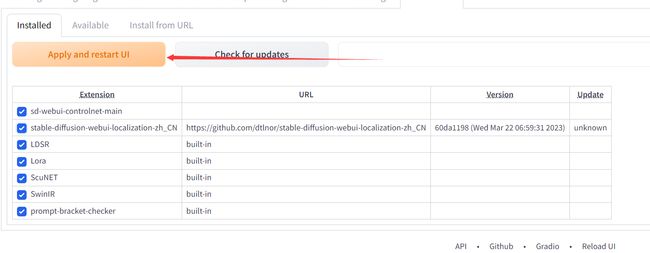

安装完毕以后回到Installed,选择Apply and restart UI,应用并重启UI即可.

安装ControlNet

ContronlNet神级插件必装.

在SD目录里找到extensions,在此文件夹内新建一个记事本,随便命名为英文即可

打开记事本将

git clone https://github.com/Mikubill/sd-webui-controlnet.git 复制进去,然后保存并更改扩展名为.bat

之后双击运行,程序就会自动在此文件夹下,将ContronlNet下载下来,或者在SD网页中点击扩展,

从网址安装,将上面的网址复制进去也行.

当看到此图就代表安装成功.

点击应用并重启就可以了.

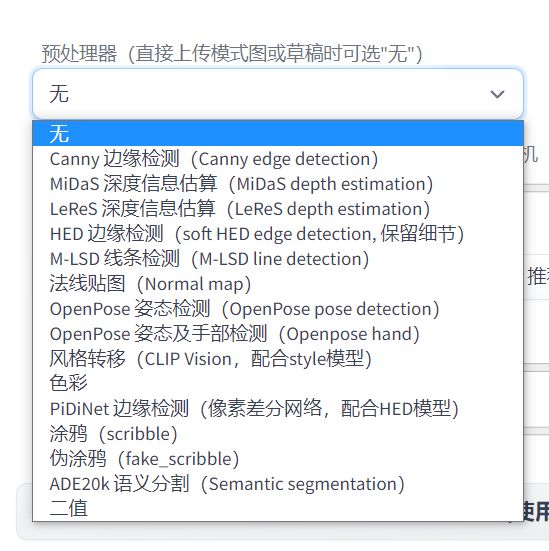

ControlNet中有许多内置处理器,如果你没有下载的话,每次点击一个预处理器,都会在后台里进行下载.

如何用StableDiffusion生成自己满意的图片(纯经验之谈)

女性火魔法师,中世纪,动漫风格,符合预期

男性冰魔法师,中世纪,动漫风格,符合预期

以上两张图为我自己作为研究Stable Diffsuion绘图的最终成果.

可以看到的是这两个人物的手部已经算是看得过去了,并且不算是纯抽卡搞出的.

其中还是有一些方法,或者说技巧来干预最后生成图片的.

想要一个符合自己脑海中预期的图片,首先还是要选好一个模型.

上图中女性魔法师比男性魔法师显然要好得多,这就是因为采用的模型不同所导致的.

女性魔法师的模型,在商业化时作者要求通知他.

当然如果有条件,或者商业行为的话,最好还是自己训练大模型(CHECKPOINT)

然后再根据项目需求训练小模型(LORA)来微调不同画风,人物,已达到预期.

不同的模型对于最后的产出效果会有很大区别,同时也将是未来一个看得见的盈利模式.

提供大模型和LORA来给一些公司进行商业化,同时赚取佣金.

这条路我就不走了,留给其他人走吧,毕竟和我的研究方向是不太一致的,我也希望以后能出一些

商业化的模型,来解决美术资源的问题,哪怕付一些钱也好过自己买设备或者租GPU云服务器"炼丹".

话说回来,这两张图片在刚从T2I时并没有这样

以女性魔法师举例

这只是其中一些图,最后选定了倒数第二个.其他的崩的都比较难以修改,至少以我的水平来说.

可以看到的是这些人的姿势其实都被固定了,这就是运用了ControlNet的Openpose功能.

将原图的姿势固定下来,之后再生成想要的画风,和一些元素.

这都算是比较初级的,点点鼠标看看视频就能会的.

比较难得是修复手部问题.

原图中的手是非常扭曲的,这里还是要通过ControlNet的Depth maps来进行一个引导.

通过深度图编辑器(Depth Library)https://github.com/jexom/sd-webui-depth-lib.git

来进行一个对手部的控制.

这些预制的手部图片可以涵盖大部分的常用手部视角,女性魔法师用的是倒数第六个手部模型.

到这里手部已经能正常显示了,但是颜色还有些不对,最后再拉到PS里进行色彩,对比度,亮度的调整,最终生成最开始的图.(对于这张图使用的绘画或者说PS技术还比较简单,放大图片,选择手部即可.)

但是在男性魔法师的创建中,我用了另外一种方法来进行手部的控制和修复.

因为男性魔法师的右手成拖球状态,在预制的深度图里没有与之相匹配的,所以我在网上找来了一个手部示例图.

将这个手部图与原图(512*864)版的在PS里进行合成,将手部图贴于男性魔法师的右手旁,并调整角度.

生成了一张具有相同尺寸512*864的一张深度图(通过滤镜3D选项进行深度图创建)

手部位置正好覆盖在人物的右手处.

之后回到SD里利用I2I的局部重绘+ControlNet的depth模型

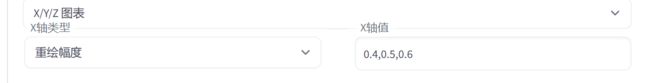

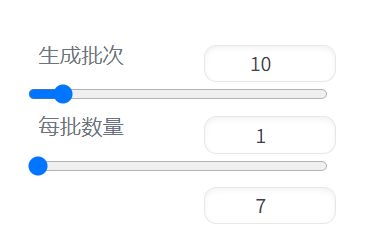

来进行一个局部重绘,并用脚本里的XYZ图标,将重绘幅度值改为3个

0.4.05.0.6

同时将生成批次改为10

这样抽卡效率会大大提升

最后在重绘幅度0.5里找到了这张图.显然与成品还是有些差距,因为我又将它拿到PS里进行了最后的处理(笔刷工具进行修改,这里就需要一些绘画技巧了,本人也只学过几个月的临摹+KK魔法学院的透视课而已,基本上只要熟悉手绘板的使用,就可以小范围的进行更改.)

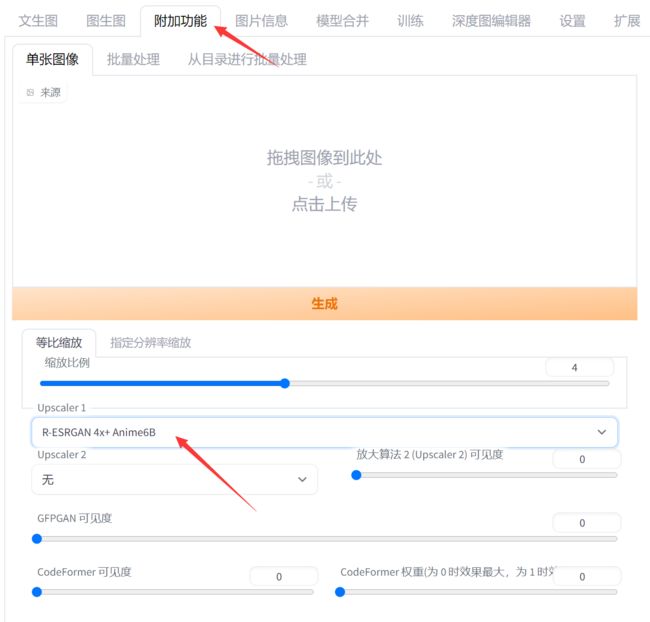

最后将512*864版的图片拉到附加功能里

将放大算法改成R-ESRGAN 4x+Anime6B或者R-ESRGAN 4x+都行,进行高清修复,最后大功告成.

当然如果放大来看图片,还是会有很多瑕疵,这就是SD的目前的天花板了,做这两张图总的算下来不过才3-4个小时而已,并且如果让我去画是绝对画不出来的.

目前来说出图的质量还不能得到保证,还需要原画师进行一个后期修图,碍于本人美术水平有限,且作为一种研究来说,已经算是了解到了SD目前最前沿的一种工作流(workflow)了.

AI的进步是飞速的,给他一年时间再来看看吧.

好了我也要去研究别的了,我的最终目的并不是完全让SD出一张完美无瑕的图.

这是GitHub社区其他人的努力方向,我祝愿他们能早日成功.

而我则要再去研究下别的了!

最后在对"小画尸"们说一句心里话:快跑!

(to be continued)