ROBUST LEARNING MEETS GENERATIVE MODELS: CAN PROXY DISTRIBUTIONS IMPROVE ADVERSARIAL ROBUSTNESS

我们首先试图正式理解从代理分布上训练的分类器到真实数据分布的鲁棒性转移。我们证明了两个分布上分类器的鲁棒性之间的差异是由它们之间的条件Wasserstein距离上界。接下来,我们使用代理分布来显著提高对抗性训练在五个不同数据集上的性能。我们进一步证明了不同的生成模型在鲁棒训练中带来了不同的性能改进。我们提出了一种稳健的判别方法来表征单个生成模型的影响,并进一步深入理解为什么当前基于扩散的生成模型的最先进技术是代理分布的更好选择,而不是生成对抗网络。

问题1 .何时将稳健性从代理分布转移到真实数据分布?

这个问题对于更好地理解代理分发是否有帮助至关重要。对于只在合成样本上训练的分类器,我们认为,除了经验和泛化误差之外,分布偏移惩罚也决定了它对真实数据分布的鲁棒性。我们证明了这个惩罚是由代理分布和真实数据分布之间的条件Wasserstein距离的上界。因此,鲁棒性将从与真实数据分布非常接近的代理分布转移到条件Wasserstein距离。

问题2:代理分布在提高真实数据集的对抗鲁棒性方面有多有效?

我们在五个数据集上的实验结果表明,在鲁棒训练(PORT)中使用来自PrOxy分布的样本可以显著提高鲁棒性。特别是,PORT在对抗鲁棒性方面比现有的最先进技术提高了高达7.5%。它的改进在不同的威胁模型('∞或' 2)、网络架构、数据集和稳健性标准(经验稳健性或认证稳健性)中是一致的。我们还发现,来自基于扩散的生成模型的合成图像在提高真实数据集的鲁棒性方面最有帮助。我们进一步研究了代理分布在稳健训练中的使用。特别是,我们调查了为什么当前基于扩散的模型的最先进技术比它们的同行(如生成对抗网络(GANs))更有帮助。

问题3:我们能否开发一个度量来描述哪个代理分布在健壮性训练中最有帮助?

我们的理论促使设计两个分布之间的接近性度量,该度量包含分布的几何形状,并且可以经验地预测鲁棒性的转移。我们提出了一种健壮的基于学习的方法,其中我们使用鉴别器在区分合成数据和真实数据的对抗扰动样本方面的成功作为接近性的衡量标准。区分合成数据和真实数据是一种常见的做法,然而,我们发现,考虑合成和真实数据样本上的对抗性扰动是使鉴别器成为这项任务的有效度量的关键。我们证明,随着扰动大小的增加,鉴别器成功的降低率可以有效地测量接近性,并准确地预测来自不同生成模型的鲁棒性的相对转移。

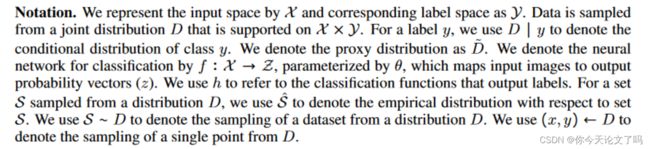

符号说明:

UNDERSTANDING TRANSFER OF ADVERSARIAL ROBUSTNESS BETWEEN DATA DISTRIBUTIONS

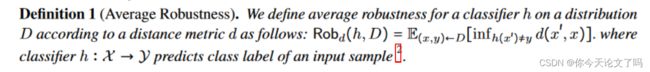

这个定义是指每个样本到最近的对抗样本的期望距离。

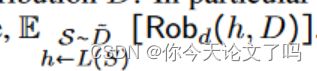

从代理数据分布到真实数据分布的健壮性的形式化转换。在从代理分布进行鲁棒学习时,我们感兴趣的是在分布D上,当训练集是从代理分布中采样的n个标记示例的集合S时,通过学习算法(L)获得的分类器的平均鲁棒性,特别是我们想提供转移的平均鲁棒性的下界,即:

为了更好地理解这个量,假设h是一个在集S上训练的分类器,该集合S是从![]() 中采样的,使用算法l。我们将Robd(h, D)分解为三个量

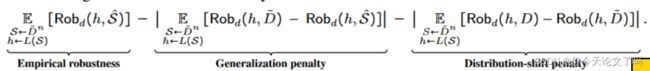

中采样的,使用算法l。我们将Robd(h, D)分解为三个量![]()

利用这种分解,通过期望的线性和三角不等式,我们可以从下到上绑定转移平均鲁棒性

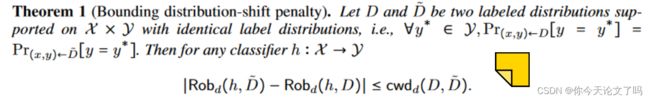

为了约束平均鲁棒性,我们需要同时约束泛化惩罚和分布偏移惩罚。在多部作品之前已经对泛化惩罚进行了严格的研究。因此,我们将重点放在限制分布偏移惩罚上。我们的目标是提供一个分布偏移惩罚的边界,它与现有的分类器无关,只与分布的性质有关。有了这个目标,我们定义了两个分布之间距离的概念

定理1展示了如何通过最小化两个分布之间的条件瓦瑟斯坦距离来约束分布偏移惩罚,即使我们成功地减少了泛化惩罚,分布偏移惩罚可能仍然是转移稳健性的主要因素。这个定理使我们能够将注意力从健壮的泛化转向创建生成模型,其中底层分布接近原始分布。

WHICH PROXY DISTRIBUTION TO CHOOSE? - APPROXIMATING CONDITIONAL WASSERSTEIN DISTANCE USING ROBUST DISCRIMINATORS

代理分布与真实数据具有较小的条件Wasserstein距离可以提高系统的鲁棒性。在本节中,我们引入一个名为ARC的度量,作为条件Wasserstein距离的代理,当我们只有样本访问数据分布时可以计算该距离

我们的度量是基于鉴别器在真实分布和代理分布样本之间的鲁棒性。与典型的鉴别器相比,即使对手可以通过大小为的扰动扰动采样实例,鲁棒鉴别器也应该是准确的。直观地说,如果存在一个成功且健壮的区分D和![]() 两个分布的判别器,那么这意味着没有对手可以使D的实例看起来像

两个分布的判别器,那么这意味着没有对手可以使D的实例看起来像![]() 的实例,即使是通过进行大小为的扰动。这意味着D和之间距离很远(图1b)。另一方面,如果不存在健壮的鉴别器,那么这意味着对手可以通过最大为的扰动将代理分布的大部分质量与实际分布的质量“对齐”。这个概念与代理和实际分布之间的最优传输密切相关。特更具体地说,鲁棒鉴别器σ的目标是使其鲁棒精度最大化

的实例,即使是通过进行大小为的扰动。这意味着D和之间距离很远(图1b)。另一方面,如果不存在健壮的鉴别器,那么这意味着对手可以通过最大为的扰动将代理分布的大部分质量与实际分布的质量“对齐”。这个概念与代理和实际分布之间的最优传输密切相关。特更具体地说,鲁棒鉴别器σ的目标是使其鲁棒精度最大化

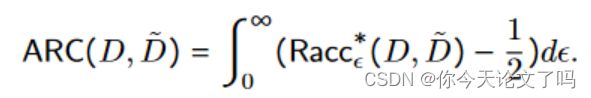

![]() 如果两个分布D和D彼此接近,精度下降的速度要快得多,因为对手可以通过添加较小的扰动使来自两个分布的图像看起来相似。我们利用这种直觉,定义我们的度规ARC如下:

如果两个分布D和D彼此接近,精度下降的速度要快得多,因为对手可以通过添加较小的扰动使来自两个分布的图像看起来相似。我们利用这种直觉,定义我们的度规ARC如下:

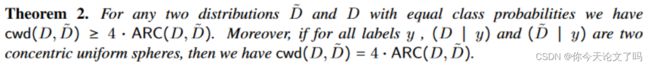

换句话说,ARC度量等于鲁棒识别精度vs .摄动曲线下的面积我们还证明了ARC度量与条件瓦瑟斯坦距离直接相关。特别地,我们有下面的定理

BRINGING IT ALL TOGETHER: IMPROVING ADVERSARIAL ROBUSTNESS USING PROXY DISTRIBUTIONS

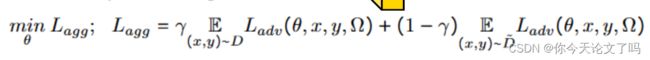

我们的目标是在稳健训练(PORT)中整合来自代理分布的合成样本。特别地,我们使用以下健壮的训练公式,将来自真实训练数据集的样本与合成样本结合起来。