tf.nn.conv2d详解

tf.nn.conv2d是TensorFlow里面实现二维卷积的函数,函数原型如下:

conv2d(input, filter, strides, padding, use_cudnn_on_gpu=True, data_format="NHWC", dilations=[1, 1, 1, 1], name=None):

1.input

指需要做卷积的输入图像,它要求是一个Tensor,具有[batch, in_height, in_width, in_channels]这样的shape,具体含义是[一个batch的图片数量, 图片高度, 图片宽度, 图像通道数],注意这是一个4维的Tensor,要求类型为float32和float64其中之一

2.filter

相当于CNN中的卷积核,它要求是一个Tensor,具有[filter_height, filter_width, in_channels, out_channels]这样的shape,具体含义是[卷积核的高度,卷积核的宽度,图像通道数,卷积核个数

3.strides

第三个参数strides:卷积时在图像每一维的步长:一个长度为4的一维列表,每个元素跟data_format互相对应,表示在data_format每一维上的移动步长。当输入的默认格式为:“NHWC”,则 strides = [batch , in_height , in_width, in_channels]。其中 batch 和 in_channels 要求一定为1,即只能在一个样本的一个通道上的特征图上进行移动,in_height , in_width表示卷积核在特征图的高度和宽度上移动的步长。

4.padding

string类型的量,只能是"SAME","VALID"其中之一

5.use_cudnn_on_gpu

use_cudnn_on_gpu:bool类型,是否使用cudnn加速,默认为true

6.data_format

data_format="NHWC" 指明输入数据和输出数据的格式,有两种

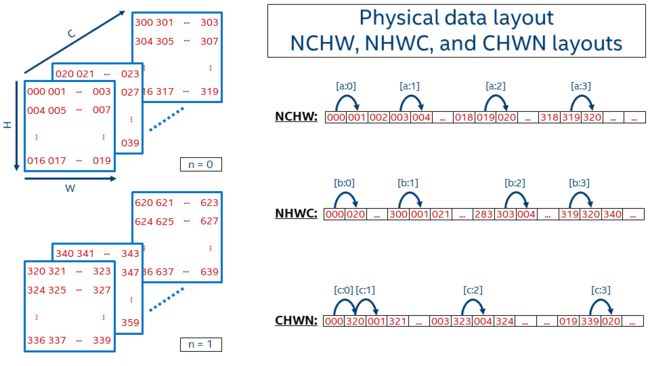

default format "NHWC", the data is stored in the order of:[batch, height, width, channels].

Alternatively, the format could be "NCHW", the data storage order of:[batch, channels, height, width].

N代表数量, C代表channel,H代表高度,W代表宽度。

NCHW其实代表的是[W H C N],第一个元素是000,第二个元素是沿着w方向的,即001,这样下去002 003,再接着就是沿着H方向,即004 005 006 007...这样到09后,沿C方向,轮到了020,之后021 022 ...一直到319,然后再沿N方向。

NHWC的话以此类推,代表的是[C W H N],第一个元素是000,第二个沿C方向,即020,040, 060..一直到300,之后沿W方向,001 021 041 061...301..到了303后,沿H方向,即004 024 .。。304.。最后到了319,变成N方向,320,340....

7.dilations

An optional list of `ints`. Defaults to `[1, 1, 1, 1]`.1-D tensor of length 4. The dilation factor for each dimension of `input`.

If set to k > 1, there will be k-1 skipped cells between each filter element on that dimension.

The dimension order is determined by the value of `data_format`, see above for details. Dilations in the batch and depth dimensions must be 1.

8.name

指定卷积操作的名字

https://www.cnblogs.com/sunny-li/p/9630305.html

https://blog.csdn.net/cxmscb/article/details/71023576