【慕伏白】stable diffusion webui 使用手册

文章目录

-

- Global Parameters

-

- 1. Stable Diffusion checkpoint

- 2. Functions

- text2img

-

- 1. Prompt

-

- Prompt Editing

- 2. Negative prompt

- 3. Sampling method

- 4. Sampling steps

- 5. □ \square □ Restore faces □ \square □ Tiling □ \square □ Hires. fix

- 6. Width & Height

- 7. Batch count & Batch size

- 8. CFG Scale

- 9. Seed

-

- 9.1 extra

- 9.2 Variation seed

- 9.3 Variation strength

- 9.4 Resize seed from width

- 9.5 Resize seed from height

- 10. Script

- 11. Styles

- 12. Generate

-

- 12.1 箭头

- 12.2 垃圾篓

- 12.3 相片

- 12.4 文档夹

- 12.5 保存

- img2img

-

- 1. Sketch

- 2. Inpaint

- 3. Inpaint sketch & Inpaint upload

- 4. Batch

- Extras

- PNG Info

- Checkpoint Merger

- Train

- Settings

- Extensions

-

- 常用扩展

-

- 1. 官方汉化

- 2. Stable Diffusion web UI 双语对照翻译插件

- 3. Controlnet

- 4. OpenPose Editor

- 5. Tagcomplete

- 更多

- Reference

- Others

Global Parameters

1. Stable Diffusion checkpoint

-

位于界面左上角,用于调整使用模型,这是对生成结果影响最大的因素,主要体现在画面风格上,不同的算法框架对不同事物的拟合表现情况会有影响

-

模型下载地址:

- civitai

推荐 - 炼丹阁

- DESAI

- ckpt | SD - WebUI 资源站

- AI绘画模型博物馆

- civitai

-

注意: 模型文件有 2 种格式,分别是

.ckpt(Model PickleTensor) 和.safetensors(Model SafeTensor),据说.safetensors更安全,这两种格式stable-diffusion-webui都支持,随意下载一种即可 -

将下载好的模型文件放到

stable-diffusion-webui/models/Stable-diffusion目录下 -

放置好模型文件之后,重启

stable-diffusion-webui -

另: 有些模型会同时需要

VAE模型,下载后放在./stable-diffusion-webui/models/VAE下,然后在Settings—Stable Diffusion—SD VAE处选择后保存并重启即可 -

若需要

Embedding模型,下载后放入./stable-diffusion-webui/embeddings目录即可

2. Functions

txt2img— 标准的文字生成图像;img2img— 根据图像成文范本、结合文字生成图像;Extras— 优化(清晰、扩展)图像;PNG Info— 图像基本信息Checkpoint Merger— 模型合并Train— 重新训练模型Settings— 默认参数修改Extensions— 安装扩展

Textual inversion— 训练模型对于某种图像风格

text2img

1. Prompt

- 对想要生成的东西进行文字描述(正面)

- 提示词所做的工作是缩小模型出图的解空间,即缩小生成内容时在模型数据里的检索范围,而非直接指定作画结果

- 提示词的效果也受模型的影响,有些模型对自然语言做特化训练,有些模型对单词标签对特化训练,那么对不同的提示词语言风格的反应就不同

- 一般而言,概念性的、大范围的、风格化的关键词写在前面,叙述画面内容的关键词其次,最后是描述细节的关键词,大致顺序如:

(画面质量提示词), (画面主题内容)(风格), (相关艺术家), (其他细节)

-

提示词中可以填写以下内容:

- 自然语言:可以使用描述物体的句子作为提示词。大多数情况下英文有效,也可以使用中文,但效果会差很多。另外,描述

prompt时应尽量避免复杂的语法。 - 单词标签:可以使用逗号隔开的单词作为提示词。一般使用普通常见的单词。单词的风格要和图像的整体风格搭配,否则会出现混杂的风格或噪点。另外,尽量避免出现拼写错误。 可参考 Tags | Danbooru (donmai.us)

- Emoji 与颜文字:Emoji (表情符号)也是可以使用并且非常准确的。因为 Emoji 只有一个字符,所以在语义准确度上表现良好。关于 emoji 的确切含义,可以参考 Emoji List, v15.0 (unicode.org) ,对于使用

Danbooru数据的模型来说,可以使用西式颜文字在一定程度上控制出图的表情,比如:-)微笑:-(不悦;-)使眼色:-D开心:-P吐舌头:-C很悲伤:-O惊讶:-/怀疑

- 自然语言:可以使用描述物体的句子作为提示词。大多数情况下英文有效,也可以使用中文,但效果会差很多。另外,描述

-

Prompt参考网站- Lexica

推荐 - Arthub.ai: Discover, Upload and Share AI Generated Art

推荐 - Civitai | Stable Diffusion models, embeddings, LoRAs and more

推荐 - 咒语词典

- MajinAI

- 词图PromptTool - AI绘画资料管理网站

- Black Lily

- Danbooru 标签超市

- 魔咒百科词典

- AI词汇加速器 AcceleratorI Prompt

- NovelAI魔导书

- aitag

- AIBooru: Anime Image Board

- Lexica

-

从其他人的图片中解析

Prompt- Stable Diffusion 法术解析

- Deep Danbooru

- 可通过源码进行本地部署

- 词图PromptTool - AI绘画资料管理网站

- 将图片以文本文档方式打开

-

注意: 在模型中,每个词语本身自带的权重可能有所不同,如果模型训练集中较多地出现某种关键词,我们在提示词中只输入一个词就能极大地影响画面,反之如果模型训练集中较少地出现某种关键词,我们在提示词中可能输入很多个相关词汇对画面的影响效果都很有限。

-

提示: 提示词的顺序很重要,越靠后的权重越低。关键词最好具有特异性,譬如

Anime(动漫)一词就相对泛化,而JoJo一词就能清晰地指向JoJo动漫的画风。措辞越不抽象越好,尽可能避免留下解释空间的措辞。 -

更多的提示词使用方法见 喂饭级stable_diffusion_webUI调参权威指南

Prompt Editing

-

可以使用括号人工修改提示词的权重,方法如:

(word)- 将权重提高至原来的 1.1 倍,即 N e w W e i g h t = W e i g h t × 1.1 NewWeight=Weight \times 1.1 NewWeight=Weight×1.1((word))- 将权重提高至原来的 1.21 倍 ,即 N e w W e i g h t = W e i g h t × 1.1 × 1.1 NewWeight=Weight \times 1.1 \times 1.1 NewWeight=Weight×1.1×1.1[word]- 将权重降低至原来的 0.9091 倍,即 N e w W e i g h t = W e i g h t ÷ 1.1 NewWeight=Weight \div1.1 NewWeight=Weight÷1.1(word:1.5)- 将权重提高至原来的 1.5 倍(word:0.25)- 将权重降低至原来的 0.25 倍- 请注意,权重值最好不要超过 1.5

-

提示词轮转,语法为:

[cow|horse] in a field- 在第一步时,提示词为

cow in a field - 在第二步时,提示词为

horse in a field - 在第三步时,提示词为

cow in a field - 以此类推

-

使得 AI 在不同的步数生成不一样的内容,譬如在某阶段后,绘制的主体由男人变成女人,语法为:

[to:when]在指定数量的step后,将to处的提示词添加到提示[from::when]在指定数量的step后从提示中删除from处的提示词[from:to:when]在指定数量的step后将from处的提示词替换为to处的提示词

例1:

a [fantasy:cyberpunk:16] landscape

- 一开始,读入的提示词为:

the model will be drawing a fantasy landscape.;- 在第 16 步之后,提示词将被替换为:

a cyberpunk landscape,它将继续在之前的图像上计算

例2:

fantasy landscape with a [mountain:lake:0.25] and [an oak:a christmas tree:0.75][ in foreground::0.6][ in background:0.25][shoddy:masterful:0.5],采样步数Steps为100

- 一开始,读入的提示词为:

fantasy landscape with a mountain and an oak in foreground shoddy;- 在第 100 × 0.25 = 25 100\times0.25=25 100×0.25=25 步后,提示词为:

fantasy landscape with a lake and an oak in foreground in background shoddy;

在第 100 × 0.5 = 50 100\times0.5=50 100×0.5=50 步后,提示词为:fantasy landscape with a lake and an oak in foreground in background masterful;

在第 100 × 0.6 = 60 100\times0.6=60 100×0.6=60 步后,提示词为:fantasy landscape with a lake and an oak in background masterful;

在第 100 × 0.75 = 75 100\times0.75=75 100×0.75=75 步后,提示词为:fantasy landscape with a lake and a christmas tree in background masterful

2. Negative prompt

- 对不想要生成的东西进行文字描述(负面)

3. Sampling method

- 采样方法:使用哪种算法生成图像,选择采样方法,部分采样器对于部分画家和物品的拟合,有更好的表现。

Sampling method: Which algorithm to use to produce the image

-

Euler是最简单的、最快的 -

Euler a (Eular ancestral)可以以较少的步数产生很大的多样性,不同的步数可能有不同的结果,但是步数太高 (>30) 效果不会更好。而非ancestral采样器都会产生基本相同的图像。DPM相关的采样器通常具有不错的效果,但耗时也会相应增加 -

DDIM收敛快,但效率相对较低,因为需要很多 steps 才能获得好的结果,适合在重绘时候使用 -

LMS是Euler的衍生,它们使用一种相关但稍有不同的方法(平均过去的几个步骤以提高准确性),大概 30 steps 可以得到稳定结果 -

PLMS是Euler的衍生,可以更好地处理神经网络结构中的奇异性 -

DPM2是一种神奇的方法,它旨在改进DDIM,减少步骤以获得良好的结果。它需要每一步运行两次去噪,它的速度大约是DDIM的两倍,生图效果也非常好。但是如果你在进行调试提示词的实验,这个采样器可能会有点慢了 -

UniPC效果较好且速度非常快,对平面、卡通的表现较好,推荐使用 -

详细采样方法介绍见 stable diffusion webui如何工作以及采样方法的对比

4. Sampling steps

- 采样步:对生成的图像进行迭代改进的次数;较高的值需要较长的时间;非常低的值可能会产生糟糕的结果。更高的 steps 代表绘制的图会更精细,会花更多的步数来检查和拟合图像,使得图像的准确率和成功率更高。

Stable Diffusion的工作方式是从以随机高斯噪声起步,向符合提示的图像一步步降噪接近。随着步数增多,可以得到对目标更小、更精确的图像。但增加步数也会增加生成图像所需的时间。增加步数的边际收益依次递减,主要取决于采样器,一般开到 20~30 即可。

Sampling steps: How many times to improve the generated image iteratively; higher values take longer; very low values can produce bad results

5. □ \square □ Restore faces □ \square □ Tiling □ \square □ Hires. fix

- 面部修复,修复画面中人物的面部,但是非写实风格的人物开启面部修复可能导致面部崩坏

Restore faces

- 可平铺:生成一个可以平铺的图像。

Tiling: Produce an image that can be tiled.

- 高清修复:使用两步过程以较小的分辨率、高档度部分创建图像,然后在不改变构图的情况下改进图像中的细节

- 默认情况下,

text2img在高分辨率下会生成非常混沌的图像。如果使用高清修复,会首先按照指定的尺寸( W i d t h × H e i g h t Width \times Height Width×Height)生成一张图片,然后通过放大算法将图片分辨率扩大,以实现高清大图效果。最终尺寸为原分辨率乘以缩放系数 Upscale ,即 ( W i d t h × H e i g h t ) × U p s c a l e (Width \times Height) \times Upscale (Width×Height)×Upscale - 放大算法中,

Latent在许多情况下效果不错,但重绘幅度小于 0.5 后就不甚理想。ESRGAN_4x、SwinR 4x对 0.5 以下的重绘幅度有较好支持 Hires step表示在进行这一步时计算的步数,设置进行高清修复时的采样迭代次数,0表示沿用原始采样迭代次数Denoising strength字面翻译是降噪强度,表现为最后生成图片对原始输入图像内容的变化程度。该值越高,放大后图像就比放大前图像差别越大。低Denoising意味着修正原图,高Denoising就和原图就没有大的相关性了。一般来讲阈值是 0.7 左右,超过 0.7 和原图基本上无关,0.3 以下就是稍微改一些。实际执行中,具体的执行步骤为 D e n o i s i n g s t r e n g t h × S a m p l i n g S t e p s Denoising strength \times Sampling Steps Denoisingstrength×SamplingSteps。

Hires. fix: Use a two step process to partially create an image at smaller resolution, upscale, and then improve details in it without changing composition

6. Width & Height

-

Width:生成图片宽度

-

Height:生成图片高度

-

W i d t h × H e i g h t Width \times Height Width×Height 指定图像的尺寸。出图尺寸太大时,图中可能会出现多个主体。

1024以上的分辨率可能会出现不理想的结果,推荐使用小尺寸分辨率搭配高清修复(Hires.fix) -

注意: 如果电脑配置不佳,不要让宽度与高度过大,否则容易因为显存不足而无法出图。

7. Batch count & Batch size

- 批次数量:要创建的图像批次数(对生成性能或VRAM使用没有影响)

Batch count: How many batches of images to create (has no impact on generation performance or VRAM usage)

- 批量大小:一个批次中要创建的图像数量(以更高的VRAM使用率为代价提高生成性能)

- 每批数量表示同时生成多少个图像。增加这个值可以提高性能,但也需要更多的显存。大的

Batch Size需要消耗巨量的显存。若没有超过 12G 的显存,请保持为 1 。

Batch size: How many image to create in a single batch (increases generation performance at cost of higher VRAM usage)

- 一次运行生成图像的数量 N u m = B a t c h c o u n t × B a t c h s i z e Num=Batch count \times Batch size Num=Batchcount×Batchsize

8. CFG Scale

- CFG量表:无分类器引导量表(Classifier Free Guidance Scale),即提示词相关性,图像应在多大程度上符合提示(

prompt),较低的值会产生更具创造性的结果,增加这个值将导致图像更接近你的提示,同时更高的数值也会提升图像的平滑程度和对比度。但过高的CFG Scale体现为粗犷的线条和过锐化的图像,在一定程度上降低了图像质量,可以用更多的steps来抵消,一般开到 7~11 即可

CFG Scale: Classifier Free Guidance Scale - how strongly the image should conform to prompt - lower values produce more creative results

9. Seed

- 种子:一个决定随机数生成器输出的值,如果你创建一个与另一个图像具有相同参数和种子的图像,你会得到相似的结果,种子决定模型在生成图片时涉及的所有随机性,它初始化了

Diffusion算法起点的初始值。理论上,在应用完全相同参数(如Steps、CFG、Seed、prompts)的情况下,生产的图片应当完全相同。

Seed: A value that determines the output of random number generator - if you create an image with same parameters and seed as another image, you’ll get the same result

- 骰子:将种子设置为-1,这将导致每次使用一个新的随机数

Set seed to -1, which will cause a new random number to be used every time

- 循环:重复使用上一代的种子,如果它上一次是随机的,此选项最有用

Reuse seed from last generation, mostly useful if it was randomed

9.1 extra

extra:启用额外的参数

9.2 Variation seed

- 变异种子: 将不同图案的种子混合到一代中。

Variation seed: Seed of a different picture to be mixed into the generation.

9.3 Variation strength

- 变异强度: 产生变异的强度。设置为0时,不会有任何效果。设置为1时,将得到带有变异种子的完整图片(除了祖先的采样器,你将只是得到一些东西)。

Variation strength: How strong of a variation to produce. At 0, there will be no effect. At 1, you will get the complete picture with variation seed (except for ancestral samplers, where you will just get something).

9.4 Resize seed from width

- 根据宽度调整种子大小:尝试以指定的分辨率生成类似于相同种子所生成的图片

Resize seed from width: Make an attempt to produce a picture similar to what would have been produced with same seed at specified resolution

9.5 Resize seed from height

- 根据高度调整种子大小:尝试以指定的分辨率生成类似于相同种子所生成的图片

Resize seed from height: Make an attempt to produce a picture similar to what would have been produced with same seed at specified resolution

10. Script

脚本:提供了一些方便的功能,为保存在

stable-diffusion-webui/scripts/路径下的python脚本文件

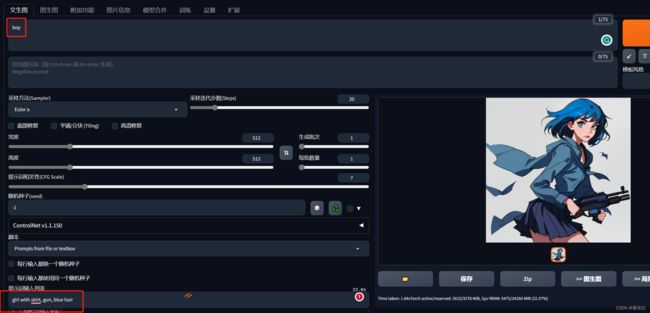

- 截至目前,

text2img功能支持 4 个脚本选择:

- 提示词矩阵: 当我们有多个提示词时,该脚本提供一个能够看不同组合效果的功能。例如我们输入

girl with skirt|gun|blue hair作为prompt,其中包含 3 个提示词,且用|分割。这样就可以生成下图这种两两组合的效果图

- 从文本框或文件载入提示词: 让用户能够从文件中导入提示词。例如我们在上面的

prompt中输入boy,在下面的文本框中输入girl with skirt, gun, blue hair,结果生成的图片是女孩,说明通过script导入的提示词覆盖了在上面文本框中的提示词

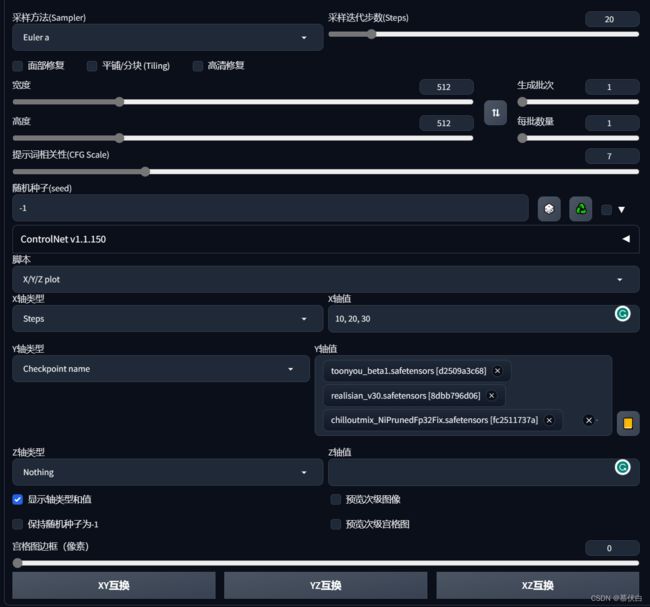

- X/Y/Z图表: 针对特定

prompt,对比不同纬度的参数取不同值时的效果。如下例中,我们选用prompt为girl holding a gun,然后对比三个模型以及steps = 10、steps = 20、steps = 30三个不同采样步数的效果

- Controlnet 视频转绘(m2m): 这个是一个视频处理功能,本质上是把用户上传的视频切帧,并分别进行

img2img,最后重新拼成一整个新的视频。但当前text2img的m2m效果一般,容易产生图像的跳动/闪烁

11. Styles

12. Generate

- 生成图像

12.1 箭头

- 从

Prompt读取生成参数,当Prompt为空时,将上次生成参数读取至当前用户界面

Read generation parameters from prompt or last generation if prompt is empty into user interface.

12.2 垃圾篓

- 清除

Prompt

Clear prompt

12.3 相片

- 显示/隐藏网络列表

Show/hide extra networks

12.4 文档夹

- 将所选样式(

Styles)应用于当前Prompt

Apply selected styles to current prompt

12.5 保存

- 将当前

tag保存至样式(Styles)

Save style

- 保存

tag文件在./stable-diffusion-webui/styles.csv

img2img

大致同上,仅说明不同的部分

- Interrogate CLIP & Interrogate DeepBooru

- 根据提供的图片生成一段描述的信息

- 区别:

CLIP更擅长推理较为真实的图像,更注重画面内的联系,并生成的自然语言描述,自然语言可以理解为一句话的形式DeepBooru对二次元的各种元素把握很好,更适合二次元动漫风格类的图像,可以对二次元图片生成标签,并给出分段形式的关键词

- Resize mode

缩放模式,缩放模式功能其实是指将素材区域的图片以什么样的方式进行加载,每一种加载方式都会影响输出的图像尺寸结果

- 四种图像处理方式的解释如下:

- Just Resize

拉伸:简单的将图片缩放至指定比例,不保证原图尺寸比 - Crop And Resize

裁剪:将图片按比例进行缩放,多余的直接裁剪掉 - Resize And Fill

填充:将图片按比例进行缩放,缺少的部分填充 - Latent upScale

隐空间直接缩放:该选项是常用于图像超分辨率的快捷选项,低显存谨慎使用

- Just Resize

Denoising strength与原图一致性的程度,一般大于 0.7 出来的都是新效果,小于 0.3 时则仅根据原图缝缝补补

1. Sketch

绘图

- 绘图功能使用方法比较简单,我们直接点击绘图按钮,此时你的鼠标移动至图像时,将会自动变为画笔样式,期间也可以通过右上角调整画笔粗细。

- 画笔的粗细调节按钮下方还有一个颜色选择区域,被画笔涂抹的部分将被重新生成,且所生成的颜色与画笔所涂抹的颜色完成一致。

- 在图像上随便涂抹一些内容,此时生成图像的提示词和所有其它参数,包括种子分辨率等设置全部未改变。

- 点击生成

注意:

- 绘图后,在未改变任何参数的情况下生成图像,即使没有被绘图的区域,也会发生一些改变。

- 已被绘图的区域将会根据绘图的颜色进行改变,但是这种改变可能会对图像生成的影响较大,甚至姿势也会发生变更。

2. Inpaint

局部重绘

- 局部重绘功能是比较常用的功能,使用方式和绘图功能大同小异,只是没有了颜色选择功能,因为局部重绘不需要颜色。

- 该功能允许用户指定在图像中特定区域进行修改,而保证其他区域不变,因此可以只修改画面中不满意的地方,将不满意的区域涂抹后重绘即可。

3. Inpaint sketch & Inpaint upload

局部重绘(手涂蒙版) & 局部重绘(上传蒙版)

- 蒙版是一张只有黑白两色的图像,可以通过这张图像控制想要保留的部分,可以快捷且精细的选择处理保留或重绘的部分

- 在

stable diffusion内手动绘制的功能使用起来较不方便,对于复杂的人物或场景无法精细处理,因此更推荐使用导入蒙版的方式使用 - 使用方法: 将想要处理的图像导入至

PhotoShop,然后进行抠图,抠图后填充选区的颜色。 - 注意: 需要重绘的区域为白色,不需要重绘的部分为黑色

- 与

Inpaint区别在于,在Inpaint中,用户涂黑的部分表示该部分可以被重绘;而在Inpaint sketch中,用户涂鸦的部分不仅表示可以重绘,用户涂鸦的内容还会成为图像生成的内容来源。

4. Batch

批量对每张图像进行图生图

- 可以批量生成同一风格的图像,例如可以将一个视频通过该功能进行重绘(视频风格重绘)

- 使用方法: 将想要处理的视频转换为序列帧(可使用

PhotoShop或Premiere、FFMpeg等工具) - 注意: 使用此功能时一定要固定种子,不然所生成的内容将会风格各异,完全不统一

- 参数:

- 输入目录:序列帧保存路径

- 输出目录:处理之后的输出路径

- Inpaint batch mask directory (required for inpaint batch processing only):上色批处理蒙版目录(仅适用于上色批处理需要)

没有可留空,如果通过其它方式处理视频后得到了蒙版,也可以将蒙版序列帧目录填写至此。

- 视频风格重绘实例:Stable Diffusion WebUI|视频风格转换

Extras

该部分主要将图像进行优化,即后期处理,可手动对图片进行导入,也可以通过其他模块中的

send to extras直接使用

提示:

- 对动漫风格的图像进行高清放大时,使用

R-ESRGAN 4x+Anime6B效果更好- 参考:AI二次元图片放大对比与推荐(网站\算法\软件)

PNG Info

该部分主要说明图像大小等信息

Checkpoint Merger

- Primary model ( A ),Secondary model ( B ),Tertiary model ( C )

- 总共可以选择三个模型,一般把主模型放入

Primary model (A)中

- Custom Name (Optional)

- 设置新模型名字

- Multiplier ( M ) - set to 0 to get model A

- 设置混合比例,设置为 0 效果时,与 Primary model (A) 相同,设置为 1 则和 Secondary model (B) 相同

- Interpolation Method

- 设置合并方法,即混合的方式,一般使用

Weighted sum(加权和)

- Checkpoint format

- 模型格式,决定保存的模型后缀是

.ckpt还是.safetensors

- Save as float16

- 是否以

Float16方式保存,不勾选默认是Float32(精度更佳)

- Save metadata

- 保存元数据信息

- 元数据信息主要用于故障恢复,大概包含以下几类信息:

- Configuration:应用使用的配置信息;

- Dstream operations:数据流操作,其实就是我们代码执行逻辑;

- incomplete batches:任务停止时候可能存在 queued 情况,那么这些数据是没有被处理的,当程序再次启动时候,需要重新处理

- SD VAE

- 整合入模型的

VAE。一些额外的VAE针对面部或者其他一些细节做了改良,所以加载VAE文件实际是替换了模型文件中原有的与VAE相关的参数 - 如果你的模型原本的效果就很好,盲目加载

VAE可能弄巧成拙;或者如果你的模型文件已经注入过VAE,你再加载同样的VAE只是浪费时间

- Discard weights with matching name

- 放弃与下列名称匹配的权重,与写入内容名称匹配的权重信息将不会写入输出的模型,可以通过写入

^model_ema以舍弃模型中的 EMA 信息 - 官方解释:What’s the use case for the “Discard weights with matching name” in the model merge tab?

- Run

- 开始融合,点击后等待一会即可融合成功,默认保存在

./models/Stable-diffusion

Train

重新训练模型

- 训练过程参考:

- Stable Diffusion 新手入门手册-目录版

- 或 Stable Diffusion 新手入门手册

Settings

修改个性化设置,根据个人使用习惯进行修改

- 修改

VAE模型Settings—Stable diffusion—SD VAE

Extensions

常用扩展

扩展均可通过

Install from URL下载,或手动下载后,移至./extensions文件夹

1. 官方汉化

- 汉化 stable-diffusion-webui

2. Stable Diffusion web UI 双语对照翻译插件

- Stable Diffusion web UI 双语对照翻译插件 bilingual

3. Controlnet

- stable-diffusion-webui 中 Controlnet 使用说明

4. OpenPose Editor

- OpenPose Editor 安装:让 ConrtolNet 的 Openpose 更好用

5. Tagcomplete

- stable diffusion webui 自动补全 Tag 的插件 Tagcomplete

更多

- 更多

Extensions参见 URL

Reference

- Stable Diffusion 新手入门手册

- stable diffusion webui如何工作以及采样方法的对比

- 模型应用—使用Stable Diffusion UI手册

- Stable Diffusion WebUI 各操作系统安装教程

- 喂饭级stable_diffusion_webUI图生图宝典 - 知乎

- NoveAI模型融合与模型链接教程

- 浅谈stable diffusion (三)

- Stable Diffusion|图生图

- 【AI绘画】一篇值得躺在你收藏夹里的 Stable-Diffusion-Tutorial

Others

- 喂饭级stable_diffusion_webUI使用教程

- 模型方法–Stable Diffusion

- 4 個 AI 繪圖「 Prompt 工具網站」推薦!讓你輕鬆輸入精準指令掌控 AI|Accucrazy 肖準行銷 - Accucrazy 肖準行銷

- 【AI绘画】全网 Stable Diffusion Prompt运用技巧(自用) - 哔哩哔哩

- NovelAI hypernetwork 自训练教程

- Lora人物训练(多concept)导论