ELK 企业级日志分析系统

一.ELK 概述

1.ELK 简介

1)ELK平台是一套完整的日志集中处理解决方案,将 ElasticSearch、Logstash 和 Kiabana 三个开源工具配合使用, 完成更强大的用户对日志的查询、排序、统计需求

2)ElasticSearch:是基于Lucene(一个全文检索引擎的架构)开发的分布式存储检索引擎,用来存储各类日志

3)Elasticsearch 是用 Java 开发的,可通过 RESTful Web 接口,让用户可以通过浏览器与 Elasticsearch 通信

4)Elasticsearch是一个实时的、分布式的可扩展的搜索引擎,允许进行全文、结构化搜索,它通常用于索引和搜索大容量的日志数据,也可用于搜索许多不同类型的文档

- Kiabana:Kibana 通常与 Elasticsearch 一起部署,Kibana 是 Elasticsearch 的一个功能强大的数据可视化 Dashboard,Kibana 提供图形化的 web 界面来浏览 Elasticsearch 日志数据,可以用来汇总、分析和搜索重要数据

- Logstash:作为数据收集引擎。它支持动态的从各种数据源搜集数据,并对数据进行过滤、分析、丰富、统一格式等操作,然后存储到用户指定的位置,一般会发送给 Elasticsearch

- Logstash 由 Ruby 语言编写,运行在 Java 虚拟机(JVM)上,是一款强大的数据处理工具, 可以实现数据传输、格式处理、格式化输出。Logstash 具有强大的插件功能,常用于日志处理

- Filebeat:轻量级的开源日志文件数据搜集器。通常在需要采集数据的客户端安装 Filebeat,并指定目录与日志格式,Filebeat 就能快速收集数据,并发送给 logstash 进行解析,或是直接发给 Elasticsearch 存储,性能上相比运行于 JVM 上的 logstash 优势明显,是对它的替代。常应用于 EFLK 架构当中

2.filebeat 结合 logstash 带来好处:

1)通过 Logstash 具有基于磁盘的自适应缓冲系统,该系统将吸收传入的吞吐量,从而减轻 Elasticsearch 持续写入数据的压力

2)从其他数据源(例如数据库,S3对象存储或消息传递队列)中提取

3)将数据发送到多个目的地,例如S3,HDFS(Hadoop分布式文件系统)或写入文件

4)使用条件数据流逻辑组成更复杂的处理管道

- 缓存/消息队列(redis、kafka、RabbitMQ等):可以对高并发日志数据进行流量削峰和缓冲,这样的缓冲可以一定程度的保护数据不丢失,还可以对整个架构进行应用解耦

- Fluentd:是一个流行的开源数据收集器。由于 logstash 太重量级的缺点,Logstash 性能低、资源消耗比较多等问题,随后就有 Fluentd 的出现。相比较 logstash,Fluentd 更易用、资源消耗更少、性能更高,在数据处理上更高效可靠,受到企业欢迎,成为 logstash 的一种替代方案,常应用于 EFK 架构当中。在 Kubernetes 集群中也常使用 EFK 作为日志数据收集的方案

- 在 Kubernetes 集群中一般是通过 DaemonSet 来运行 Fluentd,以便它在每个 Kubernetes 工作节点上都可以运行一个 Pod。 它通过获取容器日志文件、过滤和转换日志数据,然后将数据传递到 Elasticsearch 集群,在该集群中对其进行索引和存储

3.使用 ELK

- 日志主要包括系统日志、应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误

- 往往单台机器的日志我们使用grep、awk等工具就能基本实现简单分析,但是当日志被分散的储存不同的设备上。如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志。这样是不是感觉很繁琐和效率低下。当务之急我们使用集中化的日志管理,例如:开源的syslog,将所有服务器上的日志收集汇总。集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用 grep、awk和wc等Linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量依然使用这样的方法难免有点力不从心

- 一般大型系统是一个分布式部署的架构,不同的服务模块部署在不同的服务器上,问题出现时,大部分情况需要根据问题暴露的关键信息,定位到具体的服务器和服务模块,构建一套集中式日志系统,可以提高定位问题的效率。

4.完整日志系统基本特征

- 收集:能够采集多种来源的日志数据

- 传输:能够稳定的把日志数据解析过滤并传输到存储系统

- 存储:存储日志数据

- 分析:支持 UI 分析

- 警告:能够提供错误报告,监控机制

5.ELK 工作原理

1)在所有需要收集日志的服务器上部署Logstash;或者先将日志进行集中化管理在日志服务器上,在日志服务器上部署 Logstash。

2)Logstash 收集日志,将日志格式化并输出到 Elasticsearch 群集中。

3)Elasticsearch 对格式化后的数据进行索引和存储。

4)Kibana 从 ES 群集中查询数据生成图表,并进行前端数据的展示。

6.总结:logstash作为日志搜集器,从数据源采集数据,并对数据进行过滤,格式化处理,然后交由Elasticsearch存储,kibana对日志进行可视化处理

二.ELK Elasticsearch 集群部署(在Node1、Node2节点上操作)

1.环境准备

node1节点(2C/4G):node1/192.168.247.80

node2节点(2C/4G):node2/192.168.247.90

Apache节点:apache/192.168.247.131

2.设置Java环境

systemctl stop firewalld

setenforce 0

java -version

openjdk version "1.8.0_131"

OpenJDK Runtime Environment (build 1.8.0_131-b12)

OpenJDK 64-Bit Server VM (build 25.131-b12, mixed mode)

3.部署 Elasticsearch 软件

(1)安装elasticsearch—rpm包

cd /opt #上传elasticsearch-6.7.2.rpm到/opt目录下

rpm -ivh elasticsearch-6.7.2.rpm

(2)修改elasticsearch主配置文件

cp /etc/elasticsearch/elasticsearch.yml

/etc/elasticsearch/elasticsearch.yml.bak

vim /etc/elasticsearch/elasticsearch.yml

cluster.name: my-elk-cluster #-17-取消注释,指定集群名字

node.name: node1 #-23-取消注释,指定节点名字:Node1节点为node1,Node2节点为node2

node.master: true #-添加行-是否master节点,false为否

node.data: true #-添加行-是否数据节点,false为否

path.data: /var/lib/elasticsearch #-33-取消注释,指定数据存放路径

path.logs: /var/log/elasticsearch #-37-取消注释,指定日志存放路径

bootstrap.memory_lock: true #-43-取消注释,避免es使用swap交换分区

network.host: 0.0.0.0 #-55-取消注释,设置监听地址,0.0.0.0代表所有地址

http.port: 9200 #-59-取消注释,ES 服务的默认监听端口为9200,可以指定es集群提供外部访问的接口

transport.tcp.port: 9300 #-添加行-指定es集群内部通信接口

discovery.zen.ping.unicast.hosts: ["192.168.247.80:9300", "192.168.247.90:9300"] #-68-取消注释,集群发现通过单播实现,指定要发现的节点

grep -v "^#" /etc/elasticsearch/elasticsearch.yml

(3)es 性能调优参数

- 优化最大内存大小和最大文件描述符的数量

vim /etc/security/limits.conf

......

* soft nofile 65536

* hard nofile 65536

* soft nproc 32000

* hard nproc 32000

* soft memlock unlimited

* hard memlock unlimited

vim /etc/systemd/system.conf #-末尾添加以下行-

DefaultLimitNOFILE=65536

DefaultLimitNPROC=32000

DefaultLimitMEMLOCK=infinity

4.重启两台node节点虚拟机

- 优化elasticsearch用户拥有的内存权限

vim /etc/sysctl.conf

#一个进程可以拥有的最大内存映射区域数,参考数据(分配 2g/262144,4g/4194304,8g/8388608)

vm.max_map_count=262144

sysctl -p

sysctl -a | grep vm.max_map_count

(4)启动elasticsearch是否成功开启

systemctl start elasticsearch.service

systemctl enable elasticsearch.service

netstat -antp | grep 9200

(5)查看节点信息

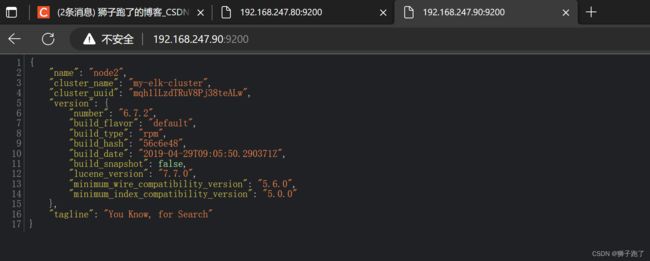

- 浏览器访问 http://192.168.247.80:9200 、 http://192.168.247.90:9200 查看节点 Node1、Node2 的信息。

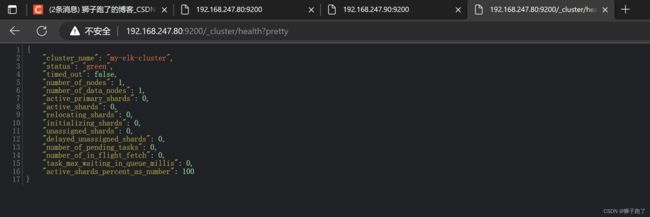

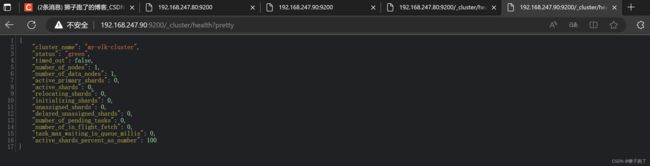

- 浏览器访问 http://192.168.247.80:9200/_cluster/health?pretty 、 http://192.168.247.90:9200/_cluster/health?pretty查看群集的健康情况,可以看到 status 值为 green(绿色), 表示节点健康运行

- 浏览器访问 http://192.168.247.80:9200/_cluster/state?pretty 检查群集状态信息

5.安装 Elasticsearch-head 插件

- Elasticsearch 在 5.0 版本后,Elasticsearch-head 插件需要作为独立服务进行安装,需要使用npm工具(NodeJS的包管理工具)安装安装

- Elasticsearch-head 需要提前安装好依赖软件 node 和 phantomjs

- node:是一个基于 Chrome V8 引擎的 JavaScript 运行环境

- phantomjs:是一个基于 webkit 的JavaScriptAPI,可以理解为一个隐形的浏览器,任何基于 webkit 浏览器做的事情,它都可以做到

1)编译安装 node

- 上传软件包 node-v8.2.1.tar.gz 到/opt

yum install gcc gcc-c++ make -y

cd /opt

tar xf node-v8.2.1.tar.gz

cd node-v8.2.1/

./configure

make -j4 && make install

2)安装 phantomjs

- 上传软件包 phantomjs-2.1.1-linux-x86_64.tar.bz2 到

cd /opt

tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2

cd /opt/phantomjs-2.1.1-linux-x86_64/bin

cp phantomjs /usr/local/bin

3)安装 Elasticsearch-head 数据可视化工具

- 上传软件包 elasticsearch-head-master.zip 到/opt

cd /opt

unzip elasticsearch-head-master.zip

cd /opt/elasticsearch-head/

npm install //安装依赖包

-

npm install 在安装时报错意外退出(npm ERR! Unexpected end of input at 1:77635) -

首先清除缓存

npm cache clean --force -

再安装

npm install

4)修改 Elasticsearch 主配置文件

vim /etc/elasticsearch/elasticsearch.yml

......

--末尾添加以下内容--

http.cors.enabled: true #开启跨域访问支持,默认为 false

http.cors.allow-origin: "*" #指定跨域访问允许的域名地址为所有

systemctl restart elasticsearch

5)启动 elasticsearch-head 服务

- 必须在解压后的 elasticsearch-head 目录下启动服务,进程会读取该目录下的 gruntfile.js 文件,否则可能启动失败。

cd /opt/elasticsearch-head/

npm run start &

netstat -natp |grep 9100

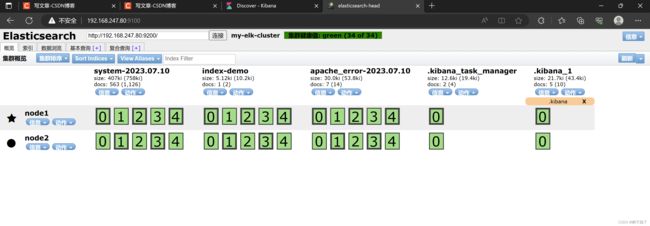

6)通过 Elasticsearch-head 查看 Elasticsearch 信息

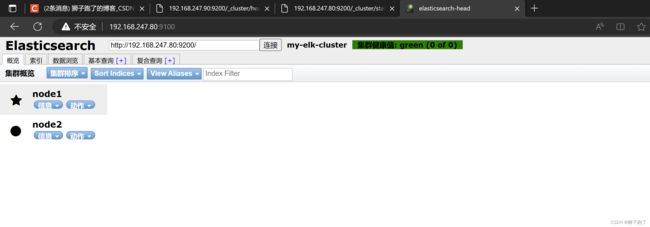

- 通过浏览器访问 http://192.168.247.80:9100/ 地址并连接群集,如果看到群集健康值为 green 绿色,代表群集很健康

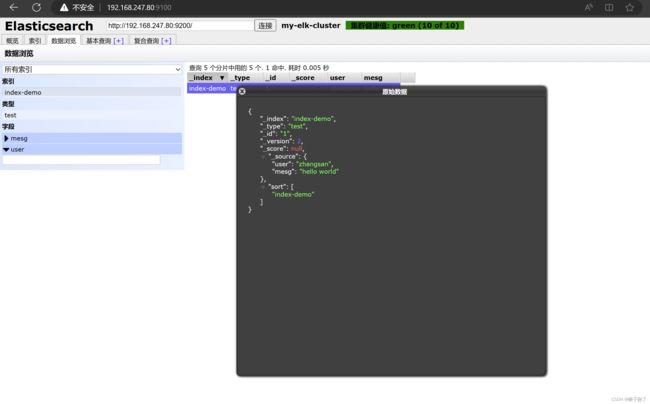

7)插入索引

- 通过命令插入一个测试索引,索引为 index-demo,类型为 test

curl -X PUT 'localhost:9200/index-demo/test/1?pretty&pretty' -H 'content-Type: application/json' -d '{"user":"zhangsan","mesg":"hello world"}'

- 浏览器访问 http://192.168.247.80:9100/ 查看索引信息,可以看见索引默认被分片5个,并且有一个副本

- 点击“数据浏览”,会发现在node1上创建的索引为 index-demo,类型为 test 的相关信息。

三. ELK Logstash 部署(在 Apache 节点上操作)

- Logstash 一般部署在需要监控其日志的服务器。在本案例中,Logstash 部署在 Apache 服务器上,用于收集 Apache 服务器的日志信息并发送到 Elasticsearch

1.更改主机名

hostnamectl set-hostname apache

2.安装Apahce服务(httpd)

yum -y install httpd

systemctl start httpd

3.安装Java环境

yum -y install java

java -version

4.安装logstash

- 上传软件包 logstash-6.7.2.rpm 到/opt目录下

cd /opt

rpm -ivh logstash-6.7.2.rpm

systemctl start logstash.service

systemctl enable logstash.service

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

5.测试 Logstash

- Logstash 命令常用选项:

f:通过这个选项可以指定 Logstash 的配置文件,根据配置文件配置 Logstash 的输入和输出流。

-e:从命令行中获取,输入、输出后面跟着字符串,该字符串可以被当作 Logstash 的配置(如果是空,则默认使用 stdin 作为输入,stdout 作为输出)。

-t:测试配置文件是否正确,然后退出。

6.定义输入和输出流:

- 输入采用标准输入,输出采用标准输出(类似管道),新版本默认使用 rubydebug 格式输出

logstash -e 'input { stdin{} } output { stdout{} }'

- 使用 rubydebug 输出详细格式显示,codec 为一种编解码器

logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }'

- 使用 Logstash 将信息写入 Elasticsearch 中

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.247.90:9200"] } }'

- 结果不在标准输出显示,而是发送至 Elasticsearch 中,可浏览器访问 http://192.168.247.80:9100/ 查看索引信息和数据浏览

7.定义 logstash配置文件

1)input:表示从数据源采集数据,常见的数据源如Kafka、日志文件等

- file beats kafka redis stdin

2)filter:表示数据处理层,包括对数据进行格式化处理、数据类型转换、数据过滤等,支持正则表达式

- grok 对若干个大文本字段进行再分割成一些小字段 (?<字段名>正则表达式) 字段名: 正则表达式匹配到的内容

- date 对数据中的时间格式进行统一和格式化

- mutate 对一些无用的字段进行剔除,或增加字段

- mutiline 对多行数据进行统一编排,多行合并或拆分

- output:表示将Logstash收集的数据经由过滤器处理之后输出到Elasticsearch

3)修改 Logstash 配置文件,让其收集系统日志/var/log/messages,并将其输出到 elasticsearch 中

chmod +r /var/log/messages #让 Logstash 可以读取日志

cd /etc/logstash/conf.d/

vim system.conf

input {

file{

path =>"/var/log/messages" #path表示要收集的日志的文件位置

type =>"system" #type是输入ES时给结果增加一个叫type的属性字段

start_position =>"beginning" #start_position可以设置为beginning或者end,beginning表示从头开始读取文件,end表示读取最新的,这个要和ignore_older一起使用

# ignore_older => 604800 #ignore_older表示了针对多久的文件进行监控,默认一天,单位为秒,可以自己定制,比如默认只读取一天内被修改的文件

sincedb_path => "/etc/logstash/sincedb_path/log_progress" #sincedb_path表示文件读取进度的记录,每行表示一个文件,每行有两个数字,第一个表示文件的inode,第二个表示文件读取到的位置(byteoffset)。默认为$HOME/.sincedb*

add_field => {"log_hostname"=>"${HOSTNAME}"} #add_field增加属性。这里使用了${HOSTNAME},即本机的环境变量,如果要使用本机的环境变量,那么需要在启动命令上加--alow-env

}

}

mkdir /etc/logstash/sincedb_path/

touch /etc/logstash/sincedb_path/log_progress

chown logstash:logstash /etc/logstash/sincedb_path/log_progress

logstash -f system.conf

- 浏览器访问 http://192.168.247.80:9100/ 查看索引信息

四.ELK Kiabana 部署(在 Node1 节点上操作)

1.安装 Kiabana

- 上传软件包 kibana-6.7.2-x86_64.rpm 到/opt目录

cd /opt

rpm -ivh kibana-6.7.2-x86_64.rpm

2.设置 Kibana 的主配置文件

vim /etc/kibana/kibana.yml

server.port: 5601 #-2-取消注释,Kiabana 服务的默认监听端口为5601

server.host: "0.0.0.0" #-7-取消注释,设置 Kiabana 的监听地址,0.0.0.0代表所有地址

elasticsearch.url: ["http://192.168.247.80:9200","http://192.168.247.90:9200"] #-28-取消注释,配置es服务器的ip,如果是集群则配置该集群中master节点的ip

kibana.index: ".kibana" #-37-取消注释,设置在 elasticsearch 中添加.kibana索引

logging.dest: /var/log/kibana.log #-96-取消注释,配置kibana的日志文件路径(需手动创建),不然默认是messages里记录日志

3.创建日志文件,启动 Kibana 服务

touch /var/log/kibana.log

chown kibana:kibana /var/log/kibana.log

systemctl start kibana.service

systemctl enable kibana.service

netstat -natp | grep 5601

4.验证 Kibana

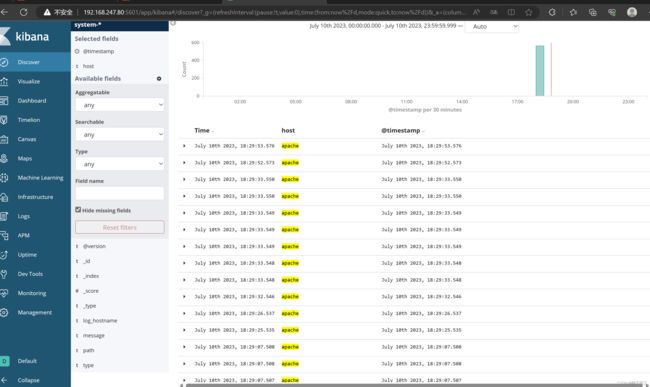

1)浏览器访问 http://192.168.247.80:5601(第一次登录需要添加一个 Elasticsearch 索引)

-

Management -> Index Pattern -> Create index pattern

Index pattern 输入:system-* #在索引名中输入之前配置的 Output 前缀“system” -

Next step -> Time Filter field name 选择 @timestamp -> Create index pattern

-

单击 “Discover” 按钮可查看图表信息及日志信息

-

数据展示可以分类显示,在“Available Fields”中的“host”,然后单击 “add”按钮,可以看到按照“host”筛选后的结果

5.将 Apache 服务器的日志(访问的、错误的)添加到 Elasticsearch 并通过 Kibana 显示

vim /etc/logstash/conf.d/apache_log.conf

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.247.80:9200","192.168.247.90:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["192.168.247.80:9200","192.168.247.90:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

cd /etc/logstash/conf.d/

/usr/share/logstash/bin/logstash -f apache_log.conf

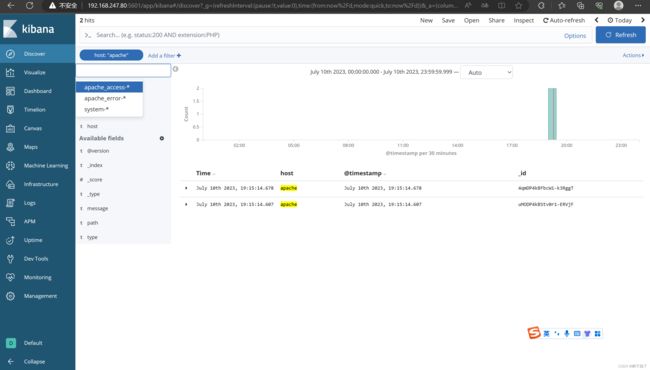

- 浏览器访问 http://192.168.247.80:9100 查看索引是否创建

- 浏览器访问 http://192.168.247.80:5601 登录 Kibana,单击“Index Pattern -> Create Index Pattern”按钮添加索引, 在索引名中输入之前配置的 Output 前缀 apache_access-*,并单击“Create”按钮。在用相同的方法添加 apache_error-*索引

- 选择“Discover”选项卡,在中间下拉列表中选择刚添加的 apache_access-* 、apache_error-* 索引, 可以查看相应的图表及日志信息

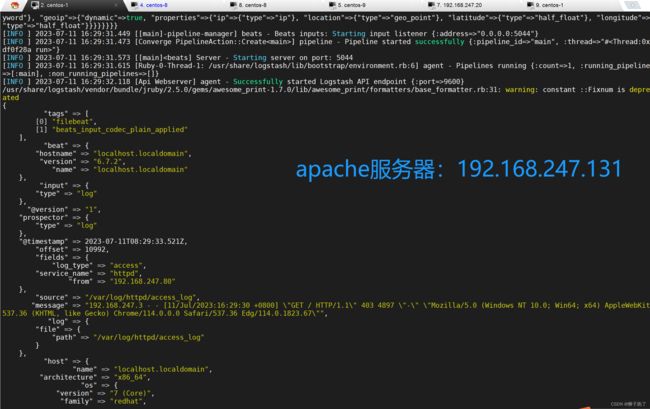

五.Filebeat+ELK 部署

Node1节点(2C/4G):node1/192.168.247.80

Node2节点(2C/4G):node2/192.168.247.90

Apache节点:apache/192.168.247.131

Filebeat节点:filebeat/192.168.247.132

1.在 Node1 节点上操作

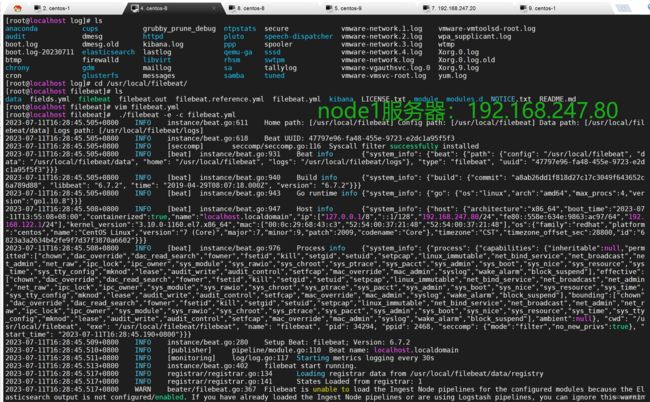

1)安装 Filebeat

- 上传软件包 filebeat-6.7.2-linux-x86_64.tar.gz 到/opt目录

tar xf filebeat-6.7.2-linux-x86_64.tar.gz

mv filebeat-6.7.2-linux-x86_64/ /usr/local/filebeat

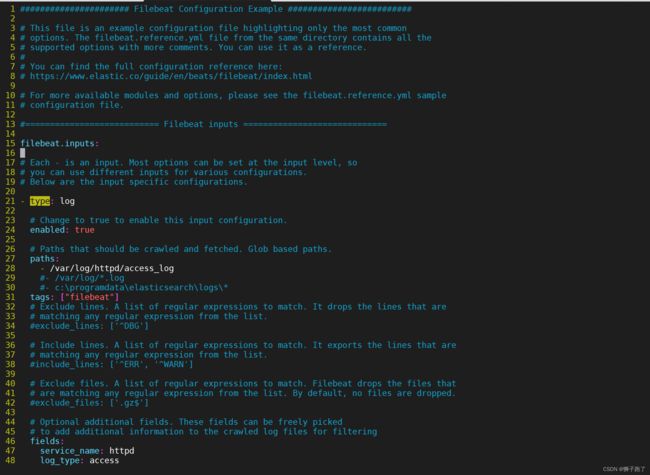

2)设置 filebeat 的主配置文件

cd /usr/local/filebeat

vim filebeat.yml

filebeat.inputs:

- type: log #指定 log 类型,从日志文件中读取消息

enabled: true

paths:

- /var/log/httpd/access_log #指定监控的日志文件

#- /var/log/*.log

tags: ["filebeat"] #设置索引标签

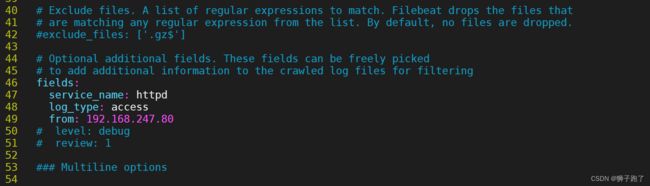

fields: #可以使用 fields 配置选项设置一些参数字段添加到 output 中

service_name: httpd

log_type: access

from: 192.168.247.80

--------------Elasticsearch output-------------------

(全部注释掉)

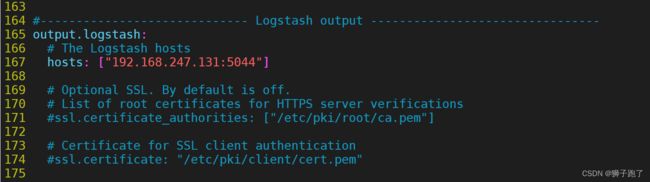

----------------Logstash output---------------------

output.logstash:

hosts: ["192.168.247.131:5044"] #指定 logstash 的 IP 和端口

2.启动 filebeat

./filebeat -e -c filebeat.yml

- #-e:输出到标准输出,禁用syslog/文件输出

- #-c:指定配置文件

- #nohup:在系统后台不挂断地运行命令,退出终端不会影响程序的运行

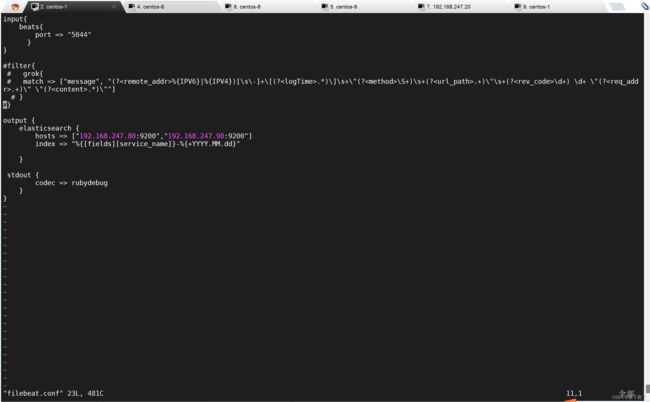

3.在 Logstash 组件所在节点上新建一个 Logstash 配置文件

cd /etc/logstash/conf.d

vim filebeat.conf

input {

beats {

port => "5044"

}

}

- filebeat发送给logstash的日志内容会放到message字段里面,logstash使用grok插件正则匹配message字段内容进行字段分割

- Kibana自带grok的正则匹配的工具:http://:5601/app/kibana#/dev_tools/grokdebugger

- %{IPV6}|%{IPV4} 为 logstash 自带的 IP 常量

filter {

grok {

match => ["message", "(?%{IPV6}|%{IPV4})[\s\-]+\[(?.*)\]\s+\"(?\S+)\s+(?.+)\"\s+(?\d+) \d+ \"(?.+)\" \"(?.*)\"" ]

}

}

output {

elasticsearch {

hosts => ["192.168.247.80:9200","192.168.247.90:9200"]

index => "%{[fields][service_name]}-%{+YYYY.MM.dd}"

}

stdout {

codec => rubydebug

}

}

4.启动 logstash

logstash -f filebeat.conf

5.浏览器访问

- http://192.168.247.80:5601 登录 Kibana,单击“Create Index Pattern”按钮添加索引“filebeat-*”,单击 “create” 按钮创建,单击 “Discover” 按钮可查看图表信息及日志信息

六.grok 正则捕获插件

1.使用文本片段切分的方式来切分日志事件

1)内置正则表达式调用

%{SYNTAX:SEMANTIC}

2)SYNTAX代表匹配值的类型

- 0.11可以NUMBER类型所匹配

- 10.222.22.25可以使用IP匹配

3)SEMANTIC表示存储该值的一个变量声明,它会存储在elasticsearch当中方便kibana做字段搜索和统计,你可以将一个IP定义为客户端IP地址client_ip_address,如%{IP:client_ip_address},所匹配到的值就会存储到client_ip_address这个字段里边,类似数据库的列名,也可以把 event log 中的数字当成数字类型存储在一个指定的变量当中,比如响应时间http_response_time

message: 192.168.247.80 GET /index.html 15824 0.043

%{IP:client_id_address} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:http_response_time}

2.浏览器访问 http://192.168.247.80:5601

七.date 时间处理插件

1.date 介绍

1)用于分析字段中的日期,然后使用该日期或时间戳作为事件的logstash时间戳

2)在Logstash产生了一个Event对象的时候,会给该Event设置一个时间,字段为“@timestamp”,同时,我们的日志内容一般也会有时间,但是这两个时间是不一样的,因为日志内容的时间是该日志打印出来的时间,而“@timestamp”字段的时间是input插件接收到了一条数据并创建Event的时间,所有一般来说的话“@timestamp”的时间要比日志内容的时间晚一点,因为Logstash监控数据变化,数据输入,创建Event导致的时间延迟。这两个时间都可以使用,具体要根据自己的需求来定

2.格式及使用

filter {

date {

match => ["access_time", "dd/MMM/YYYY:HH:mm:ss Z", "UNIX", "yyyy-MM-dd HH:mm:ss", "dd-MMM-yyyy HH:mm:ss"]

target => "@timestamp"

timezone => "Asia/Shanghai"

}

}

- match:用于配置具体的匹配内容规则,前半部分内容表示匹配实际日志当中的时间戳的名称,后半部分则用于匹配实际日志当中的时间戳格式,这个地方是整条配置的核心内容,如果此处规则匹配是无效的,则生成后的日志时间戳将会被input插件读取的时间替代。如果时间格式匹配失败,会生成一个tags字段,字段值为 _dateparsefailure,需要重新检查上边的match配置解析是否正确

- target:将匹配的时间戳存储到给定的目标字段中。如果未提供,则默认更新事件的@timestamp字段

- timezone:当需要配置的date里面没有时区信息,而且不是UTC时间,需要设置timezone参数

3.时间戳详解

1)年

- yyyy #全年号码, 例如:2015

- yy #两位数年份, 例如:2015年的15

2)月

- M #最小数字月份。 例如:1 for January and 12 for December

- MM #两位数月份。 如果需要,填充零。 例如:01 for January and 12 for Decembe

- MMM #缩短的月份文本。 例如: Jan for January。 注意:使用的语言取决于您的语言环境。 请参阅区域设置以了解如何更改语言

- MMMM #全月文本,例如:January。 注意:使用的语言取决于您的语言环境

3)日

- d #最少数字的一天, 例如:1月份的第一天1

- dd #两位数的日子,如果需要的话可以填零.例如:01 for the 1st of the month

4)时

- H #最小数字小时。 例如:0表示午夜

- HH #两位数小时,如果需要填零,例如:午夜00

5)分

- m #最小的数字分钟,例如:0

- mm #两位数分钟,如果需要填零例如,00

6)秒

- s #最小数字秒,例如:0

- ss #两位数字,如果需要填零, 例如:00

7)毫秒( 秒的小数部分最大精度是毫秒(SSS)除此之外,零附加)

- S #十分之一秒,例如:0为亚秒值012

- SS #百分之一秒 例如:01为亚秒值01

- SSS #千分之一秒 例如:012为亚秒值012

8)时区偏移或身份

- Z #时区偏移,结构为HHmm(Zulu/UTC的小时和分钟偏移量),例如:-0700

- ZZ #时区偏移结构为HH:mm(小时偏移和分钟偏移之间的冒号), 例如:-07:00

- ZZZ #时区身份,例如:America/Los_Angeles, 注意:有效的ID在列表中列出http://joda-time.sourceforge.net/timezones.html

八.multiline 多行合并插件

- java错误日志一般都是一条日志很多行的,会把堆栈信息打印出来,当经过 logstash 解析后,每一行都会当做一条记录存放到 ES, 那这种情况肯定是需要处理的。 这里就需要使用 multiline 插件,对属于同一个条日志的记录进行拼接

1.安装 multiline 插件

1)在线安装插件

cd /usr/share/logstash

bin/logstash-plugin install logstash-filter-multiline

2)离线安装插件

bin/logstash-plugin prepare-offline-pack --overwrite --output logstash-filter-multiline.zip logstash-filter-multiline

bin/logstash-plugin install file:///usr/share/logstash/logstash-filter-multiline.zip

3)检查下插件是否安装成功,可以执行以下命令查看插件列表

bin/logstash-plugin list

2.使用 multiline 插件

第一步:每一条日志的第一行开头都是一个时间,可以用时间的正则表达式匹配到第一行。

第二步:然后将后面每一行的日志与第一行合并。

第三步:当遇到某一行的开头是可以匹配正则表达式的时间的,就停止第一条日志的合并,开始合并第二条日志。

第四步:重复第二步和第三步。

filter {

multiline {

pattern => "^\d{4}-\d{1,2}-\d{1,2}\s\d{1,2}:\d{1,2}:\d{1,2}.\d{3}"

negate => true

what => "previous"

}

}

●pattern:用来匹配文本的表达式,也可以是grok表达式

●what:如果pattern匹配成功的话,那么匹配行是归属于上一个事件,还是归属于下一个事件。previous: 归属于上一个事件,向上合并。next: 归属于下一个事件,向下合并

●negate:是否对pattern的结果取反。false:不取反,是默认值。true:取反。将多行事件扫描过程中的行匹配逻辑取反(如果pattern匹配失败,则认为当前行是多行事件的组成部分)

九.mutate 数据修改插件

- 它提供了丰富的基础类型数据处理能力。可以重命名,删除,替换和修改事件中的字段

1.Mutate 过滤器常用的配置选项

add_field 向事件添加新字段,也可以添加多个字段

remove_field 从事件中删除任意字段

add_tag 向事件添加任意标签,在tag字段中添加一段自定义的内容,当tag字段中超过一个内容的时候会变成数组

remove_tag 从事件中删除标签(如果存在)

convert 将字段值转换为另一种数据类型

id 向现场事件添加唯一的ID

lowercase 将字符串字段转换为其小写形式

replace 用新值替换字段

strip 删除开头和结尾的空格

uppercase 将字符串字段转换为等效的大写字母

update 用新值更新现有字段

rename 重命名事件中的字段

gsub 通过正则表达式替换字段中匹配到的值

merge 合并数组或 hash 事件

split 通过指定的分隔符分割字段中的字符串为数组

2.格式及使用

filter {

mutate {

add_field => {

"f1" => "field1"

"f2" => "field2"

}

}

}