【NLP】BERT和原理揭示

一、说明

BERT(来自transformer的双向编码器表示)是Google AI Language研究人员最近发表的一篇论文。它通过在各种NLP任务中展示最先进的结果,在机器学习社区引起了轰动,包括问答(SQuAD v1.1),自然语言推理(MNLI)等。

BERT的关键技术创新是将流行的注意力模型Transformer的双向训练应用于语言建模。这与以前的工作形成鲜明对比,以前的努力从左到右查看文本序列或从左到右和从右到左的组合训练。论文的结果表明,双向训练的语言模型比单向语言模型具有更深入的语言上下文和流动感。在论文中,研究人员详细介绍了一种名为蒙面LM(MLM)的新技术,该技术允许在以前不可能的模型中进行双向训练。

二、背景资料

在计算机视觉领域,研究人员反复展示了迁移学习的价值——在已知任务(例如ImageNet)上预先训练神经网络模型,然后进行微调——使用经过训练的神经网络作为新的特定目的模型的基础。近年来,研究人员已经证明,类似的技术在许多自然语言任务中都很有用。

一种不同的方法,在NLP任务中也很流行,并在最近的ELMo论文中举例说明,是基于特征的训练。在这种方法中,预先训练的神经网络产生词嵌入,然后将其用作NLP模型中的特征。

2.1 BERT如何工作

BERT利用变形金刚,这是一种注意力机制,可以学习文本中单词(或子单词)之间的上下文关系。在其原版形式中,Transformer 包括两种独立的机制——读取文本输入的编码器和生成任务预测的解码器。由于BERT的目标是生成语言模型,因此只需要编码器机制。Transformer的详细工作原理在Google的一篇论文中进行了描述。

与按顺序(从左到右或从右到左)读取文本输入的方向模型相反,Transformer 编码器一次读取整个单词序列。因此,它被认为是双向的,尽管说它是非定向的会更准确。此特征允许模型根据单词的所有周围环境(单词的左侧和右侧)学习单词的上下文。

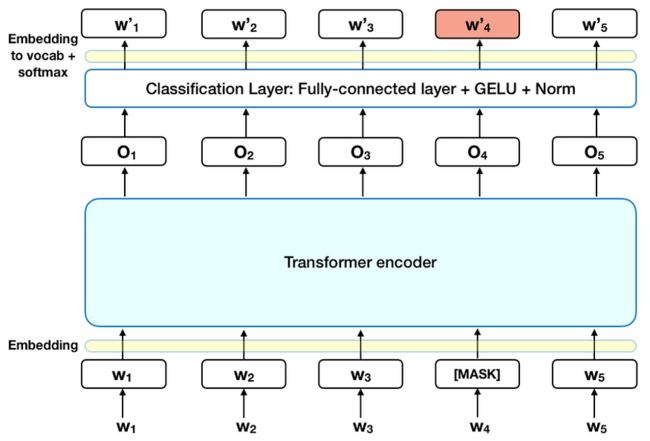

下图是变压器编码器的高级描述。输入是一系列令牌,这些令牌首先嵌入到向量中,然后在神经网络中进行处理。输出是大小为 H 的向量序列,其中每个向量对应于具有相同索引的输入标记。

在训练语言模型时,定义预测目标存在挑战。许多模型预测序列中的下一个单词(例如,“孩子从___回家”),这是一种定向方法,本质上限制了上下文学习。为了克服这一挑战,BERT使用两种培训策略:

2.2 Mask-LM(传销)

在将单词序列输入BERT之前,每个序列中15%的单词将替换为[MASK]标记。然后,该模型尝试根据序列中其他非屏蔽单词提供的上下文来预测被屏蔽单词的原始值。用技术术语来说,输出单词的预测需要:

- 在编码器输出顶部添加分类图层。

- 将输出向量乘以嵌入矩阵,将它们转换为词汇维度。

- 使用 softmax 计算词汇表中每个单词的概率。

BERT损失函数仅考虑屏蔽值的预测,而忽略非屏蔽词的预测。因此,该模型的收敛速度比定向模型慢,这一特征被其增加的上下文感知所抵消(参见要点#3)。

注意:在实践中,BERT实现稍微复杂一些,并没有取代所有15%的屏蔽词。 有关其他信息,请参阅附录 A。

2.3 下一句预测 (NSP)

在BERT训练过程中,模型接收成对的句子作为输入,并学习预测对中的第二个句子是否是原始文档中的后续句子。在训练过程中,50% 的输入是一对,其中第二句是原始文档中的后续句子,而在另外 50% 的输入中,语料库中的随机句子被选择为第二句。假设随机句子将与第一个句子断开连接。

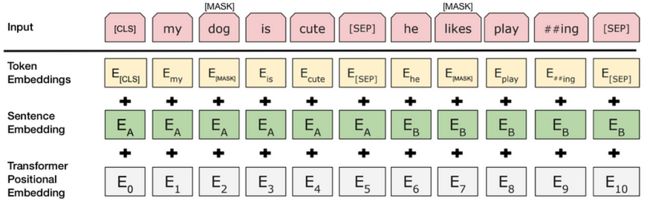

为了帮助模型在训练中区分这两个句子,在进入模型之前,将按以下方式处理输入:

- [CLS] 标记插入到第一个句子的开头,[SEP] 标记插入到每个句子的末尾。

- 指示句子 A 或句子 B 的句子嵌入将添加到每个标记中。句子嵌入在概念上类似于词汇量为 2 的标记嵌入。

- 位置嵌入将添加到每个标记中,以指示其在序列中的位置。位置嵌入的概念和实现在转换器论文中介绍。

资料来源:BERT [Devlin 等人,2018 年],经过修改

为了预测第二个句子是否确实与第一个句子相连,请执行以下步骤:

- 整个输入序列通过变压器模型。

- [CLS] 令牌的输出使用简单的分类层(学习的权重和偏差矩阵)转换为 2×1 形向量。

- 使用 softmax 计算 IsNextSequence 的概率。

在训练BERT模型时,掩码LM和下一句预测一起训练,目的是最小化两种策略的组合损失函数。

2.4 如何使用BERT(微调)

将BERT用于特定任务相对简单:

BERT可用于各种语言任务,而只需在核心模型中添加一小层:

- 情绪分析等分类任务的完成方式与“下一句”分类类似,方法是在 [CLS] 令牌的转换器输出顶部添加分类层。

- 在问答任务(例如 SQuAD v1.1)中,软件接收有关文本序列的问题,并需要在序列中标记答案。使用BERT,可以通过学习两个额外的向量来训练问答模型,这两个向量标志着答案的开始和结束。

- 在命名实体识别(NER)中,软件接收文本序列,并需要标记文本中出现的各种类型的实体(人员,组织,日期等)。使用 BERT,可以通过将每个令牌的输出向量馈送到预测 NER 标签的分类层来训练 NER 模型。

在微调训练中,大多数超参数与BERT训练中相同,本文对需要调优的超参数给出了具体的指导(第3.5节)。BERT团队使用这种技术在各种具有挑战性的自然语言任务上取得了最先进的结果,详见本文第4节。

三、特出优点

- 模型尺寸很重要,即使在大规模的情况下也是如此。BERT_large有345.110亿个参数,是同类模型中最大的。在小规模任务上,它明显优于BERT_base,后者使用相同的架构,“只有”<>.<> 亿个参数。

- 有了足够的训练数据,更多的训练步骤==更高的准确性。例如,在 MNLI 任务中,与相同批量大小的 1K 步相比,在 0M 步(1,128 字的批大小)上训练时,BERT_base准确率提高了 000.500%。

- BERT的双向方法(MLM)收敛速度比从左到右的方法慢(因为每批中只预测了15%的单词),但在少量的预训练步骤之后,双向训练仍然优于从左到右的训练。

Source: BERT [Devlin et al., 2018]

四、计算注意事项(训练和应用)

五、结论

BERT无疑是使用机器学习进行自然语言处理的突破。它平易近人并允许快速微调的事实可能会在未来允许广泛的实际应用。在这个总结中,我们试图描述论文的主要思想,同时不淹没在过多的技术细节中。对于那些希望更深入的人,我们强烈建议阅读其中引用的完整文章和辅助文章。另一个有用的参考是BERT源代码和模型,它们涵盖了103种语言,并由研究团队慷慨地作为开源发布。

六、附录 A — 单词掩码

在BERT中训练语言模型是通过预测输入中随机选择的15%的令牌来完成的。这些令牌的预处理方式如下 - 80%替换为“[MASK]”令牌,10%替换为随机单词,10%使用原始单词。导致作者选择这种方法的直觉如下(感谢谷歌的Jacob Devlin的见解):

- 如果我们 100% 使用 [MASK],模型不一定能为非屏蔽词生成良好的标记表示。非屏蔽标记仍用于上下文,但模型已针对预测屏蔽词进行了优化。

- 如果我们在90%的时间内使用[MASK],在10%的时间内使用随机单词,这将告诉模型观察到的单词永远不会正确。

- 如果我们在90%的时间内使用[MASK],并在10%的时间内保持相同的单词,那么模型就可以简单地复制非上下文嵌入。

没有对这种方法的比率进行消融,并且在不同的比率下可能效果更好。此外,模型性能并未通过简单地屏蔽 100% 的选定令牌来测试。