深度学习模型优化:提高训练效率和精度的技巧

文章目录

-

-

- 1. 数据预处理

- 2. 批量归一化(Batch Normalization)

- 3. 学习率调整

- 4. 提前停止(Early Stopping)

- 5. 模型压缩与剪枝

- 6. 模型并行与分布式训练

- 7. 自动化超参数调整

- 结论

-

欢迎来到AIGC人工智能专栏~探索Java中的静态变量与实例变量

- ☆* o(≧▽≦)o *☆嗨~我是IT·陈寒

- ✨博客主页:IT·陈寒的博客

- 该系列文章专栏:AIGC人工智能

- 其他专栏:Java学习路线 Java面试技巧 Java实战项目 AIGC人工智能 数据结构学习

- 文章作者技术和水平有限,如果文中出现错误,希望大家能指正

- 欢迎大家关注! ❤️

随着深度学习技术的快速发展,越来越多的应用场景受益于其强大的能力。然而,构建一个高效且准确的深度学习模型并不容易。在训练深度神经网络时,研究人员和工程师们需要面对许多挑战,如训练效率低下、过拟合问题等。本文将介绍一些深度学习模型优化的技巧,旨在提高训练效率和模型精度。

1. 数据预处理

数据预处理是构建高效深度学习模型的重要一环。良好的数据预处理可以加速训练过程,提高模型的收敛速度。常见的数据预处理技巧包括:

- 归一化(Normalization):将数据缩放到相似的范围,有助于加速训练和降低梯度消失问题。

- 数据增强(Data Augmentation):通过随机旋转、翻转、裁剪等方式扩充数据集,减少过拟合风险。

以下是一个使用Keras的数据预处理示例:

from keras.preprocessing.image import ImageDataGenerator

# 创建数据增强生成器

datagen = ImageDataGenerator(

rotation_range=20,

width_shift_range=0.2,

height_shift_range=0.2,

horizontal_flip=True,

vertical_flip=True,

rescale=1./255

)

# 使用生成器加载数据

train_generator = datagen.flow_from_directory(

'train_data_dir',

target_size=(224, 224),

batch_size=32,

class_mode='categorical'

)

2. 批量归一化(Batch Normalization)

批量归一化是一种常用的正则化技术,通过将每个批次的输入归一化,有助于加速训练和提高模型稳定性。它可以在网络的每一层中使用。以下是一个使用TensorFlow的批量归一化示例:

import tensorflow as tf

from tensorflow.keras.layers import BatchNormalization, Dense

model = tf.keras.Sequential([

Dense(128, activation='relu'),

BatchNormalization(),

Dense(64, activation='relu'),

BatchNormalization(),

Dense(10, activation='softmax')

])

3. 学习率调整

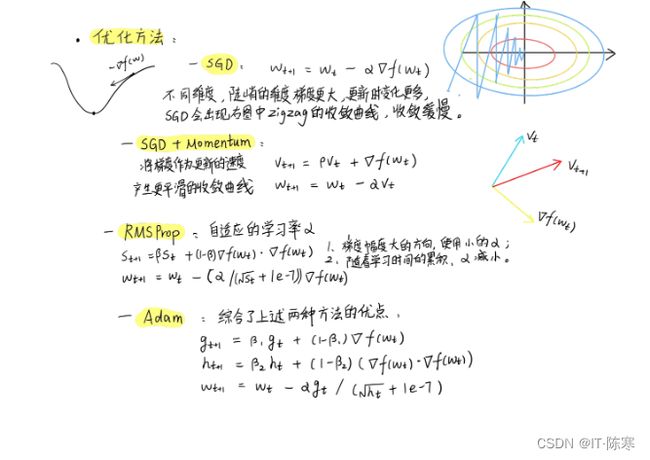

学习率是训练深度学习模型时需要调整的重要超参数之一。合适的学习率可以加速收敛,提高模型性能。常用的学习率调整策略包括:

- 学习率衰减(Learning Rate Decay):随着训练的进行,逐渐减小学习率,使模型更加稳定。

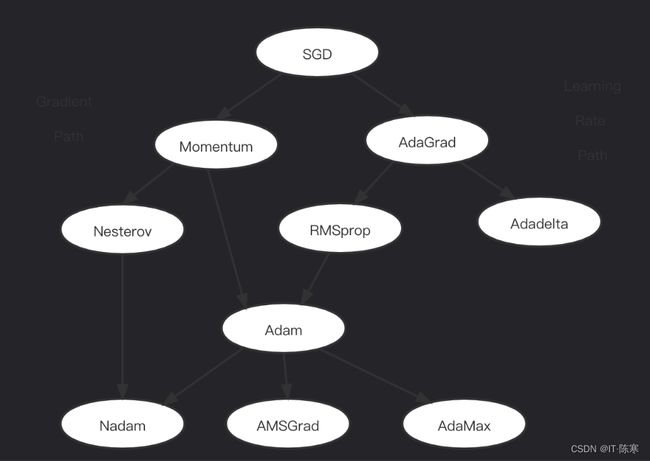

- 自适应学习率方法(如Adam、RMSprop):根据每个参数的梯度情况自动调整学习率。

以下是一个使用PyTorch的学习率调整示例:

import torch

import torch.optim as optim

from torch.optim.lr_scheduler import StepLR

model = MyModel()

optimizer = optim.Adam(model.parameters(), lr=0.001)

scheduler = StepLR(optimizer, step_size=10, gamma=0.5)

for epoch in range(epochs):

train()

validate()

scheduler.step()

4. 提前停止(Early Stopping)

过拟合是深度学习中常见的问题,为了避免模型在验证集上过拟合,可以使用提前停止技巧。当验证集上的性能不再提升时,停止训练,防止模型在训练集上过分拟合。

以下是一个使用Keras的提前停止示例:

from keras.callbacks import EarlyStopping

early_stopping = EarlyStopping(monitor='val_loss', patience=5)

history = model.fit(x_train, y_train, validation_data=(x_val, y_val), callbacks=[early_stopping], epochs=50)

5. 模型压缩与剪枝

深度学习模型通常有大量的参数,导致模型较大,计算量大。模型压缩和剪枝技术可以减少模型的大小和计算量,提高模型在嵌入式设备上的应用性能。

- 权重剪枝(Weight Pruning):去除部分参数,减少模型中的冗余参数。

- 知识蒸馏(Knowledge Distillation):将一个复杂模型的知识迁移到一个小型模型,保持模型性能的同时减小模型大小。

6. 模型并行与分布式训练

对于较大的深度学习模型,单机训练可能会面临内存和计算资源不足的问题。模型并行和分布式训练技术可以将模型训练任务分割成多个部分,分别在多个设备上进行训练,加快训练速度。

- 数据并行(Data Parallelism):将训练数据划分成多个部分,分别在不同设备上训练,然后汇总结果。

- 模型并行(Model Parallelism):将模型的不同层分配到不同设备上进行训练。

7. 自动化超参数调整

超参数调整是深度学习模型优化过程中的一项挑战。使用自动化超参数调整工具,可以自动搜索最佳的超参数组合,提高模型性能。

- 贝叶斯优化(Bayesian Optimization):基于贝叶斯思想,通过不断调整超参数来优化模型性能。

- 网格搜索(Grid Search):尝试所有可能的超参数组合,选择表现最好的组合。

结论

深度学习模型优化是构建高效且准确模型的关键步骤。通过合适的数据预处理、批量归一化、学习率调整等技巧,可以加速训练过程,提高模型性能。此外,模型压缩、并行训练和自动化超参数调整等方法也为深度学习模型优化提供了更多可能性。随着深度学习技术的不断发展,不断探索和应用这些技巧,将会在实际应用中取得更好的效果。

结尾

❤️ 感谢您的支持和鼓励!

您可能感兴趣的内容:

- 【Java面试技巧】Java面试八股文 - 掌握面试必备知识(目录篇)

- 【Java学习路线】2023年完整版Java学习路线图

- 【AIGC人工智能】Chat GPT是什么,初学者怎么使用Chat GPT,需要注意些什么

- 【Java实战项目】SpringBoot+SSM实战:打造高效便捷的企业级Java外卖订购系统

- 【数据结构学习】从零起步:学习数据结构的完整路径