矩阵向量乘法MPI程序的性能评估

文章目录

- 前言

- 一、实验代码

- 二、实验运行效果

- 三、问题以及思考

- 总结

前言

要求:对矩阵向量乘法MPI程序进行不同输入规模、不同进程数的执行和计时,并对得到运行时间进行计算分析,据此评价该程序的强扩展性和弱扩展性。最后总结学习心得,撰写实验报告。

提示:分布式程序的各进程执行进度不同步,为了较为准确地计时,需要在计时开始时插入一个Barrier,最后取各进程计时结果的最大值。为方便矩阵的生成和计算结果的验证,可以通过自定义函数直接生成单位矩阵和元素全为1的向量用于计算。要特别注意注意C语言中传递二维数组给函数时,只能以一维数组的形式传递,并在函数内部把一维数组视为二维数组使用。

一、实验代码

代码如下:

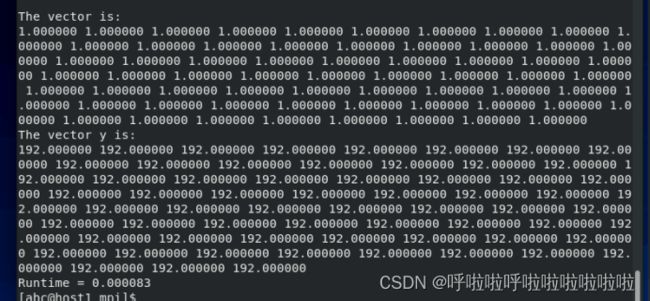

#include二、实验运行效果

反复多次换数据规模进行实验,罗列出表格。

三、问题以及思考

本次实验难度不大,因为在原来的基础上只需要增加计算时间的工具,稍微有难度的地方则是在于由于一般的数据计算时间极快,并不能发现,所以输入的矩阵规模一定要大,但由于我设计的程序是用手动输入所以十分繁琐,不得已通过Python编写了一个写矩阵的程序,在通过全选的方式复制粘贴到矩阵输入处,不过还是十分繁琐,所以一定要注意可以在刚开始就使用读取txt文件的方式,这样能大大简便使用的难度。

总结

该程序实验规模不变,进程数增加,运行时间线性减少,不能维持恒定效率所以该程序不是强可扩展性,但是规模以一定速率扩大效率没有随着进程数增加而降低,所以该程序是可扩展的,该程序规模变大可以通过增加进程数保持效率不变,所以该程序是弱可扩展性的。