JavaFlink原理、实战、源码分析(一)原理部分

JavaFlink原理、实战、源码分析(二)https://blog.csdn.net/qq_36250202/article/details/115668572

JavaFlink原理、实战、源码分析(三)https://blog.csdn.net/qq_36250202/article/details/115732840

第一章 Flink 简介

1.2 Flink 的重要特点

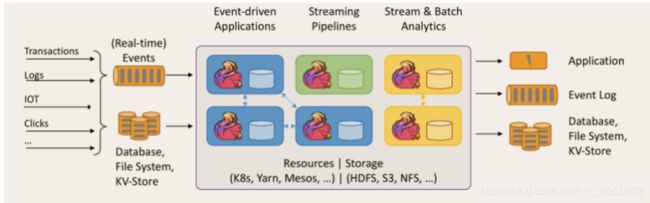

1.2.1 事件驱动型(Event-driven)

1.2.2 流与批的世界观

1.2.3 分层 api

Flink 几大模块

第二章 快速上手

2.1 搭建 maven 工程 FlinkTutorial

pom文件依赖

2.2 批处理 wordcount

2.3 流处理 wordcount

第三章 Flink 部署

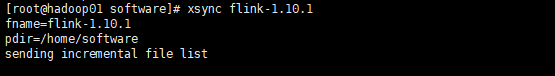

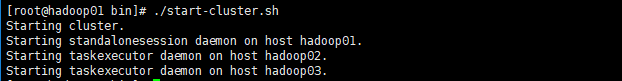

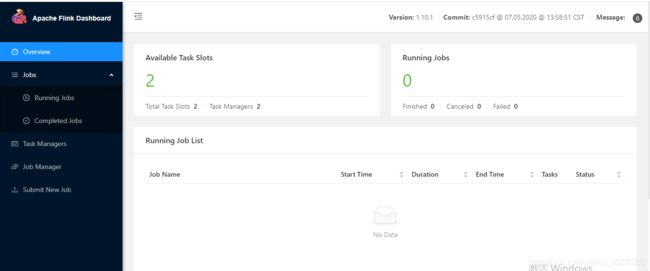

3.1 Standalone 模式

Job提交运行

linuxJob提交

3.2 Yarn 模式

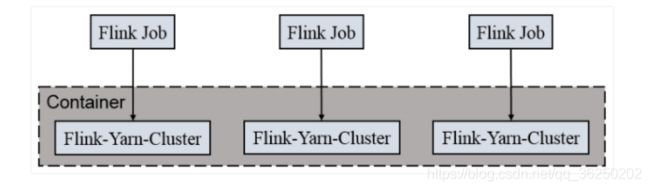

3.2.1 Flink on Yarn

3.2.2 Session Cluster

其中:

3) 执行任务

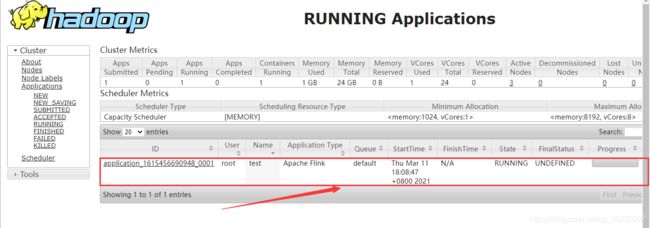

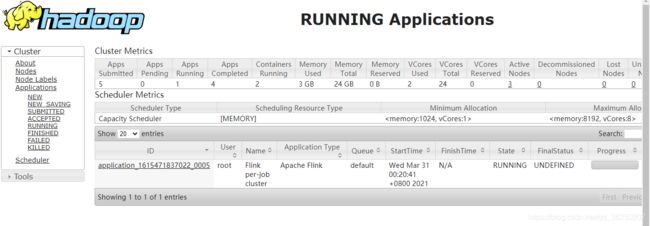

4) 去 yarn 控制台查看任务状态

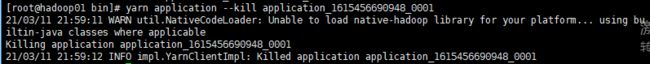

5) 取消 yarn-session

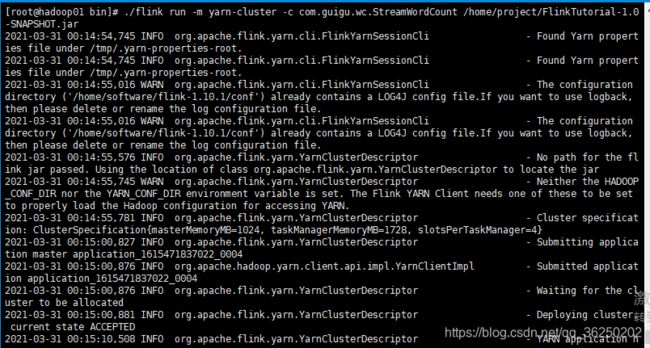

3.2.2 Per Job Cluster

1) 启动 hadoop 集群

第四章 Flink 运行架构

4.1 Flink 运行时的组件

⚫ 作业管理器(JobManager)

⚫ 任务管理器(TaskManager)

⚫ 分发器(Dispatcher)

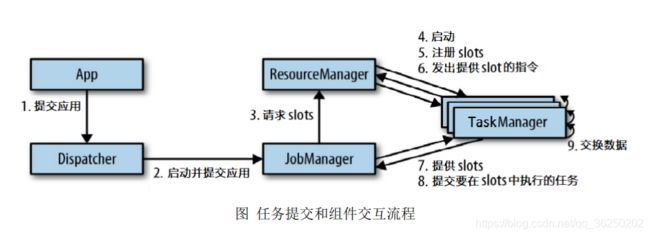

4.2 任务提交流程

4.3 任务调度原理

思考:

并行度(Parallelism)

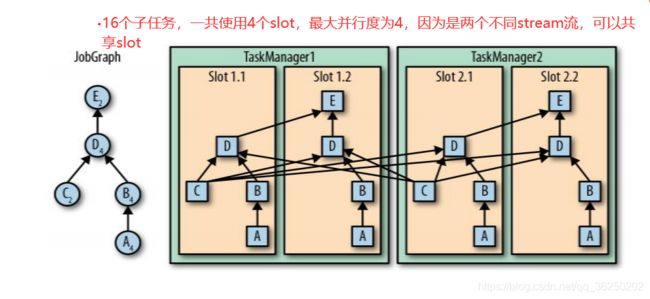

TaskManager 和 Slots

并行子任务的分配

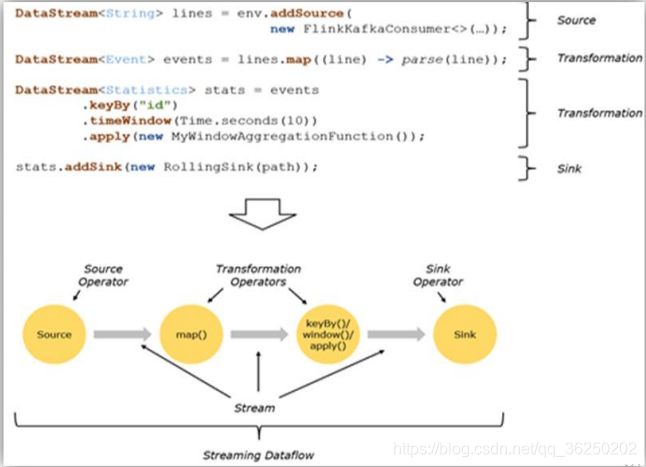

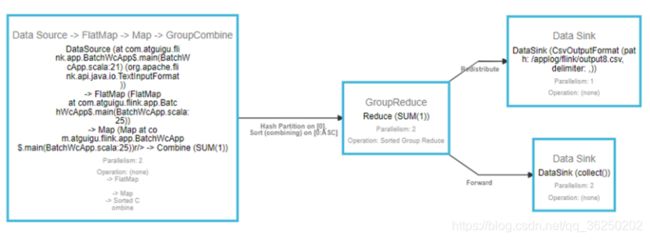

4.3.2 程序与数据流(DataFlow)

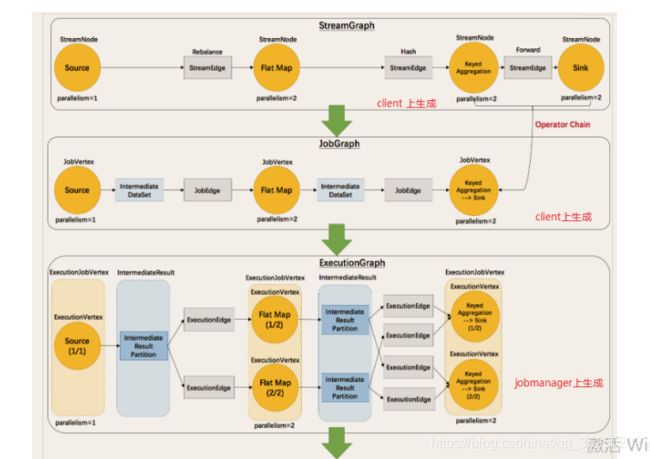

4.3.3 执行图(ExecutionGraph)

4.3.4 并行度(Parallelism)

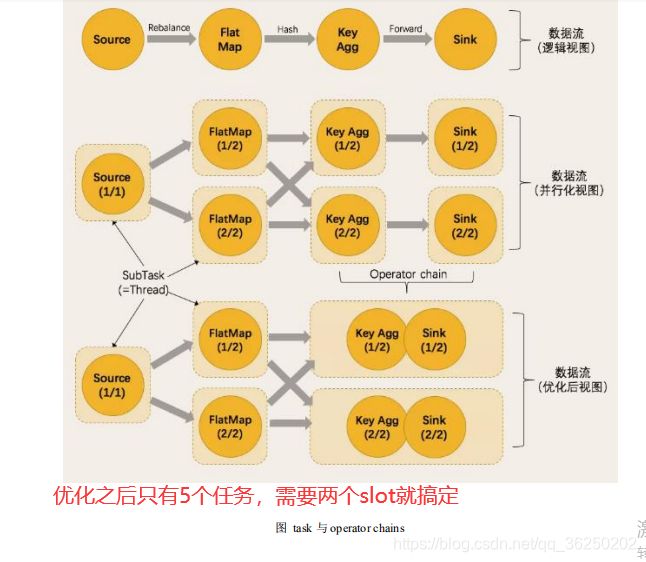

4.3.5 任务链(Operator Chains)

JavaFlink原理、实战、源码分析(二)https://blog.csdn.net/qq_36250202/article/details/115668572

JavaFlink原理、实战、源码分析(三)JavaFlink原理、实战、源码分析(三)原理部分_任错错的博客-CSDN博客

第一章 Flink 简介

1.2 Flink 的重要特点

1.2.1 事件驱动型(Event-driven)

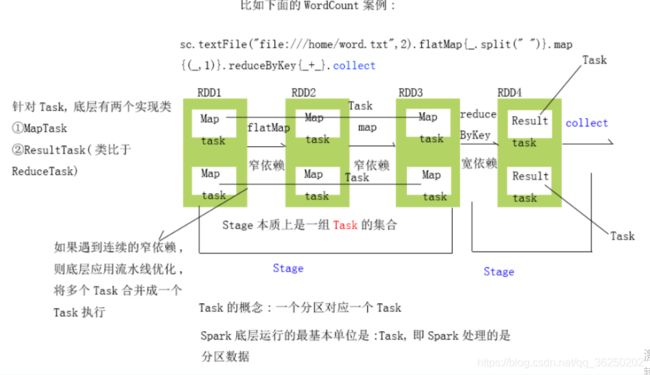

Spark会根据用户提交的计算逻辑中的RDD的转换和动作来生成RDD之间的依赖关系,同时这个计算链也就生成了逻辑上的DAG,遇到宽依赖就划分为一个stage,遇到窄依赖则继续向前找(应用流水线优化,所有的窄依赖是一个Stage)直到把一个DAG划分为多个Stage。

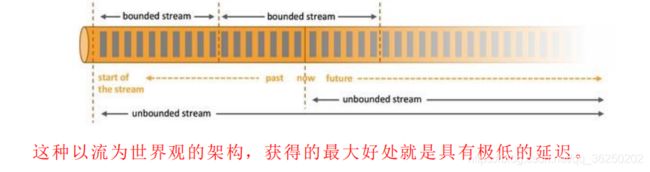

1.2.2 流与批的世界观

1.2.3 分层 api

Flink 几大模块

第二章 快速上手

2.1 搭建 maven 工程 FlinkTutorial

pom文件依赖

4.0.0

com.guigu.wc

FlinkTutorial

1.0-SNAPSHOT

org.apache.flink

flink-java

1.10.1

org.apache.flink

flink-streaming-java_2.11

1.10.1

org.apache.flink

flink-connector-kafka-0.11_2.11

1.10.1

2.2 批处理 wordcount

public class WordCount {

public static void main(String[] args) throws Exception {

ExecutionEnvironment env =ExecutionEnvironment.getExecutionEnvironment();

// 从文件中读取数据

String inputPath = "D:\\javaFlink\\src\\main\\resources\\hello.txt";

DataSet inputDataSet = env.readTextFile(inputPath);

// 对数据集进行处理,按空格分词展开,转换成(word, 1)二元组进行统计

DataSet> wordCountDataSet=

inputDataSet.flatMap(new MyFlatMapper())

.groupBy(0) // 按照第一个位置的word分组

.sum(1); // 将第二个位置上的数据求和

wordCountDataSet.print();

}

} hello.txt

hello world

hello flink

hello spark

hello scala

how are you

fine thank you

and you自定义类,实现FlatMapFunction接口 public class MyFlatMapper implements FlatMapFunction> {

@Override

public void flatMap(String value, Collector> out) throws Exception {

// 按空格分词

String[] words = value.split(" ");

// 遍历所有word,包成二元组输出

for (String word : words) {

out.collect(new Tuple2<>(word, 1));

}

}

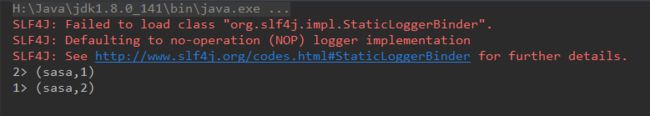

} 控制台打印

(scala,1)

(you,3)

(flink,1)

(world,1)

(hello,4)

(and,1)

(are,1)

(thank,1)

(fine,1)

(how,1)

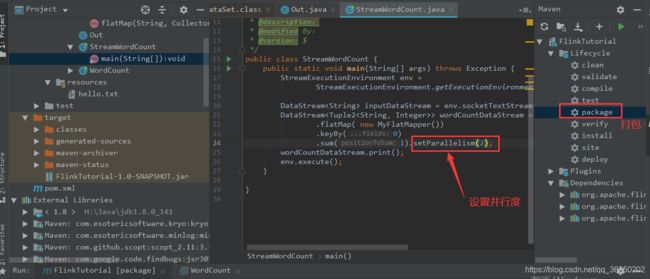

(spark,1)2.3 流处理 wordcount

public class StreamWordCount {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env =

StreamExecutionEnvironment.getExecutionEnvironment();

DataStream inputDataStream = env.socketTextStream("locahost", 7777);

DataStream> wordCountDataStream = inputDataStream

.flatMap( new MyFlatMapper())

.keyBy(0)

.sum(1);

wordCountDataStream.print().setParallelism(2);

env.execute();

}

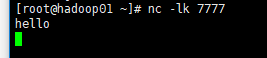

} 在linux系统用netcat命令

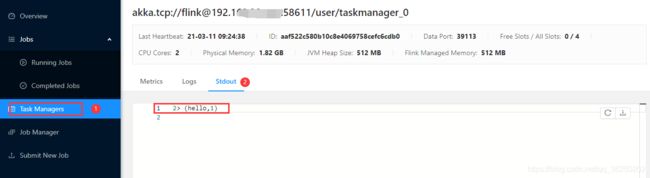

运行程序控制台打印结果

第三章 Flink 部署

3.1 Standalone 模式

3.1.1 安装

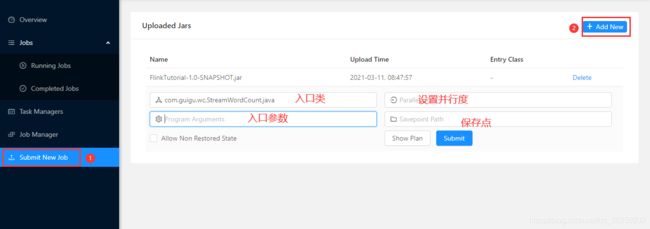

2.提交Job

并行度优先级:代码设置>job页面设置>集群配置设置

提示:因为socket的IP与端口是在代码中写死的:1.不需要在job页面传参,2.要先起启动nc -lk 7777(不然job启动后会报错)

运行结果

发送数据

控制台打印

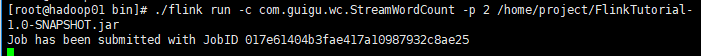

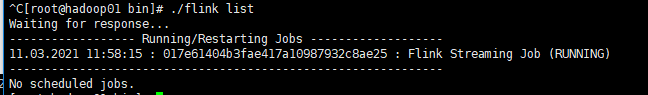

linuxJob提交

linux集群上查看Job任务

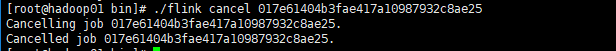

命令停止Job

3.2 Yarn 模式

3.2.1 Flink on Yarn

- 一个 Job 会对应一个集群,每提交一个作业会根据自身的情况,都会单独向 yarn申请资源,直到作业执行完成,一个作业的失败与否并不会影响下一个作业的正常提交和运行。独享 Dispatcher 和 ResourceManager,按需接受资源申请;适合规模大长时间运行的作业。

- 每次提交都会创建一个新的 flink 集群,任务之间互相独立,互不影响,方便管理。任务执行完成之后创建的集群也会消失。

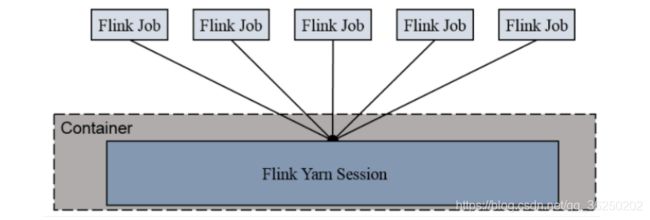

3.2.2 Session Cluster

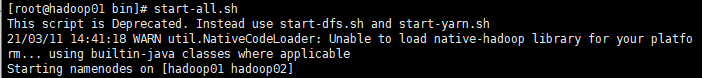

1) 启动 hadoop 集群

集群搭建与启动请参考:大数据框架搭建集群安装配置步骤大全_任错错的博客-CSDN博客_大数据框架搭建

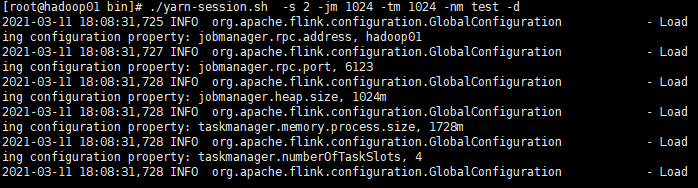

2) 启动 yarn-session

./yarn-session.sh -n 2 -s 2 -jm 1024 -tm 1024 -nm test -d其中:

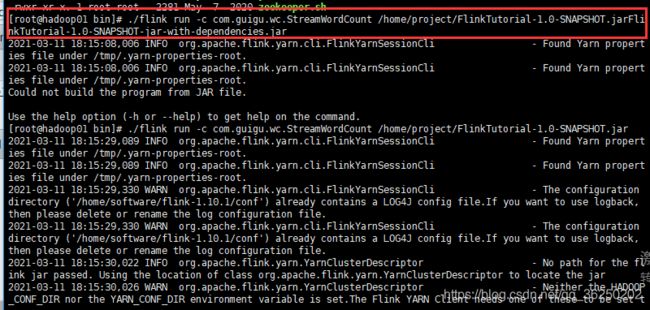

3) 执行任务

./flink run -c /home/project/com.atguigu.wc.StreamWordCount

FlinkTutorial-1.0-SNAPSHOT-jar4) 去 yarn 控制台查看任务状态

5) 取消 yarn-session

yarn application --kill application_1615456690948_0001

3.2.2 Per Job Cluster

1) 启动 hadoop 集群

集群搭建与启动请参考:大数据框架搭建集群安装配置步骤大全_任错错的博客-CSDN博客_大数据框架搭建

启动遇到的错误:

1. The main method caused an error: Could not deploy Yarn job cluster.

System times on machines may be out of sync. Check system time and time zones.

第四章 Flink 运行架构

第四章 Flink 运行架构

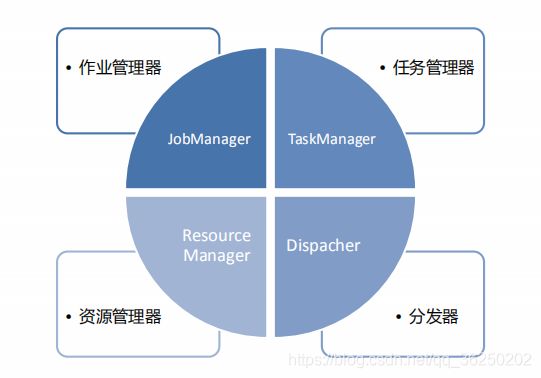

4.1 Flink 运行时的组件

Flink 运行时架构主要包括四个不同的组件,它们会在运行流处理应用程序时协同工作:

⚫ 作业管理器(JobManager)

⚫ 任务管理器(TaskManager)

⚫ 分发器(Dispatcher)

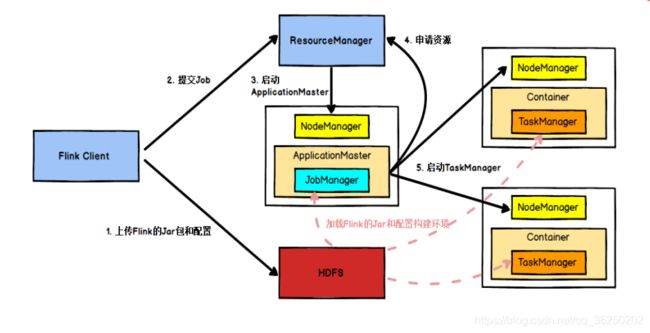

具体地,如果我们将 Flink 集群部署到 YARN 上,那么就会有如下的提交流程:

- Flink 任务提交后,Client 向 HDFS 上传 Flink 的 Jar 包和配置。

- 之后向 Yarn ResourceManager 提交任务,ResourceManager 分配 Container 资源并通知对应的 NodeManager 启动 ApplicationMaster,ApplicationMaster 启动后加载 Flink 的 Jar 包和配置构建环境,然后启动 JobManager,之后 ApplicationMaster 向 ResourceManager申请资源启动 TaskManager , ResourceManager 分 配 Container 资 源 后 , 由 ApplicationMaster 通 知 资 源 所 在 节 点 的 NodeManager 启 动 TaskManager ,NodeManager 加载 Flink 的 Jar 包和配置构建环境并启动 TaskManager,TaskManager启动后向 JobManager 发送心跳包,并等待 JobManager 向其分配任务。

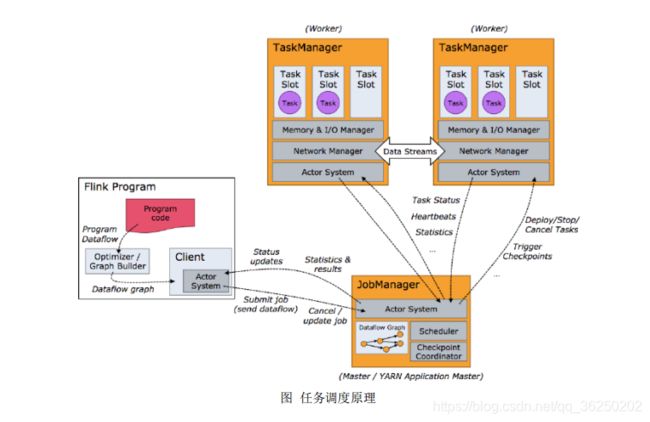

4.3 任务调度原理

- 客户端不是运行时和程序执行 的一部分,但它用于准备并发送dataflow(JobGraph)给 Master(JobManager),然后,客户端断开连接或者维持连接以等待接收计算结果。

- 当 Flink 集 群 启 动 后 , 首 先 会 启 动 一 个 JobManger 和一个或多个的TaskManager。由 Client 提交任务给 JobManager,JobManager 再调度任务到各个TaskManager 去执行,然后 TaskManager 将心跳和统计信息汇报给 JobManager。TaskManager 之间以流的形式进行数据的传输。上述三者均为独立的 JVM 进程。

- Client 为提交 Job 的客户端,可以是运行在任何机器上(与 JobManager 环境连通即可)。提交 Job 后,Client 可以结束进程(Streaming 的任务),也可以不 结束并等待结果返回。

- JobManager 主 要 负 责 调 度 Job 并 协 调 Task 做 checkpoint, 职 责 上 很 像 Storm 的 Nimbus。从 Client 处接收到 Job 和 JAR 包等资源后,会生成优化后的 执行计划,并以 Task 的单元调度到各个 TaskManager 去执行。

- TaskManager 在启动的时候就设置好了槽位数(Slot),每个 slot 能启动一个 Task,Task 为线程。从 JobManager 处接收需要部署的 Task,部署启动后,与自 己的上游建立 Netty 连接,接收数据并处理。

思考:

并行度(Parallelism)

TaskManager 和 Slots

- Flink 中每一个 worker(TaskManager)都是一个 JVM 进程,它可能会在独立的线程上执行一个或多个 subtask。

- 为了控制一个 worker 能接收多少个 task,worker 通过 task slot 来进行控制(一个 worker 至少有一个 task slot)。

- 每个 task slot 表示 TaskManager 拥有资源的一个固定大小的子集。假如一个TaskManager 有三个 slot,那么它会将其管理的内存分成三份给各个 slot。资源 slot化意味着一个 subtask 将不需要跟来自其他 job 的 subtask 竞争被管理的内存,取而代之的是它将拥有一定数量的内存储备。需要注意的是,这里不会涉及到 CPU 的隔离,slot 目前仅仅用来隔离 task 的受管理的内存。

- 通过调整 task slot 的数量,允许用户定义 subtask 之间如何互相隔离。如果一个 TaskManager 一个 slot,那将意味着每个 task group 运行在独立的 JVM 中(该 JVM可能是通过一个特定的容器启动的),而一个 TaskManager 多个 slot 意味着更多的subtask 可以共享同一个 JVM。而在同一个 JVM 进程中的 task 将共享 TCP 连接(基于多路复用)和心跳消息。它们也可能共享数据集和数据结构,因此这减少了每个task 的负载。

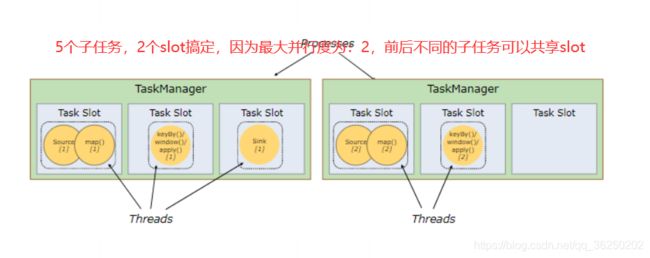

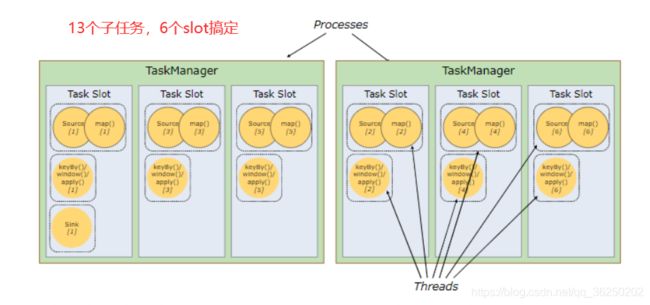

如果是5个子任务用五个slot,当数据量很大的时候,就会出现有的任务资源浪费与有的任务资源紧张 ,并且容易出现数据堆积问题。俗话讲就是:忙的忙死,闲的闲死,因为有的子任务没有复杂的计算只是简单的处理一下数据格式。

- 默认情况下,Flink 允许子任务共享 slot,即使它们是不同任务的子任务。 这样的结果是,一个 slot 可以保存作业的整个管道(具体的完整的stream处理过程,如果其他的TaskManager挂掉了,job任务依然可以执行,只是并行度降低了,能够很好的保证运行的健壮性及运行的效率都会提升)。

(注意:提前必须是前后发生不同的子任务,并行的子任务必须分开,不然提现不到并行度的作用)

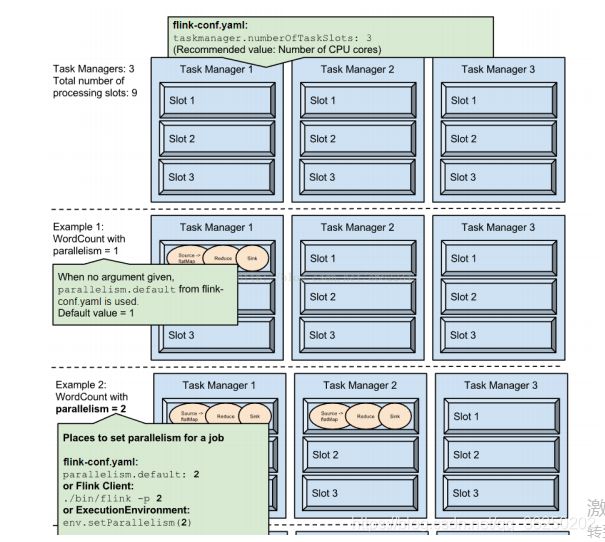

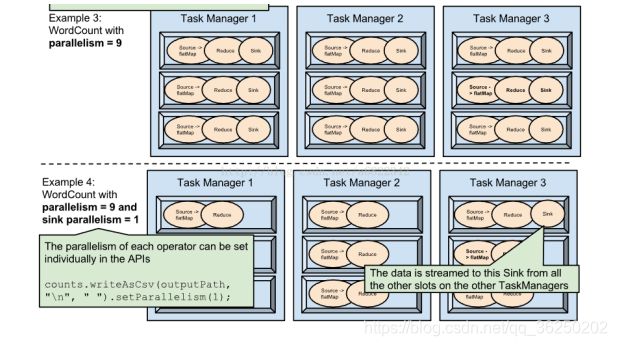

- Task Slot 是静态的概念,是指 TaskManager 具有的并发执行能力可以通过参数 taskmanager.numberOfTaskSlots 进行配置;而并行度 parallelism 是动态概念即 TaskManager 运行程序时实际使用的并发能力,可以通过参数 parallelism.default进行配置。

- 也就是说,假设一共有 3 个 TaskManager,每一个 TaskManager 中的分配 3 个 TaskSlot,也就是每个 TaskManager 可以接收 3 个 task,一共 9 个 TaskSlot,如果我 们设置 parallelism.default=1,即运行程序默认的并行度为 1,9 个 TaskSlot 只用了 1个,有 8 个空闲,因此,设置合适的并行度才能提高效率

并行子任务的分配

4.3.2 程序与数据流(DataFlow)

- 所有的Flink程序都是由三部分组成的: Source 、Transformation 和 Sink。

- Source 负责读取数据源,Transformation 利用各种算子进行处理加工,Sink负责输出

- 在运行时,Flink 上运行的程序会被映射成“逻辑数据流”(dataflows),它包含了这三部分。每一个 dataflow 以一个或多个 sources 开始以一个或多个 sinks 结束。dataflow 类似于任意的有向无环图(DAG)。在大部分情况下,程序中的转换运算(transformations)跟 dataflow 中的算子(operator)是一一对应的关系,但有时候,一个 transformation 可能对应多个 operator。

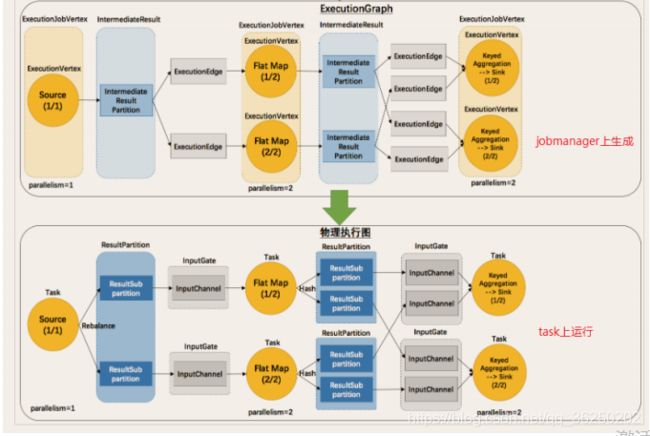

4.3.3 执行图(ExecutionGraph)

- Flink 中的执行图可以分成四层:StreamGraph -> JobGraph -> ExecutionGraph -> 物理执行图

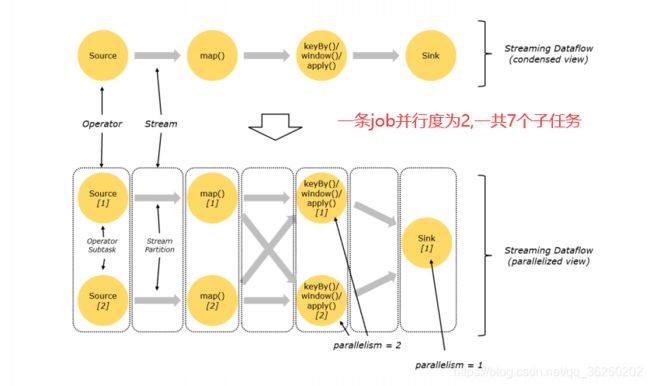

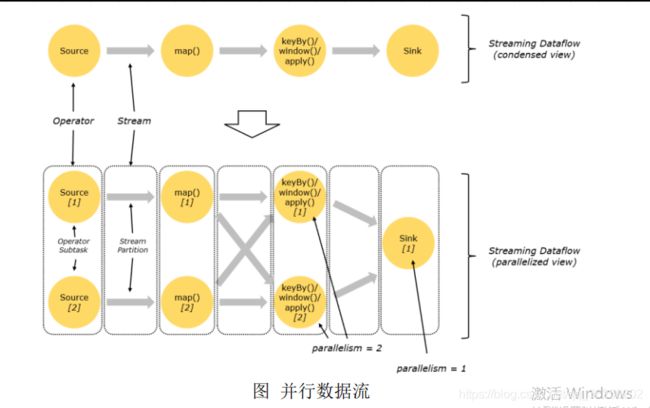

4.3.4 并行度(Parallelism)

- Flink 程序的执行具有并行、分布式的特性。

- 在执行过程中,一个流(stream)包含一个或多个分区(stream partition),而每一个算子(operator)可以包含一个或多个子任务(operator subtask),这些子任务在不同的线程、不同的物理机或不同的容器中彼此互不依赖地执行。

- 一个特定算子的子任务(subtask)的个数被称之为其并行度(parallelism)。 一般情况下,一个流程序的并行度,可以认为就是其所有算子中最大的并行度。一个程序中,不同的算子可能具有不同的并行度。

- Stream 在算子之间传输数据的形式可以是 one-to-one(forwarding)的模式也可以是 redistributing 的模式,具体是哪一种形式,取决于算子的种类。

- One-to-one:stream(比如在 source 和 map operator 之间)维护着分区以及元素的顺序。那意味着 map 算子的子任务看到的元素的个数以及顺序跟 source 算子的子 任务生产的元素的个数、顺序相同,map、fliter、flatMap 等算子都是 one-to-one 的对应关系。

- Redistributing:stream(map()跟 keyBy/window 之间或者 keyBy/window 跟 sink之间)的分区会发生改变。每一个算子的子任务依据所选择的 transformation 发送数据到不同的目标任务。例如,keyBy() 基于 hashCode 重分区、broadcast 和 rebalance会随机重新分区,这些算子都会引起 redistribute 过程,而 redistribute 过程就类似于Spark 中的 shuffle 过程。