《统计学习方法》学习笔记之第一章

统计学习方法的学习笔记:第一章

目录

第一节 统计学习的定义与分类

统计学习的概念

统计学习的分类

第二节 统计学习方法的基本分类

监督学习

无监督学习

强化学习

第三节 统计学习方法三要素

模型

策略

第四节 模型评估与模型选择

训练误差与测试误差

过拟合与模型选择

第五节 正则化和交叉验证

正则化:实现结构风险最小化策略

交叉验证

第六节 泛化能力

泛化误差

泛化误差上界

二分类问题

第七节 生成模型与判别模型

生成模型和判别模型

生成模型VS判别模型

第八节 监督学习的应用

分类问题

标注问题

回归问题

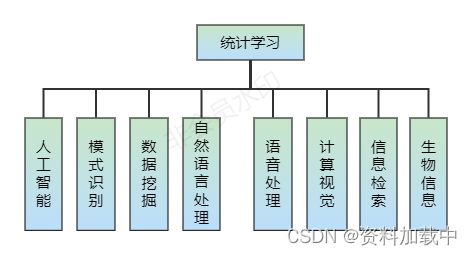

第一节 统计学习的定义与分类

统计学习的概念

- 以计算机和网络为平台

- 以数据为研究对象

- 以预测和分析数据为目的

- 以方法为中心

- 是多领域交叉的学科

定义:

统计学习(Statistical Machine Learning)是关于计算机基于数据后见概率统计模型并运用模型对数据进行预测与分析的一门学科。

统计学习方法的具体步骤:

- 得到一个有限的训练数据集合

- 确定学习模型的集合(模型)

- 确定模型选择的准则(策略)

- 实现求解最优模型的算法(算法)

- 通过学习方法选择最优模型

- 利用学习的最有名模型对新数据进行预测和分析

统计学习的分类

第二节 统计学习方法的基本分类

监督学习

定义:监督学习(Supervised Learning)是指从标注数据中学习预测模型的机器学习问题,其本质是学习输入到输出的映射的统计规律。

- 输入空间(Input Space):输入的所有可能取值的集合

- 实例(Instance):每一个具体的输入,通常由特征向量(Feature Vector)表示

- 特征空间(Feature Space):所有特征向量存在的空间

- 输出空间(Output Space):输出的所有可能取值的集合

例:核技巧

输入空间:![]() ; 实例:

; 实例:![]()

![]()

![]()

根据变量类型不同:

-输入变量与输出变量均为连续变量的预测问题(回归问题)

-输出变量为有限个离散变量的预测问题(分类问题)

-输入变量与输出变量均为变量序列的预测问题(标注问题)

符号表示

- 输入变量:X;输入变量的取值:x

- 输出变量:Y;输出变量的取值:y

- 输入实例x的特征向量表示:

![]()

- 以

表示多个输入变量中的第i个变量:

表示多个输入变量中的第i个变量:

![]()

- 样本容量为N的训练集:

![]()

- 监督学习的基本假设:X和Y具有联合概率分布P(X,Y)

- 监督学习的目的:学习一个输入到输出的映射,这一映射以模型表示

- 模型的形式:条件概率分布P(Y|X)或决策函数Y=f(X)

- 假设空间(Hypothesis Space):所有这些可能模型的集合

对具体的输入进行相应的输出与测试,表达为:

P(y|x)或y=f(x)

无监督学习

定义:无监督学习(Unsupervised Learning)是指从无标注数据中学习预测模型的机器学习问题,其本质是学习数据中的统计规律或潜在结构。

监督学习VS无监督学习

- 输入空间:

- 隐式结构空间:

- 模型:函数

,条件概率分明

,条件概率分明 或条件概率分布

或条件概率分布

- 假设空间(Hypothesis Space):所有这些可能模型的集合

- 目的:选出在给定评价标准下的最优模型

- 样本容量为N的训练集:

![]()

强化学习

第三节 统计学习方法三要素

统计学习方法=模型+策略+算法

模型

定义:假设空间(Hypothesis Space):所有可能的条件概率分布或决策函数,用F表示

- 若定义为决策函数的集合:

- F是有一个参数向量决定的函数族构成:

- 参数空间:

例:线性回归

实例:![]()

决策函数:![]()

向量形式:![]() ,其中,

,其中,![]()

若定义为条件概率的集合:![]()

F由一个参数向量决定的条件概率分布族构成:

![]()

例:Logistic回归

实例:![]()

条件概率分布:

策略

损失函数:度量模型一次预测的好坏,记作![]()

风险函数:度量平均意义下模型预测的好坏

![]()

经验风险:模型![]() 关于训练集的平均损失

关于训练集的平均损失

其中,训练集![]()

四种常见的损失函数

- 0-1损失函数(分类问题)

- 平方损失函数(回归问题)

- 绝对损失函数(回归问题)

- 对数损失函数(概率模型)

经验风险最小化:

![]()

结构风险:

![]()

结构风险最小化:

![]()

根据大数定律,当样本容量N->正无穷时,经验风险趋近于风险函数

结构风险在经验风险的基础上加了正则项(针对模型的复杂度),平衡了经验风险和模型的复杂度

选取目标函数:经验风险函数或者结构风险函数

最优模型:不存在显示解析解的情况下,可以使用梯度下降的数值运算方法

第四节 模型评估与模型选择

训练误差与测试误差

1. 训练误差

- 学习到的模型:

- 训练集(Training Set):

![]()

- 训练误差(Training Error):

2. 测试误差

- 学习到的模型:

- 训练集(Test Set):

![]()

- 训练误差(Test Error):

误差率(Error Rate):

准确率(Accuracy):

注:

![]()

M次多项式:

![]()

经验风险:

带入多项式:

通过最小二乘法求解参数。

过拟合与模型选择

过拟合(Over-Fitting):学习所的模型包含参数过多,出现对已知数据预测很好,但对位置数据预测预测很差的现象。

第五节 正则化和交叉验证

正则化:实现结构风险最小化策略

- 一般形式:

- 经验风险:

- 正则化项:

![]()

其中,![]() 权衡经验风险和模型复杂度

权衡经验风险和模型复杂度

最常见的两种正则化项

范数:

范数:

使某些参数为零,可以起到特征筛选的作用,稀疏模型,非零参数个数很少

范数:

范数:

![]()

参数可以无限接近于零,使得模型越来越简单,防止过拟合。

奥卡姆剃刀原理

在模型选择时,选择所有可能模型中,能很好解释已知数据并且十分简单的模型。

交叉验证

数据充足的情况下:

- 训练集(Training Set):用以训练模型

- 验证集(Validation Set):用以选择模型

- 测试集(Test Set):用以最终对学习方法的评估

数据不充足的情况下:

- 简单交叉验证:随机将数据分为两部分,即训练集和测试集

- S折交叉验证:随机将数据分为S个互不相交、大小相同的子集,其中以S-1个子集作为训练集,余下的子集作为测试集

- 留一交叉验证:S折交叉验证的特殊情形,S=N,在数据非常缺乏的情况下使用

第六节 泛化能力

泛化误差

若所学习到的模型是![]() ,那么这个模型对未知数据预测的误差即为泛化误差(Generalization Error):

,那么这个模型对未知数据预测的误差即为泛化误差(Generalization Error):

![]()

损失函数的期望值,所求的积分是在全样本上进行的

泛化误差上界

泛化误差上界(Generalization Error Bound):指泛化误差的概率上界。两种学习方法的优劣,通常通过他们的泛化误差上界进行比较。

性质:

- 样本容量的函数:当样本容量增加时,泛化上界趋于0

- 假设空间容量的函数:假设空间容量越大,模型就越难学,泛化误差上界就越大

假设空间:所有可能的模型

例子:

二分类问题

- 训练数据集:

![]()

其中,T是从联合概率分布P(X,Y)独立同分布产生的, ![]()

- 假设空间:

![]()

其中,d是函数个数

假设![]() ,损失函数为0-1损失,

,损失函数为0-1损失,

期望风险:

![]()

经验风险:

经验风险最小化:

![]() 的泛化能力:

的泛化能力:

![]()

定理(泛化误差上界):

对于二分类问题,当假设空间是有限个函数的集合![]() 时,对于

时,对于![]() ,至少以概率

,至少以概率![]() ,

,![]() ,以下不等式成立:

,以下不等式成立:

![]()

训练误差![]() ,泛化误差上界

,泛化误差上界![]()

其中,

d为假设空间中函数的个数,N表示i训练集中的样本个数;N趋于无穷大,![]() 趋于0;当d趋于无穷大时,即假设空间越来越复杂时,泛化误差上界增大。

趋于0;当d趋于无穷大时,即假设空间越来越复杂时,泛化误差上界增大。

泛化误差上界定理证明:

Hoeffding不等式(第一版)

Hoeffding不等式(第二版)

设![]() 是独立随机变量,且

是独立随机变量,且![]()

![]() 是

是![]() 的经验平均值,

的经验平均值,![]() ,则对任意

,则对任意![]() ,以下不等式成立:

,以下不等式成立:

第一版:

第二版:

证明:

![]() ,则

,则

:

:

![]()

![]()

- 对所有的i,

![]()

:

:

![]()

![]()

根据Hoeffding不等式,对![]() ,有:

,有:

![]()

假设空间有限,则,

![]()

![]()

或者等价于,![]()

![]()

令![]() ,

,

![]()

又,

![]()

因此,对![]() ,至少以概率

,至少以概率![]() ,以下不等式成立:

,以下不等式成立:

![]()

第七节 生成模型与判别模型

生成模型和判别模型

生成模型

由数据学习联合概率分布P(X,Y),然后求出P(Y|X)作为预测模型,即生成模型(Generative Model):

![]()

典型的生成模型:朴素贝叶斯法、隐马尔可夫模型

注:输入和输出变量要求为随机变量

判别模型

由数据直接学习决策函数f(X)或者条件概率分布P(Y|X)作为预测模型,即判别模型(Discriminative Model)

典型的判别模型:k近邻法、感知机、决策树等

注:不需要输入和输出变量均为随机变量

生成模型VS判别模型

生成模型:

- 所需数据量较大

- 可还原联合概率分布P(X,Y)

- 收敛速度更快

- 能反映同类数据本身得相似度

- 隐变量存在时,仍可以使用生成模型

判别模型:

- 所需样本的数量少于生成模型

- 可直接面对预测,准确率更高

- 可见化学习问题

- 不可以反映数据本身的特性

第八节 监督学习的应用

分类问题

分类准确率

对于给定的测试数据集,分类器正确分类的样本数与总样本数之比成为分类准确率:

I表示当预测出来的分类与真实的类别一致时为1,否则为0

二分类问题:

| 真实 预测 |

正类 |

负类 |

| 正类 |

TP |

FP |

| 负类 |

FN |

TN |

精确率:

![]()

召回率:

![]()

F1-Score:

![]()

分类方法:感知机、k近邻、朴素贝叶斯、决策树、Logistic回归

应用:银行业务、网络安全、图像处理、手写识别、互联网搜索

标注问题

训练集:

![]()

-输入观测序列:

![]()

-输出观测序列:

![]()

学习的模型:

![]()

预测

-新的输入观测序列:

![]()

-预测的输出标记序列:

![]()

方法:

隐马尔可夫模型

条件随机场

应用:

信息抽取

自然语言处理

例:

输入:At Microsoft Research,we have an insatiable curiosity and the desire to create new technology that will help define the computing experience.

输出:At/O Microsoft/B Research/E,we/O have/O an/O insatiable/B curiosity/E and/O the/O desire/BE to/O create/O new/B technology/E that/O will/O help/O define/O the/O computing/B experience/E.

回归问题

反映输入和输出的映射问题。

类型:

-按输入变量个数:一元回归、多元回归

-按输入和输出变量之间关系:线性回归、非线性回归

损失函数:平方损失

应用领域:商务领域

参考资料:

《统计学习方法》第二版

参考视频:

【合集】十分钟 机器学习 系列视频 《统计学习方法》_哔哩哔哩_bilibili

![P[S_N-E(S_N)\geq t] \leq \exp[-\frac{2t^2}{\sum\limits_{i=1}^N(b_i-a_i)^2}]](http://img.e-com-net.com/image/info8/b520e2afd5b9449f99850f9e68b483f3.png)

![P[E(S_N)-S_N\geq t] \leq \exp[-\frac{2t^2}{\sum\limits_{i=1}^N(b_i-a_i)^2}]](http://img.e-com-net.com/image/info8/c9d37bf8e3334f3483353036b7d0bb8e.png)

![P[\overline{X}-E(\overline{X})\geq t] \leq \exp[-\frac{2N^2t^2}{\sum\limits_{i=1}^N(b_i-a_i)^2}]](http://img.e-com-net.com/image/info8/823bc10f4f4c453db799989946058a3f.png)

![P[E(\overline{X})-\overline{X}\geq t] \leq \exp[-\frac{2N^2t^2}{\sum\limits_{i=1}^N(b_i-a_i)^2}]](http://img.e-com-net.com/image/info8/883c80291eed43109bda70af897594ad.png)

![\Rightarrow P[\frac{S_N}{N}-E(\frac{S_N}{N})\geq \frac{t}{N}] \leq \exp[-\frac{2t^2}{\sum\limits_{i=1}^N(b_i-a_i)^2}]](http://img.e-com-net.com/image/info8/ae1493576a0246a6a44d29da14dda1fd.png)

![P[\overline{X}-E(\overline{X})\geq t'] \leq \exp[-\frac{2(t'N)^2}{\sum\limits_{i=1}^N(b_i-a_i)^2}]](http://img.e-com-net.com/image/info8/204b7842e6c447648798ab2c953f52e2.png)