大模型,重构自动驾驶

编|王一粟

大模型如何重构自动驾驶?答案已经逐渐露出水面。

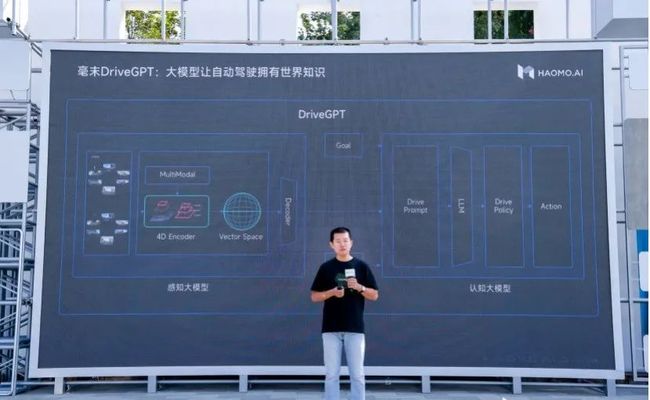

“在大数据、大模型为特征,以数据驱动为开发模式的自动驾驶3.0时代,自动驾驶大模型将在车端、云端上实现一个统一的端到端的平台管理。”毫末智行CEO顾维灏在近日的HAOMO AI DAY上表示。

大模型对自动驾驶的改变,下至感知、认知、数据标注等的底层技术框架,上至对之前技术方案的模型剪枝、蒸馏。自动驾驶在这个过程中,也变得“越来越懂”我们身处的真实世界。

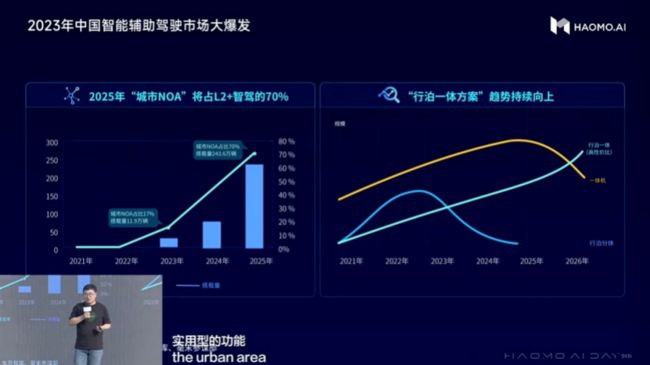

当前,随着自动驾驶技术的进步,预计将来也会有越来越多的量产车得以落地。据工信部的数据,当前乘用车市场L2及以上智能驾驶渗透率已达42.4%,预计到2025年将达到70%,并普及到10~20万的主流车型上。

面对智能汽车产品端的放量和技术普及的需求,市场正在呼唤着,更具性价比的成熟智能驾驶方案。此前昂贵的智能驾驶产品,正在迎来一个全新的“千元级”机遇。

而这也意味着,拿到更多智能驾驶订单的玩家,将积累更多的车型行驶数据。进而转化成迭代速度更快的数据飞轮,反哺到场上的自动驾驶能力。

大模型,重塑了自动驾驶,也即将揭开自动驾驶降本大战的序幕。

大模型正在重构自动驾驶

“在自动驾驶3.0阶段,自动驾驶开发呈现以大数据、大模型、大算力为核心特征,以数据驱动为开发的模式。”对于大模型重塑后的智能驾驶,顾维灏如此解释道。

首先,在数据的训练上,自动驾驶原本的训练方式是使用人工标注的数据去训练,但引入大模型之后,已经可以使用自动化的标注技术来大规模、自动化地标注4D Clips(一段时间内,所有传感器接受的数据信息),并且将大模型的训练从有监督训练升级到了自监督训练。

不仅如此,大模型还可以利用生成式AI的能力,自动生成视频来加强训练。通过构建4D表征空间,使得CV Backbone(提取视觉输入图像信息)能够学到三维的几何结构、图片纹理、时序信息等全面的物理世界信息,相当于把整个世界装入到神经网络当中。

于是,大模型解决了之前人工智能最被人戏谑的“有多少人工就有多少智能”的问题,自动化的数据标注和训练,让自动驾驶成为了一台“永动机”。

接下来,在足够的数据驱动下,自动驾驶的开发模式也随之改变。

此前的自动驾驶研发主要由任务驱动。开发过程主要基于解决特定任务所采集的小数据,构建小模型来完成。一个具体需求,对应一个具体功能,表面上看似一个个功能开发迅速,汽车智驾的场景在一个个被“攻关”。但实际上这种开发模式只能以需求为导向,在特定问题的限制下,难以穷尽真实世界之广袤,于是各种corner case 无法解决,自动驾驶也就难以真正落地。

在技术框架上,自动驾驶3.0阶段利用云端实现感知和认知大模型能力进行突破。

原本在车端的各类小模型,逐步统一到感知和认知模型中,完成车端智驾系统整合到一个完整的大模型中去。同时在云端,大模型通过剪枝、蒸馏等方式逐步提升车端的感知能力。在通讯环境好的地方,大模型甚至可以通过车云协同的方式实现远程控车。最终实现,在车端和云端上端到端的自动驾驶大模型。

从技术框架层面,将大模型引入自动驾驶的效果,我们可以参考特斯拉的表现。2020年,特斯拉引入BEV+Transformer(BEVFormer),取代上一代2D+CNN算法。

在Transformer的注意力(Attention)机制下,特斯拉增强了模型对全局的理解能力,降低了来自不同传感器数据融合的难度。实现支持汽车生成BEV(鸟瞰图),让汽车了解周围环境就像是“开天眼”一般顺畅。

汽车能够更全面地看到世界,是感知大模型的功劳。

以毫末的方案为例。在对真实物理世界的学习中,毫末使用了NeRF(三维重建)技术整合,将真实世界建模到三维空间,再加上时序形成4D向量空间。

在此基础上,通过引入开源的图文多模态大模型,实现4D向量空间到语义空间的对齐。利用图文多模态大模型对画面的描述能力,自动驾驶获得了跟人类一样“识别万物”的能力。

在GPT-4V最新的测试中,将下面的图片直接输入给ChatGPT,就能像人类一样,精准的描述出图片环境中的驾驶策略。

接下来,汽车想要“动”起来,还需要认知大模型的能力,才能给出合适的指令。

在语义感知大模型构建的“识别万物”能力的基础上,毫末通过构建驾驶语言(Drive Language)来描述驾驶环境和驾驶意图,再结合导航引导信息以及自车历史动作,并借助外部大语言模型LLM的海量知识来辅助给出驾驶解释和驾驶建议。

大语言模型LLM的意义,在于将世界知识引入到驾驶策略中来。当自动驾驶认知决策获得了人类社会的常识和推理能力(世界知识),将大幅度提升自动驾驶策略的可解释性和泛化性。

如此一来,在通用认知大模型和通用感知大模型的帮助下,自动驾驶形成了“看得清”、“看得懂”,还“知道接下来怎么做”的能力。

在引入大模型两年后,2022年特斯拉在算法中引入时序网络,从而将BEV“全景地图”升级为占用网络(occupancy Network)。以BEV“看到”的道路上,不再分析路上“有什么”,以判断汽车能否通过的方式,从而决策汽车下一步“走还是停”。

直到2023年8月,特斯拉实现了依靠车载摄像头和神经网络识别道路和交通情况,端到端的自动驾驶系统(FSD Beta V12)。

但即使如此,大模型与自动驾驶的深度结合也才刚刚开始,在感知和认知的能力上依然有很大的提升空间。

三个能力升级:

纯视觉、更广、更小

在结合多模态大模型之后,实际的效果怎么样呢?

在测试的实验结果中,毫末在纯视觉泊车、城市NOH(等同于城市领航辅助驾驶)、和小目标障碍物检测上取得了明显的进展。

这意味着,在大模型加入后,自动驾驶在能力上,出现了质的提升。

首先是在泊车环境中,验证了纯视觉感知实现功能的可行性。

毫末采用了四个视野宽广的鱼眼摄像头作为其视觉BEV的感知基础,获取汽车周围360°的画面。然后对图像进行虚拟相机转换,通过backbone技术提取出画面的视觉特征,并映射到BEV空间。在BEV空间下,完成对障碍物的轮廓边界进行识别和测量。从而识别墙、柱子、车辆等各类型的边界轮廓,实现360°的全视野动态感知。15米内精度可以达到30cm,2米内精度可以高于10cm。

以当前的结果来看,纯视觉的感知方案已经可以替代之前USS(超声波雷达)来识别汽车周边障碍物的方案。在未来,毫末完全可能去掉当前配置的12个USS。

就像是特斯拉在新款Model 3上去掉所有雷达一样,进一步增强纯视觉感知的能力,从而节省一组USS大约150元的制造成本。

在城市NOH的进展上,毫末已经可以实现对各类交通标志、地面箭头、甚至井盖等交通场景的全要素覆盖。

例如在红绿灯的识别问题中,由于国内的红绿灯形态不尽相同,道路上横的、竖的、只显示读秒的、联排的,甚至因损坏而不停闪烁的都有。对于人类来说,识别这些红绿灯及其状态轻而易举,但对于之前的自动驾驶就需要对这些不同形状的红绿灯都进行学习训练。

在通用大模型加入后,自动驾驶展现出了万物识别的泛化能力。大模型在帮助自动驾驶积累大量相关场景的物体的同时,还帮助优化了车端感知模型,进而能够识别更多道路场景要素。

最后是小目标障碍物检测上,当前毫末城市NOH可以在城市道路场景中,在时速最高70公里的50米距离外,就能检测到大概高度为35cm的小目标障碍物,可以做到100%的成功绕障或刹停。

“毫末目前引入的大模型方法,本质上是在提升车端模型的泛化性”,毫末智行数据智能科学家贺翔解释道。

从上述的几项进展中可以清晰看到,在大模型的泛化能力引入后,自动驾驶开始展现出更强的数据理解能力、更精准的物体分类认识能力和更强的识别能力。

随后对于自动驾驶近期的发展上,贺翔判断:“我个人判断,可能今年到明年之间,是自动驾驶黎明之前的黑暗,我们可能会迎来一个巨大的爆发。”

大模型加入,智驾降本战打响

在新能源汽车时代下,由中国极限制造所影响的汽车供应链,正在将汽车消费引导至更着重考虑性价比的方向。

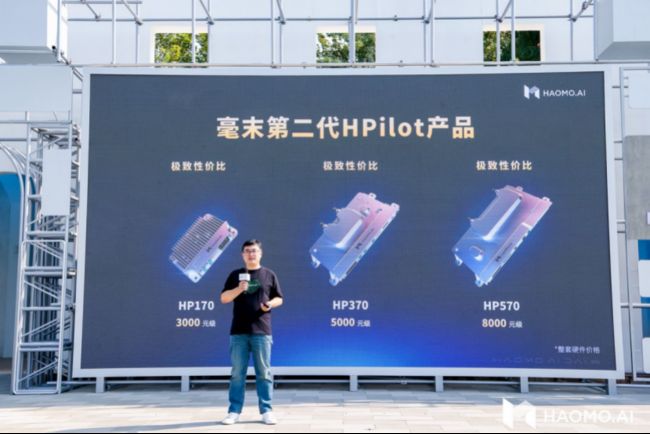

在智驾领域上,Tier1已经把成本从此前的几十万元断崖式压缩到了千元级别。

近日,毫末发布了三款千元级无图NOH产品。HP170、HP370和HP570,产品分别对应算力为5TOPS、32TOPS和72(或100)TOPS。分别对应智驾等级为包含行泊一体的高速无图 NOH、城市记忆行车和城市全场景无图 NOH,售价为3000、5000和8000元级。

在落地产品上,毫末的产品已经搭载至超过20款车型。其中包含长城汽车旗下的山海炮PHEV版和新摩卡Hi-4S等车型。

高性价比的智驾方案,破解了当下20万以上汽车才能搭配高阶智驾的局面。以毫末、大疆为首的汽车Tier1们,正在推动10万~20万元主导性价比的汽车产品中,展开智驾配置的竞争。

例如大疆在宝骏云朵灵犀版上配备了行泊一体智能驾驶方案,能够支持无图高速NOA和带有短途路线记忆功能。但这款汽车产品起售价仅为12.58万起。

另一边,相比于大疆、易航智能、纽劢等暂时仅有高速NOA的汽车Tier1们,在大模型加持下,拥有城市NOA能力的毫末,能够让合作的车厂们以更高的性价比,对技术先进的厂商开启竞争。

参考毫末的城市NOA方案,8000元级的定价虽不包含激光雷达,但也在价格上相对其他厂商拥有一定的优势。

据兴业证券测算,国内能够实现城市NOA功能的硬件成本预估为2.5-3万元。其中,传感器成本约为5000-10000元,单颗激光雷达价格约为3000-5000元,智驾域控制器成本约为1.5-2.5万元。

对比没有激光雷达的特斯拉方案,在其最新的HW4.0系统内,参考Greentheonly 的拆解推算成本。特斯拉HW4.0总计物料成本约为1500-2100美元。换算为人民币,特斯拉的方案硬件成本已然超过万元。

便宜可得的高阶智驾能力,让车厂能够在不同价格区间的产品拥有更高的智能化性价比。

在我们此前《自动驾驶攻城战,华为小鹏先亮剑》的研究中,大部分自主品牌车企对城市NOA的支持主要靠消费者在汽车配置上加价来实现。选购城市NOA功能需要的增配的加价幅度在2-6万元不等。其中,加价2万升级的小鹏G6是重点车型里加价最少的产品。

然而,当下的智能化性价比竞争中,9月25日小鹏在新款P5上砍掉了昂贵的激光雷达,将高速NOA支持车型下探至了15-20万区间。

而这也意味着,高阶辅助驾驶即将成为15-20万价格区间的标配。

消费者可以不用,但智能化的功能产品必须要有。某种意义上,智能汽车正在走向类似于手机“卷”芯片堆各种配置的老路。

而在大模型加持下自动驾驶,伴随着大模型在感知和认知能力的泛化,自动驾驶也将以越来越低的价格,配置到越来越多的车型上去。

当下的自动驾驶,距离爆发越来越近了。就像是那首《我们走在大路上》所唱,“我们走在大路上,意气风发斗志昂扬……”