2023 年 MathorCup 数学建模大数据竞赛(A题)|基于计算机视觉的坑洼道路检测和识别|建模秘籍&文章代码思路大全

铛铛!小秘籍来咯!

小秘籍希望大家都能轻松建模呀,mathorcup比赛也会持续给大家放松思路滴~

抓紧小秘籍,我们出发吧~

来看看MathorCup 数学建模大数据竞赛的A题

问题重述

问题一:基于计算机视觉的坑洼道路检测和识别

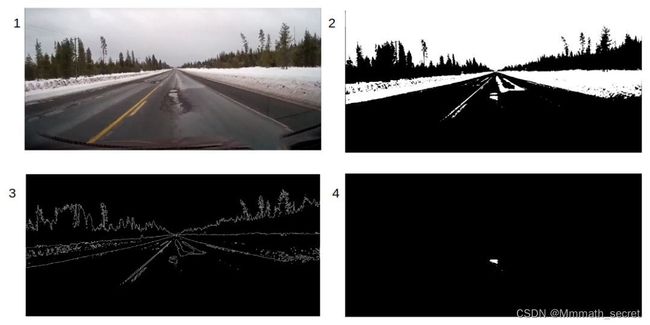

问题描述:坑洼道路检测和识别是一种计算机视觉任务,旨在通过数字图像(通常是地表坑洼图像)识别出存在坑洼的道路。这对于地质勘探、航天科学和自然灾害等领域的研究和应用具有重要意义。传统的分类算法在坑洼图像的复杂性和多变性面前效果有限。因此,近年来深度学习技术的发展提供了新的解决方案。本问题要求构建一个识别坑洼道路的模型。

具体任务如下:

问题1:结合给出的图像文件,提取图像特征,建立一个识别率高、速度快、分类准确的模型,用于识别图像中的道路是正常或者坑洼。

问题2:对问题1中构建的模型进行训练,并从不同维度进行模型评估。

问题3:利用已训练的模型识别测试集中的坑洼图像,并将识别结果放在“test_result.csv”中。

问题二:使用其他建模方法,给出问题一的具体建模的思路

问题描述:除了深度学习方法,还可以考虑使用其他数学模型和机器学习算法来解决坑洼道路检测和识别问题。本问题要求提供另一种建模方法的具体思路。

具体任务如下:

问题2:使用其他建模方法,给出问题一的具体建模思路,包括模型选择、特征提取、数据预处理等步骤。

问题三:使用已训练的模型对测试数据进行坑洼道路的识别

问题描述:在问题一中,已建立了一个坑洼道路检测和识别模型。现在需要使用这个已训练的模型来对测试数据进行坑洼道路的识别。测试数据包括数千张道路图像,每张图像需要被模型判定为正常道路或坑洼道路,并将识别结果保存在CSV文件中。

具体任务如下:

问题3:使用已训练的坑洼道路检测模型对测试数据进行识别,并将识别结果放在“test_result.csv”文件中,该文件应包括以下字段:

fnames:测试图片的文件名label:分类标识,1表示正常道路,0表示坑洼道路

问题思路

问题一:

-

特征提取:

- 首先,进行图像特征提取,将图像转化为数值特征。可以使用各种特征提取方法,例如颜色直方图、纹理特征(如灰度共生矩阵)、形状特征等。

-

数据准备:

- 准备训练数据集,包括图像特征和相应的标签。标签为二元值(0表示坑洼,1表示正常道路)。

-

特征标准化:

- 对提取的特征进行标准化,以确保不同特征的尺度一致。标准化通常使用以下公式:

X standardized = X − μ σ X_{\text{standardized}} = \frac{X - \mu}{\sigma} Xstandardized=σX−μ

其中, X X X是原始特征, μ \mu μ是特征的均值, σ \sigma σ是特征的标准差。

- SVM模型选择:

- 选择SVM作为分类器。SVM的目标是找到一个分隔超平面,以最大化支持向量(距离超平面最近的样本点)之间的间隔。分类公式为:

f ( x ) = sign ( w ⋅ x + b ) f(x) = \text{sign}(\mathbf{w} \cdot \mathbf{x} + b) f(x)=sign(w⋅x+b)

其中, w \mathbf{w} w是法向量, x \mathbf{x} x 是特征向量, b b b 是截距。

-

SVM训练:

- 使用训练数据集对SVM模型进行训练,以找到最佳的分隔超平面。

-

模型评估:

- 使用验证数据集来评估SVM模型的性能。常用的评估指标包括准确率、召回率、精确度、F1分数等。

-

超参数调优:

- 根据需要,进行超参数调优,例如SVM的核函数选择、正则化参数C的选择等。

-

模型部署:

- 一旦满足性能要求,将SVM模型部署到实际应用中,用于坑洼道路的检测和识别。

import numpy as np

from sklearn import svm

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

# 特征提取(示例中使用灰度直方图作为特征,你可以根据实际情况选择其他特征)

def extract_features(images):

# 这里使用灰度直方图作为示例特征提取方法

features = []

for image in images:

hist, _ = np.histogram(image.ravel(), bins=256, range=(0, 256))

features.append(hist)

return features

# 数据准备

def prepare_data():

# 你需要编写加载训练数据集的代码,包括图像和相应标签

# 这里使用示例数据,请根据实际情况替换为你的数据

images = np.random.rand(300, 64, 64) # 示例随机生成图像数据

labels = np.random.randint(2, size=300) # 示例随机生成标签

return images, labels

# 特征标准化

def standardize_features(features):

# 使用均值和标准差进行标准化

mean = np.mean(features, axis=0)

std = np.std(features, axis=0)

standardized_features = (features - mean) / std

return standardized_features

# SVM模型训练

def train_svm(features, labels):

clf = svm.SVC(kernel='linear', C=1.0)

clf.fit(features, labels)

return clf

# 模型评估

def evaluate_model(model, features, labels):

predictions = model.predict(features)

accuracy = accuracy_score(labels, predictions)

precision = precision_score(labels, predictions)

recall = recall_score(labels, predictions)

f1 = f1_score(labels, predictions)

return accuracy, precision, recall, f1

# 示例用法

if __name__ == '__main':

#见完整代码

问题二

以下是使用随机森林的具体建模思路:

问题二的建模思路(使用随机森林):

-

特征提取:

- 进行图像特征提取,将图像转化为数值特征。可以使用各种特征提取方法,例如颜色直方图、纹理特征、形状特征等。

-

数据准备:

- 准备训练数据集,包括图像特征和相应的标签。标签为二元值(0表示坑洼,1表示正常道路)。

-

特征标准化:

- 对提取的特征进行标准化,以确保不同特征的尺度一致。标准化通常使用以下公式:

X standardized = X − μ σ X_{\text{standardized}} = \frac{X - \mu}{\sigma} Xstandardized=σX−μ

其中,(X) 是原始特征,(\mu) 是特征的均值,(\sigma) 是特征的标准差。

- 随机森林模型选择:

- 选择随机森林作为分类器。随机森林是一种集成学习方法,通过构建多个决策树并对它们的结果进行集成来进行分类。分类公式为:

f ( x ) = majority vote ( tree 1 ( x ) , tree 2 ( x ) , … , tree n ( x ) ) f(x) = \text{majority vote}(\text{tree}_1(x), \text{tree}_2(x), \ldots, \text{tree}_n(x)) f(x)=majority vote(tree1(x),tree2(x),…,treen(x))

其中, tree i ( x ) \text{tree}_i(x) treei(x)是第 i棵决策树的分类结果。

-

随机森林训练:

- 使用训练数据集来训练随机森林模型,它将学习如何将图像特征映射到类别标签。

-

模型评估:

- 使用验证数据集来评估随机森林模型的性能。常用的评估指标包括准确率、召回率、精确度、F1分数等。

-

超参数调优:

- 根据需要,进行超参数调优,以提高模型性能。这可以通过交叉验证来实现。

-

模型部署:

- 一旦满足性能要求,将随机森林模型部署到实际应用中,用于坑洼道路的检测和识别。

import numpy as np

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

# 特征提取(示例中使用灰度直方图作为特征,你可以根据实际情况选择其他特征)

def extract_features(images):

# 这里使用灰度直方图作为示例特征提取方法

features = []

for image in images:

hist, _ = np.histogram(image.ravel(), bins=256, range=(0, 256))

features.append(hist)

return features

# 数据准备

def prepare_data():

# 你需要编写加载训练数据集的代码,包括图像和相应标签

# 这里使用示例数据,请根据实际情况替换为你的数据

images = np.random.rand(300, 64, 64) # 示例随机生成图像数据

labels = np.random.randint(2, size=300) # 示例随机生成标签

return images, labels

# 特征标准化

def standardize_features(features):

# 使用均值和标准差进行标准化

mean = np.mean(features, axis=0)

std = np.std(features, axis=0)

standardized_features = (features - mean) / std

return standardized_features

# 随机森林模型训练

def train_random_forest(features, labels):

clf = RandomForestClassifier(n_estimators=100, random_state=0)

clf.fit(features, labels)

return clf

# 模型评估

def evaluate_model(model, features, labels):

predictions = model.predict(features)

accuracy = accuracy_score(labels, predictions)

precision = precision_score(labels, predictions)

recall = recall_score(labels, predictions)

f1 = f1_score(labels, predictions)

问题三

-

加载已训练的模型:

- 从文件中加载已训练的模型,该模型是在问题一中或其他任务中训练好的用于坑洼道路检测和识别的模型。

-

加载测试数据:

- 加载测试数据集,包括待识别的坑洼图像。确保测试数据集的格式与模型期望的输入格式一致。

-

图像预处理:

-

对测试数据进行与训练数据相同的图像预处理步骤,以确保数据与模型的输入匹配。这包括图像归一化、缩放、通道处理等操作。

-

图像归一化:通常,图像像素值需要被归一化到固定的范围,例如[0, 1]或[-1, 1]。这有助于减小数据的变化范围,使模型更容易处理。

-

图像缩放:模型通常对固定尺寸的图像进行训练,因此测试图像需要被缩放到相同的尺寸。这可以通过插值方法来实现,例如双线性插值。

-

通道处理:如果训练数据和模型期望的输入通道数不匹配,需要进行通道处理。例如,如果模型预期输入是RGB图像,但测试数据是灰度图像,需要将灰度图像扩展为RGB。

-

-

模型预测:

- 使用加载的已训练模型对测试数据进行预测。模型将输出预测结果,通常是概率值或类别标签。

-

结果保存:

- 将模型的预测结果保存在CSV文件中,该文件应包括测试图片的文件名和相应的分类标识。你可以使用Python的CSV库来生成CSV文件。

import numpy as np

import pandas as pd

from sklearn.externals import joblib # 用于加载已训练的模型

# 加载已训练的模型

model = joblib.load('trained_model.pkl') # 替换为你的模型文件路径

# 加载测试数据

test_data = load_test_data() # 替换为加载测试数据的代码

# 图像预处理(示例中仅包括图像归一化)

def preprocess_image(image):

# 图像归一化,将像素值缩放到 [0, 1] 范围

normalized_image = image / 255.0

return normalized_image

# 遍历测试数据并进行预测

predictions = []

for image in test_data:

preprocessed_image = preprocess_image(image)

# 模型预测,通常是输出概率值或类别标签

prediction = model.predict([preprocessed_image])

predictions.append(prediction[0]) # 假设模型输出是类别标签

# 创建包含测试结果的DataFrame

完整思路代码看这里:

2023 年 MathorCup 数学建模大数据竞赛(A题)