Math VISTA:多模态大模型之视觉上下文条件下的数学推理能力评估

Overview

- MathVISTA

-

- 总览

- 摘要

- 一:引言

- 二:MATHVISTA数据集

-

- 2.1 收集指南

- 2.2 数据采集

- 2.2 元数据标注

- 2.4 数据准备和发布

- 2.5 数据分析

- 三: 实验

-

- 3.1 评估手段

- 3.2 实验设置

- 3.3 实验结果

- 3.4 细粒度结果

- 3.5 定性分析

- 4 相关工作

- 5 总结

- 6 附录

- 7 思考

MathVISTA

总览

题目: MATHVISTA: EVALUATING MATH REASONING IN VISUAL CONTEXTS WITH GPT-4V, BARD, AND OTHER LARGE MULTIMODAL MODELS

机构:UCLA,华盛顿大学,微软

论文: https://arxiv.org/pdf/2310.02255.pdf

代码: https://mathvista.github.io/

任务: 多模态大模型的数学推理能力评测

特点: 引入了一个数学推理能力的评测集MATH Vista,包含七种数学推理类型,五个主要任务,31个子数据集,并且在LLM,visual augmented LLM,开源LMM,以及两个专有 LMM(即 GPT-4V、Bard)展开了广泛的评测(人类表现60.3%)

前置相关工作:多模态VQA数据集(自然场景 + 数学/科学 + 人造数据集),LLM,LMM,CoT,PoT

摘要

大型语言模型(LLM)和大型多模态模型(LMM)在许多任务和领域中表现出令人印象深刻的问题解决能力,但它们在视觉上下文中的数学推理能力尚未得到系统研究。为了弥补这一差距,我们推出了 MATHVISTA,这是一个旨在结合来自不同数学和视觉任务的挑战的基准。它由 6,141 个示例组成,源自 28 个涉及数学的现有多模态数据集和 3 个新创建的数据集(即 IQTest、FunctionQA 和 PaperQA)。完成这些任务需要细粒度、深入的视觉理解和组合推理,所有最先进的基础模型都认为这具有挑战性。通过 MATHVISTA,我们对 12 个著名的基础模型进行了全面、定量的评估。表现最好的 GPT-4V 模型的总体准确率达到 49.9%,大大超过表现第二好的 Bard 15.1%。我们的深入分析表明,GPT-4V的优越性主要归因于其增强的视觉感知和数学推理。然而,GPT-4V 仍比人类表现低 10.4%,因为它经常难以理解复杂的数字并进行严格的推理。这一巨大差距凸显了 MATHVISTA 在开发能够处理数学密集型和视觉丰富的现实世界任务的通用人工智能代理方面将发挥的关键作用。我们进一步探索了 GPT-4V 的新自我验证能力(self-verification)、自我一致性(self-consistency)应用以及交互式聊天机器人功能,凸显了其未来研究的广阔潜力。

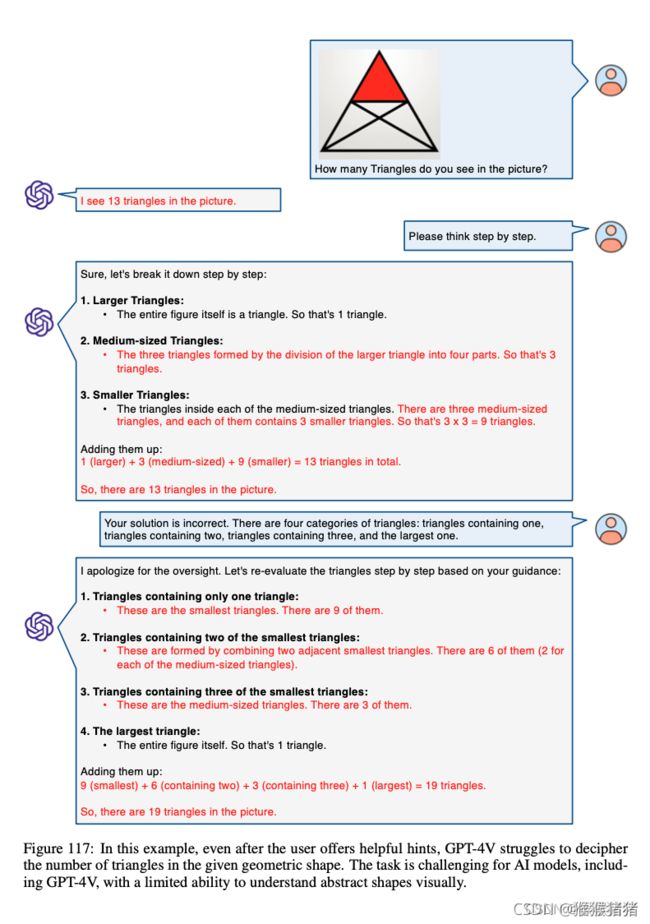

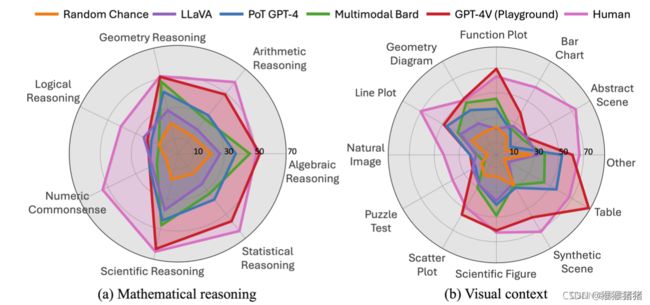

图 1:一个领先的 LLM(即 PoT GPT-4)、四个著名的 LMM、随机选项和人类在我们提出的 MATHVISTA 上跨数学推理和视觉上下文类型的表现的准确性。 PoT GPT-4 是一种文本、程序辅助的LLM(基于Bard caption和 OCR 文本)。 GPT-4V 通过 Playground 聊天机器人手动评估。

一:引言

数学推理是system-2推理的一个独特方面,它证明了人类智能的复杂性(Kahneman,2011)。它需要严格的逻辑思维、特定领域的知识以及参与多步骤推理过程的能力(Lightman et al., 2023 Let’s verify step by step)。这种复杂性不仅在文本场景中可见,而且在视觉环境中也很明显。例如,在评估孩子的数学和推理能力时,除了算术计算之外,问题的设计通常还包括视觉上下文(Stipek & Iver,1989;Pollitt et al.,2020)。同时,在视觉环境中具有强大数学推理能力的AI智能体在现实世界中具有广泛的应用,例如解决教育学科中的复杂问题(Seo等,2015;Wang等,2017),帮助分析师对统计数据进行逻辑查询(Wu et al., 2023; Yang et al., 2023a),并协助高级研究领域的定理证明和科学发现(Taylor et al., 2022; Dong et al., 2023) 。

人们已经组织了许多数据集来评估人工智能系统的数学推理能力,其中大多数数据集纯粹以文本形式呈现。 ChartQA(Lu et al., 2021a;Dahlgren Lindström & Abraham, 2022;Masry et al., 2022)等一些数据集探索了视觉语言设置中的数学推理。然而,这些数据集往往要么专注于特定任务,例如数学应用题,要么专注于特定的视觉上下文,例如几何问题或条形图。自然场景上的通用视觉问答(VQA)数据集仅包含一小部分需要数学推理的问题,而在数学框架内对视觉语言推理的全面研究在很大程度上尚未探索。

另一方面,大型语言模型(LLM)(OpenAI,2022;2023a)和大型多模态模型(LMM)(Google,2023 Bard;OpenAI,2023b GPT4-V)在许多任务和领域表现出了令人印象深刻的解决问题的能力。最近,一些研究旨在使用外部工具增强LLMs的数学和科学推理能力(Lu et al., 2023a Chameleon: Plug-and-play compositional reasoning with large language models.)。然而,这些基础模型在视觉环境中执行数学推理的能力尚未得到系统检验。因此,有必要制定一个新的基准,以(1)促进视觉密集场景下数学推理系统的开发,(2)评估LLM和LMM的研究进展,特别是它们解决严格推理任务的能力。

在本文中,我们介绍了 MATHVISTA,一个视觉上下文中的综合数学推理基准。我们提出了task taxonomy来指导 MATHVISTA 的开发:

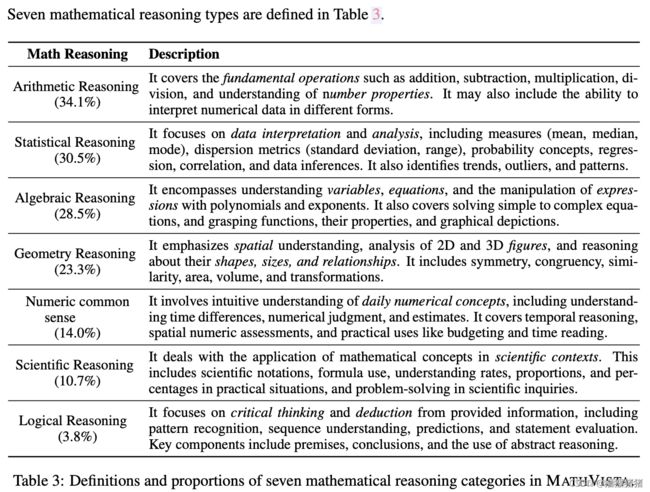

- 我们确定了七种数学推理类型:代数推理(algebraic reasoning)、算术推理(arithmetic reasoning)、几何推理(geometry reason- ing)、逻辑推理(logical reasoning)、数字常识(numeric common sense)、科学推理(scientific reasoning)和统计推理(statistical reasoning);

- 我们专注于五个主要任务:图形问答(FQA)、几何问题求解(GPS)、数学应用题(MWP)、课本问答(TQA)和视觉问答(VQA);

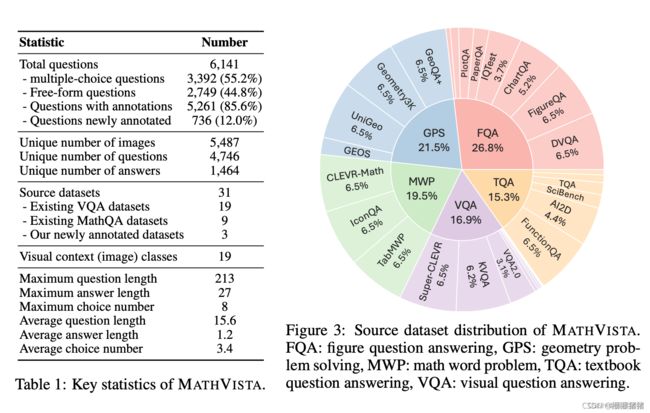

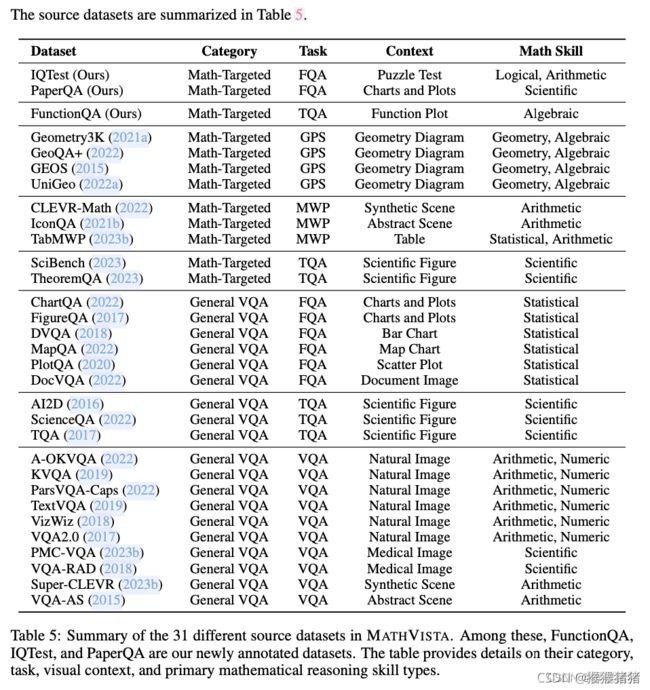

- 我们涵盖了各种各样的视觉环境,包括自然图像、几何图、抽象场景、合成场景以及各种图形、图表和绘图。 MATHVISTA 整合了 28 个现有的多模态数据集,其中包括 9 个数学目标问答(MathQA)数据集和 19 个 VQA 数据集。此外,我们还创建了三个新数据集(即 IQTest、FunctionQA、PaperQA),分别用于评估谜题测试图的逻辑推理(puzzle)、函数图的代数推理(algebraic reasoning over functional plots)以及学术论文图的科学推理。总体而言,MATHVISTA 包含 6,141 个示例,其中 736 个是新策划的(详见表 1)。为了促进细粒度的评估,示例用元数据进行注释,包括问题类型、答案类型、任务类别、年级水平、视觉上下文和所需的推理技能。数据收集的详细描述可以在§2、§B 和§C 中找到。

我们在 MATHVISTA 上进行了广泛的实验,以评估 12 个基础模型的推理能力,这些模型在数学和多模态推理方面具有领先的性能。该集合包括三个 LMM(即 ChatGPT、GPT-4、Claude-2)、两个专有 LMM(即 GPT-4V、Bard)和七个开源 LMM。对于LLMs,我们使用两种提示策略来测试零样本和少样本设置:思维链(CoT)(Wei 等人,2022b)和思维程序(PoT)(Chen 等人,2022b) )。这些LLMs还可以通过现成的图像字幕和 OCR 视觉模型进行增强。我们通过聘请具有高中或更高学历的合格人类注释者来建立人类绩效基线。我们展示了 MATHVISTA,是一个非常具有挑战性的基准,人类的准确率只能达到 60.3%。

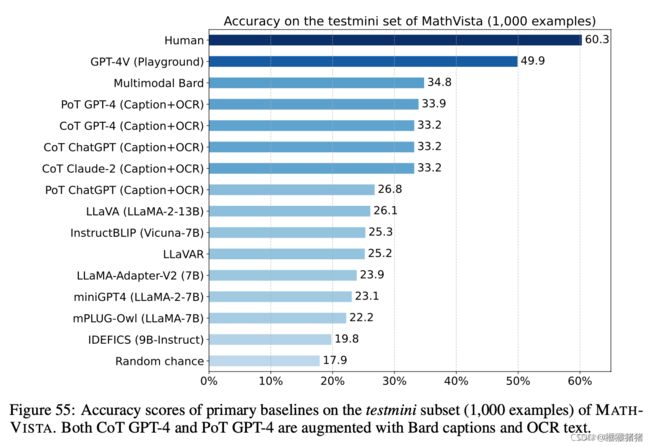

我们的结果表明,CoT GPT-4 是在没有视觉工具增强的情况下表现最好的LLM,总体准确率达到 29.2%。 Multimodal Bard 是表现最好的 LMM,达到了 34.8% (§3.3),仅达到人类表现的 58%(34.8% vs 60.3%)。当使用 Bard 字幕和 OCR 文本进行增强时,PoT GPT-4 获得 33.9%,与 Multimodal Bard (§3.4) 非常接近。进一步的分析表明,多模态Bard模型的失败源于错误的计算以及视觉感知和文本推理引起的幻觉(§3.5)。

通过 MATHVISTA,我们首次报告了 GPT-4V(OpenAI,2023b)(GPT-4 的最新多模态版本)的全面定量和定性评估。值得注意的是,GPT-4V 达到了 ==49.9% ==的最先进准确率,比 Multimodal Bard 显着提高了 15.1%。如图 1 所示,GPT-4V 在涉及代数推理和复杂视觉环境(包括表格和函数图)的一组任务上甚至超越了人类的表现。尽管如此,与人类基线相比,总体准确率仍然存在 10.4% 的差距,这为模型改进留下了很大的空间。我们的深入分析(§G)表明,GPT-4V的优越性主要归因于其强大的视觉感知和数学推理能力。我们进一步强调其自我验证的新兴能力(§G.5)、自我一致性的使用(§G.6)以及目标导向的多轮人类-人工智能对话的能力(§G.7) )。

二:MATHVISTA数据集

2.1 收集指南

如前所述,现有基准存在显着差距,这些基准主要评估文本上下文中的数学推理,忽视了许多数学问题的内在视觉本质。因此,我们的数据集 MATHVISTA 致力于弥合这一差距,为与视觉理解交织在一起的数学推理提供强大的评估基准,从而推动人工智能助手实现通用功能。我们的基准测试遵循以下收集指南:

- 它涵盖多个任务和主题以反映现实世界的应用;

- 它结合了不同的视觉背景和数学技能,以促进全面的评估;

- 它为有效探索和揭示当前模型的潜在局限性提供了不同程度的挑战;

- 它为确定性评估提供了稳健的评估设置。

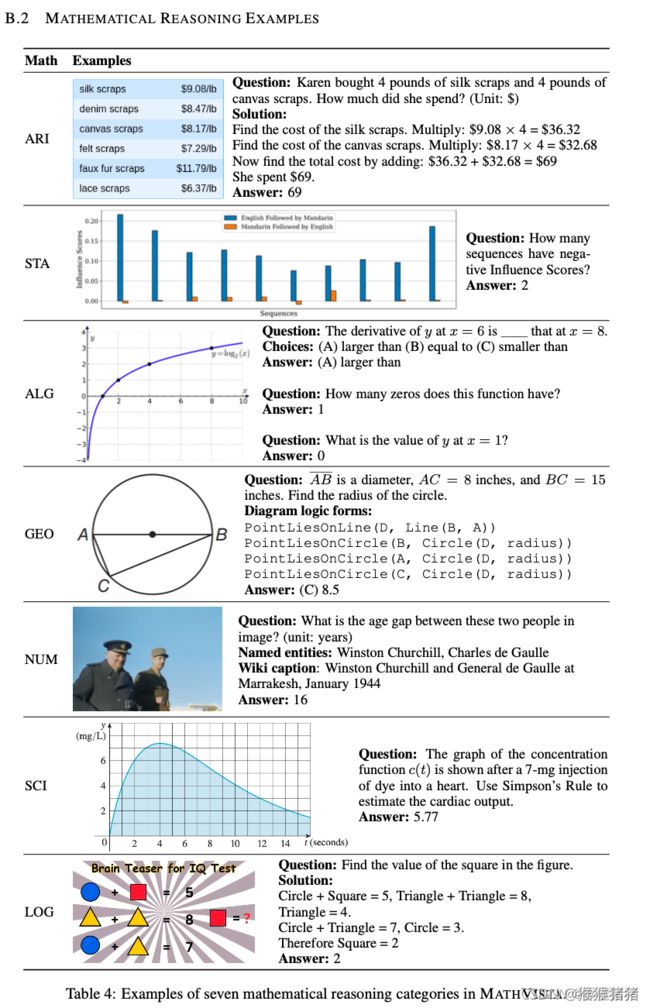

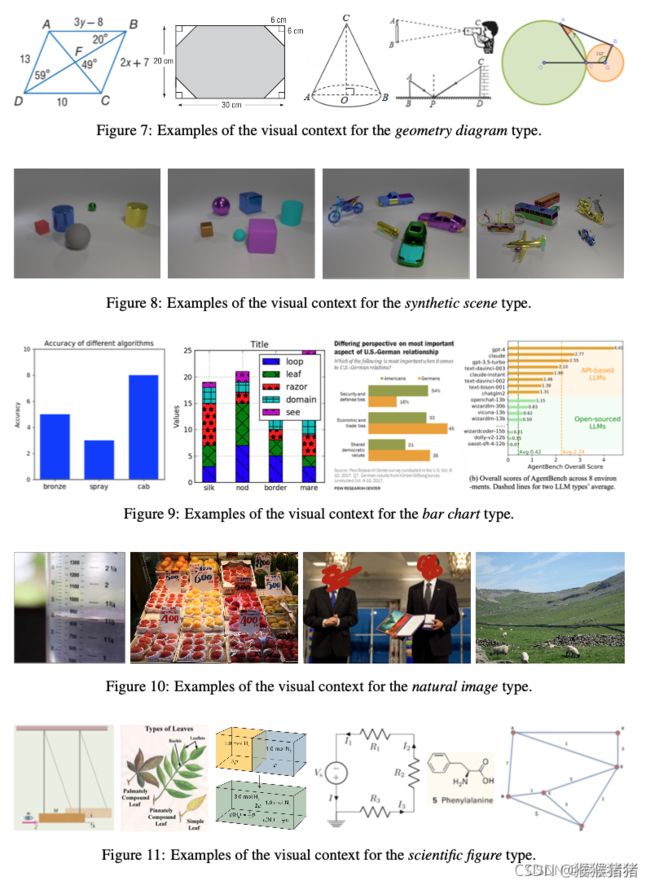

这项工作的分类介绍如下:我们确定了七种数学推理类型:代数推理、算术推理、几何推理、逻辑推理、数值常识、科学推理和统计推理,详细定义见§B.1,示例见§B.2。我们专注于五个主要任务:图形问答(FQA),其核心是对多个图表和图进行统计推理;几何问题求解(GPS),涉及几何主题;数学应用题(MWP),涉及日常场景中的算术推理;教科书问答(TQA),通常需要对科学主题和图形进行知识密集型推理;和视觉问答(VQA)。此外,我们的目标是考虑各种视觉环境,包括自然图像、几何图、抽象场景、合成场景、多个图表和绘图、科学图表、表格、函数图、谜题测试图等等,并附有示例如§B.3 所示。

2.2 数据采集

MathQA 数据集的集合。我们在多模态设置中收集了九个MathQA数据集,其中四个用于GPS,两个用于具有合成场景、抽象图表和表格的视觉上下文的MWP,以及两个用于大学课程的TQA(参见§B.4)。还收集了解决方案(solution)、程序(program)、解析结果和基础定理等注释,为LLMs提供演示示例。每个源数据集最多包含 400 个示例,以确保我们最终编译的基准测试中每个源的平衡表示。我们总共收集了 2,666 个示例。

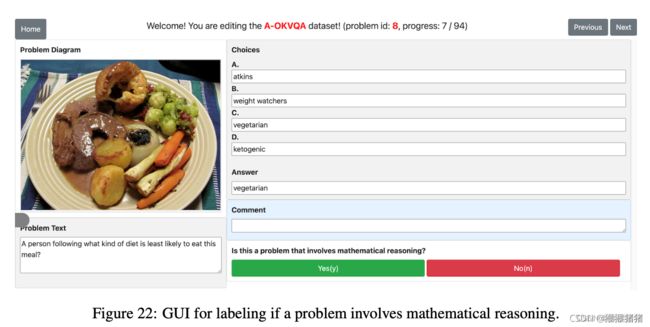

VQA 数据集的审查和收集。许多现有的 VQA 数据集都包含需要数学推理能力的实例,例如算术运算或数字常识。合并这些数据集可以增强问题在任务、领域、视觉上下文和所涉及的推理技能方面的多样性。我们审查了 70 多个数据集,收集了其中 19 个包含数学相关实例且公开可用的数据集,如 §B.4 中所列。由于这些数据集最初并不是以数学为目标的,因此我们最初设计了启发式规则来自动从大量候选数据中选择可能涉及数学推理的示例。选择问题中带有数字答案或包含数量词(如§C.1 中列出)的示例。这种自动过滤产生了 4,949 个 VQA 格式的示例,尽管仍然存在一些误报示例。因此,我们聘请了三位专家注释者来手动标记这些示例,以确定它们是否涉及数学推理(更多详细信息参见§C.2)。利用多数投票并将每个源数据集限制为 400 个示例,我们最终确定了 2,739 个示例的集合。

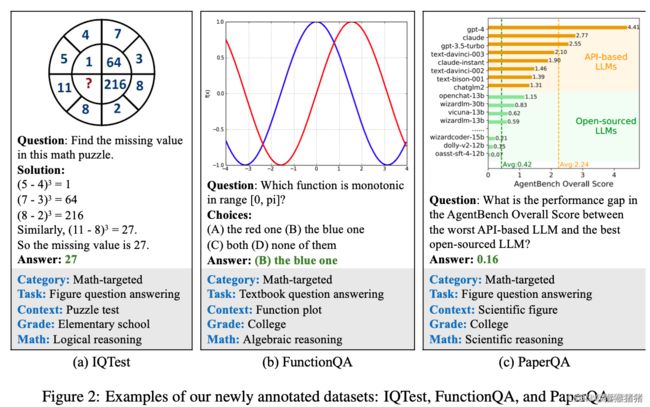

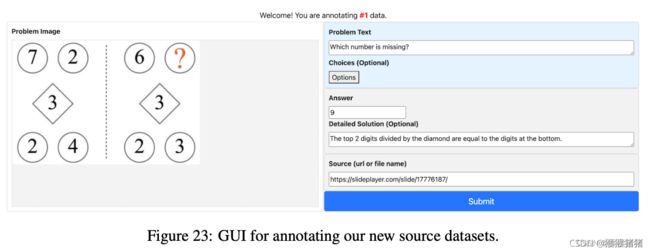

三个新数据集的集合。虽然我们收集的源数据集包含多个视觉背景和数学推理能力,某些场景仍未解决:逻辑谜题测试图推理、函数图统计推理以及科学学术图表的推理,为了解决这些差距,我们引入了三个新数据集:IQTest、FunctionQA、和 PaperQA,示例如图 2 所示。

IQTest 包括 228 个示例,需要归纳推理、抽象思维、模式预测和计算,样例源自谜题测试在线学习平台上。 FunctionQA 有 400 个示例,强调对函数图的细微视觉感知以及关于变量、表达式、方程和函数的代数推理。PaperQA是一个新颖的数据集,其中包含从信息丰富的学术插图中派生出的问题,这些插图包括来自在线教育资源的表格、图形和图表,其中107个样例源自 2023 年 8 月在 Huggingface 上发布的论文。为了确保数据质量,所有问题均由 STEM 领域的研究生手动注释,并通过严格的审核流程进一步完善。注释工具的 GUI 如§C.3 中的图 23 所示。

2.2 元数据标注

细粒度的元数据有助于对模型各个方面的推理能力进行全面分析。为此,我们使用问题类型、答案类型、语言、来源、类别、任务、年级和视觉上下文等信息对 MATHVISTA 中的示例进行注释,这些信息可以从源数据集中提供的详细信息中准确获得。 MATHVISTA 具有七种不同类型的数学推理能力,如表 3 (§B.1) 中分类。

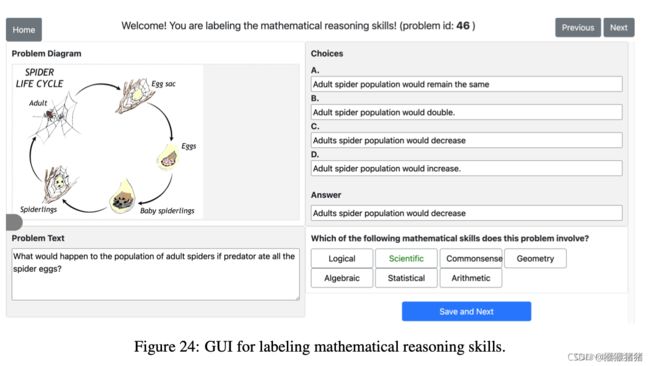

数学推理的粗略标签可以从源数据集的细节中自动获得。为了验证自动注释的质量,专家注释者使用§C.4中所示的注释工具手动标记 7 个候选者的 1,000 个示例的数学推理类别。

结果表明,94.1% 的自动标注和人工标注示例具有推理类型的一致性,而各个标签的一致性达到98.79%,说明数学推理标签的自动标注准确率很高。

2.4 数据准备和发布

MATHVISTA 由 6,141 个示例组成,分为两个子集:testmini 和 test。 testmini 包含 1,000 个示例,旨在用于模型开发验证或计算资源有限的用户。测试集包含剩余的 5,141 个示例用于标准评估。值得注意的是,为了防止数据污染,测试答案标签不会公开发布,并且我们将维护一个在线评估平台。为了确保每个源数据集在 testmini 中得到很好的表示,并保持 testmini 中的分布与整个数据集非常相似,我们采用了以下抽样策略:(1)首先,对每个源数据集随机抽样问题,阈值数量为 4; (2) 然后,根据每个源数据集在整个集合中的比例对剩余问题进行随机抽样。 testmini 集与整个集之间的 KL 散度和Total Variation(TV)距离分别为 0.008 和 0.035,表明 testmini 接近于整个集的分布。我们还进行了多次质量检查,以解决任何未定义的错误。

2.5 数据分析

MATHVISTA的主要统计数据如表1所示。有两种类型的问题:选择题和自由形式。自由形式问题的答案分为整数、浮点数或列表。大量独特的图像、问题和答案确保了 MATHVISTA 中模式的多样性。 MATHVISTA源自31个源数据集,包括三个新注释的数据集,以解决特定视觉上下文中数学推理缺失类型的问题。表 4 (§B.2) 中的数据集示例突出了所涉及的数学推理的丰富性。 §B.3 中的示例展示了 MATHVISTA 中存在的多种视觉上下文。有关数据分析的更多详细信息,请参阅§D。

推理类型的丰富性

视觉上下文的丰富性

三: 实验

之前的工作(Yang et al., 2023b The Dawn of LMMs: Preliminary explorations with gpt-4v(ision).)从定性的角度研究了视觉环境中基础模型的推理能力。相比之下,我们的目标是进行定性和定量研究,以使用 MATHVISTA 对视觉上下文中数学推理能力的现有基础模型进行系统评估。我们为 MATHVISTA 引入了一种专为基础模型量身定制的新颖基准测试策略(第 3.1 节)。模型的选择详见第 3.2 节。定量结果可在第 3.3 节和第 3.4 节中找到,而定性分析则在第 3.5 节中提供。鉴于 GPT-4V 相对于其他模型的显着进步,我们在各个方面与同行进行了深入的比较研究,并 在§G 部分强调了未来研究的潜在途径。

3.1 评估手段

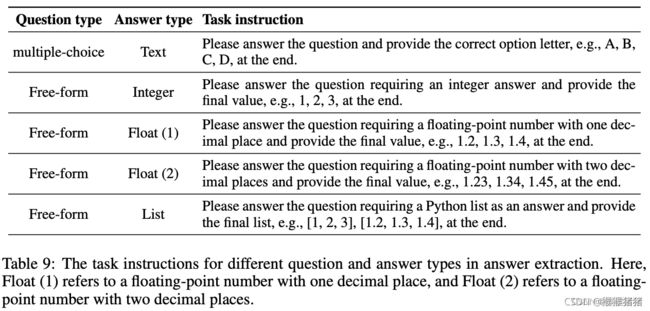

最近的LLMs和LMMs已被指示在传统设置中生成长响应而不是短文本。因此,我们提出了一种新的 MATHVISTA 基准测试策略,与使用人工设计或模板匹配规则不同(Lu et al., 2022 (science VQA))。评估过程包括三个阶段:响应生成、答案提取和分数计算。最初,基线使用表 9(§E.3)中定义的模板生成给定输入查询的响应,其中包含任务描述、问题、选项和元数据。接下来,从详细响应中提取简短答案文本。我们提出了一种基于 LLM(例如 GPT-4)的答案提取器(§E.2),其灵感来自于其卓越的文本处理能力(Wei 等人,2022b)。对 200 个示例的初步研究表明,GPT-4 可以以超过 99.5% 的准确率提取答案文本。最后,将提取的答案标准化为所需的答案格式(例如,选项字母或整数),并计算目标指标分数。利用 MATHVISTA 中的实例要么是文本答案的多项选择题,要么是数字答案的自由形式问题的事实,准确率被用作确定性评估的指标。这个可能也是MATH VISTA的一个短板,即要么是多选,要么是free form的数字答案,对于长文本输出以及其它形式的答案是不支持的。【比如作图题,应用题,计算题】

3.2 实验设置

我们在三种设置下评估 MATHVISTA 上的模型:

- 纯文本 LLM,包括零样本和双样本中的 ChatGPT、GPT-4和 Claude-2(具有思想链(CoT)和思想计划(PoT))

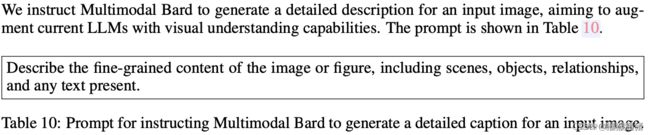

- 增强LLM,其中LLM被提供了额外的视觉信息,包括从 Multimodal Bard生成的图像标题和从 EasyOCR (JaidedAI, 2020) 检测到的 OCR 文本

- 开源/专有LMM模型, IDEFICS-9B (Laurenc ̧on 等人, 2023)、mPLUG-OWL-LLaMA-7B(Ye 等人,2023)、miniGPT-4-LLaMA-2-7B(Zhu 等人,2023a)、LLaMA-Adapter-V2-7B(Gao 等人, 2023)、InstructBLIP-Vicuna-7B(Dai 等人,2023)、LLaVA-LLaMA-2-13B(Liu 等人,2023a)、LLaVAR,以及 Bard 和 GPT-4V 等专有模型。由于 GPT-4V 不提供 API 访问,我们求助于使用 Playground 聊天机器人手动评估它。我们在§E 中提供了 LLM 的提示和用于 LMM 的超参数。

3.3 实验结果

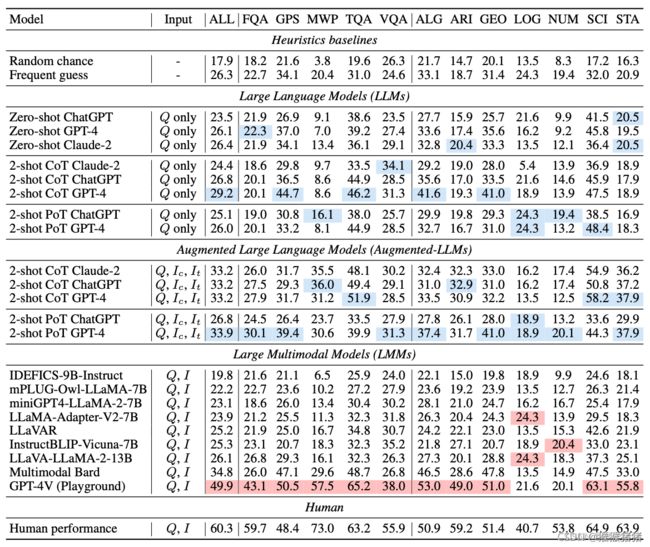

我们在表2中比较了几种模型的性能,包括纯文本 LLM、增强型 LLM 和 MATHVISTA 上的 LMM。我们包括随机选项(即多项选择题中的随机选项之一,以及自由形式问题中为空) )和频率猜测(§E.1)作为最简单的基线。此外,我们使用 Amazon Mechanical Turk 建立了人类表现基线。合格的人类注释者必须具有令人满意的标注历史,成功通过资格示例,并拥有高中或更高学位。我们要求每位注释者在 20 分钟内完成 5 个问题。更多详细信息请参见§E.6。

在纯文本LLMs中,所有模型都优于随机基线,其中使用思想链 (CoT) 的 2-shot GPT-4 促使达到 29.2%。纯文本LLMs的有限性能表明我们的数据集需要模型在视觉上下文中进行推理以获得最佳结果。当配备图像标题和检测到的 OCR 文本时,与 MATHVISTA 上的纯文本对应物相比,增强型LLMs表现出卓越的性能。具体来说,表现最好的增强型 LLM 是采用思维计划 (PoT) 提示的 2-shot GPT-4,得分为 33.9%。该模型生成Python程序来执行,从而促进严格推理。

在 LMM 方面,Multimodal Bard 的准确度为 34.8%,仅为人类表现(60.3%)的 58%。值得注意的是,性能最好的 GPT-4V 模型达到了 49.9%,比 Bard 大幅提高了 15.1%;然而,它仍然比人类表现低 10.4%。这些差距凸显出我们的基准还有很大的进一步改进空间。开源模型(IDEFICS 到 LLaVA)在 MATHVISTA 上的表现并不理想。

表 2:MATHVISTA testmini 子集的准确度得分。输入:Q:问题,I:图像,Ic:图像标题,It:图像中检测到的 OCR 文本。 ALL:总体准确度。任务类型:FQA:图形问答、GPS:几何问题解答、MWP:数学应用题、TQA:课本问答、VQA:视觉问答。数学推理类型:ALG:代数推理、ARI:算术推理、GEO:几何推理、LOG:逻辑推理、NUM:数字常识、SCI:科学推理、STA:统计推理。每个部分和整体模型中的最高分分别以蓝色和红色突出显示。

这可以归因于==开源的LMMs他们缺乏数学推理能力、文本识别(对于数学应用问题有用)、形状检测(对于几何问题有用)和图表理解。==值得注意的是,这些模型利用不同的模型架构来处理视觉(例如,OpenCLIP,CLIP,Vit-G)和语言(例如,LLaMA-1,LLaMA-2),不同的对齐策略(例如,LLaVA中的MLP投影, InstructBLIP 中的 Q-former、mPLUGOwl 中的视觉抽象器)和指令调整数据(例如,来自 LLaVA 数据的 150K 指令响应对、来自 miniGPT-4 的 3,500 个指令响应对)。虽然使用来自文本丰富的图像的指令遵循数据进行微调,但 LLaVAR的表现不佳,这表明强大的文本识别能力并不能保证 MATHVISTA 的高性能,因为 MATHVISTA 需要全面的视觉感知和数学推理。这强调了模型、数据或训练目标方面的创新有巨大的可能性,可以提高 LMM 在 MATHVISTA 上的零样本性能。

比较尴尬的是,许多LMM模型的表现还不如frequent guess,这的确比较尴尬。

3.4 细粒度结果

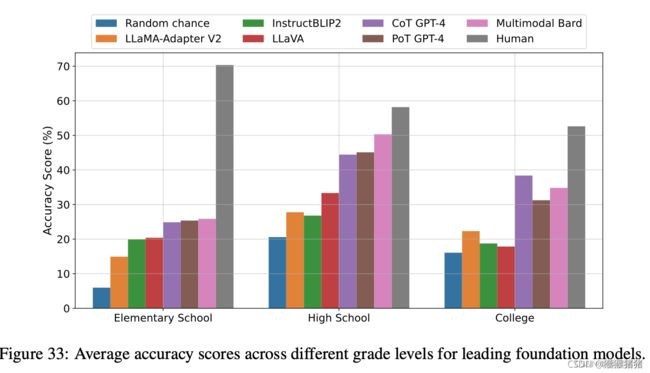

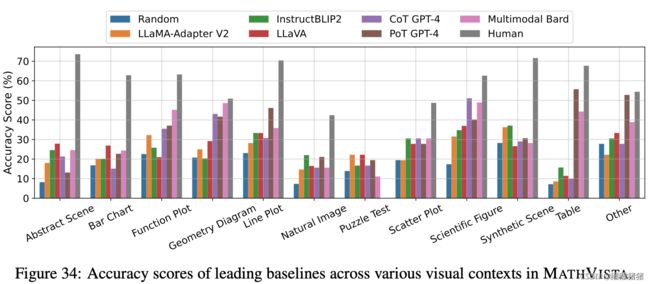

我们还报告了细粒度分数,以全面研究现有模型跨不同任务的能力(表 2)、数学推理能力(表 2)、年级水平(§F.2 中的图 33)和视觉上下文类型(图 1、§F.3 中的图 34)。值得注意的是,GPT-4V 在各个类别中都超越了大多数其他基线,但与逻辑推理和数字常识推理相关的问题除外。值得注意的是,GPT-4V 不仅在几何问题求解 (GPS)、教科书问答 (TQA) 和代数推理等数学推理技能等任务中超越了人类表现,而且在包括函数图、几何图、散点图和表格等视觉上下文上也超越了人类。

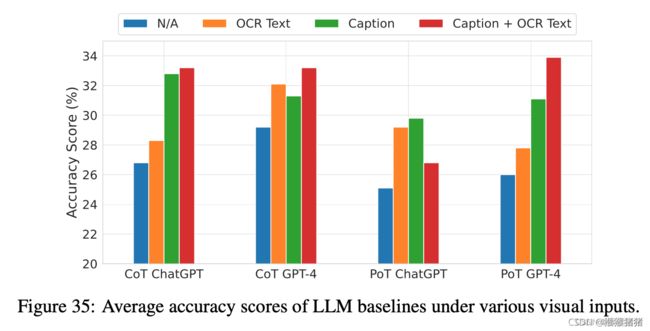

我们对增强的LLMs进行了消融研究,并在表 35 中列出了结果(参见§F.4)。增强型LLMs的性能差距可归因于较差的图像caption(可能无法充分描述视觉上下文中的数学)、OCR 无法检测对几何推理有用的形状,以及缺乏数学推理能力。对 GPT-4V 的深入研究可以在§G 中找到。

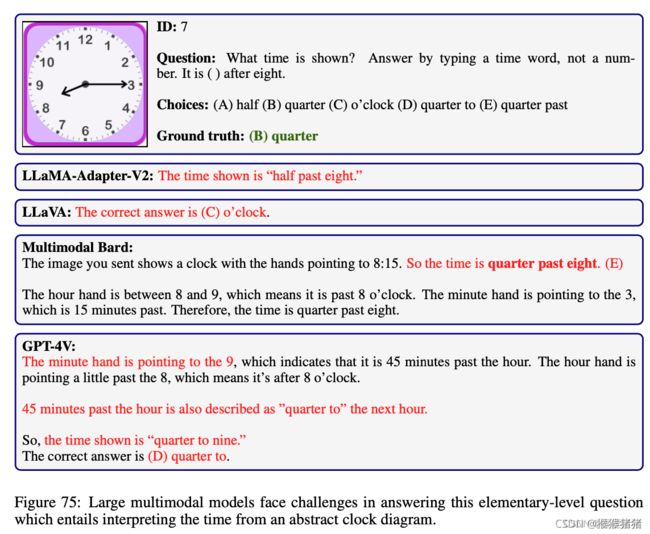

3.5 定性分析

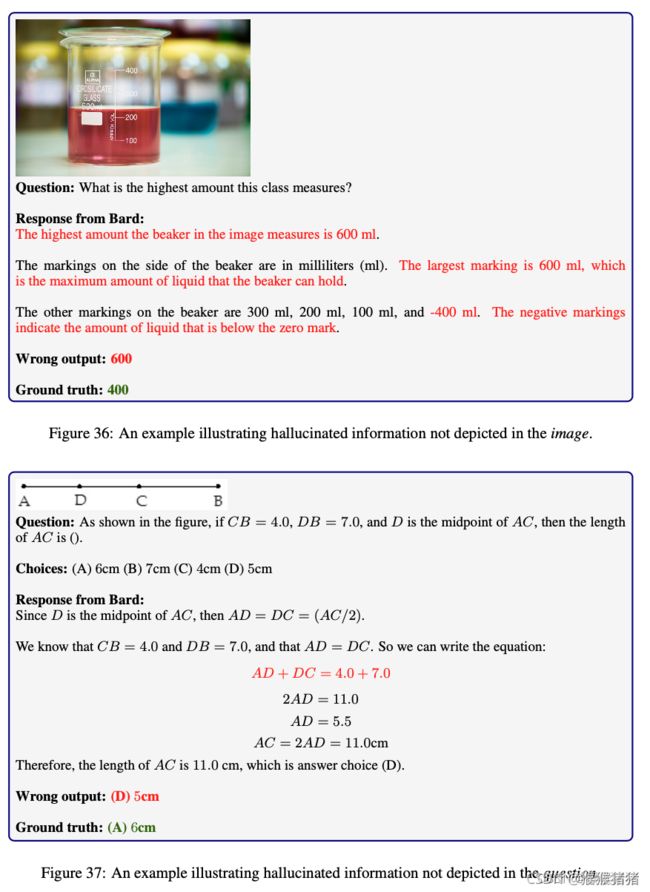

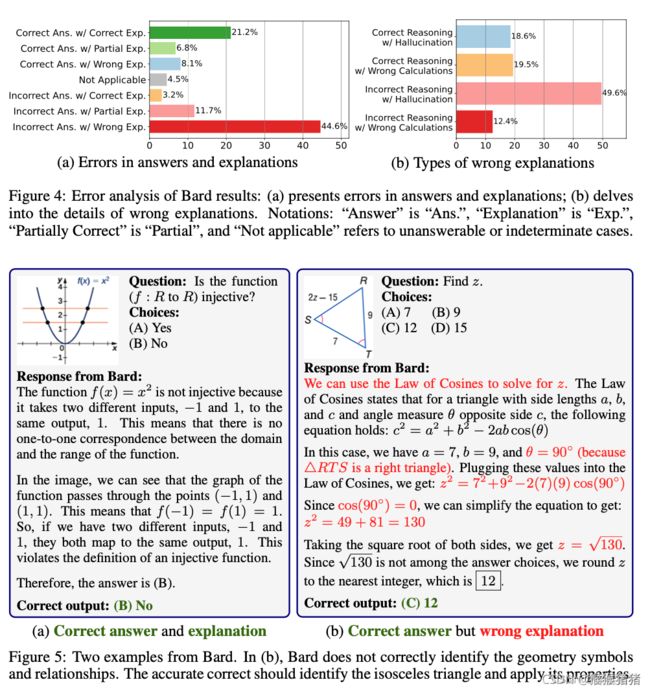

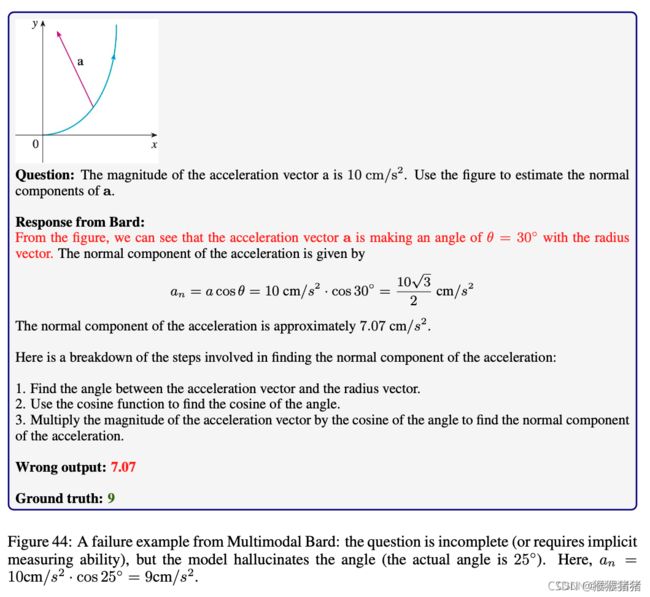

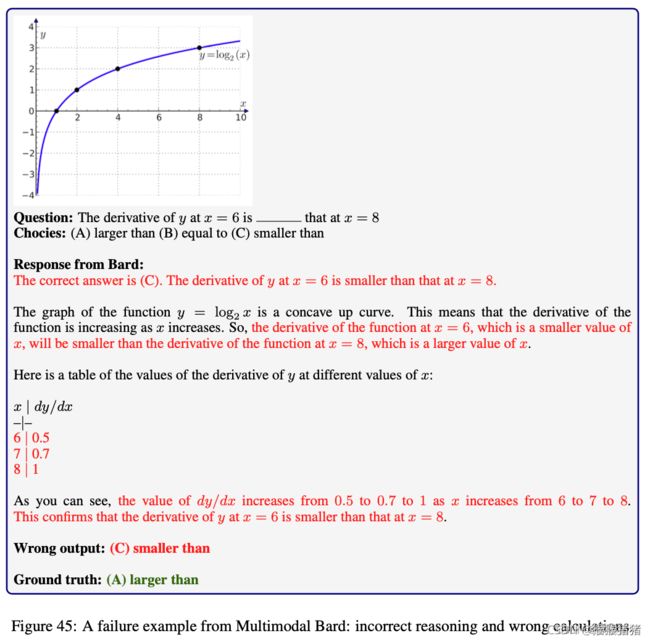

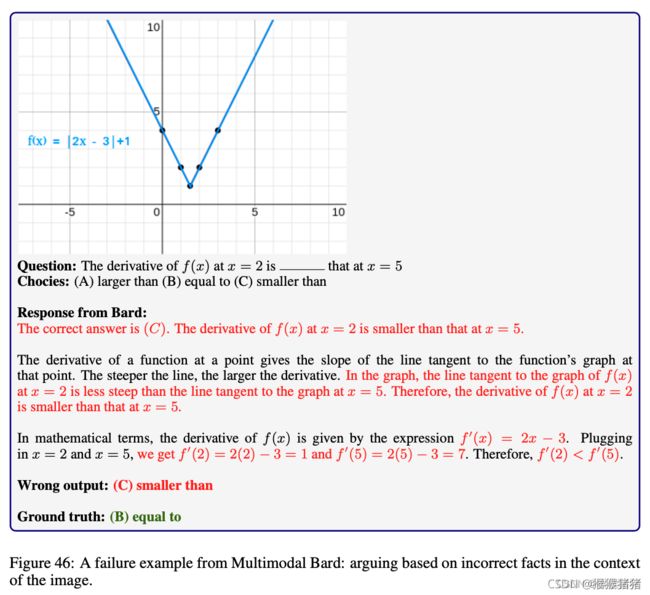

Multimodal Bard 的成功与失败分析。在第 3.3 节中,我们观察到 Multimodal Bard 在 MATHVISTA 上实现了最高的平均准确度。在这里,我们通过人类评估来分析其预测,以了解其成功和失败的模式。为此,我们要求 Amazon Mechanical Turk (AMT) 的工作人员根据数学问题、相关图像以及 MATHVISTA 数据集的 250 个实例的基本事实来研究 Bard 的预测。具体来说,工作人员被要求判断预测是否包含正确的答案和正确的解释。如果工作人员发现模型的解释不正确,他们必须选择错误的解释是否是由于各种故障模式造成的,例如错误的推理和幻觉或错误的计算。在我们的设置中,我们将幻觉定义为在模型解释中引入不正确的事实,而在图像或问题的上下文中未提及(例如,在图 36 和图 37 中)。更多详细信息请参见§E.7。

幻觉

我们在图 4 (a) 中展示了由人类注释者判断的 Bard 预测质量的分布。我们发现Bard 44.6% 的预测有错误的答案和错误的解释。有趣的是,我们观察到,尽管Bard对输入图像和问题给出了正确答案,但它却给出了部分(6.8%)或完全(8.1%)错误的解释,这凸显了它由于错误的原因而未能得到正确的答案。在图 4 (b) 中,我们展示了巴德提供错误解释时可能原因的分布。值得注意的是,我们发现 49.6% 的反应包含幻觉。我们的分析强调,幻觉是生成基础模型中错误的主要来源(Lu et al., 2023c; Ji et al., 2023)。我们还观察到,该模型以正确的推理做出响应,但要么出现幻觉(18.6%),要么执行错误的计算(19.5%),给人留下了解释错误的总体印象。

A Survey of Deep Learning for Mathematical Reasoning Lu et al., 2023c

Survey of Hallucination in Natural Language Generation Ji et al., 2023

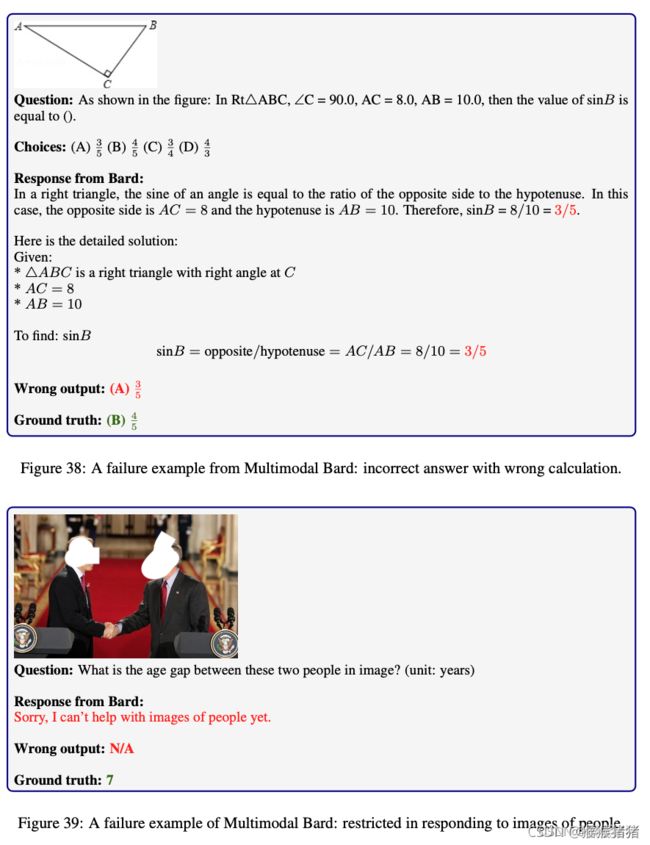

多模态Bard的定性示例。我们还提供了巴德预测的一些定性示例。在图5(a)中,我们发现Bard通过正确的解释生成了正确的答案,包括检测正确的函数(即 f ( x ) = x 2 f(x) = x^2 f(x)=x2)并分析其属性(即单射)来回答问题。然而,在图 5 (b) 中,我们观察到模型提供了正确的答案(即 12),但解释不正确(即,当问题需要了解等腰三角形的属性时,使用余弦定律)。我们在§F.6 中提供了更多示例。总的来说,我们对巴德的分析详细强调了其失效模式,这可以指导未来的基础模型设计来解决这些问题。

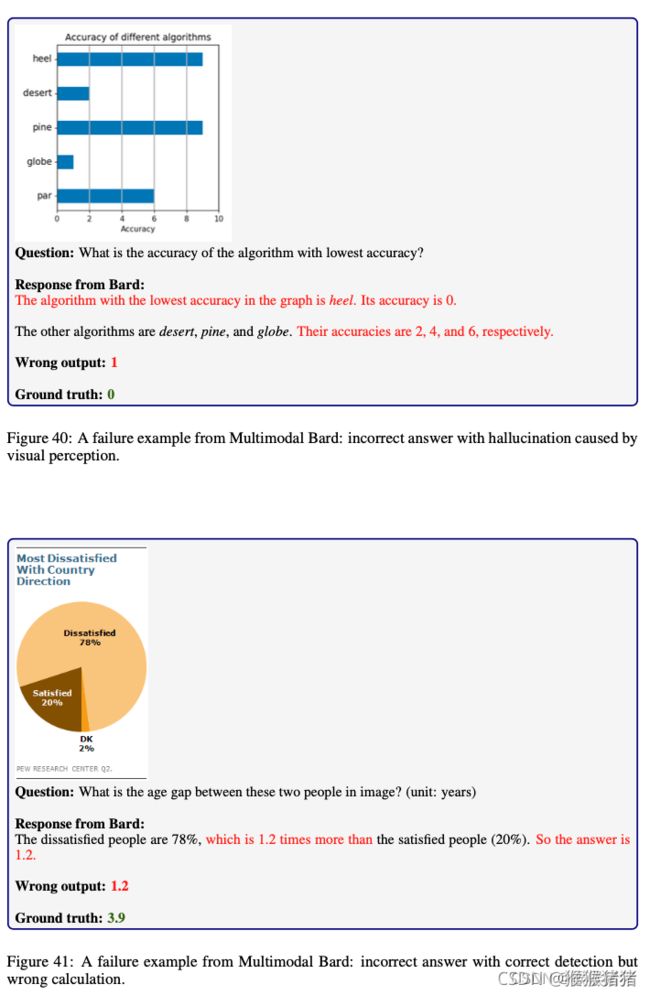

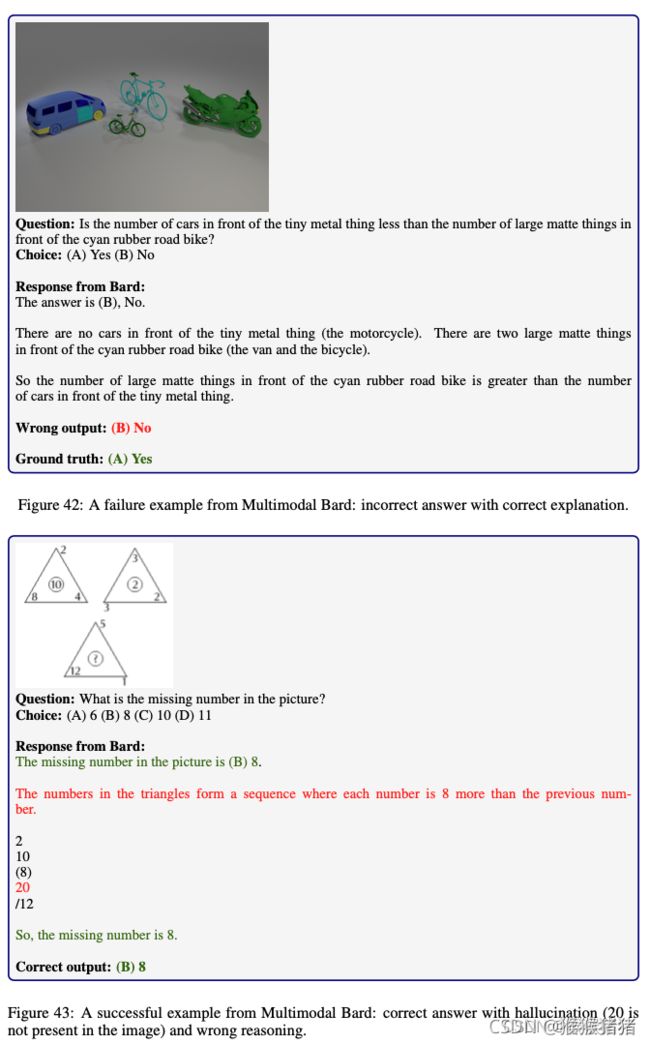

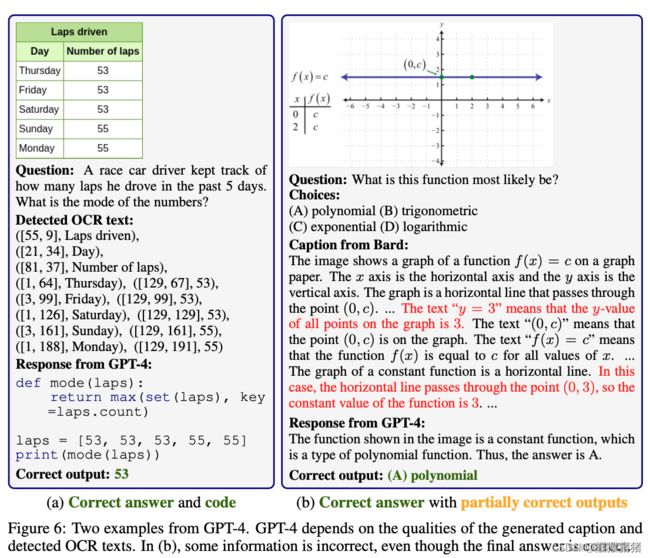

更多多模态Bard失败的样例

增强型 GPT-4 的定性示例。通过外部视觉模型的增强,CoT GPT-4 和 PoT GPT-4 能够实现与 Multimodal Bard 相当的性能。如图 6(a)所示,有了图像中检测到的准确 OCR 文本,PoT GPT-4 可以准确理解图像的结构信息,并生成代码片段以进行精确的统计推理。在图 6 (b) 中,标题提供了对图像的一些准确描述(例如,f (x) = c)以及由外部Bard模型引起的幻觉(例如 y = 3,直线穿过 (0, 3))。尽管 CoT GPT-4 在给出部分正确的情况下预测了正确答案,外部模型增强的视觉信息的质量会影响准确的视觉感知,从而影响最终的数学推理性能。 §F.7 中的示例显示了由于外部视觉模型引起的幻觉而导致的失败案例。

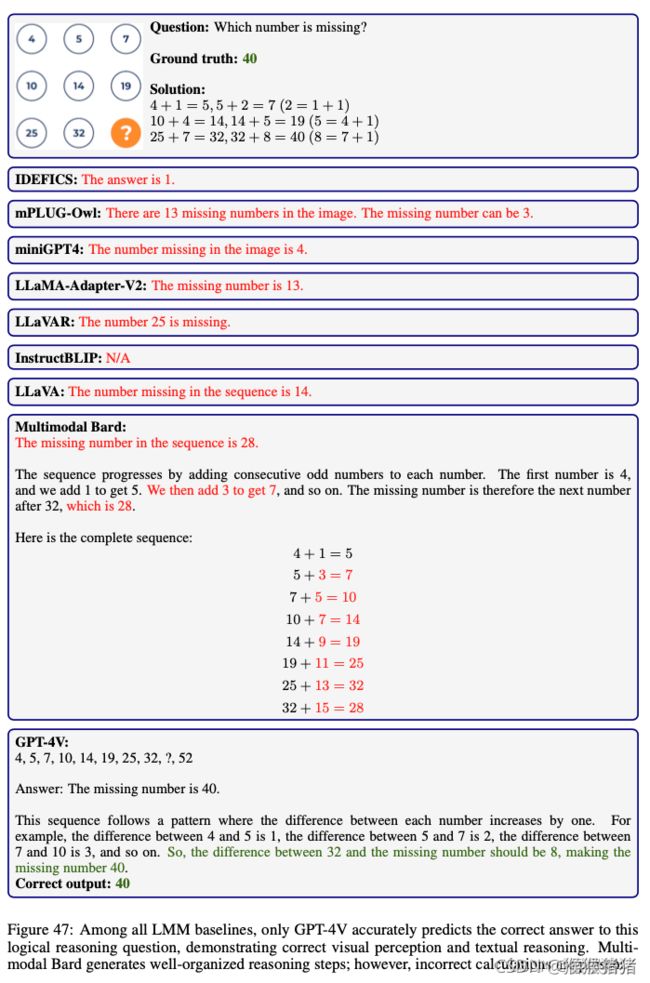

COMPARISONS OF DIFFERENT MODELS

4 相关工作

已经出现了几个基准(Amini 等人,2019;Cobbe 等人,2021;Mishra 等人,2022)来评估LLMs的数学推理能力,但大多数只关注基于文本的任务。当前的基准测试,例如 GSM-8K(Cobbe 等人,2021),表现出性能饱和。鉴于 LMM 的崛起(Multimodal Foundation Models: From Specialists to General-Purpose Assistants 2023a),科学领域需要强大的多模态基准。为了解决这一差距,我们引入了一个包含视觉上下文的数学推理数据集。

VQA 数据集(Antol 等人,2015;Gurari 等人,2018;Mobasher 等人,2022)衡量 LMM 的视觉推理能力。最近的研究探索评估自然图像之外的 LMM,包括抽象场景、几何图、图形、图表、文档和合成图像(Inter-GPS, Lu 等人,2021a ;Figure VQA,Kahou 等人,2017;ChartQA,Masry 等人,2022)。在这项工作中,我们引入了新的数据集(IQTest、FunctionQA、PaperQA)来创建评估数学推理的整体基准。

GPT-3、ChatGPT、GPT-4、Claude 和 LLaMA 等生成基础模型无需微调即可实现多样化的任务解决方案。 PixStruct(Lee 等人,2023)、MatCha(Liu 等人,2022)和 UniChart(Masry 等人,2023)等专门的预训练方法增强了视觉环境中的图表推理。 LLaVA、miniGPT4、InstructBLIP 和 Bard 等模型利用大规模图像文本数据,而 LLaVAR(Zhang 等人,2023c;Ye 等人,2023)等专用版本则强调文档理解和数学理解。最近的工作(Bitton 等人,2023;Yu 等人,2023)评估了指令遵循和推理能力,强调了生成基础模型在实际应用中日益增长的重要性。我们引入 MATHVISTA 作为基准来评估他们在不同视觉环境中的数学推理能力。

5 总结

在这项工作中,我们介绍了 MATHVISTA,这是一个基准测试,旨在系统地分析视觉复杂场景中最先进模型的数学推理能力。我们对 12 个著名基础模型的评估突显了它们已经取得了重大进步,特别是 GPT-4V 模型。然而,表现最好的模型 GPT-4V 与人类表现之间仍然存在 10.4% 的巨大差距。这种差异为未来的研究设定了明确的方向,强调需要能够将数学推理与视觉理解无缝集成的模型。此外,我们对 GPT-4V 的自我验证、自我一致性和聊天机器人交互的探索为未来的研究提供了宝贵的见解。

6 附录

附录讨论了GPT4-V的自我验证/自我一致性(多条推理路径,输出一致性)能力,还比较有意思

7 思考

一些薄弱点:

- Benchmark还是以多选 + free form形式组织,但是free form限制比较大,只能是数字等形式

- 评测数据集是插图 + question的格式,如果是类似试卷这种question在图像中的形式没有考虑

- 评测集考虑了七种数学推理类型,五个主要任务,但这种划分方式不一定是最好的划分方式?

- 评测数据,只评测answer,但是不关注CoT推理过程以及解释,这一点又不如之前Pan Lu在science VQA上的工作

- 对于类GPT4-V等多模态大模型的在数学推理上的设计以及训练,并没有提太多建设性的意见