MATLAB - Gazebo 联合仿真 —— 使用 UR10 机械臂检测和采摘水果

系列文章目录

文章目录

- 系列文章目录

- 前言

- 一、设置 Gazebo 仿真环境

- 二、在 Gazebo 中模拟和控制机器人

-

- 2.1 概述

- 2.2 任务调度器

- 2.3 感知和目标生成系统

- 2.4 运动规划

- 2.5 机械臂和关节控制系统

- 三、分配用于控制机器人的参数

-

- 3.1 定义机器人模型和运动规划参数,

- 3.2 定义机械手姿势和摄像机参数

- 3.3 配置 Gazebo 协同仿真设置

- 3.4 定义夹具控制设置

- 4. Simulink 模型

- `少侠请留步,点赞、收藏、关注`

前言

本示例演示如何在 Gazebo 物理模拟器中设置 Universal Robotics UR10 机械臂和仿真环境。您需要配置一个机器人从树上摘苹果的仿真环境。

本示例演示如何利用这些工具箱,使用 Universal Robotics UR10 机械手模拟机器人检测并从树上摘取苹果。

-

Robotics System Toolbox™- 在Simulink®和Gazebo中对机械手进行建模、规划和模拟。 -

Navigation Toolbox™- 生成三维环境的占用图。 -

Stateflow®- 调度示例中的高级任务并按顺序执行。 -

Computer Vision Toolbox™- 处理三维点云数据。 -

Deep Learning Toolbox™- 使用 Gazebo 中的模拟摄像头检测物体。 -

Computer Vision Toolbox™ Model for YOLO v4 Object Detection- 提供预训练的YOLO v4 csp-darknet53-coco物体检测网络。

要使用预训练的 YOLO v4 csp-darknet53-coco 物体检测网络,您必须从附加组件资源管理器下载并安装用于 YOLO v4 物体检测的 Computer Vision Toolbox™ Model。有关安装附加组件的更多信息,请参阅获取和管理附加组件。

本示例中的板条箱模型版权归 Arturo Matheus 所有,采用 1.3 版自由艺术许可协议进行许可。原始板条箱模型可在 sweethome3d 上获取。

一、设置 Gazebo 仿真环境

请按照以下步骤设置仿真环境。

-

要下载带有 Gazebo 的虚拟机 (VM),请按照在 Simulink 和 Gazebo 之间执行协同仿真中的说明操作。

-

在虚拟机设置中,在虚拟机 > 设置 > 硬件 > 显示下,禁用加速 3D 图形。有关更多信息,请参阅准备虚拟机以使用加速 3D 图形。

-

启动 Ubuntu® 虚拟机桌面。

-

在 Ubuntu 桌面上,单击

Gazebo Co-Sim Fruit Picking启动本例的 Gazebo 世界。

二、在 Gazebo 中模拟和控制机器人

本示例使用 Gazebo 协同仿真 Simulink 模块来连接、读取摄像头图像以及读取和设置关节位置。Gazebo 世界包含一个带有 RGB-D 深度(RGB-D)摄像头传感器的 Universal Robotics UR10 机械臂机器人模型。Gazebo 世界还包含一棵苹果树和一个收集苹果的箱子。

2.1 概述

模拟开始时,机械手处于原点配置。然后,机械手移动到图像抓取位置,从 Gazebo 收集 RGB-D 图像。当机器人接收到图像时,它会使用 YOLO v4 物体检测网络检测并识别苹果。然后,机器人计算出目标位置,并将其发送给运动规划子系统。然后,模型使用操纵器RRT 对象在图像抓取位置和计算出的目标位置之间进行运动规划。当机器人接近目标苹果时,抓手手指张开,当机器人摘到苹果后,抓手手指关闭。然后,模型规划目标位置和苹果下落位置之间的运动。然后,机械手向苹果下落位置移动,并打开抓手,将苹果放入箱子中。接着,机械手移回图像抓取位置。这个过程一直持续到机器人从树上取下所有苹果为止。

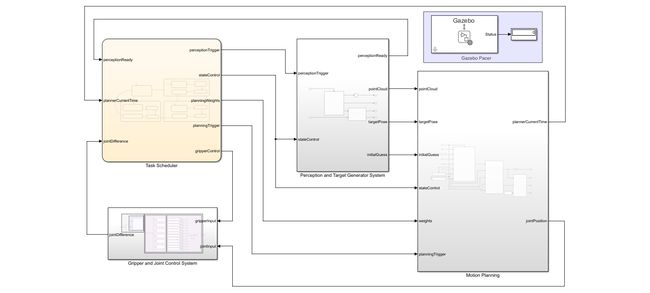

Simulink 模型

Simulink 模型由这些子系统组成。

-

任务调度器

-

感知和目标生成系统

-

运动规划

-

抓手和关节控制系统

2.2 任务调度器

状态流程图定义了机器人手臂在取放工作流程中的不同状态。该图包含以下步骤。

-

最初,闲置状态(IdleState)触发并过渡到原点状态(HomeState)。

-

在 HomeState 状态下,当前配置通过运动规划过渡到图像抓取配置。

-

当 HomeState 结束时,它会触发 PerceptionState,捕捉 RGB-D 图像并过渡到 GrabState。

-

为了让机械手向目标移动,GrabState 会计算目标苹果的位置并执行运动规划。

-

机械手在向目标移动时打开抓手,到达目标后开始关闭抓手。

-

当 GrabState 结束时,抓手关闭以抓取苹果。

-

然后,ReleaseState 计划目标位置和苹果下落位置之间的运动。

-

机械手在到达苹果下落位置后,打开抓手并释放苹果。

-

机械手回到原点状态,从树上摘下一个苹果。

-

这个过程一直持续到机械手从树上摘下所有苹果为止。

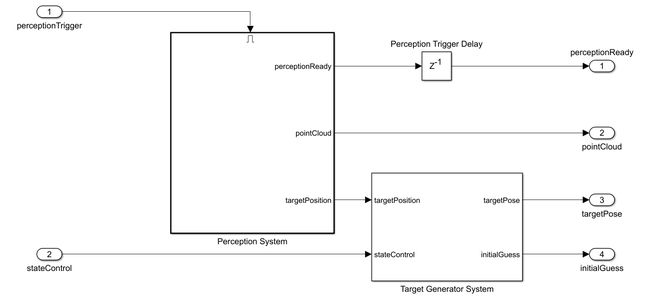

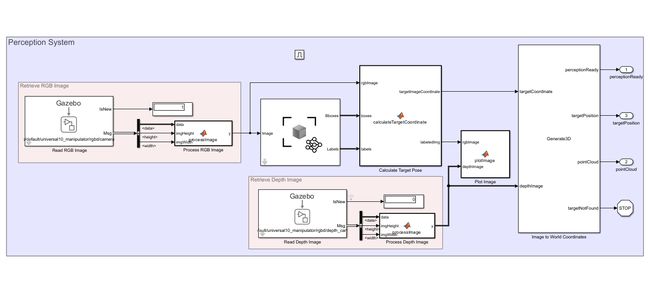

2.3 感知和目标生成系统

感知系统模块和目标生成系统模块通过 Gazebo 读取模块从 Gazebo 中查询 RGB-D 图像,并通过接收到的 RGB-D 图像检测目标苹果生成目标姿态。

感知系统使用深度学习对象检测器(计算机视觉工具箱)模块,从输入的 RGB 图像中估计边界框和标签。子系统对标签进行细化,只选择苹果标签。感知系统从所有检测到的苹果标签列表中选择第一个苹果标签作为目标苹果,并通过输入的深度图像计算三维目标姿态。此外,子系统还会根据输入的深度图像计算运动规划中所需的点云。

2.4 运动规划

感知和目标生成器系统会生成目标姿态,并将其发送至目标配置生成器模块,以生成目标关节配置。获取目标姿势模块利用机械手的基准位置、末端执行器偏移和当前状态输入计算目标姿势。然后,逆运动学程序块根据计算出的目标姿势、权重和初始猜测计算出目标关节配置。

运动规划模块从 Gazebo 中获取当前关节配置,并使用操纵器RRT 对象进行运动规划。此外,子系统还会使用 occupancyMap3D(导航工具箱)对象为计算出的点云生成三维占位图。为了避免 Gazebo 世界中复杂的树形结构,子系统将该占用图作为运动规划的输入之一。最后,子系统根据运动规划中计算出的航点来估算关节位置。

2.5 机械臂和关节控制系统

Gazebo 应用命令块将估算的关节位置应用到 Gazebo 模型中。Gazebo 读取模块从 Gazebo 中获取当前的关节位置。抓手控制器模块使用 Gazebo 应用命令块对每个抓手手指关节施加扭矩。此外,任务调度程序中的状态转换会计算关节差,并利用关节差执行状态转换。

三、分配用于控制机器人的参数

打开 Simulink 模型。

open_system("FruitPickingGazeboManipulator.slx");

3.1 定义机器人模型和运动规划参数,

使用 loadrobot 对 universalUR10 机械手进行加载和可视化。

robot = loadrobot("universalUR10",DataFormat="row",Gravity=[0 0 -9.81]);

show(robot)

ans =

Axes (Primary) with properties:

XLim: [-2 2]

YLim: [-2 2]

XScale: 'linear'

YScale: 'linear'

GridLineStyle: '-'

Position: [0.1300 0.1100 0.7750 0.8150]

Units: 'normalized'

Show all properties

在 Gazebo 世界中,RGB-D 摄像机和抓手连接到 Universal Robotics UR10 机器人模型的手腕_3_link 上。因此,请指定 wrist_3_link 为末端执行器。

endEffectorName = "wrist_3_link";

为 universalUR10 机器人模型指定所附抓手偏移量。

endEffectorOffset = [0.0 -0.27 0.0];

初始化运动规划参数

initializeMotionPlanningParameters

3.2 定义机械手姿势和摄像机参数

加载要在 Gazebo 模拟器中应用的相机设置。

initializeCameraParameters

要抓取图像,请定义 universalUR10 机器人移动到的位置。

imageGrabPositionTform = eye(4);

imageGrabPositionTform(1:3,4) = [0.1639 -0.6120 0.5839];

imageGrabPositionTform(1:3,1:3) = eul2rotm([0 0 0]);

定义机械手图像抓取位置的初始猜测配置。

imageGrabPositionInitialGuess = [-pi/2 0 -pi/2 pi/2 -pi/2 pi];

定义采摘苹果的下落位置。

releasePositionInitialTform = eye(4);

releasePositionInitialTform(1:3,4) = [-0.1348 -0.5613 0.3530];

releasePositionInitialTform(1:3,1:3) = eul2rotm([5*pi/6 0 -5*pi/6]);

定义机械手目标释放位置的初始猜测配置。

releasePositionInitialGuess = [-2*pi/3 -pi/2 2*pi/3 -pi/3 -pi/2 0];

3.3 配置 Gazebo 协同仿真设置

定义 Gazebo 协同模拟模块的采样时间。

Ts = 0.01;

打开 Gazebo Pacer 块,点击配置 Gazebo 网络和模拟设置链接。在网络地址下拉菜单中,选择自定义。输入 Linux 机器的 IP 地址。Gazebo 的默认端口值是 14581。将响应超时设置为 10。

单击 "测试 "按钮,测试与运行中的 Gazebo 模拟器的连接。

3.4 定义夹具控制设置

分配机械手开合力度值。

gripperOpenEffort = -0.15;

gripperCloseEffort = 0.15;

4. Simulink 模型

要执行模拟并将其可视化,请单击 “运行”。

在 MATLAB 中可视化检测到的苹果和深度图像。