ubuntu20.04显卡驱动cuda cudnn conda TensorRT安装及配置

显卡驱动 cuda cudnn conda TensorRT安装及配置

- 如果要使用

TensorRT,请注意CUDA 支持的最高算力要大于等于GPU本身的算力, 可以先看3小节 - conda和pip换源直接看2.3小节

- 本人已在ubuntu20.04下安装成功。其他版本步骤应该差不多

- 如果帖子有帮助,感谢一键三连,

^_^ - 部署有问题的小伙伴欢迎留言和加

Q裙-472648720 - BEV各算法环境部署实战汇总

1 显卡驱动, cuda, cudnn

1.1 显卡驱动下载

显卡算力查询

- 禁用

nouveau核显

- 安装显卡驱动必须禁用

nouveau核显,不然安装显卡驱动后会黑屏 - 不要更新内核,更新内核后不能用apt二进制安装, 安装前需要禁核显

# 1 禁用nouveau

sudo vim /etc/modprobe.d/blacklist.conf

# 2 末尾添加下面2句代码, 来禁用其他核显

blacklist nouveau

options nouveau modeset=0

# 3 生效

sudo update-initramfs -u

# 4 查看是否生效,如果没输出就已经生效,如果有输出重启在试试

lsmod | grep nouveau

- 安装

- 安装方法1

apt二进制

# 查看可以安装的驱动

sudo ubuntu-drivers devices

# 根据table补全选择一个合适的

sudo apt install nvidia-drive-470

- 安装方法2 官方下载安装

更新过内核驱动选择此方法, 都需要提前禁nouveau核显

官方网站下载

按照自己显卡型号下载linux版本就行

依赖

sudo apt install g++ make

安装

sudo ./NVIDIA-Linux-x86_64-515.76.run

一直默认就行,点enter就行

查看版本

nvidia-smi

终端输出nvidia-smi, 有显卡信息即代表安装成功

1.2 cuda安装

1.下载

cuda下载

cuda版本和算力

-

6000显卡算力

8.9;cuda-12.0支持的算力5.0 – 9.0 -

30系显卡算力

8.6;cuda-11.1 – 11.4算力支持3.5-8.6 -

cuda-11.8 support for compute capability 3.5 – 9.0

# cuda12.0

wget https://developer.download.nvidia.com/compute/cuda/12.0.0/local_installers/cuda_12.0.0_525.60.13_linux.run

# cuda11.3.0

wget https://developer.download.nvidia.com/compute/cuda/11.3.0/local_installers/cuda_11.3.0_465.19.01_linux.run

- 安装

sudo sh cuda_11.3.1_465.19.01_linux.run

-

安装时注意, 选择continue ,然后输入

accept之后 只选择cuda tookit, 其他driver \文档\ sample等都不要安装, 即把选项之前的X按enter去掉就行,最后选择install等待安装完成就行。 -

安装后会在

/usr/local/下生成cuda和cuda-11.3目录 ,cuda是cuda-11.3软连接得到的,在本机有多个cuda环境时,可以重新软连接切换cuda版本

- 添加环境变量

vim ~/.bashrc

# 在~/.bashrc文本加入下面2句

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda/lib64

export PATH=$PATH:/usr/local/cuda/bin

# 退出~/.bashrc, 生效

source ~/.bashrc

- 查看cuda版本

nvcc -V

-

出现nvcc版本信息表示安装cuda成功

-

有的人

nvcc -V没有输出,可能是因为环境变量没有设置对,要确认/usr/local下是否含有

cuda和cuda-11.3,有可能是cuda-11.x, 第3步就换成对应的,退出~/.bashrc一定要source

1.3 cudnn

下载cudnn下载

选择支持cuda11.x版本linux平台的cudnn-8.6.0,下载后解压

# 8.2.1版本.tgz

tar -xf cudnn-11.3-linux-x64-v8.2.1.32.tgz

# 8.6.0版本.tar.xz

tar -xf cudnn-linux-x86_64-8.6.0.163_cuda11-archive.tar.xz

解压后得到的文件,拷贝到/usr/local/cuda-11.3/中

cp cuda/lib64/* /usr/local/cuda-11.3/lib64/

cp cuda/include/* /usr/local/cuda-11.3/include/

查看cudnn版本

cat /usr/local/cuda/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

cat /usr/local/cuda-11.3/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

上面2句结果都一样,证明cudnn复制成功,并生效

CuBLAS CuBLAS查看版本,自己根据版本好修改

2 conda安装

2.1 安装

miniconda地址

anaconda地址

下载完后,先加权限,再运行安装包

chmod +x Miniconda3-latest-Linux-x86_64.sh

sudo ./Miniconda3-latest-Linux-x86_64.sh

安装一直yes就行,安装路径可以自己设定, 不懂就直接默认即可

2.2 conda初始化设置

- 初始化conda

cd Miniconda3

./bin/conda init

2.3 conda和pip换源

- conda换源

- 终端中依次执行5句代码就ok

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/linux-64/

conda config --set show_channel_urls yes

- pip换源

创建一个~/.pip/pip.conf文件,然后将下面的源地址添加进去

# 创建~/.pip/pip.conf文件

mkdir ~/.pip && vim ~/.pip/pip.conf

- 源地址。把下面代码粘贴进

~/.pip/pip.conf即可

[global]

index-url = https://pypi.tuna.tsinghua.edu.cn/simple/

2.4 torch安装

torch版本和cuda版本对应查询

conda和pip换源后就可以安装虚拟python环境了

- conda创建虚拟环境

# 创建一个名为lin,python环境为3.8的虚拟环境. 一直yes即可

conda create -n lin python=3.8

- 激活conda安装torch等包

# 1 激活lin虚拟环境

conda activate lin

# 2 在lin虚拟环境中,使用pip安装python包

pip install torch==1.11.0+cu113 torchvision==0.12.0+cu113 torchaudio==0.11.0 --extra-index-url https://download.pytorch.org/whl/cu113

3 TensorRT

tensorRT下载, 需要注册账号

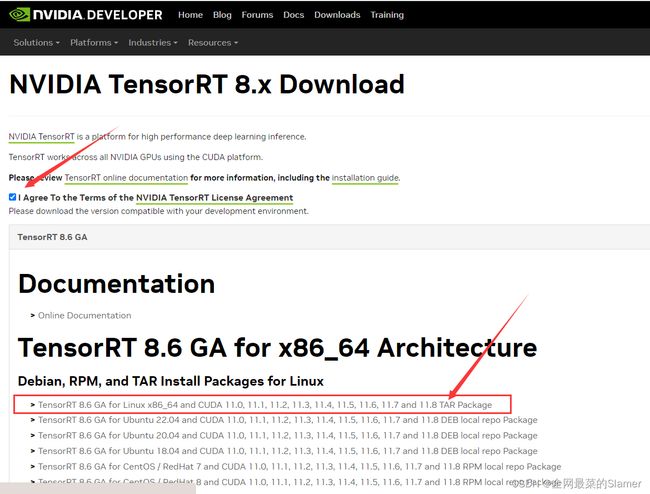

注册后选择登录,以TensorRT8为例子,选择TensorRT8,勾选下图上的Agree,选择8.6GA版本(GA通用版,EA抢先体验版),和自己的ubuntu版本和cuda对应上,我是ubuntu20.04-cuda11.3选择下图红框内容,选择tar版本(已经编译好了)

c++解压就能用

tar -xf TensorRT-8.6.1.6.Linux.x86_64-gnu.cuda-11.8.tar.gz

python版本的tensorrt安装,根据python版本选择,这里是python3.8

# 进入解压后的tensorRT/python目录

cd TensorRT-8.6.1.6/python

# 虚拟环境中安装python3.8版本

pip install tensorrt-8.6.1.6-cp38-none-linux_x86_64.whl

自此,c++版本和python版本的tensorRT已经安装完成。

TensorRT部署时, 注意cuda的算力和显卡的算力

编译c++的时候会报错**

nvcc fatal : Unsupported gpu architecture 'compute_89'

- 也就是说

CUDA支持的最高算力要大于等于GPU本身的算力

显卡支持 89的算力,而cuda是11.3只支持86的算力

-

yolov5-v7使用tensorRT加速 -

ros下完成lidar2cam的点云上色、目标检测、测距代码链接 -

CMakeLists.txt文件输出相关库的版本号

MESSAGE("\n------------\n")

MESSAGE("----OPENCV VERSION: " ${OpenCV_VERSION})

MESSAGE("----PCL VERSION: " ${PCL_VERSION})

MESSAGE("----CUDA VERSION: " ${CUDA_VERSION})

message(STATUS " cuda-libraries: ${CUDA_LIBRARIES}")

message(STATUS " cuda-include path: ${CUDA_INCLUDE_DIRS}")

MESSAGE("----TensorRT VERSION: " ${TensorRT_FOUND})

message("\n---------------\n")