LLama2 CPU Windows 部署-小白踩坑合集

关于Llama下载相关-小白踩坑

1、直接在官网申请(需要梯子):https://ai.meta.com/llama/![]() https://ai.meta.com/llama/

https://ai.meta.com/llama/

申请的时候注意一定要点击下一步,我在这个上面踩过坑,申请过九九八十一次,一直没有收到邮件,结果就是因为…没有点击下一步(没文化真可怕,对英语单词不敏感)

2、huggingface上面也是有很多链接

meta-llama (Meta Llama 2) (huggingface.co)![]() https://huggingface.co/meta-llama

https://huggingface.co/meta-llama

3、GPU安装过程可以参考:Llama2模型申请与本地部署详细教程_哔哩哔哩_bilibili最强开源大模型Llama 2,Meta已开放权重和模型文件,而且可免费商用。现在有70亿、130亿和700亿三个不同参数的版本,需要先到Meta AI官网进行申请,审核通过后即可下载原生版Llama 2模型。申请成功后,也可在hugging face上绑定申请的邮箱,进行下载。开源项目MLC目前为最快的使用Llama2模型的推理程序,可在消费级显卡上运行Llama 2的各参数版本模型,也可以使用W, 视频播放量 23771、弹幕量 6、点赞数 779、投硬币枚数 358、收藏人数 2129、转发人数 310, 视频作者 AI百晓生, 作者简介 不保证成功,不一定有用。,相关视频:llama2:基于llama-2和LocalGPT实现100%本地化的知识库,与本地文档安全对话,Llama2和chatGPT4,究竟谁才是最强王者?,LLAMA2一键可运行整合包:Windows10+消费级显卡可用(Meta大语言模型),无需显卡,在本地体验llama2系列模型,支持7B、13B、70B,Llama2 技术详解,五分钟快速一键启动Llama2,不用搞环境,"妙鸭相机"开源版facechain本地部署详细教程(windows系统),从0构建llama2+localGPT的本地模型,5 分钟部署免费私有化的 Llama2中文版(可商用),人大发布微调版Llama2-13b模型https://www.bilibili.com/video/BV1H14y1X7kD/?spm_id_from=333.337.search-card.all.click

这个里面是通过Cmake+MinGW来编译:

MinGW安装过程:MinGW安装过程-腾讯云开发者社区-腾讯云MinGW官网下载地址:http://sourceforge.net/projects/mingw/![]() https://cloud.tencent.com/developer/article/2055825

https://cloud.tencent.com/developer/article/2055825

但是这个期间我遇到了非常多的困难,于是我就开始换教程,寻求更详细的解答。

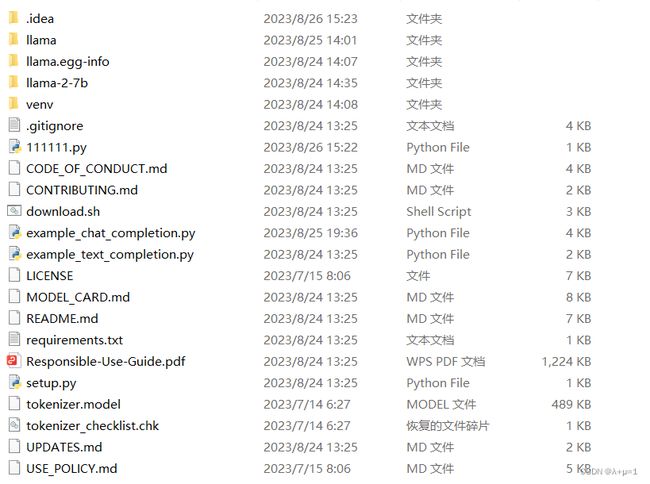

后来我得知,通过这个方法所谓的本地部署出来就是一个llama文件夹:

也就是一个python项目文件,这个时候如果要运行,可以参考一下llama中文社区:

Streamlit![]() https://chinese.llama.family/

https://chinese.llama.family/

里面有很多详细的代码。但是需要GPU。于是我就去搜索CPU的部署方式。

4、如何在低配Windows上部署原版llama.cpp

关于llama.cpp是什么,可以去搜。作为一个小白,我也是在不断探索,我也不懂,我只知道它可以在CPU上面运行,OK,开动!

Github地址:GitHub - ggerganov/llama.cpp: Port of Facebook's LLaMA model in C/C++![]() https://github.com/ggerganov/llama.cpp

https://github.com/ggerganov/llama.cpp

但是一开始我没有看,因为emm比较抗拒英文。

初期安装参考链接:

在低配Windows上部署原版llama.cpp_go2coding的博客-CSDN博客现在大语言模型的部署,通常都需要大的GPU才能实现,如果是仅仅想研究一下,大语言模型的算法,我们是很想能够直接在我们的工作电脑上就能直接运行的,llama.cpp就是很好的实现。LLaMa.cpp使用int4这种数值格式,其显著降低了内存需求,并且在大多数硬件上其性能严重受到内存限制。LLaMa.cpp使用原始C ++的项目来重写LLaMa(长格式语言模型)推理代码。这使得可以在各种硬件上本地运行LLaMa,包括。在使用一些优化和量化技术来量化权重的情况下,LLaMa.cpp。https://blog.csdn.net/weixin_40425640/article/details/131305145

我很执着地安装了Cmake+MinGW,但是遇到了很多很多的问题:

问题1 cmake语句不生效,检查后是因为安装mingw发现bin目录下没有mingw32-make.exe

解决方案:安装mingw发现bin目录下没有mingw32-make.exe怎么办?_下载的sdl文件没有mingw32_飞天小猫咪的博客-CSDN博客![]() https://blog.csdn.net/XXX1238XGH/article/details/102652531

https://blog.csdn.net/XXX1238XGH/article/details/102652531

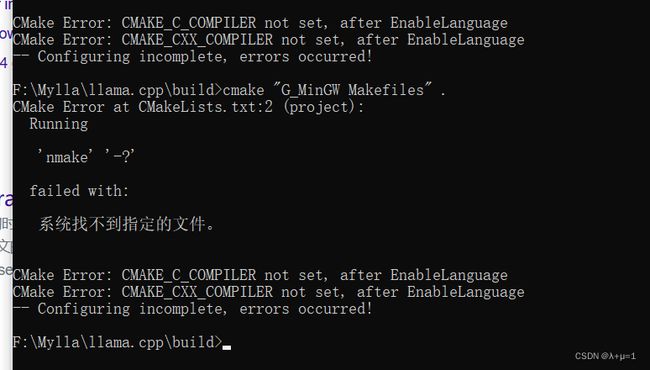

问题2 如图

解决方案:windows 搭建cmake和gcc编译环境 问题记录_cmake环境变量不生效_csdndulala的博客-CSDN博客![]() https://blog.csdn.net/csdndulala/article/details/121390778?ops_request_misc=&request_id=&biz_id=102&utm_term=CMake%20Error:%20Error:%20generator%20&utm_medium=distribute.pc_search_result.none-task-blog-2~all~sobaiduweb~default-5-121390778.nonecase&spm=1018.2226.3001.4187

https://blog.csdn.net/csdndulala/article/details/121390778?ops_request_misc=&request_id=&biz_id=102&utm_term=CMake%20Error:%20Error:%20generator%20&utm_medium=distribute.pc_search_result.none-task-blog-2~all~sobaiduweb~default-5-121390778.nonecase&spm=1018.2226.3001.4187

问题3 intrin.h mingw error : No such file or directory

解决方案:这个问题我也找了很久,最后我采取的方法是去寻求intrin.h这个头文件然后手动复制到相应文件夹下面(MinGW\include)

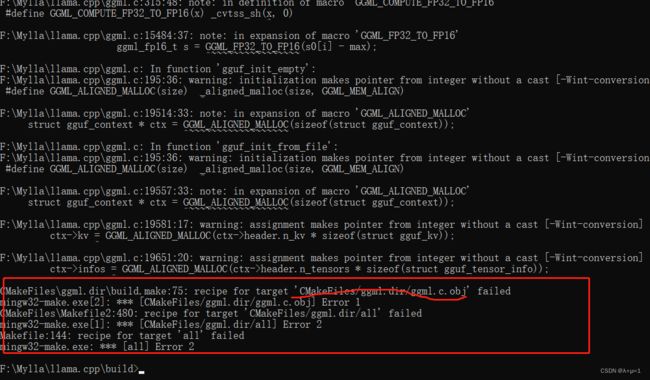

Github地址:GitHub - yuikns/intrin: Compatibility header for GCCCompatibility header for GCC. Contribute to yuikns/intrin development by creating an account on GitHub.![]() https://github.com/yuikns/intrin问题4 最后遇到一个编译问题我一直没有解决

https://github.com/yuikns/intrin问题4 最后遇到一个编译问题我一直没有解决

在执行cmake –build . –config Release遇到的

最后我放弃了这个办法,开始向他人求助,我还是回到了官方文档:

https://github.com/ggerganov/llama.cpp![]() https://github.com/ggerganov/llama.cpp

https://github.com/ggerganov/llama.cpp

然后准备利用w64devkit的方法,最后我需要一个什么Object C,不知道是不是因为没装好Visual Studio的原因,反正我放弃了,,,最后用了别人编译好的llama.cpp文件,是同学分享给我的。里面模型文件我去掉了,如果可以的话我把它分享出来:

链接:https://pan.baidu.com/s/1NUeZNT3SlT5ZeSaW1WNvEA

提取码:hbib

(这个是编译好的)

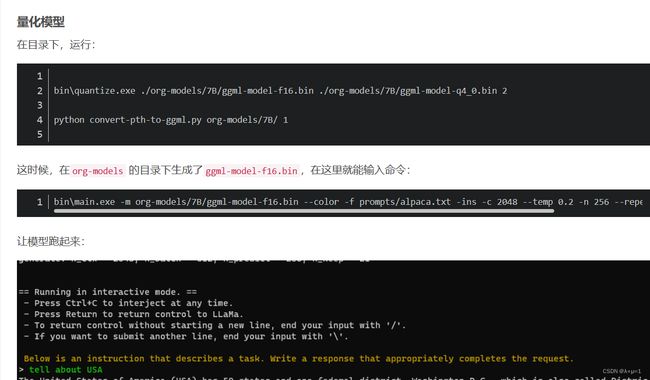

下载下来之后直接跳转到链接在低配Windows上部署原版llama.cpp_go2coding的博客-CSDN博客现在大语言模型的部署,通常都需要大的GPU才能实现,如果是仅仅想研究一下,大语言模型的算法,我们是很想能够直接在我们的工作电脑上就能直接运行的,llama.cpp就是很好的实现。LLaMa.cpp使用int4这种数值格式,其显著降低了内存需求,并且在大多数硬件上其性能严重受到内存限制。LLaMa.cpp使用原始C ++的项目来重写LLaMa(长格式语言模型)推理代码。这使得可以在各种硬件上本地运行LLaMa,包括。在使用一些优化和量化技术来量化权重的情况下,LLaMa.cpp。https://blog.csdn.net/weixin_40425640/article/details/131305145

的“量化模型”步骤:

最后就成功啦!

但是注意一定要装以下Visual Studio:

我因为之前安装失误就遇到这个问题,最后我重新安装了一下,建议Visual Studio 2022

Visual Studio 2022最新版安装教程(数千字图文详解),一步步教会你如何安装并运行VS2022(+背景图设置)Visual Studio 2022最新版安装教程(数千字图文详解),一步步教会你如何安装并运行VS2022(+背景图设置)![]() http://www.360doc.com/content/22/0416/09/277688_1026758662.shtml

http://www.360doc.com/content/22/0416/09/277688_1026758662.shtml

5、llama-python-cpp:

https://github.com/abetlen/llama-cpp-python