4.F1 评分机器学习模型性能的常用的评估指标

F1评分作为机器学习领域中的一个综合性评价指标,旨在在准确率和召回率之间寻求平衡,进而提供对模型性能全面评估的手段。本文将深入探讨F1评分的定义、计算方法、应用领域、案例研究以及未来发展方向,力求为读者提供详实而全面的了解。

一.F1 评分的定义

F1评分是一种综合性评价指标,其核心思想是通过综合考虑准确率和召回率两个关键指标,找到它们之间的平衡点。4

在实际应用中,我们往往不仅关注模型对正样本的识别准确性(召回率),还关注模型对正样本的正确预测比例(准确率)。F1评分通过将这两个指标进行调和平均,将其合并为一个单一的分数,从而综合考虑了假阳性和假阴性的影响。

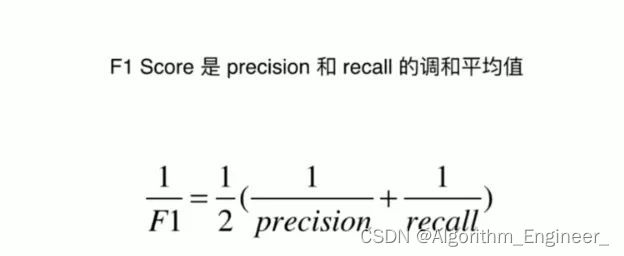

二.F1评分的计算方法

F1评分的计算方法是基于准确率(Precision)和召回率(Recall)的调和平均值。具体而言,F1评分的计算公式如下:

其中,Precision表示准确率,Recall表示召回率。F1评分的取值范围在0和1之间,越接近1表示模型在准确率和召回率之间取得更好的平衡。

三.F1评分的应用领域

F1评分作为一个综合性的评价指标,在多个领域都得到了广泛的应用。以下是F1评分在一些具体领域的详细介绍:

医学图像分割: 在医学图像分割任务中,常常需要对图像中的不同组织或病灶进行准确的分割。F1评分被广泛应用于评估分割模型的性能,尤其是对于肿瘤检测等任务,F1评分能够综合考虑准确率和召回率,帮助医生更全面地了解模型的表现。

文本分类: 在自然语言处理领域的文本分类任务中,F1评分常被用于评估模型对不同类别的分类性能。通过综合考虑模型的准确率和召回率,F1评分能够提供一个全面的性能指标,特别适用于处理类别不平衡的文本分类问题。

金融欺诈检测: 在金融领域,欺诈检测是一个重要的任务。F1评分能够帮助评估模型对欺诈交易的检测能力,同时考虑到了误报和漏报的影响,为金融机构提供了更全面的性能评估。

医学诊断: 在医学诊断中,F1评分被广泛应用于评估模型对疾病的诊断准确性。通过综合考虑病患确实患病(真正例)和模型误判的情况(假正例、假负例),F1评分有助于医生了解模型在不同疾病诊断上的性能。

网络安全: 在网络安全领域,F1评分被用于评估入侵检测系统的性能。模型需要在检测到潜在入侵时具有高的召回率,同时保持相对较高的准确率,以减少误报。F1评分为网络安全专业人员提供了一个综合评估模型的工具。

情感分析: 在社交媒体分析和情感分析任务中,F1评分可用于度量模型对情感的准确分类。综合考虑了正类别(情感)的识别和负类别的排除,F1评分为情感分析任务提供了全面的性能评估。

F1评分在自然语言处理(NLP)领域有着广泛的应用,尤其在文本分类、实体识别、情感分析等任务中起到了重要的评价作用。以下是F1评分在NLP应用领域的详细介绍:

文本分类: 在文本分类任务中,F1评分常被用于评估模型对各个类别的分类性能。文本分类涉及将文本分为不同的类别,例如垃圾邮件过滤、新闻分类等。F1评分能够全面衡量模型的准确率和召回率,尤其在类别不平衡的情况下提供了更全面的性能指标。

实体识别: 在实体识别任务中,F1评分被用于评价模型对文本中命名实体的识别准确性。命名实体可以是人名、地名、组织名等,而F1评分能够综合考虑模型对真实实体的识别(召回率)和模型的预测准确性(准确率)。

情感分析: 在情感分析任务中,F1评分用于度量模型对文本情感的分类性能。情感分析通常涉及对文本进行正面、负面或中性情感的分类。F1评分可以帮助评估模型在各个情感类别上的综合性能,确保模型对各种情感的分类都具有良好的准确性和召回率。

问答系统: 在问答系统中,特别是在命名实体识别和问题分类的子任务中,F1评分被广泛应用。评估系统对用户提问的准确回答和漏报率是提高问答系统性能的关键。

语义角色标注: 在语义角色标注任务中,F1评分用于评估模型对句子中各个词语的语义角色标注准确性。这对于深入理解句子中词语的语义关系和语法结构非常重要。

机器翻译: 在机器翻译任务中,F1评分可用于评估模型对于不同语言之间翻译准确性的综合性能。此时,F1评分可以考虑翻译结果与参考答案之间的准确匹配度。

总的来说,F1评分在NLP领域中广泛应用于多个任务,其综合性能评估的特性使其成为一个全面而有效的评价指标。在选择评价指标时,具体任务的特点和需求将决定F1评分是否是最合适的选择。

四.F1评分的局限性

F1评分作为一个综合性的评价指标,在应用中也存在一些局限性,其中包括以下几个方面:

平衡问题: F1评分是准确率和召回率的调和平均,更关注两者之间的平衡。然而,在某些场景下,对准确率和召回率的重视程度可能不同。F1评分在追求平衡的同时,可能无法满足某些特定任务对准确率或召回率的特定需求。

对类别不平衡敏感: F1评分对于类别不平衡的数据集较为敏感。当正负样本数量差异较大时,F1评分可能不够准确地反映模型在处理少数类别的性能。这可能导致在处理不平衡数据时,其他评价指标如AUC-ROC更具优势。

二分类偏向: F1评分通常应用于二分类问题,对于多分类问题的评估存在一定的限制。在多分类情况下,可能需要考虑其他更适合的评价指标,如多分类精确度、混淆矩阵等。

不考虑实际应用场景: F1评分是基于混淆矩阵的统计指标,它关注的是模型在样本层面的性能。然而,在实际应用中,模型的性能可能受到多种因素的影响,包括数据的分布、领域特征等。因此,F1评分未必能够全面反映模型在真实应用场景中的表现。

不考虑不同误差类型的权重: 在某些应用中,不同的误差类型可能具有不同的代价。F1评分对所有的误差类型平等看待,无法区分不同误差类型的影响,因此在特定场景下可能需要引入加权F1评分或其他考虑误差权重的指标。

综上所述,F1评分虽然是一个常用的评价指标,但在特定情境下可能存在一些局限性。在选择评价指标时,需要根据任务的特性和需求,综合考虑多个指标,以更全面地评估模型性能。

五.F1评分的未来发展方向

F1评分作为一个综合性的评价指标,未来有望在多个方向上迎来进一步的发展和拓展:

-

模型解释性与可解释性: 随着深度学习等复杂模型的广泛应用,关注模型的解释性和可解释性变得愈发重要。未来的发展方向可能包括通过解释性技术,使F1评分更具可解释性,帮助用户理解模型的决策过程。

-

针对不同领域的定制化: 不同领域对模型性能的需求各异,未来可能会出现更多针对特定领域的定制化F1评分变体。这些变体可能考虑到特定行业、任务或数据特性,更准确地反映模型在实际应用中的性能。

-

结合其他评价指标: 虽然F1评分在平衡准确率和召回率方面表现出色,但未来的研究可能会更加注重综合考虑多个评价指标。结合其他指标如ROC曲线、AUC值等,可以提供更全面的性能评估,帮助用户更好地了解模型的表现。

-

面向大规模数据和在线学习: 随着大规模数据的普及和在线学习的发展,未来的F1评分研究可能更加注重适用于处理大规模数据流、动态更新的在线学习任务,以适应现代数据处理的需求。

-

考虑类别不平衡: 在某些任务中,类别不平衡是一个常见的问题,传统的F1评分对于不平衡数据可能不够敏感。未来的研究可能会致力于改进F1评分,使其更适用于处理类别不平衡的情况。

-

基于深度学习的进一步研究: 随着深度学习的不断发展,未来的研究可能会涉及基于深度学习的F1评分的改进和优化,以适应复杂模型和大规模数据的挑战。

综合而言,F1评分的未来发展将在模型解释性、领域定制、综合评价等多个方向上取得新的突破,以更好地服务于不同领域和应用场景。

六.F1评分的代码实现

F1评分的计算涉及到准确率(Precision)、召回率(Recall)和F1分数的公式。以下是一个简单的Python代码实现,假设有两个列表,一个是真实标签(ground truth),另一个是模型的预测标签:

def calculate_f1_score(true_labels, predicted_labels):

true_positives = sum((a == 1 and b == 1) for a, b in zip(true_labels, predicted_labels))

false_positives = sum((a == 0 and b == 1) for a, b in zip(true_labels, predicted_labels))

false_negatives = sum((a == 1 and b == 0) for a, b in zip(true_labels, predicted_labels))

precision = true_positives / (true_positives + false_positives) if (true_positives + false_positives) != 0 else 0

recall = true_positives / (true_positives + false_negatives) if (true_positives + false_negatives) != 0 else 0

f1_score = 2 * (precision * recall) / (precision + recall) if (precision + recall) != 0 else 0

return precision, recall, f1_score

# 示例

true_labels = [1, 0, 1, 1, 0, 1]

predicted_labels = [1, 1, 0, 1, 0, 0]

precision, recall, f1_score = calculate_f1_score(true_labels, predicted_labels)

print(f"Precision: {precision:.2f}")

print(f"Recall: {recall:.2f}")

print(f"F1 Score: {f1_score:.2f}")

上述代码定义了一个calculate_f1_score函数,该函数接受真实标签和预测标签的两个列表,计算并返回准确率、召回率和F1分数。在示例中,true_labels是真实标签,predicted_labels是模型的预测标签。请注意,该代码中使用的是二分类情况下的F1分数计算方式,对于多分类问题可能需要进行适当的修改。

Sklearn库提供了方便的工具函数来计算F1评分。以下是使用Sklearn计算F1评分的代码示例:

from sklearn.metrics import f1_score

# 示例数据

true_labels = [1, 0, 1, 1, 0, 1]

predicted_labels = [1, 1, 0, 1, 0, 0]

# 计算F1评分

f1 = f1_score(true_labels, predicted_labels)

print(f"F1 Score: {f1:.2f}")

七.F1评分的总结

F1评分是一个综合性的评价指标,平衡了准确率和召回率。它特别适用于处理类别不平衡的问题,能够全面评估模型在正负样本上的性能。总的来说,F1评分对于那些需要同时考虑模型的精度和覆盖率的任务非常有用。在某些应用场景中,高F1分数的模型可能更具优势,因为它在错误类型的权衡上更加谨慎。但需要注意,F1评分并不适用于所有情况,具体的评价指标选择应根据任务的特性和需求来确定。