- 【科研必备】EI/Scopus收录!2025年3-4月智能制造、自动化、无人驾驶、人工智能等前沿领域国际会议邀您参与~与全球学者交流,让学术之光在国际舞台上闪耀!

努力毕业的小土博^_^

学术会议推荐制造自动化人工智能深度学习神经网络算法

【科研必备】EI/Scopus收录!2025年3-4月智能制造、无人驾驶、人工智能等前沿领域国际会议邀您参与~与全球学者交流,让学术之光在国际舞台上闪耀!【科研必备】EI/Scopus收录!2025年3-4月智能制造、无人驾驶、人工智能等前沿领域国际会议邀您参与~与全球学者交流,让学术之光在国际舞台上闪耀!文章目录【科研必备】EI/Scopus收录!2025年3-4月智能制造、无人驾驶、人工智能等

- 一切皆是映射:DQN训练加速技术:分布式训练与GPU并行

AI天才研究院

计算AI大模型企业级应用开发实战ChatGPT计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

1.背景介绍1.1深度强化学习的兴起近年来,深度强化学习(DeepReinforcementLearning,DRL)在游戏、机器人控制、自然语言处理等领域取得了令人瞩目的成就。作为一种结合深度学习和强化学习的强大技术,DRL能够使智能体在与环境交互的过程中学习最优策略,从而实现自主决策和控制。1.2DQN算法及其局限性深度Q网络(DeepQ-Network,DQN)是DRL的一种经典算法,它利用

- 大规模语言模型从理论到实践 分布式训练的集群架构

AI智能涌现深度研究

DeepSeekR1&大数据AI人工智能Python入门实战计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

大规模语言模型从理论到实践分布式训练的集群架构作者:禅与计算机程序设计艺术/ZenandtheArtofComputerProgramming1.背景介绍1.1问题的由来随着深度学习技术的飞速发展,大规模语言模型(LargeLanguageModels,LLMs)在自然语言处理(NaturalLanguageProcessing,NLP)领域取得了突破性进展。LLMs,如BERT、GPT-3等,通

- 图生视频技术的发展与展望:从技术突破到未来图景

Liudef06

StableDiffusion音视频人工智能深度学习stablediffusion

一、技术发展现状图生视频(Image-to-VideoGeneration)是生成式人工智能(AIGC)的重要分支,其核心是通过单张或多张静态图像生成动态视频序列。近年来,随着深度学习、多模态融合和计算硬件的进步,图生视频技术经历了从基础研究到商业落地的快速演进。早期探索与GAN的奠基早期图生视频技术主要基于生成对抗网络(GAN),通过对抗训练生成低分辨率的视频片段。例如,DeepMind的DVD

- 【SoC基础】单片机之寄存器解析

望闻问嵌

#SoC单片机嵌入式硬件

:如果你也对机器人、人工智能感兴趣,看来我们志同道合✨:不妨浏览一下我的博客主页【https://blog.csdn.net/weixin_51244852】:文章若有幸对你有帮助,可点赞收藏⭐不迷路:内容若有错误,敬请留言指正!原创文,转载注明出处文章目录1、寄存器位置2、寄存器种类2.1通用用途寄存器2.2CPU执行相关寄存器2.3外设控制寄存器3.寄存器在CPU访问外设过程中起到的作用1、寄

- 大模型时代的知识焦虑

机载软件与适航

机器学习-建模算法-代理模型人工智能大数据

引言:浪潮之巅,焦虑暗涌大模型时代已经浩荡而来,如同奔腾的浪潮,以令人惊叹的速度重塑着世界的面貌。从智能客服的温声细语,到AI绘画的妙笔生花,再到自动驾驶的日趋成熟,大型语言模型、图像模型等人工智能技术以前所未有的姿态,渗透进我们生活的方方面面。信息获取前所未有的便捷,知识创造空前高效,人机交互焕然一新,一个充满无限可能的智能化未来似乎触手可及。然而,在这令人眼花缭乱的技术盛景之下,一股无形的焦虑

- “轻松一键生成 AI 图像:Stable Diffusion Online 带来革命性视觉创意体验!“

ai小精灵

人工智能stablediffusion文心一言AI作画chatgpt

StableDiffusionOnline正在为AI图像生成领域树立新标准,将复杂的功能与便捷直观的用户体验相结合。历史上,StableDiffusion的部署步骤带来了重大挑战,特别是对于技术新手而言。然而,StableDiffusionOnline消除了这些障碍,提供了一个既适合新手也适合资深专业人士的酷炫界面。什么是StableDiffusionOnline?StableDiffusionO

- 近期计算机领域的热点技术

0dayNu1L

云计算量子计算人工智能

随着科技的飞速发展,计算机领域的新技术、新趋势层出不穷。本文将探讨近期计算机领域的几个热点技术趋势,并对它们进行简要的分析和展望。一、人工智能与机器学习人工智能(AI)和机器学习(ML)是近年来计算机领域最为热门的话题之一。AI和ML技术已经广泛应用于图像识别、自然语言处理、智能推荐等领域,并取得了显著的成果。随着技术的不断进步,AI和ML将更深入地渗透到各个行业,为人类社会带来更多便利和效益。在

- 谷歌准备斥资 230 亿收购网络安全初创公司 Wiz

网络研究观

网络研究观谷歌

Alphabet正在就收购Wiz进行深入谈判,这将显著增强其安全能力。这将是谷歌母公司有史以来最大规模的收购。这是路透社根据匿名消息来源撰写的内容。目标收购金额为230亿美元,即211亿欧元。Wiz拥有实时检测和响应网络威胁的技术。通过实施人工智能,Wiz能够在短时间内吸引许多公司作为客户。Alphabet的收购目标定于2020年初。到2023年,Wiz的收入将达到3.5亿美元。当时,全球40%的

- 数学领域的跨时代进化与升级:从公理化到智能化的破茧之路

夏末之花

算法

作者:夏末之花|发布时间:2025-03-16|阅读量:10万+|点赞数:5.6万引言:数学的“破茧时刻”与文明跃迁人类历史上,数学的每一次重大突破都像一次“破茧时刻”,推动文明跨越式发展。从古希腊的几何公理化到牛顿的微积分,再到20世纪的计算机理论,数学始终是科学革命的基石。而在21世纪的今天,随着量子计算、人工智能、生物信息等技术的爆发,数学正迎来新一轮的进化与升级——从纯粹的逻辑工具,演变为

- 精准测试:软件开发中的高效质量保障利器

霍格沃兹软件测试开发

精准化测试测试用例安全性测试测试覆盖率模块测试selenium测试工具压力测试

全面解析软件测试开发:人工智能测试、自动化测试、性能测试、测试左移、测试右移到DevOps如何驱动持续交付在现代软件开发中,测试效率与测试质量直接影响产品竞争力。精准测试作为一项兼具效率与精度的创新测试方法,已经成为众多企业提升软件质量的重要手段。本篇文章围绕精准测试的落地实施、对质量指标的提升、数据统计与效果评估方法以及如何提高投入产出比进行全面解读,帮助企业掌握精准测试的价值与实践路径。精准测

- 提升敏感力,“工具人”破圈的唯一解!

技能咖

GAI认证生成式人工智能认证人工智能

在当今这个日新月异的数字化时代,个人与组织面临着前所未有的挑战与机遇。随着科技的飞速发展,尤其是生成式人工智能(GenerativeAI)的兴起,职场生态正在发生深刻变革。如何在这场变革中提升敏感力,实现从“工具人”到行业佼佼者的跨越,成为了众多职场人士关注的焦点。本文将探讨提升敏感力的重要性,并引入生成式人工智能认证(GAI认证),为您揭示“工具人”破圈的唯一解。提升敏感力:职场竞争的关键什么是

- Moodle + Websoft9:创新教育的强大组合,助力教学与学习

开源软件

Moodle+Websoft9:构建未来课堂的技术基石一、Moodle:开源生态的深度解析•模块化设计:支持超800个官方插件,如H5P交互内容创作、BigBlueButton虚拟课堂,满足个性化教学需求。•学习分析引擎:内置LearningAnalyticsAPI,可集成Python/R语言进行深度学习,预测学生学业风险。•移动优先战略:MoodleApp支持离线学习、扫码签到,2023年新增A

- 新浪财经App喜娜AI助手通过大模型登记,已上线AI摘要和个股公告AI解读

量子位

3月14日,官方发布的信息显示,新浪财经App喜娜AI助手近日已通过北京市生成式人工智能服务登记。目前,喜娜AI助手已上线两项创新功能:喜娜AI摘要和个股公告AI解读。这两项功能旨在通过先进的人工智能技术,提升用户对财经资讯和上市公司公告的理解与分析效率,这标志着AI技术在信息服务领域的又一重大突破。喜娜AI摘要:快速提炼财经资讯核心要点AI时代,资讯信息迎来爆炸性增长,用户每天都要面对海量资讯,

- 书籍-《动手学深度学习(英文版)》

书籍:DiveintoDeepLearning作者:AstonZhang,ZacharyC.Lipton,MuLi,AlexanderJ.Smola出版:CambridgeUniversityPress编辑:陈萍萍的公主@一点人工一点智能下载:书籍下载-《动手学深度学习(英文版)》01书籍介绍深度学习已经彻底改变了模式识别,为计算机视觉、自然语言处理和自动语音识别等领域提供了强大的工具。应用深度学

- 模型微调:让AI更懂你的魔法棒

带上一无所知的我

pytorch人工智能python

模型微调:让AI更懂你的魔法棒✨在人工智能的世界里,模型微调(Fine-tuning)就像是一位魔法师用魔法棒对预训练模型进行“个性化改造”,让它更适应特定的任务。今天,我们就来深入探讨模型微调的技术细节,让你也能像魔法师一样,轻松驾驭AI模型!什么是模型微调?模型微调是指在预训练模型的基础上,通过少量的特定任务数据进行训练,使模型更好地适应新任务的技术。预训练模型通常是基于大规模数据集(如Ima

- 从 DeepSeek 到 AI 工具箱:Websoft9 应用托管平台赋能高校教学与科研

人工智能deepseek

从DeepSeek到AI工具箱:Websoft9应用托管平台赋能高校教学与科研人工智能技术的快速发展正在重塑高校的教学与科研生态。从智能教学辅助到跨学科研究,AI工具的应用场景不断扩展,而技术落地的复杂性也带来新的挑战。在这一背景下,如何将大模型能力与多样化AI工具无缝整合,构建安全、易用的科研教学环境,成为高校数字化转型的关键命题。一、高校智能化转型的三大痛点技术门槛高•AI工具部署依赖专业运维

- 聊聊关于Python与人工智能那些事

小G-biu-

python人工智能tensorflow

Python与人工智能:介绍Python在人工智能方面的应用Python是一种广泛使用的编程语言,也是人工智能领域中最受欢迎的语言之一。Python提供了许多用于构建和训练人工智能模型的库和框架。本文将介绍一些常见的人工智能技术以及Python在这些技术中的应用。OpenAIOpenAI是一个非营利组织,旨在推动人工智能的发展并促进其对人类的利益。OpenAI通过开发人工智能技术、研究人工智能的影

- 当现代教育技术遇上仓颉---探秘华为仓颉编程语言与未来教育技术的接轨

想成为高手499

华为服务器php

引言随着人工智能、物联网、区块链等新兴技术的发展,编程语言的需求也在不断演化。据市场研究机构发布的数据显示,全球编程语言市场规模预计在未来五年内将以每年10%的速度增长。此外,越来越多的企业和高校正在积极推动基于分布式系统和硬件优化的新型语言开发,这进一步表明对高性能编程语言的需求日益旺盛。近年来,华为推出了自研编程语言“仓颉”,以其高效的语法设计、灵活的语义表达能力和强大的跨平台适配性能引发了编

- Python在人工智能与机器人开发中的应用与实践

一键难忘

python人工智能机器人

Python在人工智能与机器人开发中的应用与实践Python已经成为人工智能和机器人开发的主要编程语言之一,凭借其简洁的语法、强大的库支持和广泛的社区资源,Python为开发者提供了一个高效且易于学习的平台。在这篇文章中,我们将深入探讨如何使用Python进行人工智能(AI)和机器人开发,并通过实际代码示例展示核心技术和应用。1.Python在人工智能中的应用人工智能(AI)领域的核心任务包括机器

- 智慧交通是什么,可以帮助我们解决什么问题?

Guheyunyi

运维大数据人工智能信息可视化前端

智慧交通是什么?智慧交通(SmartTransportation)是指利用物联网(IoT)、大数据、人工智能(AI)、云计算、5G通信等先进技术,对交通系统进行智能化管理和优化,以提高交通效率、减少拥堵、降低事故率、提升出行体验,并实现交通资源的合理配置和可持续发展。智慧交通的核心是通过数据采集、分析和应用,实现交通系统的智能化、自动化和协同化,从而构建一个高效、安全、绿色、便捷的交通生态系统。智

- 在线视频创作平台(Vidnami)

deepdata_cn

视频生成视频剪辑视频创作

Vidnami是一款功能强大的在线视频创作平台,前身为ContentSamurai,于2015年推出,2020年更名为Vidnami。它运用人工智能技术,能够分析输入的文本,自动从大量素材中选取合适的图像和视频片段,将文字快速转化为具有专业外观的视频,无需用户具备视频编辑经验。该平台提供多种视频模板、全主题定制功能以及内置的免版权媒体库,包括3000万张图片和3万首音乐,还支持自动配音,用户可以录

- OpenCV第1课OpenCV 介绍及其树莓派下环境的搭建

嵌入式老牛

树莓派之OpenCVopencv人工智能计算机视觉

1.机器是如何“看”的我们人类可以通过眼睛看到五颜六色的世界,是因为人眼的视觉细胞中存在分别对红、绿、蓝敏感的3种细胞。其中的光感色素根据光线的不同进行不同比例的分解,从而让我们识别到各种颜色。对人工智能而言,学会“看”也是非常关键的一步。那么机器人是如何看到这个世界的呢?这就涉及到人工智能方向重要的分支--机器视觉。机器视觉即用机器人代替人眼来做测量和判断,通过机器视觉产品(即图像摄取装置,分C

- Linux安装Anaconda和Jupyter

硬水果糖

人工智能Linuxlinuxjupyter运维

一、了解Anaconda和Jupyter引言:Anaconda是一个流行的开源数据科学平台,广泛用于数据分析、机器学习、人工智能等领域。它是一个集成了大量科学计算和数据科学工具的Python和R编程语言环境。Anaconda的主要目标是简化数据科学和机器学习的开发流程,提供一个易于安装和管理的环境。而预装了大量常用的Python和R库,这些库涵盖了数据科学的各个方面,包括:数据分析:Pandas、

- DeepSeek 大模型落地成都高新区:科技赋能警务的创新变革

AGI大模型学习

科技人工智能DeepSeek大模型chatgpt大模型应用AI大模型

在科技飞速发展的当下,人工智能正以前所未有的速度融入各个领域,深刻改变着人们的生活与工作方式。公安领域也不例外,积极拥抱科技创新,成为提升警务效能、维护社会稳定的关键路径。全国第一例警用DeepSeek大模型落地成都高新区,这一突破性举措在警务智能化发展进程中具有里程碑意义,为公安工作带来了全方位的革新。一、警用DeepSeek大模型落地的时代背景近年来,国产AI蓬勃发展,不断涌现出令人瞩目的成果

- LORA的魔法棒:在Stable Diffusion中挥洒注意力机制的优化咒语 ??

DTcode7

AI生产力AIAIGCstablediffusionAI生产力前沿

LORA的魔法棒:在StableDiffusion中挥洒注意力机制的优化咒语??欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。推荐:DTcode7的博客首页。一个做过前端开发的产品经理,经历过睿智产品的折磨导致脱发之后,励志要翻身农奴把歌唱,一边打入敌人内部一边持续提升自己,为我们广大开发同胞

- 大数据和人工智能概念全面解析

就犯得上方法

一、大数据和人工智能大数据是伴随着信息数据爆炸式增长和网络计算技术迅速发展而兴起的一个新型概念。根据麦肯锡全球研究所的定义,大数据是一种规模大到在获取、存储、管理、分析方面大大超出了传统数据库软件工具能力范围的数据集合,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。大数据能够帮助各行各业的企业从原本毫无价值的海量数据中挖掘出用户的需求,使数据能够从量变到质变,真正产生价值

- DeepSeek爆火,背后模型竟藏着这些秘密!

qq_23519469

ai

DeepSeek是什么来头最近,AI圈可是被一个名字刷爆了屏,那就是DeepSeek!它就像一颗横空出世的超级新星,在全球范围掀起了一阵狂热的追捧潮,这热度,简直了!大家都在疯狂讨论它,各种测评、对比层出不穷。它到底有啥过人之处,能让这么多人都为之疯狂?今天咱就来好好唠唠。DeepSeek,全称杭州深度求索人工智能基础技术研究有限公司,是一家专注于开发先进大语言模型(LLM)和相关技术的企业。它成

- AI人工智能代理工作流AI Agent WorkFlow:设计智能任务处理流程

AI天才研究院

计算AI大模型企业级应用开发实战DeepSeekR1&大数据AI人工智能大模型计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

AI人工智能代理工作流AIAgentWorkFlow:设计智能任务处理流程作者:禅与计算机程序设计艺术/ZenandtheArtofComputerProgramming1.背景介绍1.1问题的由来在当今的数字化时代,随着数据量的爆炸式增长和复杂性的提升,传统的手动任务处理方式已经无法满足高效、准确的需求。人工智能技术的发展为自动化任务处理提供了新的可能性。AI人工智能代理(AIAgent)作为一

- 图像处理篇---图像预处理

Ronin-Lotus

图像处理篇深度学习篇程序代码篇图像处理人工智能opencvpython深度学习计算机视觉

文章目录前言一、通用目的1.1数据标准化目的实现1.2噪声抑制目的实现高斯滤波中值滤波双边滤波1.3尺寸统一化目的实现1.4数据增强目的实现1.5特征增强目的实现:边缘检测直方图均衡化锐化二、分领域预处理2.1传统机器学习(如SVM、随机森林)2.1.1特点2.1.2预处理重点灰度化二值化形态学操作特征工程2.2深度学习(如CNN、Transformer)2.2.1特点2.2.2预处理重点通道顺序

- java的(PO,VO,TO,BO,DAO,POJO)

Cb123456

VOTOBOPOJODAO

转:

http://www.cnblogs.com/yxnchinahlj/archive/2012/02/24/2366110.html

-------------------------------------------------------------------

O/R Mapping 是 Object Relational Mapping(对象关系映

- spring ioc原理(看完后大家可以自己写一个spring)

aijuans

spring

最近,买了本Spring入门书:spring In Action 。大致浏览了下感觉还不错。就是入门了点。Manning的书还是不错的,我虽然不像哪些只看Manning书的人那样专注于Manning,但怀着崇敬 的心情和激情通览了一遍。又一次接受了IOC 、DI、AOP等Spring核心概念。 先就IOC和DI谈一点我的看法。IO

- MyEclipse 2014中Customize Persperctive设置无效的解决方法

Kai_Ge

MyEclipse2014

高高兴兴下载个MyEclipse2014,发现工具条上多了个手机开发的按钮,心生不爽就想弄掉他!

结果发现Customize Persperctive失效!!

有说更新下就好了,可是国内Myeclipse访问不了,何谈更新...

so~这里提供了更新后的一下jar包,给大家使用!

1、将9个jar复制到myeclipse安装目录\plugins中

2、删除和这9个jar同包名但是版本号较

- SpringMvc上传

120153216

springMVC

@RequestMapping(value = WebUrlConstant.UPLOADFILE)

@ResponseBody

public Map<String, Object> uploadFile(HttpServletRequest request,HttpServletResponse httpresponse) {

try {

//

- Javascript----HTML DOM 事件

何必如此

JavaScripthtmlWeb

HTML DOM 事件允许Javascript在HTML文档元素中注册不同事件处理程序。

事件通常与函数结合使用,函数不会在事件发生前被执行!

注:DOM: 指明使用的 DOM 属性级别。

1.鼠标事件

属性

- 动态绑定和删除onclick事件

357029540

JavaScriptjquery

因为对JQUERY和JS的动态绑定事件的不熟悉,今天花了好久的时间才把动态绑定和删除onclick事件搞定!现在分享下我的过程。

在我的查询页面,我将我的onclick事件绑定到了tr标签上同时传入当前行(this值)参数,这样可以在点击行上的任意地方时可以选中checkbox,但是在我的某一列上也有一个onclick事件是用于下载附件的,当

- HttpClient|HttpClient请求详解

7454103

apache应用服务器网络协议网络应用Security

HttpClient 是 Apache Jakarta Common 下的子项目,可以用来提供高效的、最新的、功能丰富的支持 HTTP 协议的客户端编程工具包,并且它支持 HTTP 协议最新的版本和建议。本文首先介绍 HTTPClient,然后根据作者实际工作经验给出了一些常见问题的解决方法。HTTP 协议可能是现在 Internet 上使用得最多、最重要的协议了,越来越多的 Java 应用程序需

- 递归 逐层统计树形结构数据

darkranger

数据结构

将集合递归获取树形结构:

/**

*

* 递归获取数据

* @param alist:所有分类

* @param subjname:对应统计的项目名称

* @param pk:对应项目主键

* @param reportList: 最后统计的结果集

* @param count:项目级别

*/

public void getReportVO(Arr

- 访问WEB-INF下使用frameset标签页面出错的原因

aijuans

struts2

<frameset rows="61,*,24" cols="*" framespacing="0" frameborder="no" border="0">

- MAVEN常用命令

avords

Maven库:

http://repo2.maven.org/maven2/

Maven依赖查询:

http://mvnrepository.com/

Maven常用命令: 1. 创建Maven的普通java项目: mvn archetype:create -DgroupId=packageName

- PHP如果自带一个小型的web服务器就好了

houxinyou

apache应用服务器WebPHP脚本

最近单位用PHP做网站,感觉PHP挺好的,不过有一些地方不太习惯,比如,环境搭建。PHP本身就是一个网站后台脚本,但用PHP做程序时还要下载apache,配置起来也不太很方便,虽然有好多配置好的apache+php+mysq的环境,但用起来总是心里不太舒服,因为我要的只是一个开发环境,如果是真实的运行环境,下个apahe也无所谓,但只是一个开发环境,总有一种杀鸡用牛刀的感觉。如果php自己的程序中

- NoSQL数据库之Redis数据库管理(list类型)

bijian1013

redis数据库NoSQL

3.list类型及操作

List是一个链表结构,主要功能是push、pop、获取一个范围的所有值等等,操作key理解为链表的名字。Redis的list类型其实就是一个每个子元素都是string类型的双向链表。我们可以通过push、pop操作从链表的头部或者尾部添加删除元素,这样list既可以作为栈,又可以作为队列。

&nbs

- 谁在用Hadoop?

bingyingao

hadoop数据挖掘公司应用场景

Hadoop技术的应用已经十分广泛了,而我是最近才开始对它有所了解,它在大数据领域的出色表现也让我产生了兴趣。浏览了他的官网,其中有一个页面专门介绍目前世界上有哪些公司在用Hadoop,这些公司涵盖各行各业,不乏一些大公司如alibaba,ebay,amazon,google,facebook,adobe等,主要用于日志分析、数据挖掘、机器学习、构建索引、业务报表等场景,这更加激发了学习它的热情。

- 【Spark七十六】Spark计算结果存到MySQL

bit1129

mysql

package spark.examples.db

import java.sql.{PreparedStatement, Connection, DriverManager}

import com.mysql.jdbc.Driver

import org.apache.spark.{SparkContext, SparkConf}

object SparkMySQLInteg

- Scala: JVM上的函数编程

bookjovi

scalaerlanghaskell

说Scala是JVM上的函数编程一点也不为过,Scala把面向对象和函数型编程这两种主流编程范式结合了起来,对于熟悉各种编程范式的人而言Scala并没有带来太多革新的编程思想,scala主要的有点在于Java庞大的package优势,这样也就弥补了JVM平台上函数型编程的缺失,MS家.net上已经有了F#,JVM怎么能不跟上呢?

对本人而言

- jar打成exe

bro_feng

java jar exe

今天要把jar包打成exe,jsmooth和exe4j都用了。

遇见几个问题。记录一下。

两个软件都很好使,网上都有图片教程,都挺不错。

首先肯定是要用自己的jre的,不然不能通用,其次别忘了把需要的lib放到classPath中。

困扰我很久的一个问题是,我自己打包成功后,在一个同事的没有装jdk的电脑上运行,就是不行,报错jvm.dll为无效的windows映像,如截图

最后发现

- 读《研磨设计模式》-代码笔记-策略模式-Strategy

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/*

策略模式定义了一系列的算法,并将每一个算法封装起来,而且使它们还可以相互替换。策略模式让算法独立于使用它的客户而独立变化

简单理解:

1、将不同的策略提炼出一个共同接口。这是容易的,因为不同的策略,只是算法不同,需要传递的参数

- cmd命令值cvfM命令

chenyu19891124

cmd

cmd命令还真是强大啊。今天发现jar -cvfM aa.rar @aaalist 就这行命令可以根据aaalist取出相应的文件

例如:

在d:\workspace\prpall\test.java 有这样一个文件,现在想要将这个文件打成一个包。运行如下命令即可比如在d:\wor

- OpenJWeb(1.8) Java Web应用快速开发平台

comsci

java框架Web项目管理企业应用

OpenJWeb(1.8) Java Web应用快速开发平台的作者是我们技术联盟的成员,他最近推出了新版本的快速应用开发平台 OpenJWeb(1.8),我帮他做做宣传

OpenJWeb快速开发平台以快速开发为核心,整合先进的java 开源框架,本着自主开发+应用集成相结合的原则,旨在为政府、企事业单位、软件公司等平台用户提供一个架构透

- Python 报错:IndentationError: unexpected indent

daizj

pythontab空格缩进

IndentationError: unexpected indent 是缩进的问题,也有可能是tab和空格混用啦

Python开发者有意让违反了缩进规则的程序不能通过编译,以此来强制程序员养成良好的编程习惯。并且在Python语言里,缩进而非花括号或者某种关键字,被用于表示语句块的开始和退出。增加缩进表示语句块的开

- HttpClient 超时设置

dongwei_6688

httpclient

HttpClient中的超时设置包含两个部分:

1. 建立连接超时,是指在httpclient客户端和服务器端建立连接过程中允许的最大等待时间

2. 读取数据超时,是指在建立连接后,等待读取服务器端的响应数据时允许的最大等待时间

在HttpClient 4.x中如下设置:

HttpClient httpclient = new DefaultHttpC

- 小鱼与波浪

dcj3sjt126com

一条小鱼游出水面看蓝天,偶然间遇到了波浪。 小鱼便与波浪在海面上游戏,随着波浪上下起伏、汹涌前进。 小鱼在波浪里兴奋得大叫:“你每天都过着这么刺激的生活吗?简直太棒了。” 波浪说:“岂只每天过这样的生活,几乎每一刻都这么刺激!还有更刺激的,要有潮汐变化,或者狂风暴雨,那才是兴奋得心脏都会跳出来。” 小鱼说:“真希望我也能变成一个波浪,每天随着风雨、潮汐流动,不知道有多么好!” 很快,小鱼

- Error Code: 1175 You are using safe update mode and you tried to update a table

dcj3sjt126com

mysql

快速高效用:SET SQL_SAFE_UPDATES = 0;下面的就不要看了!

今日用MySQL Workbench进行数据库的管理更新时,执行一个更新的语句碰到以下错误提示:

Error Code: 1175

You are using safe update mode and you tried to update a table without a WHERE that

- 枚举类型详细介绍及方法定义

gaomysion

enumjavaee

转发

http://developer.51cto.com/art/201107/275031.htm

枚举其实就是一种类型,跟int, char 这种差不多,就是定义变量时限制输入的,你只能够赋enum里面规定的值。建议大家可以看看,这两篇文章,《java枚举类型入门》和《C++的中的结构体和枚举》,供大家参考。

枚举类型是JDK5.0的新特征。Sun引进了一个全新的关键字enum

- Merge Sorted Array

hcx2013

array

Given two sorted integer arrays nums1 and nums2, merge nums2 into nums1 as one sorted array.

Note:You may assume that nums1 has enough space (size that is

- Expression Language 3.0新特性

jinnianshilongnian

el 3.0

Expression Language 3.0表达式语言规范最终版从2013-4-29发布到现在已经非常久的时间了;目前如Tomcat 8、Jetty 9、GlasshFish 4已经支持EL 3.0。新特性包括:如字符串拼接操作符、赋值、分号操作符、对象方法调用、Lambda表达式、静态字段/方法调用、构造器调用、Java8集合操作。目前Glassfish 4/Jetty实现最好,对大多数新特性

- 超越算法来看待个性化推荐

liyonghui160com

超越算法来看待个性化推荐

一提到个性化推荐,大家一般会想到协同过滤、文本相似等推荐算法,或是更高阶的模型推荐算法,百度的张栋说过,推荐40%取决于UI、30%取决于数据、20%取决于背景知识,虽然本人不是很认同这种比例,但推荐系统中,推荐算法起的作用起的作用是非常有限的。

就像任何

- 写给Javascript初学者的小小建议

pda158

JavaScript

一般初学JavaScript的时候最头痛的就是浏览器兼容问题。在Firefox下面好好的代码放到IE就不能显示了,又或者是在IE能正常显示的代码在firefox又报错了。 如果你正初学JavaScript并有着一样的处境的话建议你:初学JavaScript的时候无视DOM和BOM的兼容性,将更多的时间花在 了解语言本身(ECMAScript)。只在特定浏览器编写代码(Chrome/Fi

- Java 枚举

ShihLei

javaenum枚举

注:文章内容大量借鉴使用网上的资料,可惜没有记录参考地址,只能再传对作者说声抱歉并表示感谢!

一 基础 1)语法

枚举类型只能有私有构造器(这样做可以保证客户代码没有办法新建一个enum的实例)

枚举实例必须最先定义

2)特性

&nb

- Java SE 6 HotSpot虚拟机的垃圾回收机制

uuhorse

javaHotSpotGC垃圾回收VM

官方资料,关于Java SE 6 HotSpot虚拟机的garbage Collection,非常全,英文。

http://www.oracle.com/technetwork/java/javase/gc-tuning-6-140523.html

Java SE 6 HotSpot[tm] Virtual Machine Garbage Collection Tuning

&

。

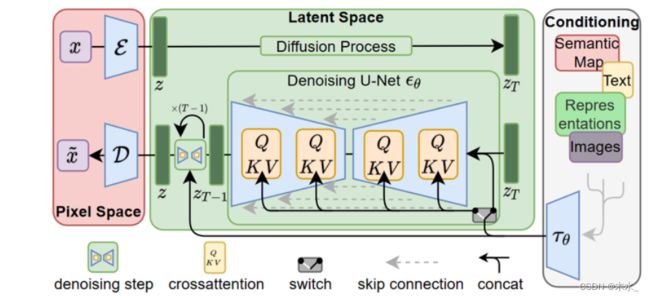

。![]() 和一个解码器

和一个解码器 ![]() 。这样就可以利用在训练时就可以利用编码器得到

。这样就可以利用在训练时就可以利用编码器得到 ![]() ,从而让模型在潜在表示空间中学习。

,从而让模型在潜在表示空间中学习。